Immaginate di trovarvi in una biblioteca dove, accanto ai volumi della prestigiosa Oxford University Press, si trovano disposti con la stessa dignità espositiva libelli di dubbia provenienza, manifesti complottisti e bozze mai riviste.

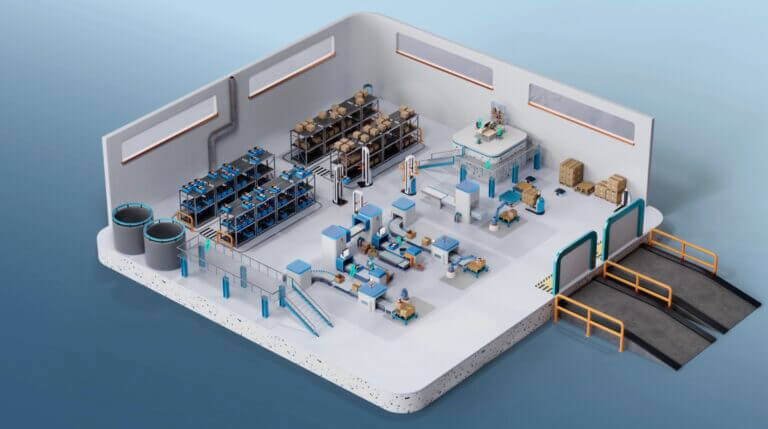

l’esperimento cefriel

L’AI mente con sicurezza: come testare la qualità delle fonti

L’affidabilità delle fonti AI è uno dei temi più urgenti nel dibattito sull’uso dell’intelligenza artificiale in ambito accademico e professionale. Quando l’apparenza dell’autorevolezza nasconde contenuti non verificati, il rischio di decisioni sbagliate si fa concreto

Cefriel

Continua a leggere questo articolo

Argomenti

Canali

Con o Senza – Galaxy AI per il business