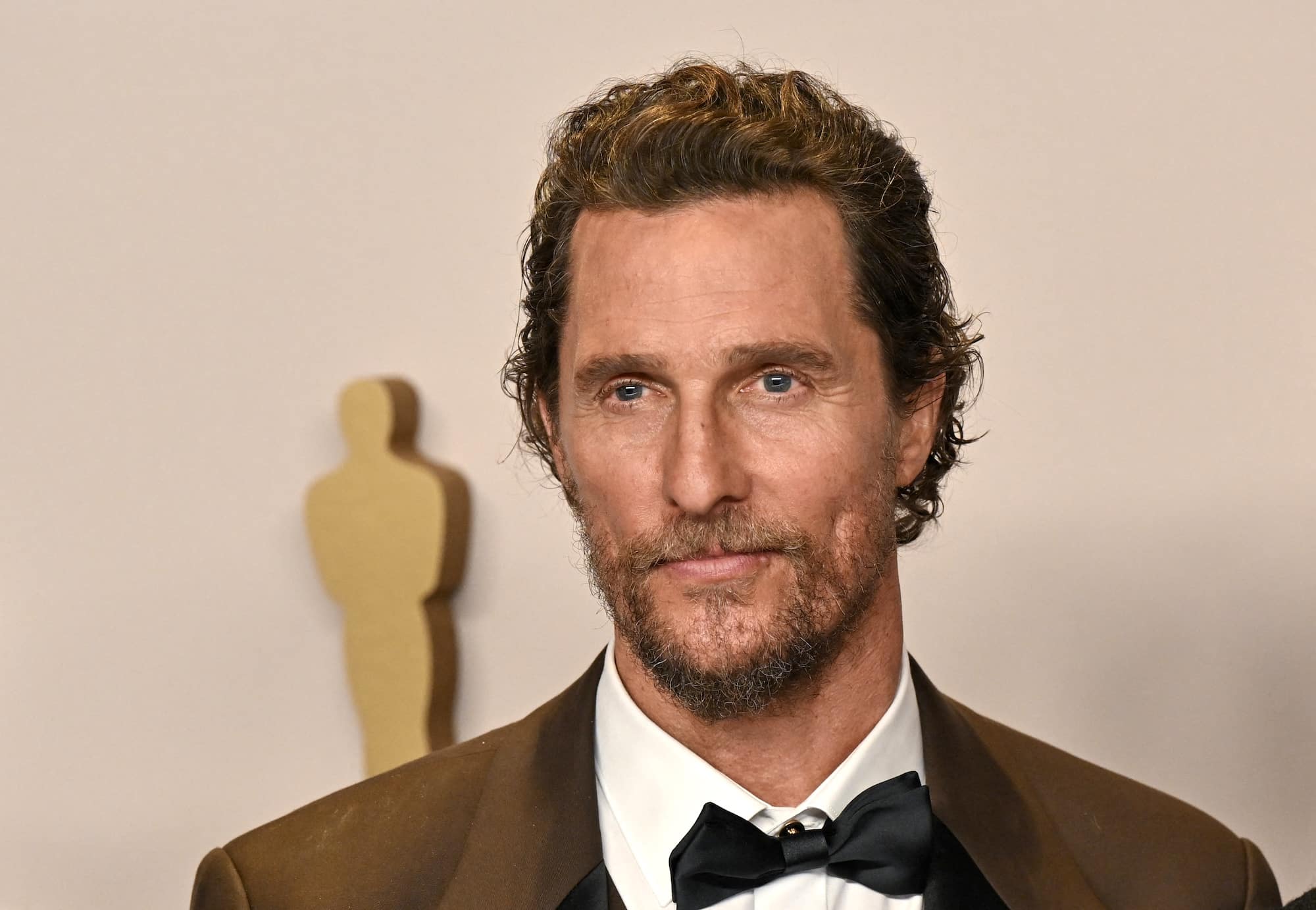

Matthew McConaughey, l’attore, ha scelto una strada netta contro i deepfake: si è brevettato. Ha fatto registrare materiali video e la propria voce tramite un soggetto specializzato in proprietà intellettuale, con l’obiettivo di rendere più facile e più rapida la contestazione degli usi generati dall’intelligenza artificiale.

Indice degli argomenti

McConaughey, brevetto della propria identità video voce contro il deepfake

L’operazione è costruita come tutela preventiva, con un impianto organizzativo alle spalle e una logica semplice: fissare in modo formalizzato i tratti identitari e biometrici per ottenere rimozioni, blocchi e risarcimenti quando l’immagine o il timbro finiscono in contenuti creati senza consenso.

Il fatto, però, porta subito a una domanda più scomoda della notizia stessa, perché quel tipo di registrazione promette forza solo in certi contesti e soprattutto per certi soggetti. Da un lato offre un vantaggio concreto, un titolo più chiaro, una prova più solida, una corsia più veloce nelle richieste alle piattaforme e nelle diffide.

Dall’altro rischia di trasformare la difesa dell’identità in un servizio premium, accessibile a chi possiede notorietà, struttura legale e capacità di monitoraggio. In più, l’idea stessa del termine brevetto resta ambigua, perché l’immagine non entra nel mondo dei brevetti come una macchina o un’invenzione, mentre trova sponde più realistiche in marchi, diritti della personalità, diritto all’immagine e patti contrattuali.

Perché l’IA rende esplosiva la difesa dai deepfake

L’intelligenza artificiale rende la questione esplosiva perché rompe il nesso tradizionale tra identità e controllo. Un volto o una voce, una volta acquisiti da un modello generativo, perdono la loro unicità operativa e diventano materia replicabile all’infinito, utilizzabile in contesti che vanno dalla pubblicità non autorizzata alla truffa, fino alla manipolazione reputazionale.

Il danno nasce proprio da questa moltiplicazione incontrollata: l’offesa non resta confinata in un singolo episodio, ma si distribuisce in rete con una velocità e una pervasività che rendono inefficace ogni reazione ex post.

Celebrità e casi giudiziari: perché intervenire dopo a tutela della propria identità è sempre tardi

Il richiamo ai casi giudiziari che hanno coinvolto celebrità, come quello di Scarlett Johansson, serve a chiarire questo salto di scala. In quelle vicende l’azione legale nasce dopo la diffusione di contenuti generati artificialmente che sfruttano la riconoscibilità della voce o del volto, dimostrando quanto sia difficile intervenire quando la clonazione ha già prodotto circolazione, imitazione e riuso.

L’IA, in altre parole, sposta il problema dal singolo illecito alla sostenibilità complessiva della tutela: ogni clone genera altri cloni e ogni rimozione arriva quando il danno simbolico ed economico ha già preso forma.

“Registrare” l’identità: cosa promette davvero la difesa dai deepfake

Dentro questo scenario prende senso l’idea di registrare l’identità come leva legale. La logica non consiste nel fermare la tecnologia, ma nel costruire un titolo giuridico chiaro, immediatamente azionabile.

L’obiettivo implicito è cambiare il piano dello scontro: smettere di inseguire il singolo deepfake per colpire invece il meccanismo che rende conveniente l’uso non autorizzato dell’immagine.

Quando l’identità viene formalizzata come bene tutelato, ogni sfruttamento commerciale perderebbe l’alibi dell’ambiguità e diventerebbe più facilmente qualificabile la violazione.

Il limite: tutela forte nel mercato, più debole nello spazio culturale

Proprio qui si annida un rischio di fondo: la forza di questa leva cresce con la notorietà del soggetto e con la capacità di presidiare legalmente la propria identità, anticipando una difesa selettiva che funziona bene per alcuni e molto meno per tutti gli altri.

Il limite principale riguarda il contesto d’uso. La tutela mostra la sua massima forza quando immagine o voce alimentano uno sfruttamento economico riconoscibile.

Nel momento in cui il contenuto entra nell’area della satira, della fiction o del commento pubblico, la protezione perde nettezza e si scontra con la libertà di espressione, che continua a godere di un peso decisivo nei sistemi costituzionali occidentali.

Norme frammentate e tempi lenti: perché la legge arriva in ritardo

A questo si aggiunge una frammentazione normativa che rende la tutela diseguale anche sul piano territoriale. Negli Stati Uniti il diritto alla protezione dell’immagine varia sensibilmente da Stato a Stato, con differenze nella durata, nell’estensione e nei rimedi.

L’identità digitale circola senza confini, mentre il diritto resta ancorato a giurisdizioni locali, con il risultato che la stessa clonazione può essere colpita duramente in un luogo e tollerata in un altro.

Anche quando esiste un titolo giuridico solido, la velocità della distribuzione resta un problema strutturale. La legge opera con tempi incompatibili con la circolazione virale dei contenuti.

La registrazione dell’identità rafforza le richieste, ma senza l’intermediazione attiva delle piattaforme e senza strumenti di enforcement tempestivi rischia di ridursi a una tutela teorica.

La vera asimmetria: chi può permettersi la difesa dai deepfake

Infine pesa una asimmetria economica difficile da ignorare. Celebrità e grandi brand possono sostenere i costi di monitoraggio, consulenza legale e contenzioso continuo.

Per gli utenti comuni, la stessa strada risulta spesso impraticabile. La difesa preventiva dell’identità tende così a funzionare come privilegio di chi possiede risorse e visibilità, lasciando scoperta la fascia di soggetti più esposta agli abusi quotidiani dell’IA.

Piattaforme: perché le procedure non bastano nella difesa dai deepfake

Se si guarda alle strategie realmente praticabili, l’idea che le piattaforme costituiscano una linea di difesa efficace cade rapidamente. Le procedure di segnalazione restano lente, opache, spesso automatizzate, e nella maggior parte dei casi producono risposte standard quando il contenuto ha già circolato, è stato copiato, ricaricato e adattato.

Affidare la tutela dell’identità alle policy interne equivale, nella pratica, a rinunciare al controllo: la logica che le governa privilegia scala ed engagement, non sempre la protezione preventiva dei diritti individuali.

Deterrenza mirata: cosa funziona davvero contro i deepfake

Se si abbandona la retorica della tutela e si guarda alla realtà operativa, emerge una verità scomoda ma decisiva: contro l’IA non esiste uno scudo generale, esistono solo strategie di deterrenza mirata.

La difesa efficace dell’identità nasce quando l’abuso diventa antieconomico, rischioso, tracciabile.

Questo cambia completamente il piano della risposta.

Controllare le fonti: la materia prima dei deepfake

La prima leva incisiva riguarda il controllo degli input, non degli output. Chi riesce a limitare l’accesso originario a materiali ad alta qualità riduce drasticamente la potenza delle repliche.

Non si tratta di segretezza, ma di gestione selettiva delle fonti: distribuzione differenziata di file, versioni degradate, campioni vocali incompleti, immagini non neutre.

Le grandi violazioni nascono quasi sempre da archivi ufficiali, interviste, spot, keynote, non dal rumore di fondo dei social. Governare questi flussi significa ridurre la materia prima dell’addestramento clandestino.

Colpire chi monetizza: responsabilità dove passa il denaro

Il secondo livello riguarda l’attribuzione della responsabilità, spostata dai contenuti ai soggetti che li monetizzano. L’uso illecito dell’identità diventa vulnerabile quando viene collegato a un vantaggio economico dimostrabile, anche indiretto.

La strategia non consiste nel rincorrere il deepfake, ma nel colpire chi lo utilizza per vendere, acquisire utenti, orientare scelte, raccogliere dati.

La pressione giuridica funziona quando intercetta il punto in cui l’IA tocca il denaro: lì ci sono documenti, pagamenti, intermediari, contratti, quindi responsabilità concrete.

Assicurare il rischio: quando il mercato disciplina l’abuso

Un terzo fronte riguarda l’assicurabilità del rischio identitario. Trasformare l’abuso dell’immagine in un rischio economico assicurato obbliga aziende, agenzie e produttori di contenuti a dimostrare diligence, consenso e tracciabilità.

L’assicurazione non tutela la vittima in senso morale, ma disciplina il mercato: nessun soggetto coperto accetta esposizioni incontrollate. La difesa avanza così come clausola di sostenibilità economica.

Rendere l’identità meno statica: autodifesa cognitiva

Infine esiste una strategia che riguarda il tempo, non il diritto. L’identità digitale va aggiornata, rinnovata, resa mobile.

Le repliche funzionano perché imitano una versione stabile di volto e voce. Rendere l’identità meno statica, attraverso variazioni intenzionali, segnali riconoscibili per chi conosce il soggetto, contesti comunicativi coerenti, riduce l’efficacia persuasiva dei cloni.

Non è una soluzione giuridica, ma una tecnica di autodifesa cognitiva che lavora sulla percezione.

Conclusione: il caso McConaughey è utile, ma non basta

Questo è il punto che rende il caso McConaughey interessante ma anche limitato. La registrazione dell’identità può rafforzare alcune azioni, soprattutto nel mercato e nella pubblicità, ma non governa il fenomeno.

La vera difesa nasce da una combinazione più dura e meno elegante: controllo delle fonti, attacco ai profitti, trasferimento del rischio, gestione strategica della propria presenza.

L’IA non viene fermata con un atto simbolico, ma con un sistema che rende l’abuso costoso, fragile e scomodo.

Quando accade questo, la tecnologia rallenta da sola.