Le ultime settimane sono state caratterizzare dalla pubblicazione di articoli che sollevano interrogativi importanti rispetto alla tecnologia dell’AI e alle sue prospettive.

Indice degli argomenti

Verso una comprensione più profonda del funzionamento dei modelli AI

Da un lato ricercatori di Apple hanno messo in discussione la reale capacità di ragionare dei modelli AI, dall’altro ricercatori della Cornell University hanno mostrato come anche nei modelli AI possa esistere una sorta di rappresentazione universale dei concetti evocando la teoria delle idee di Platone.

In aprile il CEO di Anthropic Amodei ha condiviso una riflessione sull’urgenza di capire come i modelli AI prendono decisioni visto che ad oggi la nostra comprensione sul reale funzionamento di questi modelli è sostanzialmente nulla. Sembra che in questa corsa sfrenata allo sviluppo di questa tecnologia stiano cominciando a emergere questioni fondamentali che servono anche a capire se davvero la cosiddetta intelligenza artificiale generale o AGI sia davvero vicina come sostengono alcuni o lontana o addirittura impossibile da raggiungere.

Si tratta di un dibattito molto interessante da seguire ricco anche di conseguenze pratiche, sia in termini di sviluppo dei modelli AI e loro sicurezza che anche della sicurezza informatica stessa degli emergenti database vettoriali.

È sicuramente degno di nota il fatto che entrambi i risultati vanno nella direzione indicata da Amodei, cioè capire di più il funzionamento interno dei modelli. Cerchiamo di capire l’essenza di questi risultati e le loro implicazioni nel contesto della corsa sfrenata allo sviluppo di questa tecnologia.

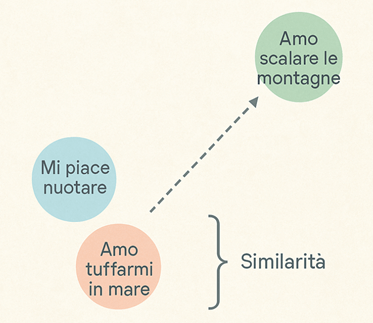

Embedding e rappresentazione universale nei modelli AI

Gli embedding sono un sottoprodotto degli LLM o per meglio il primo strato della rete neurale che li implementa. Il compito è quello di associare a un testo (e ai token di cui è composto) un vettore che ne rappresenti il significato, ovverosia parole o frasi che individuano concetti simili generano vettori vicini nel senso che misurando la distanza vettoriale tra i due vettori sarà minore tanto più il significato del testo che rappresentano.

La rete di embeddings è addestrata con il modello LLM ed è l’intero processo che consente di ottenere questa capacità di riconoscere la similarità nel significato.

Una volta addestrato il modello la prima parte può però essere usata indipendentemente ed è divenuta un componente essenziale nella tecnologia dei Vector Database e quindi anche dei sistemi RAG.

Il modo con cui la rete degli embeddings viene addestrata, ovvero insieme al relativo modello LLM, può far pensare che reti differenti portino a rappresentazioni vettoriali differenti del significato delle frasi visto che l’addestramento fa uso di dati specifici che sono diversi tra modello e modello.

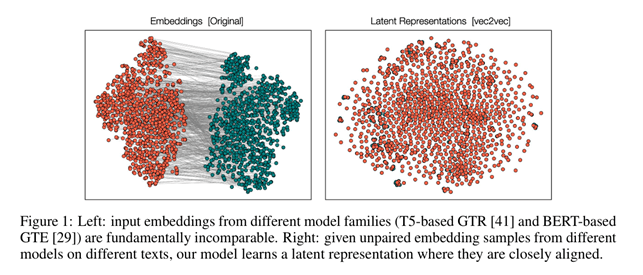

I ricercatori della Cornell University hanno dimostrato come sia possibile utilizzare un sistema di apprendimento automatico non supervisionato (senza quindi alcun aiuto esterno) capace di “tradurre” i vettori di embedding di vari modelli in un spazio vettoriale “universale” in cui lo stesso concetto è rappresentato con lo stesso vettore.

Si tratta di un risultato straordinario che può essere letto come l’esistenza di una struttura comune a tutti modelli, e di conseguenza al linguaggio umano, di rappresentare in un modo unico i concetti. E vi sono già evidenze che i vettori di embedding sono simili anche quando gli stessi concetti sono espressi in lingue differenti.

Implicazioni di sicurezza dei modelli AI e degli embeddings

Ci sono molti modi per interpretare questo risultato, e sicuramente il fatto che le informazioni nascono dal cervello umano forse non è poi così sorprendente che le strutture che genera, se considerate ad un livello profondo, sono le stesse e le macchine semplicemente rivelano questa “lingua vera” (un po’ come in nel mondo fantasy di Eragon).

Vanno però considerate anche le conseguenze più pratiche di questo risultato: i vettori che vengono usati come chiavi nei nostri vector database sono meno criptici di quanto si pensava, e si possono quindi immaginari scenari di attacco informatico in cui usando un modello latente universale è possibile indovinare dato il semplice vettore un possibile significato. In ambito di cybersecurity si possono quindi immaginare attacchi che sfruttino questa capacità per risalire a contenuti altrimenti non disponibili, aprendo nuovi scenari nella custodia delle informazioni usate.

Il ragionamento nei modelli AI: potenzialità e limiti

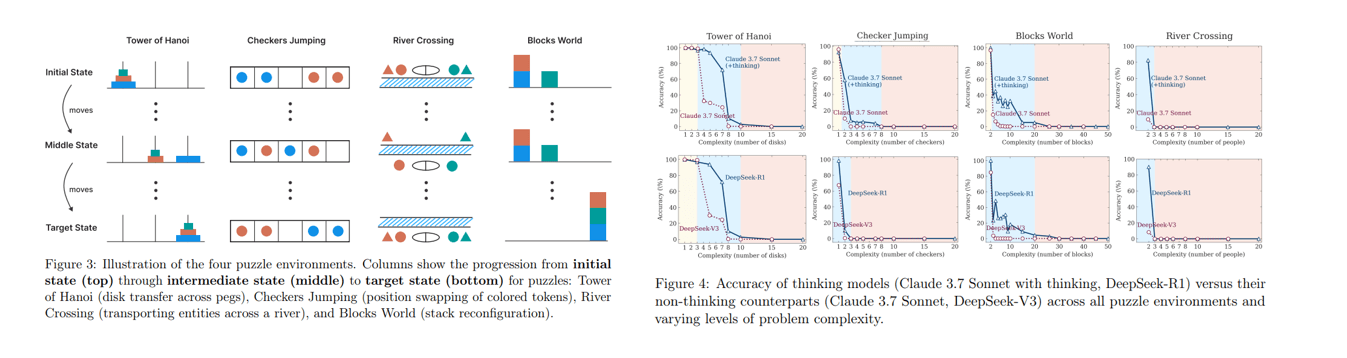

La capacità, quantomeno apparente, dei modelli di “ragionare” ha contribuito a generare la percezione che l’AGI si sta avvicinando, e i risultati ottenuti sembravano indicare progressi notevoli nel corso di pochi mesi. In questo contesto l’articolo di Apple che ha analizzato vari modelli che ragionano cercando di metterli in crisi ha mostrato potenziali limiti alla capacità di ragionare.

Il ragionamento nasce come la meccanizzazione della cosiddetta Chain of thoughts: usare dei prompt per scomporre un problema in sottoproblemi e poi affrontarli uno alla volta fino a quando non si risolve il problema. In sostanza è come assistere a qualcuno che ragiona a voce alta nel tentativo di risolvere un problema. Si può quindi dire che il modello si avvalga degli schemi di ragionamento tradotti in manipolazione linguistica appresi durante l’addestramento.

Test pratici sui limiti dei modelli AI

L’articolo cerca di risolvere problemi classici, come ad esempio il puzzle delle torri di Hanoi, mostrando come gli LLM non riescono a generalizzare il ragionamento e al complicarsi del problema addirittura si arrendano quasi subito.

Si tratta di un risultato difficile da ignorare anche se molti commentatori hanno a mio avviso un po’ esagerato nel commentarlo insinuando che l’AI allora serve a poco. Certamente la tendenza ad arrendersi subito quando il problema è complesso darà molto lavoro a chi realizza i modelli, ma niente nell’articolo di Apple sembra mostrare problemi insormontabili.

Sicuramente contribuisce ad una prospettiva realistica del funzionamento di questi modelli e di cosa ci possiamo attendere nel breve futuro. Indica anche che forse i benchmark che usiamo per giudicarli non sempre riflettono la reale capacità del modello in contesti imprevisti.

Prospettive future per la comprensione dei modelli AI

Anche in questo caso questi esperimenti contribuiscono a farci capire meglio come funzionano i modelli e cosa ci possiamo attendere da loro. Evitando di farsi trasportare da facili entusiasmi.

Comprendere il comportamento dell’AI è molto importante, ed è indicativo il modo sperimentale di procedere dei ricercatori: si fanno esperimenti come se si trattasse di un qualcosa di naturale e non un manufatto prodotto dalla mente umana.

Sono state proposte tante strategie di analisi, alcune simili a delle risonanze magnetiche digitali, ma a oggi sembra che gli approcci che funzionano siano quelli di analisi comportamentale. È necessario quindi ricercare (e sostenere la ricerca) per comprendere al meglio questa tecnologia, non solo per capirne il funzionamento ma anche per comprenderne i limiti e valutarne le implicazioni nel loro uso. Chissà come avrebbe commentato Platone che i concetti sembrano davvero avere una rappresentazione unica e universale.