Negli ultimi anni il concetto di sovranità dei dati è entrato stabilmente nel lessico politico, istituzionale e industriale europeo. La questione della localizzazione dell’informazione, della sua protezione giuridica e della sua custodia infrastrutturale ha rappresentato il fulcro di un dibattito che ha prodotto regolazione, investimenti e nuove architetture tecnologiche.

Questo percorso ha avuto un valore indiscutibile, poiché ha riportato il controllo del dato all’interno di una cornice di responsabilità pubblica e di diritto, ma nonostante ciò, l’evoluzione dell’intelligenza artificiale sta progressivamente mostrando i limiti di una sovranità intesa esclusivamente come controllo del dato.

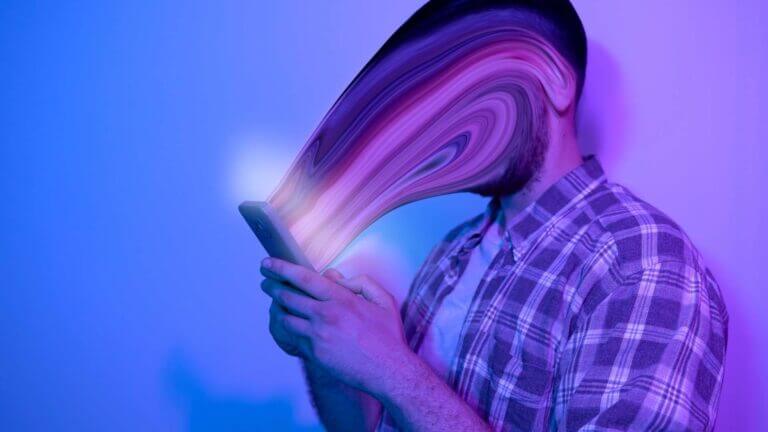

Il dato, da solo, non genera valore né potere decisionale. È la sua interpretazione algoritmica a produrre valutazioni, previsioni e azioni automatiche che incidono su cittadini, imprese e istituzioni e, in questa prospettiva, la sovranità dei dati rappresenta una condizione necessaria, ma non più sufficiente.

Proviamo allora a dimostrare che la vera frontiera della sovranità digitale non risiede più soltanto nella gestione dell’informazione, ma risiede nella capacità di governare gli algoritmi che la trasformano in decisione.

Indice degli argomenti

Dalla localizzazione del dato alla governance della decisione

Per lungo tempo il tema della sovranità digitale è stato affrontato attraverso una logica spaziale: dove risiedono i dati, sotto quale giurisdizione vengono trattati, quali infrastrutture li ospitano. Questo approccio riflette però una visione statica del potere tecnologico, coerente con un’epoca in cui il dato era prevalentemente un oggetto di archiviazione e trasmissione, un’epoca che però abbiamo abbondantemente superato.

L’intelligenza artificiale ha introdotto una discontinuità profonda perché oggi il valore strategico del dato emerge nel momento in cui esso viene elaborato da modelli che classificano, selezionano, prevedono e suggeriscono decisioni. Il potere non è più concentrato nel possesso dell’informazione: il potere oggi si trova nella capacità di determinare come essa venga interpretata.

E quella che definiamo sovranità algoritmica si colloca esattamente in questo passaggio. Essa non riguarda l’autarchia tecnologica né il rifiuto delle piattaforme globali, ma la possibilità di esercitare un controllo effettivo sui criteri decisionali automatizzati che orientano scelte pubbliche e private.

AI Act e responsabilità: dalla tecnologia al governo dell’automazione

Il regolamento europeo sull’intelligenza artificiale ha segnato un punto di svolta nella costruzione della sovranità digitale europea. Per la prima volta l’attenzione del legislatore si è spostata in modo esplicito dalla tecnologia come tale alla responsabilità connessa all’uso di sistemi decisionali automatizzati.

La classificazione dei sistemi ad alto rischio, gli obblighi di governance, la documentazione dei modelli e la supervisione umana introducono una logica di controllo sostanziale.

Questo passaggio, badate bene, non è stato ancora pienamente compreso. In molti contesti amministrativi e industriali l’AI Act viene interpretato come un insieme di vincoli formali, piuttosto che come l’indicazione di un nuovo paradigma di governo dell’automazione. Il rischio è quello di ridurre la regolazione a compliance, senza affrontare il nodo centrale: comprendere chi definisce le regole decisionali incorporate negli algoritmi.

La sovranità algoritmica richiede un salto culturale prima ancora che tecnologico.

Sovranità algoritmica: la dimensione strategica invisibile

A differenza della sovranità infrastrutturale, la sovranità algoritmica è meno visibile e più difficile da misurare. Essa non si manifesta attraverso confini fisici o asset tangibili, ma attraverso logiche decisionali, modelli predittivi e sistemi di ottimizzazione che operano spesso in modo opaco.

Un sistema può trattare dati localizzati in Europa, rispettare le norme sulla protezione dell’informazione e, allo stesso tempo, dipendere completamente da modelli sviluppati, addestrati e controllati da soggetti esterni. In questo caso la sovranità del dato non impedisce la formazione di una dipendenza strategica sul piano cognitivo.

La vera questione non è dunque dove si trova il dato, ma chi controlla il processo che lo rende “decisione”.

Dipendenze cognitive e opacità decisionale

Gli algoritmi non sono strumenti neutri perché incorporano assunzioni, metriche di successo, priorità e criteri di classificazione che riflettono scelte progettuali precise. Quando questi elementi non sono conoscibili, verificabili o modificabili, si genera una forma di dipendenza cognitiva che limita la capacità di intervento delle istituzioni.

La sovranità algoritmica implica la possibilità di audit, spiegazione e contestazione delle decisioni automatizzate. Senza questi strumenti, anche sistemi formalmente conformi possono produrre effetti sistemici difficilmente governabili, soprattutto in settori sensibili come sanità, sicurezza, credito, welfare e amministrazione pubblica.

Europa tra regolazione e capacità di governo

L’Europa ha scelto di affrontare la sfida dell’intelligenza artificiale attraverso una regolazione avanzata e orientata alla tutela dei diritti fondamentali. Questa scelta comporta però una responsabilità ulteriore: tradurre le norme in capacità operative.

La sovranità algoritmica europea non potrà limitarsi a imporre obblighi, ma dovrà essere sostenuta da competenze, infrastrutture di verifica e filiere industriali capaci di sviluppare modelli affidabili e controllabili. In assenza di questa dimensione operativa, la regolazione rischierà di governare tecnologie progettate altrove.

L’opportunità italiana: integrare dati, algoritmi e governance

In questo nuovo ecosistema l’Italia dispone di una finestra di opportunità concreta. Gli investimenti in cloud pubblico, supercalcolo, cybersicurezza e infrastrutture digitali costituiscono una base solida su cui costruire un modello avanzato di governance algoritmica.

Il passaggio decisivo consiste nell’integrare la sovranità dei dati con il controllo dei processi decisionali automatizzati. Questo implica sviluppare capacità di audit algoritmico, rafforzare i partenariati pubblico-privati orientati alla trasparenza e investire nella formazione di competenze interdisciplinari.

L’Italia potrebbe così proporsi come laboratorio europeo di governo responsabile dell’intelligenza artificiale: non solo come luogo di conservazione del dato, ma come spazio di controllo della decisione automatizzata.

Conclusioni

La sovranità digitale ai nostri giorni non si esaurisce nella custodia del dato, ma si realizza pienamente nella capacità di governare gli algoritmi che trasformano l’informazione in decisione. La sovranità algoritmica rappresenta quindi l’evoluzione naturale della sovranità dei dati.

La vera partita strategica non riguarda soltanto l’infrastruttura, ma il controllo delle logiche decisionali automatizzate. In questa prospettiva, l’Europa ha tracciato una direzione chiara. Spetta ora agli Stati membri, e all’Italia in particolare, trasformare la regolazione in capacità di governo.

Un Paese che governa i propri algoritmi è un Paese che governa il proprio futuro digitale.

Bibliografia essenziale

Busuioc, M. (2020).

Accountable Artificial Intelligence: Holding Algorithms to Account.

Public Administration Review, 81(5), 825–836.

https://pmc.ncbi.nlm.nih.gov/articles/PMC8518786

Cobbe, J., Singh, J., & Lee, M. S. A. (2021).

Reviewable Automated Decision-Making: A Framework for Accountable Algorithmic Systems. https://arxiv.org/abs/2102.04201

Gstrein, O. J. (2024).

General-purpose AI regulation and the European Union AI Act.

Internet Policy Review, 13(1).

ttps://policyreview.info/articles/analysis/general-purpose-ai-regulation-and-ai-act

Raji, I. D., Xu, P., Honigsberg, C., & Ho, D. E. (2022).

Outsider Oversight: Designing a Third-Party Audit Ecosystem for AI Governance. https://arxiv.org/abs/2206.04737

Pasquale, F. (2016).

The Black Box Society: The Secret Algorithms That Control Money and Information. Harvard University Press.