Il “codice rosso” dichiarato da OpenAI, l’avanzata cinese di DeepSeek ora con nuovi modelli anti Gpt5, il nuovo scacchiere di alleanze Anthropic–Microsoft–Nvidia e il rilancio dell’AI Google con Gemini 3 delineano un ecosistema in cui la leadership nei modelli linguistici non è più scontata.

Le Big Tech, intanto, preparano oltre 400 miliardi di dollari di investimenti in data center, chip e infrastrutture di calcolo: la competizione non è più solo tecnica, ma profondamente industriale e finanziaria.

Che sta succedendo? Succede che nel risiko dell’AI non c’è più nulla di scontato. Non è più scontato ad esempio che OpenAI e Nvidia saranno i grandi vincitori di questa partita.

Indice degli argomenti

Un nuovo orizzonte competitivo: l’AI come infrastruttura globale

Il punto è che su questo finire del 2025, l’intelligenza artificiale ha abbandonato lo status di promessa tecnologica per trasformarsi in una vera e propria battaglia industriale. Le trimestrali recenti di Google, Microsoft, Meta e Amazon mostrano un impegno complessivo superiore ai 400 miliardi di dollari in data center, chip, reti e potenza di calcolo.

Siamo davanti a un cambio di fase: l’AI non è più un settore verticale, ma la nuova infrastruttura economica su cui poggeranno manifattura, finanza, servizi e media.

Mentre questo scenario si consolida, improvvise tensioni attraversano la frontiera tecnologica dei modelli linguistici lasciando emergere un quadro coerente: la competizione si sta spostando dai modelli alle architetture industriali che li sostengono.

La nuova corsa globale ai modelli linguistici. Codice rosso di OpenAI

Il Wall Street Journal ha rivelato il contenuto di un memo interno di Sam Altman che dichiara un vero e proprio “codice rosso”. Non si tratta di una formula retorica.

OpenAI sposta risorse e priorità per migliorare ChatGPT, rimandando iniziative strategiche come la pubblicità, gli agent verticali e il progetto Pulse.

Nel memo emergono due preoccupazioni nette. La prima è tecnologica: i nuovi modelli di Google e i più recenti sviluppi della concorrenza hanno ridotto il vantaggio di OpenAI, soprattutto sul piano del ragionamento e della coerenza nelle risposte.

La seconda è finanziaria: l’azienda non è ancora profittevole e ha assunto impegni per infrastrutture computazionali di scala senza precedenti.

L’Economist interpreta questo passaggio come la prima incrinatura nella «facciata dominante» di OpenAI.

L’azienda che aveva definito l’era della generative AI scopre improvvisamente di essere vulnerabile, mentre i costi di gestione e le pressioni degli investitori crescono in parallelo alla competizione.

OpenAI e il rischio di perdere il vantaggio nei modelli linguistici

In questo scenario, il vantaggio iniziale nei modelli linguistici non basta più. OpenAI deve riequilibrare roadmap di prodotto, sostenibilità economica e posizionamento competitivo, mentre i competitor recuperano terreno sui fronti critici del reasoning, del contesto lungo e dell’integrazione nei flussi di lavoro reali.

La nozione stessa di “laboratorio leader” viene messa in discussione da un ecosistema in cui il compute e il capitale diventano leve più decisive della singola innovazione di modello.

DeepSeek e la frontiera cinese del ragionamento, i modelli nuovi

Se OpenAI arretra, DeepSeek, la startup cinese che negli ultimi mesi ha sorpreso il settore con modelli particolarmente efficienti e costruiti per integrare il ragionamento con l’uso di strumenti esterni, accelera.

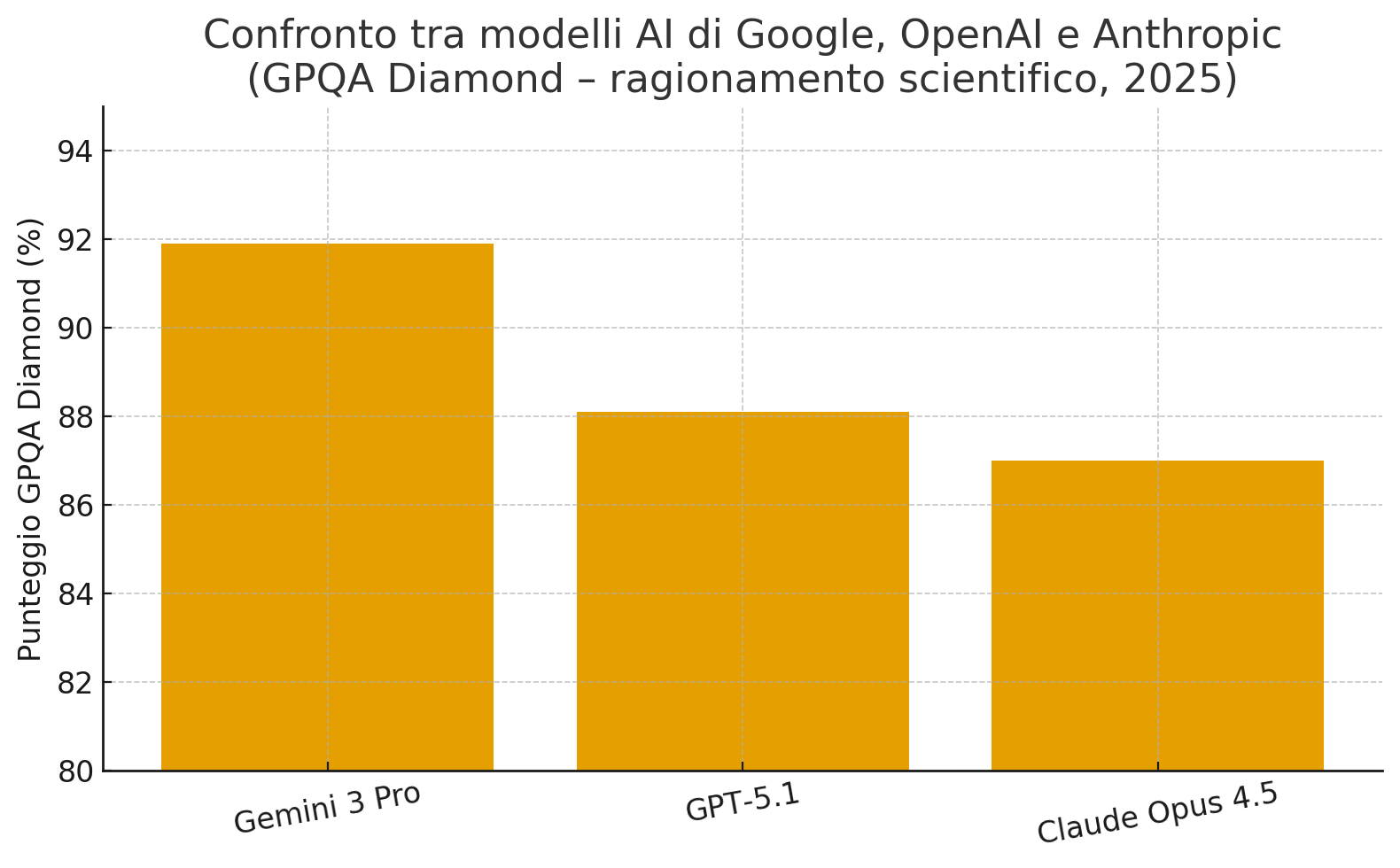

Le nuove versioni DeepSeek-V3.2 e DeepSeek-V3.2-Special raggiungono performance equivalenti, rispettivamente, a GPT-5 e Gemini-3 Pro nei benchmark più impegnativi.

Il modello Special, dedicato al calcolo matematico avanzato, ottiene risultati da medaglia d’oro nelle principali competizioni internazionali e indica la maturazione di un approccio diverso da quello occidentale: agenti progettati nativamente per concatenare ragionamenti, consultare fonti, eseguire codice e correggersi autonomamente.

La Cina non è più un competitore attardato: presidia ormai la frontiera del reasoning e del long thinking, proponendo modelli open che dialogano con l’ecosistema globale ma consolidano un’autonomia tecnologica nazionale.

Modelli linguistici e capitale dell’asse Anthropic–Microsoft–Nvidia

Nel frattempo, si impone all’attenzione il giro di accordi tra Anthropic, Microsoft e Nvidia, un esempio emblematico della “circolarità” finanziaria che caratterizza la nuova economia dell’AI.

Microsoft e Nvidia annunciano di voler investire 15 miliardi di dollari in Anthropic. Anthropic, a sua volta, si impegna a spendere 30 miliardi sulla piattaforma Azure, fondandosi su chip Nvidia.

Questa dinamica chiusa – il capitale che alimenta infrastrutture che generano nuova domanda di capitale – ricorda molto da vicino i circuiti di investimento tipici dei settori energetici o delle infrastrutture critiche.

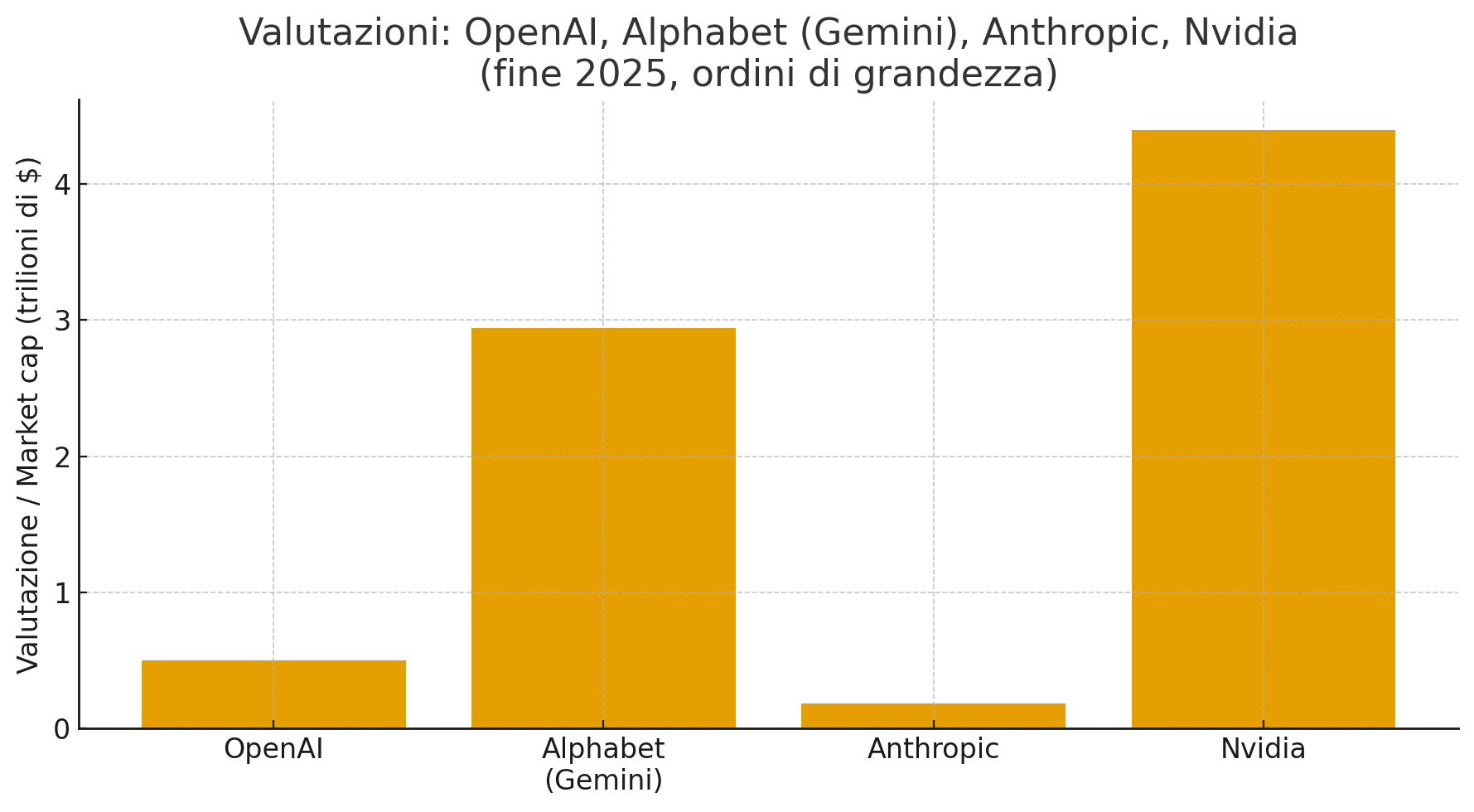

Anthropic raggiunge così una valutazione vicina ai 350 miliardi di dollari, riducendo la distanza con OpenAI e consolidandosi come secondo polo della frontiera AI.

Nel frattempo, anche altri laboratori di frontiera stanno crescendo con valutazioni enormi. Tra questi c’è xAI, la società fondata da Elon Musk che è in trattative per raccogliere circa 15 miliardi di dollari, con una valutazione intorno ai 230 miliardi.

Questo dato conferma che non è solo Anthropic ad avvicinarsi alla scala di OpenAI: l’intero ecosistema dei laboratori avanzati si sta espandendo e nessun attore sta costruendo una posizione dominante in grado di chiudere la partita.

La filiera come vero vantaggio competitivo

Il risultato è una competizione in cui non prevale chi costruisce il modello migliore, ma chi governa l’intera filiera: chip proprietari, potenza di calcolo, servizi cloud, accesso alle aziende, partnership strutturali.

I modelli linguistici diventano così nodi di una catena molto più ampia, dove contano contratti pluriennali, economie di scala e integrazione nei processi produttivi, più che il singolo salto prestazionale.

Google, Gemini e l’integrazione verticale dei modelli linguistici

Mentre OpenAI si concentra sugli aggiustamenti interni, Google sfrutta la forza di un ecosistema completamente integrato.

I suoi modelli Gemini sono addestrati su TPU proprietarie, riducendo drasticamente il costo per query.

Le AI Overviews introdotte nella ricerca hanno aumentato l’engagement e portato Alphabet oltre i mille miliardi di capitalizzazione aggiuntiva in pochi mesi.

Questa strategia conferma quanto sostenuto in precedenza: l’integrazione verticale torna di moda. Google non dipende da fornitori esterni per chip, infrastruttura o distribuzione.

Ogni miglioramento del modello si riflette immediatamente su prodotti utilizzati da miliardi di persone e su un sistema di ricavi già consolidato.

Convergenza tecnica, divergenza industriale

La distanza tecnica tra i modelli si sta riducendo. GPT-5, Gemini-3, DeepSeek-V3.2 e Claude dell’ultima generazione non appartengono più a galassie diverse, ma orbitano nella stessa fascia prestazionale.

La concorrenza non si gioca sul singolo benchmark, ma sull’efficienza economica, sulla disponibilità di compute, sulla capacità di integrare i modelli in servizi reali.

Le Big Tech stanno assumendo posizioni differenti: Microsoft punta sulle alleanze e sui partenariati strategici; Google sulla potenza dell’autarchia tecnologica; Meta sulla scommessa visionaria della superintelligenza; Amazon sulla monetizzazione immediata del cloud.

Il denominatore comune rimane uno: l’AI non è più un prodotto, ma un’infrastruttura economica.

Bolla dell’AI o nuova infrastruttura economica?

L’ondata di investimenti che attraversa il settore solleva un interrogativo: tutta questa potenza di calcolo genererà davvero valore o rischiamo la costruzione della più costosa illusione tecnologica della storia recente?

È possibile che l’AI stia vivendo il suo momento di espansione massima, con valutazioni che anticipano un futuro ancora da verificare.

Siamo in presenza di una bolla AI?

A questa incertezza si aggiunge un altro elemento che emerge chiaramente dagli ultimi rilasci di DeepSeek e Mistral: il “gap” tecnologico non è affatto incolmabile.

Modello dopo modello, i competitor dimostrano che non esistono veri fossati difensivi, nessun moat, nessun vantaggio che produca un lock-in credibile.

Ogni modello può essere affiancato a un altro, sostituito o combinato senza attrito.

Nessun lock-in, solo orchestrazione di modelli

Un ecosistema aperto per definizione, non perché le aziende lo desiderino, ma perché la natura stessa degli LLM, privi di memoria affidabile e persistente, impedisce la costruzione di barriere reali.

Nel lavoro quotidiano con professionisti e imprese, per ottenere il massimo dall’intelligenza artificiale generativa è spesso necessario utilizzare più modelli in sinergia.

Non esiste alcun costo operativo che scoraggi il passaggio da uno all’altro, perché oggi nessun LLM è in grado di ricordare in maniera robusta e autonoma lo storico delle interazioni che lui stesso ha generato. Questo solo fatto può annullare ogni tentativo di fidelizzazione.

Anche il costo economico è pressoché nullo: passando da un abbonamento a un uso via API on-demand, la spesa complessiva resta simile, ma si ottiene un vantaggio decisivo, ossia la libertà di utilizzare tutti i modelli disponibili, non uno solo.

Qui si gioca davvero il vantaggio competitivo: nella capacità di orchestrare strumenti diversi, sfruttare approcci complementari e costruire sistemi intelligenti che non dipendono da un singolo fornitore, ma da una strategia capace di integrare modelli, infrastrutture e processi.

In ogni caso, il paradigma è già cambiato: la generative AI non è più l’innovazione che si aggiunge al digitale, è l’infrastruttura su cui il digitale del futuro verrà costruito.

Fino a quando una nuova architettura non ridisegnerà nuovamente il panorama.