Nonostante i suoi risultati straordinari, l’IA non sempre fornisce la soluzione ottimale per ogni problema. È fondamentale comprendere come valutare e validare i risultati prodotti dall’IA, nonché riconoscere quando l’informatica tradizionale può offrire soluzioni più efficienti e spiegabili.

Indice degli argomenti

L’intelligenza artificiale e i suoi limiti: quando l’informatica tradizionale è preferibile

Ogni giorno assistiamo nuovi errori da parte di sistemi di intelligenza artificiale generativa: molte conversazioni rivelano errori – talvolta banali – che vengono prontamente condivisi per attirare like e guadagnarsi visibilità sui social. Il fenomeno è ormai sistematico: sui social o su media più “tradizionali”, proliferano video, post e articoli che mettono in evidenza scivoloni della IA generativa, presentati come fossero uno scoop. Il risultato è una narrativa distorta, che dipinge l’IA come inaffidabile, spesso per puro effetto virale.

Altri studi più rigorosi dimostrano con fatti ben spiegati alcuni limiti dei Large Language Models, alla base della IA generativa.

Come quello pubblicato da Apple dal titolo The Illusion of Thinking. In questo studio, Apple analizza i modelli linguistici avanzati, detti Large Reasoning Models (LRMs), che generano tracce di ragionamento prima di rispondere.

Sebbene migliorino le prestazioni in compiti di ragionamento, questi modelli mostrano limiti significativi quando la complessità dei problemi aumenta: la loro accuratezza crolla oltre una certa soglia, e il loro impegno nel ragionamento cresce fino a un punto per poi diminuire.

La ricerca confronta i LRMs con i modelli tradizionali su test di complessità controllata, rilevando che i primi non riescono a usare algoritmi espliciti e mostrano ragionamenti incoerenti nei compiti più complessi, sollevando interrogativi sulla reale portata delle loro capacità cognitive.

Eppure, al di là degli episodi clamorosi, non si può ignorare che l’IA generativa ha ormai raggiunto uno status imprescindibile.

Ne ho avuto una prova concreta in ambito legale: ho chiesto prima a chatGPT e poi a Claude una “consulenza” sul diritto di prelazione per una proprietà immobiliare indivisa tra due eredi non diretti. La risposta è stata sorprendentemente precisa, circoscritta e di grande utilità. Ho fatto validare la risposta da un professionista che ne ha confermato la correttezza. Un esempio che parla chiaro: l’IA può essere più di un semplice strumento, ed è già diventata parte integrante della nostra vita professionale o quotidiana.

Ma è davvero necessario usare l’IA in ogni contesto? Quanto può e deve integrarsi nel nostro lavoro, e dove invece necessita del filtro umano?

Oggi, quando si parla di intelligenza artificiale, la maggior parte delle persone pensa ai sistemi basati sull’IA generativa – come chatbot, generatori di immagini o assistenti automatici. Ma l’IA è molto di più: un insieme di tecnologie che vanno dall’analisi predittiva ai sistemi di raccomandazione, fino all’automazione industriale e ai modelli decisionali complessi. In questo articolo analizzeremo alcune criticità e limiti dell’IA, per capire quando è davvero indispensabile e quando può e deve restare un semplice “assistente” – non un sostituto.

La sfida della trasparenza: l’IA deve spiegare le sue decisioni

Oggi una delle sfide più importanti dell’intelligenza artificiale è imparare a spiegare come arriva alle sue conclusioni. Non basta più ottenere risposte precise: vogliamo anche capire il perché di quelle risposte.

Il problema è che molti sistemi di IA funzionano come “scatole nere”: sono così complessi che è difficile capire come prendono le loro decisioni.

Per rispondere a questa esigenza, i ricercatori hanno sviluppato strumenti chiamati LIME e SHAP, che cercano di semplificare e spiegare le decisioni dell’AI dopo che sono state prese. Tuttavia, questi strumenti hanno dei limiti: richiedono molta potenza computazionale (quindi energia), non sempre sono affidabili e rischiano di confondere l’utente con troppe informazioni.

La sfida diventa ancora più complessa quando l’AI lavora con dati come testi, immagini o suoni, perché questi elementi cambiano continuamente e sono difficili da interpretare in modo chiaro.

Ma c’è un problema ancora più profondo: le spiegazioni che l’IA ci offre potrebbero essere solo giustificazioni create dopo aver preso una decisione, piuttosto che le vere ragioni che l’hanno portata a quella scelta. Questo può darci una falsa sicurezza sulla comprensione del sistema.

Normative e regolamentazioni: come garantire l’affidabilità dell’IA

La soluzione non è solo tecnica. Per questo servono regole chiare, come quelle previste dall’AI Act europeo, che richiedano alle aziende di rendere i loro sistemi davvero trasparenti, controllabili e comprensibili per le persone che li usano.

IA vs informatica tradizionale: i vantaggi

Mentre l’intelligenza artificiale continua a catturare l’attenzione dei media e delle aziende, è importante ricordare che l’informatica tradizionale rimane spesso la soluzione più sensata per molti problemi. Gli algoritmi classici, quelli che usiamo da decenni, offrono infatti vantaggi significativi che non dovremmo sottovalutare nella corsa verso l’innovazione.

Prendiamo ad esempio la spiegabilità: quando usiamo un algoritmo tradizionale per ordinare una lista di prodotti per prezzo o per calcolare il percorso più breve tra due città, sappiamo esattamente cosa sta succedendo ad ogni passaggio. Non c’è mistero, non ci sono scatole nere da decifrare. Ogni decisione ha una logica chiara e tracciabile, qualcosa che nell’era dell’IA diventa un lusso prezioso.

L’efficienza energetica dell’informatica tradizionale

Dal punto di vista ambientale, poi, la differenza è notevole. Mentre addestrare un potente modello di intelligenza artificiale può consumare l’energia equivalente a quella di centinaia di case per mesi, un algoritmo classico spesso risolve lo stesso problema con una frazione di quell’energia. In un mondo sempre più attento alla sostenibilità, questa efficienza energetica non è solo una questione di costi, ma anche di responsabilità.

E a proposito di costi, le aziende stanno scoprendo che non sempre più complesso significa migliore. Implementare e mantenere un sistema basato su algoritmi tradizionali costa spesso molto meno rispetto a soluzioni di IA avanzate, che richiedono hardware specializzato, grandi quantità di dati e team di esperti altamente qualificati, costosi e non sempre facile da trovare. Per molte applicazioni pratiche, la soluzione più semplice si rivela anche la più economica e affidabile.

La potenza dei grafi nelle soluzioni tradizionali

Un esempio di come l’informatica tradizionale possa essere sorprendentemente potente è quello della graph analytics, l’analisi dei grafi. Questa tecnica, che ha radici profonde nella matematica e nell’informatica classica, si sta rivelando uno strumento indispensabile per comprendere e risolvere problemi complessi del mondo moderno.

Graph analytics per il rilevamento di frodi finanziarie

Consideriamo il caso delle transazioni bancarie, un settore dove la trasparenza e la comprensibilità sono fondamentali. Ogni volta che trasferiamo denaro, facciamo un acquisto con carta o riceviamo lo stipendio, stiamo implicitamente creando un collegamento in una rete gigantesca. I Data Engineer possono rappresentare questa rete come un grafo, dove ogni conto bancario diventa un punto (chiamato “nodo”) e ogni transazione diventa una linea che collega due punti (chiamata “arco”).

Questa rappresentazione apparentemente semplice rivela pattern straordinari. Gli stessi algoritmi che Google usa per classificare le pagine web – come il famoso PageRank, sviluppato dai fondatori di Google Larry Page e Sergey Brin – possono essere adattati per identificare comportamenti sospetti nel sistema bancario. Un conto che riceve improvvisamente molte piccole transazioni da fonti diverse potrebbe essere coinvolto in attività di riciclaggio, e l’algoritmo può segnalarlo facilmente.

Ma la vera forza di questi approcci sta nella loro trasparenza. Quando un analista riceve un alert, può seguire visivamente i percorsi del denaro attraverso la rete, capire esattamente perché un certo conto è stato marcato come sospetto e spiegare le proprie conclusioni ai supervisori o alle autorità. Non c’è bisogno di decifrare decisioni prese da una “scatola nera”: ogni passaggio del ragionamento è chiaro e verificabile, rendendo il lavoro degli esperti finanziari più efficace e credibile.

Transazioni circolari e riciclaggio: rilevamento con database a grafo

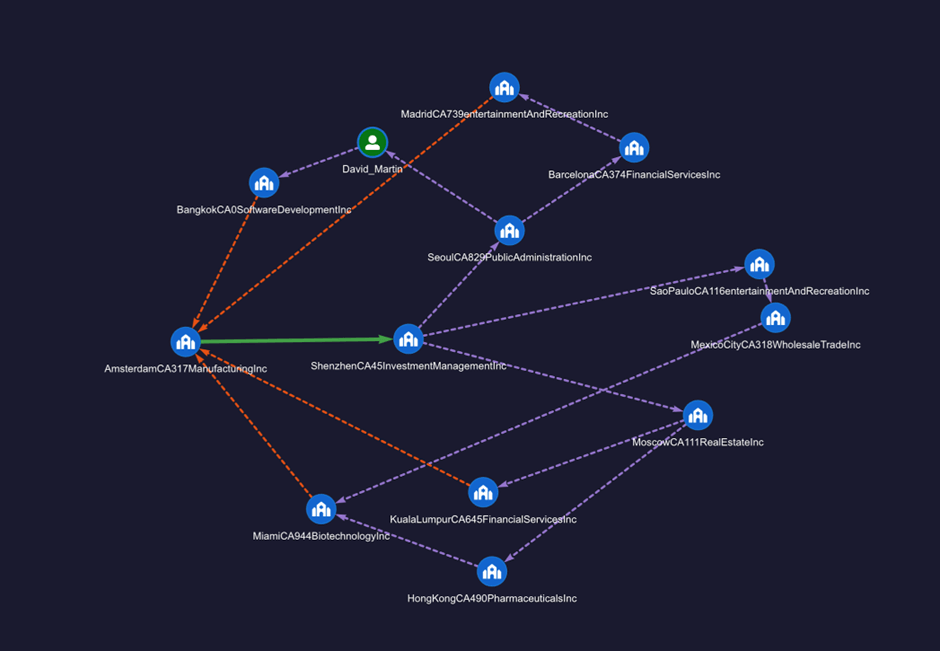

Si consideri l’esempio illustrato in figura, in cui un grafo rappresenta le transazioni finanziarie tra conti bancari fittizi appartenenti a diverse aziende. In particolare, si osserva come l’azienda Amsterdam CA317 Manufacturing Inc effettui una transazione in uscita (rappresentata con un arco verde) verso un’altra entità, e come, attraverso una serie di passaggi intermedi, i fondi ritornino infine all’azienda stessa (archi tratteggiati in rosso). Questo è esempio di circular transaction (o round-tripping). Le transazioni circolari rappresentano una pratica contabile e finanziaria in cui un’azienda vende un bene inutilizzato a un’altra società, accordandosi contemporaneamente per ricomprare lo stesso bene — o uno simile — a un prezzo pressoché identico.

In apparenza, queste operazioni possono sembrare normali transazioni commerciali, ma in realtà non producono alcun reale valore economico. Si tratta infatti di semplici scambi che, pur non generando utili concreti, vengono registrati nei bilanci come vendite e acquisti, creando l’illusione di attività economica intensa e crescita aziendale. Questo comportamento viola il principio contabile della “sostanza sulla forma”, secondo cui le operazioni devono essere registrate in base alla loro reale sostanza economica, non solo alla loro forma legale.

Il round-tripping può quindi essere usato in modo fraudolento per far apparire un’azienda più attiva o in crescita di quanto non sia in realtà, attirando investitori ingannati dall’aumento apparente del volume d’affari, anche in assenza di profitti reali. Questo meccanismo è stato utilizzato in passato per gonfiare temporaneamente il valore di mercato di aziende note, tra cui Enron.

Lo stesso schema delle transazioni circolari viene spesso impiegato anche nel riciclaggio di denaro. In questo contesto, il denaro di provenienza illecita viene fatto “circolare” attraverso una catena di operazioni finanziarie che, in apparenza, risultano perfettamente legittime.

A ogni passaggio, l’origine illecita dei fondi viene ulteriormente offuscata: le transazioni coinvolgono soggetti diversi, conti bancari in giurisdizioni differenti o aziende di comodo, rendendo difficile ricostruire il percorso originale del denaro.

Alla conclusione del ciclo, i fondi ritornano al punto di partenza, o a un’entità collegata al soggetto iniziale, ma ora appaiono come proventi leciti, pronti per essere reinseriti nel sistema economico senza sollevare sospetti. Questo tipo di schema, se non intercettato, consente di “ripulire” capitali illeciti con una strategia che sfrutta la complessità e l’opacità delle operazioni circolari.

Utilizzando un database a grafo, come ad esempio Ultipa Graph, è possibile modellare questo tipo di relazioni in modo naturale ed efficace. Una delle principali potenzialità di questa tecnologia è la capacità di rilevare schemi ricorrenti – in questo caso dei cicli – attraverso semplici interrogazioni, senza la necessità di addestrare e mantenere complessi modelli di intelligenza artificiale. Non a caso, una delle più importanti banche centrali al mondo sta utilizzando Ultipa Graph per analizzare transazioni finanziarie effettuate tramite criptovalute per individuare frodi.

Sebbene le tecniche di riciclaggio e frode finanziaria siano in continua evoluzione, esse si basano spesso su schemi logici riconoscibili, concepiti per mascherare attività illecite all’interno di sequenze di operazioni apparentemente legittime. Una volta individuato un nuovo schema fraudolento, è possibile tradurlo in una query sul database a grafo, consentendo l’identificazione rapida di comportamenti simili su larga scala.

Quanto costa ad esempio implementare un modello per individuare circular transaction, utilizzando un graph database? Assumendo di aver già importato i dati in un database a grafo e che supporti il nuovo standard GQL, l’individuazione di tutti i pattern su descritti richiede l’esecuzione di una semplice – ma potentissima – interrogazione, simile a quella riportata di seguito:

MATCH frodi_sospette=

(origine:Account)-[:Transaction]->{1,20}<-(origine)

RETURN frodi_sospette

Con questa query si individuano le transazioni che partono da un account e, dopo un numero elevato di passaggi (assumiamo fino a venti), riportano del denaro al conto originario. E’ chiaro che ci sono molti altri aspetti da considerare, come scartare le transazioni circolari lecite per evitare falsi positivi. In ogni caso non c’è bisogno di allenare e aggiornare una IA per individuare questo pattern e non c’è bisogno di aggiornare costantemente il modello di IA per ottenere risultati buoni nel tempo. Soprattutto, l’elenco delle frodi sospette è spiegabile: sono transazioni circolari. Nulla di più spiegabile! Quanta energia abbiamo consumato per definire questo modello? Zero energia, zero CO2.

L’approccio basato su grafi si dimostra particolarmente utile nella lotta contro i crimini finanziari, offrendo strumenti agili e trasparenti per l’analisi di transazioni complesse e per l’individuazione di pattern anomali difficilmente rilevabili con tecniche tradizionali. La graph analytics è molto di più di questo in quanto è sempre più utilizzata in tanti altri ambiti.

IA vs informatica tradizionale: verso un’integrazione bilanciata

Negli ultimi mesi si sta delineando una distinzione sempre più netta tra due visioni contrapposte. Da un lato, coloro che fanno affidamento sui metodi deterministici mettono al centro del dibattito la chiarezza, l’affidabilità e la spiegabilità dei sistemi. Dall’altro, sostenitori più orientati all’intelligenza artificiale vedono nei modelli adattivi una svolta capace di superare i limiti della programmazione tradizionale. Tuttavia, questa polarizzazione rischia di oscurare una considerazione essenziale: l’innovazione più solida nasce spesso dall’integrazione, non dall’opposizione.

L’esperienza concreta delle organizzazioni dimostra infatti che nessun approccio, da solo, è in grado di rispondere pienamente alla varietà e complessità delle sfide attuali. L’informatica tradizionale continua a offrire vantaggi decisivi in contesti che richiedono elevata precisione, controllo rigoroso e aderenza a normative specifiche. L’intelligenza artificiale, invece, si dimostra particolarmente efficace in ambiti caratterizzati da dati eterogenei, dinamici e difficilmente riconducibili a regole fisse.

Non si tratta, quindi, di decretare un vincitore, ma di riconoscere che questi due approcci rappresentano prospettive complementari. Il futuro dell’innovazione si costruisce su una visione integrata, in cui la trasparenza degli algoritmi classici si coniuga con la capacità adattiva dei sistemi intelligenti. Le organizzazioni che sapranno gestire in modo efficace questa dualità saranno meglio attrezzate non solo per affrontare la complessità del presente, ma anche per trarne vantaggio.

Questa evoluzione richiede nuove competenze. Servono professionisti capaci di muoversi con flessibilità tra modelli diversi, in grado di valutare di volta in volta quale tecnologia risponda meglio a esigenze specifiche. Figure che non si limitino a padroneggiare una singola metodologia, ma che siano in grado di progettare soluzioni che integrino diverse prospettive in modo coerente.

L’intelligenza artificiale non rappresenta una minaccia alla trasparenza, così come l’informatica tradizionale non è un ostacolo all’innovazione. Entrambe, se adottate con criterio, possono essere elementi fondamentali di una strategia tecnologica equilibrata. Come spesso accade, la sfida principale non è tecnica, ma organizzativa: sviluppare un approccio che favorisca l’interoperabilità tra sistemi, l’integrazione tra competenze e una governance capace di bilanciare efficienza, responsabilità e adattabilità.