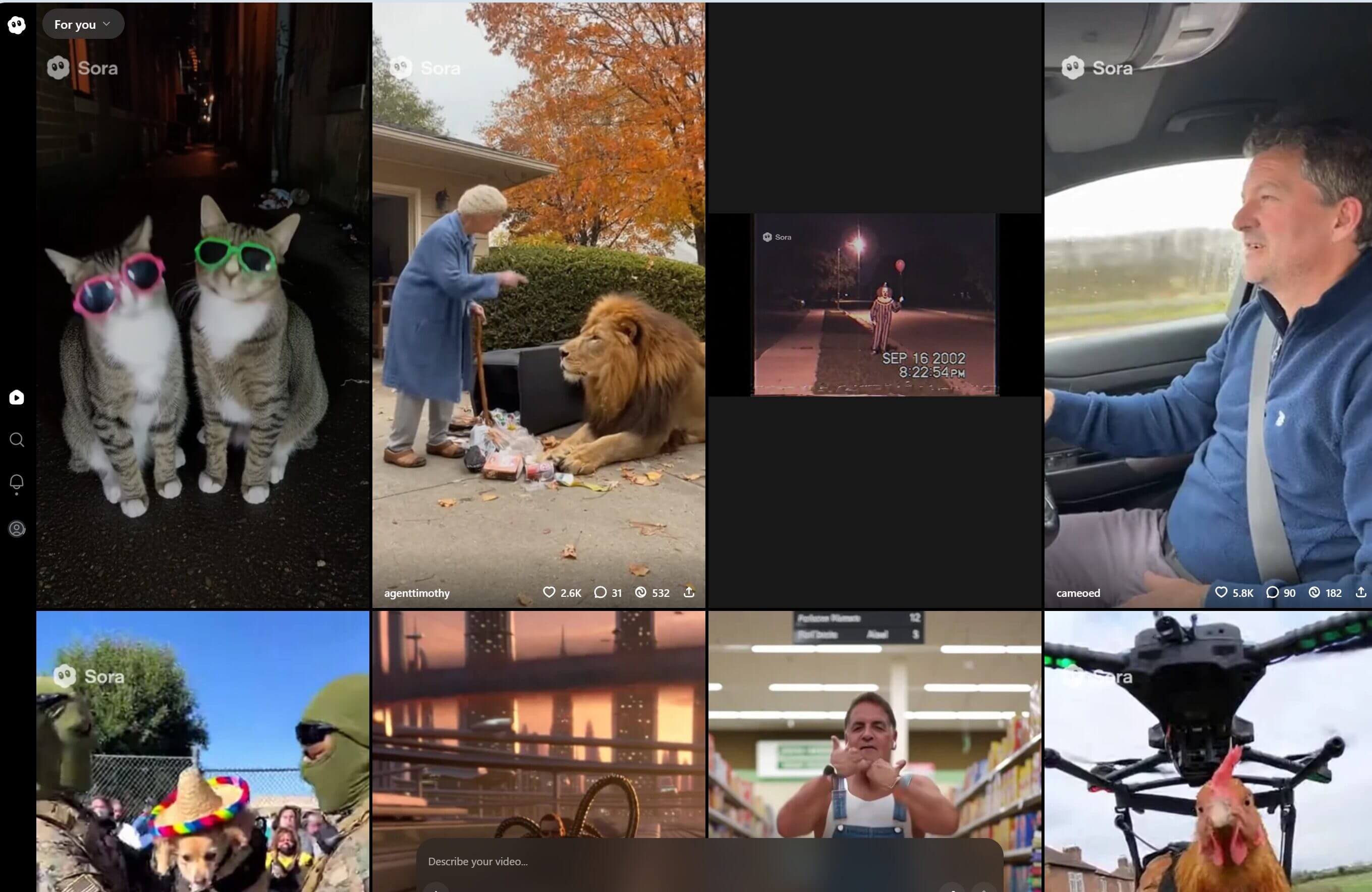

Il lancio di Sora2, il nuovo modello video di OpenAI, con l’app Sora ha trasformato la generazione automatica di immagini in un’esperienza di pubblicazione sociale, rendendola una piattaforma dotata di feed pubblico, funzioni di commento e possibilità di remix dei contenuti generati.

Sora: perché il “TikTok con l’AI” cambierà i social per sempre

È un passaggio epocale, in quanto la creazione sintetica diventa circolazione, e la circolazione (a sua volta) produce di per se stessa valore informativo, economico e politico.

Indice degli argomenti

Sora 2 e App Sora: perché è il trionfo del sintetico sul reale

Sul piano tecnico, Sora2 introduce una maggiore controllabilità temporale e spaziale anche rispetto alla sua precedente versione, ovverossia la capacità di stabilire sia che cosa accade in una scena, sia come ciò accade, con coerenza fisica dei movimenti, sincronizzazione audio-video e resa più stabile delle texture e delle interazioni tra oggetti.

Il risultato sono video coerenti, dotati di fisica realistica e sincronizzazione audio dove per la prima volta controllo narrativo e resa cinematografica si integrano.

OpenAI la descrive come la prima piattaforma capace di “far comprendere ai modelli di AI le regole della fisica del mondo reale”.

Il nostro volto e quello di altre persone in video con AI

A ciò si aggiunge la funzione cameo, che consente all’utente di inserire il proprio volto o quello di un’altra persona nel video generato: si tratta di una funzione che, pur apparendo prima facie come gesto apparentemente innocuo, introduce in realtà una novità giuridica sostanziale, cioè l’identità personale come prompt; in pratica il soggetto passa da autore o spettatore, a materia prima della rappresentazione.

E’ il deepfake che diventa alla portata di tutti, in altre parole. E il fenomeno può essere così ultra popolare, con i suoi aspetti positivi (creatività, satira) e negativi.

Sora, la viralità del falso con l’AI: perché

L’app Sora – sebbene disponibile solo su invito, negli Usa e in Canada – in una settimana dal lancio ha superato il milione di donwload.

Il successo è stato alimentato anche dal formato ibrido dell’app, che consente di condividere i video generati direttamente in feed pubblici e di interagire con quelli altrui, trasformando l’intelligenza artificiale in una rete sociale della creazione.

In più i video generati sono scaricabili e quindi condivisibili su altri social.

Questa dimensione “sociale” dell’AI, che rende la generazione di contenuti un atto collettivo e immediatamente esibito, sposta il baricentro dell’analisi giuridica dalla tutela del dato e dell’autorialità, alla gestione della viralità come fattore di rischio sistemico ai sensi degli articoli 34–37 del Digital Services Act.

I casi inquietanti

Nei giorni immediatamente successivi al lancio, The Guardian ha documentato come diversi utenti abbiano spinto Sora2 verso territori di rappresentazione estrema, ottenendo video di sparatorie simulate, scene di panico in luoghi pubblici o frammenti che riproducono conflitti bellici reali, come Gaza e l’Ucraina. Alcune clip, caricate sui social, mostravano folle che fuggono da stazioni metropolitane o soldati che interagiscono con civili feriti, il tutto completamente generato e non reale.

C’è quindi una doppia ricaduta: disinformazione a nuovi livelli e diffusione di deepfake potenzialmente lesivi della reputazione di terzi.

Si è quindi andati ben oltre la falsificazione involontaria, approdando all’uso intenzionale della generazione per costruire dei falsi credibili, in cui l’AI riformula la realtà secondo criteri di verosimiglianza. Naturalmente, quando il verosimile diventa indistinguibile dal vero, la linea di demarcazione tra creatività e manipolazione perde il suo significato giuridico.

Aspetto particolarmente inquietante è quello della “resurrezione digitale”.

Diverse testate hanno raccontato come gli utenti abbiano generato video con celebrità defunte come sketch in cui Robin Williams recita battute inedite, Michael Jackson alle prese con nuovi passi di danza, Stephen Hawking che fa acrobazie su uno skateboard, e perfino rappresentazioni di Adolf Hitler o Stalin in contesti distorti, usati per propaganda o satire borderline (ad esempio, Spongbob travestito da Hitler).

Queste “resurrezioni sintetiche” finiscono col creare un doppio giuridico, ovvero persone la cui immagine, voce e movimenti continuano a esistere e a produrre effetti comunicativi dopo la morte, fuori dal controllo degli eredi o dei titolari dei diritti di immagine. Per questo, negli Stati Uniti, alcune famiglie (tra cui, proprio i familiari di Robin Williams) stanno valutando azioni legali per emotional distress e appropriazione indebita di immagine.

Deepfake, le questioni giuridiche

Il tema, oltre che etico, è giuridico e sistemico.

Il consenso impossibile

Il consenso alla generazione è elemento centrale per l’uso lecito dell’immagine di una persona, ma i defunti non possono esprimere consenso né revocarlo. Da parte sua, OpenAI dichiara di escludere le persone viventi dai dataset, ma non limita la rappresentazione di “personaggi storici” e, in generale, persone decedute. Così, l’assenza di consenso diventa eccezione di fatto.

Almeno, dopo le polemiche, ora per i nostri Cameo OpenAI ha messo qualche tutela.

Gli utenti possono impostare limiti più precisi su ciò che il loro Cameo può fare e dire utilizzando prompt di testo, come “Non inserirmi in video che contengono commenti politici” o “Non farmi dire questa parola”. Ci si può anche assicurare che il Cameo appaia con dettagli specifici, come indossare un capo di abbigliamento identificativo.

Diritto all’immagine e dignità postuma

Il diritto all’immagine è riconosciuto negli ordinamenti europei come estensione della personalità (art. 10 CEDU, art. 2 Cost. italiana). Tuttavia, la tutela post mortem è variabile e spesso solo morale; così, l’uso dell’immagine di un defunto in un video generato automatizza un concetto che il diritto non ha mai dovuto affrontare, cioè la reiterabilità infinita dell’identità.

Danno emotivo e sfruttamento economico

Se i video vengono monetizzati (tramite piattaforme o pubblicità) il problema si sposta dal piano morale a quello economico e l’interrogativo è su chi beneficia dello sfruttamento di un volto non più esistente, dato che gli eredi non hanno strumenti per rivendicare royalties o rimozioni immediate. Per questo, negli Stati Uniti, alcune famiglie stanno già valutando azioni per “emotional distress” e appropriazione indebita d’immagine dei loro cari.

Le norme sono inadeguate

L’AI Act prevede etichettature obbligatorie per i contenuti sintetici (come fa Sora con watermark, che gli utenti possono però rimuovere con facilità), ma non disciplina la generazione di identità postume; il GDPR non tutela i defunti; il Data Act non chiarisce a chi appartengano i dati biometrici sintetici.

In mancanza di parametri giuridici, la distinzione tra “celebrità storica” e “persona da tutelare” resta discrezionale e rappresenta un vuoto normativo che apre a una nuova forma di colonialismo dell’immagine: l’appropriazione della memoria come materiale generativo.

Il reato di deepfake nella legge italiana 132/2025

Di fronte a una simile proliferazione di contenuti falsificati, occorre tener presente che la legge italiana sull’intelligenza artificiale (legge 23 settembre 2025, n. 132) ha segnato l’ingresso formale dell’IA nel sistema normativo nazionale, introducendo tra gli interventi di natura penale (si tratta infatti di legge composita, che contiene tra l’altro al suo interno disposizioni eterogenee come principi generali, misure di coordinamento istituzionale, incentivi all’innovazione) il nuovo reato di diffusione illecita di contenuti manipolati o generati artificialmente, collocato nel Codice penale come articolo 612-quater, sotto il titolo dei delitti contro la libertà morale.

La norma punisce la produzione o la diffusione, con dolo, di contenuti audiovisivi alterati mediante intelligenza artificiale, qualora tali contenuti riproducano o simulino persone reali, con aggravanti in caso di danno alla reputazione, finalità di lucro o sfruttamento pornografico.

Si tratta di una disposizione che, per la prima volta in Italia, riconosce la falsificazione digitale come lesione autonoma della persona, indipendente dalla diffamazione o dalla violazione del diritto d’autore; la disposizione si inserisce in un quadro europeo più ampio, in cui gli articoli 30 e 34 del Digital Services Act impongono agli app store e alle piattaforme di garantire la tracciabilità dei trader e la gestione dei rischi sistemici, mentre l’articolo 54 dell’AI Act richiede che i modelli generativi etichettino chiaramente gli output sintetici.

L’Italia non è però un caso isolato. Alcuni ordinamenti, come la Corea del Sud, che dal 2023 punisce i deepfake a contenuto sessuale anche in assenza di diffusione, e diversi Stati degli USA (tra cui California e Texas, con leggi del 2019 e 2023), hanno già introdotto da qualche anno norme dedicate. Tuttavia occorre ammettere che il legislatore italiano è stato il primo in Europa a tipizzare il reato in modo unitario, includendo nella fattispecie ogni manipolazione idonea a ledere l’identità personale o reputazionale.

Il diritto penale deve però definire chi sia il responsabile del contenuto: in questa prospettiva, il legislatore italiano ha tentato di anticipare la tensione tra libertà creativa e tutela dell’identità, sebbene la formula “chiunque diffonde, pubblica, trasmette o cede immagini, video o contenuti di persone reali, manipolati o generati artificialmente in modo da apparire autentici, qualora ciò provochi un danno ingiusto”, celi diverse criticità. In particolare, la definizione di “contenuto manipolato con intelligenza artificiale” resta di fatto eccessivamente indeterminata e, soprattutto, il rischio maggiore è che la norma sia di fatto inefficace per la difficoltà probatoria tipica dei fenomeni digitali distribuiti, che non collima con l’incriminazione, la quale presuppone invece una linearità dell’azione incompatibile con l’opacità delle reti digitali.

Copyright e somiglianza algoritmica

Sora2 solleva anche questioni di proprietà intellettuale che vanno oltre la falsificazione personale, in quanto si tratta di un modello che apprende da milioni di filmati protetti, riproducendolo stile, atmosfere e coreografie di opere cinematografiche o musicali riconoscibili, quindi video che ricordano Star Wars, scene alla Pixar, danze simili a Thriller o frammenti in stile Kubrick.

Il tema è già emerso in casi concreti come la causa Getty Images vs Stability AI (High Court di Londra, 2024), in cui l’agenzia fotografica ha denunciato l’uso non autorizzato di milioni di immagini per l’addestramento del modello Stable Diffusion. Analoghe tensioni si riscontrano in Italia, dove la SIAE ha sollevato il problema del text and data mining ai sensi della Direttiva UE 2019/790, chiedendo la possibilità di opt-out dai dataset generativi. Questi episodi mostrano come l’uso di opere protette non riguardi più la copia diretta, ma l’assimilazione strutturale di interi linguaggi visivi.

Non si tratta di plagio in senso tecnico, quanto di un fenomeno di assimilazione algoritmica che crea un “look-and-feel” proprietario non riconducibile a un autore umano e in cui Il problema giuridico riguarda la somiglianza sostanziale: se un’opera generata riprende un’estetica riconoscibile, l’assenza di un autore umano non elimina la violazione economica del diritto. In parallelo, l’AI Act prevede l’obbligo per i fornitori di modelli generativi di documentare i dataset di addestramento e di garantire la possibilità di audit indipendenti sulla provenienza dei dati. Tuttavia, l’etichettatura o la disclosure non risolvono il nodo di fondo poiché la somiglianza non è sempre copia, come l’imitazione non è sempre illecita; in questo modo il diritto resta prigioniero della sua semantica analogica: l’opera deve somigliare troppo per essere tutelata, ma non abbastanza per essere protetta.

L’Europa tra etichettatura e responsabilità

Nel contesto europeo, l’intersezione tra AI Act e Digital Services Act rappresenta il primo tentativo di disciplinare congiuntamente produzione e diffusione di contenuti sintetici, in quanto il primo regola il come dell’intelligenza artificiale; il secondo, il dove e il quanto della sua circolazione; entrambi condividono una fragilità strutturale cioè la presunzione che l’utente sia in grado di riconoscere la natura artificiale di ciò che vede. L’esperienza empirica mostra però il contrario, dal momento che l’immagine sintetica è in grado di superare la soglia cognitiva del sospetto.

Il rischio è appunto quello della credibilità automatizzata (e non più della semplice disinformazione) quale condizione in cui la fiducia sostituisce la verifica e la viralità rimpiazza la prova.

In questo scenario, strumenti come i watermark digitali rischiano di avere valore più simbolico che tecnico poichè segnalano un’etica dell’intenzione, ma non una garanzia effettiva. Al diritto europeo viene ora richiesto di fare un salto di qualità e di governare la percezione, anziché limitarsi a regolare la comunicazione.

Governare l’immaginario: il diritto e la creazione automatica

L’intera vicenda Sora2, tra mercato nero degli inviti, video ingannevoli e resurrezioni sintetiche, descrive un ecosistema in cui l’AI precede il diritto e lo costringe all’inseguimento, in quanto la tecnologia è diventata soggetto di produzione normativa implicita (non più solo oggetto da regolare): ogni piattaforma costruisce le proprie regole d’ingaggio, i propri standard di trasparenza, le proprie eccezioni etiche.

Il diritto europeo, pur dotato di strumenti avanzati (AI Act, DSA, GDPR, Data Act, Legge italiana sull’AI) non riesce a operare in sincronia con la realtà tecnica, ma con norme che agiscono ex post, mentre i modelli generativi producono in tempo reale.

Finché non si costruirà un sistema di certificazione algoritmica, con audit obbligatori e identificatori resistenti alla manipolazione, la fiducia resterà affidata al marchio e non alla prova.

Il futuro della governance dell’intelligenza artificiale non dipenderà dalla sua capacità di “creare”, ma da quella di rendere visibile il processo della creazione e finché l’immaginario potrà essere acquistato, imitato o resuscitato senza responsabilità, ogni invito a Sora2 resterà il simbolo perfetto della nostra epoca: una chiave d’accesso al potere di generare, ma non ancora al diritto di comprendere.

Tuttavia, l’impatto di Sora2 è sociale, estetico e linguistico, oltre che normativo. In pochi giorni, il modello ha trasformato milioni di utenti in produttori di immagini e ogni prompt è diventato un atto comunicativo, ogni video un messaggio destinato al consumo pubblico. Se TikTok aveva reso ognuno regista del proprio tempo, Sora2 rende ognuno autore di mondi simulati, in un salto qualitativo nella cultura visiva, in cui la viralità sostituisce la competenza e la condivisione prende il posto dell’intenzionalità.

In questa dinamica, ciò che conta è la capacità dell’immagine di circolare, non importa se sia reale o meno. Il diritto, costretto a inseguire l’immaginario, si trova di fronte a un potere nuovo, cioè quello della creazione immediata e replicabile, in cui ogni spettatore è anche autore e ogni autore è già pubblico. È la logica dell’immagine infinita, che anticipa e dissolve il concetto stesso di limite giuridico.

Se è vero che ogni epoca ha avuto le proprie falsificazioni, la nostra le ha automatizzate. Ecco perché la verità, nell’era dei deepfake, non è più un fatto da provare, ma un diritto da garantire.