Nel giro di pochi anni l’Intelligenza artificiale è passata dal suggerire la “playlist del giorno” a cimentarsi, almeno in parte, nel lavoro dei ricercatori in laboratorio.

Le ultime iniziative annunciate da OpenAI, ossia il benchmark FrontierScience e gli esperimenti di biologia wet lab con GPT-5, mostrano quanto rapidamente tale tecnologia stia entrando nel cuore della ricerca scientifica, sollevando allo stesso tempo entusiasmo e timori.

Indice degli argomenti

GPT-5 e ricerca scientifica: cosa misura FrontierScience

FrontierScience è il nuovo banco di prova con cui OpenAI vuole rispondere a una domanda cruciale: un modello di Intelligenza artificiale è davvero in grado di ragionare come uno scienziato?

Oppure si limita a ripetere informazioni imparate in addestramento?

Oltre la scelta multipla: quesiti originali e set “gold”

A differenza dei classici test a scelta multipla, questo benchmark (parametro di riferimento) raccoglie oltre 700 quesiti originali di fisica, chimica e biologia, con un sottoinsieme “gold” di 160 problemi usati per la valutazione standardizzata.

Le domande non chiedono semplicemente di ricordare una formula: costringono il modello a seguire passaggi logici, fare calcoli, collegare concetti e proporre soluzioni strutturate, proprio come farebbe un dottorando alle prese con un problema complesso.

Come funziona il benchmark tra “Olympiad” e “Research”

La particolarità di FrontierScience è la sua divisione in due grandi aree: una parte “Olympiad”, con 100 problemi pensati da ex medagliati delle Olimpiadi Internazionali della Matematica, e una parte “Research”, con 60 sotto-compiti che imitano il lavoro di ricerca vero e proprio, scritti da scienziati con titolo di dottorato.

Nel primo caso si tratta di quesiti molto vincolati, spesso con risposta numerica o espressione precisa, che misurano la capacità di arrivare al risultato corretto in maniera rigorosa.

Nel secondo caso, invece, le risposte sono aperte, spesso lunghe e articolate, e vengono giudicate su una scala da 0 a 10 punti, valutando completezza, correttezza e qualità del ragionamento.

Una soluzione viene considerata “giusta” solo se raggiunge almeno 7 punti, e la valutazione delle risposte è affidata a una procedura automatizzata che usa a sua volta un modello di Intelligenza artificiale, progettata per ridurre errori e incoerenze attraverso più passaggi di controllo e confronto tra giudizi.

I risultati di GPT-5.2 e perché il progresso resta incompleto

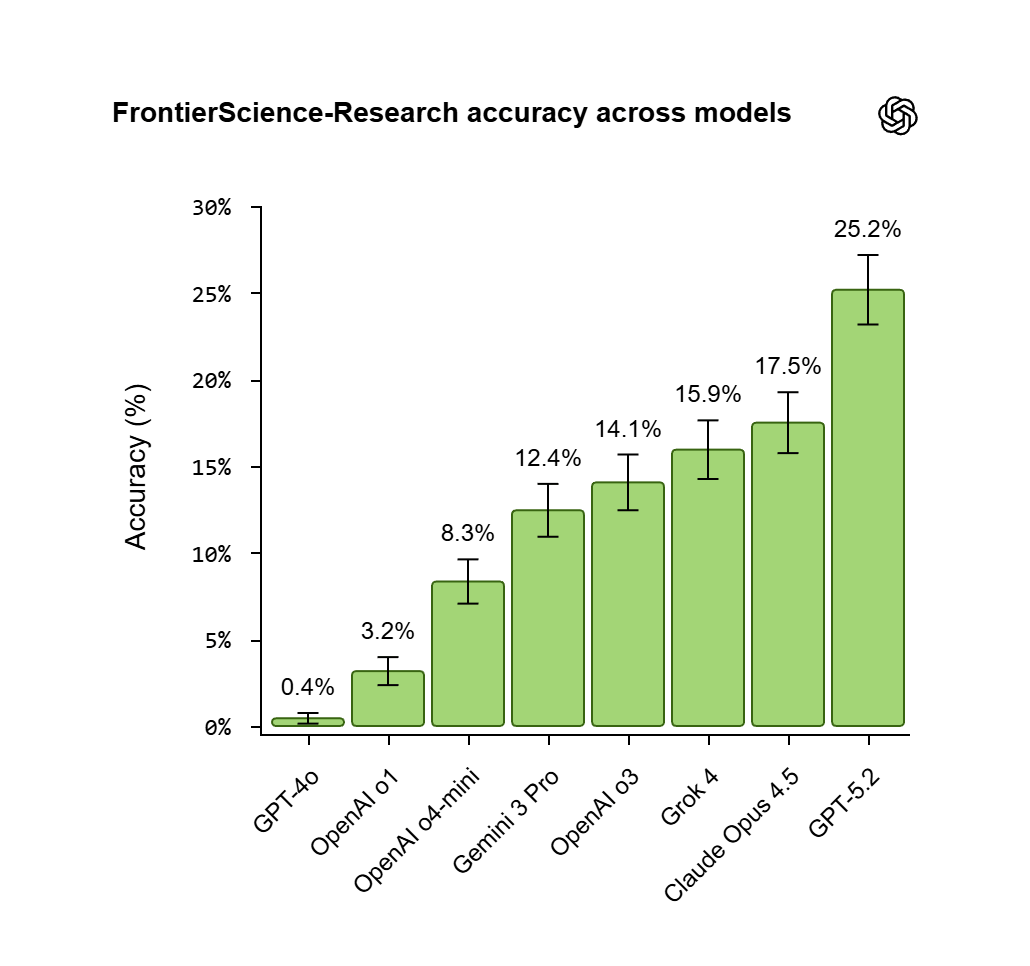

Le prestazioni dei modelli di ultima generazione su questo benchmark raccontano una storia di progresso impressionante ma incompleto.

Secondo OpenAI, GPT-5.2 è oggi il modello con le migliori performance complessive, capace di risolvere circa il 77% dei problemi “in stile” Olimpiadi della Matematica e il 25% dei compiti “open-ended” di ricerca, superando concorrenti come Claude Opus 4.5 e Gemini 3 Pro (almeno sul primo fronte).

Alcune analisi di settore sottolineano come questi numeri rappresentino un salto enorme rispetto ai benchmark a livello di PhD (dottorato di ricerca) di solo due anni prima, dove GPT-4 si fermava intorno al 39%.

Comunque, appena ci si allontana dai problemi “puliti” e ben strutturati, le prestazioni crollano e l’Intelligenza artificiale torna a mostrare limiti significativi.

GPT-5 e ricerca scientifica: i limiti ammessi dagli stessi autori

In effetti, gli stessi creatori di FrontierScience ammettono i limiti del test: si tratta pur sempre di problemi ben definiti, scritti da esperti e confinati al testo.

Non coprono elementi essenziali della ricerca reale come l’ideazione di ipotesi davvero nuove, il lavoro di gruppo, la gestione degli errori sperimentali o l’uso di dati e immagini.

Eppure, questo tipo di valutazione “a monte” è visto come un passo necessario per capire quali capacità l’Intelligenza artificiale stia sviluppando, prima di permetterle di interagire con strumenti più potenti e contesti potenzialmente a rischio.

La stessa OpenAI ha definito FrontierScience come uno strumento preliminare che aiuta a comprendere se i modelli sono pronti per applicazioni più delicate come quelle della ricerca scientifica.

Nel wet lab: GPT-5 e ricerca scientifica tra provette, clonaggio e robot da banco

Un altro elemento affascinante di questa storia è che FrontierScience non nasce nel vuoto, ma arriva dopo anni di esperimenti in cui i modelli di OpenAI hanno imparato non solo a “passare gli esami”, ma anche a contribuire a risultati scientifici reali.

In uno degli studi più citati, dedicato agli “early science acceleration experiments” con GPT-5, un gruppo di ricercatori racconta come il modello sia stato in grado di risolvere un problema di matematica aperto dagli anni Settanta, aiutando a trovare una nuova dimostrazione per un enigma del matematico ungherese Paul Erdős e suggerendo miglioramenti in algoritmi di ottimizzazione rimasti sostanzialmente invariati per decenni.

In biologia, lo stesso filone di ricerca descrive casi in cui GPT-5 ha analizzato in pochi minuti dati sperimentali complessi per proporre meccanismi in grado di spiegare comportamenti inaspettati delle cellule immunitarie, poi messi alla prova e confermati da esperimenti tradizionali.

Questi esempi, uniti ai risultati del laboratorio wet lab, suggeriscono un cambio di paradigma: l’Intelligenza artificiale non è più solo un motore di ricerca molto evoluto, ma comincia a comportarsi come un “collega” che legge articoli, incrocia risultati, propone ipotesi e talvolta coglie collegamenti che gli esseri umani non avevano visto.

Il punto non è tanto che il modello “pensi” come uno scienziato, quanto il fatto che, inserito in un contesto di lavoro ben progettato — con esperti in carne ed ossa che filtrano e verificano — possa aumentare la capacità complessiva del gruppo di esplorare idee nuove e percorsi sperimentali non banali.

La sfida per università, centri di ricerca e imprese sarà capire come integrare questi strumenti in modo sistematico, trasformando casi isolati in prassi quotidiana.

Sarà fondamentale comprendere chi potrà usare modelli di questo tipo, con quali dati, con quali limiti e con quale livello di responsabilità in caso di errori o conseguenze inattese.

Rischi biologici e cornici di sicurezza: cosa cambia con GPT-5

Se FrontierScience misura quanto l’Intelligenza artificiale sa ragionare “sulla carta”, l’altro annuncio di OpenAI entra invece nel cuore del laboratorio, dove si maneggiano pipette, provette e reagenti.

In una serie di esperimenti condotti con partner come la società di bio-sicurezza Red Queen Bio (della quale è investitore), GPT-5 è stato messo alla prova in un sistema di clonaggio molecolare controllato, con l’obiettivo di capire se un modello avanzato potesse davvero migliorare protocolli già consolidati.

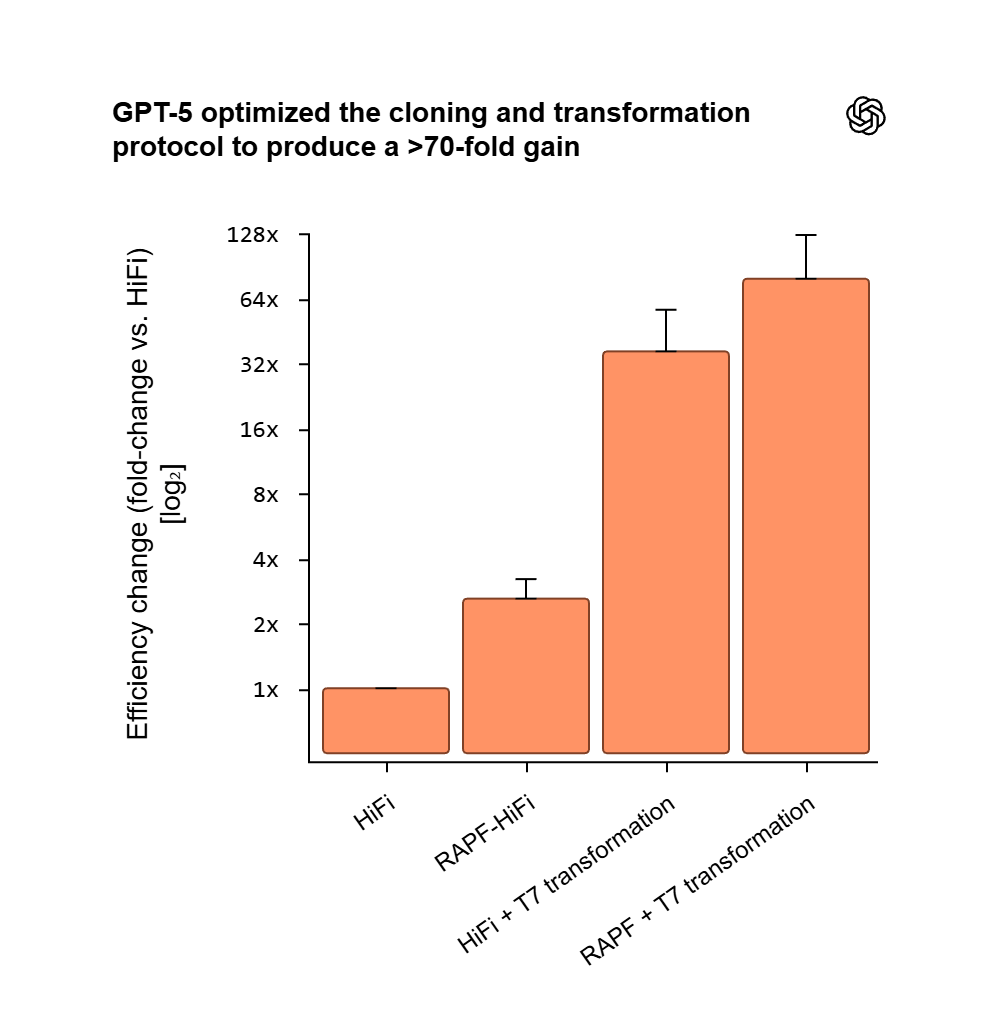

Il risultato più clamoroso è stato ottenuto quando il modello ha proposto una combinazione inedita di proteine, RecA e gp32, insieme a modifiche nella tempistica e nella temperatura delle reazioni, riuscendo a ottenere un aumento dell’efficienza di clonaggio di 79 volte rispetto al protocollo di base.

Le cronache del settore hanno battezzato la variante proposta da GPT-5 con il nome di RAPF-HiFi (RecA-Assisted Pair-and-Finish HiFi Assembly): un’estensione del classico protocollo Gibson in cui l’Intelligenza artificiale ha inserito le due proteine “helper”, gp32 e RecA, per aiutare le estremità del DNA a riconoscersi e appaiarsi in modo più efficiente.

In combinazione con una semplice (ma ingegnosa) modifica della fase di trasformazione, questo ha portato a un aumento di efficienza di 79 volte rispetto al protocollo di partenza, con risultati replicati in diverse condizioni sperimentali.

In queste prove, il modello non si limita a suggerire una lista di passaggi: entra in un ciclo iterativo che assomiglia sorprendentemente a quello di un giovane ricercatore.

Propone un cambiamento, osserva i risultati sperimentali restituiti dagli scienziati, analizza cosa non ha funzionato e affina le ipotesi successive.

È sempre l’essere umano a condurre fisicamente gli esperimenti, ma l’Intelligenza artificiale fornisce nuove direzioni, esplora parametri che normalmente richiederebbero settimane di tentativi e sbagli, e aiuta a comprimere in pochi cicli un processo che spesso richiede mesi di lavoro.

Altre collaborazioni citate da osservatori indipendenti, come il caso Retro Biosciences, parlano di miglioramenti fino a 50 volte in specifici biomarcatori di riprogrammazione cellulare grazie al supporto di modelli multimodali in grado di integrare testo, immagini e dati sperimentali.

Questo scenario alimenta una narrativa “affascinante”: la possibilità che l’Intelligenza artificiale diventi una sorta di sistema operativo per la ricerca biologica, capace di velocizzare la progettazione di esperimenti, ridurre gli sprechi, ottimizzare l’uso di reagenti costosi e rendere più produttivo il tempo passato in laboratorio.

Non a caso, economisti e studiosi in ambito scientifico cominciano a parlare dell’Intelligenza artificiale come di una tecnologia che può cambiare non solo la velocità, ma anche la geografia della ricerca scientifica.

Un paper della no-profit statunitense National Bureau of Economic Research sottolinea come una parte enorme del lavoro scientifico consista nel cercare tra combinazioni “quasi infinite” di esperimenti, idee e disegni di studio: una ricerca che l’Intelligenza artificiale può rendere più mirata, riducendo costi e barriere d’ingresso, soprattutto per i gruppi con meno risorse.

Allo stesso tempo, metriche come il nuovo GDPval di OpenAI, che misura le performance dei modelli su compiti “economicamente rilevanti” in decine di professioni, indicano che la frontiera non è più solo quella dei laboratori d’eccellenza, ma di tutto l’ecosistema del lavoro cognitivo avanzato, dalla consulenza alla progettazione ingegneristica.

Proprio nel campo biologico, però, l’entusiasmo si scontra con preoccupazioni profonde.

Fin dal 2024 OpenAI ha avviato studi su come grandi modelli linguistici (LLM o Large Language Models) possano, potenzialmente, aiutare nella creazione di minacce biologiche, arrivando alla conclusione che GPT-4 offriva solo un aumento “modesto” di capacità rispetto al non usare l’Intelligenza artificiale, riconoscendo la necessità di sistemi di allerta precoce e collaborazione con istituzioni specializzate.

Con l’arrivo di GPT-5 e dei nuovi agenti automatizzati, la stessa azienda californiana ha scelto un approccio prudenziale, classificando il modello come “alto rischio” per l’ambito biologico e chimico e attivando procedure di sicurezza più stringenti, pur dichiarando di non avere prove definitive che possa permettere a un “principiante” di creare armi biologiche.

Nel frattempo, il dibattito sulla sicurezza non si limita alle dichiarazioni aziendali.

Esperti e istituzioni, come l’AI Safety Institute nel Regno Unito, stanno sottoponendo questi sistemi a test avversari per trovare vulnerabilità, tentare di forzare i modelli a rilasciare istruzioni pericolose o a bypassare i filtri di sicurezza.

OpenAI, dal canto suo, descrive un insieme multilivello di protezione per GPT-5: dal monitoraggio continuo delle minacce alla classificazione automatica dei contenuti sensibili, fino alla possibilità di bloccare o bandire gli account che cercano deliberatamente di usare l’Intelligenza artificiale per scopi malevoli o per aggirare le policy esistenti.

Ma anche nella biologia sperimentale “benigna” è la cornice a fare la differenza.

Tutto il lavoro sul clonaggio molecolare e sugli altri protocolli si è svolto in ambienti strettamente controllati, con sistemi biologici scelti per ridurre al minimo qualsiasi rischio, filtri che impediscono al modello di suggerire esperimenti pericolosi e un oversight esterno in linea con il Preparedness Framework che OpenAI ha iniziato a implementare per anticipare scenari critici.

Gli esperti di bio-sicurezza coinvolti nelle analisi sottolineano che, per ora, si tratta di dimostrazioni circoscritte: l’Intelligenza artificiale non può prendere autonomamente iniziative pericolose, e ogni passo è supervisionato da scienziati che conoscono bene il contesto.

Tuttavia, se queste capacità continueranno a crescere, sarà inevitabile affrontare domande più ampie su come regolamentare l’uso di strumenti in grado di manipolare informazioni sensibili in genetica, virologia e altri campi estremamente delicati, a livello sia nazionale sia internazionale.

Il confine che si assottiglia: perché GPT-5 e ricerca scientifica contano per tutti

Vista dall’esterno, questa corsa tra capacità e controlli ricorda l’equilibrio delicato che la società co-fondata da Elon Musk sta cercando di costruire intorno alle tecnologie più potenti.

Da un lato, benchmark come FrontierScience mostrano che l’Intelligenza artificiale può già oggi esibire livelli di ragionamento scientifico comparabili a quelli di studenti eccellenti e, in alcuni compiti, di ricercatori alle prime armi.

Dall’altro, gli stessi test rivelano che i modelli continuano a commettere errori di logica, calcolo e comprensione di concetti di nicchia: errori che, in un contesto sperimentale, potrebbero tradursi in rischi concreti se non adeguatamente supervisionati.

In biologia, inoltre, la linea tra ricerca “benefica” e possibilità di abuso è spesso sottile, con ogni accelerazione che richiede un surplus di responsabilità e trasparenza da parte di chi sviluppa e usa questi strumenti.

Per il grande pubblico, abituato a pensare all’Intelligenza artificiale come a un chatbot che scrive email o riassume documenti, immaginare un modello che suggerisce nuovi meccanismi enzimatici o che ottimizza protocolli di clonaggio può sembrare fantascienza.

Eppure, i progressi descritti nelle ultime settimane indicano che si è già entrati in una fase nuova, in cui l’Intelligenza artificiale non si limita a organizzare il sapere esistente ma comincia a contribuire (seppur in modo limitato e supervisionato) alla generazione di nuove conoscenze scientifiche.

Per ora resta un assistente potente e fallibile, che ha bisogno di guide esperte e di regole chiare.

Ma la direzione di marcia è quella di una collaborazione sempre più stretta tra algoritmi e ricercatori umani, con tutto il carico di opportunità e dilemmi etici che questo comporta.

In questo quadro, le due notizie di OpenAI — il lancio di FrontierScience e i risultati nel wet lab — assumono un significato che va oltre l’ennesimo annuncio tecnologico.

Sono il segnale che il confine tra Intelligenza artificiale e ricerca scientifica si sta assottigliando: da una parte c’è un benchmark che quantifica, con numeri e punteggi, quanto un modello riesca a pensare come uno scienziato “su carta”; dall’altra ci sono protocolli reali, provette e robot da banco che dimostrano come quelle stesse capacità possano tradursi in azioni concrete in laboratorio.

Per il grande pubblico, abituato a vedere l’Intelligenza artificiale nei video fake, nei filtri fotografici o nei suggerimenti testuali, questa evoluzione invita a guardare la tecnologia con occhi diversi, più consapevoli.

Non come magia infallibile, ma come uno strumento potente che, se usato bene, può contribuire a scoprire nuovi farmaci, comprendere meglio le malattie e persino risolvere problemi scientifici rimasti aperti per decenni: a patto, ovviamente, di non perdere mai di vista i rischi, la trasparenza e la responsabilità che un simile potere comporta.