Una foto di famiglia, un’app di generazione video e la promessa seducente di trasformare chiunque in protagonista.

È il racconto (vero) con cui una giornalista statunitense del Wall Street Journal ha scoperto quanto sia facile trasformare il volto di suo figlio (neonato) in un mini elfo natalizio.

Indice degli argomenti

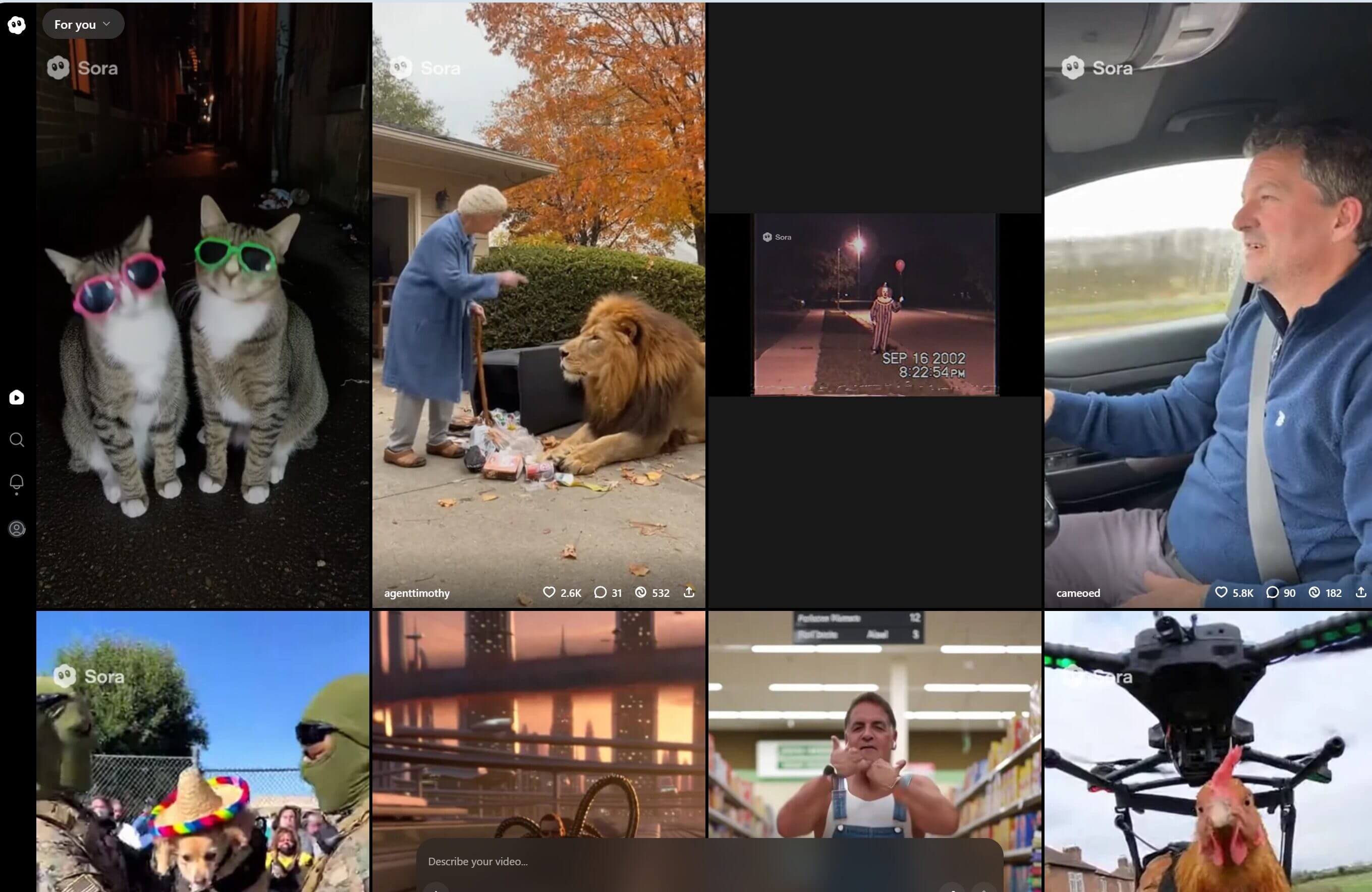

Sora 2 con Cameo e altri sistemi AI che “rubano” il volto

Quando un parente lo ha fatto usando una foto condivisa in chat, tramite strumenti oggi a portata di smartphone, e, in particolare, utilizzando la funzione Cameo della nuova app video Sora 2 (che si aggiunge agli altri generatori di immagini “ready-to-use” e agli editor “giocattolo” integrati nelle piattaforme social) l’effetto era davvero tenero e divertente.

Peccato che subito dopo sia arrivata la doccia fredda, cioè la consapevolezza: quel volto infantile era stato caricato sui server di una piattaforma globale, che per contratto può riutilizzarlo per “migliorare i propri modelli di AI”.

Da un gesto affettuoso e divertito nasceva così la sensazione opposta, cioè la perdita del controllo sulle fattezze del proprio figlio, cioè su ciò che ci rappresenta più intimamente, la nostra immagine.

Gli avatar digitali Cameo, Sora, Veo, Image Playground

Da qui le riflessioni della giornalista che sono quelle che dovremmo fare tutti noi.

Le nuove applicazioni di video generativo, fra cui, appunto, Sora, Veo e Image Playground, permettono di creare “cameo”, cioè veri e propri sosia digitali (o avatar) capaci di muoversi, parlare e interpretare scene mai vissute. Bastano pochi secondi di ripresa e qualche parola pronunciata davanti alla fotocamera per generare un duplicato digitale pronto a recitare in qualunque clip e scenario.

Che cos’è davvero un “cameo” e perché cambia le regole del gioco

Il “cameo” è un modello generativo personalizzato costruito a partire da pochi secondi di video: l’utente si inquadra, esegue micro-movimenti, pronuncia qualche parola chiave. Da quel momento, il sistema può sintetizzare volti e movimenti compatibili con la nostra fisionomia e inserirli in clip di fantasia. Ciò:

- abbassa brutalmente la soglia d’accesso: chiunque può “clonare” un volto, anche senza competenze di post-produzione;

- moltiplica i contesti d’uso: inviti, meme, micro-advertising, contenuti UGC, ma anche frodi, estorsioni, disinformazione.

- rende la clonazione “riutilizzabile”: una volta creato, il cameo può recitare in scenari sempre nuovi.

In sintesi, l’identità per fattezze diventa un token riutilizzabile e, se quel token esce dal perimetro iniziale di cui eravamo coscienti, per dolo, imprudenza o semplice leggerezza.

L’effetto è spettacolare, ad un prezzo invisibile ma pesantissimo: una copia del nostro volto risiede da qualche parte, pronta a essere richiamata da un algoritmo che non conosciamo, proprio come raccontato in prima persona dalla giornalista del WSJ. Pur avendo sperimentato la funzione cameo per pura ricerca giornalistica, ha infatti affermato di aver provato un disagio immediato e un profondo senso di vulnerabilità.

Le opzioni di sicurezza offerte da Sora (limiti d’uso, divieto di download, possibilità di eliminare le comparsate) non eliminano questa vulnerabilità e non sono in grado di fermare una nuova forma di furto d’identità: il furto di fattezze.

Le cinque faglie di rischio privacy attivate dai cameo

a) Riuso non previsto del volto

Anche se l’utente limita i permessi, il contesto reale di riuso resta spesso non trasparente: i contenuti possono finire in feed di altri soggetti, essere catturati con mezzi di fatto (screening su altri dispositivi), o rigenerati altrove. L’effetto è una perdita di controllo sul ciclo di vita del proprio “ritratto digitale”.

b) Ambiguità sul ruolo privacy: titolare o contitolare?

Chi è il titolare del trattamento quando un utente crea un cameo di un amico, lo condivide a un gruppo e lo monta in una clip? Provider e creatori potrebbero risultare contitolari per alcune fasi (determinazione congiunta dei mezzi e delle finalità della replica), mentre in altre il provider agirebbe da titolare esclusivo (es. uso per sicurezza, miglioramento modelli), con obblighi di informativa e basi giuridiche separate.

c) Raccolta di materiale di minori

I volti di minori circolano ovunque e l’uso di questi “in cameo” amplifica l’esposizione. Consenso dei genitori e cautele rafforzate restano essenziali, in quanto si tratta di uno dei campi dove l’asticella di necessità e proporzionalità è più alta, come ripetono autorità e board europei in tema di AI e riconoscimento facciale.

d) Watermarking e “labeling” non sono sempre efficaci

L’AI Act impone obblighi di trasparenza per sistemi che generano contenuti sintetici: gli output vanno contrassegnati come artificiale/sintetico e gli utenti devono essere informati quando interagiscono con un sistema di AI (art. 50). Sul campo, però, i marchi invisibili si degradano, vengono rimossi, o non vengono riconosciuti dai viewer. Limiti sostanziali, ammessi anche dall’EPRS (European Parliamentary Research Service).

e) Effetto esca per frodi e “social engineering”

La credibilità del volto animato da un cameo aumenta il tasso di riuscita di richieste di denaro, campagne di phishing, truffe affettive. Laddove il contenuto tocca poi sfera sessuale, scatta la fattispecie penale italiana della diffusione illecita di immagini o video sessualmente espliciti (art. 612-ter c.p.), applicabile anche a materiale sintetico diffuso senza consenso, con aggravanti specifiche e giurisprudenza in evoluzione. Dal 10 ottobre 2025, con la Legge n. 132/2025, l’Italia ha inoltre introdotto il nuovo reato di “deepfake” (art. 612-quater c.p.) che punisce la diffusione di contenuti generati o alterati con l’intelligenza artificiale idonei a trarre in inganno e ledere la reputazione o la dignità della persona ritratta.

I rischi: cinque esempi

L’adozione dei cameo apre nuove aree di vulnerabilità, in cui la combinazione tra realismo e automatizzazione può amplificare rischi di abuso o manipolazione.

Ecco cinque esempi concreti:

Raccolta “silenziosa” per training: l’app consente l’opt-out, ma è pre-flag su on, con un’interfaccia non chiara.

Falso endorsement: il volto di un dipendente o di un creator viene usato in un video promozionale senza liberatoria.

Estorsione “affettiva” con deepfake intimo: cameo usato per simulare video espliciti e minaccia di diffusione.

Phishing con volto aziendale: finto CFO in video che ordina un bonifico urgente (vishing + deepfake).

Cameo di un minore in contesto derisorio condiviso tra compagni di classe.

Le basi giuridiche possibili (e quelle illusorie)

Consenso. È la via maestra per l’uso del volto in cameo, se è libero, specifico, informato e revocabile. Il consenso “granulare” alle singole comparsate è preferibile al consenso una tantum. Per i minori, sono essenziali doppi consensi e meccanismi di age-assurance non invasivi.

Esecuzione del contratto. Non basta a coprire trattamenti eccedenti rispetto alla fruizione puntuale del servizio (es. uso per addestrare il modello), ma serve una base distinta e un opt-in reale.

Legittimo interesse. In caso di volto e soprattutto di dati biometrici, è una coperta corta, che difficilmente regge senza test comparativo robusto e misure tecniche forti (pseudonimizzazione reale, conservazioni brevi, disabilitazione di funzioni di identificazione).

Categorie particolari (biometrico). Se l’uso del volto configura riconoscimento/identificazione, si entra nel perimetro dell’art. 9 GDPR, con divieto generale di trattamento salvo eccezioni e garanzie ulteriori.

Trasparenza e contrassegno: cosa chiede l’AI Act e cosa fa (davvero) il DSA per tutelare il nostro volto (e identità)

Il Regolamento europeo sull’AI richiede che venga resa agli utenti un’informativa adeguata e eseguita la marcatura dei contenuti sintetici da parte dei sistemi che generano o manipolano immagini, audio e video (obblighi di trasparenza; v. art. 50).

Il Digital Services Act impone alle piattaforme online procedure di segnalazione e rimozione, obblighi di mitigazione dei rischi sistemici (per i servizi molto grandi), e cooperazione con le autorità. In breve: chi ospita e diffonde i deepfake non può far finta di nulla e deve mettere in piedi canali efficaci di notice-and-action, strumenti di verifica, reporting e auditing del rischio.

La combinazione di AI Act e DSA crea un binario tecnico-organizzativo, prevedendo etichettatura all’origine e governance sulla distribuzione.

Il diritto all’immagine in Italia: che cosa resta vietato anche senza parlare di “dati”

Accanto al GDPR, il nostro ordinamento tutela il ritratto come proiezione della personalità.

- Art. 10 c.c. consente al giudice di far cessare l’abuso e riconoscere il danno se l’immagine è pubblicata senza basi legali o lede reputazione e decoro.

- Art. 96 Legge sul diritto d’Autore. vieta la pubblicazione/commercializzazione dell’immagine senza consenso; art. 97 L.d.A. prevede eccezioni tassative (interesse pubblico, giustizia, scopi scientifici/didattici, notorietà entro limiti).

L’uso di cameo per sponsorizzazioni, promo, contenuti virali monetizzati senza consenso formale della persona ritratta resta illecito a prescindere dal GDPR; quando la replica digitale è utilizzata per ingannare (es. contattare terzi, ottenere benefici), entra in gioco anche la sostituzione di persona (art. 494 c.p.).

Minori e deepfake: linee guida dei garanti europei e leggi

Il Garante italiano ha pubblicato un vademecum sui deepfake che spiega come difendersi e a chi rivolgersi (Polizia Postale, Garante) in caso di abusi, con richiami a documenti EDPB/EDPS e attenzione specifica ai minori.

Le autorità europee hanno inoltre prodotto, come già ricordato, pareri specifici sul riconoscimento facciale e sull’uso di dati biometrici, ribadendo minimizzazione, necessity test e DPIA come condizioni imprescindibili.

Più di recente l’Italia ha istituito un reato di deepfake con reclusione da due a sette anni per i responsabili.

Che cosa deve fare subito chi sviluppa, adotta o permette cameo in azienda/PA

Chi progetta e gestisce piattaforme come Sora 2 deve assumersi la responsabilità di mettere la trasparenza al centro della progettazione. Prima di tutto, l’utente deve poter decidere consapevolmente se i propri contenuti potranno essere usati per addestrare modelli di intelligenza artificiale. Nessun consenso pre-flaggato, nessuna clausola nascosta nei termini di servizio: serve un opt-in esplicito, separato e facilmente revocabile, accompagnato da informative immediate e comprensibili, mostrate nel momento in cui il dato viene caricato o riutilizzato.

Altro pilastro è la tracciabilità. I contenuti generati dovrebbero essere contrassegnati da watermark robusti e interoperabili, riconoscibili da qualsiasi piattaforma e resistenti ai tentativi di rimozione. A questi si deve affiancare un label visibile nel player (conforme a quanto previsto dall’AI Act) e una documentazione pubblica che spieghi il livello di protezione contro le manipolazioni.

Poi c’è il tema del controllo. Ogni utente dovrebbe poter cancellare tutte le proprie comparse in un solo gesto, attraverso un vero e proprio “kill switch” che elimini le repliche dai server e disattivi ogni possibilità di riuso. Le piattaforme dovrebbero inoltre prevedere controlli d’età robusti ed efficaci, e impostazioni predefinite restrittive per i minori, che impediscano automaticamente l’uso del loro volto in video generati.

Sul piano tecnico, è necessario che le API integrino meccanismi di policy enforcement: in altre parole, il sistema deve essere in grado di bloccare automaticamente l’inserimento di cameo in contesti sensibili (come politica, sessualità o violenza), registrando i blocchi in un log verificabile.

Infine, per i trattamenti più delicati, chi gestisce la piattaforma dovrebbe pubblicare almeno una sintesi della propria DPIA (Data Protection Impact Assessment), come previsto dall’art. 35 del GDPR, quale misura di trasparenza concreta e non solo formale.

Per chi adotta i cameo in contesti aziendali o pubblici

Le aziende e le pubbliche amministrazioni che utilizzano strumenti di generazione video per la comunicazione interna, eventi o employer branding devono aggiornare le proprie regole. Le liberatorie tradizionali non sono più sufficienti, poiché serve una specifica autorizzazione per l’uso sintetico del volto, che distingua tra foto reali e avatar generati, chiarendo limiti, durata e finalità d’uso.

Occorre poi definire policy interne chiare: vietare la creazione di cameo di colleghi o terzi senza base giuridica legittima, istituire canali di segnalazione per chi ritiene di essere stato rappresentato senza consenso e prevedere procedure rapide di rimozione.

I principi di minimizzazione e proporzionalità restano fondamentali: niente cameo di minori o persone vulnerabili e, ove possibile, preferire avatar neutri o generici.

Dal punto di vista della governance digitale, le organizzazioni dovrebbero attrezzarsi con un presidio DSA (Digital Services Act), capace di gestire notifiche verso le piattaforme in caso di contenuti illeciti o lesivi, monitorando l’efficacia delle rimozioni.

Infine, in un contesto in cui il volto può essere falsificato, anche le procedure antifrode vanno aggiornate, prevedendo una doppia validazione voce/video per istruzioni finanziarie o approvazioni sensibili e un playbook interno per reagire a eventuali incidenti da deepfake.

Per chi ospita e modera contenuti generati da utenti: regole da seguire

Le piattaforme che pubblicano o diffondono contenuti creati con sistemi di AI hanno il compito delicato di garantire che l’utente sappia sempre quando guarda un volto artificiale. Ciò significa imporre l’etichettatura obbligatoria di tutti i contenuti generati, implementare sistemi di rilevamento attivo dei watermark e di verifica incrociata delle fonti.

Alla trasparenza deve seguire la reazione: la rimozione di contenuti segnalati come falsi o lesivi deve essere tempestiva e tracciata, e vanno introdotti meccanismi tecnici contro la ricomparsa dello stesso contenuto, ad esempio tramite hashing o “takedown persistente”, in linea con gli obblighi del DSA.

Infine, la protezione dei minori deve rimanere prioritaria. Occorrono canali di emergenza dedicati, un’escalation rapida verso i team di sicurezza e limitazioni algoritmiche che riducano la visibilità e la viralità dei video sintetici che li coinvolgono.

Cosa fare se il nostro volto finisce in un cameo AI non autorizzato

Se il nostro volto o la nostra voce compaiono in un contenuto generato con l’intelligenza artificiale senza consenso, è necessario raccogliere tempestivamente le prove (screenshot, link, con data e ora), per segnalare il materiale alla piattaforma tramite il meccanismo notice and action del Digital Services Act e, se possibile, diffidare direttamente l’autore.

E’ possibile agire in sede civile (art. 10 c.c. e artt. 96–97 L.d.A.) per ottenere la rimozione e il risarcimento e sul piano penale, invocando la sostituzione di persona (art. 494 c.p.), la diffusione illecita di immagini sessualmente esplicite (art. 612-ter c.p.) e, oggi, il nuovo reato di deepfake (art. 612-quater c.p., L. 132/2025).

Se la piattaforma non interviene, è opportuno presentare un reclamo al Garante Privacy, che ha messo a disposizione dei cittadini l’apposito vademecum con istruzioni e moduli utili.

Una chiosa per i designer di Sora 2 (e di chi verrà dopo)

Se un’app rende banale la creazione di repliche convincenti, allora ne deve rendere “banale” anche la tutela (almeno quanto il clic che crea e replica) attraverso opt-in veri, uscita rapida, etichette che viaggiano con il contenuto e non si perdono al primo re-upload, verifiche d’età sobrie e robuste (non invasive), default prudenti, policy chiare su training e uso secondario dei materiali. L’AI Act e il DSA forniscono già cornici operative; il diritto all’immagine e il codice penale tracciano le linee rosse. In poche parole, ciò che serve è ingegnerizzare la prudenza.