Il 2025 è stato proclamato da molti come “l’anno degli agenti AI”. Secondo un’indagine di IBM e Morning Consult condotta su 1.000 sviluppatori che costruiscono applicazioni AI per l’enterprise, il 99% di loro ha dichiarato di essere in fase di esplorazione o sviluppo di agenti AI¹.

Tuttavia, l’entusiasmo generale rischia di essere frenato da una crescente confusione terminologica, che potrebbe compromettere l’evoluzione stessa della tecnologia.

Indice degli argomenti

La confusione terminologica degli agenti AI

Un agente di intelligenza artificiale è fondamentalmente diverso da un semplice strumento basato su Large Language Model (LLM). Si tratta di un sistema autonomo progettato per percepire l’ambiente, elaborare informazioni, prendere decisioni e agire per raggiungere obiettivi specifici.

Maryam Ashoori, Director of Product Management di IBM watsonx.ai ha recentemente dichiarato: “La vera definizione di un agente AI è un’entità intelligente con capacità di ragionamento e pianificazione che può agire autonomamente. Quelle capacità di ragionamento e pianificazione sono oggetto di discussione. Dipende da come le si definisce”¹. Questa ambiguità non è casuale: riflette sia la complessità intrinseca di sistemi in rapida evoluzione, sia la tendenza delle aziende ad utilizzare il termine “agente” per descrivere qualsiasi applicazione che incorpori un modello linguistico di grandi dimensioni.

L’inflazione terminologica nel mercato degli agenti AI

L’industria tecnologica sta vivendo quella che potremmo definire un’“inflazione terminologica”: ogni applicazione che integra un LLM viene promossa come “agente”, indipendentemente dalle sue reali capacità. Come osservano i ricercatori di Anthropic: “Alcuni clienti definiscono agenti sistemi completamente autonomi che operano indipendentemente per periodi estesi, usando vari strumenti per compiere task complessi. Altri usano il termine per descrivere implementazioni più prescrittive che seguono flussi di lavoro predefiniti”⁴.

Questa ambiguità non è neutra: confonde i ruoli, sovrastima le capacità dei sistemi e rende più difficile fare scelte tecnologiche informate. Quando un’azienda chiama “agente” un chatbot che utilizza una pipeline fissa (prompt → LLM → function call → risposta), può sviluppare aspettative non allineate con le capacità reali del sistema.

Secondo previsioni di settore, nel 2025 gli investimenti in AI si sposteranno decisamente dalla sperimentazione all’esecuzione⁵. Un rapporto di Deloitte prevede che il 25% delle aziende che utilizzano AI generativa implementerà agenti AI entro il 2025, crescendo al 50% entro il 2027⁶. In questo contesto, la mancanza di chiarezza terminologica può portare a investimenti mal orientati in tecnologie che non soddisfano le aspettative, delusione degli stakeholder quando i “sistemi agentici” non dimostrano l’autonomia promessa e frammentazione dello sviluppo con team che lavorano su definizioni incompatibili.

I cinque fondamenti per riconoscere veri agenti AI

Distinguere un vero agente AI da un chatbot avanzato o un semplice wrapper LLM richiede di osservare cinque caratteristiche fondamentali.

- L’autonomia decisionale è il primo segnale: un agente prende decisioni senza bisogno di microgestione costante. Come spiega Ece Kamar di Microsoft, le persone vogliono che l’AI “faccia le cose per loro”, non solo che generi risposte². Ad esempio, un agente di customer service dovrebbe essere in grado di riconoscere autonomamente quando è il momento di coinvolgere un operatore umano.

- La capacità di azione concreta va oltre il semplice parlare: un agente può modificare davvero lo stato delle cose attraverso API e sistemi esterni, utilizzando strumenti in sequenze coordinate per raggiungere obiettivi specifici.

- La memoria adattiva non significa solo ricordare le conversazioni passate, ma imparare dalle esperienze e aggiornare continuamente le proprie strategie.

- Il ragionamento multi-step dinamico permette all’agente di scomporre problemi complessi in passaggi gestibili, adattando il piano in tempo reale in base ai risultati ottenuti. È questa flessibilità che lo distingue dai sistemi di automazione rigidi.

- Infine, l’orientamento agli obiettivi: un vero agente è guidato da scopi specifici e misurabili, non si limita a rispondere a richieste singole.

Fonte: https://sendbird.com/blog/how-to-build-an-ai-agent

Fonte: https://sendbird.com/blog/how-to-build-an-ai-agent

Architettura e funzionamento degli agenti AI

Lo schema mostra l’architettura di un agente AI che integra memoria, strumenti e capacità di ragionamento avanzate. Il sistema utilizza memoria a breve e lungo termine per alimentare le sue operazioni cognitive. L’agente accede a strumenti specializzati come Calendar(), Calculator(), CodeInterpreter() e Search() attraverso un processo di pianificazione centrale. Il vero punto di forza è il modulo di pianificazione, che implementa auto-critica, Chain of Thoughts e decomposizione in sotto-obiettivi per analizzare e migliorare continuamente le proprie performance.

Case studies di agenti AI reali

AutoGPT e Harvey AI sono due esempi di agenti AI che agiscono autonomamente per risolvere compiti complessi. Questi agenti mostrano come l’intelligenza artificiale possa essere impiegata per obiettivi concreti e autonomi.

AutoGPT: l’Agente pioniere

AutoGPT è uno degli esempi più rappresentativi di comportamento agentico nel mondo dell’intelligenza artificiale: è in grado di pianificare autonomamente una sequenza di azioni e portarle a termine senza intervento umano diretto. Questo significa che può affrontare compiti complessi, come la ricerca di informazioni online, l’elaborazione di strategie o la gestione di piccoli progetti, decidendo passo dopo passo cosa fare, come farlo e quando farlo. Il sistema decompone autonomamente obiettivi complessi, mantiene stato attraverso multiple iterazioni, e adatta la strategia basandosi sui risultati intermedi.

Caratteristiche distintive:

- Autonomia: genera il proprio piano d’azione senza supervisione continua

- Azione: interagisce con browser, file system, e API esterne

- Memoria: mantiene contesto progettuale attraverso sessioni multiple

- Ragionamento: adatta dinamicamente la strategia basandosi sui feedback

Harvey AI:

Harvey AI è una piattaforma di intelligenza artificiale specializzata nel settore legale, progettata per assistere studi e dipartimenti legali in attività complesse come la redazione di documenti, la due diligence e la ricerca normativa. È considerata un vero e proprio agente AI perché non si limita a generare testo, ma opera in modo autonomo seguendo obiettivi complessi: interpreta richieste dell’utente, pianifica le azioni necessarie, accede a basi di conoscenza legale, produce output contestualizzati e apprende dalle interazioni.

Il suo comportamento agentico si manifesta soprattutto nella capacità di orchestrare flussi di lavoro legali adattandosi al contesto specifico di ciascun cliente e integrandosi con sistemi esistenti.

Caratteristiche distintive:

- Autonomia: genera strategie legali personalizzate e gestisce flussi di lavoro complessi senza supervisione continua

- Azione: interagisce con database legali, sistemi documentali e piattaforme di case management

- Memoria: mantiene cronologia dei casi, precedenti e preferenze cliente attraverso sessioni multiple

- Ragionamento: adatta approcci legali basandosi su feedback clienti ed evoluzione normativa

Esempi di falsi agenti AI

Non tutti i sistemi che si spacciano per “agenti” sono effettivamente autonomi. Molti chatbot e pipeline LLM mancano di autonomia e capacità di azione concreta, quindi non soddisfano i criteri degli agenti AI.

Chatbot RAG “Agente”

Esempio: Un sistema di assistenza clienti che cerca informazioni in una base di conoscenza per rispondere alle domande.

Perché NON è un agente:

- Manca autonomia: ogni interazione richiede input utente esplicito

- Nessuna azione: si limita a generare testo informativo

- Memoria limitata: ricorda solo la conversazione corrente

- Ragionamento lineare: segue pattern fissi retrieval→generazione→risposta

Pipeline LLM con Function Calling

Esempio: Un sistema che processa email utilizzando GPT-4 per classificarle e attivare le azioni appropriate, tramite chiamate API.

Perché NON è un agente:

- Orchestrazione esterna: il flusso è determinato da logica pre-programmata

- Obiettivi transazionali: risponde a singole email senza strategia complessiva

- Memoria non adattiva: non evolve il proprio comportamento basandosi sui risultati

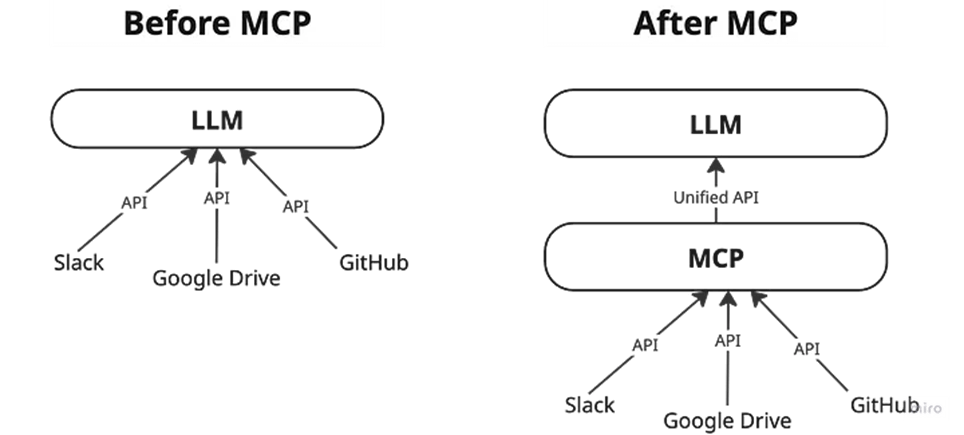

Model Context Protocol: l’infrastruttura della rivoluzione agentica

Fino ad oggi, anche i modelli più sofisticati sono rimasti vincolati dal loro isolamento dai dati—intrappolati dietro silos informativi e sistemi legacy. Ogni nuova fonte dati richiede la propria implementazione personalizzata, rendendo difficile scalare sistemi veramente connessi.

Il Model Context Protocol (MCP), sviluppato da Anthropic e diventato rapidamente uno standard di settore, rappresenta una risposta tecnica concreta a questa frammentazione⁷. Oltre a fungere da connettore universale tra agenti linguistici e software esterno, MCP si è affermato come standard flessibile per la creazione di agenti AI completi, fornendo le fondamenta architetturali necessarie per sviluppare sistemi agentici autonomi e interconnessi. Gli analisti del settore hanno soprannominato MCP “l’USB-C delle app AI”, sottolineando il suo obiettivo di servire come connettore universale tra agenti linguistici e software esterno⁸.

MCP è un protocollo aperto che standardizza come le applicazioni forniscono contesto agli LLM⁹. Proprio come USB-C fornisce un modo standardizzato per connettere i dispositivi a varie periferiche e accessori, MCP fornisce un modo standardizzato per connettere modelli AI a diverse fonti dati e strumenti.

Adozione universale del model context protocol

La potenza di MCP emerge dalla sua rapida adozione cross-industry. Nel marzo 2025, OpenAI ha ufficialmente adottato MCP, con il CEO Sam Altman che ha dichiarato: “Le persone amano MCP e siamo entusiasti di aggiungere supporto tra i nostri prodotti”¹⁰.

Anche Demis Hassabis, CEO di Google DeepMind, ha confermato nell’aprile 2025 il supporto MCP nei modelli Gemini e nell’infrastruttura correlata, descrivendo il protocollo come “che sta rapidamente diventando uno standard aperto per l’era agentistica dell’AI”⁸.

Fonte: https://medium.com/data-science-collective/mcp-is-a-security-nightmare-heres-how-the-agent-security-framework-fixes-it-fd419fdfaf4e

Casi d’uso concreti degli agenti AI

Anthropic mantiene un repository open-source di implementazioni di server MCP di riferimento per sistemi enterprise popolari inclusi Google Drive, Slack, GitHub, Git, Postgres, Puppeteer e Stripe⁷.

Esempio: agente di analisi finanziaria

Un agente equipaggiato con server MCP che può:

- Accedere a database finanziari attraverso un server Postgres MCP

- Recuperare documentazione aziendale da Google Drive

- Eseguire web scraping di siti finanziari tramite Puppeteer

- Consolidare informazioni in rapporti analitici strutturati

Questo rappresenta vera agenticità: il sistema persegue autonomamente l’obiettivo di analisi finanziaria, adatta la propria strategia in base ai dati trovati, e mantiene contesto attraverso multiple operazioni.

Criticità e futuri sviluppi degli Agenti AI

Gli agenti AI devono affrontare diverse sfide, tra cui l’affidabilità, i costi computazionali e la gestione della memoria adattiva. Allo stesso tempo, le architetture multi-agente promettono nuove opportunità.

Affidabilità: l’aspetto critico

Gli agenti AI affrontano sfide di affidabilità molto più complesse dei sistemi LLM statici. Il problema principale è che esistono numerose modalità di fallimento che tendono a propagarsi e amplificarsi lungo tutta la catena di decisioni. Inoltre, anche i meccanismi di correzione vengono gestiti da LLM, creando ulteriori punti critici.

Tra le principali sfide troviamo gli errori composti, dove ogni decisione autonoma può trascinare problemi attraverso l’intera sequenza di azioni. C’è poi il fenomeno delle allucinazioni agentiche, in cui il modello genera informazioni fattuali incorrette o completamente inventate¹². Infine, la memoria adattiva che caratterizza questi sistemi può causare quello che viene chiamato drift comportamentale: l’agente sviluppa nel tempo comportamenti imprevisti e potenzialmente problematici.

Costi computazionali

Gli agenti potrebbero richiedere più passaggi di ragionamento utilizzando modelli più potenti. Tutto questo aumenta i costi. Con costi più alti arrivano maggiori richieste per la proposta di valore. In particolare, un agente che esegue planning multi-step può facilmente consumare 10-20 volte più token di un LLM tradizionale per task equivalente, rendendo cruciale l’ottimizzazione dell’efficienza.

Architetture multi-agente

Nel 2025, gli agenti di intelligenza artificiale stanno evolvendo da semplici assistenti reattivi — che eseguono comandi su richiesta — a problem-solver proattivi, capaci di agire in autonomia. Questo significa che non si limitano più ad attendere istruzioni dall’utente, ma sono in grado di anticipare bisogni, proporre soluzioni pertinenti, prendere decisioni autonome e portare avanti compiti complessi end-to-end. Al centro di questa trasformazione c’è il passaggio da modelli singoli a architetture multi-agente, ovvero ecosistemi composti da più agenti AI specializzati che collaborano tra loro.

Ogni agente è progettato per eccellere in uno specifico dominio o tipo di attività — come l’analisi dati, la generazione di contenuti, o la pianificazione strategica — ma è nella coordinazione emergente che risiede il vero potenziale: gli agenti possono organizzarsi autonomamente, assegnarsi ruoli, suddividere il lavoro e adattarsi dinamicamente all’evoluzione del problema. A rendere tutto questo possibile contribuisce anche una memoria condivisa, una base di conoscenza comune alla quale ogni agente può accedere per apprendere più rapidamente, sincronizzare il proprio stato con gli altri e migliorare le prestazioni collettive.

Conclusioni

Comprendere la differenza tra LLM-tools e veri agenti AI non è un esercizio accademico, ma una necessità strategica per le organizzazioni che vogliono sfruttare appieno le potenzialità dell’intelligenza artificiale.

La distinzione ha implicazioni concrete:

- Budget allocation: gli agenti veri richiedono investimenti diversi in infrastruttura e competenze.

- Risk management: le implicazioni di sicurezza e compliance sono radicalmente diverse.

- Aspettative di performance: gli agenti possono automatizzare interi flussi di lavoro, ma quando sbagliano causano danni più estesi e difficili da individuare.

Raccomandazioni operative

Per i decision maker:

- Applicare i 5 criteri di agenticità prima di qualunque investimento significativo.

- Richiedere demo live che dimostrino autonomia, non solo automation.

- Investire in formazione per distinguere dichiarazioni promozionali da capacità reali.

Per i team tecnici:

- Iniziare con MCP per costruire fondamenta solide di integrazione.

- Progettare fin dall’inizio tenendo conto dell’osservabilità degli agenti.

- Implementare safeguards robusti prima di concedere autonomia significativa.

I veri agenti AI non rappresentano semplicemente un’evoluzione incrementale degli LLM, ma l’emergere di una nuova categoria di strumenti digitali capaci di partnership cognitiva con gli esseri umani. Tuttavia, questa partnership richiede fondamenta solide: comprensione chiara delle capacità, implementazione responsabile e aspettative realistiche.

Bibliografia

¹ IBM: “AI Agents in 2025: Expectations vs. Reality” – https://www.ibm.com/think/insights/ai-agents-2025-expectations-vs-reality

² Microsoft: “AI agents — what they are, and how they’ll change the way we work” – https://news.microsoft.com/source/features/ai/ai-agents-what-they-are-and-how-theyll-change-the-way-we-work/

³ Jack Vanlightly: “AI Agents in 2025” – https://jack-vanlightly.com/blog/2025/1/16/ai-agents-in-2025

⁴ Anthropic: “Building Effective Agents” – https://www.anthropic.com/engineering/building-effective-agents

⁵ MarTech: “AI agents: 2025 predictions” – https://martech.org/ai-agents-2025-predictions/

⁶ Analytics Vidhya: “Top 10 AI Agent Trends and Predictions for 2025” – https://www.analyticsvidhya.com/blog/2024/12/ai-agent-trends/

⁷ Anthropic: “Introducing the Model Context Protocol” – https://www.anthropic.com/news/model-context-protocol

⁸ Wikipedia: “Model Context Protocol” – https://en.wikipedia.org/wiki/Model_Context_Protocol

⁹ Anthropic Documentation: “Model Context Protocol (MCP)” – https://docs.anthropic.com/en/docs/agents-and-tools/mcp

¹⁰ TechCrunch: “OpenAI adopts rival Anthropic’s standard for connecting AI models to data” – https://techcrunch.com/2025/03/26/openai-adopts-rival-anthropics-standard-for-connecting-ai-models-to-data/

¹¹ Sequoia Capital: “AI 50: AI Agents Move Beyond Chat” – https://www.sequoiacap.com/article/ai-50-2025/

¹² Evidently AI: “LLM hallucinations and failures: lessons from 4 examples” – https://www.evidentlyai.com/blog/llm-hallucination-examples

¹³ Analytics Vidhya: “Top 10 AI Agent Trends and Predictions for 2025” – https://www.analyticsvidhya.com/blog/2024/12/ai-agent-trends/

¹⁴ TopBots: “The AI Agent Race Heats Up: Who’s Leading in 2025?” – https://www.topbots.com/top-ai-agent-companies-2025/