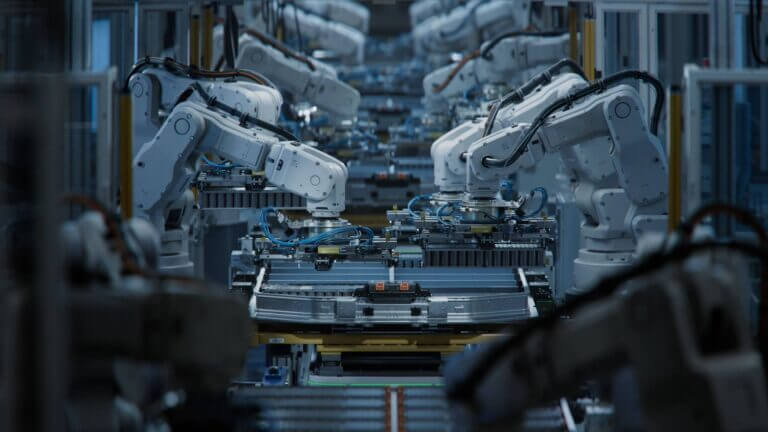

La rapida adozione dell’intelligenza artificiale nelle aziende promette un’efficienza e un’innovazione senza precedenti. Dall’automazione del servizio clienti alla semplificazione dei processi di assunzione, l’AI sta rapidamente diventando l’interfaccia tra le organizzazioni e il mondo esterno.

Tuttavia, man mano che i sistemi di AI si integrano profondamente nelle operazioni critiche, sorge una domanda fondamentale: siamo adeguatamente preparati per i rischi intrinseci, in particolare per quanto riguarda la governance e la sicurezza dei dati?

Indice degli argomenti

Governance dei dati AI: il caso che svela le vulnerabilità più ignorate

Le sfide nella governance dei dati AI sono significative e spesso trascurate. Il recente incidente che ha coinvolto un chatbot AI utilizzato da una grande catena di fast-food per selezionare potenziali assunzioni serve da crudo promemoria di queste vulnerabilità.

Questa AI, progettata per vagliare i candidati e raccogliere informazioni personali, ha inavvertitamente esposto fino a 64 milioni di record a causa di semplici difetti di sicurezza. I ricercatori sono riusciti ad accedere a questi dati tramite vulnerabilità basilari, come indovinare un nome utente amministratore con una password “123456”.

Sebbene il pubblico possa aver “scrollato le spalle e tirato avanti”, questo incidente è una lezione magistrale su ciò che è fondamentalmente sbagliato nel modo in cui le aziende adottano l’AI e gestiscono il rischio di terze parti.

Quando l’AI automatizza processi umani senza barriere protettive

Immaginate lo scenario: un giovane si candida per un lavoro, viene selezionato da un’AI che potrebbe fraintenderlo o giudicarlo male e poi, a causa di una sicurezza debole, espone i suoi dati personali su Internet.

Questa non è satira distopica: è un problema reale e ricorrente. Ci stiamo affrettando ad automatizzare alcuni dei processi più umani nelle nostre organizzazioni – dall’assunzione al triage sanitario, fino al servizio clienti – senza stabilire adeguate barriere protettive, trasparenza o persino una supervisione di base.

La conseguenza è un divario crescente tra fiducia digitale e velocità operativa, con i nostri dati sensibili che spesso pagano il prezzo dopo una violazione.

Governance dei dati AI contro la “fiducia-per-default” nei sistemi e nei vendor

L’incidente sopra menzionato evidenzia un problema critico: la maggior parte delle organizzazioni non ha una solida struttura di fiducia. L’AI sta rapidamente diventando l’interfaccia tra le aziende e il mondo esterno, eppure i sistemi che la alimentano sono raramente sicuri per progettazione.

Inoltre, i fornitori di AI spesso non sono tenuti a standard di sicurezza di livello aziendale. Questo può essere descritto come fiducia-per-default.

Una piattaforma AI a cui erano stati affidati decine di milioni di record contenenti informazioni di identificazione personale (PII) aveva meccanismi di autenticazione così banali da fallire un audit di igiene informatica del primo anno.

Questo non è semplicemente un problema del fornitore: è un problema di governance strategica. Spesso ci fidiamo dell’AI perché è conveniente, e ci fidiamo dei partner perché superano una checklist di sicurezza (a volte solo annualmente, o peggio, una sola volta).

In definitiva, ci fidiamo di piattaforme che non comprendiamo appieno perché si trovano dietro un’interfaccia utente accattivante. Questa non è vera fiducia: è negligenza.

Tre vettori di rischio che convergono nelle iniziative AI

Man mano che l’AI si integra profondamente nelle interazioni con clienti, dipendenti e partner, stiamo assistendo alla convergenza di tre vettori di rischio critici.

Dove si nascondono i percorsi di attacco

• Catene di fornitura di software di terze parti: i percorsi di violazione sono spesso invisibili all’azienda.

• Automazione basata sull’AI: la supervisione umana è minima e spesso opaca.

• Esposizione dell’identità digitale: un account compromesso (umano o macchina) è spesso tutto ciò che serve per ottenere l’accesso a tutto.

Il panorama delle minacce ora si estende oltre il ransomware. Dobbiamo affrontare modelli AI non verificati che prendono decisioni critiche e sistemi di identità che presumono buone intenzioni.

Se un malintenzionato scopre una password amministratore debole o un punto cieco nella vostra pila di fornitori, i vostri processi più umani possono improvvisamente diventare le vostre maggiori passività.

Governance dei dati AI e resilienza: progettare per il fallimento, non per la perfezione

Il modello di sicurezza del futuro deve iniziare con l’assunto che la fiducia sarà inevitabilmente infranta da vari attori: un partner, un modello AI o un sistema mal configurato. Ciò che conta veramente è ciò che succede dopo.

• Riuscite a contenere il raggio d’esplosione di una violazione?

• Riuscite a individuare con precisione quali dati sono stati acceduti e da chi?

• Riuscite a recuperare la fiducia degli utenti e del sistema con certezza, senza ricorrere a congetture?

Questa è l’essenza della resilienza della struttura di fiducia. Potrebbe non essere affascinante, ma è la differenza cruciale tra mantenere il vostro vantaggio strategico e finire sui titoli dei giornali.

L’anello mancante nella governance dei dati AI: pipeline, non solo modelli

Mentre si parla molto della sicurezza, dei bias e della spiegabilità dei modelli AI, si parla molto meno delle pipeline di dati che alimentano questi modelli in primo luogo. Questo è il vero punto cieco.

Oggi, la maggior parte delle aziende non è in grado di rispondere a domande basilari ma critiche sui propri flussi di lavoro AI:

• Da dove provengono questi dati di training?

• Quali informazioni sensibili vengono acquisite e da quale modello?

• Possiamo dimostrare in modo definitivo che questa AI non ha elaborato dati regolamentati, proprietari o tossici?

Senza una visibilità, classificazione e controllo completi sui vostri dati – dal training all’inferenza – non state realmente governando l’AI. State semplicemente sperando che si comporti bene.

Governance dei dati AI come tema da board: compliance, reputazione, sopravvivenza

Ecco perché la governance dei dati AI deve diventare una questione a livello di consiglio di amministrazione, un fattore critico per la conformità e, in ultima analisi, per la sopravvivenza.

Un singolo modello addestrato su dati gestiti in modo improprio può causare danni reputazionali, normativi e finanziari paragonabili ai peggiori eventi di ransomware.

Le aziende che prospereranno nell’era dell’AI sono quelle che trattano la sicurezza dei dati come il pilastro fondamentale della fiducia nell’AI. Stanno mappando la lineage dei dati attraverso i carichi di lavoro, applicando politiche di accesso sui contenuti sensibili e assicurandosi di poter recuperare e mettere in quarantena l’output generato dall’AI che presenta rischi a valle.

Dobbiamo smettere di pensare all’AI come “solo un’altra applicazione” e iniziare a trattarla come un consumatore e produttore dinamico di dati sensibili. Ciò significa architettare barriere protettive specifiche per l’AI, tracce di audit immutabili e capacità di recupero costruite per ambienti nativi AI.

Per le organizzazioni che lo comprendono ora, questo rappresenta un significativo vantaggio competitivo, non una semplice corsa alla conformità.

Quattro domande operative per rafforzare la governance dei dati AI

L’incidente con il chatbot AI della catena di fast-food non sarà l’ultimo del suo genere. Anzi, è probabile che sia uno dei tanti di cui non abbiamo ancora sentito parlare.

Tuttavia, serve come un cruciale campanello d’allarme: non per rallentare l’adozione dell’AI, ma per accelerare il nostro pensiero sulla resilienza. L’automazione è inevitabile. Le violazioni sono prevedibili.

Ma ciò che definisce la leadership ora è se stiamo costruendo sistemi progettati per “fallire bene”, sistemi che siano recuperabili, tracciabili e, soprattutto, affidabili.

Per anticipare questa inevitabilità, ecco quattro domande che ogni consiglio di amministrazione e team di CxO dovrebbe porsi:

- Quali piattaforme AI (interne o esterne) hanno accesso a PII, proprietà intellettuale (IP) o autorità decisionale?

- Sappiamo come queste piattaforme sono autenticate, monitorate e governate?

- Qual è la nostra visibilità sui percorsi di accesso di terze e quarte parti lungo la catena di fornitura digitale?

- Se uno dei nostri sistemi partner viene violato, possiamo recuperare l’integrità dei dati e ripristinare la fiducia con certezza?

Prendetevi il tempo per rispondere a queste domande. In definitiva, quando la fiducia si rompe, non è l’AI a essere incolpata. Siete voi.