L’Intelligenza Artificiale Spiegabile (Explainable AI, XAI) sta progressivamente emergendo quale fattore abilitante per l’adozione efficace di soluzioni di manutenzione predittiva (PdM) nei settori critici, tra cui il trasporto pubblico. In ambito ferroviario e metropolitano, i guasti imprevisti a componenti vitali possono determinare l’immediata indisponibilità del veicolo e, conseguentemente, significativi disservizi per l’utenza.

Un caso emblematico è rappresentato dall’Air Production Unit (APU) installata sul tetto dei convogli della metropolitana di Porto: tale unità alimenta diversi sottosistemi, tra cui le sospensioni secondarie, deputate a mantenere l’assetto orizzontale del veicolo indipendentemente dal numero di passeggeri a bordo. L’APU è soggetta a sollecitazioni continue lungo l’intero arco della giornata e, in assenza di ridondanza funzionale, il suo guasto comporta l’immediato ritiro del treno dal servizio per le necessarie riparazioni. Tali malfunzionamenti, spesso non rilevabili attraverso i criteri manutentivi tradizionali basati su soglie predefinite, possono determinare un impatto sistemico sulla regolarità del servizio: basti considerare che nel solo anno 2017 oltre 170 corse della metropolitana di Porto furono cancellate a seguito di guasti riconducibili a questa tipologia. (Veloso, Gama, et al. 2022).

Per le aziende di trasporto pubblico – frequentemente riconducibili alla sfera della Pubblica Amministrazione (PA) – la transizione da un paradigma di manutenzione reattiva a uno predittivo basato su dati (cd. data-driven) costituisce una condizione strategica per l’ottimizzazione dell’affidabilità e la riduzione dei fermi non pianificati. Tuttavia, l’impiego di modelli di machine learning (ML) per l’automazione delle decisioni manutentive si scontra con una diffusa diffidenza, riconducibile alla natura opaca di molti algoritmi, spesso percepiti come “scatole nere”. In ambito pubblico, tale opacità risulta particolarmente problematica, in quanto i gestori degli asset e i decisori istituzionali richiedono motivazioni trasparenti per legittimare le scelte operative e garantire accountability. In questo contesto, le tecniche di XAI risultano fondamentali per calibrare la fiducia degli utenti nei modelli di intelligenza artificiale (AI), fornendo insight sul processo decisionale dei sistemi di ML (Kucher, Zohrevandi, e Westin 2025). Come evidenziato da (Cummins et al. 2024) in una recente rassegna, l’aggiunta di spiegabilità nei sistemi di PdM permette agli operatori umani di fidarsi delle previsioni mantenendo al contempo alte prestazioni dei modelli. XAI offre gli strumenti per unire accuratezza e trasparenza, condizione essenziale affinché la PA adotti soluzioni di AI in ambiti critici e di pubblica utilità.

Il caso di studio alla base dell’analisi presentata in questo lavoro si fonda sull’utilizzo del dataset MetroPT-3, reso disponibile sull’UCI Machine Learning Repository da (Davari et al. 2021). Esso è stato raccolto per supportare lo sviluppo di modelli di PdM, rilevamento di anomalie e stima della vita utile residua (cd. Remaining Useful Life, RUL) applicati ai compressori di bordo mediante tecniche di ML e deep learning. Il dataset consiste in una serie temporale multivariata composta da 15.169.480 istanze, campionate a 1 Hz durante il periodo compreso tra febbraio e agosto 2020, acquisite tramite sensori analogici e digitali installati sull’unità di compressione dell’aria di un treno metropolitano. In particolare, il dataset comprende 15 variabili, suddivise in 7 segnali analogici e 8 digitali.

Sebbene il dataset non sia etichettato, sono disponibili quattro intervalli temporali noti nei quali si sono verificati guasti – in particolare, perdite d’aria –, documentati tramite report di manutenzione forniti dall’operatore. Queste informazioni consentono di utilizzare il dataset come benchmark per valutare le prestazioni di algoritmi di failure prediction, rilevamento di anomalie e stima della RUL in scenari industriali reali. La registrazione dei dati è stata effettuata da un dispositivo embedded installato a bordo, capace di monitorare il comportamento temporale del sistema e registrare eventi critici in tempo reale.

Nel contesto del presente lavoro, il dataset MetroPT-3 sarà utilizzato per sviluppare e confrontare modelli predittivi sia interpretabili che black-box, applicare tecniche XAI, tra cui SHAP e LIME, al fine di evidenziare i benefici decisionali apportati dalla XAI per la PA.

Indice degli argomenti

L’Explainable AI nella manutenzione predittiva

Negli ultimi anni, la manutenzione predittiva ha visto un fiorire di approcci basati su ML e deep learning, con numerosi studi che propongono modelli per prevedere guasti e anomalie in svariati settori industriali. In particolare, nel dominio ferroviario, diverse tecniche di analisi dati sono state sperimentate per monitorare componenti come ruote, freni, unità pneumatiche e altri sottosistemi critici (Narjes Davari, Veloso, Costa, et al. 2021). La letteratura mostra che modelli di apprendimento automatico avanzati possono ottenere elevate prestazioni nel predire fault imminenti a partire da segnali acquisiti dai sensori.

Tuttavia, l’adozione industriale su larga scala di tali soluzioni rimane ostacolata da alcune sfide aperte. Una delle principali è la complessità e l’opacità dei modelli: spesso quelli più accurati sono anche i meno interpretabili, il che rende difficile per gli operatori fidarsi delle loro diagnosi senza comprenderne le motivazioni. Per questo motivo sta emergendo il filone di ricerca dell’explainable predictive maintenance (XPM), che mira ad applicare metodi XAI specificamente al contesto PdM. Una recente survey di (Cummins et al. 2024) fornisce una panoramica completa di tali metodi, categorizzando le tecniche XAI adottate in ambito PdM e discutendo sfide attuali e direzioni future. Dalla letteratura scientifica emerge con chiarezza che l’integrazione di meccanismi di spiegabilità all’interno dei sistemi di PdM rappresenta un prerequisito essenziale per rafforzare la fiducia e promuovere l’accettazione delle soluzioni basate su AI da parte degli operatori umani, specialmente nei contesti ad elevata rilevanza per la sicurezza. In tali applicazioni, la possibilità di comprendere, verificare e validare le raccomandazioni generate dai modelli predittivi risulta imprescindibile per garantire un processo decisionale responsabile e conforme ai requisiti normativi e operativi.

Tra le tecniche XAI più affermate in PdM vi sono quelle model-agnostic, capaci di spiegare il funzionamento di qualsiasi modello black-box tramite analisi post-hoc. In particolare, i metodi basati su Shapley values hanno guadagnato ampia popolarità. Le Shapley Additive Explanations (SHAP) di (Lundberg e Lee 2017) si fondano su tre proprietà fondamentali, ereditate dall’impostazione teorica classica dei valori di Shapley: local accuracy, missingness e consistency. La local accuracy si riferisce alla capacità dell’input semplificato di eguagliare almeno l’output dell’input reale proveniente dai dati. La proprietà di missingness concerne le feature mancanti dall’input semplificato, stabilendo in sintesi che, se una caratteristica non è utile per la spiegazione, allora non è utile nemmeno per il modello. Infine, la consistency implica che l’importanza di una feature debba rimanere costante o aumentare, indipendentemente dalla presenza delle altre caratteristiche.

Pertanto, SHAP unifica diversi algoritmi di feature importance e fornisce un modo quantitativo per attribuire a ciascuna feature un contributo alla predizione del modello. Secondo la rilevazione di (Cummins et al. 2024) SHAP risulta di gran lunga il metodo XAI più utilizzato negli studi su XPM. Ciò si deve alla sua versatilità – applicabile a modelli di diversa natura – e alla solidità teorica nell’assegnare importanza locale e globale alle variabili. SHAP è stato impiegato con successo per spiegare modelli di anomaly detection, fault diagnosis e prognosis. In applicazioni di fault diagnosis, l’analisi SHAP ha permesso di identificare le feature più determinanti per l’output di un classificatore – come XGBoost – evidenziando le cause potenziali di un fault. Accanto a SHAP, un altro strumento molto diffuso è LIME (Local Interpretable Model-Agnostic Explanations), introdotto da (Ribeiro, Singh, e Guestrin 2016) per fornire spiegazioni locali approssimando il modello black-box linearmente in prossimità di una predizione specifica. LIME è stato applicato nella PdM per produrre pesi locali che indicano in che misura ciascuna feature ha influenzato una particolare previsione di guasto, aiutando gli esperti a comprendere caso per caso il comportamento del modello. Oltre a SHAP e LIME, la letteratura XPM comprende svariati metodi quali Rule-Based Explainers o Surrogate Models – che approssimano globalmente il modello complesso con uno interpretabile, Counterfactuals – che indicano come variare le condizioni per evitare un guasto – nonché tecniche di Visualization, volte a fornire un’immagine che illustra il funzionamento interno dell’architettura del modello esaminato. Per una disamina completa delle tecniche di XPM si rimanda all’articolo di (Cummins et al. 2024).

Metodologia per investigare l’importanza delle XAI applicata alla PdM

Per investigare l’importanza delle XAI applicata alla PdM, è stato sviluppato un framework metodologico articolato in cinque fasi distinte.

In una prima fase, il dataset MetroPT‑3 è stato sottoposto a operazioni di pre-processing e analisi esplorativa, con l’obiettivo di garantire la qualità, la coerenza e la rappresentatività dei dati.

La seconda fase ha previsto la costruzione di due differenti modelli predittivi per i compiti di anomaly detection: un modello interpretabile basato su alberi decisionali e un modello più complesso, non interpretabile nativamente, basato su Sparse Autoencoder. Entrambi sono stati progettati per individuare anomalie significative associate a guasti imminenti dell’APU.

Nella terza fase sono state applicate tecniche di XAI, per interpretare il modello black box e attribuire un peso esplicativo alle diverse variabili. Le spiegazioni locali ottenute sono state confrontate tra i due approcci e, parzialmente, validate empiricamente attraverso un’analisi delle distribuzioni di densità delle feature, comparando i comportamenti nei casi di funzionamento normale e in prossimità di failure.

La quarta fase ha previsto una discussione critica dei risultati ottenuti, evidenziando punti di forza, limiti e ambiguità interpretative riscontrate, con particolare riferimento all’efficacia esplicativa dei metodi XAI adottati e alla coerenza temporale delle predizioni.

Infine, la quinta fase ha formulato un insieme di proposte prospettiche, delineando traiettorie future di ricerca orientate:

(i) all’integrazione di tecniche XAI con strumenti di Visual Analytics,

(ii) allo sviluppo di dashboard interattive,

(iii) alla sperimentazione di estensioni time-aware dell’architettura SAE, e

(iv) al rafforzamento dei meccanismi di AI governance, in linea con le più recenti raccomandazioni scientifiche volte a promuovere ecosistemi decisionali affidabili, trasparenti e auditabili.

Le analisi sono state condotte utilizzando Python all’interno di un ambiente Google Colab.

Preprocessing e analisi esplorativa dei dati

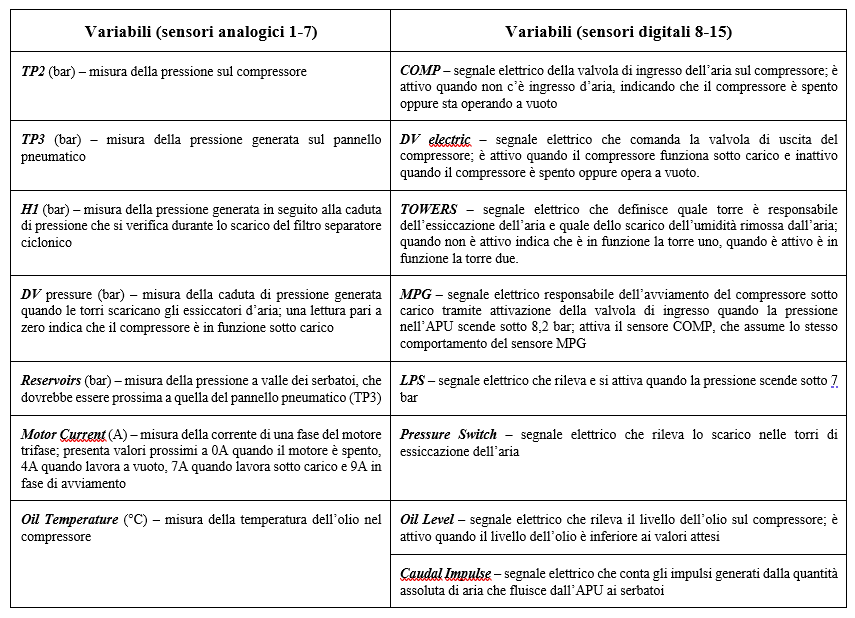

Il dataset MetroPT-3 è stato acquisito in formato CSV dal repository UC Irvine Machine Learning (Davari et al. 2021). In fase di preprocessamento, i dati temporali sono stati indicizzati e segmentati in finestre significative per l’analisi da parte degli autori. Poiché i sensori operano a frequenza di 1 Hz, l’intervallo tra febbraio e agosto 2020 produce una serie storica piuttosto estesa, composta da 15.169.480 istanze raccolte. Non essendo presenti valori mancanti né outlier evidenti, non si è reso necessario un data cleaning intensivo. Il dataset è composto da 15 variabili, derivanti da 7 sensori analogici (1-7) e 8 sensori digitali (8-15):

Figura 1 – Variabili presenti nel Dataset.

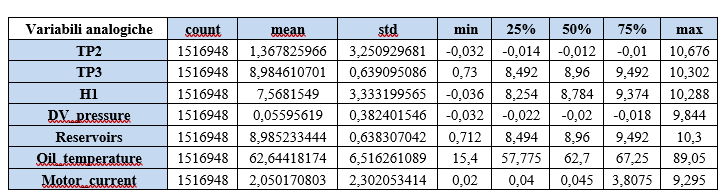

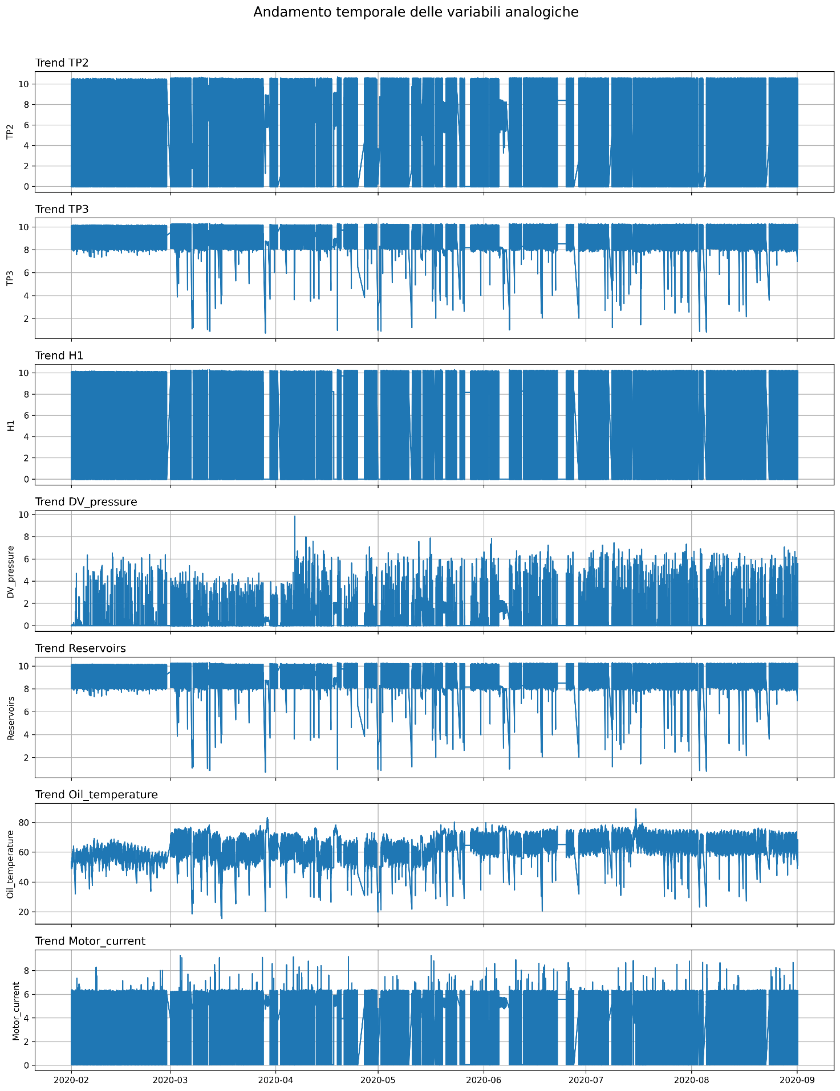

In primo luogo, è stata analizzata la struttura dei dati e verificata la presenza di valori mancanti. Successivamente, sono state elaborate alcune statistiche descrittive di base delle variabili analogiche e digitali estratte dal dataset MetroPT-3, riportate in Figura 2. Tali sintesi rappresentano un primo step fondamentale nell’analisi esplorativa dei dati, poiché consentono di identificare le principali caratteristiche distributive delle grandezze monitorate e di verificare la qualità del dataset.

Figura 2- Statistiche descrittive di base delle variabili.

Gli indicatori riportati in Figura 1 consentono di delineare il range operativo tipico dei sensori, di valutare la presenza di dispersioni significative o comportamenti stazionari, e di evidenziare eventuali scostamenti dai valori attesi che potranno essere approfonditi in fase successiva tramite specifiche analisi di individuazione degli outlier.

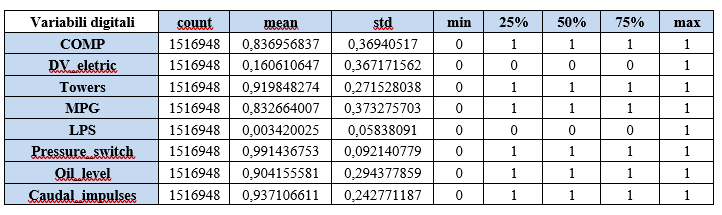

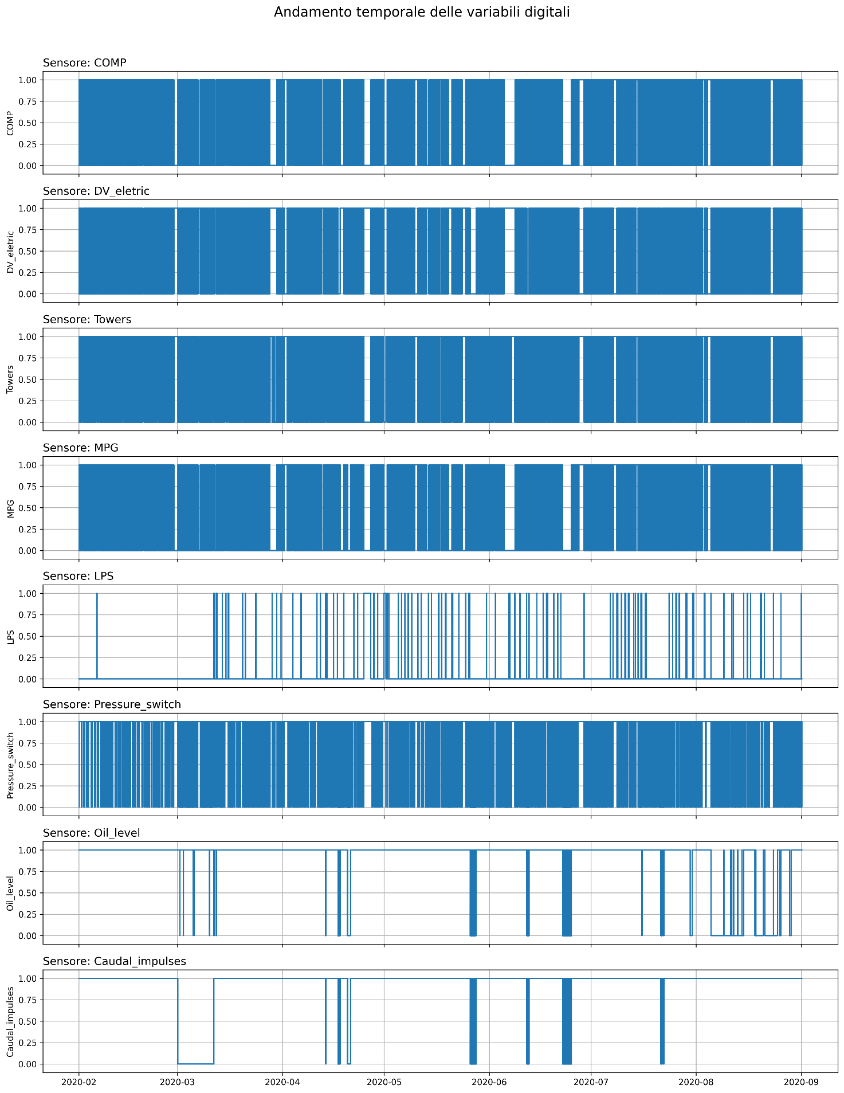

L’analisi temporale delle variabili analogiche e digitali, riportata nella Figura 3, rappresenta una successiva fase preliminare essenziale per la comprensione del comportamento operativo dell’APU. La rappresentazione grafica dell’evoluzione di queste variabili sull’intero intervallo di osservazione consente di identificare pattern ricorrenti, fasi di regime stazionario, transizioni operative e potenziali discontinuità correlate a eventi di manutenzione o anomalie. Inoltre, la visualizzazione congiunta delle serie temporali fornisce una prima base per l’individuazione di correlazioni tra i diversi sensori, facilitando l’identificazione di condizioni di esercizio critiche o atipiche. Tali elementi, anche in questo caso, risultano propedeutici sia per la validazione dei dati e l’individuazione di outlier, sia per la successiva fase di modellizzazione predittiva e di interpretabilità mediante tecniche di XAI.

Figura 3- Andamento temporale delle variabili.

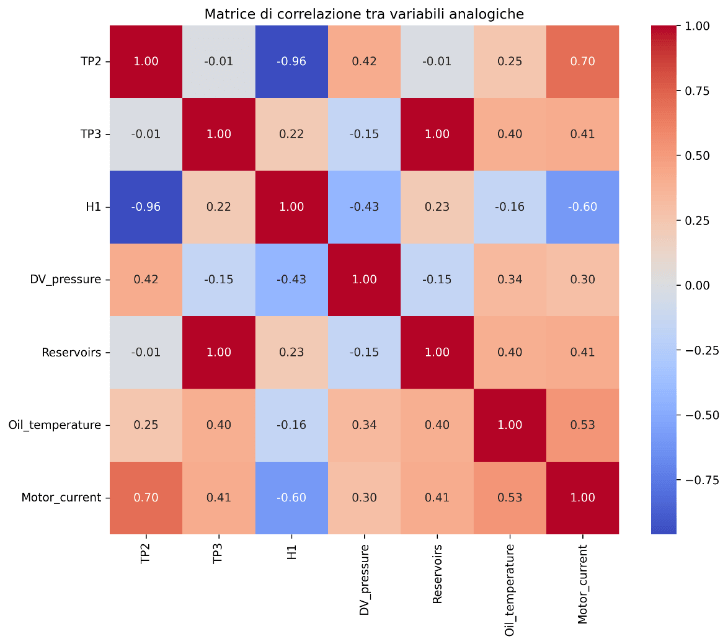

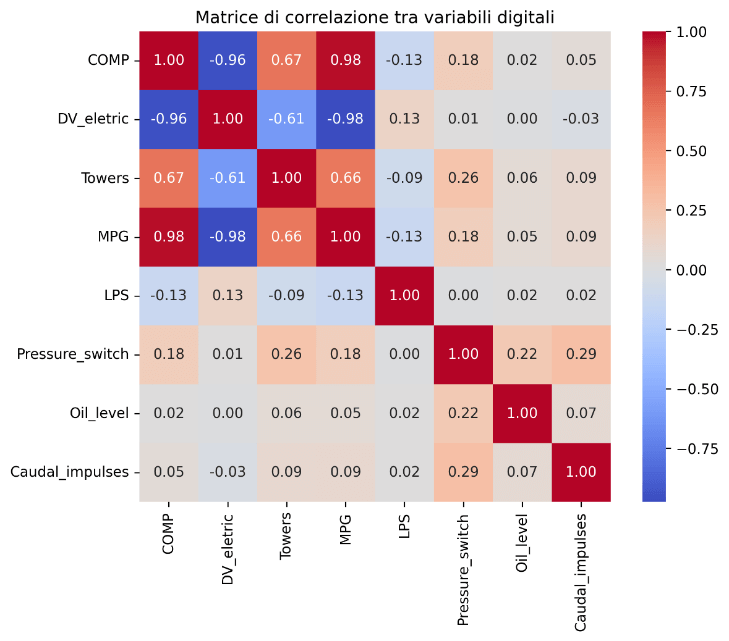

A completamento dell’analisi esplorativa, si è proceduto con la valutazione quantitativa delle relazioni tra le variabili analogiche e digitali mediante la costruzione delle matrici di correlazione, riportate nelle Figura 4. La rappresentazione in forma di heatmap consente di visualizzare sinteticamente la forza e il segno delle correlazioni grandezze monitorate, facilitando l’identificazione di pattern di dipendenza e potenziali ridondanze informative. In particolare, la heatmap generata in Python tramite la libreria Seaborn si basa sulla matrice di correlazione calcolata con coefficiente di Pearson.

Figura 4- Matrici di correlazione tra le variabili.

L’analisi della matrice di correlazione evidenzia la presenza di elevatissimi livelli di correlazione lineare tra alcune variabili analogiche e digitali, aspetto che riflette sia la coerenza del sistema fisico monitorato sia eventuali relazioni funzionali o ridondanze informative tra i sensori, nonché la presenza di cicli di carico e scarico. Tali evidenze, di fatto già previste nella documentazione tecnica del sistema, suggeriscono la necessità di valutare la ridondanza informativa e la possibile semplificazione del set di variabili in fase di modellizzazione predittiva.

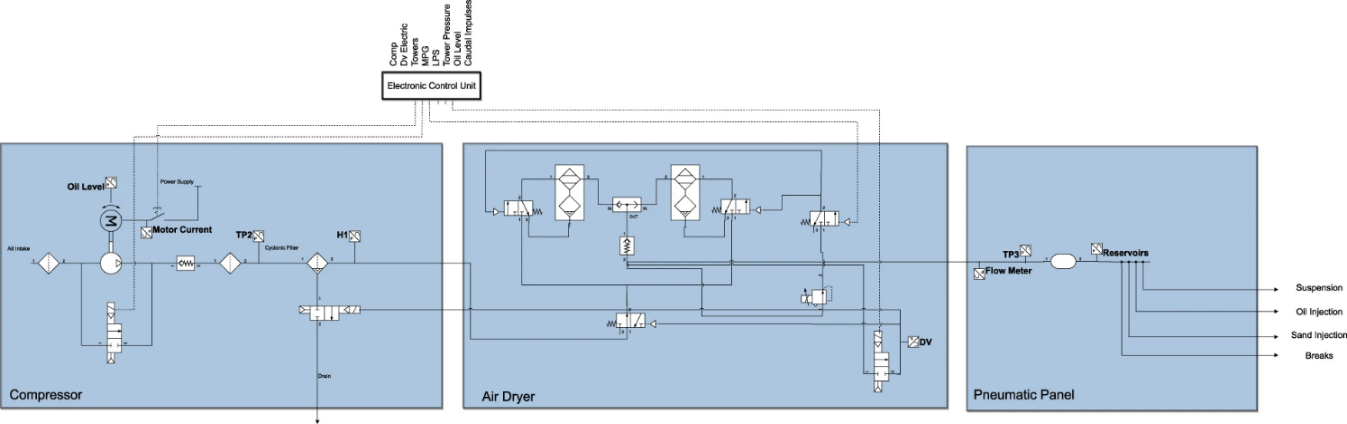

La Figura 5 mostra i componenti dell’APU. Per una disamina completa del suo funzionamento, si rimanda agli articoli di (Barros et al. 2020), (Narjes Davari, Veloso, Ribeiro, et al. 2021) e (Veloso, Ribeiro, et al. 2022).

Figura 5 – Componenti dell’APU (Veloso, Ribeiro, et al. 2022).

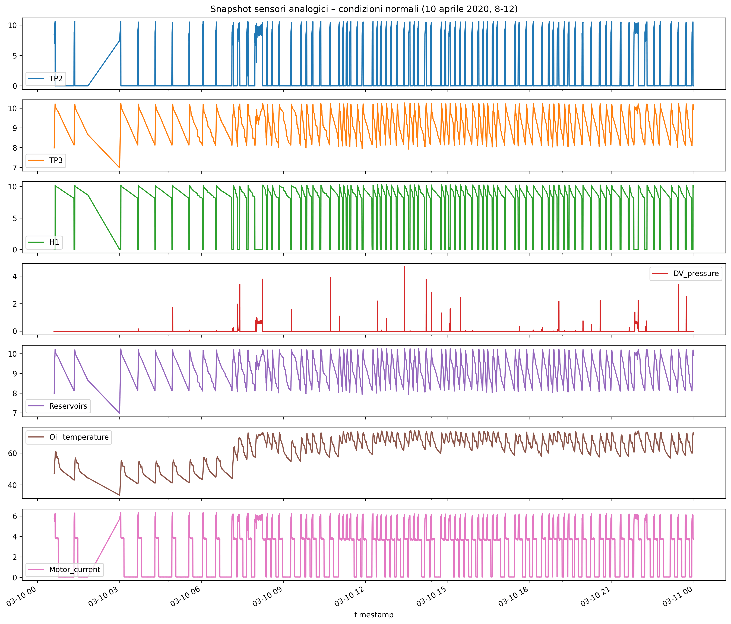

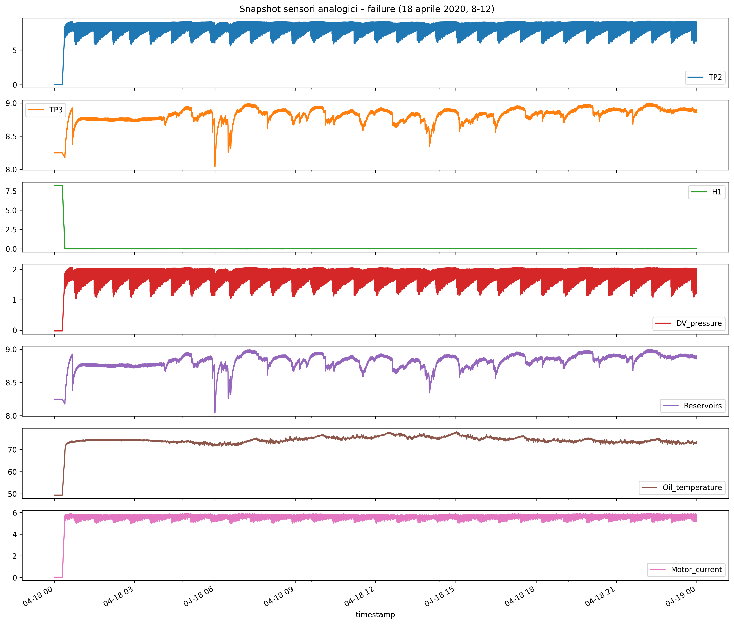

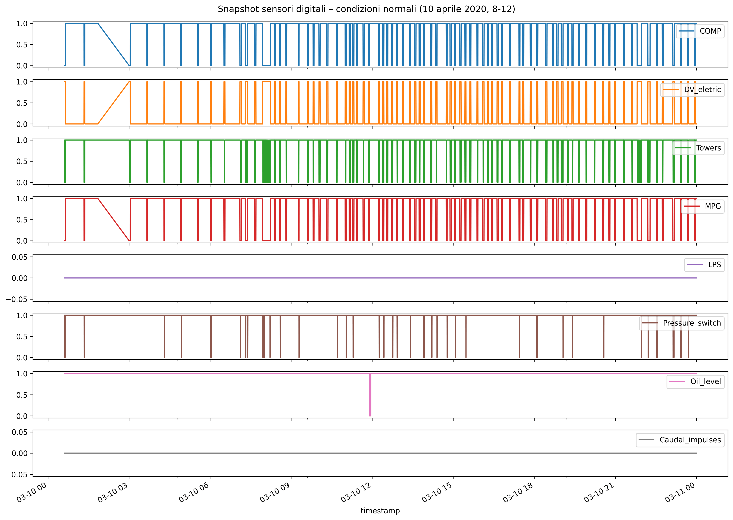

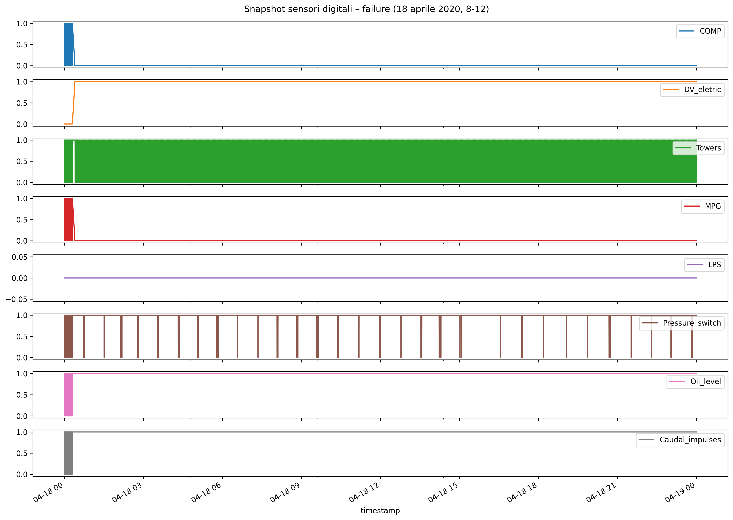

Si riportano di seguito, nelle Figure 6 e 7, gli snapshot relativi all’andamento giornaliero delle variabili analogiche e digitali registrate dal sistema di monitoraggio dell’APU, rispettivamente in condizioni di normale funzionamento, giornata del 10 marzo 2020 (a sinistra), e in condizioni di failure nella giornata del 18 aprile 2020 (a destra). Questa analisi comparativa consente di evidenziare in modo puntuale le differenze nei pattern operativi tra regime nominale e scenario di malfunzionamento.

Figura 6- Snapshot dell’andamento delle variabili analogiche in condizioni normali e di failure.

Dal confronto quantitativo tra i due regimi emerge che, in condizioni di normale funzionamento, le variabili analogiche manifestano oscillazioni e livelli di dispersione coerenti con la fisiologia dei cicli operativi dell’APU. In caso di failure, tutte le variabili evidenziano una drastica riduzione della deviazione standard, a testimonianza di una perdita della normale variabilità del sistema e del suo “cristallizzarsi” attorno a valori anomali.

Figura 7- Snapshot dell’andamento delle variabili digitali in condizioni normali e di failure.

L’analisi quantitativa delle variabili digitali mette in evidenza come, in condizioni normali, i sensori presentino frequenti commutazioni tra gli stati di attivazione, con elevata variabilità e pattern coerenti con la logica ciclica del sistema. In condizioni di failure, al contrario, si osserva anche in questo caso la tendenza di alcune variabili a stabilizzarsi in modo quasi permanente nello stato attivo o inattivo, mentre altre, manifestano un’alternanza continua, indice di instabilità operativa.

I fenomeni descritti precedentemente, facilmente rilevabile attraverso tecniche di visualizzazione e analisi statistica, costituiscono già di per sé dei robusti indicatori diagnostici, e offrono un supporto immediato alla diagnosi precoce e all’implementazione di sistemi di XAI nella PdM.

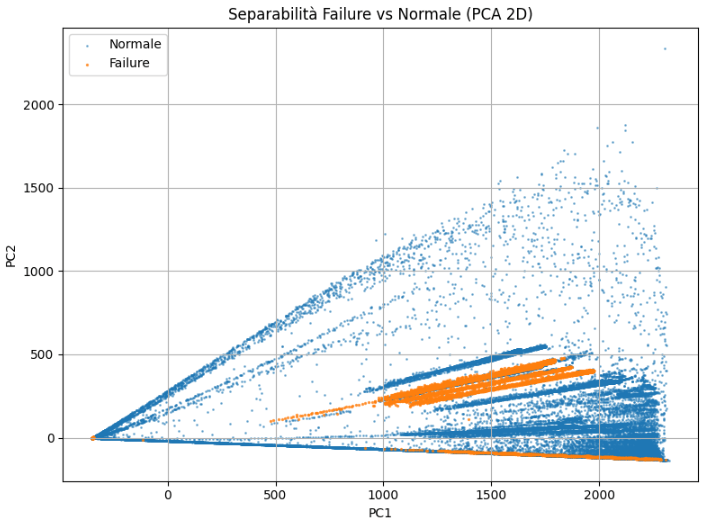

Analisi della separabilità tra condizioni normali e failure mediante PCA e t-SNE

Nell’ambito della PdM e dell’anomaly detection nei sistemi complessi, è prassi consolidata introdurre una fase di analisi preliminare della struttura dei dati. Questa fase è essenziale per valutare la separabilità tra stati normali e stati di failure, nonché per esplorare la presenza di pattern, cluster o outlier che possano influenzare le successive scelte modellistiche. Tecniche di dimensionality reduction non supervisionate, come la Principal Component Analysis (PCA) e la t-distributed Stochastic Neighbor Embedding (t-SNE), consentono di proiettare dati ad alta dimensionalità in spazi bidimensionali interpretabili, mantenendo, almeno parzialmente, le relazioni di distanza e struttura tra i dati originali.

La Principal Component Analysis (PCA) è una tecnica di riduzione dimensionale lineare, largamente impiegata nell’analisi esplorativa dei dati. PCA ricerca una trasformazione ortogonale che proietta i dati originari in uno spazio di dimensione inferiore, mantenendo la massima varianza possibile lungo le prime componenti principali. Formalmente, data una matrice dei dati centrata rispetto alla media, la PCA determina gli autovettori e gli autovalori della matrice di covarianza, e seleziona le direzioni corrispondenti ai maggiori autovalori. L’obiettivo è quindi quello di rappresentare ciascun dato tramite nuove variabili che sono combinazioni lineari delle variabili originali e che spiegano la quota più elevata di varianza osservata nei dati (Jolliffe e Cadima 2016). Questo facilita la visualizzazione e la comprensione della struttura latente, specialmente in contesti ad alta dimensionalità (IBM 2023), come nel caso in esame.

Nel presente studio, la PCA è stata applicata alle feature quantitative del dataset, previa standardizzazione robusta tramite RobustScaler, al fine di minimizzare l’influenza di eventuali outlier tipici dei dati di processo industriale. Lo script utilizzato procede come segue:

- Caricamento e pulizia dati, inclusa l’etichettatura binaria della variabile ‘failure’;

- Selezione delle feature tecniche rilevanti per l’analisi, in questo caso tutte.

- Scaling delle feature – tramite mediana e IQR – per maggiore robustezza.

- Applicazione della PCA: vengono estratte le prime due componenti principali che rappresentano la massima varianza.

- Visualizzazione: i dati vengono proiettati nel nuovo piano (PC1, PC2), e si osserva la distribuzione dei punti appartenenti alle classi normale e failure, con colori diversi.

Figura 8 – PCA applicata al dataset MetroPT3.

La Figura 8 mostra la proiezione bidimensionale delle osservazioni, con i punti blu rappresentanti condizioni di funzionamento normale e i punti arancioni associati ai periodi di failure conclamato. Si osserva una parziale separabilità tra le due classi. I punti associati ai failure tendono a occupare porzioni specifiche del piano delle componenti principali, generalmente localizzate verso valori intermedi o elevati di PC1, a testimonianza dell’effettiva differenza statistica tra le due condizioni operative. Tuttavia, permane una sovrapposizione significativa con la nuvola dei dati normali, indice di un fenomeno di class imbalance e della natura non perfettamente separabile del problema, tipico nei dataset reali di condition monitoring. Questo risultato conferma che feature engineering e modelli avanzati potrebbero rendersi necessari per migliorare la separabilità e la capacità predittiva.

L’analisi preliminare tramite PCA, pur evidenziando una certa separabilità tra condizioni normali e di failure, suggerisce che il problema presenta caratteristiche di alta complessità. Pertanto, la sola riduzione lineare delle dimensioni non consente una discriminazione netta tra i due stati. Questa evidenza motiva il ricorso a tecniche di feature extraction non lineari, come la t-SNE, e modelli neurali avanzati, oggetto della sezione successiva.

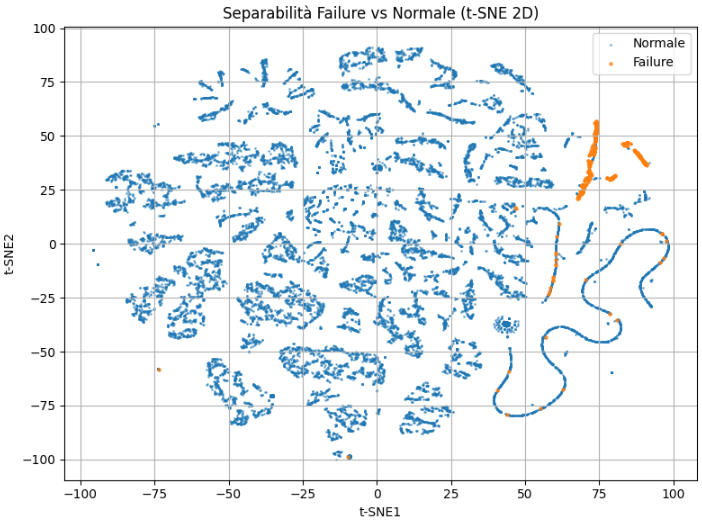

La t-distributed Stochastic Neighbor Embedding (t-SNE) è una tecnica di riduzione dimensionale non lineare introdotta da (van der Maaten e Hinton 2008) e ampiamente utilizzata per la visualizzazione di dati ad alta dimensionalità, specialmente in ambito di ML e pattern recognition. A differenza della PCA, la t-SNE non cerca di preservare la varianza globale dei dati, bensì le relazioni di vicinanza locale: trasforma le distanze euclidee nello spazio originale in probabilità che rappresentano la similarità tra punti, sia nello spazio ad alta che in quello a bassa dimensionalità, e minimizza la divergenza tra queste due distribuzioni tramite la Kullback-Leibler divergence. Per ovviare al problema del crowding – compressione eccessiva dei dati in basso spazio –, t-SNE utilizza una distribuzione t-Student. La t-SNE consente di evidenziare strutture locali come cluster, outlier e transizioni tra classi nei dati, anche quando queste non sono linearmente separabili, offrendo una visualizzazione interpretativa ma non adatta a compiti di classificazione diretta o inferenza quantitativa, quanto piuttosto a esplorazione qualitativa della struttura latente dei dati (IBM 2025).

Nel caso oggetto di studio, la t-SNE è stata applicata a un sottoinsieme casuale del dataset (20.000 istanze, scelta giustificata dalla complessità computazionale del modello) pre-elaborato tramite RobustScaler, con i parametri di default consigliati in letteratura (perplexity=30, learning rate=200, 1000 iterazioni, n_components=2).

Figura 9 – t-SNE applicata al dataset MetroPT3.

La visualizzazione risultante in Figura 9 mostra come le istanze di failure tendano ad aggregarsi in regioni specifiche dello spazio t-SNE, separate dalla maggior parte dei dati normali, benché permangano alcune sovrapposizioni. Questo suggerisce, anche in questo caso, che, pur in presenza di pattern di failure riconoscibili, esistono aree di confine in cui la distinzione rispetto ai dati normali non è netta, riflettendo la complessità e la variabilità delle condizioni operative reali del sistema. L’analisi conferma la validità di un approccio basato su modelli di failure prediction, ma evidenzia anche la necessità di tecniche avanzate per discriminare efficacemente tra condizioni normali e di failure.

Modelli predittivi interpretabili e black-box

Definito il quadro dei dati, si è proceduto allo sviluppo di modelli predittivi per l’identificazione precoce di comportamenti anomali riconducibili a potenziali failure nel sottosistema APU. Sono stati confrontati un modello interpretabile e un modello complesso, al fine di valutarne l’efficacia in termini di rilevazione e trasparenza.

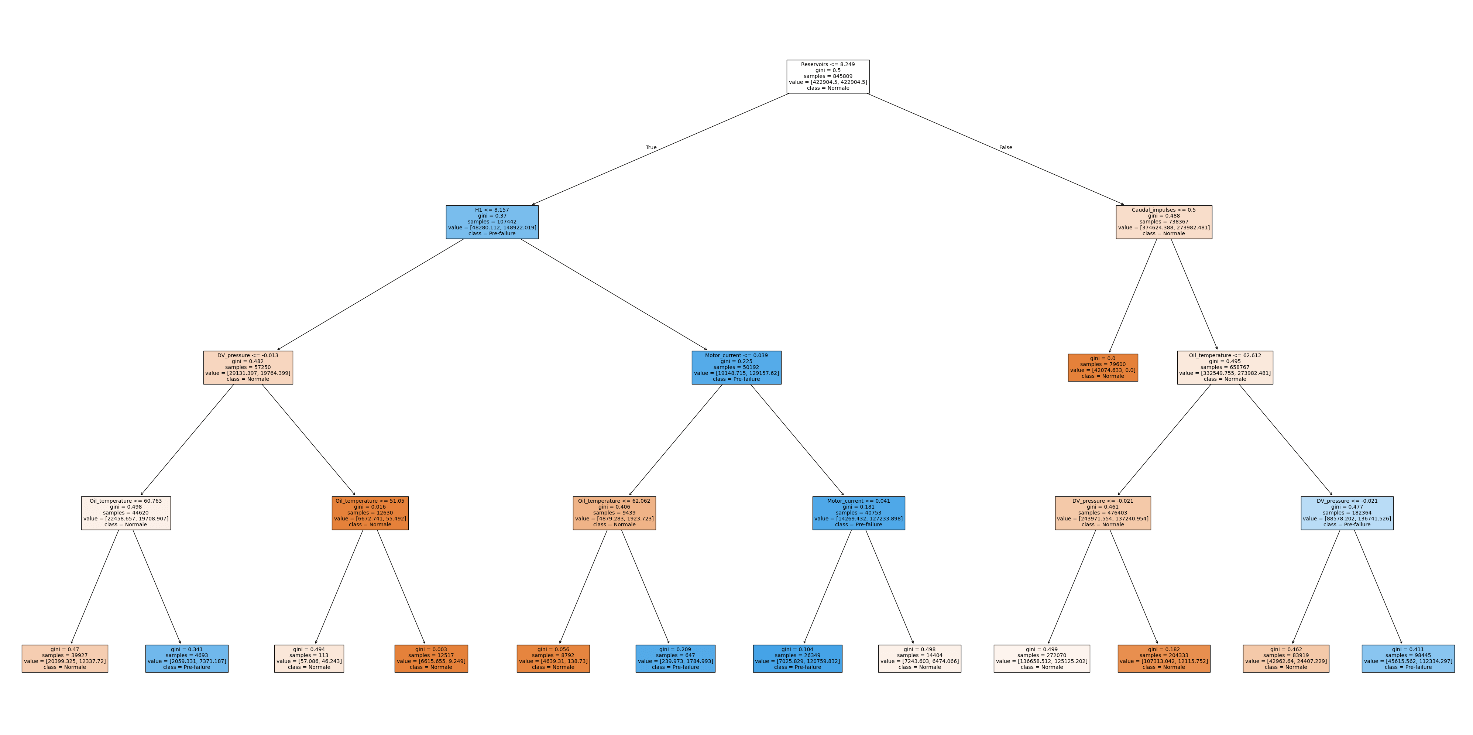

Il metodo Decision Tree

In primo luogo, come modello interpretabile, è stato utilizzato un albero decisionale (cd. Decision Tree). Un decision tree è un metodo di apprendimento automatico supervisionato, non parametrico, caratterizzato da una struttura gerarchica ad albero, impiegato sia per problemi di classificazione che di regressione. L’obiettivo principale di questa tecnica è costruire un modello capace di prevedere il valore di una variabile target apprendendo regole decisionali semplici derivate dalle variabili di input (ovvero le cd. feature). L’algoritmo suddivide ricorsivamente lo spazio degli input in sottoinsiemi, selezionando ad ogni nodo la variabile più informativa, fino a ottenere nei nodi foglia gruppi di dati omogenei rispetto alla variabile di uscita. Il processo si interrompe al soddisfacimento di specifici criteri di arresto – come profondità massima dell’albero o numero minimo di osservazioni per foglia –, producendo così una struttura in cui ogni percorso dalla radice a una foglia rappresenta una sequenza logica di decisioni che conduce alla predizione finale (Semanjski 2023).

Nel caso specifico, è stata adottata una strategia di etichettatura binaria per il compito di failure prediction. Nel corso delle sperimentazioni condotte sono stati esplorati molteplici scenari.

Dalle analisi svolte, la combinazione più efficace è risultata essere la seguente: addestramento sui dati relativi ai mesi di febbraio-maggio 2020, periodo che include almeno due finestre di pre-failure, esclusione dal training e dal test dei periodi di failure conclamato, etichettatura come classe positiva delle 72 ore precedenti ciascun guasto e utilizzo di tutte le feature disponibili – del resto il decision tree riduce il rischio di multicollinearità senza pregiudicare interpretabilità o capacità predittiva –, con una profondità massima dell’albero decisionale fissata a 4. Questo schema di etichettatura riflette un caso d’uso realistico: si desidera che il sistema segnali un’allerta entro un certo anticipo – sino a 2–24 ore – così da poter intervenire prima che si verifichi il guasto critico (Veloso, Gama, et al. 2022).

Nella Figura 10 è riportata la rappresentazione grafica dell’albero decisionale addestrato sul dataset MetroPT-3 per la previsione delle condizioni di pre-failure dell’APU. L’albero consente di visualizzare in modo trasparente le principali regole decisionali apprese dal modello.

Figura 10 – Decision Tree.

A titolo esemplificativo, si evidenzia uno dei percorsi principali che conduce alla classificazione di uno stato di pre-failure:

SE Reservoirs ≤ 8.25 E H1 ≤ 8.16 E DV_pressure ≤ -0.01 E Oil_temperature > 60.76 → Classe predetta: 1 (pre-failure).

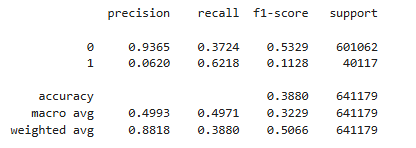

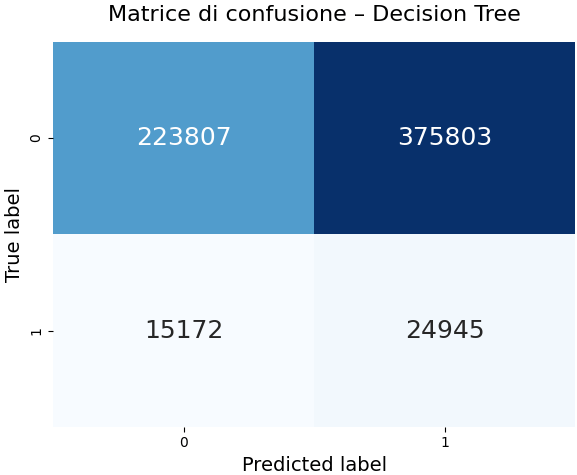

Questo percorso mette in luce la combinazione di condizioni operative che, secondo il modello, sono maggiormente associate all’insorgere di anomalie imminenti. Dal punto di vista delle metriche di performance, i risultati ottenuti sono riportati in Figura 11.

Figura 11 – Metriche di performance del decision tree.

Questi valori evidenziano una elevata capacità di richiamo (cd. recall) per la classe pre-failure (62%), il che significa che il modello riesce a intercettare una buona quota di condizioni anomale effettive. Tuttavia, la precisione risulta particolarmente bassa per la stessa classe (6%), indicando una elevata frequenza di falsi positivi. Il valore di accuratezza complessiva (circa il 39%) è influenzato dallo sbilanciamento delle classi e dalla struttura semplificata del modello.

La matrice di confusione, riportata in Figura 12, mostra che la maggior parte delle istanze classificate come pre-failure sono in realtà normali (cd. falsi positivi), mentre una parte rilevante degli stati normali viene correttamente riconosciuta come tale. In scenari applicativi ad elevata criticità, può essere preferibile massimizzare la sensibilità rispetto agli eventi avversi, anche al costo di un incremento del tasso di allarme, al fine di garantire una copertura estesa degli stati di rischio.

Figura 12 – Matrice di confusione del decision tree.

In conclusione, il decision tree si conferma uno strumento altamente spiegabile, in grado di fornire regole decisionali facilmente interpretabili e tracciabili da parte degli operatori. Tuttavia, le prestazioni predittive risultano limitate, soprattutto in termini di precisione, a causa della natura intrinsecamente complessa e sbilanciata del problema. Tali evidenze suggeriscono la necessità di integrare modelli interpretabili con approcci più sofisticati, affiancati da tecniche di XAI, al fine di coniugare trasparenza e affidabilità predittiva nei sistemi di PdM.

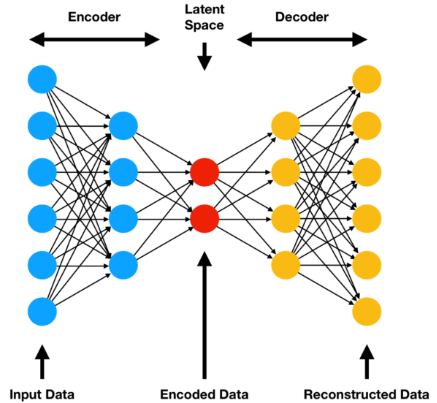

L’Autoencoder

Un autoencoder (AE) è una rete neurale artificiale progettata per apprendere una rappresentazione compressa dei dati, mantenendo al contempo la capacità di ricostruire l’input originale. L’architettura tipica di un AE è simmetrica e comprende uno strato di input e uno di output di dimensione equivalente, intervallati da uno o più strati nascosti a capacità ridotta. Tali strati costituiscono il bottleneck del modello e sono responsabili della codifica delle informazioni salienti in uno spazio latente di dimensionalità inferiore. La rete è addestrata in maniera non supervisionata a minimizzare l’errore di ricostruzione, ossia la differenza tra l’input originario e l’output prodotto dal decoder. L’encoder trasforma l’input ad alta dimensionalità in una rappresentazione compatta, mentre il decoder tenta di ricostruire fedelmente i dati iniziali a partire da tale rappresentazione (Narjes Davari, Veloso, Ribeiro, et al. 2021), (Bergmann e Stryker 2023). Nella Figura 13 è riportato lo schema di un AE.

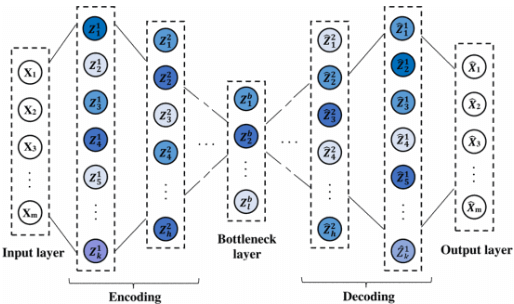

Figura 13 – Schema di un autoencoder (Cisternino 2024).

Gli autoencoder sparsi (SAE) impongono un vincolo di scarsità: invece di creare un collo di bottiglia delle informazioni riducendo il numero di nodi in ogni livello nascosto, i SAE creano un collo di bottiglia riducendo il numero di nodi che possono essere attivati contemporaneamente. Gli AE con una funzione di scarsità sono penalizzati per ogni neurone che è stato attivato oltre una certa soglia. Questo permette all’encoder e al decoder di avere una capacità maggiore senza un corrispondente rischio di overfitting ai dati di addestramento (perché non tutti i neuroni saranno attivati). Consente inoltre agli strati nascosti di contenere nodi dedicati alla scoperta di caratteristiche specifiche: la funzione di scarsità garantisce l’attivazione di tali nodi solo se queste sono presenti. Sebbene il calcolo dell’errore di ricostruzione e la successiva ottimizzazione dei pesi dei parametri attraverso la retro-propagazione avvengano separatamente, questa ottimizzazione viene regolarizzata dalla funzione di scarsità. L’AE è quindi costretto ad apprendere la rappresentazione dello spazio latente più efficace entro i vincoli di scarsità dati. Le funzioni utilizzate per imporre un vincolo di scarsità sono tipicamente la regolarizzazione L1 o la divergenza di KL (Bergmann e Stryker 2023) (Narjes Davari, Veloso, Ribeiro, et al. 2021).

Figura 14 – Schema di uno sparse autoencoder (Narjes Davari, Veloso, Ribeiro, et al. 2021).

Sia gli AE che gli SAE trovano un’applicazione particolarmente efficace nei compiti di anomaly detection (Narjes Davari et al. 2024). Grazie alla loro capacità di apprendere una rappresentazione compressa e ricostruire fedelmente dati normali, tali architetture risultano in grado di identificare anomalie come deviazioni significative tra input e output ricostruito.

L’architettura dello SAE adottata in questo studio si compone di strati completamente connessi (cd. fully connected), organizzati simmetricamente rispetto a un bottleneck layer costituito da 8 neuroni. I parametri principali sono stati fissati come segue: dimensione dei layer intermedi [128, 64, 32, 16], dropout del 20% dopo il quarto layer, e penalità di sparsità implementata tramite una divergenza di Kullback-Leibler con target ρ=0.01 e peso β=5, applicata come activity regularizer al bottleneck. L’addestramento del modello è stato effettuato su un campione casuale di 100.000 istanze di dati normali, ossia non afferenti a finestre di failure o recupero post-failure – in particolare le 4 ore successive –, selezionate dal dataset MetroPT3, e preprocessate mediante RobustScaler per mitigare l’impatto di eventuali outlier. La fase di training si è svolta per 100 epoche, con batch size pari a 50 e validation split del 10%. Il modello è stato ottimizzato mediante la funzione di perdita MSE (Mean Squared Error) e ottimizzatore Adam, lasciando la penalità di sparsità all’activity regularizer.

La soglia per la detection di anomalie è stata fissata al 99° percentile degli errori di ricostruzione calcolati sul training set normale, con successiva validazione delle performance sul test set completo.

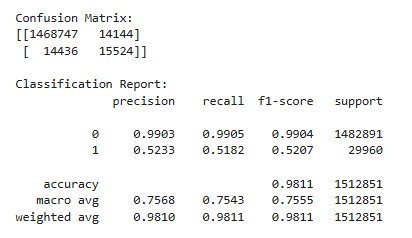

Figura 15- Metriche di performance del modello SAE.

Le metriche ottenute, mostrate in Figura 15, in particolare recall=0.52, precision=0.52, accuracy>98%, sebbene quest’ultima poco indicativa dato il forte sbilanciamento tra le classi, dimostrano una capacità discriminante superiore rispetto a una classificazione casuale, in linea con le migliori pratiche nella letteratura sull’anomaly detection industriale (Narjes Davari, Veloso, Ribeiro, et al. 2021). Il risultato attesta la validità del SAE come baseline robusta, adatta per scenari reali di PdM in ambito ferroviario.

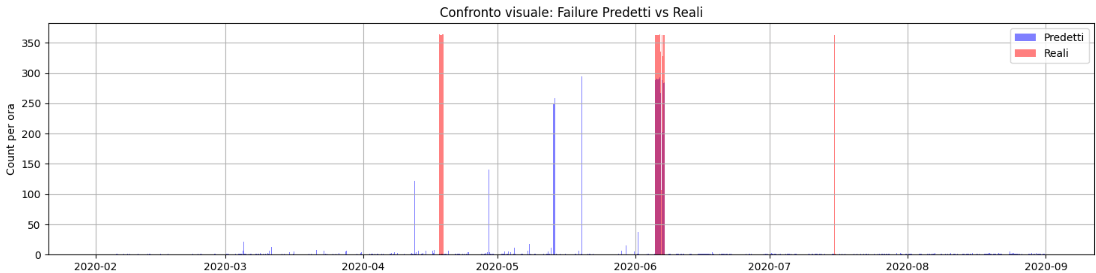

Al fine di valutare qualitativamente la capacità discriminante del modello SAE rispetto all’andamento temporale degli eventi di failure, è stato sviluppato uno script di visualizzazione che consente il confronto diretto tra i failure reali annotati nel dataset e quelli predetti dal modello. In particolare, le occorrenze di failure reali e predetti sono state aggregate su base oraria, mediante funzione di resampling temporale, e rappresentate tramite istogrammi sovrapposti all’interno di un unico grafico mostrato in Figura 16.

Figura 16- Visualizzazione comparata tra failure reali e predetti.

Questo approccio permette di cogliere, con immediatezza visiva, la coerenza temporale tra i pattern di anomalie identificate dal modello e gli eventi di failure effettivamente osservati sul sistema. L’aggregazione oraria consente di attenuare la variabilità puntuale e di mettere in risalto sia le corrispondenze che le eventuali discrepanze tra predizioni e realtà osservata, offrendo un ausilio interpretativo prezioso sia per la validazione del modello che per la successiva fase di analisi causa-effetto. La sovrapposizione cromatica tra le barre (blu per i failure predetti, rosso per i failure reali) consente inoltre di individuare con facilità eventuali falsi positivi (predizioni anomale non confermate da eventi reali) e falsi negativi (failure reali non intercettate dal modello), favorendo così una valutazione puntuale delle performance del modello in ottica applicativa e operativa.

Questo tipo di rappresentazione, ampiamente utilizzato in letteratura per la rappresentazione di sistemi di anomaly detection su dati temporali (Amini e and Gan 2022), risulta di particolare utilità in contesti industriali.

Spiegabilità del modello black box tramite SHAP e LIME

Dopo aver sviluppato i modelli predittivi, sono stati integrati metodi di spiegazione XAI per interpretare le predizioni del modello SAE. In particolare, sono stati utilizzati SHAP e LIME.

Il metodo SHAP

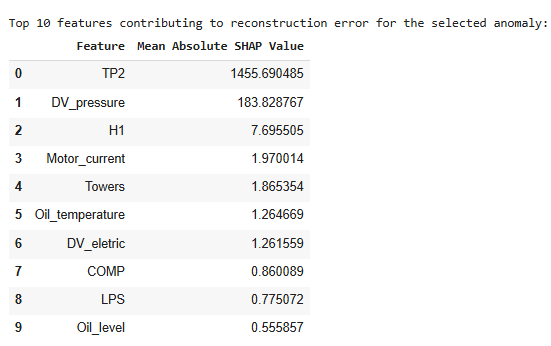

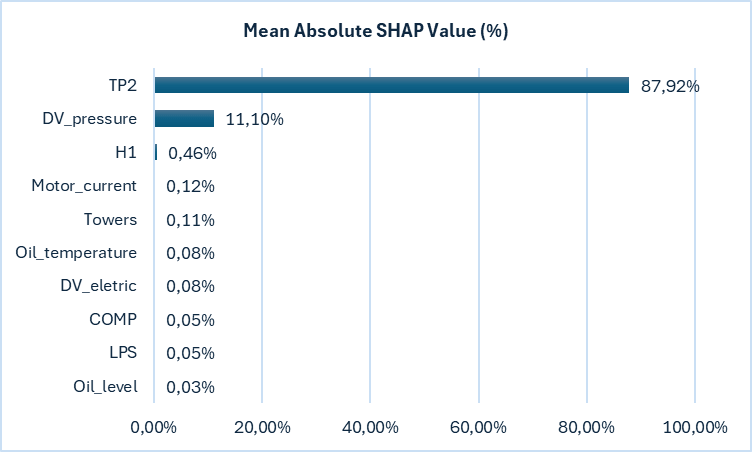

Al fine di garantire un’interpretabilità del comportamento del modello SAE, è stata condotta un’analisi di interpretabilità locale mediante SHAP, utilizzando l’approccio DeepExplainer appropriato per modelli neurali differenziabili. L’analisi è stata applicata alla prima singola istanza correttamente classificata come failure (cd. true positive), selezionata dal test set. L’obiettivo era identificare le feature che, in quella specifica circostanza, hanno maggiormente contribuito all’errore di ricostruzione del modello. SHAP è un metodo di interpretazione dei modelli basato sulla teoria dei giochi cooperativi, che assegna a ciascuna variabile un “contributo” alla predizione finale. Ispirato ai valori introdotti da (Shapley 1953), il metodo quantifica l’importanza di una variabile come la media ponderata dei suoi contributi marginali in tutte le possibili coalizioni di feature (Lundberg e Lee 2017). Pertanto, dopo aver definito un background set indipendente (200 istanze normali per garantire efficienza computazionale), il metodo ha calcolato i valori SHAP associati a ciascuna feature di input, aggregando i contributi lungo le dimensioni di output ricostruite dal modello. L’aggregazione è stata ottenuta calcolando il valore assoluto medio dei contributi SHAP attraverso tutte le feature ricostruite, fornendo così una misura consolidata dell’influenza complessiva di ciascuna variabile sull’errore di ricostruzione per l’istanza analizzata. Tale approccio è coerente con le raccomandazioni presenti nella letteratura sull’interpretabilità dei modelli AI in contesti critici, dove l’analisi locale delle predizioni riveste un ruolo fondamentale per il debugging operativo (Bulla e Birje 2022).

Figura 17 – Risultati di SHAP.

L’analisi dei Mean Absolute SHAP Values evidenzia una forte dominanza della variabile TP2 (misura della pressione sul compressore) nel contribuire all’errore di ricostruzione, largamente superiore rispetto alle altre. Questo suggerisce che, per l’anomalia in esame, le deviazioni anomale di TP2 rispetto al comportamento appreso durante il training hanno avuto un impatto preponderante nella classificazione come failure da parte del modello. L’interpretazione fornita è coerente con la natura del sistema osservato e ciò suggerisce la possibilità di utilizzare TP2 come leading indicator in uno schema di early warning. Infine, si evidenzia che l’importanza delle variabili non è distribuita uniformemente: le prime due feature contribuiscono in misura schiacciante all’errore (circa il 99%), mentre le restanti appaiono marginali. Questo comportamento potrebbe essere ulteriormente indagato con analisi globali aggregate per verificare se il pattern si conferma su un numero maggiore di anomalie predette.

La metodologia LIME

LIME è una delle metodologie più affermate per l’interpretabilità dei modelli di AI (Cummins et al. 2024), in particolare nei contesti in cui è necessario spiegare localmente la decisione di un modello complesso su una specifica istanza. Il metodo è stato introdotto da (Ribeiro, Singh, e Guestrin 2016), ed ha avuto un impatto significativo sia nella letteratura scientifica sia nelle applicazioni industriali. Esso si basa sulla generazione di un set di dati sintetici (cd. perturbazioni locali) ottenuto perturbando le feature dell’istanza di interesse. Per ciascuna di queste istanze modificate, si calcola la predizione del modello complesso da spiegare. Viene quindi addestrato un modello interpretabile locale che approssima il comportamento del modello complesso nella vicinanza della specifica istanza. L’importanza attribuita alle variabili deriva dai coefficienti del modello interpretabile locale, pesati rispetto alla distanza tra l’istanza originale e quelle perturbate. La validità delle spiegazioni dipende dalla qualità delle perturbazioni e dalla capacità del modello interpretabile di approssimare localmente la black box, non offrendo, pertanto, garanzie di coerenza globale sulle spiegazioni. Tuttavia la letteratura ha evidenziato che LIME può soffrire di instabilità locale (Alvarez-Melis e Jaakkola 2018), in quanto le spiegazioni prodotte per punti adiacenti nello spazio delle feature possono risultare significativamente diverse anche in assenza di cambiamenti sostanziali nel dato (Molnar 2025).

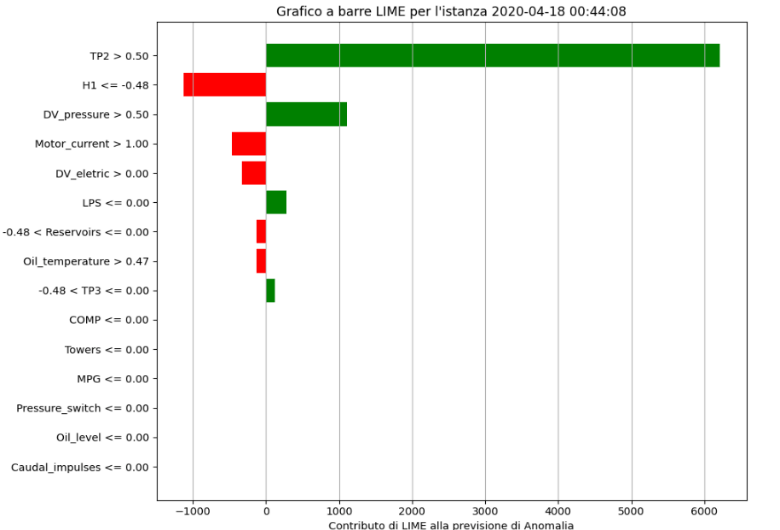

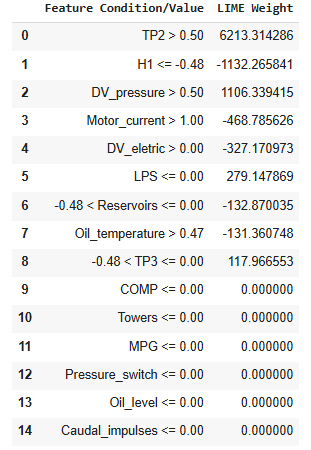

Nella fase esplicativa del modello di anomaly detection basato sul SAE, è stato implementato il framework LIME per generare interpretazioni locali su istanze specifiche. Coerentemente con l’approccio adottato per SHAP, è stata selezionata la prima istanza true positive, garantendo comparabilità metodologica. Per rendere compatibile l’output del SAE con l’approccio model-agnostic di LIME, è stata definita una funzione di predizione che restituisce il valore di errore di ricostruzione calcolato per ogni input. Il training set normalizzato è stato utilizzato come background per il LimeTabularExplainer, impostato in modalità classification. La spiegazione permette di identificare le feature maggiormente responsabili dell’assegnazione locale della predizione anomala, supportando un’analisi interpretativa post-hoc conforme alle migliori pratiche XAI per contesti industriali. I contributi sono stati ordinati per valore assoluto e rappresentati graficamente tramite un bar plot orizzontale, dove il colore indica la direzione del contributo (verde per effetto positivo sull’anomalia, rosso per effetto negativo). Questa visualizzazione, mostrata in Figura 18, permette all’utente di individuare a colpo d’occhio quali condizioni sulle variabili di input risultano più determinanti per la specifica decisione locale del modello.

Figura 18 – Risultati di LIME.

L’analisi locale effettuata tramite LIME evidenzia che la condizione più rilevante per la classificazione di anomalia è rappresentata dal valore elevato della variabile TP2. Le variabili con peso nullo in questa spiegazione non hanno contribuito alla classificazione della specifica anomalia. Quanto evidenziato trova riscontro nell’analisi fornita da SHAP, dove la feature TP2 risulta nettamente dominante per l’errore di ricostruzione. La coerenza tra i due metodi, nonostante le differenze concettuali e operative, conferma la rilevanza di tale variabile nel contesto della failure considerata e rafforza l’affidabilità interpretativa del modello SAE.

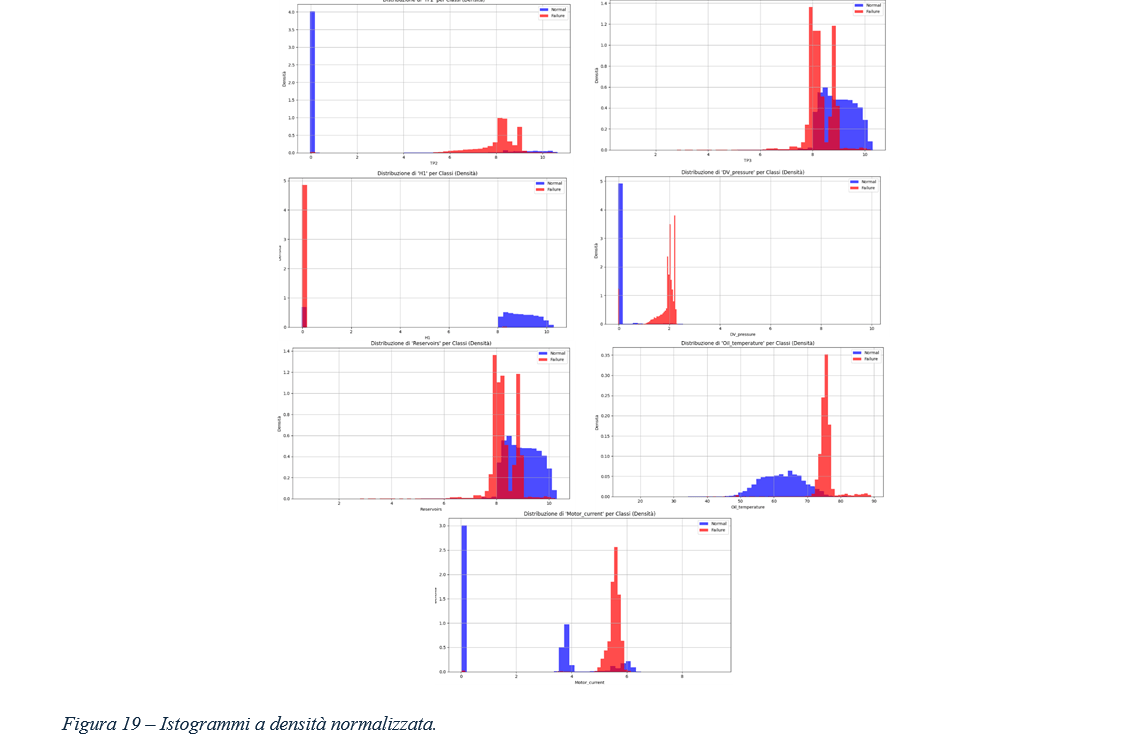

Analisi esplorativa delle distribuzioni delle variabili rispetto agli eventi di failure

Al fine di comprendere le differenze strutturali tra condizioni operative normali e anomale conclamate, è stata condotta un’analisi esplorativa della distribuzione delle variabili di processo. A tale scopo, per ciascuna feature, sono stati generati istogrammi di densità distinti per le osservazioni associate a condizioni normali e a quelle di failure, utilizzando i dati etichettati nel dataset MetroPT3. La metodologia adottata, generando per ciascuna variabile istogrammi a densità normalizzata, mostrati in Figura 19, per le sole variabili analogiche, consente di visualizzare graficamente la sovrapposizione o la separazione delle distribuzioni nei due stati. Questo tipo di visualizzazione rappresenta uno strumento diagnostico fondamentale sia nella fase preliminare di feature selection, sia per l’interpretazione fisica delle variabili individuate come rilevanti dai modelli di XAI.

Una feature è potenzialmente utile per l’anomaly detection se la distribuzione dei valori (ovvero la forma e la posizione dell’istogramma) è significativamente diversa tra lo stato normale e lo stato di guasto. Se gli istogrammi blu e rosso sono quasi identici o si sovrappongono ampiamente, significa che i valori di quella feature non cambiano molto tra i due stati, e quindi quella feature è meno utile per distinguerli.

La presenza di differenze sistematiche tra le distribuzioni può essere utilizzata per motivare la selezione di specifiche feature all’interno dei modelli predittivi e per validare l’affidabilità dei risultati forniti da tecniche XAI. quali SHAP e LIME. L’analisi della distribuzione della variabile TP2 ha evidenziato una marcata differenza tra i periodi di normale funzionamento e quelli caratterizzati da failure conclamate. Questa evidenza trova conferma nelle analisi di explainability: sia l’algoritmo SHAP sia LIME individuano TP2 come la feature a maggior contributo per la predizione delle anomalie nell’istanza analizzata. Tuttavia, l’esistenza di un overlap tra le distribuzioni delle due classi impone cautela: nonostante TP2 rappresenti un efficace segnale sentinella, non costituisce una variabile discriminante perfetta.

L’output analizzato va interpretato, pertanto, come uno strumento integrativo rispetto alle analisi XAI, in grado di fornire al ricercatore e all’ingegnere di dominio un supporto visivo immediato per comprendere il comportamento delle variabili critiche in relazione agli eventi di failure.

Risultati dello studio e discussione

I risultati sperimentali ottenuti sul caso studio MetroPT-3 confermano il valore aggiunto derivante dall’integrazione di tecniche di XAI nei sistemi di PdM. In fase preliminare, l’impiego di tecniche non supervisionate di riduzione della dimensionalità, quali la PCA e la t-SNE, ha consentito la proiezione di dati ad alta dimensionalità in spazi bidimensionali più interpretabili, preservando – almeno in parte – le relazioni topologiche e le distanze tra le istanze nel dominio originale. Tali rappresentazioni visuali hanno evidenziato la presenza di strutture latenti nei dati, giustificando l’adozione di modelli predittivi avanzati per la rilevazione precoce delle anomalie.

Dal punto di vista quantitativo, il modello SAE ha evidenziato capacità discriminanti superiori rispetto a una classificazione casuale, con valori di recall e precision pari a 0,52 e un’accuracy superiore al 98%. Questi risultati rispecchiano quanto riportato nelle principali esperienze di anomaly detection su dati industriali presenti in letteratura. Inoltre, attestano la validità del SAE come baseline robusta, adatta a scenari reali di PdM. L’analisi visuale delle predizioni lungo l’asse temporale consente una valutazione qualitativa immediata della sensibilità e della specificità operativa del modello. Tale rappresentazione facilita l’identificazione di falsi positivi (allarmi non associati a guasti effettivi) e falsi negativi (mancata rilevazione di failure reali), cruciale in contesti reali di esercizio.

Il confronto con un albero decisionale interpretabile – seppur caratterizzato da metriche inferiori, soprattutto in termini di precision sulla classe di interesse – ha fornito una chiara struttura di regole, utile sia come baseline che come riferimento per la validazione delle evidenze emerse dai modelli più complessi. In prospettiva, la combinazione di modelli black-box e modelli interpretabili rappresenta una strategia efficace per bilanciare accuratezza e trasparenza nella PdM, e pone le basi per una transizione verso sistemi di decision support realmente affidabili e spiegabili.

Sul fronte dell’interpretabilità, l’integrazione delle tecniche XAI, quali SHAP e LIME, ha permesso di collegare quantitativamente i risultati del modello black box alle variabili fisiche sottostanti. La convergenza delle spiegazioni ha individuato il sensore TP2 come principale driver delle decisioni di anomalia, coerentemente con l’analisi esplorativa delle distribuzioni delle feature. Questo riscontro, validato su istanze di true positive, dimostra come l’approccio XAI consenta di rendere trasparenti e giustificabili le predizioni di modelli complessi, favorendo l’accettabilità degli algoritmi AI in contesti safety-critical.

Le tecniche di XAI migliorano concretamente la comprensibilità del sistema predittivo e la sua utilità decisionale per gli stakeholder operativi, quali tecnici della manutenzione e dirigenti. L’adozione combinata di SHAP e LIME ha permesso di generare spiegazioni coerenti e reciprocamente complementari, abilitando una lettura chiara dei risultati del modello. In termini applicativi, questa sinergia consente di fondare le decisioni data-driven della PA su evidenze tecniche verificabili, aumentando il grado di accountability delle scelte.

In scenari operativi ad elevata complessità decisionale, come quelli che caratterizzano il trasporto pubblico locale, la possibilità di disporre di spiegazioni puntuali, coerenti e comprensibili in merito alle decisioni algoritmiche rappresenta un requisito essenziale non solo per l’efficacia operativa, ma anche per la legittimazione istituzionale delle scelte. In particolare, nel caso in cui un convoglio ferroviario venga temporaneamente ritirato per manutenzione, l’assenza di trasparenza può generare disservizi percepiti, perdita di fiducia da parte dell’utenza e contestazioni da parte degli organi di vigilanza. Le evidenze fornite da tecniche di interpretabilità post-hoc possono costituire strumenti fondamentali di accountability comunicativa, in grado di supportare la motivazione delle decisioni sia nei confronti delle autorità di regolazione, sia nei confronti dei cittadini. Tali strumenti favoriscono l’affermazione di una trasparenza operativa sostanziale, elemento sempre più richiesto nei contesti di adozione dell’AI nella PA e nei servizi di interesse pubblico.

Un ulteriore potenziale beneficio riguarda poi l’accelerazione del ciclo diagnostico. Le spiegazioni fornite dai metodi XAI possono arricchire la conoscenza di dominio, suggerendo relazioni latenti tra variabili che potrebbero non essere state inizialmente considerate dagli operatori. In questa prospettiva, l’XAI si configura come uno strumento cognitivo, in grado di rafforzare la collaborazione tra uomo e macchina.

Infine, una valutazione qualitativa dell’utilizzo di tecniche di XAI suggerisce un aumento percepito della fiducia e della soddisfazione da parte degli utenti finali. In linea con l’approccio human-centered AI, le spiegazioni agiscono come catalizzatori di fiducia, allineando il comportamento del modello predittivo al modello mentale dei tecnici (Kucher, Zohrevandi, e Westin 2025). Questo è l’obiettivo fondante delle moderne applicazioni AI-human collaborative: valorizzare la velocità di analisi e la capacità di pattern recognition dell’AI, integrandole con l’esperienza e il giudizio esperto degli operatori umani.

Limiti dello studio

Nonostante i risultati positivi, lo studio presenta alcuni limiti. In primo luogo, il modello SAE non cattura esplicitamente le dipendenze temporali intrinseche nelle serie storiche dei dati del compressore, a differenza di architetture ricorrenti come le LSTM che potrebbero essere più adatte a modellare la sequenzialità dei dati (Bisht 2025).

In secondo luogo, non è stato eseguito un feature engineering specifico che consideri finestre temporali o eventi contestuali, come l’analisi dei dati durante le fasi di avvio del compressore, un approccio che, come proposto in letteratura, potrebbe fornire feature più informative per il rilevamento di anomalie legate a specifici stati operativi (Narjes Davari et al. 2024).

Dal punto di vista della regolarizzazione, la penalità di sparsità impiegata nel SAE è implementata tramite l’activity regularizer di Keras, che la calcola in maniera batch-wise (Keras 2023). Tuttavia, la sparsity è definita come proprietà globale sull’intero training set (Ng 2017). Tale discrepanza può comportare una penalizzazione non ottimale e variazioni nella convergenza tra i diversi batch. Sebbene il calcolo batch-wise sia una semplificazione metodologica ampiamente adottata per ragioni computazionali, essa potrebbe non risultare adeguata qualora si richieda un rigore teorico più stringente.

In merito alla componente esplicativa, la qualità delle spiegazioni fornite da LIME e SHAP dipende fortemente dalla copertura e rappresentatività del dataset di addestramento. In particolare, il campione disponibile, limitato a circa sei mesi e contenente solo quattro eventi di guasto, potrebbe non rappresentare esaustivamente la varietà di failure possibili nel sistema. Ciò comporta un rischio di underfitting nelle spiegazioni e una potenziale riduzione dell’affidabilità del modello in scenari diversi da quelli osservati. Inoltre, sarebbe opportuno estendere l’analisi SHAP anche a livello globale, al fine di verificare la coerenza delle importanze delle feature su tutto il dominio delle predizioni anomale. La combinazione di spiegazioni locali e globali rappresenta una best practice raccomandata in letteratura per la validazione dei sistemi XAI in ambiti industriali complessi.

Infine, per migliorare ulteriormente la qualità e l’utilità operativa delle spiegazioni generate dai modelli di XAI, si ritiene auspicabile l’integrazione di approcci di Root Cause Analysis (RCA) basati su conoscenza esperta e su ontologie ingegneristiche di dominio. L’obiettivo è quello di arricchire le spiegazioni algoritmiche con componenti causali, superando i limiti di interpretazioni puramente statistiche o post-hoc. Tale integrazione consente di contestualizzare gli alert generati, facilitando l’identificazione del guasto primario e la pianificazione di azioni correttive efficaci. Studi recenti mostrano che l’adozione congiunta di modelli predittivi, tecniche XAI e framework RCA incrementa in modo significativo la robustezza delle diagnosi e la loro affidabilità in scenari reali di PdM (Narjes Davari, Veloso, Costa, et al. 2021).

Conclusioni

Il presente studio ha illustrato un approccio integrato per la PdM nel settore ferroviario, fondato sulla combinazione di SAE, tecniche di XAI e metodologie esplorative basate su riduzione dimensionale. Nonostante alcune semplificazioni adottate per garantire l’applicabilità in contesti reali, l’architettura proposta si è dimostrata solida, efficace e compatibile con i vincoli operativi.

L’analisi condotta sul dataset MetroPT‑3 ha evidenziato che, anche in presenza di modelli percepiti come black box, è possibile garantire un elevato grado di trasparenza decisionale attraverso l’impiego di strumenti di interpretabilità post-hoc. In particolare, il SAE ha mostrato buone capacità di intercettare anomalie riconducibili a condizioni di pre-failure, mentre le tecniche SHAP e LIME hanno fornito spiegazioni localmente consistenti e interpretabili.

Un’ulteriore validazione empirica della robustezza delle spiegazioni è emersa dall’analisi delle distribuzioni di densità delle variabili, evidenziando una coerenza tra le feature ritenute rilevanti dai metodi XAI e i pattern statistici effettivamente osservati nei dati. Tale coerenza supporta l’affidabilità delle spiegazioni generate e rafforza la legittimità dell’adozione di XAI.

Dal punto di vista metodologico, il lavoro mette in luce il valore delle spiegazioni puntuali fornite da tecniche XAI locali, che consentono di attribuire direzione e intensità ai contributi delle variabili su singole istanze. Tali spiegazioni risultano compatibili con i requisiti di accountability, tracciabilità e trasparenza richiesti nei contesti decisionali della PA. Il risultato è un compromesso tra accuratezza predittiva e intelligibilità del modello, condizione necessaria per una diffusione responsabile dell’AI nella PA.

In prospettiva, si evidenzia la necessità di integrare le tecniche di XAI con strumenti di visual analytics, attraverso dashboard interattive in grado di coniugare spiegazioni locali e globali in formato operativo. Sarà inoltre cruciale lo sviluppo di analisi SHAP su scala globale per l’individuazione di pattern di rilevanza ricorrenti, nonché l’estensione del framework a configurazioni time-aware (es. LSTM), capaci di cogliere le dinamiche temporali tipiche dei sistemi tecnici complessi.

Infine, il rafforzamento della governance algoritmica rappresenta una priorità trasversale. Ciò implica l’introduzione di pratiche sistematiche di auditabilità, supervisione umana e valutazione del rischio algoritmico lungo tutto il ciclo di vita del modello, in coerenza con i requisiti emergenti dal Regolamento europeo sull’AI e dai quadri normativi nazionali. L’adozione di tali misure è essenziale per costruire ecosistemi di AI realmente affidabili, sostenibili e conformi ai principi di buona amministrazione.

Bibliografia

Alvarez-Melis, David, e Tommi S. Jaakkola. 2018. «On the Robustness of Interpretability Methods». doi:10.48550/arXiv.1806.08049.

Amini, Amin, Kanfoud ,Jamil, e Tat-Hean and Gan. 2022. «An Artificial Intelligence Neural Network Predictive Model for Anomaly Detection and Monitoring of Wind Turbines Using SCADA Data». Applied Artificial Intelligence 36(1): 2034718. doi:10.1080/08839514.2022.2034718.

Barros, Mariana, Bruno Veloso, Pedro M. Pereira, Rita P. Ribeiro, e João Gama. 2020. «Failure Detection of an Air Production Unit in Operational Context». In IoT Streams for Data-Driven Predictive Maintenance and IoT, Edge, and Mobile for Embedded Machine Learning, a c. di Joao Gama, Sepideh Pashami, Albert Bifet, Moamar Sayed-Mouchawe, Holger Fröning, Franz Pernkopf, Gregor Schiele, e Michaela Blott. Cham: Springer International Publishing, 61–74. doi:10.1007/978-3-030-66770-2_5.

Bergmann, D., e C. Stryker. 2023. «Cos’è un autoencoder?» https://www.ibm.com/it-it/think/topics/autoencoder (24 giugno 2025).

Bisht, Amrit. 2025. «ANN vs RNN: Why RNN Is the Better Choice for Sequential Data». Medium. https://medium.com/@amritsinghbist/ann-vs-rnn-why-rnn-is-the-better-choice-for-sequential-data-7c3e38706673.

Bulla, Chetan, e Mahantesh N. Birje. 2022. «Improved Data-Driven Root Cause Analysis in Fog Computing Environment». Journal of Reliable Intelligent Environments 8(4): 359–77. doi:10.1007/s40860-021-00158-x.

Cisternino, A. 2024. «L’autoencoder svelato: ecco come l’AI crea le immagini». Agenda Digitale. https://www.agendadigitale.eu/cultura-digitale/lautoencoder-svelato-ecco-come-lai-crea-le-immagini/.

Cummins, Logan, Alexander Sommers, Somayeh Bakhtiari Ramezani, Sudip Mittal, Joseph Jabour, Maria Seale, e Shahram Rahimi. 2024. «Explainable Predictive Maintenance: A Survey of Current Methods, Challenges and Opportunities». IEEE Access 12: 57574–602. doi:10.1109/ACCESS.2024.3391130.

Davari, N., B. Veloso, B. R. Ribeiro, e J. Gama. 2021. «MetroPT-3 Dataset». doi:https://doi.org/10.24432/C5VW3R.

Davari, Narjes, Bruno Veloso, Gustavo de Assis Costa, Pedro Mota Pereira, Rita P. Ribeiro, e João Gama. 2021. «A Survey on Data-Driven Predictive Maintenance for the Railway Industry». Sensors 21(17): 5739. doi:10.3390/s21175739.

Davari, Narjes, Bruno Veloso, Rita P. Ribeiro, Pedro Mota Pereira, e João Gama. 2021. «Predictive maintenance based on anomaly detection using deep learning for air production unit in the railway industry». In 2021 IEEE 8th International Conference on Data Science and Advanced Analytics (DSAA), , 1–10. doi:10.1109/DSAA53316.2021.9564181.

Davari, Narjes, Bruno Veloso, Rita Paula Ribeiro, e Joao Manuel Portela Da Gama. 2024. «Detecting and Explaining Anomalies in the Air Production Unit of a Train». In Proceedings of the 39th ACM/SIGAPP Symposium on Applied Computing, SAC ’24, New York, NY, USA: Association for Computing Machinery, 358–64. doi:10.1145/3605098.3635906.

IBM. 2023. «Cos’è l’analisi delle componenti principali (PCA)?» https://www.ibm.com/it-it/think/topics/principal-component-analysis.

IBM. 2025. «Nodo t-SNE». https://www.ibm.com/docs/it/spss-modeler/18.5.0?topic=nodes-t-sne-node.

Jolliffe, Ian T., e Jorge Cadima. 2016. «Principal component analysis: a review and recent developments». Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences 374(2065): 20150202. doi:10.1098/rsta.2015.0202.

Keras. 2023. «Keras Documentation: Layer Weight Regularizers». https://keras.io/api/layers/regularizers/.

Kucher, Kostiantyn, Elmira Zohrevandi, e Carl A. L. Westin. 2025. «Towards Visual Analytics for Explainable AI in Industrial Applications». Analytics 4(1): 7. doi:10.3390/analytics4010007.

Lundberg, Scott M, e Su-In Lee. 2017. «A Unified Approach to Interpreting Model Predictions». In Advances in Neural Information Processing Systems, Curran Associates, Inc. https://proceedings.neurips.cc/paper/2017/hash/8a20a8621978632d76c43dfd28b67767-Abstract.html (25 maggio 2025).

van der Maaten, L., e G. Hinton. 2008. «Visualizing Data using t-SNE». Visualizing Data using t-SNE 9.

Molnar, Christoph. 2025. Interpretable Machine Learning. https://christophm.github.io/interpretable-ml-book/global.html.

Ng, A. 2017. «Sparse autoencoder». In CS294A Lecture notes, Stanford University.

Ribeiro, Marco Tulio, Sameer Singh, e Carlos Guestrin. 2016. «“Why Should I Trust You?”: Explaining the Predictions of Any Classifier». doi:10.48550/arXiv.1602.04938.

Semanjski, Ivana Cavar. 2023. «Chapter 5 – Data analytics». In Smart Urban Mobility, a c. di Ivana Cavar Semanjski. Elsevier, 121–70. doi:10.1016/B978-0-12-820717-8.00008-7.

Shapley, L. S. 1953. «A Value for n-Person Games». In Contributions to the Theory of Games (AM-28), Volume II, a c. di Harold William Kuhn e Albert William Tucker. Princeton University Press, 307–18. doi:10.1515/9781400881970-018.

Veloso, Bruno, João Gama, Rita P. Ribeiro, e Pedro M. Pereira. 2022. «A Benchmark dataset for predictive maintenance». doi:10.48550/arXiv.2207.05466.

Veloso, Bruno, Rita P. Ribeiro, João Gama, e Pedro Mota Pereira. 2022. «The MetroPT Dataset for Predictive Maintenance». Scientific Data 9(1): 764. doi:10.1038/s41597-022-01877-3.

Riccardo Gentilucci, Ministero delle Infrastrutture e dei Trasporti – Ufficio di Coordinamento del Dipartimento per le Infrastrutture e le Reti di Trasporto, Via Nomentana 2, 00161 Rome – Italia. Email: riccardo.gentilucci@mit.gov.it; riccardo.gentilucci@uniroma1.it ↑