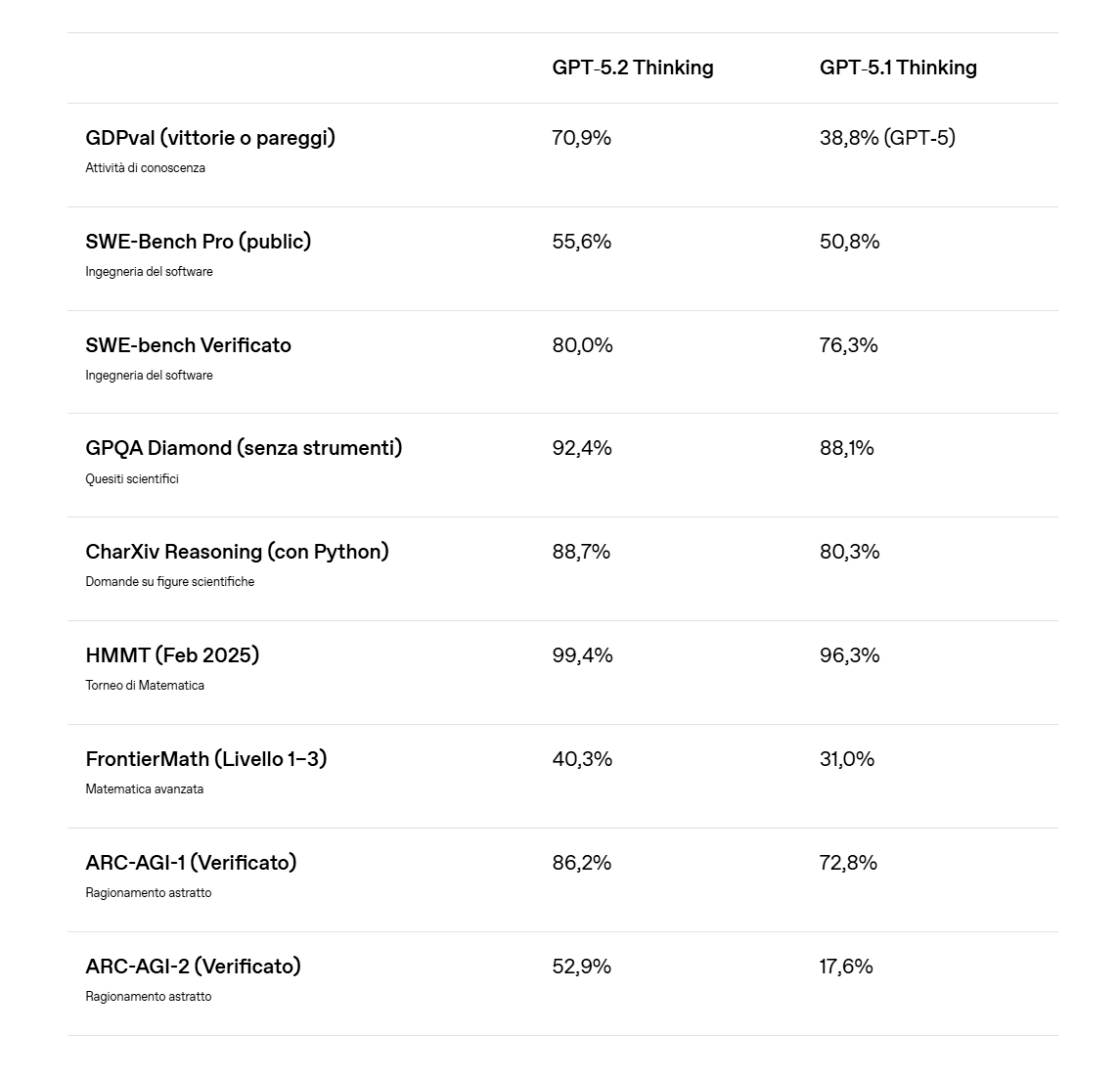

In queste ore si parla molto del rilascio di GPT-5.2 e dei suoi benchmark: dei record su AIME, dei miglioramenti su SWE-Bench Pro e dei grafici che mostrano nuove soglie raggiunte o superate.

Quando si citano AIME e SWE-Bench Pro si fa riferimento a due classi di benchmark molto diverse, pensate per valutare capacità distinte dei modelli di AI.

Indice degli argomenti

AIME e SWE-Bench Pro: record sì, ma cosa misurano

AIME e SWE-Bench Pro sono spesso citati insieme, ma misurano competenze diverse e, soprattutto, rispondono a esigenze differenti.

Nel dibattito sui modelli, distinguere con precisione cosa valutano questi test è utile per non confondere ragionamento astratto, prestazioni su compiti “chiusi” e capacità operative in scenari industriali.

AIME e il ragionamento matematico “closed-book”

AIME (American Invitational Mathematics Examination) deriva da un test matematico competitivo utilizzato negli Stati Uniti per selezionare studenti ad alto livello.

Nel contesto dell’intelligenza artificiale viene impiegato per misurare la capacità di risolvere problemi matematici complessi che richiedono ragionamento astratto, algebra, teoria dei numeri e combinatoria, in modalità di closed-book reasoning, quindi senza accesso a dati esterni o esempi pregressi.

Per questo è un indicatore utile quando si vuole capire quanto un modello regga su problemi “puliti”, dove la difficoltà sta nella catena logica più che nel recupero di informazioni.

SWE-Bench Pro e i task realistici di software engineering

SWE-Bench Pro è invece un benchmark specifico per il software engineering e per i coding agents: va ben oltre i classici esercizi di programmazione.

Propone task realistici tratti da repository reali e richiede la generazione di patch che risolvano bug o implementino modifiche su codebase multi-file, validate tramite test automatici.

È stato progettato per essere più rigoroso e rilevante per scenari industriali reali rispetto ai benchmark tradizionali di coding, perché misura non solo la “scrittura di codice”, ma la capacità di intervenire su sistemi esistenti con vincoli, dipendenze e verifiche automatiche.

Il costo del ragionamento cambia, ecco la notizia di GPT-5.2

Tutto questo è senza dubbio interessante e corretto, ma non è qui che si trova il punto davvero rilevante di questo aggiornamento.

La notizia centrale non è un valore percentuale più alto di un altro, bensì un numero molto semplice: 11,64 dollari.

Si tratta del costo per task con cui GPT-5.2 Pro raggiunge il 90,5% di accuratezza su ARC-AGI-1, uno dei benchmark più significativi mai progettati per misurare il ragionamento astratto.

ARC-AGI-1: perché il costo del ragionamento conta più dell’accuratezza

ARC-AGI-1 (Abstraction and Reasoning Corpus for Artificial General Intelligence) è stato introdotto nel 2019 da François Chollet con un obiettivo molto preciso: verificare se un sistema artificiale è in grado di generalizzare davvero, andando oltre la memorizzazione o il riconoscimento di pattern visti in addestramento.

Il punto, qui, non è solo arrivare a un’alta accuratezza, ma capire cosa significa raggiungerla e con quale costo del ragionamento.

Puzzle visivi e pochissimi esempi: come funziona ARC-AGI-1

Il benchmark è composto da una collezione di piccoli puzzle visivi basati su griglie colorate.

Per ogni task vengono forniti pochissimi esempi di input e output corretti, spesso solo due o tre, e il modello deve inferire la regola astratta che li lega per applicarla a un nuovo caso mai visto prima.

Non ci sono istruzioni testuali, né contesto esterno, né possibilità di recuperare informazioni dal web: tutto il problema è contenuto negli esempi mostrati.

Perché è “ostile” agli LLM: niente brute force e niente scorciatoie

La caratteristica chiave di ARC-AGI-1 è che non può essere risolto efficacemente tramite brute force, statistiche o semplice pattern matching.

Ogni puzzle è unico, non ricorre online e non segue distribuzioni regolari.

Per questo motivo è stato a lungo considerato un test “ostile” agli LLM tradizionali e un riferimento utile per una domanda cruciale: un sistema artificiale riesce a costruire una rappresentazione astratta di un problema nuovo e a trasferirla correttamente, oppure sta semplicemente riconoscendo schemi già visti?

Umani vs modelli: la soglia che cambia la discussione

Per anni, i modelli basati su scaling puro hanno ottenuto risultati prossimi allo zero, mentre gli esseri umani risolvono circa il 95% dei task senza addestramento specifico.

ARC-AGI-1 è diventato così un benchmark di riferimento per misurare la generalizzazione, proprio perché forza il sistema a inferire regole con pochissimi esempi e senza appoggi esterni.

Per molto tempo, la comunità di ricerca ha considerato ARC-AGI la dimostrazione che la sola crescita di scala non sarebbe stata sufficiente a raggiungere capacità di ragionamento di livello umano.

Da migliaia a 11,64 dollari: il costo del ragionamento crolla

A dicembre 2024 quella soglia è stata superata per la prima volta, ma a costi estremamente elevati, tali da rendere il risultato poco più che una dimostrazione teorica.

Undici mesi dopo, senza dover nemmeno aspettare un intero anno, quel limite non solo è stato ulteriormente superato, ma è diventato economicamente accessibile.

Quasi dodici mesi fa, risultati comparabili richiedevano costi dell’ordine di migliaia di dollari per singolo task, con stime comprese tra 3.000 e 30.000 dollari a seconda della configurazione di calcolo.

Oggi, lo stesso livello di prestazioni costa poco più di undici dollari.

390 volte in dodici mesi: l’efficienza come nuova metrica

Questo equivale a un miglioramento di circa 390 volte sull’efficienza in dodici mesi.

Ed è qui che, oggi, il discorso cambia davvero: non il 90,5% di accuratezza, ma il costo con cui quell’accuratezza viene raggiunta.

Quando il prezzo del ragionamento artificiale crolla di quasi quattrocento volte in un anno, l’idea che l’AI sia “troppo costosa” smette di essere un vincolo tecnologico e diventa una scelta strategica.

A questi livelli di costo, il confronto con il lavoro umano sul ragionamento on-demand non è più astratto, ma concreto.

Dalla performance alla strategia: cosa abilita il costo del ragionamento

Potremmo pensare che, da questo punto in avanti, la competizione non si giochi più principalmente su chi riesce a risolvere un problema, perché la capacità di farlo sta rapidamente diventando una commodity.

La vera competizione si sposta sull’efficienza, sull’integrazione e sulla capacità di progettare sistemi e prodotti che siano in grado di sfruttare il ragionamento artificiale a costi marginali sempre più bassi.

Anche il contesto competitivo lo conferma: il rilascio di GPT-5.2 avviene in un mercato in cui più attori stanno convergendo sugli stessi livelli di performance, accelerando ulteriormente la compressione dei costi.

ARC-AGI-2 e le sfide rimaste: oltre il costo

Guardando oltre, ARC-AGI-2 mostra che esistono ancora sfide aperte e spazi di miglioramento, ma il punto è chiaro: il divario che resta non appare più come un limite concettuale, bensì come un problema di ottimizzazione.

Per chi costruisce prodotti e prende decisioni oggi, questo significa una cosa molto semplice e molto interessante: il ragionamento artificiale non è più un lusso né qualcosa che si avvicina a una demo avanzata, ma una capacità sempre più accessibile, su cui è possibile costruire valore reale.

Il benchmark nato per dimostrare i limiti dell’AI è diventato, di fatto, una voce di costo sempre più prevedibile, ed è da questa trasformazione, più che dai record di accuratezza, che vale la pena ripartire per immaginare cosa viene dopo.