L’arrivo di LLaMA 4, la nuova generazione di modelli linguistici di Meta, segna un passaggio chiave nell’evoluzione dell’intelligenza artificiale generativa per le imprese. Dopo aver analizzato le potenzialità di LLaMA 4 per le aziende italiane, proponiamo un confronto diretto con ChatGPT di OpenAI, la piattaforma più nota del settore.

Il focus è preciso: confrontare le API a disposizione degli sviluppatori, esaminando punto per punto gli aspetti tecnici e funzionali delle due soluzioni. L’obiettivo è aiutare a scegliere consapevolmente tra due approcci molto diversi all’AI generativa, entrambi oggi centrali sul mercato.

L’analisi considera otto aspetti chiave:

- modalità di accesso (cloud vs on-premise, API aperte vs chiuse)

- costi e licenze

- possibilità di personalizzazione (fine-tuning e RAG)

- supporto multimodale

- lunghezza del contesto

- privacy e controllo dei dati

- prestazioni (token generati al secondo)

- scalabilità.

Questa guida comparativa, aggiornata e affidabile, è pensata per professionisti IT, sviluppatori e decision maker aziendali che vogliono valutare quale piattaforma risponda meglio alle proprie esigenze, non solo in termini di potenza, ma anche per quanto riguarda governance, efficienza, costi e flessibilità.

Indice degli argomenti

Modalità di accesso: cloud vs on-premise, API aperte vs chiuse

Il primo confronto riguarda la disponibilità e la filosofia d’uso delle API: LLaMA 4 si distingue per l’approccio open-weight e flessibile, anche on-premise. ChatGPT è invece interamente cloud-based, con benefici di semplicità ma meno controllo.

LLaMA 4

LLaMA 4 segue la filosofia open-weight già adottata da Meta nei modelli precedenti: i pesi sono pubblici, consentendo a sviluppatori e aziende di utilizzare il modello liberamente. Può essere eseguito localmente (on-premise) su infrastrutture private o su servizi cloud di terze parti.

Per la prima volta, Meta ha introdotto anche un’API ufficiale, annunciata alla LlamaCon 2025, inizialmente disponibile per pochi partner ma destinata a un’apertura progressiva.

L’ecosistema di Meta è particolarmente flessibile: grazie a partnership con fornitori hardware come Cerebras e Groq, e a un SDK dedicato, gli utenti possono scegliere se usare GPU tradizionali o hardware alternativo. LLaMA 4 è già disponibile su Amazon Bedrock (AWS) e Azure AI Foundry, offrendo opzioni cloud completamente gestite.

Tuttavia, il vero vantaggio è la possibilità di eseguire il modello in locale, mantenendo il pieno controllo dei dati. Meta propone così un sistema modulare: on-premise, ibrido o as-a-service.

ChatGPT

OpenAI adotta una logica opposta. I suoi modelli, tra cui GPT-3.5 e GPT-4o (modello multimodale lanciato ad aprile 2024), sono chiusi e proprietari: non è possibile accedere ai pesi né eseguire i modelli localmente. L’unico modo per utilizzarli è tramite API cloud offerte da OpenAI o dal servizio Azure OpenAI.

Esistono piani avanzati come ChatGPT Enterprise, con istanze dedicate, SLA elevati e sicurezza rafforzata, ma l’intero sistema resta centralizzato: i modelli non sono scaricabili né modificabili. In cambio, OpenAI garantisce gestione semplificata e scalabilità automatica, ma con evidenti limiti di controllo e autonomia.

Il risultato è chiaro: ChatGPT privilegia la semplicità d’uso, ma impone un lock-in tecnologico, mentre LLaMA 4 offre maggiore flessibilità e libertà infrastrutturale.

Costi e licenze

Meta punta su un modello aperto e gratuito, con vantaggi economici per le aziende. OpenAI adotta invece una logica commerciale centralizzata, con modelli accessibili solo tramite API a pagamento e con limiti sulla portabilità.

LLaMA 4

LLaMA 4 è un modello open-weight distribuito gratuitamente con una licenza commerciale aperta. L’unica eccezione riguarda le grandi piattaforme con oltre 700 milioni di utenti mensili, che devono stipulare accordi specifici. Le aziende possono eseguire il modello localmente, sostenendo solo i costi hardware e operativi, oppure utilizzare l’API ufficiale, attualmente in fase di rollout. Partner come GroqCloud offrono tariffe competitive per l’accesso al modello. Un ulteriore vantaggio è la portabilità del fine-tuning: i modelli personalizzati restano di proprietà dell’utente e possono essere esportati e utilizzati liberamente, senza costi aggiuntivi né vincoli.

ChatGPT

I modelli di OpenAI, come GPT-4o, sono chiusi e accessibili esclusivamente tramite API cloud. GPT-4o è un modello multimodale che offre maggiore velocità ed efficienza rispetto ai predecessori. OpenAI offre anche GPT-3.5 come alternativa più economica, sebbene con prestazioni inferiori. Il piano ChatGPT Enterprise fornisce servizi dedicati con SLA e sicurezza avanzata, ma i modelli rimangono ospitati sulla piattaforma OpenAI e non sono esportabili. OpenAI garantisce che i dati delle API non vengono utilizzati per l’addestramento senza consenso esplicito, ma l’intero sistema resta chiuso e centralizzato.

Personalizzazione: Fine-Tuning e Retrieval-Augmented Generation (RAG)

LLaMA 4 consente un alto grado di personalizzazione grazie all’accesso ai pesi e alla compatibilità con sistemi RAG. OpenAI permette tuning e retrieval, ma all’interno di un’infrastruttura chiusa, riducendo l’autonomia degli utenti.

LLaMA 4

Meta ha progettato LLaMA 4 per offrire massima flessibilità nella personalizzazione, supportando sia il fine-tuning sia l’approccio RAG (Retrieval-Augmented Generation).

Fine-Tuning

Grazie alla natura open-weight, le aziende possono scaricare i pesi del modello ed eseguire il fine-tuning su infrastrutture locali, utilizzando framework consolidati come PyTorch o TensorFlow.

Meta ha anche introdotto un’API per effettuare il fine-tuning in cloud, inizialmente rivolta ai modelli più piccoli, ma con l’intenzione di estenderla a quelli di dimensioni maggiori come LLaMA 4.

Un elemento distintivo è la portabilità: i modelli personalizzati possono essere esportati, eseguiti on-premise o nel cloud, senza vincoli tecnici o commerciali. Inoltre, Meta garantisce che i dati impiegati nel fine-tuning non verranno usati per l’addestramento dei modelli pubblici, assicurando pieno controllo e tutela della proprietà intellettuale.

Retrieval-Augmented Generation (RAG)

LLaMA 4 si adatta molto bene a sistemi RAG, in cui le informazioni vengono recuperate dinamicamente da basi di conoscenza esterne e fornite al modello come contesto, mantenendolo generico ma informato.

L’API non include nativamente un sistema RAG, ma proprio questa separazione consente alle aziende di progettare pipeline su misura, mantenendo il pieno controllo sui dati, sulla logica di retrieval e sulle fonti documentali.

GPT-4o

Anche OpenAI ha ampliato le funzionalità di personalizzazione dei suoi modelli, supportando sia il fine-tuning sia l’integrazione in architetture RAG attraverso strumenti esterni.

Fine-Tuning

È possibile eseguire il fine-tuning su GPT-4o e GPT-4o mini, ma l’intero processo avviene sui server OpenAI, e i modelli risultanti non sono esportabili. Restano quindi all’interno dell’infrastruttura proprietaria, limitando la portabilità e incrementando il rischio di lock-in.

Retrieval-Augmented Generation (RAG)

OpenAI supporta l’integrazione in pipeline RAG attraverso librerie come LangChain e LlamaIndex, che facilitano l’interfacciamento con basi di conoscenza esterne.

L’API consente anche il function calling, permettendo al modello di invocare funzioni definite dall’utente, come una ricerca documentale. Tuttavia, l’implementazione del retrieval e la gestione dei documenti restano responsabilità dello sviluppatore, e non sono nativamente integrate.

Supporto multimodale: LLaMA 4 vs GPT-4o

LLaMA 4 e GPT-4o offrono supporto multimodale, ma con approcci distinti: Meta integra testo e immagini in modo open e scalabile, mentre OpenAI estende le funzionalità anche ad audio e generazione immagini, ma solo tramite cloud.

LLaMA 4

Meta ha sviluppato LLaMA 4 come modello nativamente multimodale, in grado di elaborare testo e immagini all’interno di un contesto unificato. Utilizza la tecnica dell’Early Fusion, che integra token testuali e visivi nello stesso backbone, migliorando la comprensione congiunta degli input.

Questa architettura consente al modello di svolgere compiti come visual question answering, descrizione di immagini e analisi di contenuti visivi complessi.

Una versione avanzata, LLaMA 4 Maverick, è ottimizzata per la comprensione delle immagini e supporta 12 lingue, rendendola ideale per applicazioni come assistenti virtuali capaci di analizzare screenshot o documenti scansionati.

Attualmente, LLaMA 4 non gestisce nativamente audio o video, ma la sua struttura open-weight consente di integrarlo con pipeline esterne per estendere le capacità multimodali.

GPT-4o

GPT-4o (“omni”) è il modello multimodale più avanzato di OpenAI, in grado di elaborare e generare testo, immagini e audio in tempo reale. Addestrato end-to-end su dati testuali, visivi e sonori, permette un’interazione fluida tra le diverse modalità.

Disponibile tramite l’API OpenAI, GPT-4o consente lo sviluppo di applicazioni complesse come assistenti vocali, interfacce visive o sistemi multimediali interattivi.

OpenAI ha inoltre integrato funzionalità di generazione di immagini direttamente all’interno di GPT-4o, offrendo un’alternativa ai modelli di diffusione come DALL·E, con un’esperienza più immediata e integrata.

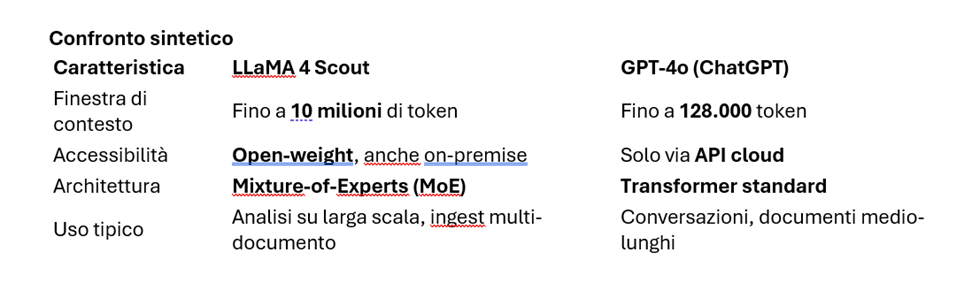

Dimensione del contesto: LLaMA 4 vs GPT-4o

La dimensione del contesto indica quanti token (parole o frammenti) un modello può gestire in una singola richiesta. Un contesto ampio consente di analizzare documenti lunghi, conversazioni articolate o codebase estese senza frammentazioni.

LLaMA 4

Con la variante LLaMA 4 Scout, Meta ha stabilito un nuovo record: finestra di contesto fino a 10 milioni di token. Una scala senza precedenti nel settore, che permette – almeno teoricamente – di processare l’equivalente di decine di libri o l’intero archivio documentale di un’azienda in un’unica richiesta.

Questa capacità è resa possibile dall’uso dell’architettura Mixture-of-Experts (MoE) e da ottimizzazioni che riducono il costo per token. Scout può funzionare anche su una singola GPU NVIDIA H100, rendendolo accessibile anche al di fuori di infrastrutture supercomputazionali.

Applicazioni tipiche includono:

- analisi di trascrizioni di riunioni,

- lettura integrale di documentazione aziendale,

- analisi contrattuali complesse,

- elaborazione di intere codebase software.

Non tutte le varianti di LLaMA 4 offrono questa capacità: Maverick, ad esempio, è ottimizzato per compiti visivi. Ma Scout rappresenta oggi il riferimento per i contesti ultra-estesi.

GPT-4o

Con il lancio di GPT-4o nel maggio 2024, OpenAI ha portato la finestra di contesto a 128.000 token, circa 200 pagine di testo. Si tratta di un netto miglioramento rispetto ai 32K token delle versioni precedenti di GPT-4, che consente l’elaborazione di documenti articolati e conversazioni complesse.

Tuttavia:

- il contesto resta circa 80 volte inferiore rispetto a LLaMA 4 Scout,

- l’uso di contesti estesi comporta costi e latenze maggiori,

- GPT-4o è accessibile solo via API cloud (OpenAI o Azure),

- l’architettura resta quella Transformer standard, senza MoE.

Privacy e controllo dei dati: LLaMA 4 vs GPT-4o

Il controllo sui dati è un nodo cruciale: LLaMA 4 consente esecuzione locale e ispezione del modello, mentre GPT-4o si affida a cloud esterni, garantendo privacy contrattuale ma senza accesso interno ai modelli.

LLaMA 4

Uno dei principali punti di forza di LLaMA 4 è la possibilità di eseguire il modello localmente, grazie alla distribuzione open-weight. Questo consente alle aziende di mantenere i dati sensibili all’interno dei propri sistemi, evitando di trasmetterli a terze parti. È un vantaggio cruciale per settori regolamentati come sanità, finanza, pubblica amministrazione o difesa, dove la riservatezza è un requisito legale e operativo.

Anche scegliendo la LLaMA API in cloud, Meta assicura che i dati non vengano usati per addestrare i modelli generali, salvo consenso esplicito – in linea con le migliori pratiche già adottate da OpenAI per i clienti Enterprise.

Un ulteriore punto di forza è la portabilità dei modelli personalizzati: è possibile effettuare il fine-tuning nel cloud di Meta e poi scaricare il modello custom per eseguirlo localmente, eliminando la dipendenza dal cloud e riducendo il rischio di lock-in.

LLaMA 4 offre anche ampia auditabilità: essendo open-weight, gli sviluppatori possono analizzare il comportamento del modello, modificare i filtri, rafforzare (o allentare) le mitigazioni di sicurezza in base alle proprie esigenze.

Meta fornisce strumenti di protezione a livello di modello e API, ma lascia agli utenti pieno controllo sulle impostazioni.

Inoltre, l’apertura del codice favorisce la trasparenza: aziende, ricercatori e sviluppatori possono contribuire attivamente al miglioramento del modello, segnalare vulnerabilità o proporre ottimizzazioni.

Dal punto di vista normativo, LLaMA 4 può essere eseguito su server localizzati in Europa, facilitando la conformità al GDPR e ad altre normative sulla protezione dei dati.

In sintesi, LLaMA 4 è oggi tra le soluzioni più solide per chi cerca sovranità tecnologica, privacy totale e pieno controllo sul comportamento del modello.

GPT-4o

OpenAI ha rafforzato le proprie garanzie sulla privacy: dal 2023, i dati trasmessi tramite API non vengono utilizzati per l’addestramento, salvo consenso esplicito. Nel piano ChatGPT Enterprise, ciò è anche garantito contrattualmente: le conversazioni non vengono registrate né usate per migliorare il modello.

OpenAI ha ottenuto certificazioni di sicurezza come SOC 2 Type II e offre funzionalità avanzate di isolamento dei dati, tra cui il deployment su infrastrutture dedicate (es. Azure Virtual Network isolate). Tuttavia, anche in questi casi si tratta sempre di cloud esterni: i dati devono comunque transitare sui server OpenAI o Microsoft, senza possibilità di esecuzione locale.

Essendo un modello chiuso, GPT-4o non consente ispezione né modifica del comportamento interno. I filtri di moderazione e la logica delle risposte non sono accessibili. Le uniche forme di personalizzazione disponibili sono prompt strutturati o system message, ma restano superficiali rispetto alle esigenze di trasparenza richieste in contesti regolamentati.

In sostanza, ChatGPT offre forti garanzie contrattuali, ma resta una soluzione basata sulla fiducia: l’utente deve accettare che il modello sia una “black box” gestita da terzi.

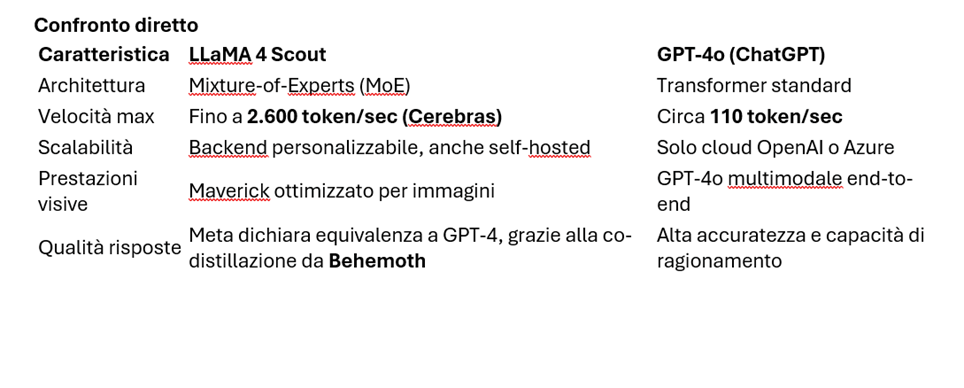

Prestazioni e scalabilità: LLaMA 4 vs GPT-4o

Con architetture innovative e hardware dedicato, LLaMA 4 raggiunge velocità elevate e scalabilità modulare. OpenAI migliora le performance con GPT-4o, ma mantiene un’infrastruttura chiusa e centralizzata.

LLaMA 4

I modelli LLaMA 4 sono progettati per offrire alte prestazioni ed efficienza, grazie all’architettura Mixture-of-Experts (MoE), che attiva solo una parte dei parametri per ogni token elaborato, riducendo il carico computazionale.

- LLaMA 4 Scout: 17 miliardi di parametri attivi su 109 miliardi totali (16 esperti). Può essere eseguito su una singola GPU NVIDIA H100 grazie alla quantizzazione INT4.

- LLaMA 4 Maverick: dispone di 128 esperti e 400 miliardi di parametri totali, ma mantiene attivi solo 17 miliardi per token, bilanciando ampiezza e efficienza.

Accelerazione con Cerebras e Groq

Meta ha stretto partnership con fornitori hardware innovativi per aumentare la velocità di generazione:

- Cerebras (Wafer-Scale Engine): oltre 2.600 token/secondo con LLaMA 4 Scout, superando di gran lunga i modelli concorrenti.

- Groq: su GroqCloud, Scout raggiunge oltre 460 token/secondo, offrendo una soluzione scalabile ed economica per applicazioni ad alto throughput.

Grazie al proprio SDK, Meta consente agli sviluppatori di scegliere il backend più adatto, offrendo modularità e flessibilità infrastrutturale.

ChatGPT / GPT-4o

OpenAI ha migliorato le prestazioni dei suoi modelli attraverso versioni sempre più ottimizzate:

- GPT-4: velocità media di generazione ~27 token/secondo.

- GPT-4 Turbo: miglioramenti in velocità e costi rispetto a GPT-4 standard.

- GPT-4o (maggio 2024): 2x più veloce e 50% più economico di GPT-4 Turbo, con velocità intorno a 110 token/secondo.

OpenAI utilizza principalmente GPU NVIDIA per l’inferenza, ma sta sperimentando anche hardware dedicato per ulteriori ottimizzazioni. Tuttavia, l’infrastruttura resta gestita centralmente e non modificabile dagli utenti.

Conclusioni

LLaMA 4 è ideale per applicazioni che richiedono velocità elevate, scalabilità modulare e controllo completo sull’infrastruttura.

GPT-4o è adatto a chi cerca un modello performante e pronto all’uso, pur con minori possibilità di personalizzazione.

La scelta dipende dalle esigenze specifiche: tempo di risposta, tipo di hardware disponibile, controllo richiesto, e accuratezza necessaria.

Sitografia

https://ai.meta.com/blog/llama-4-multimodal-intelligence/

https://ai.meta.com/blog/llamacon-llama-news/