L’omicidio di Charlie Kirk presso la Utah Valley University ha catalizzato l’attenzione dei media internazionali per la gravità dell’atto, ma anche per la singolare quantità di video e immagini che hanno documentato la sequenza dei fatti. Le telecamere del campus, quelle di abitazioni private vicine e i filmati girati da studenti hanno permesso una ricostruzione quasi in tempo reale: l’arrivo del sospettato, il cambio d’abiti, la salita sul tetto, lo sparo, la fuga improvvisata.

scenario

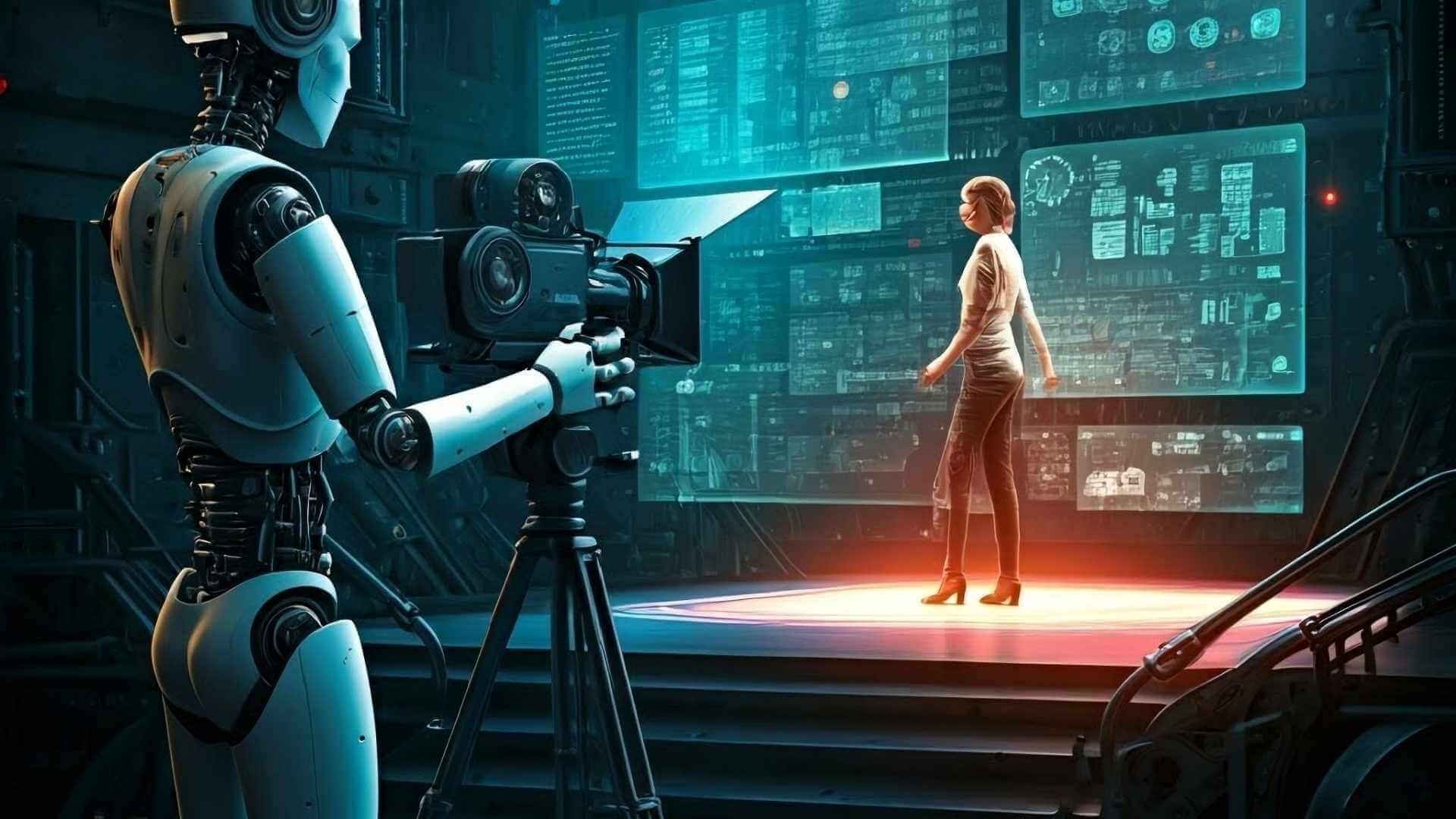

Biometria comportamentale, quanto è affidabile e quali sono i rischi

L’omicidio dell’influencer Maga Charlie Kirk porta a riflettere sull’affidabilità dei sistemi basati su biometria comportamentale: ecco quali sono, i rischi connessi e cosa prevedono le normative europee

Privacy Officer e Consulente Privacy Tuv Italia

Continua a leggere questo articolo

Argomenti

Canali

Con o Senza – Galaxy AI per il business