Quando nel 2019 GPT-2 completava task autonomi in 4 secondi, sembrava fantascienza. Oggi, a febbraio 2026, Kimi K2 impiega 5 ore per portare a termine autonomamente lavori che richiederebbero giorni a un essere umano. Non stiamo parlando di chiacchierate più fluide o risposte più precise. Stiamo parlando di una crescita della capacità operativa di 1.667x ogni anno.

Ho analizzato i dati empirici di benchmark indipendenti (METR, LLM Latency Benchmark, Artificial Analysis) e documentazione tecnica dei principali provider. I numeri sono chiari, brutali, inesorabili. E raccontano una storia che la Pubblica Amministrazione italiana non può più permettersi di ignorare.

Indice degli argomenti

Adozione dell’AI nella pubblica amministrazione italiana: perché ora

Partiamo dai fatti. Non dalle promesse dei vendor, non dalle presentazioni dei convegni. I fatti misurabili.

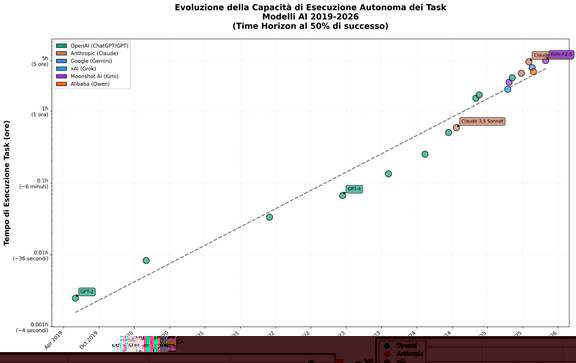

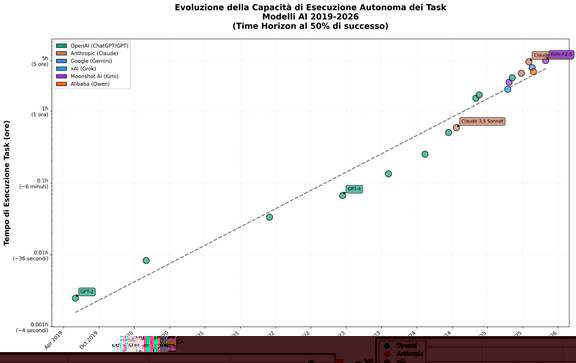

Figura 1 – Evoluzione della capacità di esecuzione autonoma dei task nei modelli AI (2019-2026). Il “Time Horizon” misura il tempo medio per completare un task con 50% di probabilità di successo autonomo. Fonte: METR Benchmark, elaborazione propria.

Capacità di esecuzione autonoma

Nel 2019 GPT-2 completava micro-task da pochi secondi. Nel 2023 GPT-4 arriva a 6 minuti (90 volte di più). Nel 2024 Claude 3.5 Sonnet raggiunge i 42 minuti (7 volte di più). Nel 2026 Kimi K2 tocca le 5 ore (altre 7 volte). È una progressione geometrica, non aritmetica. E il trend è chiaro: stiamo passando da task elementari a lavoro cognitivo complesso che richiede ore di concentrazione umana.

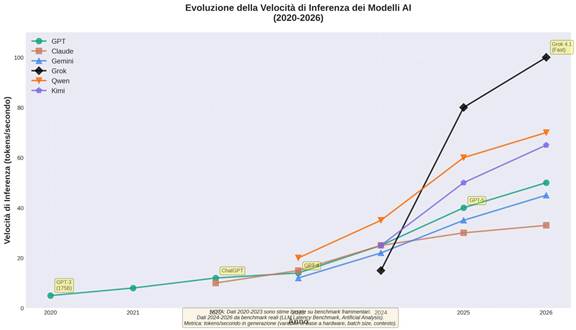

Figura 2 – Evoluzione della velocità di inferenza dei modelli AI (2020-2026). La metrica misura i token generati al secondo. La crescita è di circa 67% annuo, con accelerazione negli ultimi due anni. Fonte: LLM Latency Benchmark, Artificial Analysis.

Velocità inferenziale

Nel 2020 GPT-3 generava 5 token al secondo. Oggi Grok 4.1 Fast arriva a 100 token al secondo. Venti volte più veloce in sei anni, con un tasso di crescita del 67% annuo. Non è un miglioramento incrementale. È un cambio di categoria: dalla lentezza percettibile all’istantaneità. E questo cambia completamente il tipo di applicazioni possibili.

Figura 3 – Evoluzione del Context Length nei modelli AI per provider (2020-2026). Si nota la crescita esponenziale da 2K a 2M token (1000x) e la divergenza strategica tra provider generalisti e specialisti long-context. Fonte: documentazione tecnica provider, elaborazione propria.

Context window

Nel 2020 i modelli gestivano 2.000 token (circa una pagina). Oggi arriviamo a 2 milioni di token con Grok 4 Fast. Mille volte di più. Significa passare da “dammi un riassunto” a “analizza l’intero archivio documentale degli ultimi cinque anni e dammi un quadro d’insieme”. È la differenza tra un assistente e un analista senior con memoria perfetta.

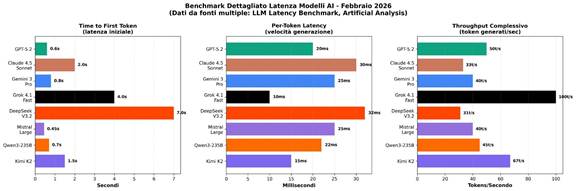

Figura 4 – Benchmark dettagliato della latenza dei principali modelli AI (febbraio 2026). Time to First Token, Per-Token Latency e Throughput complessivo evidenziano le diverse strategie di ottimizzazione dei provider. Fonte: LLM Latency Benchmark, Artificial Analysis.

Latenza

Time to first token: dai 5 secondi del 2020 agli 0,45 secondi di Mistral Large oggi. Le interazioni passano da “aspetto che risponda” a “sembra che stia pensando insieme a me”. Anche qui, non è questione di user experience. È questione di quali processi diventano automatizzabili in tempo reale.

Ma il punto non è solo quanto sono cresciuti questi parametri. Il punto è la velocità con cui stanno crescendo. E soprattutto, cosa significa questa velocità per chi deve prendere decisioni oggi su infrastrutture, competenze, processi che dovranno funzionare domani.

La divergenza strategica che nessuno racconta

C’è un altro dato che emerge dall’analisi: non tutti i provider stanno ottimizzando le stesse metriche. E questo è rivelatore di strategie profondamente diverse.

I modelli “fast” (Grok, Mistral) puntano tutto sulla latenza ultra-bassa e sul throughput massivo. Sono ottimizzati per applicazioni real-time, per sostituire interfacce umane, per essere embedded in processi critici dove il millisecondo conta.

I modelli “quality” (Claude, GPT) cercano il bilanciamento. Non sono i più veloci, ma nemmeno i più lenti. Privilegiano l’affidabilità, la coerenza, la capacità di ragionamento complesso. Sono pensati per lavoro cognitivo di qualità, non per volume.

Gli specialisti long-context (xAI, Google) hanno scommesso sui mega-context da 1-2 milioni di token. Vogliono essere l’infrastruttura per chi deve gestire enormi quantità di informazioni: knowledge base aziendali, archivi storici, documentazione tecnica estesa.

Questa divergenza non è casuale. È il mercato che si segmenta. E le amministrazioni pubbliche dovrebbero chiedersi: su quale segmento stiamo puntando? O meglio: abbiamo capito che esistono questi segmenti?

Gli scenari che ci aspettano (con le probabilità)

Proiettare il futuro è sempre rischioso. Ma quando hai trend esponenziali così consolidati, puoi almeno tracciare scenari con gradi di confidenza differenti.

Scenario 2027 (probabilità: 85%)

Tra un anno, i modelli gestiranno autonomamente task che oggi richiedono 1-2 settimane di lavoro umano. La latenza scenderà sotto il decimo di secondo, rendendo le interazioni indistinguibili da una conversazione umana. Il context window dei modelli generalisti arriverà a 500K token: interi manuali operativi, raccolte normative complete, banche dati progettuali analizzabili in tempo reale.

Per la PA italiana questo significa: automazione completa dei servizi di front-office, assistenti AI capaci di gestire pratiche amministrative complesse dall’inizio alla fine, analisi predittive su dataset gestionali multi-anno. Non è fantascienza. È estrapolazione lineare di trend già consolidati.

Scenario 2029 (probabilità: 60%)

In tre anni, se il ritmo di crescita si mantiene esponenziale, parleremo di task da 6-12 mesi gestiti autonomamente dall’AI. Velocità di ragionamento 10 volte superiori all’umano. Context window da 1-5 milioni di token per i modelli generalisti, 50-100 milioni per gli specialisti.

Tradotto: gestione autonoma di procedimenti amministrativi end-to-end, policy simulation e impact assessment in tempo reale, comprensione contestuale di intere organizzazioni con la loro memoria istituzionale completa. Il “funzionario digitale” non sarà più un concept. Sarà un requisito operativo.

E qui emerge la prima grande domanda scomoda: abbiamo anche solo iniziato a ripensare i processi della PA per un mondo dove questo diventa possibile? O stiamo ancora discutendo se “validare” o no l’uso di ChatGPT per scrivere le email?

Scenario 2031 (probabilità: 30-40%)

A cinque anni, entriamo nel territorio dello speculativo. Ma vale la pena tracciarlo, perché le implicazioni sono sistemiche.

Se i trend proseguono (grande “se”), parleremo di AI con capacità equivalenti a 10-25 anni di esperienza umana specialistica. Velocità di pensiero 100 volte superiori. Context da 500 milioni a 1 miliardo di token. Architetture completamente nuove: sistemi ibridi neural-symbolic, computing neuromorfico, accelerazione quantistica.

Per la PA questo significa: riorganizzazione completa attorno a sistemi cognitivi, servizi pubblici personalizzati e predittivi, necessità di competenze e governance che oggi non esistono nemmeno nei corsi universitari.

La finestra 2025–2027 e la domanda politica finale

Ricapitoliamo. I modelli AI stanno crescendo esponenzialmente su tutte le metriche rilevanti. La velocità di questa crescita non ha precedenti nella storia della tecnologia. Gli scenari futuri, anche quelli conservativi, prefigurano capacità che cambiano radicalmente cosa significa “lavoro cognitivo”.

E la Pubblica Amministrazione italiana cosa fa?

Continua a ragionare come se l’AI fosse “una cosa da esplorare”. Organizza convegni. Fa qualche sperimentazione spot. Aspetta che qualcuno “decida”. Nel frattempo, il gap con chi si sta muovendo seriamente (altri paesi, settore privato, amministrazioni illuminate) si allarga ogni mese.

Ma c’è ancora una finestra. Stretta, ma c’è. Il 2025-2027 è l’ultima occasione per fare scelte strategiche consapevoli invece che rattoppi d’emergenza.

Sovranità e capacità amministrativa: il costo del “subire”

I dati sono sul tavolo. Gli scenari sono tracciati. Le azioni necessarie sono chiare.

La domanda a questo punto non è tecnica. È politica nel senso più nobile del termine: abbiamo la lucidità per vedere cosa sta succedendo? E la volontà per fare le scelte necessarie, anche se scomode, anche se impopolari, anche se vanno contro le inerzie consolidate?

Perché l’alternativa non è “continuare come prima”. L’alternativa è subire passivamente una trasformazione che altri avranno guidato, perdendo sovranità, competenza, capacità di autodeterminazione.

L’AI sta raddoppiando le sue capacità ogni anno. Noi cosa stiamo facendo?