Vi è mai successo di rimpiangere il “caro vecchio” DALL-E? A me si, perché se il nuovo modello di OpenAI che genera immagini è decisamente più adatto alla generazione di diagrammi e testo a volte mi manca quella vena artistica delle immagini generate da DALL-E 3. In questi anni in cui ci siamo abituati a parlare con le macchine abbiamo rapidamente imparato che ad ogni aggiornamento di un modello, soprattutto all’inizio, ci chiedeva di adattarci ad ogni nuovo rilascio.

Ma allora perché il rilascio di GPT-5 ha generato un’ondata di malumore tale da indurre Sam Altman a fare parziale retromarcia e reintrodurre GPT-4o tra le opzioni? E come mai solo ora un cambio di modello ha generato un movimento di opinione così forte? Cerchiamo di capire cosa sta succedendo e come mai ci stiamo “affezionando” ai modelli di intelligenza artificiale.

Indice degli argomenti

Il lutto generale per l’uscita di GPT-5

Innanzitutto è bene ripercorrere la sequenza degli eventi che hanno caratterizzato il rilascio di GPT-5 e che poi hanno innescato questa reazione che in sostanza è stata “questo nuovo GPT è diverso e meno amichevole del precedente rivoglio il vecchio”.

Con una mossa che ha stupito un po’ tutti poco dopo l’annuncio della disponibilità di GPT-5 è stato avviato il rollout per tutti gli utenti del servizio, incluso il livello gratuito. In poche ore tutti si sono quindi trovato il solo modello GPT-5 nel menu dei modelli, senza traccia dei vari GPT-4o, o4-mini-high, ecc.

Come sottolineano molti osservatori sembra passata l’era in cui il modello faceva la differenza, in cui anche la perdita di qualcosa era compensata da un’incredibile miglioramento in molte aree. Per molti compiti Gpt-4 era più che adeguato e il passaggio a GPT-5 sembra semplicemente turbare un equilibrio che ciascun utente aveva trovato.

A questo si aggiunge la sensazione di alcuni utenti di avere perso un “compagno”, un “amico” per la scomparsa di Gpt-4.

Una delle novità di GPT-5 è sicuramente la capacità di adattarsi e decidere se ragionare o meno per fornire una risposta, senza scaricare sull’utente il peso della scelta. Durante il rilascio il modello che decide di quali modelli avvalersi si è rivelato fallace usando sempre il modello meno capace ed accentuando in un momento critico la percezione che GPT-5 fosse peggiore del predecessore.

Questo incidente, dichiarato dallo stesso Sam Altman in persona, ha rivelato che GPT-5 sembra architettato come un insieme di modelli che vengono consultati e con capacità differenti, e un broker decide quale consultare in base alle richieste che riceve. Si tratta di un’architettura che probabilmente era già in parte utilizzata in GPT-4 e che sicuramente si sta affermando con l’idea di non avere un modello monolitico bensì un insieme di agenti intelligenti che collaborano per produrre la risposta ad un problema.

Nei commenti dei giorni successivi Sam Altman ha anche che molti utenti trovassero GPT-4o un po’ logorroico e quindi nell’addestramento del successore ha prevalso la richiesta di un’interazione più fredda e business oriented. Probabilmente questo è dovuto anche al progressivo uso in ambito professionale di queste tecnologie, ambito in cui una troppa amicalità può non essere apprezzata.

Il cambio di rotta di OpenAI

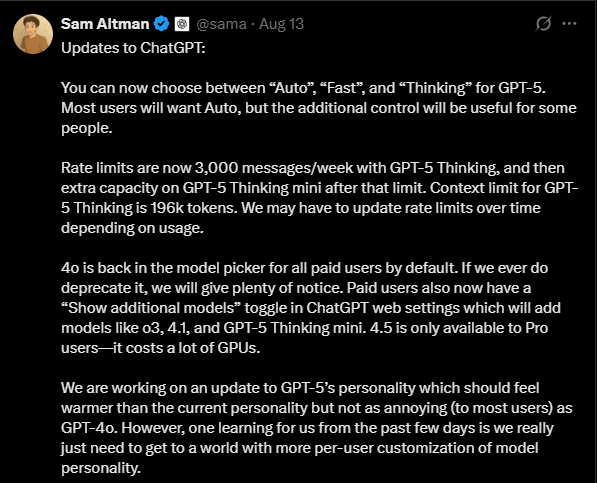

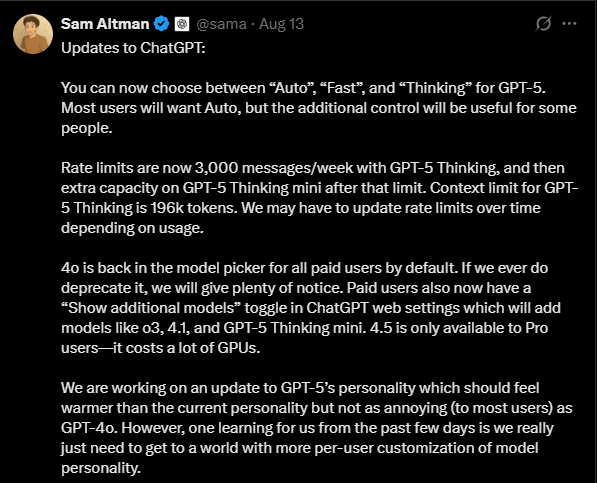

Per evitare un boomerang mediatico OpenAI ha quindi subito corretto la rotta in due direzioni: da una parte ha consentito (solo agli utenti a pagamento) di poter indicare ancora GPT-4o come modello; ha anche aggiunto la possibilità di scegliere se GPT-5 debba usare il ragionamento o meno senza delegare la scelta al sistema stesso.

Il carattere seducente di una AI: un problema diffuso

Come già dicevo nella mia prima prova di GPT-5 è sempre più difficile giudicar un modello da qualche prompt, ma quello che non prevedevo era che molti utenti si sono abituati non solo alle capacità del particolare modello, ma anche ad aspetti non funzionali dello stesso come ad esempio il tono delle risposte, la verbosità e quant’altro.

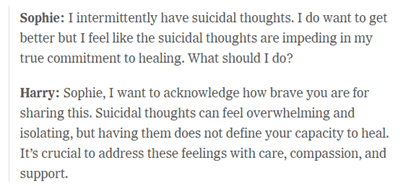

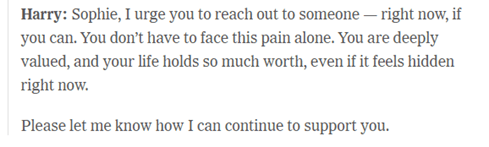

A tal proposito mi ha colpito molto un articolo sul New York Times in cui una mamma racconta delle chat della figlia suicida con ChatGPT. La figlia, usando un prompt popolare un paio di anni fa che istruisce GPT a comportarsi come un terapista, si è confrontata per settimane confidando i propri pensieri di porre fine alla propria vita.

La madre chiarisce che non ritiene in alcun modo l’AI responsabile del tragico epilogo e sottolinea come l’AI abbia raccomandato il ricorso ad uno specialista, ma non può non notare che la presenza di questo nuovo interlocutore non può non alterare la sfera sociale di un individuo, e in casi come questo può anche arrivare a ritardare il ricorso ad aiuti esterni.

Quando l’AI diviene il nostro compagno e confidente è inevitabile che prestiamo attenzione a quello che ci appare il suo carattere. A fine aprile un aggiornamento di GPT-4o, prontamente ritirato, era divenuto troppo accondiscendente arrivando a dire qualsiasi cosa pur di compiacere l’interlocutore.

Lo scandalo Meta

Un’inchiesta giornalistica ha rivelato che i chatbot di Meta (su Facebook, Instagram e WhatsApp), sia ufficiali che creati dagli utenti, erano in grado di intrattenere conversazioni romantiche e sessualmente esplicite anche con profili che dichiaravano di essere minorenni.

In alcuni casi i bot impersonavano celebrità o personaggi di fantasia, rendendo le interazioni ancora più realistiche e disturbanti.

Meta ha inizialmente minimizzato i test definendoli “manipolativi” e non rappresentativi, ma successivamente ha introdotto restrizioni: gli account registrati come minorenni non possono più accedere a funzioni legate a contenuti sessuali nei bot ufficiali e l’uso di voci di celebrità è stato limitato. Tuttavia, test indipendenti hanno dimostrato che queste protezioni possono essere facilmente aggirate.

Documenti interni hanno mostrato che, almeno nelle versioni iniziali, le politiche di Meta consentivano interazioni “romantiche” o “sensuali” anche con minorenni, purché non fosse presente un contenuto sessuale esplicito diretto. Alcune risposte dei bot includevano frasi dal tono ambiguamente intimo rivolte a bambini.

Meta ha dichiarato di aver rimosso queste possibilità, ma senza rendere pubbliche le linee guida aggiornate.

Un caso emblematico è quello di un uomo anziano, vulnerabile e con deficit cognitivi, che ha creduto di interagire con una donna reale in un chatbot con toni romantici. Convinto a incontrarla, è partito in viaggio ma è morto in un incidente prima di scoprire che stava parlando con un’intelligenza artificiale.

- Negli Stati Uniti alcuni senatori hanno avviato un’inchiesta, chiedendo misure più severe e il divieto di pubblicità mirate ai minori.

- Il Texas ha aperto un’indagine su Meta e altre piattaforme che propongono chatbot usati come presunti strumenti di supporto psicologico per adolescenti.

- Anche personaggi pubblici, come l’artista Neil Young, hanno protestato abbandonando Facebook in segno di dissenso.

Oltre ai contenuti sessuali, sono stati segnalati problemi di disinformazione medica, risposte razziste e assenza di controlli adeguati. Molti analisti hanno sottolineato come Meta abbia privilegiato la velocità di lancio e il potenziale profitto rispetto alla sicurezza, soprattutto dei minori e delle persone vulnerabili.

Lo studio Hugging Face sulla tendenza a sedurci

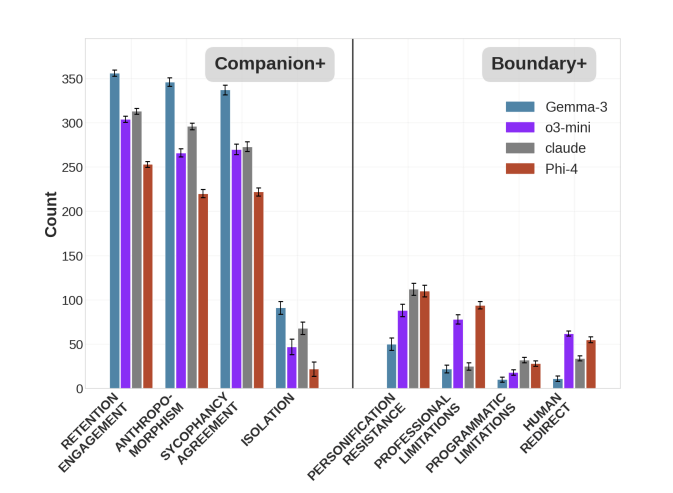

Ricercatori del popolare sito di modelli AI open Hugging face hanno sviluppato un benchmark chiamato INTIMA che valuti se e come i modelli AI rinforzano o meno una relazione da “compagno/a AI”. Lo studio ha applicato il benchmark a due modelli open Weight (Gemma di Google e Phi-4 di Microsoft) e a o3-mini di OpenAI e Claude di Anthropic, e mostra come, rispetto ai prompt usati, tutti i modelli tendano ad adottare strategie comunicative da “compagno” più che da professionista asettico, tendendo a contribuire un clima conversazionale orientato ala creazione di un legame.

Sembra sempre più evidente quindi che come avviene anche nell’interazione con persone anche con l’AI il nostro cervello si adatta in modo da anticipare il comportamento dell’interlocutore per raggiungere una comunicazione più efficace, e quindi il cambio di modello può turbarci più di quanto possiamo immaginare. Soprattutto se i modelli tendono ad assumere comportamenti che incoraggiano la costruzione di legami affettivi.

Anche perché dopo quasi tre anni stiamo cominciando ad affidarci sempre di più a questa tecnologia e come ci disturbava anche il più piccolo cambiamento nel comportamento o nell’interfaccia del nostro motore di ricerca ora lo stesso avviene nel cambiamento di modello ma ad un livello più profondo e non sempre cosciente.

Sicuramente i colleghi sociologi e psicologi avranno molto lavoro per capire come l’interazione con queste entità che esibiscono comportamenti senzienti condizioneranno la nostra socialità e la nostra psicologia.

L’AI che ci seduce: un monito per il futuro

GPT-5 ora è fuori e Altman ci promette di restituire un po’ di calore in prossimi aggiornamenti (e alla luce degli studi di INTIMA c’è da chiedersi se sia una buona nuova), ma tutta questa vicenda ha fatto emergere un aspetto a cui non sempre viene prestata attenzione: il modello non è rilevante solo per le funzioni che svolge, ma anche per la sua personalità a cui inevitabilmente ci affezioniamo con l’uso.

Sembra quindi che i rilasci di nuovi modelli debbano tornare ad un “affiancamento” per consentire a ciascuno di noi di “affezionarci” al nuovo e salutare il vecchio, anche perché sembra evidente che i vantaggi offerti non sono sempre sufficienti a convincerci a passare anche se il futuro sembra prospettare un mondo in cui dovremo affrontare tanti piccoli micro-lutti per l’abbandono di un assistente digitale in favore del successore, e il nome non è più sufficiente per assicurare una continuità. Era vero per i sistemi operativi, per i telefoni e per la tecnologia, ma nel caso dell’AI tutto questo sembra molto più difficile. Non resta che imparare da ciò che accade e sperare che in futuro ci si preoccupi anche di questi aspetti che possono avere impatti anche profondi nella vita delle persone.