Negli ultimi due anni il dibattito pubblico sull’intelligenza artificiale si è polarizzato attorno a una domanda precisa e inquietante: l’AI ruberà il mio lavoro?

L’uso sempre più diffuso di strumenti di AI generativa nel coding, nell’analisi dei dati, nella scrittura e nella progettazione ha rafforzato l’idea di una sostituzione imminente del lavoro umano, soprattutto nelle professioni cosiddette “white collar”.

AI, meno lavoro per tutti (ma più produttivo)? Il punto sugli studi

A fronte di un rapido miglioramento delle prestazioni tecniche dei modelli, i dati sull’occupazione non mostrano un collasso del lavoro qualificato. Anzi, molte professioni considerate “a rischio” continuano a esistere e a trasformarsi, spesso in modo meno visibile ma più profondo.

La domanda giusta, quindi, non è se l’AI farà il lavoro al posto delle persone, ma che cosa intendiamo davvero per “lavoro”. Per provare a rispondere, vale la pena mettere in dialogo alcune analisi recenti che arrivano da ambiti diversi ma finiscono per raccontare una storia sorprendentemente coerente.

Da un lato, esperimenti che misurano cosa accade quando l’AI viene messa alla prova su incarichi di lavoro reali; dall’altro, letture di lungo periodo dei dati sul mercato del lavoro che aiutano a capire come e dove il valore economico si sia progressivamente spostato nel tempo.

Indice degli argomenti

Cosa succede quando l’AI prova a fare un lavoro vero

Il Remote Labor Index[1] nasce dall’esigenza di spostare il dibattito sull’intelligenza artificiale dal piano delle capacità astratte a quello del lavoro concreto. Invece di valutare i modelli su benchmark sintetici o singole abilità, il progetto si chiede cosa accada quando sistemi di AI vengono applicati a incarichi di lavoro reali, così come sono effettivamente definiti, retribuiti e valutati nel mercato del lavoro remoto.

La domanda di fondo è semplice, fino a che punto un sistema di intelligenza artificiale è oggi in grado di portare a termine, in autonomia, un incarico completo dall’inizio alla fine, producendo un risultato che un committente considererebbe accettabile senza ulteriori interventi? Per rispondere, i ricercatori hanno raccolto centinaia di lavori già svolti da professionisti umani su piattaforme di freelancing, utilizzandoli come unità di misura operativa delle capacità dell’AI.

In questo senso, il Remote Labor Index non nasce come una classifica dei modelli né come una previsione sull’occupazione futura, ma come uno strumento per misurare la distanza tra ciò che l’AI sa fare in teoria e ciò che il lavoro reale richiede in pratica. Si testano incarichi completi, presi da piattaforme di lavoro remoto e già pagati a lavoratori umani.

Parliamo di attività come la progettazione grafica, la creazione di dashboard interattive, lo sviluppo di videogiochi web, la modellazione e animazione 3D di prodotti o la formattazione di articoli accademici.

Gli stessi incarichi vengono assegnati a diversi sistemi di AI senza supporto umano, senza iterazioni guidate e senza strumenti aggiuntivi rispetto a quelli nativamente disponibili. In questo contesto, l’unità di misura non è l’“intelligenza” astratta del modello, ma la sua sostituibilità operativa rispetto al lavoro umano. Questo studio non dice cosa accadrà domani, ma cosa non accade oggi, anche con modelli di frontiera.

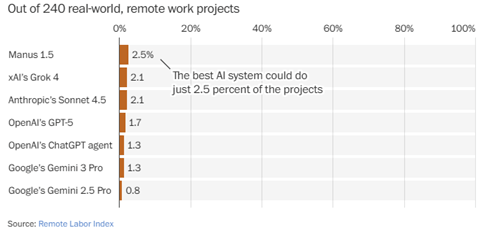

Come lavora l’AI: il dato che ribalta la narrativa: il 2,5%

Il risultato centrale è netto. Il miglior sistema di AI riesce a completare con successo solo una piccola frazione degli incarichi testati. Vale la pena soffermarsi su un dettaglio spesso trascurato. Lo studio non mette alla prova prototipi marginali o sistemi sperimentali, ma modelli di intelligenza artificiale considerati, al momento dei test, tra i più avanzati disponibili sul mercato. Tra questi figurano sistemi della famiglia GPT, modelli Claude/Sonnet di Anthropic, Gemini di Google, Grok di xAI e Manus.

La scelta dei ricercatori è deliberata, non confrontare quale modello “vince”, ma osservare cosa accade quando strumenti di frontiera vengono chiamati a svolgere incarichi di lavoro reali, dall’inizio alla fine, senza supporto umano. Il fatto che anche questi modelli falliscano nella maggior parte dei casi suggerisce che il limite osservato non riguardi una singola architettura o una versione specifica, ma qualcosa di più strutturale, il modo stesso in cui il lavoro umano è organizzato e valutato.

Nella grande maggioranza dei casi, i fallimenti assumono forme ricorrenti: lavori lasciati incompleti, output che appaiono plausibili ma risultano funzionalmente errati, errori tecnici elementari come file corrotti o elementi mancanti, oppure una mancata aderenza al brief iniziale. L’AI non “sbaglia perché è stupida”, ma perché il lavoro reale non è riducibile a una sequenza lineare di task eseguibili uno dopo l’altro. Il lavoro implica controllo, verifica, adattamento e responsabilità, elementi che oggi i sistemi di AI faticano a integrare in modo coerente.

Gli esempi del Remote Labor Index: dove il lavoro prende forma

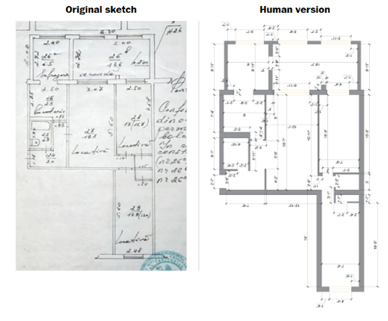

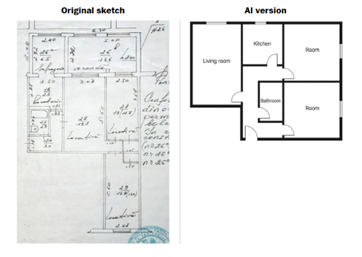

Attraverso gli esempi concreti del Remote Labor Index, anche grazie alla ricostruzione visiva del Washington Post , il funzionamento reale di questi limiti emerge con maggiore chiarezza. Nel caso della trasformazione di una piantina disegnata a mano in una planimetria digitale, il confronto è particolarmente istruttivo.

L’output prodotto da un progettista umano restituisce una pianta coerente, leggibile e utilizzabile, in cui proporzioni, vincoli spaziali e funzioni degli ambienti risultano allineati. Il miglior sistema di AI, messo di fronte allo stesso incarico, genera invece una planimetria che a una prima occhiata appare plausibile, persino “professionale”, ma che si rivela rapidamente sbagliata nel suo insieme.

Le stanze non rispettano le proporzioni originali, alcuni elementi architettonici sono collocati in modo incoerente e l’organizzazione degli spazi non corrisponde più allo schizzo di partenza. Questo esempio è centrale perché mostra un limite che va oltre l’accuratezza grafica. Il problema non è che l’AI “disegni male”, ma che non verifica il risultato rispetto ai vincoli funzionali del compito. Produce qualcosa che assomiglia a una soluzione, ma non controlla se quella soluzione sia davvero tale. Un errore particolarmente insidioso, perché non emerge come fallimento evidente, l’output può essere accettato superficialmente, pur essendo inutilizzabile nella pratica.

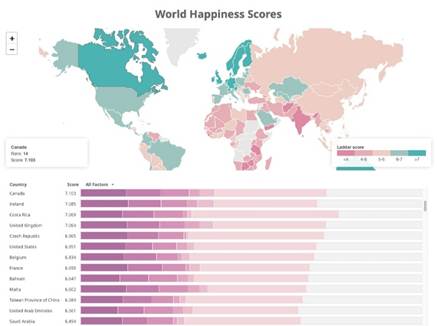

Nel progetto di creazione di una dashboard basata su dati complessi, l’output generato dall’AI sembra corretto a una prima occhiata, ma contiene errori silenziosi come dati mancanti, colori incoerenti o sovrapposizioni: è il tipo di errore più pericoloso nei contesti professionali, perché non si manifesta come un fallimento evidente.

Ci sono altri due casi, un video 3D e un videogioco web. Nel caso dei video 3D di prodotto, il fallimento è ancora più esplicito. Qui il limite non è creativo, ma operativo. L’AI non utilizza gli strumenti con cui questo tipo di lavoro viene realmente svolto e non riesce a produrre un risultato utilizzabile. Infine, nel progetto di sviluppo di un videogioco web, l’AI riesce a generare un prodotto funzionante, ma ignora un requisito chiave del brief. Il gioco “gira”, ma manca di senso rispetto agli obiettivi richiesti. Ancora una volta, l’AI esegue, ma non governa il progetto nel suo insieme.

Perché l’AI fallisce nel lavoro

Dall’analisi complessiva emerge un pattern chiaro. I limiti osservati non riguardano soltanto la potenza di calcolo o la maturità tecnologica, ma la natura stessa del lavoro umano. Il lavoro richiede memoria nel tempo, coordinamento tra parti diverse, giudizio su cosa sia “abbastanza buono” e assunzione di responsabilità rispetto al risultato finale.

Questi fallimenti non sono incidenti tecnici, ma segnali di una difficoltà strutturale nel trasformare lavoro complesso in pura esecuzione automatica. Un task può essere automatizzato, un ruolo può essere ridisegnato, ma un lavoro è un sistema di decisioni distribuite nel tempo. In altre parole, il lavoro non è solo esecuzione ma collegamento e orchestrazione. Dimensioni che sfuggono ancora in termini di efficacia ai sistemi di AI.

Il mercato del lavoro con l’AI

A questo punto entra in gioco una seconda linea di evidenza, che emerge dall’analisi di lungo periodo dei dati su occupazione e salari e che non nasce nel dibattito sull’intelligenza artificiale.

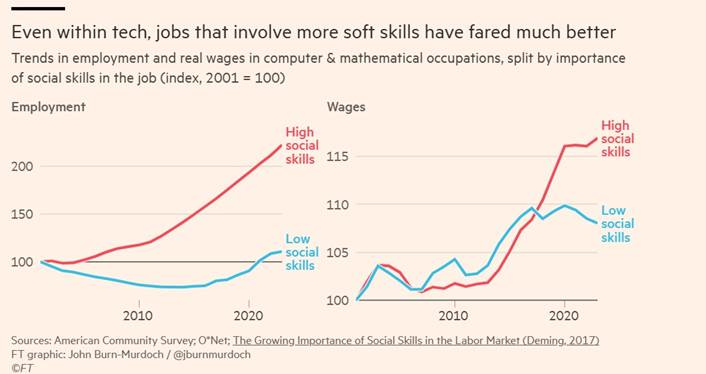

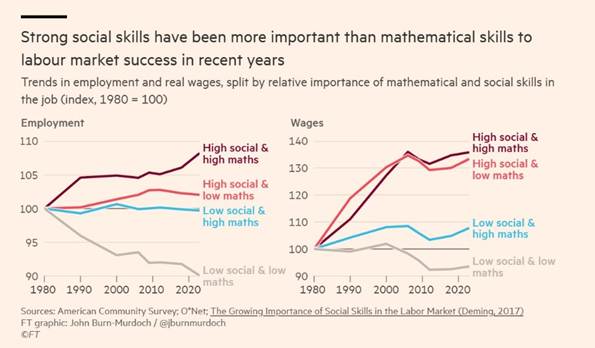

Le serie storiche mostrano una dinamica che precede di anni l’attuale ondata di AI generativa, il valore economico del lavoro si è progressivamente concentrato nei ruoli che combinano competenze tecniche con capacità relazionali, cognitive e di coordinamento, mentre la pura padronanza quantitativa, isolata dal contesto organizzativo, ha perso parte della sua centralità[2]. Non si tratta quindi di una svalutazione delle competenze tecniche in quanto tali, ma di un cambiamento nel modo in cui esse generano valore, sempre meno come abilità autosufficienti, sempre più come leve inserite in processi decisionali complessi, collettivi e situati.

I dati mostrano infatti un’inversione storica rispetto agli anni Ottanta. Oggi i profili che combinano capacità di interazione, lettura del contesto, persuasione e coordinamento ottengono risultati migliori nel mercato del lavoro anche quando le competenze matematiche o formali sono relativamente più deboli. Non si tratta di una svalutazione delle competenze tecniche, ma di un cambiamento nel modo in cui esse generano valore. Sempre meno come abilità isolate, sempre più come strumenti inseriti in processi complessi e collettivi.

Anche nella tech economy: il coding non basta dopo l’AI

Una possibile obiezione a questa lettura è che valga in generale, ma non nei lavori tecnologici e quantitativi, storicamente associati a forti premi salariali. Anche qui, però, i dati raccontano una storia diversa. All’interno delle stesse professioni tech, crescono di più i ruoli che combinano competenze tecniche con collaborazione, creatività e interazione rispetto a quelli più isolati e puramente esecutivi.

Questo punto è cruciale perché mostra che il valore non si sposta fuori dalla tecnologia, ma dentro la tecnologia stessa. Non è il coding in quanto tale a perdere centralità, ma l’idea che scrivere codice, analizzare dati o costruire modelli possa costituire da sola un’identità professionale autosufficiente. I ruoli che prosperano sono quelli in cui le competenze tecniche diventano leva per prendere decisioni, coordinare altri attori, integrare punti di vista e risolvere problemi che non sono mai completamente definiti a monte.

Il punto di contatto decisivo: cosa vale di più è ciò che l’AI fa peggio

A questo punto il collegamento tra le due analisi diventa difficile da ignorare. Il Remote Labor Index mostra che l’AI fallisce soprattutto quando un incarico richiede coordinamento tra più dimensioni, giudizio sul risultato finale e assunzione di responsabilità rispetto al contesto d’uso. L’analisi del mercato del lavoro mostra che, da anni, è proprio su queste stesse dimensioni che si concentra la parte più rilevante del valore economico del lavoro umano.

Non si tratta di una coincidenza. Ciò che oggi l’AI fatica ad automatizzare è esattamente ciò che il mercato del lavoro ha iniziato a premiare molto prima dell’attuale ondata di hype sull’intelligenza artificiale. In questo senso, l’AI non sta anticipando una trasformazione, ma la sta rendendo visibile, accelerando una dinamica già in atto.

Il vero rischio: non la sostituzione, ma la compressione

Questo non significa che l’impatto dell’AI sul lavoro sia trascurabile. Anche in assenza di una sostituzione diretta e massiccia dei lavoratori, l’automazione può produrre effetti profondi sull’organizzazione del lavoro e sulla distribuzione del valore. In molti contesti, meno persone possono essere sufficienti per svolgere lo stesso volume di attività; alcuni ruoli intermedi rischiano di perdere funzione; le attività più standardizzabili possono subire una pressione al ribasso sui compensi.

Il contributo del Remote Labor Index è particolarmente rilevante proprio sul piano economico. Lo studio mostra che, anche quando i risultati prodotti dall’AI sono peggiori rispetto a quelli umani, il differenziale di costo resta enorme. In alcuni casi, incarichi svolti da professionisti umani per migliaia di dollari vengono replicati da sistemi di AI con costi marginali di poche decine di dollari.

Questa asimmetria introduce un incentivo strutturale alla sperimentazione e all’adozione, indipendentemente dalla qualità finale dell’output. Dal punto di vista economico, il punto non è quindi se l’AI “funzioni meglio” dell’essere umano, ma se il suo output sia sufficientemente accettabile rispetto al costo sostenuto. Qui si innesta il rischio di compressione, non la scomparsa immediata dei lavori, ma una progressiva ridefinizione delle soglie di qualità considerate adeguate, con effetti diretti su compensi, tempi e aspettative. Su questo terreno, più che su quello della sostituzione totale, che si gioca la partita più delicata dell’impatto dell’AI sul lavoro.

Come mettere al riparo il lavoro dall’AI

In questo scenario, ragionare su come “mettere al riparo” il lavoro dall’AI rischia di essere fuorviante se la questione viene ridotta all’apprendimento di nuovi strumenti. Il punto non è diventare più veloci nell’esecuzione, ma governare una transizione in cui il baricentro del valore professionale si sposta progressivamente. Dalla produzione alla valutazione, dall’esecuzione al coordinamento, dal singolo task alla decisione, dall’output isolato al processo nel suo complesso. La transizione non è automatica e non avviene per semplice esposizione alla tecnologia.

Richiede percorsi di apprendimento e di formazione diversi da quelli tradizionali, meno centrati sull’addestramento all’uso degli strumenti e più orientati allo sviluppo di capacità di giudizio, integrazione e responsabilità. Non si tratta solo di “imparare l’AI”, ma di imparare a lavorare con l’AI in contesti reali, ridefinendo ruoli, aspettative e criteri di qualità. In questo spazio di apprendimento continuo, spesso informale e situato, che si collocano le competenze meno visibili, più difficili da misurare e, proprio per questo, più resistenti all’automazione.

Una bussola per orientarsi

L’intelligenza artificiale non sta togliendo valore al lavoro umano. Sta rendendo esplicito dove quel valore si era già spostato, spesso senza che ce ne accorgessimo. Comprendere questa dinamica non elimina le tensioni né le asimmetrie che l’AI può amplificare, ma aiuta a leggere il cambiamento con maggiore lucidità.

Forse la vera domanda, allora, non è quali lavori scompariranno, ma quali parti del lavoro continuiamo a chiamare “lavoro” solo per abitudine, anche quando il valore si è già spostato altrove.

Note

[1] https://static.scale.com/uploads/654197dc94d34f66c0f5184e/Remote_Labor_Index%20%284%29.pdf

[2] I grafici richiamati in questa sezione sintetizzano elaborazioni pubblicate dal Financial Times, basate su dati longitudinali di occupazione e salari negli Stati Uniti, che integrano fonti come l’American Community Survey e il database O*NET sulle competenze professionali. Questa lettura riprende e aggiorna filoni di ricerca avviati già prima dell’attuale fase di sviluppo dell’AI, in particolare gli studi dell’economista David Deming, che hanno mostrato come, a partire dagli anni Novanta, i rendimenti salariali associati alle competenze sociali abbiano superato quelli legati alle competenze puramente matematiche.