Il rilascio di Claude Sonnet 4.6 ieri segna un passaggio significativo nella strategia di Anthropic. Il modello non viene presentato come un affinamento incrementale, ma come un aggiornamento completo delle capacità tipiche della fascia Sonnet, quella pensata per essere rapida, economica e sufficientemente potente per coprire la maggior parte dei casi d’uso professionali.

La novità più rilevante è che Sonnet 4.6 diventa il modello predefinito per gli utenti Free e Pro sull’interfaccia web e mobile di Claude e in Claude Cowork, senza variazioni di prezzo rispetto alla versione precedente. In pratica, una porzione più ampia di utenza si ritrova a usare quotidianamente un modello che ambisce a prestazioni da classe Opus su molti compiti operativi.

Sonnet 4.6 è anche un tassello della generazione “Claude 4.6”, che introduce cambiamenti trasversali di piattaforma. Oltre al miglioramento del modello in sé, vengono messi a disposizione strumenti e controlli pensati per agenti più affidabili e conversazioni più lunghe, con un’attenzione esplicita alla sostenibilità dei costi e al contenimento degli errori che emergono quando un modello deve pianificare, usare strumenti e portare a termine compiti a più step.

Indice degli argomenti

Claude Sonnet 4.6 e il salto nel coding e negli agenti

Il messaggio principale è che la qualità del coding migliora non solo in accuratezza, ma in prevedibilità. Anthropic riporta che, in valutazioni con sviluppatori con accesso anticipato, Sonnet 4.6 è stato preferito a Sonnet 4.5 nel 71% dei confronti. Nelle stesse valutazioni, il modello è stato preferito anche rispetto a Claude Opus 4.5 nel 59% dei casi, un segnale importante perché indica che, per una quota di problemi reali, la differenza percepita tra fascia Sonnet e fascia Opus può ridursi sensibilmente. La preferenza è motivata da aspetti pratici, come minore tendenza all’overengineering, migliore aderenza alle istruzioni, riduzione di affermazioni errate di completamento del lavoro, meno allucinazioni e una maggiore costanza nell’esecuzione di richieste composte da più passaggi.

Questa impostazione si collega all’evoluzione dei flussi di sviluppo basati su agenti. Nel coding moderno, l’output non è solo la singola funzione corretta, ma una catena di decisioni che include ricerca nel codice, interpretazione di vincoli impliciti, scelta di pattern coerenti con la codebase e verifica del risultato. Un modello “più forte” ma incostante può generare costi nascosti perché richiede più iterazioni e più controllo umano. La tesi di Sonnet 4.6 è che gran parte del valore stia nella riduzione dell’attrito, cioè nel convergere più spesso alla prima o seconda iterazione verso una soluzione pronta per la produzione.

I benchmark e i compiti agentici “computer-using”

Computer use e lavoro d’ufficio: i numeri dei benchmark

Il salto più evidente, secondo la documentazione tecnica pubblicata da Anthropic, riguarda i compiti agentici che richiedono l’uso di un computer e di applicazioni reali. Nel post di lancio viene richiamato OSWorld, uno dei benchmark più utilizzati per misurare la capacità di completare task su software diffuso in un ambiente simulato, e si sottolinea come il percorso di miglioramento sia stato rapido a partire dall’introduzione dei modelli “computer-using”. La system card di Sonnet 4.6 riporta per OSWorld-Verified un risultato del 72,5%, un valore che colloca la fascia Sonnet in una zona storicamente riservata ai modelli di punta.

Sul versante coding, la system card indica un punteggio del 79,6% su SWE-bench Verified, un benchmark che si concentra su correzioni reali di bug in repository open source, con verifica automatica dei risultati. Per attività su terminale, Terminal-Bench 2.0 viene riportato a 59,1%, un valore che aiuta a stimare la robustezza del modello quando deve operare in modo agentico su shell e ambienti testuali. Nella stessa panoramica compaiono anche segnali di solidità su valutazioni orientate al lavoro di conoscenza, come un Elo di 1633 su GDPval-AA per task d’ufficio e un 89,3% su MMLU per il question answering multilingue.

Questi numeri vanno letti con cautela, perché nessun benchmark cattura completamente il rischio del mondo reale. Anthropic lo esplicita nel post di lancio, osservando che l’uso del computer nella pratica è più ambiguo, più “sporco” e spesso più costoso in caso di errore rispetto alle condizioni controllate di un test. Tuttavia, l’insieme dei risultati suggerisce una convergenza tra competenze di programmazione, pianificazione e affidabilità nell’uso di strumenti, che è esattamente ciò che serve per trasformare un modello in un componente operativo di un processo.

Come leggere la figura comparativa dei risultati

La tabella comparativa dei benchmark: lettura critica

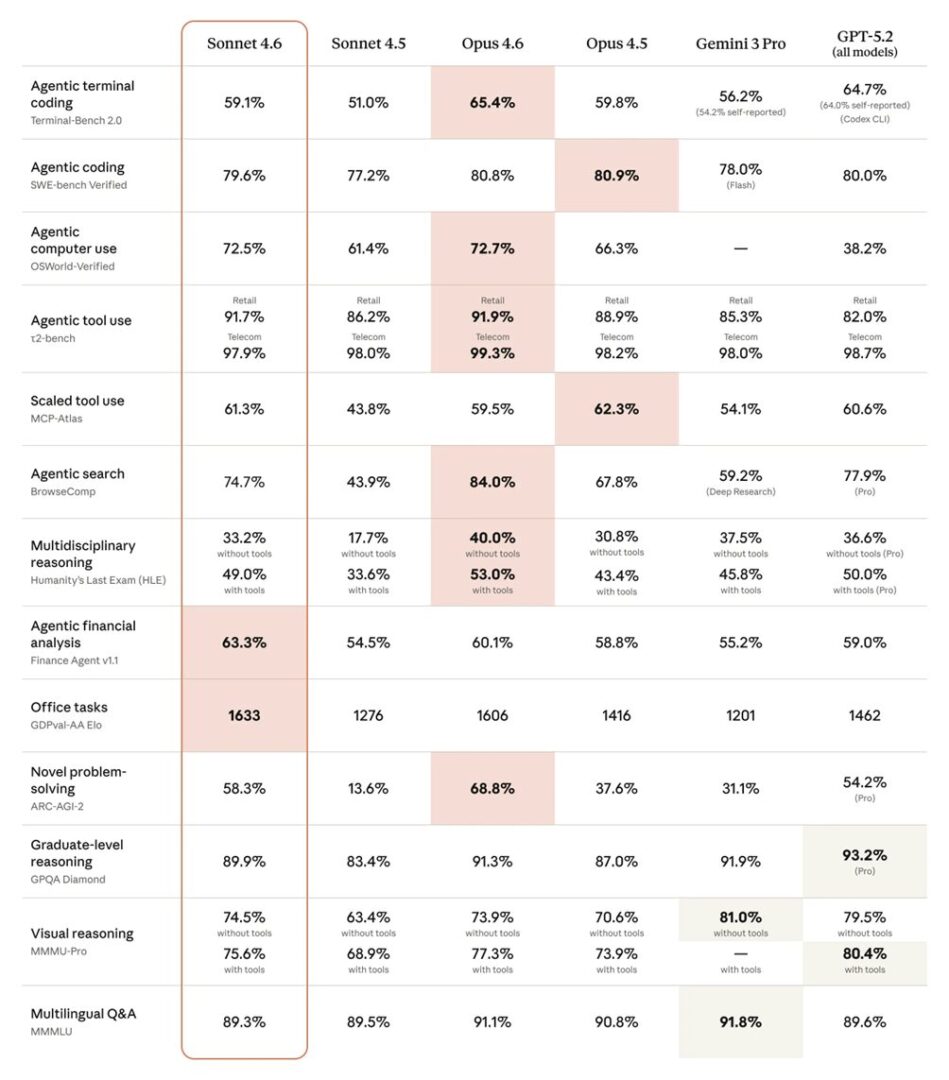

La figura mette a confronto Sonnet 4.6 con Sonnet 4.5, Opus 4.6 e Opus 4.5, insieme a due riferimenti esterni come Gemini 3 Pro e GPT-5.2, su un insieme eterogeneo di benchmark che coprono coding agentico, uso di strumenti, ricerca, ragionamento e task d’ufficio. È utile perché evidenzia, a colpo d’occhio, dove si colloca Sonnet 4.6 rispetto alla fascia frontier e dove restano margini.

Nell’area più vicina al lavoro quotidiano degli sviluppatori emergono due segnali. Su SWE-bench Verified il modello si mantiene vicino ai valori dei modelli di punta e al riferimento GPT, mentre su Terminal-Bench 2.0 resta sotto Opus 4.6 e GPT-5.2 ma con un salto netto rispetto a Sonnet 4.5. Ancora più eloquente è OSWorld-Verified, che misura la capacità di completare task su applicazioni e interfacce. Qui Sonnet 4.6 è praticamente allineato a Opus 4.6 e stacca in modo ampio Sonnet 4.5, un risultato coerente con l’enfasi posta da Anthropic sull’affidabilità degli agenti che operano su interfacce.

La parte dedicata al tool use rafforza la stessa lettura. Nei due scenari di t2-bench, retail e telecom, le differenze tra modelli sono contenute ma Sonnet 4.6 rimane nelle fasce alte. Nel benchmark MCP-Atlas, pensato per un uso di strumenti più scalato, Sonnet 4.6 supera Opus 4.6 e si avvicina a Opus 4.5 e GPT-5.2. Anche BrowseComp, che rappresenta un proxy di ricerca agentica, mostra un progresso marcato rispetto alla versione precedente. Nel grafico, alcune misure riportano note di contesto, come l’indicazione di risultati self-reported o di varianti specifiche, per esempio Flash o Pro. Queste etichette ricordano che i confronti non sono sempre perfettamente allineati e che, al di fuori dei benchmark, contano configurazioni, tool disponibili e pipeline di valutazione.

Quando si passa ai test di ragionamento generale e multimodale, la figura suggerisce un profilo più equilibrato che dominante. Su HLE si osserva un guadagno rilevante quando vengono abilitati gli strumenti, a conferma che in compiti interdisciplinari la qualità dell’orchestrazione tool-augmented incide quanto il modello base. Su ARC-AGI-2 Sonnet 4.6 compie un salto evidente rispetto a Sonnet 4.5 e si colloca in una fascia competitiva, pur restando dietro Opus 4.6. Su GPQA Diamond e MMMU-Pro, invece, emergono aree in cui i riferimenti esterni guidano ancora, rispettivamente GPT-5.2 e Gemini 3 Pro. Infine, la riga su GDPval-AA Elo indica un vantaggio di Sonnet 4.6 nelle attività d’ufficio, un dato che si allinea con il posizionamento del modello come default per la produttività.

In sintesi, la figura non va letta come una classifica assoluta, ma come una mappa. Sonnet 4.6 sembra puntare a una convergenza tra performance agentica e costo sostenibile, riducendo la distanza dalla fascia Opus proprio dove l’adozione pratica è più sensibile. Nei test più accademici e multimodali resta una competizione più aperta, che dipende anche da come vengono attivati strumenti, modalità di reasoning e varianti di modello.

Claude Sonnet 4.6, long context e continuità operativa

Long context e continuità operativa: 1M token e compaction

Un elemento distintivo di Sonnet 4.6 è l’estensione della finestra di contesto. Anthropic parla di un contesto da 1 milione di token in beta, sufficiente, in molti casi, a includere un’intera codebase, contratti lunghi o un corpus di documenti di ricerca in un’unica richiesta. La documentazione dei modelli chiarisce che la finestra “standard” rimane 200K, mentre l’opzione a 1M richiede l’abilitazione in beta e comporta regole di pricing specifiche oltre la soglia dei 200K token di prompt.

Il tema del contesto lungo non è solo una questione di capacità di input. Il punto critico è mantenere coerenza e progressione quando la conversazione diventa un progetto, cioè quando si accumulano ipotesi, vincoli, decisioni prese e output intermedi. Qui entra in gioco compaction, una funzionalità in beta che automatizza la sintesi server-side delle parti più vecchie della conversazione man mano che ci si avvicina ai limiti della finestra. La documentazione tecnica descrive compaction come un meccanismo che produce un blocco di riassunto, sostituisce parte della storia e permette di proseguire, con un comportamento configurabile tramite soglie di attivazione e istruzioni di sintesi personalizzate.

Nel complesso, 1M token e compaction convergono verso lo stesso obiettivo. Rendere praticabili conversazioni e agenti “a lunga durata” senza richiedere all’applicazione di orchestrare manualmente il riassunto e la gestione della memoria, e senza che i costi esplodano per ripetizione di contesto. È un passo rilevante perché, nelle applicazioni enterprise, l’adozione reale dipende spesso dalla capacità di far lavorare il modello su dossier estesi, audit trail e processi che durano ore o giorni.

Strumenti, difese e distribuzione: cosa cambia nella piattaforma

Tooling per l’affidabilità: ricerca web con filtraggio dinamico e difese

La release non riguarda solo il modello, ma anche l’infrastruttura di strumenti. Sonnet 4.6 supporta adaptive thinking e extended thinking, con controlli di “effort” che permettono di modulare profondità di ragionamento e costo, soprattutto nei flussi agentici. In parallelo, gli strumenti di web search e web fetch vengono aggiornati con una modalità di filtraggio dinamico in beta. L’idea è che il modello possa scrivere ed eseguire codice per filtrare e processare risultati e contenuti prima che entrino nel contesto, trattenendo solo ciò che è rilevante. Questo dovrebbe migliorare l’accuratezza e ridurre il consumo di token, perché la finestra non viene “inquinata” da pagine o estratti marginali.

Un dettaglio operativo interessante è che, nelle note di piattaforma, l’esecuzione di codice risulta gratuita quando viene usata insieme agli strumenti web, restando a carico solo il costo standard di input e output token. In un’ottica di agenti che cercano, leggono e sintetizzano, questo tipo di scelta di pricing incentiva l’uso di pipeline più strutturate, dove il modello filtra e normalizza dati prima di ragionare.

L’affidabilità, però, non è solo una questione di tool. È anche una questione di robustezza a prompt injection, cioè la capacità di resistere a istruzioni malevole inserite nei contenuti recuperati dal web o da documenti. La system card di Sonnet 4.6 include risultati su valutazioni dedicate, come Shade, mostrando una riduzione consistente dei tassi di successo degli attacchi in configurazioni con prompt difensivi rispetto a modelli precedenti. Il dato non implica immunità, ma segnala un miglioramento misurabile in un’area che, con l’aumento dell’automazione, diventa uno dei principali vettori di rischio.

Accesso, API e prezzi

Distribuzione, costi e implicazioni per aziende e sviluppatori

Sul piano dell’accesso, Sonnet 4.6 è posizionato per essere ovunque. Oltre all’interfaccia web e mobile di Claude e ai prodotti Cowork, è disponibile via API con l’identificativo claude-sonnet-4-6 e attraverso le principali piattaforme cloud. La documentazione di Google Cloud indica la disponibilità generale su Vertex AI e conferma l’opzione di contesto da 1M token in modalità preview.

La distribuzione non riguarda solo l’API. Nel post di annuncio vengono evidenziati aggiornamenti di prodotto che mirano a portare capacità avanzate anche in contesti non strettamente “developer”. Tra questi compaiono l’espansione delle funzionalità nel livello Free, che include strumenti come creazione di file, connettori e skills, e l’evoluzione degli add-in, come Claude in Excel, che in ambito enterprise può attingere a contesti esterni tramite connettori basati su Model Context Protocol.

Nel mondo degli strumenti di sviluppo, GitHub comunica la disponibilità di Sonnet 4.6 in GitHub Copilot per gli abbonamenti Pro, Pro+, Business ed Enterprise. Il modello è selezionabile dal model picker in ambienti come Visual Studio Code, Visual Studio, l’interfaccia web di GitHub, le app mobile, la CLI e il coding agent, mentre per gli account aziendali l’abilitazione può essere governata da policy lato amministrazione.

Il pricing resta uno dei motivi centrali del posizionamento. La pagina prezzi di Anthropic indica per Sonnet 4.6 un costo di 3 dollari per milione di token in input e 15 dollari per milione di token in output, con costi maggiorati quando si supera la soglia dei 200K token di prompt nelle richieste long context. Si aggiungono poi meccanismi che incidono direttamente sul costo effettivo, come prompt caching e batch processing, che vengono proposti come leve per ridurre la spesa in scenari ad alto volume o con contesto ripetuto.

Per aziende e team di ricerca applicata, l’implicazione è chiara. Se un modello della fascia “workhorse” raggiunge risultati vicini ai top model su coding, uso del computer e document understanding, diventa più facile standardizzare i flussi su un solo modello e riservare i modelli più costosi a casi davvero estremi. Questo non elimina la necessità di valutazioni interne, monitoraggio e guardrail, soprattutto in contesti regolati o ad alto rischio operativo. La stessa Anthropic, nel post di annuncio e nella system card, ribadisce l’uso di valutazioni di sicurezza e l’inquadramento della distribuzione secondo il proprio Responsible Scaling Policy, con Sonnet 4.6 riportato come distribuito a uno standard ASL-3.

Bilancio sintetico su Sonnet 4.6

Claude Sonnet 4.6 rappresenta un’evoluzione interessante perché combina tre linee che spesso avanzano separatamente. Aumenta le prestazioni del modello, estende in modo pragmatico la gestione del contesto e migliora l’ecosistema di strumenti che rendono un agente più utile e meno costoso. Il risultato è un candidato credibile per diventare il motore standard di molti workflow professionali, dal coding assistito alla gestione di documenti complessi, fino a compiti agentici su interfacce prive di API.

Resta un punto fermo. Più un modello è in grado di agire, più diventa importante trattarlo come un componente software con requisiti di qualità, test, osservabilità e sicurezza, non come un semplice chatbot. Sonnet 4.6 sembra muoversi in questa direzione, offrendo un mix di potenza e controllo che rende più realistico portare l’AI generativa fuori dai prototipi e dentro processi ripetibili.

Bibliografia

Anthropic, Introducing Claude Sonnet 4.6 (17 febbraio 2026).

Anthropic, Claude Sonnet 4.6 System Card (2026).

Anthropic, Claude API Docs, Models overview.

Anthropic, Pricing.

Anthropic, Claude API Docs, Compaction.

Anthropic, Claude API Docs, Web search tool.

Anthropic, Claude API Docs, Web fetch tool.

Anthropic, Claude API Docs, What’s new in Claude 4.6.

GitHub, Claude Sonnet 4.6 is now generally available in GitHub Copilot (17 febbraio 2026).

GitHub Docs, Supported AI models in GitHub Copilot.

Google Cloud, Vertex AI Documentation, Claude Sonnet 4.6 model details.

OSWorld, OSWorld benchmark.

Andon Labs, Vending-Bench Arena.

Artificial Analysis, Office tasks evaluation and benchmarking.

Axios, Anthropic’s newest AI model is cheaper and faster (17 febbraio 2026).