L’implementazione di modelli AI on-premises è un’opportunità concreta per le aziende che vogliono differenziare i propri investimenti in intelligenza artificiale, ridurre la dipendenza dai servizi cloud delle big tech e mantenere il controllo completo sui propri dati.

Indice degli argomenti

La bolla AI e la necessità di strategie aziendali sostenibili

Il continuo rilascio di nuovi modelli e capacità dell’AI continua a dominare il dibattito tecnologico mentre cresce la tensione sui mercati finanziari per il possibile scoppio della bolla dell’intelligenza artificiale.

Gli investimenti da capogiro che le grandi stanno facendo nelle AI factories mettono in dubbio la sostenibilità di un sistema la cui unità di misura di corrente sembra essere divenuta il gigawatt. È naturale per un’azienda chiedersi come differenziare i propri investimenti nel settore contenendo i potenziali rischi dovuti allo scoppio della bolla e consolidando i propri investimenti per assicurare una continuità operativa con basi solide per il proprio funzionamento.

In questo panorama sempre più complesso è naturale chiedersi quale sia ora lo stato di maturazione delle tecnologie dei modelli cosiddetti open-weight, ovvero per cui è possibile disporre dei file “binari” del modello che possono anche essere utilizzati per usi commerciali. Cerchiamo di fare il punto e capire le opzioni disponibili per un’azienda che voglia investire sull’esecuzione locali di almeno di una parte dei servizi AI.

Strumenti software per l’esecuzione locale di modelli AI

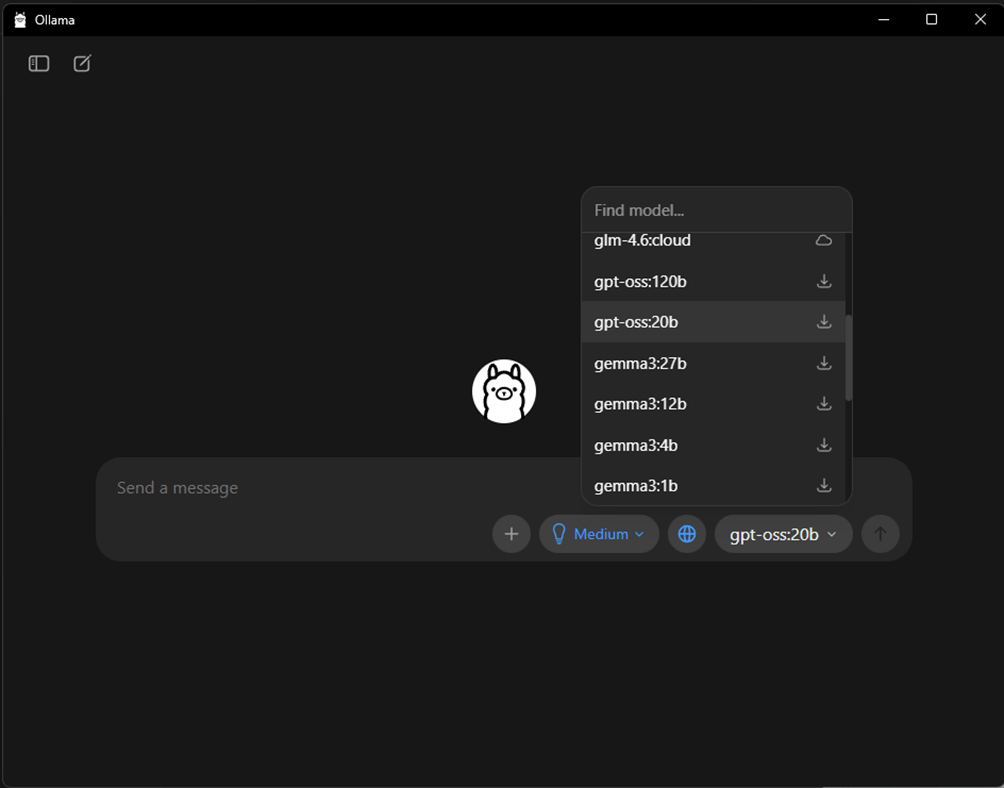

Con la maturazione delle tecnologie open in ambito AI i software come ollama e LM Studio sono divenuti punti di riferimento consentendo ai non esperti l’esecuzione di modelli aperti, per lo più provenienti dal popolare sito hugging face, supportando sia l’interazione orientata alla chat che l’accesso mediante API. Personalmente continuo a utilizzare ollama, sia sul mio laptop che nelle installazioni che effettuiamo su server per l’esecuzione di modelli più capaci nel nostro datacenter.

L’interfaccia a linea di comando, sebbene ancora disponibile, è stata affiancata da un’interfaccia grafica che offre controlli simili a quelli a cui ci siamo rapidamente abituati, abilitando la possibilità di caricare documenti, impostare il ragionamento ed arricchire le risposte mediante le ricerche Web.

Ollama cura vari modelli che si scaricano facilmente e semplicemente funzionano, consente però anche di riferire modelli nel sito hugging face supportando de facto migliaia di modelli di AI che vengono costantemente aggiornati e migliorati dalla comunità e dalle big del settore che pubblicano modelli open oltre a sviluppare i propri modelli come GPT, Gemini e Sonnet internamente.

Implementazione server e maturità dell’user experience

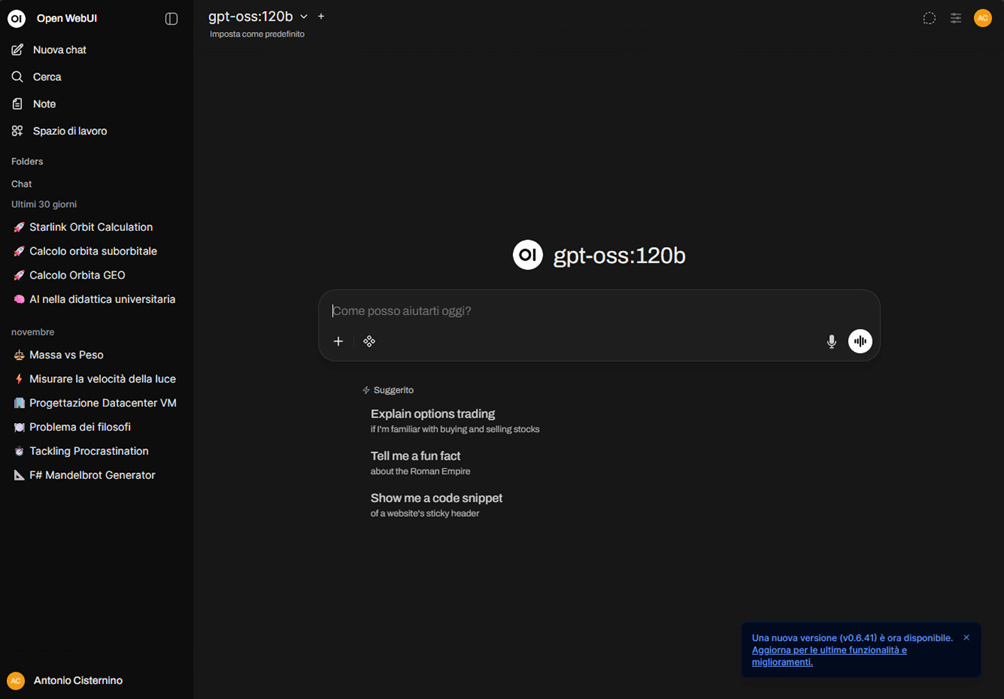

Lato server è possibile facilmente, grazie alla disponibilità delle versioni container, mettere in esecuzione il progetto Open WebUI insieme ad ollama per ottenere un servizio interno alla propria realtà che consente di usufruire dei servizi ed integrarli in soluzioni proprie.

Da un punto di vista della user experience è interessante osservare come questi strumenti siano maturati rapidamente e possano essere considerati per costruire una strategia di AI che non sia legata esclusivamente alle big. Va detto che l’abito non fa il monaco, e non è detto che una bella interfaccia corrisponda poi a un sistema realmente fruibile e soprattutto utile.

Evoluzione dei modelli open-weight verso applicazioni industriali

I modelli open weight sono migliorati moltissimo negli ultimi mesi, e la discesa in campo da parte di big come OpenAI con i suoi modelli GPT-OSS ha sicuramente contribuito ad alzare il livello qualitativo dei modelli che possono essere messi in esecuzione localmente ai nostri sistemi.

Se fino a pochi mesi fa i modelli piccoli per uso generale, seppur sorprendenti, presentavano limitazioni significative sia in termini di allucinazioni che nell’abilità di integrarsi facilmente con sorgenti di dati, i nuovi sviluppi ci consegnano uno scenario in cui entrambe le limitazioni sono state superate (o quantomeno ridotte significativamente), aprendo ad un uso industriale delle tecnologie.

Prestazioni e requisiti hardware per implementazioni aziendali

L’architettura MoE di GPT-OSS consente l’esecuzione della versione piccola del modello (20B) anche su un laptop, certo non con prestazioni fulminee, ma assolutamente impensabili poco tempo fa.

Quello che però colpisce è il miglioramento nell’efficienza di esecuzione su un server dove il servizio è capace di generare token ad una velocità assolutamente paragonabile a quella a cui siamo abituati online e con le risposte di una qualità che in molti casi è sufficiente per supportare una produzione.

L’hardware per poter eseguire i modelli su scala industriale resta sicuramente costoso, ma l’ottimizzazione dei modelli consente di poter pensare di creare un servizio con un server dal costo di circa sessantamila euro su cui sono in esecuzione due GPU nVidia RTX6000, una versione ridotta ma capace di tenere in memoria il modello da 120B parametri di GPT-OSS.

Quando si usano più GPU è necessario eseguire più istanze di ollama, una per GPU e lavorare con strumenti come bilanciatori di carico per assicurare l’uso di tutte le risorse del sistema, ma le prestazioni sono decisamente più che adeguate e i modelli sufficientemente maturi per svolgere compiti utili.

Va detto che l’esecuzione su larga scala di un modello può richiedere costi di oltre dieci volte superiori per server (con 8-16 GPU e non 2), ma per partire anche un server non troppo costoso può consentire di svolgere funzioni utili con un token rate di generazione accettabili per usi aziendali.

Framework ad agenti e protocollo MCP per l’automazione

Oltre ai framework per eseguire modelli AI, è necessario cominciare a tenere d’occhio il mondo dei framework ad agenti (Cohere per esempio sta rapidamente divenendo un attore importante in questo spazio, ma vi sono numerosi strumenti anche nello spazio open come ad esempio LangChain e AutoGen), altro elemento di automazione in cui i modelli vengono utilizzati per automatizzare compiti e, attraverso il protocollo MCP, collegarsi a realtà aziendali.

Maturità delle tecnologie e opportunità di investimento

Le tecnologie open per l’implementazione dell’AI in ambito aziendale stanno rapidamente maturando, grazie a modelli più capaci che possono svolgere compiti utili e non essere semplici curiosità e a software che ne consentono l’esecuzione e l’integrazione secondo interfacce ed API standard.

È quindi il momento di guardare a queste tecnologie non solo come delle potenziali curiosità per un futuro prossimo ma come elementi su cui cominciare ad effettuare investimenti volti anche a migliorare le competenze in house.

Limitazioni attuali e prospettive di integrazione aziendale

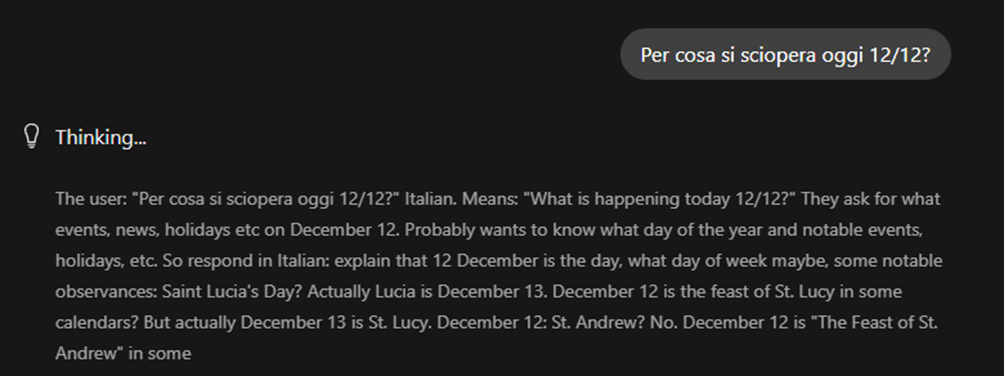

Se i modelli sono decisamente migliorati è importante ricordare che non sono perfetti, soprattutto quelli con non troppi parametri come GPT-OSS 20B che non è stato capace di tradurre correttamente il prompt in figura.

Problemi di conoscenza e linguistici a parte i modelli open sembrano pronti per una loro integrazione nei processi aziendali, consentendo una gestione più controllata delle informazioni e la possibilità di procedere a generazioni di testo che sarebbero molto onerose per un servizio online ma sono assolutamente accettabili quando il modello è in esecuzione sui propri sistemi. La maturazione degli ecosistemi rende non più rimandabile l’avvio di attività sperimentali al fine di differenziare le proprie strategie in termini di adozione dell’AI.