L’interazione tra dispositivi medici e intelligenza artificiale è oggi al centro dell’attenzione regolatoria europea. Il recente documento congiunto dell’Artificial Intelligence Board[1] e del Medical Device Coordinati on Group[2] fornisce indicazioni operative per i fabbricanti, con l’obiettivo di armonizzare gli obblighi previsti dalla normativa europea sui dispositivi medici – Regolamento (UE) 2017/745 “MDR” e Regolamento (UE) 2017/746 “IVDR“ – e di quella sui sistemi di intelligenza artificiale – Regolamento (UE) 2024/1689 “AI Act“,

Indice degli argomenti

quadro normativo e obiettivi del documento

Il documento “AIB 2025 -1, MDCG 2025-6 Interplay between the Medical Devices Regulation (MDR) & In vitro Diagnostic Medical Devices Regulation (IVDR) and the Artificial Intelligence Act (AIA)” (“Documento”).[3] è indirizzato ai fabbricanti di dispositivi medici che implementano l’intelligenza artificiale, e in particolare a quelli che implementano sistemi di AI “ad alto rischio” ai sensi dell’AI Act. Tali sistemi, infatti, quando integrati in un dispositivo medico software, dovranno rispettare taluni obblighi specifici posti dall’AI Act, che si intersecano con quelli già previsti da MDR e IVDR. Per questa ragione, a partire dal 2 agosto 2027[4] i certificati di conformità dei dispositivi medici, rilasciati dai competenti organismi notificati, dovranno attestare la conformità a entrambe le normative, ove applicabile.

Un approccio unitario tra sicurezza clinica e rischio algoritmico

L’integrazione tra MDR/IVDR da un lato, e AI Act dall’altro, impone ai fabbricanti di dispositivi medici basati sull’AI un approccio unitario, capace di coniugare sicurezza clinica e gestione dei rischi derivanti dall’algoritmo. L’approccio che il Documento suggerisce ai fabbricanti è chiaro: adottare un sistema di governance e di sorveglianza integrato, capace di soddisfare simultaneamente i requisiti del MDR/IVDR e dell’AI Act, evitando duplicazioni e garantendo che la conformità del dispositivo dal punto di vista clinico, da un lato, e quella relativa all’algoritmo, dall’altro, siano dimostrate in modo unitario e trasparente.

Classificazione e definizione dei sistemi di AI ad alto rischio

L’AI Act non influisce sulla classificazione del rischio dei dispositivi medici. Al contrario, è la classificazione di un dispositivo medico ai sensi di MDR e IVDR che determina se il sistema AI si qualifica come ad alto rischio ai sensi dell’AI Act. L’AI Act, infatti, classifica come “ad alto rischio” un sistema di AI che soddisfa entrambe le seguenti condizioni:

- il sistema è destinato a essere utilizzato come componente di sicurezza[5] di un prodotto, o è esso stesso un prodotto, disciplinato da una normativa di armonizzazione elencata nell’allegato II; e

- il prodotto il cui componente di sicurezza è il sistema di AI, o il sistema di AI stesso in quanto prodotto, è soggetto a una valutazione della conformità da parte di organismi terzi ai fini dell’immissione sul mercato o della messa in servizio.[6]

Nel caso dei dispositivi medici, MDR e IVDR figurano fra le normative di armonizzazione elencate nell’Allegato II dell’AI Act (condizione 1).

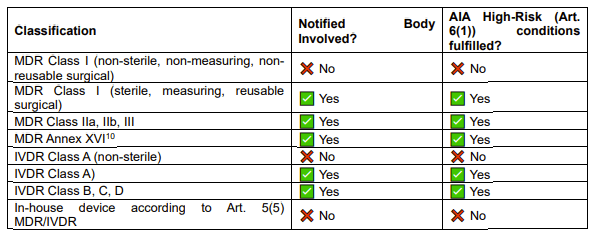

Pertanto, qualora ai sensi di tali normative i dispositivi richiedano l’intervento di un organismo notificato ai fini della loro certificazione di conformità (circostanza che ricorre per tutti i dispositivi dalla classe IIa / A sterile a salire), i relativi sistemi di AI saranno qualificati “ad alto rischio”, con la conseguenza che si applicheranno anche le regole specifiche previste dall’AI Act (condizione 2). Tale circostanza dovrebbe riguardare la maggioranza dei dispositivi medici software che implementano l’AI, in quanto, stando alle regole stabilite da MDR e IVDR[7], la possibilità di non coinvolgere un ON appare confinata a casi residuali (essenzialmente dispositivi di classe I e classe A non sterili, che sono molto limitati nel caso dei dispositivi medici software).[8]

Si riporta di seguito la tabella inclusa nel Documento:

Gestione della qualità e documentazione tecnica integrata

I fabbricanti di un dispositivo medico software che utilizza l’AI devono quindi procedere determinando innanzitutto la classificazione del dispositivo secondo le regole consolidate di MDR e IVDR e, solo in seguito, valutare l’applicabilità dei requisiti aggiuntivi dell’AI Act.

Sistema di gestione della qualità e documentazione tecnica: integrazione anziché duplicazioneIl fabbricante del dispositivo – già tenuto a istituire e mantenere un sistema di gestione della qualità che copra le fasi dalla progettazione e produzione sino alla gestione dei rischi e alla sorveglianza post-market – deve ora considerare gli ulteriori requisiti previsti dall’AI Act per i sistemi di AI ad alto rischio.

A livello generale, l’AI Act ha previsto espressamente la possibilità di valutare la conformità di un sistema di AI nell’ambito delle ordinarie procedure di valutazione della conformità condotte secondo la normativa applicabile al prodotto. Ciò significa, per i dispositivi medici di classe IIa (o superiore) e per i dispositivi medico-diagnostici in vitro di classe A sterile (e superiore), che tali valutazioni saranno condotte dagli organismi notificati già incaricati di valutare la sicurezza e le performancedei dispositivi ai sensi di MDR e IVDR.[9]

Con riferimento al sistema di gestione della qualità, non si tratta di duplicare procedure, ma di estendere le procedure esistenti: i processi di risk management dovranno includere anche i rischi specifici dell’IA (robustezza tecnica, bias, opacità degli algoritmi), mentre le procedure di validazione e verifica dovranno documentare non solo la conformità clinica, ma anche la conformità ai requisiti di trasparenza e supervisione umana previsti dal Regolamento sull’intelligenza artificiale.

Il medesimo principio di integrazione documentale vale anche con riferimento alla ulteriore documentazione tecnica necessaria al dispositivo ai sensi di entrambe le normative applicabili.

In prospettiva, a partire dal 2 agosto 2027, gli organismi notificati saranno chiamati a rilasciare certificati che attestino la conformità congiunta, e ciò implica che il sistema di gestione dovrà essere strutturato in modo da dimostrare, in un unico corpus documentale, il rispetto di MDR/IVDR e AI Act.

Governance dei dati e requisiti di rappresentatività

Il Documento evidenzia come la gestione dei dati rappresenti uno dei punti di contatto più delicati tra MDR/IVDR e AI Act. Il MDR richiede dati clinici e tecnici accurati, completi e tracciabili, a supporto della valutazione clinica e della sorveglianza post‑market, mentre l’AI Act impone l’utilizzo di set di dati sufficientemente rappresentativi, privi di bias e trattati in condizioni di sicurezza e trasparenza.

Ne consegue che i fabbricanti devono adottare procedure di governance dei dati che integrino entrambi i profili: qualità clinica e affidabilità dell’algoritmo. Ciò significa garantire la rappresentatività ed equità dei dataset, assicurarne la tracciabilità lungo l’intero ciclo di vita del dispositivo e applicare misure di sicurezza coerenti con il GDPR. Tali procedure devono essere documentate e rese disponibili agli organismi notificati e alle autorità competenti, così da dimostrare la conformità sia ai requisiti del MDR/IVDR sia a quelli dell’AI Act.

L’approccio promosso dal MDCG è ancora una volta quello di una governance integrata, capace di soddisfare insieme i requisiti del MDR/IVDR e dell’AI Act ed evitare duplicazioni.

Valutazione clinica dei dispositivi e dei sistemi di AI

Il Documento chiarisce che, per i dispositivi medici basati su AI, la valutazione clinica prevista dal MDR/IVDR deve essere integrata con le verifiche richieste dall’AI Act. Da un lato, il fabbricante è tenuto a raccogliere e mantenere evidenze cliniche solide, conformi agli standard di MDR e IVDR, a supporto della sicurezza e delle prestazioni del dispositivo. Dall’altro, deve documentare i risultati dei test di accuratezza, robustezza e resilienza del sistema di IA, nonché le misure di supervisione umana, come previsto dall’art. 14 dell’AI Act.

L’approccio suggerito dal MDCG è quindi quello di un processo unitario: i dati clinici e i risultati dei test sul sistema di AI devono confluire nella documentazione tecnica in modo coerente e integrato, così da consentire agli organismi notificati di valutare simultaneamente la conformità ai requisiti del MDR/IVDR e a quelli dell’AI Act, evitando duplicazioni e garantendo trasparenza.

Modifiche sostanziali e cambiamenti significativi

Il concetto di “modifica sostanziale” è definito dall’AI Act come qualsiasi cambiamento apportato a un sistema di intelligenza artificiale dopo la sua immissione sul mercato o messa in servizio, che non sia stato previsto o programmato nella valutazione iniziale della conformità e che abbia l’effetto di incidere sulla conformità del sistema stesso. In tali casi, l’articolo 43, paragrafo 4, stabilisce che i sistemi di AI ad alto rischio – tra cui i dispositivi medici basati su AI – devono essere sottoposti a una nuova procedura di valutazione di conformità.[10]

A riguardo, il Documento chiarisce che in caso di sistemi di IA dotati di capacità di apprendimento continuo anche dopo l’immissione sul mercato o la messa in servizio, i fabbricanti possono predeterminare, già in sede di valutazione iniziale, le modifiche attese al funzionamento del sistema, purché tali modifiche siano chiaramente descritte, valutate e inserite nella documentazione tecnica. Le modifiche così predeterminate non costituiscono modifica sostanziale ai sensi dell’AI Act e possono quindi essere implementate senza dover riavviare l’intero iter di conformità, a condizione che restino coerenti con la natura e la destinazione d’uso del dispositivo.

Un concetto simile è già presente nella normativa sui dispositivi medici. MDR e IVDR, e le relative linee guida MDCG – in particolare, MDCG 2020‑3 e MDCG 2022‑6 – disciplinano i c.d. “cambiamenti significativi”, ossia modifiche relative alla destinazione d’uso e alla progettazione che incidono sulla sicurezza e/o sulle prestazioni cliniche del dispositivo. Anche in questo contesto, tali modifiche non possono essere considerate meri aggiornamenti, ma richiedono una nuova valutazione di conformità e l’intervento dell’organismo notificato (salvo per i dispositivi di classe minore).

Il punto di contatto tra i due regimi è evidente: sia l’AI Act sia il MDR/IVDR qualificano come sostanziale ogni cambiamento che interessi il dispositivo e che possa alterare l’originaria valutazione della conformità condotta secondo ciascuna normativa. La differenza risiede nell’oggetto della valutazione: mentre il MDR/IVDR si concentra sulla sicurezza e sulle prestazioni cliniche, l’AI Act estende l’analisi a profili specifici dei sistemi di AI, come l’aggiornamento dei dataset di addestramento, l’introduzione di nuove funzionalità algoritmiche o modifiche che incidono su trasparenza, supervisione umana e gestione dei bias.

Per i fabbricanti, ciò implica la necessità di istituire procedure capaci di individuare e gestire di conseguenza ogni cambiamento che possa incidere sulle valutazioni di conformità già eseguite per il dispositivo.

Sorveglianza post-market integrata tra MDR/IVDR e AI Act

Sul versante della sorveglianza post commercializzazione, il Documento evidenzia come i fabbricanti siano tenuti a combinare in un unico sistema gli obblighi derivanti da MDR e IVDR, da un lato, e dall’AI Act, dall’altro. MDR (artt. 83 ss.) e IVDR (artt. 78 ss.) impongono la predisposizione di un piano di sorveglianza (PMS) e la redazione di rapporti periodici di sicurezza (PSUR), finalizzati a monitorare costantemente le prestazioni cliniche o diagnostiche e a individuare tempestivamente eventuali rischi per la salute. Parallelamente, l’AI Act (art. 72) richiede ai provider di sistemi di IA ad alto rischio di istituire un monitoraggio continuo che consenta di rilevare malfunzionamenti, bias, problemi di trasparenza, nonché interazioni inattese con altri sistemi.

ll Documento richiama dunque l’esigenza di integrare PMS e monitoraggio AI. In termini pratici, ciò implica per i fabbricanti, ancora una volta, la necessità di strutturare procedure che integrino i requisiti di PMS del MDR/IVDR con quelli di post‑market monitoring dell’AI Act in un unico sistema documentato.

Note

[1] Istituito ai sensi dell’art. 65 dell’AI Act.

[2] Istituito ai sensi dell’art. 103 del MDR.

[3] Disponibile alla seguente pagina https://health.ec.europa.eu/document/download/b78a17d7-e3cd-4943-851d-e02a2f22bbb4_en?filename=mdcg_2025-6_en.pdf.

[4] Articolo 113 dell’AI Act.

[5] Ai sensi dell’AI Act, un componente che svolge una funzione di sicurezza per il prodotto o sistema considerato, o il cui guasto o malfunzionamento mette in pericolo la salute e la sicurezza di persone o beni.

[6] Sono inoltre classificati ad alto rischio alcuni sistemi individuati dall’Allegato III dell’AI Act, essenzialmente sulla base della loro finalità (identificazione e categorizzazione biometrica delle persone, gestione e funzionamento di infrastrutture critiche, accesso a prestazioni e servizi pubblici, etc.).

[7] La possibilità di non coinvolgere un organismo notificato ai fini della certificazione è prevista per i soli dispositivi medici di classe I e i dispositivi medico-diagnostici in vitro di classe A non sterili.

[8] Per i dispositivi medici, in particolare, la regola di classificazione numero 11 (Allegato VIII, Capo III) del prevede che il software “destinato a fornire informazioni utilizzate per prendere decisioni a fini diagnostici o terapeutici” rientri nella classe IIa, salvo collocarsi in taluni casi in classe III (se le decisioni possono determinare il decesso o un deterioramento irreversibile delle condizioni di salute di una persona) o in classe IIb (se le decisioni possono determinare un grave deterioramento delle condizioni di salute di una persona o un intervento chirurgico). Anche il software “destinato a monitorare i processi fisiologici” è collocato nella classe IIa, salvo si tratti di parametri fisiologici vitali la cui variazione può determinare un pericolo immediato per il paziente, nel qual caso rientra nella classe IIb. Solamente al di fuori di queste ipotesi, il dispositivo medico software rientra nella classe I.

[9] Art. 43(3), AI Act.

[10] Sul concetto di modifica sostanziale sono attese ulteriori linee guida da parte della Commissione Europea.