Nell’apprendimento automatico tradizionale, la valutazione di un modello si basa su metriche come accuratezza, precisione (precision) e recupero (recall) che sono misure di adeguatezza tra il modello e i dati di test. Il presupposto è semplice: i dati usati nella fase di test offrono una buona rappresentazione del mondo reale. Tuttavia questa assunzione è, spesso, una semplificazione eccessiva.

Indice degli argomenti

I limiti del test set nella pratica reale

Il test set può non rappresentare fedelmente la realtà. Ad esempio potrebbe contenere classificazione errate, non contenere tra i suoi esempi i casi meno frequenti, o non riflettere i cambiamenti che avvengono nel tempo. Pensiamo a un sistema di diagnosi medica: se i dati di test non includono i più recenti biomarcatori per una patologia, il modello può sembrare eccellente nelle prove, ma rivelarsi insufficiente quando incontra pazienti reali.

In altre parole, limitarsi al dataset di test significa guardare il modello in una cornice artificiale, rischiando di trascurare ciò che davvero conta: la capacità di adattarsi al contesto reale di utilizzo.

Tre insiemi per capire cosa manca

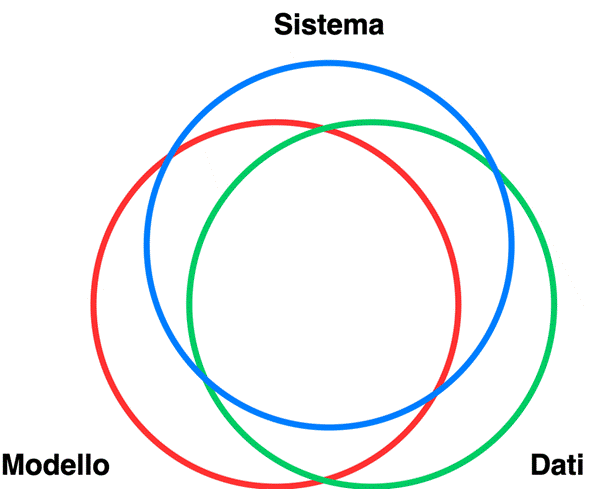

Per comprendere meglio questo limite, possiamo immaginare tre insiemi:

- M = ciò che il modello ha imparato.

- D = ciò che è presente nei dati di addestramento e test.

- S = ciò che serve davvero al sistema nel mondo reale.

Le cinque aree di sovrapposizione

La valutazione classica si concentra solo sull’intersezione tra M e D, assumendo che i dati raccolti rappresentino in modo fedele la realtà (D ≈ S). Ma questa assunzione raramente regge. In molti casi, D non copre tutto ciò che serve a S, oppure include schemi irrilevanti che il modello rischia di riprodurre. La figura mostra come questi tre insieme possono sovrapporsi.

- M ∩ D – l’area valutata dai test tradizionali: il modello viene giudicato sulla base di ciò che ha imparato e che era presente nei dati.

- D ∩ S – dati utili e rilevanti per il sistema, che sono stati raccolti: se non appartengono anche a M, significa che il modello non li ha appresi correttamente. Indica una scelta sbagliata nella progettazione del processo di apprendimento.

- M ∩ S – conoscenze che il modello ha appreso e che sono davvero utili per il mondo reale: questa è l’area più desiderabile.

- M ∩ ¬S – ciò che il modello ha imparato ma che non serve (o è addirittura dannoso) per il sistema: qui si trovano bias, correlazioni spurie, allucinazioni o schemi irrilevanti.

- S \ D – aspetti del mondo reale che non sono presenti nei dati: senza nuovi dati il modello non potrà mai gestirli correttamente.

L’esempio della moderazione dei contenuti

Un esempio concreto per comprendere meglio quanto descritto dalla figura può essere offerto dalla moderazione dei contenuti online. Un modello addestrato su vecchi insulti e linguaggi espliciti potrà funzionare bene sul test set (M ∩ D), ma fallire quando si trova di fronte a nuovi codici linguistici usati per aggirare i controlli (elementi di S assenti in D). Oppure, al contrario, potrà segnalare come pericoloso un contenuto innocuo, perché confonde schemi sbagliati appresi dai dati (M ∩ ¬S).

Quando scalare non basta

Negli ultimi anni, la ricerca ha dimostrato che aumentando le dimensioni dei modelli e la quantità di dati, gli errori diminuiscono secondo regolarità statistiche prevedibili. È la logica che sostiene lo sviluppo dei grandi modelli linguistici.

Tuttavia, scalare non risolve tutto. Fenomeni rari o complessi restano difficili da catturare anche con dataset enormi. Inoltre, se i dati sono sbilanciati o contengono pregiudizi, ampliare la scala significa soltanto amplificarli.

Sistemi dinamici che evolvono con il contesto

La vera sfida è trasformare i modelli da artefatti statici a sistemi dinamici, che evolvono insieme al contesto. Ad esempio, in un abito come la sanità, ciò significa aggiornare i dati ogni volta che emergono nuove scoperte cliniche, così che il modello resti allineato con la pratica medica. Nei social media, significa integrare costantemente esempi di nuove espressioni linguistiche o visuali, per evitare che i sistemi di moderazione diventino obsoleti.

In questo modo, la valutazione dell’IA smette di essere una fotografia della conoscenza raccolta in fase di addestramento, e diventa un vero e proprio ciclo di controllo e miglioramento continuo, che aiuta a mantenere il modello efficace, affidabile e aggiornato.

Analizzare gli errori per sottogruppi

Per andare oltre la semplice valutazione su un test set, è necessario osservare come e dove il modello sbaglia. Ad esempio, non è sufficiente calcolare l’accuratezza media, ma è fondamentale analizzare la frequenza degli errori rispetto a sottogruppi rilevanti nel contesto applicativo. In un sistema di diagnostica medica, si potrebbe scoprire che il modello commette più errori su fasce di età specifiche o su patologie rare. In questi casi, l’errore osservato supera quello atteso in base alla distribuzione dei dati, segnalando potenziali problemi di generalizzazione. Questo tipo di analisi permette di identificare aree critiche in cui intervenire prima che il modello venga impiegato nella pratica reale. Una tipica contromisura è rappresentata dal bilanciamento nella numerosità dei sottogruppi rilevanti, aumentando, eventualmente anche in modo sintetico, i sottogruppi meno rappresentati.

Completezza e rappresentatività dei dati

Un’altra dimensione cruciale riguarda la completezza e la rappresentatività del dataset. I dati di test tradizionali possono essere parziali e non aggiornati, lasciando fuori casi rari ma rilevanti, condizioni ambientali particolari, o variazioni culturali e linguistiche. Misurare la copertura dei dati significa verificare sistematicamente se tutte le condizioni d’uso del modello sono adeguatamente rappresentate nel dataset, utilizzando strumenti di data auditing e metriche di diversità. In questo modo è possibile individuare lacune potenziali e pianificare raccolte dati supplementari. Anche la valutazione della robustezza rispetto a perturbazioni o casi limite è fondamentale: testare il modello con esempi leggermente modificati o più complessi del dataset originale può rivelare vulnerabilità non visibili sul test set.

Monitoraggio continuo in produzione

Un ulteriore passo consiste nell’adottare la divergenza tra distribuzioni (come la KL-divergence) per capire se i dati in produzione si discostano da quelli di addestramento, segnalando potenziali cali di performance. In questo caso i dati raccolti possono provenire dalle esecuzioni del modello in produzione arricchiti dalla raccolta di feedback, impliciti o espliciti, da parte degli utenti del sistema.

Più in generale è importante capire la la valutazione dei sistemi di IA deve diventare un processo dinamico e continuo. Monitorare le prestazioni in produzione permette di rilevare deviazioni rispetto al comportamento atteso e di correggere tempestivamente eventuali errori emergenti. In questo modo, il modello smette di essere una scatola nera statica e si trasforma in un sistema vivente, capace di adattarsi al contesto reale e mantenere affidabilità, equità e utilità nel tempo.