Nel giro di pochi giorni il dibattito tecnico su TPU e GPU è uscito dalle conference room dei data center per finire in prima pagina nei giornali finanziari. La notizia che Meta sta valutando di usare i chip di Google per addestrare e servire i propri modelli di intelligenza artificiale – come già Anthropic da ottobre – ha fatto perdere in poche ore decine di miliardi di capitalizzazione a Nvidia.

E ha riacceso una domanda di fondo: qual è davvero lo stato dell’arte tra GPU e TPU e come sta cambiando l’equilibrio di potere nell’hardware per l’AI.

Ricordiamo che dietro le TPU c’è il successo di Gemini 3, ottimo spot per i chip Google.

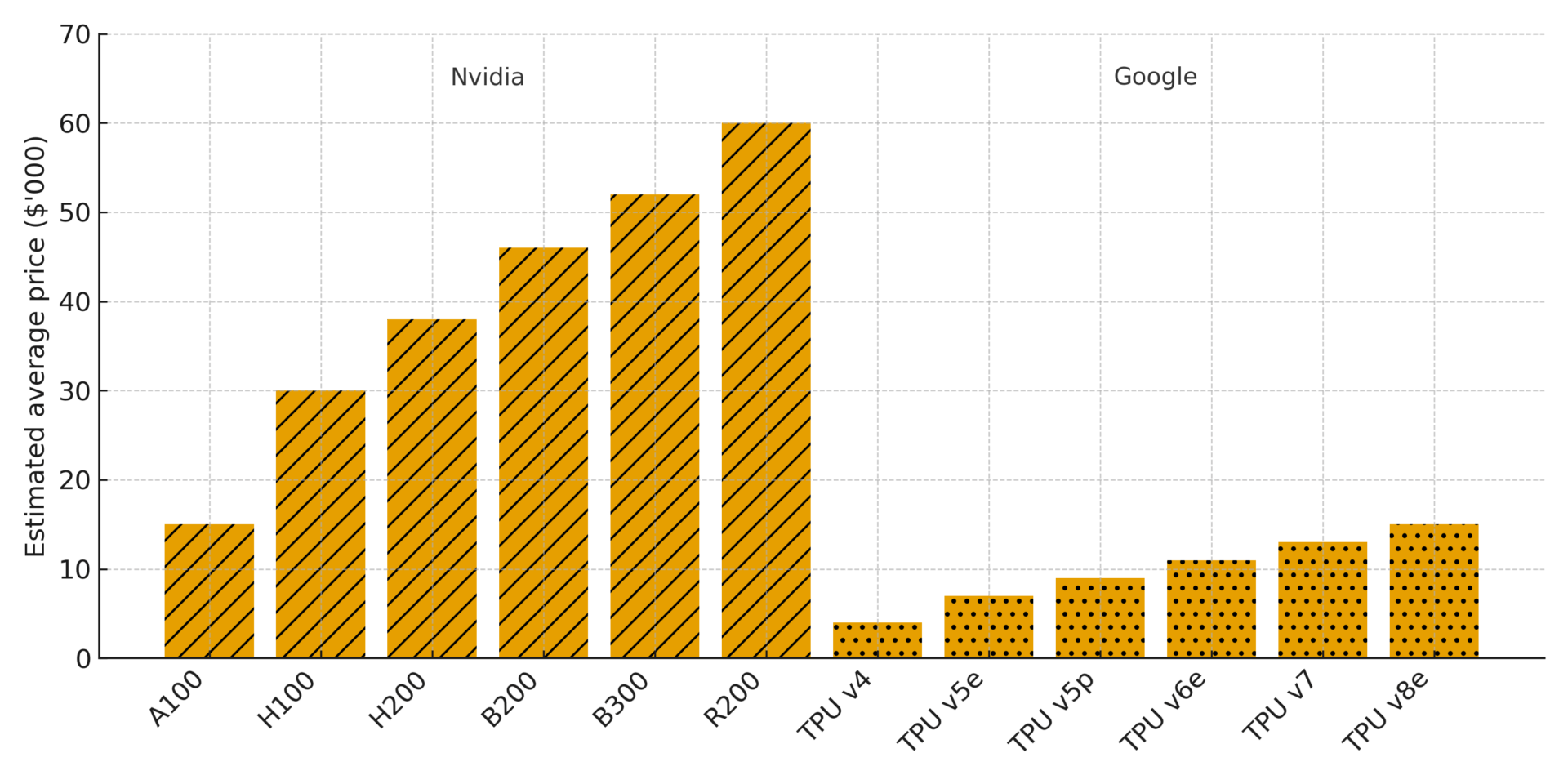

C’è anche da considerare che le TPU sono molto più economiche delle GPU, tra la metà e un decimo.

Bernstein, una società di ricerca sugli investimenti, stima che le GPU di Nvidia rappresentino oltre i due terzi del costo di un tipico rack di server AI.

Per capire che cosa sta succedendo occorre distinguere i livelli. Da un lato c’è l’evoluzione tecnologica degli acceleratori, con GPU sempre più specializzate e TPU ormai mature, arrivate alla quinta generazione. Dall’altro c’è la dimensione strategica, in cui i grandi hyperscaler – Google, Meta, Microsoft, Amazon – cercano di ridurre la dipendenza da Nvidia e di trasformare i propri chip interni in un vantaggio competitivo a tutti gli effetti.

Indice degli argomenti

TPU contro GPU nella nuova guerra dei chip per l’AI

La nuova fase della competizione tra fornitori di hardware per l’AI non si esaurisce in un confronto di specifiche. TPU contro GPU è diventato il simbolo di due approcci diversi: da un lato l’ecosistema GPU di Nvidia, general purpose e dominante, dall’altro le TPU di Google come alternativa specializzata e sempre più aperta. Sullo sfondo, la domanda è se il settore resterà centrato su un solo player o si sposterà verso una pluralità di piattaforme.

Due architetture a confronto tra flessibilità ed efficienza

Le GPU nascono come processori grafici ma, grazie alla struttura fortemente parallela, sono diventate il motore di fatto del deep learning. L’ecosistema costruito da Nvidia intorno a CUDA, alle librerie software e ai server DGX ha trasformato la GPU in una piattaforma general purpose per quasi tutte le fasi della pipeline di AI, dall’addestramento alla messa in produzione.

Le TPU (Tensor Processing Unit) rappresentano un approccio diverso. Sono ASIC, cioè chip progettati su misura, pensati fin dall’origine per eseguire operazioni tensoriali tipiche delle reti neurali. Google ha iniziato a usarle internamente già nella seconda metà degli anni 2010 e oggi le impiega per addestrare e servire modelli come Gemini, offrendo al contempo l’accesso in Google Cloud e, sempre più spesso, valutando la possibilità di installarle direttamente nei data center dei clienti.

In termini molto sintetici, le GPU privilegiano flessibilità e compatibilità con un’ampia varietà di workload, mentre le TPU puntano su efficienza energetica, densità di calcolo e costo per unità di inferenza. Non è una gara in cui esiste un vincitore assoluto, ma una scelta architetturale che dipende da scala, budget e vincoli applicativi.

TPU e GPU nello stato dell’arte del 2025

Sul fronte GPU, il riferimento è oggi la famiglia Blackwell di Nvidia, in particolare il B200 e le varianti per data center affiancate agli H200. Questi chip combinano enormi capacità di calcolo in FP8 e FP16 con memoria ad altissima banda e sono pensati per i modelli generativi di nuova generazione, dove il collo di bottiglia è sempre più spesso il throughput complessivo del cluster e non il singolo dispositivo.

Google, dal canto suo, ha portato sul mercato le TPU v5 nelle varianti v5p per il training ad alta scala e v5e più orientate all’inferenza e ai carichi misti. I benchmark pubblici e quelli pubblicati da terze parti mostrano che, per molti workload transformer, la combinazione di pod di TPU v5p e di una buona ottimizzazione del modello consente prestazioni paragonabili o superiori alle migliori GPU Nvidia, con un vantaggio significativo in termini di consumo energetico e di costo per token elaborato.

È importante notare che il confronto non si gioca solo sul singolo chip. I pod di TPU sono concepiti come “fabbriche di AI” integrate, con rete interna ad altissima velocità e un ambiente software relativamente omogeneo, mentre gli ecosistemi basati su GPU si appoggiano a un ventaglio più ampio di configurazioni, dai server proprietari Nvidia alle istanze cloud di diversi provider. Questo rende le GPU più flessibili ma talvolta meno efficienti dal punto di vista sistemistico.

C’è anche da considerare che molti sviluppatori ormai sono abituati a Cuda. Una barriera all’ingresso per nuovi chip AI.

Gli altri: Aws, Amd

Accanto a Nvidia e Google si stanno affacciando anche altri attori. AWS spinge su Trainium e Inferentia come alternativa interna per i propri clienti, mentre AMD con la serie MI300 cerca di proporsi come seconda fonte credibile di GPU per l’AI. Intel, con Gaudi, tenta di ritagliarsi uno spazio specifico su alcuni workload. Il denominatore comune è chiaro: nessuno vuole dipendere da un unico fornitore di acceleratori, soprattutto quando le roadmap di modelli sempre più grandi richiedono investimenti da decine di miliardi.

Il caso Meta–Google e l’effetto sul mercato degli acceleratori AI

In questo contesto si inserisce la notizia, riportata da più fonti, delle trattative tra Meta e Google per l’adozione delle TPU. Secondo le informazioni circolate, Meta starebbe valutando di spendere decine di miliardi di dollari per usare i chip di Google nei propri data center a partire dalla seconda metà del decennio, integrando al contempo capacità in affitto tramite Google Cloud.

Meta è oggi uno dei maggiori clienti di Nvidia e ha annunciato piani per costruire una delle più grandi infrastrutture GPU al mondo. Il solo fatto che stia considerando seriamente un’alternativa basata su TPU è stato interpretato dal mercato come un segnale inequivocabile che il monopolio di fatto di Nvidia sull’AI ad alte prestazioni sta entrando in una fase nuova.

La reazione di Borsa è stata immediata. Nel giro di una seduta Nvidia ha visto bruciare una quota significativa della propria capitalizzazione, con cali intraday nell’ordine del 5–7 per cento e una perdita secca stimata nell’ordine dei 150 miliardi di dollari di valore. Alphabet, la casa madre di Google, ha invece beneficiato delle indiscrezioni, avvicinandosi ulteriormente a una valutazione da 4.000 miliardi di dollari. Non è solo un rimbalzo di breve periodo, ma il riflesso di un possibile riequilibrio strutturale nel mercato degli acceleratori.

Dal punto di vista tecnico, l’interesse di Meta per le TPU è coerente con il suo profilo di azienda che opera a scala iperplanetaria. Quando si gestiscono migliaia di miliardi di token al giorno tra addestramento continuo, fine-tuning e inferenza di modelli sempre più grandi, anche un miglioramento relativamente modesto nel rapporto prestazioni per watt può tradursi in miliardi di risparmio sull’arco di qualche anno.

Perché le TPU tornano a insidiare il dominio delle GPU

Per qualche tempo le TPU sono state percepite come una tecnologia molto potente ma sostanzialmente confinata all’ecosistema Google. Oggi lo scenario è cambiato. Da un lato, Google ha aperto in modo più deciso le proprie TPU ai clienti cloud, affiancando alla modalità “a consumo” anche offerte più vicine al modello di noleggio su larga scala. Dall’altro, la maturità dello stack software intorno a JAX, XLA e alle integrazioni con framework come PyTorch ha ridotto una parte delle frizioni iniziali per chi arriva dal mondo GPU.

La narrativa che si sta imponendo tra molti architetti di infrastrutture è che le TPU rappresentino un’opzione particolarmente interessante per i grandi carichi di inferenza, dove la forma finale del modello è relativamente stabile e l’obiettivo principale è contenere i costi operativi. Le GPU restano spesso preferite quando si lavora su ricerca di frontiera, modelli in rapida evoluzione o pipeline che richiedono un livello elevato di sperimentazione.

Va però evitata la tentazione di trasformare il confronto in una tifoseria. Nella pratica, i grandi operatori stanno convergendo verso ambienti eterogenei, in cui coesistono GPU Nvidia, TPU, chip interni e, sempre più spesso, acceleratori di altri fornitori. La sfida vera diventa orchestrare in modo intelligente questo zoo di hardware, scegliendo di volta in volta la piattaforma più adatta al task e automatizzando il più possibile il placement dei workload.

Nvidia tra TPU, GPU e narrativa di mercato sugli acceleratori AI

Nvidia, dal canto suo, non sta certo guardando alla finestra. L’azienda continua a ribadire la superiorità del proprio ecosistema, sottolineando come la combinazione di GPU, rete ad altissime prestazioni, software e servizi di supporto costituisca un vantaggio difficilmente colmabile nel breve periodo. A oggi, la quasi totalità dei modelli di punta presentati in ambito accademico e industriale viene ancora addestrata su GPU Nvidia, e l’enorme base installata rende complessa qualsiasi migrazione.

Al tempo stesso, però, la dipendenza del settore da un numero relativamente ristretto di fornitori di chip ha contribuito a gonfiare valutazioni e aspettative. Lo si è visto anche nelle dichiarazioni di Sam Altman, che da un lato celebra la corsa a mettere online milioni di GPU, dall’altro avverte dei rischi di una possibile correzione quando domanda e offerta di calcolo si riequilibreranno e quando l’attenzione degli investitori si sposterà dal solo volume di GPU alla capacità di trasformare quell’hardware in prodotti sostenibili nel tempo.

Per Nvidia la scommessa dei prossimi anni è duplice. Sul piano tecnico deve continuare a mantenere un vantaggio netto in prestazioni assolute e facilità d’uso, spingendo l’integrazione con framework come PyTorch e i nuovi strumenti per l’ottimizzazione automatica di modelli e grafi di calcolo. Sul piano strategico deve dimostrare che la propria piattaforma rimane centrale anche in un mondo in cui Google, AWS, Microsoft e gli altri hyperscaler sviluppano e offrono in parallelo soluzioni hardware proprietarie.

TPU contro GPU nelle scelte di compute e nelle strategie di investimento

Le parole di Sam Altman si inseriscono in questo scenario ad alta volatilità. Negli ultimi mesi il numero uno di OpenAI ha insistito sul fatto che la partita dell’intelligenza artificiale avanzata sarà decisa in larga parte dalla quantità di calcolo disponibile. Ha parlato di obiettivi nell’ordine di milioni di GPU online e, più recentemente, di un orizzonte in cui questa scala potrebbe crescere di due ordini di grandezza. Al tempo stesso, in comunicazioni interne e pubbliche ha riconosciuto che il settore sta entrando in una fase più complessa, fatta di “venti economici contrari” e di una concorrenza sempre più agguerrita, in particolare da parte di Google.

Il messaggio implicito è che la corsa al compute non può proseguire indefinitamente sulla base di valutazioni di Borsa sempre crescenti. A un certo punto la sostenibilità economica delle infrastrutture AI dipenderà dalla capacità di ridurre il costo per unità di intelligenza erogata, cioè di ottenere più calcolo utile per ogni watt consumato e per ogni dollaro speso. Ed è proprio su questo terreno – efficienza, densità, costo per token – che le TPU rivendicano un vantaggio rispetto alle GPU tradizionali.

Per chi lavora in aziende che sviluppano o adottano sistemi di intelligenza artificiale, il messaggio di fondo è meno spettacolare ma più concreto rispetto ai movimenti di Borsa. Il confronto tra GPU e TPU va letto come una scelta di portafoglio e non come una scommessa binaria. Nel breve periodo è difficile immaginare scenari in cui le TPU rimpiazzano completamente le GPU o viceversa. Molto più realistico è un mondo in cui cluster eterogenei coesistono, legati da livelli software che astraggono i dettagli dell’hardware sottostante.

Per i team tecnici questo implica investire su competenze trasversali, capaci di comprendere sia le peculiarità dello stack Nvidia sia quelle degli ambienti TPU e degli altri acceleratori emergenti. Significa progettare pipeline in cui il training sperimentale può avvenire su GPU, mentre l’inferenza massiva o il serving di modelli stabili può migrare su piattaforme più efficienti. E significa, soprattutto, considerare da subito la dimensione del costo totale di proprietà, includendo consumo energetico, complessità di gestione e dipendenza dai fornitori.

Prospettive future: GPU e TPU nella corsa all’AI

L’episodio Meta–Google non è un fulmine a ciel sereno, ma il sintomo di un cambio di fase. Per anni Nvidia ha incarnato quasi da sola la corsa all’hardware per l’AI. Oggi, con TPU mature, chip proprietari dei cloud provider e una competizione sempre più serrata, il baricentro si sposta verso un ecosistema più articolato, in cui nessun attore può dare per scontata la propria posizione.

Sul piano tecnologico, GPU e TPU rappresentano due declinazioni complementari dello stesso obiettivo: fornire la massima quantità di calcolo utile per alimentare modelli sempre più grandi e complessi. Sul piano industriale, la vera domanda è quale combinazione di flessibilità, efficienza e integrazione verticale si rivelerà vincente nei prossimi cinque-dieci anni.

Per chi progetta e utilizza sistemi di AI, la lezione è chiara. Non esiste un acceleratore perfetto in assoluto, ma solo la piattaforma più adatta a un determinato contesto. In un mondo che si avvia verso centinaia di milioni di acceleratori installati, la capacità di scegliere e combinare in modo intelligente GPU, TPU e le altre soluzioni che arriveranno sarà uno dei fattori decisivi per trasformare l’attuale boom dell’AI in valore duraturo.

Bibliografia essenziale

Reuters, “Meta in talks to spend billions on Google’s AI chips, The Information reports”.

The Wall Street Journal, “Meta Is in Talks to Use Google’s Chips in Challenge to Nvidia”.

Corriere della Sera, “Nvidia brucia in Borsa 150 miliardi dopo le trattative Google–Meta sui chip per l’intelligenza artificiale”.

Tom’s Hardware, “Google TPUs garner attention as AI chip alternative, but are only a minor threat to Nvidia’s dominance”.

UncoverAlpha, “The chip made for the AI inference era – the Google TPU”.

CloudOptimo, “TPU vs GPU: What’s the Difference in 2025?”.

Marktechpost, “How Do GPUs and TPUs Differ in Training Large Transformer Models”.

Communications of the ACM, “The Race to 100 Million GPUs”.

Times of India / Economic Times, articoli di approfondimento sulla competizione tra Nvidia e i chip AI di Google.

Analisi e report tecnici su TPU v5, Nvidia Blackwell, AWS Trainium e AMD MI300 pubblicati tra il 2024 e il 2025 su blog e documentazione ufficiale dei rispettivi vendor.