Nel cuore dell’evoluzione digitale dell’Unione Europea, il sistema statistico europeo si sta trasformando da produttore di tabelle a infrastruttura critica per interoperabilità, dati aperti e intelligenza artificiale affidabile.

Facciamo il punto, mettendo in relazione quadro normativo, standard, tecnologie API-first e principi FAIR per mostrare come il Sistema Statistico Europeo (SSE) possa diventare il curatore di un grafo di conoscenza autorevole, al servizio di sovranità digitale, politiche basate sull’evidenza e ecosistemi di IA conformi all’AI Act.

Indice degli argomenti

Il sistema statistico europeo nella strategia digitale dell’UE

La tesi centrale di questo articolo è che la realizzazione degli ambiziosi obiettivi di Interoperabilità europea e, per estensione, dell’intera strategia europea per i dati, dipende in modo critico da un’infrastruttura fondamentale, spesso data per scontata: il Sistema Statistico Europeo (SSE). L’analisi che segue intende ridefinire la percezione del SSE, non più solo come un produttore tradizionale di statistiche, ma anche come il curatore dell’interoperabilità dei dati, indispensabile per la sovranità digitale, le politiche basate sull’evidenza e un ecosistema di IA affidabile.

Ci riferiremo criticamente alle discussioni che hanno avuto luogo in sede europea durante il meeting annuale ENDORSE – The European Data Conference on Reference Data and Semantics, che non hanno riguardato concetti astratti, ma una trasformazione che è già in atto, in modo silenzioso ma potente, all’interno degli uffici statistici europei. La conferenza che si è tenuta a Bruxelles nell’ottobre 2025 ha rappresentato una proficua occasione d’incontro per i professionisti del settore digitale dei dati in Europa. Abbiamo constatato che l’interoperabilità semantica, la gestione della conoscenza, l’elaborazione di politiche “digital-ready” e, soprattutto, l’intersezione critica tra dati di riferimento e intelligenza artificiale non sono più argomenti di confronto ma i pilastri su cui si sta costruendo il futuro digitale del continente. Per i decisori di politiche, comprendere la portata di questa trasformazione non è più un’opzione, ma un imperativo strategico.

Quindi guideremo il lettore attraverso gli aspetti normativi, le trasformazioni tecnologiche e i paradossi strategici che stanno rimodellando l’SSE. Verrà esaminato come la legislazione sui dati aperti abbia fornito un nuovo e potente mandato per la modernizzazione. Si approfondiranno le pipeline digitali, API, standard aperti e Linked Open Data, che stanno rendendo le statistiche europee più dinamiche e accessibili. Verrà analizzato come i principi FAIR stiano fornendo un modello di governance per la fiducia nell’era digitale. Infine, si esplorerà come il paradosso creato dall’avvento e dalla regolamentazione dell’IA rappresenti contemporaneamente una sfida di conformità e un’opportunità per il SSE. Si conclude con una serie di raccomandazioni strategiche per Eurostat, gli Istituti Nazionali di Statistica (INS) e gli utenti dei dati, delineando un percorso per trasformare l’SSE nel pilastro di un ecosistema di dati europeo affidabile e innovativo.

Il sistema statistico europeo nella strategia digitale europea

Il Sistema Statistico Europeo (SSE) è definito come una partnership tra l’ufficio statistico dell’Unione Europea, Eurostat, e gli Istituti Nazionali di Statistica (INS) o altre autorità nazionali responsabili in ciascuno Stato membro dell’UE per lo sviluppo, la produzione e la diffusione delle statistiche europee. Questa partnership include anche i paesi dell’Associazione Europea di Libero Scambio (EFTA). Il SSE funziona come una rete, in cui Eurostat svolge un ruolo di primo piano nell’armonizzazione delle statistiche, in stretta collaborazione con le autorità statistiche nazionali.

La base giuridica che governa il sistema è il Regolamento (CE) n. 223/2009, noto informalmente come la “Legge statistica”, che stabilisce il quadro per lo sviluppo, la produzione e la diffusione delle statistiche europee. La missione fondamentale del SSE è fornire statistiche europee affidabili, comparabili e di alta qualità che supportino l’elaborazione delle politiche dell’UE, le decisioni amministrative e la conoscenza pubblica.

Questo obiettivo richiede un complesso sforzo di coordinamento per superare le barriere poste dalle diverse lingue, dalle diverse forme di organizzazione amministrativa e dalle specifiche classificazioni nazionali. Sebbene la pianificazione delle attività sia condotta congiuntamente, la produzione di statistiche nazionali armonizzate è responsabilità dei singoli Stati membri, mentre Eurostat raccoglie i dati forniti, li analizza e garantisce la loro coerenza e qualità a livello europeo.

Il SSE coordina inoltre il suo lavoro con organizzazioni internazionali come l’OCSE, le Nazioni Unite, il Fondo Monetario Internazionale e la Banca Mondiale, al fine di promuovere l’armonizzazione statistica a livello globale. Il modello federato del SSE rappresenta contemporaneamente un punto di forza e una sfida. Sfruttando la profonda competenza e la conoscenza del contesto locale degli INS, il sistema garantisce che le statistiche siano ben radicate nelle realtà nazionali. Tuttavia, questa stessa struttura decentralizzata introduce una notevole complessità e il potenziale per un’adozione disomogenea delle tecnologie e delle metodologie tra i vari Stati membri.

Il mandato per la qualità e la comparabilità

Al centro dell’impegno del SSE per l’eccellenza vi è il “Codice delle statistiche europee”. Questo codice, che comprende 16 principi, funge da quadro di riferimento per la garanzia di qualità, assicurando che le statistiche ufficiali siano prodotte in modo indipendente da interferenze politiche e in conformità con metodi scientifici riconosciuti in tutti gli Stati membri. I principi coprono l’intero processo statistico, dal quadro istituzionale alla produzione e alla diffusione, garantendo aspetti come l’indipendenza professionale, la riservatezza, l’affidabilità, la tempestività, l’accessibilità e la comparabilità.

Una solida struttura di governance istituzionale sostiene l’applicazione di questo codice. Il “Comitato del sistema statistico europeo” (ESSC – European Statistical System Committee), composto dai presidenti degli INS e dal Direttore Generale di Eurostat, è l’organo strategico principale che fornisce orientamenti professionali per la pianificazione, la produzione e la diffusione delle statistiche europee.

Per garantire che le esigenze degli utenti siano prese in considerazione, è stato istituito il “Comitato consultivo statistico europeo” (ESAC – European Statistical Advisory Committee), che rappresenta utenti, intervistati, istituzioni scientifiche e sociali e l’amministrazione comunitaria. Inoltre, il “Comitato consultivo sulla governance statistica europea” (ESGAB – European Statistical Governance Advisory Board) svolge un ruolo di supervisione indipendente, consigliando la Commissione sull’applicazione del codice delle statisticiche europee e presentando relazioni annuali al Parlamento Europeo e al Consiglio.

Un ruolo in evoluzione, da compilatore di dati a pilastro della strategia europea per i dati

Il ruolo del SSE sta subendo una profonda trasformazione, evolvendo da quello di semplice compilatore di statistiche a quello di componente critico della più ampia strategia europea per i dati. Questa evoluzione è guidata da una crescente domanda da parte degli utenti di dati più granulari, più tempestivi e più facilmente accessibili per rispondere a nuove sfide sociali ed economiche.

L’agenda per l’innovazione del SSE riflette questo orientamento al futuro, con l’obiettivo di modernizzare i processi e i prodotti statistici per soddisfare queste nuove esigenze. In un ecosistema di dati sempre più affollato, in cui abbondano fonti di informazione di qualità variabile, il SSE si posiziona come fornitore di dati autorevoli e affidabili.

La sua adesione a rigorosi principi di qualità e indipendenza lo rende un punto di riferimento essenziale, in grado di fornire la base fattuale per il processo decisionale basato sull’evidenza. Il progresso sistemico dell’intero SSE nell’adozione di tecnologie avanzate, come il Linked Open Data o la produzione di dati aiutata dall’IA, è tuttavia condizionato dalla capacità degli INS tecnologicamente meno avanzati.

Questa realtà rende necessarie iniziative centralizzate e dall’alto verso il basso per lo sviluppo delle capacità e la promozione di strumenti e infrastrutture condivise. Senza un sostegno centralizzato, come dimostrano i recenti finanziamenti di Eurostat per progetti specifici degli INS, l’adozione di nuove tecnologie sarebbe disomogenea, minando l’obiettivo fondamentale di armonizzazione e compromettendo l’integrità del sistema nel suo percorso di modernizzazione.

I 16 principi del codice delle statistiche europee

Il codice delle statistiche europee stabilisce 16 principi per garantire la fiducia e la qualità delle statistiche ufficiali. È stato originariamente adottato il 24 febbraio 2005. Tuttavia, in quella prima versione, i principi erano 15. La versione attuale del codice, che comprende tutti e 16 i principi, è il risultato di una revisione successiva.

La modifica più significativa, con l’introduzione del principio “1bis” sul coordinamento e la cooperazione, è stata adottata il 16 novembre 2017. I principi sono suddivisi in tre aree principali: contesto istituzionale, processi statistici e produzione statistica.

Contesto istituzionale

Questi principi riguardano l’indipendenza e la solidità del quadro istituzionale e giuridico delle autorità statistiche.

- Principio 1, indipendenza professionale. L’indipendenza professionale delle autorità statistiche da altre istituzioni e organi politici, nonché da operatori del settore privato, garantisce la credibilità delle statistiche europee.

- Principio 1bis, coordinamento e cooperazione. Le autorità statistiche nazionali e l’autorità statistica dell’Unione (Commissione – Eurostat) assicurano il coordinamento delle attività per la produzione delle statistiche europee, al fine di garantirne la coerenza e la comparabilità.

- Principio 2, mandato per la rilevazione dei dati e accesso ai dati. Le autorità statistiche dispongono di un chiaro mandato giuridico per la rilevazione di informazioni e per l’accesso ai dati amministrativi per finalità statistiche.

- Principio 3, adeguatezza delle risorse. Le risorse a disposizione delle autorità statistiche sono sufficienti per soddisfare i requisiti della statistica europea.

- Principio 4, impegno per la qualità. Le autorità statistiche si impegnano a garantire la qualità, definendo e rendendo pubbliche le politiche e le procedure per la gestione e il miglioramento della qualità del loro lavoro.

- Principio 5, riservatezza statistica e protezione dei dati. È assolutamente garantita la privacy dei fornitori di dati (famiglie, imprese, amministrazioni e altri rispondenti), la riservatezza delle informazioni da essi fornite e il loro utilizzo esclusivo a fini statistici, nonché la protezione dei dati.

- Principio 6, imparzialità e obiettività. Le autorità statistiche sviluppano, producono e diffondono le statistiche europee nel rispetto dei principi di neutralità scientifica, imparzialità e obiettività, trattando tutti gli utenti in modo equo.

Processi statistici

Questi principi si concentrano sulla qualità dei processi utilizzati per produrre le statistiche.

- Principio 7, metodologia rigorosa. Una metodologia rigorosa è alla base della qualità delle statistiche e richiede strumenti, procedure e competenze adeguati.

- Principio 8, procedure statistiche appropriate. Procedure statistiche appropriate, attuate dall’acquisizione dei dati alla loro convalida, sostengono la qualità delle statistiche prodotte.

- Principio 9, onere non eccessivo per i rispondenti. L’onere statistico è proporzionato alle necessità degli utenti e non eccessivo per i rispondenti.

- Principio 10, efficienza dei costi. Le risorse devono essere utilizzate in modo efficiente.

Produzione statistica

Questi principi descrivono la qualità dell’output statistico, ovvero i dati stessi.

- Principio 11, pertinenza. Le statistiche europee soddisfano le esigenze degli utenti.

- Principio 12, accuratezza e affidabilità. Le statistiche europee rispecchiano in modo accurato e affidabile la realtà.

- Principio 13, tempestività e puntualità. Le statistiche europee sono diffuse in modo tempestivo e puntuale.

- Principio 14, coerenza e comparabilità. Le statistiche europee sono coerenti a livello interno, nel tempo e comparabili tra le diverse regioni e paesi.

- Principio 15, accessibilità e chiarezza. Le statistiche europee sono presentate in una forma chiara e comprensibile, diffuse in modo idoneo e comodo, sono disponibili e accessibili a tutti, sulla base del principio di imparzialità.

Dati aperti e sistema statistico europeo: quadro giuridico e HVD

La spinta verso una maggiore accessibilità e riutilizzo dei dati del settore pubblico nell’Unione Europea è sancita dalla direttiva UE 2019/1024, nota come “Direttiva sui dati aperti”. Sostituendo la precedente direttiva sull’informazione del settore pubblico, questa legislazione stabilisce un quadro giuridico comune per un mercato europeo dei dati detenuti dai governi, basato sui pilastri chiave del mercato interno: trasparenza, concorrenza leale e libero flusso dei dati.

La direttiva incoraggia gli Stati membri a rendere disponibile per il riutilizzo la maggiore quantità possibile di informazioni, coprendo un’ampia gamma di materiali, tra cui testi scritti, banche dati, file audio e frammenti di film. L’obiettivo principale è sbloccare il potenziale economico e sociale dei dati pubblici, facilitando lo sviluppo di servizi innovativi e nuovi modelli di business.

Le statistiche come “dataset di elevato valore” (HVD)

Un’innovazione fondamentale della direttiva sui dati aperti è l’introduzione del concetto di “dataset di elevato valore” (High-Value Datasets, HVD). Si tratta di documenti il cui riutilizzo è associato a importanti benefici per la società e l’economia. La direttiva identifica sei categorie tematiche di HVD, e le “statistiche” sono esplicitamente una di queste, insieme a dati geospaziali, di osservazione della terra e ambientali, meteorologici, sulle imprese e sulla mobilità.

Questa designazione non è puramente simbolica, ma impone una serie di requisiti più stringenti per la loro diffusione. Dal 9 giugno 2024 si applica il Regolamento di esecuzione (UE) 2023/138 sugli HVD, che impone disponibilità gratuita, formati machine-readable, API e, ove rilevante, download massivo.

La designazione delle statistiche come HVD agisce come un potente catalizzatore legale e politico per la modernizzazione. Fornisce a Eurostat e agli INS un mandato chiaro per investire e dare priorità allo sviluppo di API e formati leggibili meccanicamente, accelerando la loro transizione da editori di dati tradizionali a moderni fornitori di servizi di dati.

Il portale europeo dei dati, un gateway centrale

Il principale punto di accesso per la scoperta e il reperimento dei dati aperti europei è il portale ufficiale data.europa.eu. Questa piattaforma funge da repository pan-europeo per le informazioni del settore pubblico, offrendo un unico punto di accesso in tutte le 24 lingue ufficiali dell’UE per i dati pubblicati dalle amministrazioni pubbliche a tutti i livelli di governo.

Il portale data.europa.eu aggrega metadati in DCAT-AP/RDF ed espone un endpoint SPARQL pubblico per interrogazioni machine-to-machine (https://data.europa.eu/sparql/) di oltre 1,9 milioni di dataset, compresi quelli delle istituzioni e agenzie dell’UE come Eurostat e quelli degli Stati membri.

Per favorire la comparabilità e l’interoperabilità transfrontaliera, il portale presenta i riferimenti dei metadati in un formato comune (il profilo applicativo DCAT per i portali di dati in Europa), utilizzando la tecnologia RDF (Resource Description Framework). Inoltre, il portale ospita una sezione dedicata ai dataset di elevato valore e un’accademia di formazione che offre materiali su come riutilizzare i dati aperti, promuovendo così una comunità di utenti più informata e competente.

L’obbligo, imposto dalla direttiva, di fornire accesso tramite API e download massivi aumenterà drasticamente il volume e la velocità del consumo programmatico dei dati. Man mano che i sistemi automatizzati diventeranno i principali consumatori dei dati del SSE, i limiti di un’interoperabilità puramente sintattica, come un file CSV privo di metadati ricchi, diventeranno un collo di bottiglia significativo.

Questo cambiamento nei modelli di consumo, guidato dalla tecnologia, creerà una domanda urgente e guidata dagli utenti per metadati avanzati e soluzioni semantiche, ponendo le basi per la necessità di un’infrastruttura di dati più intelligente e auto-descrittiva.

Gateway tecnologici per l’accesso alle statistiche europee

Sezione 3 – Gateway tecnologici alle statistiche europee

3.1 L’approccio “API first”, accesso programmatico e automazione

In linea con il mandato sui dati aperti e la designazione come HVD, Eurostat ha implementato una strategia di diffusione “API first”, offrendo una suite di servizi web REST per consentire l’accesso programmatico ai suoi dati. Questo approccio segna un passaggio fondamentale dalla semplice pubblicazione di tabelle e file scaricabili alla fornitura di dati come servizio, consentendo a ricercatori, giornalisti, sviluppatori e imprese di integrare le statistiche europee aggiornate direttamente nei loro flussi di lavoro e applicazioni.

La suite di API di Eurostat è segmentata per soddisfare le diverse esigenze degli utenti:

- Statistics API: progettate per la continuità con i precedenti servizi web, queste API forniscono dati nel formato JSON-stat 2.0, ottimizzato per l’uso in strumenti di visualizzazione e applicazioni web. Offrono un accesso semplice e diretto a sottoinsiemi di dati e sono disponibili in inglese, francese e tedesco.

- SDMX 3.0/2.1 API: queste sono le API principali per i professionisti dei dati e gli statistici. Basate sullo standard Statistical Data and Metadata Exchange (SDMX), consentono query complesse e personalizzate non solo per i dati, ma anche per i metadati strutturali che li descrivono (ad esempio, definizioni delle dimensioni, liste di codici). Supportano una varietà di formati di output, tra cui SDMX-ML (XML), SDMX-CSV, JSON-stat e TSV (Tab-Separated Values), offrendo la massima flessibilità per l’integrazione in flussi di lavoro statistici automatizzati.

- Catalogue API: queste API sono dedicate specificamente alla scoperta programmatica dei dataset. Permettono agli utenti di interrogare il catalogo di Eurostat per trovare i dataset disponibili, i loro codici identificativi e le informazioni di base, facilitando l’automazione del processo di ricerca dei dati.

- Bulk/Files: canale file per automazione (https://ec.europa.eu/eurostat/api/dissemination/files).

L’uso di queste API abilita scenari potenti, come la creazione di script per scaricare periodicamente dati aggiornati per un cruscotto aziendale o per un modello di ricerca, eliminando la necessità di ripetere manualmente il processo di download attraverso un’interfaccia web.

3.2 Tessere la rete dei dati, Linked Open Data

Oltre all’accesso tramite API, il SSE sta esplorando il paradigma del Linked Open Data (LOD) per creare una rete di dati più interconnessa e semanticamente ricca. Il LOD si basa sui principi del web semantico, utilizzando tecnologie standard come il Resource Description Framework (RDF) per descrivere i dati come un grafico di triple (soggetto-predicato-oggetto), gli Uniform Resource Identifier (URI) per identificare in modo univoco ogni entità (ad esempio, un paese, un indicatore, un’osservazione) e il linguaggio di interrogazione SPARQL per interrogare questi grafici di dati distribuiti.

Eurostat pubblica in RDF e interroga via SPARQL soprattutto le proprie classificazioni e liste di codici attraverso la piattaforma ShowVoc e il triple store Cellar dell’Ufficio delle pubblicazioni; per i dati statistici RDF sono disponibili endpoint SPARQL di terze parti istituzionali come quello dell’Agenzia europea dell’ambiente (Eionet). Alcuni esempi sono: ShowVoc/Cellar per classificazioni; SPARQL EEA (http://semantic.eea.europa.eu/sparql) per dataset RDF derivati da Eurostat; SPARQL di data.europa.eu per i metadati DCAT-AP.

Il vero potere di questo approccio risiede nella capacità di eseguire query SPARQL che attraversano questi collegamenti. Ad esempio, un utente potrebbe interrogare un endpoint SPARQL per trovare tutti i paesi dell’UE con un PIL pro capite superiore a una certa soglia (dati Eurostat) e recuperare contemporaneamente la loro popolazione e capitale da DBpedia, il tutto con un’unica query, senza la necessità di scaricare e unire manualmente file separati.

Endpoint SPARQL, come quello fornito da data.europa.eu o dall’Agenzia europea dell’ambiente, fungono da gateway per questo tipo di interrogazione avanzata e integrazione di dati inter-dominio. L’esistenza di molteplici API e di vari endpoint SPARQL non costituisce una ridondanza, ma piuttosto una sofisticata strategia di diffusione segmentata.

Questa strategia è progettata per soddisfare diverse comunità di utenti con competenze tecniche e necessità eterogenee: dagli sviluppatori web che necessitano di semplici file JSON, agli statistici che richiedono le strutture SDMX complete, fino ai data scientist che esplorano i grafi RDF. Tuttavia, questa strategia di diffusione multicanale crea una sfida tecnica e di governance significativa: garantire che i dati sottostanti e, soprattutto, i metadati (definizioni, liste di codici, classificazioni) siano perfettamente sincronizzati su tutti gli endpoint.

Una modifica a un concetto statistico deve essere propagata istantaneamente e in modo coerente al Data Browser, a tutti i formati API e alle triple RDF. Ciò richiede un sistema di gestione dei metadati robusto, centralizzato e leggibile meccanicamente come “unica fonte di verità”, il che sottolinea l’importanza di standard come SDMX e la necessità di ontologie formali.

Ontologie, SDMX e metadati per un sistema statistico europeo semantico

Perché i dati siano veramente interoperabili, non è sufficiente che siano accessibili in formati leggibili meccanicamente: devono essere accompagnati da metadati ricchi che ne descrivano la struttura, il contesto e il significato. Nel mondo delle statistiche ufficiali, lo standard de facto per questo scopo è lo Statistical Data and Metadata Exchange (SDMX).

Patrocinato da organizzazioni internazionali tra cui Eurostat, l’FMI e la Banca Mondiale, SDMX fornisce un modello informativo comune per descrivere i dati statistici. Il cuore del modello SDMX è la definizione della struttura dei dati (Data Structure Definition, DSD), che agisce come un “meta-modello” per un dataset.

La DSD definisce le dimensioni (ad esempio, paese, sesso, anno), le misure (l’osservazione, come il tasso di disoccupazione) e gli attributi (informazioni aggiuntive, come lo stato di confidenzialità di un dato). Ogni dimensione è legata a un concetto definito in uno schema di concetti e i suoi valori consentiti sono spesso elencati in una lista di codici (ad esempio, una lista di codici paese standardizzati).

Questo approccio garantisce che i dati scambiati tra le organizzazioni abbiano una struttura coerente e non ambigua, abilitando l’interoperabilità sintattica e strutturale. L’evoluzione dello standard alla versione 3.0, rilasciata nel settembre 2021, rappresenta un passo significativo verso una maggiore ricchezza semantica e una modernizzazione.

Le principali novità includono: un modello semplificato per metadati di riferimento, il supporto a microdati (multi-measure, array), il supporto geospaziale, alcune estensioni a codelist e mapping, miglioramenti a gerarchie/constraint, il versioning semantico e API REST aggiornate.

Queste nuove funzionalità posizionano SDMX 3.0 non solo come uno standard per lo scambio di dati, ma come una base fondamentale per la gestione della governance dei dati e per l’implementazione dei principi FAIR.

Per precisione, nel maggio 2025 è stata rilasciata la revisione minore la 3.1 che introduce come novità principale il supporto per le “Data Structure Definitions (DSD) orizzontalmente complesse”, che consentono di definire strutture di dati in cui la presenza e la rilevanza di alcune dimensioni dipendono dal valore di una dimensione “discriminante”.

Oltre la sintassi, affrontare la “semantica non utilizzata” con le ontologie

Nonostante la sua potenza, SDMX da solo non risolve completamente il problema della “semantica non utilizzata”. Questo problema si verifica quando i dati sono leggibili meccanicamente (un computer può analizzare il file) ma non sono comprensibili meccanicamente (il computer non “intende” il significato dei concetti).

Ad esempio, un’API SDMX può restituire che per la dimensione GEO il valore è BE. Un essere umano sa che BE significa Belgio, ma per una macchina, BE è solo una stringa di due caratteri. Per ottenere una vera interoperabilità semantica, questa stringa deve essere collegata in modo inequivocabile al concetto di “Regno del Belgio”.

È qui che entrano in gioco le tecnologie del web semantico, come le ontologie e i vocabolari controllati. Un’ontologia definisce formalmente un insieme di concetti e le relazioni tra di essi in un particolare dominio.

Mappando gli artefatti SDMX secondo gli standard del web semantico si può colmare il divario semantico. Ad esempio, una lista di codici SDMX (come la lista dei paesi) può essere rappresentata come un vocabolario SKOS (Simple Knowledge Organization System), dove ogni codice diventa un concetto con etichette in più lingue, definizioni e relazioni gerarchiche.

Precisamente, il codice BE può essere collegato tramite una relazione skos:exactMatch o owl:sameAs all’URI corrispondente in un’ontologia geografica autorevole come GeoNames. Questo processo trasforma i dati da tabelle isolate a nodi in un grafo di conoscenza globale.

Una macchina può quindi seguire questi collegamenti per inferire nuove informazioni, ad esempio, che il Belgio è un membro dell’Unione Europea, si trova in Europa occidentale e confina con Francia e Germania, semplicemente interrogando il grafo di conoscenza collegato.

Questo sblocca la capacità di integrare i dati statistici con dataset non statistici su larga scala e in modo completamente automatizzato. SDMX 3.0, con le sue funzionalità migliorate e il suo modello informativo più robusto, può essere visto come un ponte cruciale tra il mondo tradizionale delle statistiche ufficiali e il moderno mondo del web semantico e del Linked Open Data.

Il vero valore delle statistiche europee nel XXI secolo non sarà realizzato analizzandole isolatamente, ma integrandole con altri domini di dati. Questa integrazione è impossibile su larga scala senza risolvere il problema semantico. Definendo formalmente i suoi concetti e collegandoli a ontologie esterne, il SSE può trasformare i suoi dati da una semplice risorsa per lo spazio europeo dei dati a una spina dorsale semantica, fornendo le definizioni autorevoli e affidabili rispetto alle quali altri dati possono essere confrontati e integrati.

Principi FAIR e governance dei dati nel sistema statistico europeo

I principi FAIR, pubblicati per la prima volta nel 2016, forniscono un insieme di linee guida per migliorare la reperibilità (findability), l’accessibilità (accessibility), l’interoperabilità (interoperability) e il riutilizzo (reusability) degli asset digitali. Questi principi non sono uno standard prescrittivo, ma un quadro concettuale che enfatizza l’azionabilità meccanica, ovvero la capacità dei sistemi computazionali di trovare, accedere, interoperare e riutilizzare i dati con un intervento umano minimo o nullo.

Per il SSE, l’adozione di questi principi è un obiettivo strategico esplicito per modernizzare la diffusione dei dati. Analizziamo ogni principio nel contesto del SSE.

Reperibilità (Findability)

I dati e i metadati devono essere facili da trovare sia per gli esseri umani che per le macchine. Ciò si ottiene attraverso:

- F1: assegnazione di identificatori univoci e persistenti (PID) a (meta)dati; Eurostat assegna DOI (Digital Object Identifier) ai dataset/microdati nel Data Browser (es. microdati EU-LFS: DOI 10.2907/LFS1983-2023) e fornisce linee guida di citazione.

- F2: descrizione dei dati con metadati ricchi, un’area in cui l’SSE eccelle grazie a standard come SDMX.

- F3: inclusione esplicita dell’identificatore dei dati nei metadati.

- F4: registrazione o indicizzazione di (meta)dati in una risorsa ricercabile, come il portale data.europa.eu.

Accessibilità (Accessibility)

Una volta trovati, i (meta)dati devono essere recuperabili. Ciò si ottiene attraverso:

- A1: i (meta)dati sono recuperabili tramite il loro identificatore utilizzando un protocollo di comunicazione standardizzato e aperto (ad esempio, HTTP, implementato attraverso le API di Eurostat).

- A1.2: il protocollo consente procedure di autenticazione e autorizzazione, se necessario. Questo è fondamentale per il SSE, che deve gestire dati sensibili e confidenziali.

- A2: i metadati rimangono accessibili anche quando i dati non sono più disponibili, garantendo una traccia storica.

Interoperabilità (Interoperability)

I dati devono poter essere integrati con altri dati e interoperare con applicazioni per l’analisi. Ciò si ottiene attraverso:

- I1: i (meta)dati utilizzano un linguaggio formale, accessibile, condiviso e ampiamente applicabile per la rappresentazione della conoscenza. SDMX è il linguaggio primario per il SSE, con RDF e ontologie che rappresentano il livello successivo di maturità.

- I2: i (meta)dati utilizzano vocabolari che seguono i principi FAIR (ad esempio, liste di codici standardizzate e referenziabili).

- I3: i (meta)dati includono riferimenti qualificati ad altri (meta)dati, creando una rete di conoscenza interconnessa.

Riutilizzo (Reusability)

L’obiettivo finale è ottimizzare il riutilizzo dei dati. Ciò si ottiene attraverso:

- R1: i (meta)dati sono riccamente descritti con una pluralità di attributi accurati e pertinenti.

- R1.1: i (meta)dati sono rilasciati con una licenza d’uso chiara e accessibile, come la CC BY 4.0 richiesta per gli HVD.

- R1.2: i (meta)dati sono associati a una provenienza dettagliata, essenziale per la fiducia nelle statistiche ufficiali.

- R1.3: i (meta)dati soddisfano gli standard comunitari pertinenti al dominio, come il Codice delle statistiche europee.

Dai principi all’infrastruttura, implementare la “FAIRness” nel SSE

La transizione dai principi FAIR alla pratica richiede investimenti strategici in infrastrutture e metodologie. Il progetto pilota dell’European Social Survey (ESS) all’interno dell’iniziativa SSHOC (Social Sciences & Humanities Open Cloud) offre un caso di studio concreto.

Questo progetto ha implementato un repository integrato di dati e metadati conforme ai principi FAIR, utilizzando soluzioni software moderne come Colectica per la gestione dei metadati e l’infrastruttura cloud di Azure per l’archiviazione. L’accesso ai repository avviene tramite API, consentendo un flusso di lavoro efficiente, collaborativo e versionato per l’elaborazione, la documentazione e la pubblicazione di dati e metadati.

Questo approccio dimostra come l’uso di vocabolari controllati e API robuste possa migliorare significativamente la reperibilità, l’accessibilità e l’interoperabilità dei dati di indagine transnazionali.

I principi FAIR non rappresentano uno standard concorrente, ma un quadro strategico di alto livello che unifica e dà uno scopo ai vari sforzi di modernizzazione all’interno del SSE. L’investimento in API, l’evoluzione di SDMX, la spinta verso licenze aperte e l’esplorazione del LOD possono essere tutti razionalizzati e allineati sotto l’obiettivo comune di rendere le statistiche europee più FAIR.

Tuttavia, una sfida critica per il SSE nell’implementazione dei principi FAIR è la gestione della tensione intrinseca tra il principio di accessibilità e i requisiti legali ed etici della riservatezza statistica. Sebbene i principi FAIR consentano un accesso limitato (“aperto quanto possibile, chiuso quanto necessario”), l’implementazione di questo concetto per le statistiche ufficiali richiede un’architettura tecnica altamente sofisticata con meccanismi di autenticazione e autorizzazione robusti e standardizzati.

Il futuro dell’approccio FAIR per il SSE risiede nella costruzione di sistemi in grado di servire metadati completamente aperti gestendo al contempo un accesso stratificato ai dati sottostanti, dai file per uso pubblico all’accesso remoto sicuro per ricercatori accreditati.

Intelligenza artificiale, regolazione e nuovi usi dei dati ufficiali

L’avvento dell’intelligenza artificiale (IA) e del machine learning (ML) ha creato una domanda insaziabile di dati di alta qualità per l’addestramento, la validazione e il test dei modelli. Le statistiche ufficiali prodotte dal SSE rappresentano una risorsa di prim’ordine per questo scopo.

La loro coerenza metodologica, la garanzia di qualità, la copertura temporale e la comparabilità internazionale le rendono un benchmark inestimabile per lo sviluppo di sistemi di IA in campi come l’economia, le scienze sociali e la modellizzazione delle politiche pubbliche.

L’adozione crescente di tecnologie di IA da parte delle imprese dell’UE testimonia una domanda in rapida espansione di dati affidabili per alimentare questi sistemi: nel 2024, il 13,5% delle imprese dell’UE con almeno 10 addetti ha utilizzato tecnologie di IA (8,0% nel 2023; +5,5 p.p.). L’uso è nettamente più alto nelle grandi imprese: 41% nel 2024 (contro circa 13% per le PMI).

L’IA come produttore, innovare la produzione statistica

Oltre a essere una risorsa per l’IA, l’IA stessa sta diventando uno strumento per innovare la produzione statistica. Gli INS stanno iniziando a esplorare e implementare tecniche di IA, in particolare il machine learning e l’elaborazione del linguaggio naturale (NLP), per automatizzare processi, migliorare l’efficienza e sfruttare nuove fonti di dati.

Un esempio emblematico è l’iniziativa “Trusted Smart Statistics” di Eurostat, che finanzia progetti degli INS per integrare dati raccolti dal web nelle statistiche ufficiali. Progetti specifici si concentrano sugli annunci di lavoro online (online job advertisements, OJA): diversi INS (Spagna, Croazia, Ungheria, Paesi Bassi, Polonia) stanno utilizzando tecniche di web scraping e NLP per raccogliere e classificare annunci di lavoro, estraendo informazioni ad alta frequenza sulle offerte di lavoro e sulle competenze richieste, che completano le indagini tradizionali sulle offerte di lavoro.

Altri progetti riguardano le caratteristiche delle imprese basate sul web (online-based enterprise characteristics, OBEC): INS come Danimarca, Paesi Bassi, Austria e Polonia stanno utilizzando il ML per estrarre informazioni dai siti web aziendali (ad esempio, presenza di e-commerce, link di proprietà) per arricchire i registri statistici delle imprese. Queste iniziative sono sviluppate nel Web Intelligence Hub (https://cros.ec.europa.eu/win) e OJA pubblica già statistiche sperimentali.

Queste iniziative, spesso etichettate come “statistiche sperimentali”, dimostrano il potenziale dell’IA per fornire approfondimenti più tempestivi e granulari rispetto ai metodi basati su indagini tradizionali, sebbene pongano nuove sfide in termini di qualità e metodologia.

Alcuni INS stanno anche sperimentando l’uso dell’IA generativa e di quella agentica per la consultazione e la costruzione di vocabolari controllati, di ontologie e di schemi dati Open API, per semplificare e velocizzare la produzione di semantica, necessaria per l’interoperabilità dei dati.

La legge sull’IA, governance dei dati e conformità

L’entusiasmo per l’IA è controbilanciato dalla necessità di un quadro normativo che ne garantisca un uso etico e affidabile. La legge sull’IA nell’UE (AI Act) è la prima regolamentazione completa al mondo in questo campo e adotta un approccio basato sul rischio, classificando i sistemi di IA in quattro categorie: rischio inaccettabile (che è vietato), alto rischio, rischio limitato e rischio minimo.

La maggior parte degli obblighi normativi ricade sui sistemi ad alto rischio, che includono sistemi utilizzati in settori critici come l’istruzione, l’occupazione, l’accesso a servizi essenziali, l’applicazione della legge e le infrastrutture critiche.

Per le organizzazioni che desiderano utilizzare i dati del SSE per addestrare un sistema di IA ad alto rischio (ad esempio, un sistema per la valutazione del merito creditizio o per la selezione di candidati a un posto di lavoro), l’AI Act impone requisiti stringenti, in particolare attraverso l’articolo 10, dati e loro governance.

Questo articolo stabilisce che i set di dati di addestramento, validazione e test per i sistemi ad alto rischio devono soddisfare criteri di qualità rigorosi. Devono essere soggetti a pratiche di governance dei dati che ne garantiscano la rilevanza, la rappresentatività e la completezza; i dati devono essere adeguati allo scopo previsto e riflettere le caratteristiche della popolazione su cui il sistema di IA sarà utilizzato; deve essere garantita l’assenza di errori, i dati devono essere, per quanto possibile, privi di errori; e infine è richiesto l’esame dei bias, i set di dati devono essere esaminati per individuare possibili distorsioni che potrebbero portare a discriminazioni o avere un impatto negativo sui diritti fondamentali.

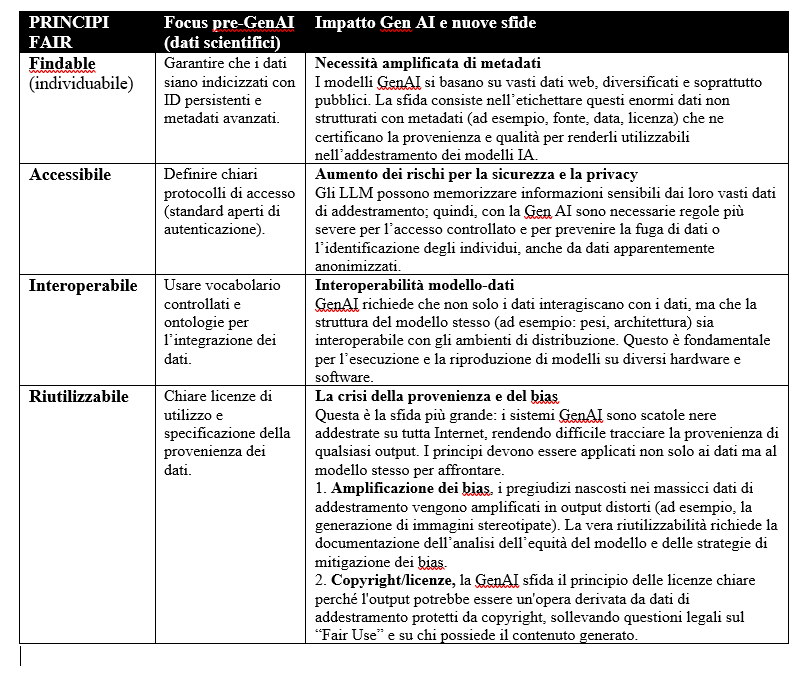

Devono essere adottate misure appropriate per rilevare, prevenire e mitigare tali bias. I principi FAIR devono essere leggermente modificati per accogliere le conseguenze della diffusione dei sistemi GenAI. La tabella seguente riassume alcune considerazioni.

Questi requisiti creano una nuova dinamica. La direttiva sui dati aperti spinge per la massima diffusione e riutilizzo dei dati. La legge sull’IA pone un contrappeso, introducendo requisiti rigorosi di qualità e governance per usi specifici ad alto rischio.

Questo crea un nuovo e complesso panorama di conformità per gli utenti dei dati. Inavvertitamente, l’AI Act crea un’enorme opportunità per il SSE. In un mondo in cui l’uso di dati errati può comportare responsabilità legali, la domanda di dati affidabili, ben documentati e prodotti in modo trasparente è destinata a essere molto elevata.

Il SSE è in una posizione unica per fornire “dati di qualità per la conformità” o “dati pronti per l’IA”. Questo potrebbe trasformare il suo ruolo da semplice fornitore di informazioni pubbliche a un abilitatore strategico di un ecosistema di IA europeo affidabile, aprendo potenzialmente la strada a nuovi servizi di dati certificati incentrati sulla fornitura di dataset con la documentazione estesa richiesta per la conformità alla legge sull’IA.

Sistema statistico europeo pronto per l’IA: visione e roadmap

L’analisi condotta in questo articolo converge verso una visione strategica per il futuro del sistema statistico europeo. In questa visione, l’organizzazione trascende il suo ruolo di produttore solo di statistiche per diventare il curatore di un grafo di conoscenza autorevole, FAIR e semanticamente interconnesso.

Non si tratta più di pubblicare semplicemente dati, ma di fornire asset di conoscenza leggibili e comprensibili meccanicamente, pronti per essere integrati in flussi di lavoro automatizzati e sistemi di intelligenza artificiale. In questo futuro, un utente, sia esso un ricercatore, un’applicazione software o un modello di IA, può scoprire un dataset tramite una query in linguaggio naturale, accedervi programmaticamente tramite un’API, comprenderne il significato grazie a definizioni semantiche collegate e integrarlo con altre fonti di dati.

Allo stesso tempo, avrà accesso a metadati ricchi e trasparenti, sufficienti a valutare l’idoneità del dato per l’uso in un sistema di IA regolamentato, garantendo così fiducia e conformità. Il SSE non sarebbe solo una risorsa nello spazio europeo dei dati, ma ne costituirebbe la spina dorsale semantica, fornendo il fondamento di verità su cui costruire un’economia digitale basata sui dati e una IA affidabile.

Roadmap operativa

Per realizzare questa visione, è necessario un impegno coordinato da parte di tutti gli attori del sistema. Si propongono le seguenti raccomandazioni strategiche, suddivise per stakeholder.

Per Eurostat e il Comitato del sistema statistico europeo:

- Accelerare l’adozione di SDMX 3.0, promuovere attivamente l’adozione dello standard SDMX 3.0 in tutti gli INS, con un’enfasi particolare sulle sue capacità avanzate di gestione dei metadati di riferimento, del supporto geospaziale e della descrizione dei microdati. Questo standard deve essere considerato il fondamento tecnico per l’interoperabilità e la FAIRness.

- Lanciare un’iniziativa strategica di mappatura semantica, avviare un progetto a livello di SSE per mappare i concetti statistici fondamentali (classificazioni, liste di codici, definizioni di variabili) a vocabolari controllati pubblici del web semantico. Questo passo è cruciale per passare dall’interoperabilità sintattica a quella semantica.

- Sviluppare “Datasheets for datasets”, istituire come pratica standard la pubblicazione di schede tecniche per ogni dataset, ispirate alle pratiche dell’ingegneria del software. Questi documenti dovrebbero fornire informazioni dettagliate su provenienza, ambito, metodologia, limitazioni e un’analisi trasparente dei potenziali bias, al fine di fornire agli sviluppatori di IA le informazioni necessarie per la conformità all’AI Act.

- Investire in un sistema unificato di gestione dei metadati, sviluppare o adottare un sistema centralizzato di gestione dei metadati che funga da unica fonte di verità per l’intero SSE. Questo sistema deve alimentare in modo coerente e automatico tutti i canali di diffusione (portale web, diverse API, endpoint SPARQL), garantendo che una modifica a un concetto si rifletta istantaneamente ovunque.

Per gli istituti nazionali di statistica:

- Dare priorità allo sviluppo delle capacità, investire nella formazione e nello sviluppo di competenze interne nelle nuove tecnologie (sviluppo di API, Linked Open Data) e nella data science (ML/NLP). Sfruttare attivamente gli strumenti condivisi, le conoscenze e le migliori pratiche sviluppate nell’ambito di progetti a livello di SSE, come quelli finanziati da Eurostat, per evitare la duplicazione degli sforzi e accelerare la modernizzazione.

- Interagire proattivamente con gli ecosistemi nazionali di IA, stabilire un dialogo con le imprese, le università e i centri di ricerca nazionali che sviluppano sistemi di IA. Questo permetterà di comprendere meglio le loro esigenze in termini di dati e di promuovere il valore delle statistiche ufficiali come risorsa affidabile e di alta qualità per lo sviluppo di sistemi di IA conformi alla normativa, senza contare la possibilità di provare a usare i vari tipi di IA ai fini della statistica ufficiale.

Per gli utenti avanzati di dati (ricercatori e sviluppatori):

- Passare a flussi di lavoro programmatici, abbandonare il download manuale di file a favore dell’utilizzo delle API disponibili. Questo approccio non solo migliora l’efficienza, ma garantisce anche la riproducibilità della ricerca e delle analisi, consentendo un aggiornamento automatico e continuo dei dati.

- Incorporare i principi di governance dei dati dell’AI Act, adottare i requisiti dell’articolo 10 della legge sull’IA come una lista di controllo standard per la due diligence ogni volta che si utilizzano statistiche ufficiali per qualsiasi sistema di modellizzazione o decisionale. Valutare la pertinenza, la rappresentatività e i potenziali bias dei dati nel contesto specifico dell’applicazione, anche per i sistemi non classificati come ad alto rischio, è una buona pratica che promuove uno sviluppo responsabile dell’IA.

Fonti web

• European Statistical System – ESS

https://csu.gov.cz/european-statistical-system

• European Statistical System (ESS) – Statbel.fgov

https://statbel.fgov.be/en/about-statbel/our-partners/european-statistical-system-ess

• European Statistical System – Statistisches Bundesamt

https://www.destatis.de/Europa/EN/Methods/ESS/_inhalt.html

• European Statistical System – CSO – Central Statistics Office

https://www.cso.ie/en/aboutus/pagesforfoi/europeanstatisticalsystem/

• European Statistical System (ESS) – STATISTICS AUSTRIA – The Information Manager

https://www.statistik.at/en/about-us/international/european-statistical-system-ess

• Eurostat e gli europei

https://ec.europa.eu/eurostat/statistics-explained/SEPDF/cache/10129.pdf

• Cos’è l’ESS e come funziona

https://csu.gov.cz/what_is_the_ess_and_how_it_works

• European Statistical System (ESS) – ELSTAT

https://www.statistics.gr/en/european-statistical-system

• Diffusione dei dati aperti presso Eurostat – Stato dell’arte – 65° Congresso mondiale di statistica ISI

https://www.isi-next.org/abstracts/submission/1413/view/

• Sfide e opportunità presentate dall’IA generativa nella statistica ufficiale – Banca dei Regolamenti Internazionali

https://www.bis.org/ifc/publ/ifcb62_25.pdf

• TRUSTED SMART STATISTICS – Eurostat grants turbo-charge

https://ec.europa.eu/newsroom/estat_tss/items/891215/en

• Legislazione europea sugli open data | Plasmare il futuro digitale dell’Europa

https://digital-strategy.ec.europa.eu/en/policies/legislation-open-data

• Cosa sono gli Open Data | data.europa.eu – European Union

https://data.europa.eu/en/dataeuropa-academy/what-open-data

• Open data e set di dati di alto valore: guida all’accesso passo dopo passo

https://digital-strategy.ec.europa.eu/en/factpages/open-data-and-high-value-datasets-step-step-access-guide

• Open data portals | Shaping Europe’s digital future – European Union

https://digital-strategy.ec.europa.eu/en/policies/open-data-portals

• API – Introduction – User guides – Eurostat – European Commission

https://ec.europa.eu/eurostat/web/user-guides/data-browser/api-data-access/api-introduction

• API – Examples – periodic data download – User guides – Eurostat – European Commission

https://ec.europa.eu/eurostat/web/user-guides/data-browser/api-data-access/api-faq/examples

• Regolamento (CE) n. 223/2009 del Parlamento europeo e del Consiglio, dell’11 marzo 2009, relativo alle statistiche europee

https://eur-lex.europa.eu/eli/reg/2009/223/oj/eng

• Regolamento di esecuzione (UE) 2023/138 della Commissione, del 21 dicembre 2022, che stabilisce un elenco di set di dati specifici di elevato valore e le modalità per la loro pubblicazione e il loro riutilizzo

https://eur-lex.europa.eu/eli/reg_impl/2023/138/oj/eng

• Regolamento (UE) 2024/1689 del Parlamento europeo e del Consiglio, del 13 giugno 2024, che stabilisce norme armonizzate in materia di intelligenza artificiale

https://eur-lex.europa.eu/eli/reg/2024/1689/oj/eng

• Code of practice of European Statistics

https://dzs.gov.hr/highlighted-themes/quality/code-of-practice-of-european-statistics/681

• L’uso delle tecnologie di IA è in aumento nelle imprese dell’UE

https://ec.europa.eu/eurostat/web/products-eurostat-news/w/ddn-20250123-3

• Online Job Advertisements (OJA)

https://cros.ec.europa.eu/wih/oja

• Online based enterprise characteristics (OBEC)

https://cros.ec.europa.eu/wih/obec