I data center sono infrastrutture decisive dell’economia digitale: strutture fisiche massicce che sostengono cloud computing, intelligenza artificiale e trasformazione tecnologica. Comprendere la loro natura, vulnerabilità e impatto strategico è essenziale per chi guida organizzazioni nell’era dell’AI.

Indice degli argomenti

Quando un incendio spegne milioni di siti web

La notte del 10 marzo 2021, un incendio scoppia presso uno dei data center di OVHcloud a Strasburgo, in Francia. Pochi conoscono il nome di questa struttura. Ancora meno sanno cosa sia realmente accaduto quella notte. Eppure, nei pochi minuti in cui le fiamme divoravano tremila server in un edificio di cinquecento metri quadrati, una fetta significativa della rete europea si spegneva.

Tre milioni e seicentomila siti web. Mezzo milione di nomi di dominio. Università che perdevano accesso ai loro portali. Piattaforme pubbliche che andavano al buio. E-commerce che non potevano processare transazioni. OVHcloud è il più grande cloud provider europeo, il terzo al mondo per numero di server installati, dietro solo ad Amazon Web Services e Microsoft Azure. Gestisce trentasette data center in otto paesi. Ospita dal sito di una piccola azienda ai sistemi di governo, fino agli ambienti per l’addestramento dell’intelligenza artificiale.

Quando il suo impianto di Strasburgo ha ceduto, l’effetto non è stato circoscritto. È stato sistemico.

L’illusione dell’immaterialità digitale

Questo incidente, spesso dimenticato nei rapporti annuali sulla trasformazione digitale, contiene una lezione che oggi i leader dovrebbero studiare con attenzione: il cloud non galleggia nell’etere.

Vive in edifici reali, collegati a reti elettriche fisiche, raffreddati da acqua e aria. E gli edifici crollano.

Anatomia di una fortezza tecnologica

Quando parliamo di trasformazione digitale, di intelligenza artificiale, di cloud computing, la nostra immaginazione tende a collocare queste realtà in uno spazio virtuale, immateriale. Ma la materia prima della rivoluzione digitale è, paradossalmente, materia concreta. Acciaio, cemento, silicio, energia elettrica.

Un moderno data center non è un ufficio con computer. È una struttura industriale massiccia, progettata per funzionare ininterrottamente, ventiquattro ore al giorno, trecentosessantacinque giorni all’anno. Una struttura dove migliaia di computer elaborano e archiviano dati per le piattaforme cloud, per i sistemi aziendali, per i modelli di intelligenza artificiale.

Una singola struttura moderna può consumare da cinquanta a centocinquanta megawatt di energia elettrica (Colossus 2 appena avviato arriva ad 1 gigawatt), una quantità equivalente al consumo di una città, e costare tra duecento cinquanta milioni e qualche miliardo di dollari per essere costruita (Colossus 2 pare sia costato 20 miliardi di dollari). Dentro questi edifici, l’affidabilità non è un optional. È un imperativo assoluto.

L’energia è fornita attraverso molteplici sottostazioni. Sistemi di batterie entrano in azione istantaneamente durante le interruzioni di corrente. Generatori diesel possono sostenere le operazioni per giorni interi. Sistemi di raffreddamento mantengono temperature stabili per prevenire il malfunzionamento dell’hardware. Reti in fibra ottica collegano l’edificio al backbone di Internet.

Quando uno solo di questi sistemi fallisce, l’impatto non rimane contenuto. Si propaga come onde d’urto in tutta la rete.

Strasburgo, una lezione di fragilità

A Strasburgo, l’assenza di sistemi automatici di soppressione degli incendi e la limitata compartimentazione ha permesso alle fiamme di diffondersi rapidamente, creando la più grande perdita di infrastrutture digitali d’Europa.

Un’espansione senza precedenti

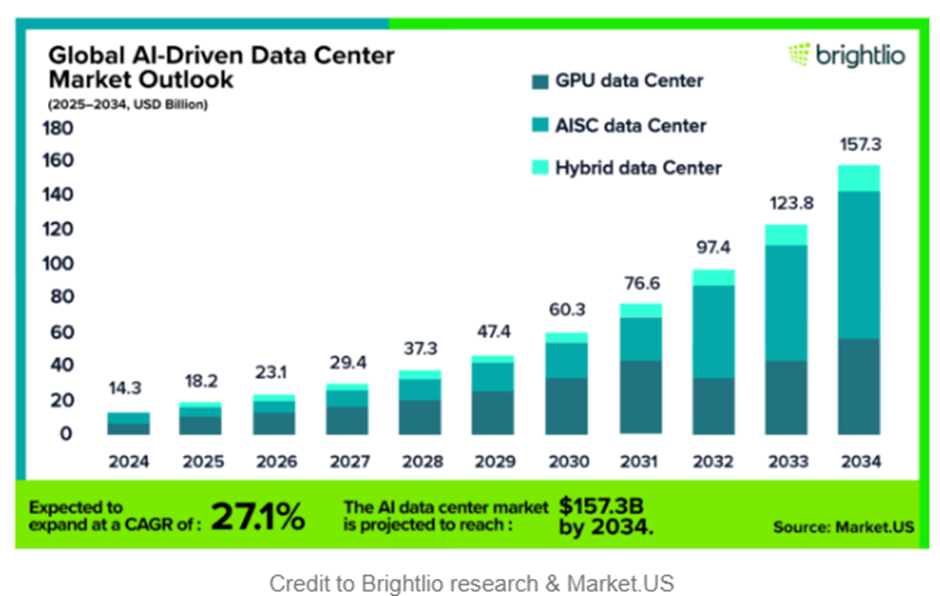

Eppure, malgrado incidenti come quello di Strasburgo, il mercato mondiale dei data center sta attraversando un’espansione che non ha precedenti.

Non è crescita incrementale. È trasformazione infrastrutturale su scala globale. I numeri sono eloquenti. Il mercato dei data center per l’intelligenza artificiale crescerà undici volte tra il 2024 e il 2034. Non è crescita lineare. È moltiplicazione di un ordine di magnitudo.

La corsa agli investimenti miliardari

Le maggiori aziende tecnologiche stanno riversando capitale liquido in questa espansione come mai prima.

- Microsoft ha annunciato investimenti per ottanta miliardi di dollari per raddoppiare la sua impronta globale entro il 2027.

- Amazon Web Services sta mettendo in campo cinquantacinque miliardi di dollari in un solo anno.

- Meta prevede di spendere tra settanta e settantadue miliardi di dollari nella costruzione di campus pronti per l’intelligenza artificiale in Nord America e Europa.

- Google ha più di trenta nuovi progetti in costruzione in tutto il mondo. E non si tratta solo dei giganti della tecnologia.

- Fondi sovrani, investitori infrastrutturali, private equity: tutti vedono i data center come una classe di asset fondamentale.

- Nei mercati emergenti, paesi come Indonesia, Brasile e Nigeria stanno registrando tassi di crescita annuali del venti-trenta per cento nella capacità, mentre la domanda di servizi cloud locali accelera.

Ma quale è il motore di questa espansione? Perché i data center sono diventati improvvisamente il centro della conversazione strategica?

Il costo energetico dell’intelligenza artificiale

La risposta è semplice: l’intelligenza artificiale mangia energia. L’intelligenza artificiale non è un algoritmo che fluttua nel vuoto computazionale. È hardware. Ogni prompt, ogni modello, ogni immagine generata accade dentro un data center pieno di GPU.

L’addestramento di un modello di intelligenza artificiale su larga scala può richiedere decine di migliaia di chip che funzionano per settimane, consumando tanta energia quanto cinquemila case americane in un anno.

Ogni richiesta di intelligenza artificiale richiede inoltre una quantità di energia enormemente superiore a una ricerca web standard. La generazione di una singola immagine può consumare dieci volte l’elettricità di una ricerca Google. Moltiplicate questo per miliardi di interazioni, e il risultato è una domanda massiccia e nuova di potenza computazionale e di elettricità.

Verso il quattro percento del consumo globale

Le utility elettriche negli Stati Uniti segnalano che l’espansione dei data center potrebbe richiedere venticinque gigawatt di nuova capacità generativa entro il 2030. È grosso modo come aggiungere l’intero fabbisogno energetico dell’Australia. Questo legame tra computazione ed energia sta diventando una caratteristica definitoria dell’economia dell’intelligenza artificiale.

L’Agenzia Internazionale per l’Energia stima che il consumo di elettricità dei data center, che era circa quattrocentosessanta terawatt-ora nel 2022, potrebbe superare mille terawatt-ore entro il 2026.

Questo rappresenterebbe quasi il quattro per cento del consumo energetico globale totale, equivalente al consumo combinato di Giappone e Germania.

Data center e sovranità nazionale

Questo non è soltanto un problema tecnologico. È un problema geopolitico. È un problema di strategia nazionale. I paesi che stanno costruendo capacità di data center si stanno posizionando come economie pronte per l’intelligenza artificiale. I paesi che li stanno bloccando per motivi ambientali stanno scegliendo la cautela normativa sulla posizionamento strategico.

Nessuno dei due approcci è ovviamente sbagliato. Ma entrambi hanno conseguenze. Il capitale globale destinato ai data center dovrebbe superare i mille duecento miliardi di dollari tra il 2024 e il 2030. Non è investimento speculativo. È investimento infrastrutturale.

I leader dovrebbero porsi domande essenziali: Dove sta localizzandosi l’intelligenza artificiale del nostro paese? Quali paesi stanno accumulando capacità computazionale? Quali regioni avremo bisogno di scegliere per i nostri servizi critici? Queste non sono discussioni accademiche.

Sono discussioni che stanno accadendo nelle riunioni dei consigli di amministrazione delle utility, nelle commissioni di zonizzazione, negli uffici delle agenzie normative, nelle stanze dei governi. Sono discussioni che plasmeranno quale nazione sarà centrale nell’economia dell’intelligenza artificiale e quale rimarrà alla periferia.

Sfida ambientale e risposte tecnologiche

La crescita del settore ha inevitabilmente attirato l’attenzione globale per la sua impronta energetica e ambientale. I data center attualmente producono circa il due per cento delle emissioni di carbonio globali, una cifra che potrebbe raddoppiare entro il 2030 senza significativi miglioramenti di efficienza.

Ma gli operatori stanno rispondendo. Le nuove strutture si propongono di raggiungere rapporti di Power Usage Effectiveness (PUE) inferiori a 1,2, scesi dalla media industriale di 1,6 un decennio fa. Il raffreddamento a liquido e i sistemi di gestione energetica basati su intelligenza artificiale sono ora comuni.

Gli hyperscaler hanno sottoscritto accordi per energia rinnovabile multigigawatt negli Stati Uniti e in Europa. In Danimarca e Finlandia, il calore recuperato dai data center oggi riscalda migliaia di abitazioni ogni inverno.

Quando la resilienza incontra la sostenibilità

Ma l’incendio di Strasburgo ha rivelato un’altra dimensione ambientale: lo spreco. Più di centocinquanta tonnellate di equipaggiamento elettronico sono state distrutte in una singola notte, sottolineando che resilienza e sostenibilità sono inseparabili.

Non puoi essere verde se il tuo sistema crolla. Non puoi essere sostenibile se la tua infrastruttura si disintegra nel fuoco.

Dipendenza invisibile e costi reali

Anche se la tua organizzazione non costruisce o gestisce data center, dipendi da essi. Determinano quanto è affidabile il tuo sistema cloud, quanto rimane sicuro il tuo dato, quanto costa far girare i tuoi modelli di intelligenza artificiale.

Gartner stima che il fermo macchina costi alle grandi imprese circa cinquemilaseicento dollari al minuto, o più di trecentomila dollari all’ora. Un’ora di interruzione per un’azienda di medie dimensioni è non soltanto una perdita operativa. È una perdita che può riconfigurare la fiducia dei clienti, le relazioni commerciali, il posizionamento sul mercato.

Decisioni strategiche nell’era digitale

Ma i data center influenzano questioni strategiche ancora più ampie. La loro localizzazione geografica influisce sulla conformità alle leggi sulla sovranità dei dati. La loro composizione energetica impatta le metriche ESG. La loro capacità limita le catene di approvvigionamento e la disponibilità di prodotti.

Comprendere questi fattori aiuta i leader a prendere decisioni più consapevoli riguardo alle partnership, al rischio, alla pianificazione a lungo termine.

Quando l’incendio di OVHcloud ha oscurato milioni di siti web, ha reso visibile ciò che la maggior parte delle persone non vede mai: il macchinario fisico che mantiene il mondo digitale in funzione. È stato un segnale che la strategia digitale e la strategia infrastrutturale non possono più essere separate.

L’intelligenza artificiale, il cloud computing, la trasformazione digitale convergono tutte dentro queste strutture. Per i leader moderni, comprendere i data center non significa diventare un tecnologo. Significa vedere l’infrastruttura che sostiene l’innovazione, la resilienza, la crescita. E riconoscere che in quella infrastruttura si decide il futuro.

Prepping digitale, prepararsi all’inevitabile

Va quindi pensato, con il prepping digitale, cosa fare in caso di outage prolungato, che è solo questione di tempo: arriverà. Ma cosa è il prepping digitale? Il prepping digitale è un approccio strategico alla preparazione e resilienza digitale delle organizzazioni.

Si tratta essenzialmente di prepararsi in modo preventivo a possibili interruzioni digitali, cyber attacchi, perdita di dati o malfunzionamenti tecnologici, invece di limitarsi a reagire quando il problema si è già verificato. L’obiettivo è garantire la resilienza operativa e la continuità dei servizi anche in scenari critici, attraverso una gestione proattiva del rischio digitale.

I pilastri della resilienza digitale

Concretamente, questo approccio si declina in diversi ambiti interconnessi. Il primo riguarda le strategie di backup e disaster recovery, ovvero tutti quei meccanismi che permettono di salvare i dati e ripristinare i sistemi in caso di emergenza. Parallelamente c’è la cybersecurity preparedness, cioè la protezione preventiva da minacce informatiche, che non si limita agli antivirus ma include formazione, procedure e monitoraggio costante.

Un altro aspetto fondamentale è la business continuity digitale, che si traduce in piani operativi concreti per mantenere attive le funzioni critiche dell’organizzazione anche quando qualcosa va storto.

Questo spesso richiede infrastrutture ridondanti, quindi sistemi alternativi e soluzioni cloud di backup che possano subentrare rapidamente. Infine, ma non meno importante, c’è la formazione del personale, perché anche la migliore tecnologia è inefficace se le persone non sanno come gestire le emergenze digitali.

Prepping digitale nella pubblica amministrazione

Nel contesto della Pubblica Amministrazione italiana in cui operi, questo si traduce nel rispetto del Piano di Continuità Operativa richiesto da AgID, nella protezione dei servizi essenziali ai cittadini, e nella gestione della transizione al cloud secondo la strategia nazionale, mantenendo sempre la compliance GDPR per i dati sensibili. E sarebbe utile, in qualche ragionamento di Data Sovereignty e AI Sovereignty.