Traffico bot significa molto più di visite “non umane”: nel 2024 ha superato l’attività degli utenti reali e nel 2025 ha accelerato ancora, con una quota crescente di automazioni malevole. Il risultato è un impatto diretto su budget adv, qualità dei dati e scelte strategiche, mentre grey bot e AI agent rendono la minaccia più difficile da intercettare.

Indice degli argomenti

Traffico bot: i numeri 2024–2025 e perché contano

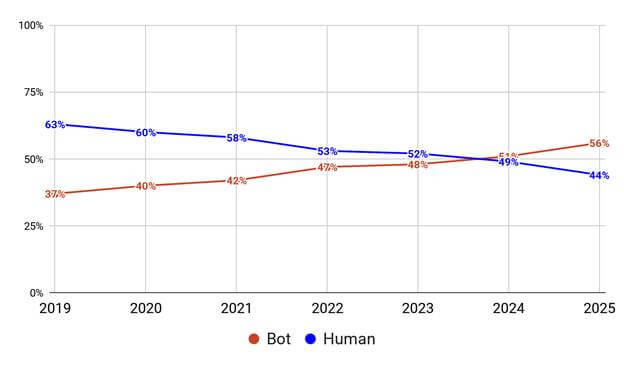

Nel 2024 è accaduto qualcosa di storico nell’ecosistema digitale: per la prima volta in un decennio, il traffico generato da bot ha superato quello prodotto da esseri umani, raggiungendo il 51% contro il 49%.

I dati del 2025 confermano l’accelerazione: il traffico bot ha raggiunto il 56%, mentre quello umano è sceso al 44%.

Secondo Imperva, società specializzata in cybersecurity, il 75% dei bot attivi nel 2025 sono classificati come “malicious”, ossia progettati con intenti malevoli. Un aumento significativo rispetto al 72% del 2024 e al 64% del 2023.

Malicious Bot: tecniche avanzate di elusione

I Malicious Bot sono invece entità sofisticate progettate per manipolare, sfruttare e danneggiare i siti web.

La simulazione del comportamento umano è diventata estremamente convincente. I bot moderni replicano movimenti del mouse non lineari che seguono il tracciato naturale di un utente, effettuano scroll a velocità variabile per sembrare navigazione autentica, e compilano moduli con ritmi di digitazione realistici, pause naturali e persino errori intenzionali seguiti da correzioni.

Eludono le difese tradizionali risolvendo automaticamente i CAPTCHA, distribuendo le richieste su IP diversi, e superando i Web Application Firewall. Occultano l’origine utilizzando reti proxy e proxy residenziali, rendendo inefficace il rilevamento basato sull’IP.

Le tattiche classiche si sono evolute diventando più precise ed efficienti, anche grazie all’intelligenza artificiale.

Ad Fraud: spreco di budget e blocco dell’inventario

I bot rappresentano una vera minaccia operativa per aziende e advertiser.

In particolare, la generazione di click e impression false sulle campagne pubblicitarie, consumano budget senza generare valore reale, permettendo così alle campagne dei competitor di posizionarsi meglio.

I bot possono inoltre interferire con l’inventario ecommerce: l’aggiunta di prodotti ai carrelli senza completare l’acquisto e la creazione di falsi out-of-stock non solo compromettono l’affidabilità dei dati su cui basare le analisi delle performance dello shop, ma alterano la disponibilità reale dei prodotti, impedendo ad utenti reali di completare acquisti e compromettendo la reputazione del brand.

L’effetto combinato è uno spreco diretto di risorse pubblicitarie e un danno concreto nella gestione delle vendite online.

Dati falsati e conseguenze sulle decisioni strategiche

Il traffico bot non si limita a consumare budget: compromette anche la qualità dei dati raccolti, con impatti concreti sulle decisioni aziendali. Le metriche più colpite includono la frequenza di rimbalzo, le conversioni e il comportamento di navigazione degli utenti. Ad esempio, sessioni simulate dai bot possono far sembrare che una pagina venga visitata e chiusa subito, gonfiando la frequenza di rimbalzo e fornendo indicazioni errate sull’interesse reale per i contenuti da parte delle audience di pubblico raggiunte.

Dall’altro lato, i bot possono essere causa anche di conversioni fittizie, generate da click su call-to-action o aggiunte al carrello automatizzate, sovrastimano le performance effettive delle campagne e dei contenuti del sito.

Questo porta a valutazioni sbagliate sul layout, sui messaggi e sulle strategie di engagement.

Anche l’allocazione del budget pubblicitario risente delle distorsioni causate da bot: risorse vengono spostate su canali che attraggono solo traffico bot, creando un ciclo perverso in cui metriche positive generano ulteriori investimenti su traffico e conversioni false.

Di conseguenza, ROAS, analisi del funnel e ottimizzazioni del customer journey diventano poco affidabili, compromettendo l’efficacia complessiva delle strategie di marketing.

Grey Bot: zona grigia etica e legale

I Grey Bot, chiamati anche AI Data Scrapers o AI Crawlers, operano invece in una “zona grigia”.

Infatti, non compiono azioni palesemente illegali come furto di credenziali, ma utilizzano contenuti protetti da copyright per creare nuovi contenuti e prodotti commerciali.

Il loro compito è di raccogliere enormi quantità di contenuti testuali, immagini e codice; dati che, una volta identificati e scaricati, vengono utilizzati per alimentare e addestrare i sistemi di Large Language Model (LLM) come ChatGPT, Gemini, Perplexity, etc.

L’ambiguità legale ed etica di questi bot è evidente: non compiono azioni di furto di dati sensibili o personali come password o credenziali bancarie. Tuttavia prelevano contenuti protetti da copyright con lo scopo di creare nuovi contenuti o prodotti aziendali.

A rendere i Grey Bot strumenti pericolosi è soprattutto l’impatto che determinano sul corretto funzionamento dei presidi web aziendali: infatti, la loro intensa attività di scraping può sovraccaricare i server di un ecommerce, aumentandone i costi di gestione, compromettendo la velocità di navigazione e, di conseguenza, l’esperienza e la qualità del percorso di conversione degli utenti.

AI Agent: autonomia e apprendimento continuo

Gli AI Agent rappresentano un’evoluzione significativa nel modo dei bot web.

A differenza dei bot tradizionali basati su script predefiniti, gli AI Agent sono entità software autonome che operano in modo indipendente, senza il bisogno di un costante intervento umano, e possono prendere iniziative decidendo autonomamente le azioni necessarie per raggiungere l’obiettivo.

Pianificano ed eseguono sequenze complesse di azioni senza istruzioni dettagliate, analizzano dati e prendono decisioni logiche autonome. Immagina di avere di fronte un browser automatizzato che riceve il comando “compra questo prodotto” ed esegue tutto il processo: dalla verifica delle varianti dei prodotti, fino all’aggiunta al carrello e completamento dell’acquisto.

Ciò che rende molto insidiosi gli AI Agent è la loro abilità di apprendere dalle interazioni passate con gli elementi o le pagine di un sito web, adattando il proprio comportamento, valutando alternative e conseguenze, anche sbagliando intenzionalmente per capire le contromisure e aggirarle.

In questo scenario, il traffico bot generato da AI Agent è significativamente più difficile da rilevare e mitigare rispetto a quello dei bot tradizionali per la loro capacità di mimare il comportamento umano in modo molto più convincente.

Approccio stratificato alla difesa: combinare tecniche per risultati efficaci

Come sottolineato da Guido Barbacci, Senior Digital Analyst di Tag Manager Italia, durante il GA Summit 2025, contro i bot non esiste una “pallottola d’argento”. Nessuna singola tecnologia può fornire una protezione completa: è necessario combinare tecniche diverse che lavorano in sinergia tra loro.

Primo livello: Web Application Firewall per la protezione perimetrale

Il primo strato di difesa si basa sui Web Application Firewall (WAF), sistemi che bloccano il traffico malevolo prima che consumi risorse del server, riducendo costi infrastrutturali e migliorando le performance del sito per gli utenti reali.

Funzionano come un posto di blocco intelligente che ispeziona ogni richiesta in arrivo e decide se lasciarla passare o bloccarla.

Ad esempio, Cloudflare Bot Management rappresenta una delle soluzioni più diffuse e tecnicamente sofisticate. Il sistema assegna a ogni richiesta HTTP un “bot score” da 1 a 99: punteggi più alti indicano probabilità maggiore che la richiesta provenga da un utente umano con browser standard, mentre punteggi bassi segnalano traffico automatizzato sospetto.

Poniamo il caso di un ecommerce che riceve 3.000 richieste al secondo (visite di pagina, interazioni coi contenuti, etc.).

Un sistema WAF le analizza in tempo reale e identifica 1.000 richieste sospette provenienti da IP con cattiva reputazione, con comportamenti ritenuti non umani (pattern di navigazione identici, e tentano di accedere a pagine prodotto in sequenza troppo veloce, etc.).

A queste richieste sospette, il sistema WAF assegna un bot score basso e le blocca prima che raggiungano i server, lasciando fluire senza rallentamenti le 2.000 richieste legittime.

Secondo livello: Server-Side tracking per recuperare dati accurati

Il secondo livello sfrutta le potenzialità del tracking lato server, una tecnica che sposta la raccolta dati dal browser o device dell’utente al server che gestisce il sito web o ecommerce aziendale.

Questo approccio risolve diversi problemi creati dai bot e dagli adblocker.

Nel tracking tradizionale client-side, ogni script di analytics o advertising viene eseguito direttamente nel browser dell’utente. Questo significa che adblocker, restrizioni browser come ITP di Safari, e bot sofisticati possono facilmente bloccare o falsificare i dati.

Con il server-side tracking, invece, il browser invia i dati a un server proprietario che poi li redistribuisce agli strumenti di analytics e alle piattaforme pubblicitarie. I bot hanno molto più difficoltà a manipolare questo processo di invio dati.

Stape, piattaforma specializzata in hosting per Google Tag Manager (GTM) server-side, ha introdotto una funzionalità chiamata Bot Detection, che identifica il traffico bot analizzando parametri della richiesta, ad esempio lo User Agent, pattern di navigazione sospetti e firme note di bot (insiemi di caratteristiche tecniche e comportamentali già riconosciute come tipiche di specifici bot o categorie di bot).

Una volta identificato un bot, è possibile configurare Google Tag Manager server-side per bloccare o dirottare le richieste verso analytics e advertising platform.

Infatti, affiancando a soluzioni di bot detection la configurazione di tag di tracciamento GTM, si possono creare regole basate su pattern specifici già noti nel proprio business: ad esempio, bloccare richieste provenienti dalle campagne Google Ads che aggiungono 50 prodotti al carrello in 2 minuti, o che compilano form con velocità di digitazione superiore a 200 caratteri al minuto, etc.

In questo esempio, le richieste sospette vengono intercettate e bloccate prima dell’invio dei dati a GA4, a Google Ads e ad altri strumenti di analytics. Il risultato è un tracciamento basato su click reali, un ROAS più affidabile e nessun budget sprecato su traffico fittizio.

Terzo livello: analisi comportamentale per distinguere umani da bot

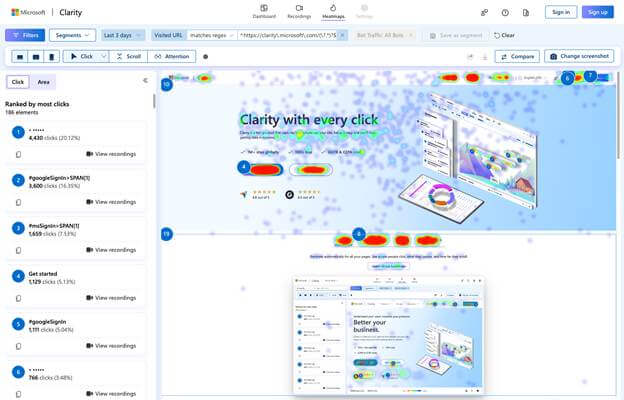

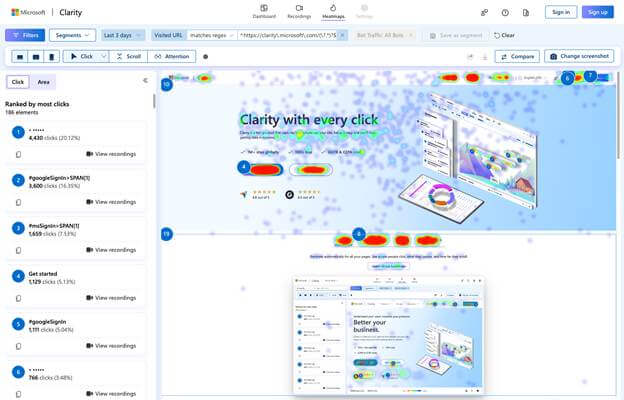

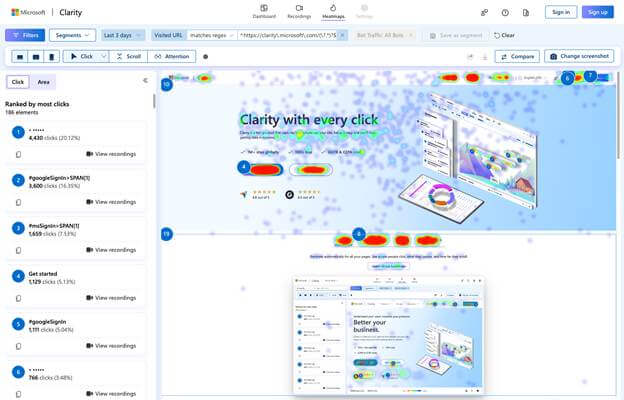

Il terzo strato si concentra sull’analisi comportamentale: non chiedersi “chi è” il visitatore, ma “come si comporta”. Qui entra in gioco Microsoft Clarity, uno strumento che registra le sessioni degli utenti e crea heatmap delle interazioni.

Clarity ha introdotto di recente funzionalità dedicate all’analisi del traffico bot. Il sistema rileva automaticamente bot e li esclude dal conteggio totale delle sessioni e dalle analytics.

Grazie all’analisi di centinaia di segnali comportamentali per ogni sessione di navigazione (movimenti del mouse, velocità di scroll, pattern di click, sequenze di navigazione, etc.), Clarity è capace di identificare, isolare e monitorare pattern di comportamento anomali.

Ad esempio, se all’interno dei report Heatmap vengono registrati centinaia di click identici ripetuti nello stesso punto con precisione millimetrica, è certo che si tratti di una interazione di un bot. Gli utenti umani hanno movimenti imprecisi e variabili.

Allo stesso modo, grazie ai report di Session recording è possibile analizzare i movimenti di un utente su un sito web.

Se i form vengono compilati istantaneamente senza pause tra i campi, o al contrario se il puntatore del mouse rimane fermo nell’angolo superiore sinistro per tutta la sessione senza alcuna interazione, si tratta di interazioni da traffico bot.

Con la combinazione di filtri nativi e di smart events Clarity, è possibile effettuare analisi approfondite per identificare traffico e comportamenti anomali, oppure visualizzare report isolando tutte le sessioni di traffico bot.

In questo modo si possono studiare i pattern d’attacco bot ricorrenti e affinare configurazioni di tracciamento per identificarle ed escluderle dai dati di analisi.

Prendiamo il caso di un’azienda che rileva pattern di comportamento anomali provenienti da campagne di email marketing. Analizzando i video delle sessioni di navigazione provenienti dal canale email, si nota che il 90% delle sessioni ha il cursore immobile nell’angolo in alto a sinistra, zero interazioni, durata di pochi secondi. Diagnosi: queste interazioni e visite non sono generate da utenti reali. L’azienda configura quindi degli eventi custom in GTM che marcano come “bot” tutte le sessioni con zero interazioni entro 5 secondi, escludendole dai report.

Quarto livello: Machine Learning per minacce sconosciute

Il livello più avanzato utilizza Machine Learning (ML) per rilevare minacce mai viste prima, i cosiddetti zero-day: bot che non corrispondono a nessuna firma nota perché sono completamente nuovi.

Inn pratica, gli algoritmi di ML vengono addestrati su enormi dataset di traffico reale. Imparano quindi a riconoscere:

- quali sono i pattern di navigazione normali del comportamento umano legittimo

- e quali sono invece sono interazioni anomale.

Una volta addestrati, questi modelli analizzano ogni richiesta in tempo reale confrontandola con ciò che hanno imparato. Se rilevano comportamenti che si discostano significativamente dalla norma, attivano un segnale ad hoc per marcare questa tipologia anomale e sconosciuta di comportamento, generato da bot.

Il vantaggio di utilizzare algoritmi personalizzati di ML è chiaro: consente di identificare nuove tattiche d’attacco bot più sofisticate in modo automatico, aggiornando il proprio database di informazioni in modo autonomo, senza intervento umano.

Attraverso l’uso di strumenti di data warehouse cloud come BigQuery, è possibile costruire modelli predittivi personalizzati, esportando al suo interno dati provenienti da strumenti come GA4, Google Ads, Meta Ads e CRM; in questo modo si avrà un database fornito da una grande quantità di dati per analizzare in profondità:

- pattern di navigazione (sequenze di pagine visitate, timing tra le azioni),

- caratteristiche delle sessioni (durata, profondità di scorrimento pagine, dispositivo, geolocalizzazione),

- anomalie negli eventi tracciati (frequenza innaturale, distribuzione temporale sospetta),

- correlazioni tra variabili multiple che singolarmente sembrerebbero normali ma insieme rivelano comportamenti bot.

Riprendere il controllo strategico

Con il 56% del traffico web generato da bot nel 2025 e il 75% di natura malevola, siamo di fronte a una trasformazione strutturale che richiede attenzione strategica immediata. Le conseguenze di ignorare il fenomeno si traducono in budget sprecati su ad fraud, decisioni basate su dati falsati, danni d’immagine per esperienze compromesse, perdita di revenue per inventory bloccato, costi infrastrutturali aumentati, e analisi ROI distorte.

La difesa richiede un approccio che combini protezione perimetrale con WAF, rilevamento comportamentale con Clarity, tracking avanzato server-side con Stape e template GTM custom, e machine learning con BigQuery.

Solo attraverso questa strategia integrata è possibile distinguere il traffico reale da quello artificiale e garantire che le decisioni si basino su dati autentici.

Il primo passo è prendere consapevolezza. Il secondo è agire implementando le difese appropriate. Il terzo è monitorare continuamente l’evoluzione, perché i bot, specialmente gli AI Agent, imparano e si adattano costantemente.