Dal primo gennaio 2026 vietato girare con l’hijab in tutto il territorio italiano, insorgono i musulmani: se ciò vi suona strano avete ragione, perché è una bufala. Una fake news ben impacchettata in un video realizzato con Sora di OpenAI e, ciò che è più grave, brandizzato col logo del TG5, testata autorevole di Mediaset ovviamente estranea alla situazione. Il video, indicato come “video divertente”, circola su TikTok, è destinato a un pubblico di lingua italiana e ha scatenato centinaia di commenti anti-islamici e anti-immigrazione.

Indice degli argomenti

Deepfake social: gli esempi in Italia

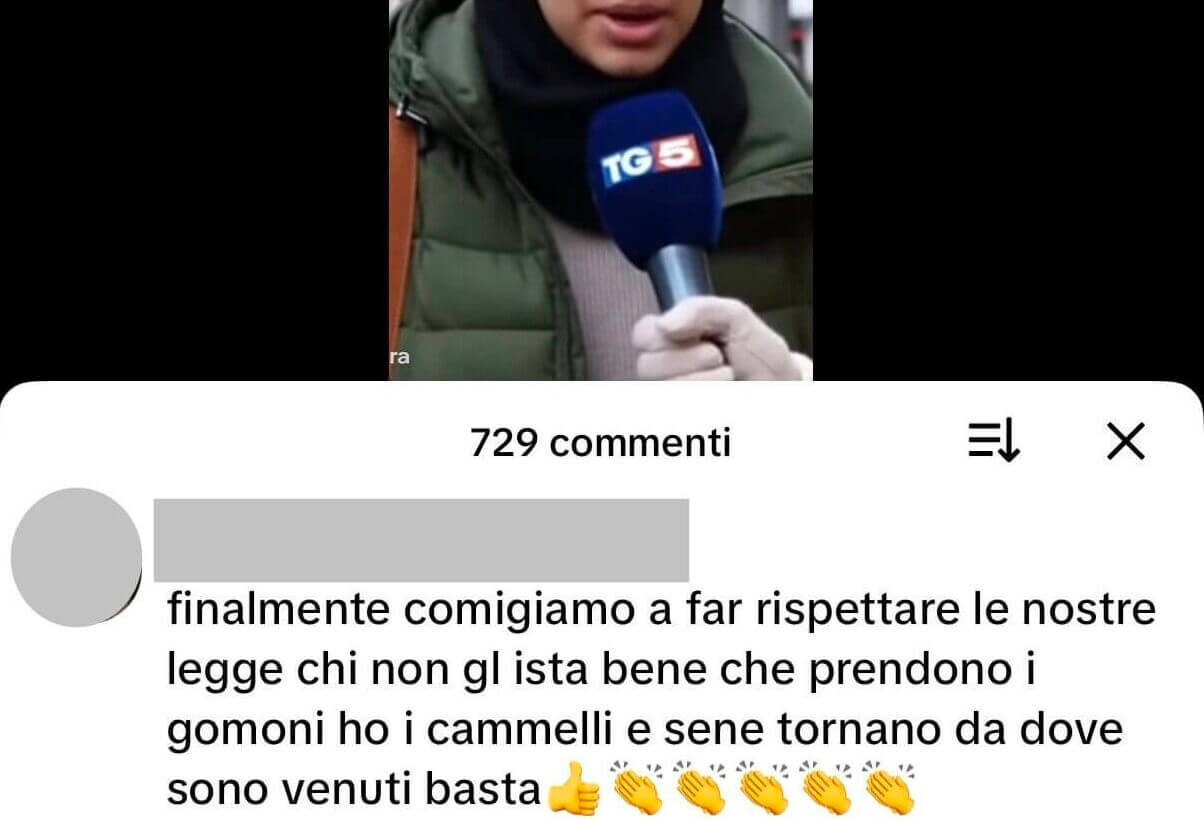

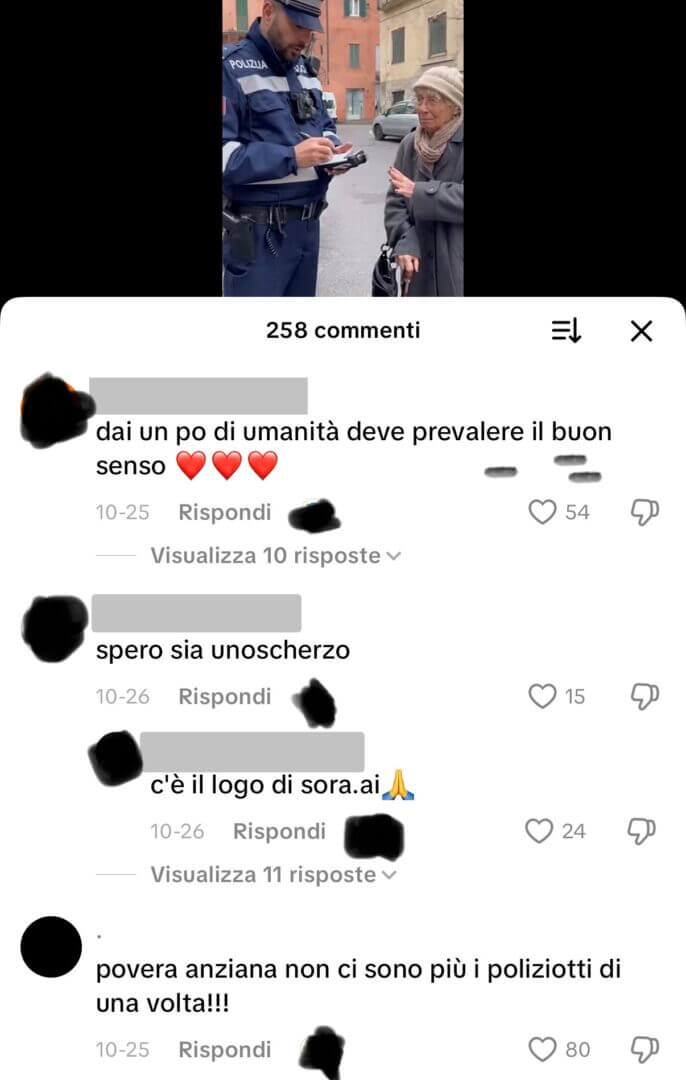

Perché, nonostante in un lampo comparisse il logo di Sora sul video e fosse anche ben visibile, ci sono 729 commenti e quasi tutti mostrano che gli utenti hanno ritenuto vero il servizio e le interviste mostrati. È così che i video di finte interviste deepfake diventano veicolo di hate speech online.

Non si può attribuire all’intelligenza artificiale una colpa per la diffusione di disinformazione e discorsi d’incitamento all’odio, perché significherebbe riconoscere a una tecnologia una forma di autonomia di pensiero. La quale spesso manca anche agli umani: e certo il problema sui social network si nota in molti commenti a video palesemente sintetici, esplicitamente indicati come tali con hashtag e loghi, che tuttavia vengono presi d’impulso per veri e commentati con rabbia, sfogando frustrazioni sociali profonde in parole al vetriolo. Una questione culturale, che riguarda come ci rapportiamo con le tecnologie e ci porta a domandarci se, a livello cognitivo ed emotivo, siamo sempre in grado di stare al passo con la velocità dell’innovazione.

Finte interviste deepfake con AI: il fake TG5 e la bufala del divieto di portare l’hijab

Il video appena descritto è stato pubblicato il 27 ottobre. Sul video compare, in modo corretto, il logo di Sora, dunque è esplicitato che si tratta di un contenuto generato con intelligenza artificiale. Per un occhio attento è facile notarlo: ad esempio, per quanto sia iper realista, i contorni dei volti non sono naturali, sembrano a tratti indefiniti e in alcuni punti la voce è evidentemente artificiale.

Nel video si notano distintamente i loghi del TG5 sia nel sottopancia, sia nello sfondo che sul microfono che viene inquadrato durante le finte interviste. Il video si apre con un giornalista sintetico che introduce la notizia.

Poi, una carrellata di finte interviste per strada, a donne che indossano il velo islamico e che si dicono contrarie, tranne una, al nuovo divieto. Tutto finto.

Fact checking sulla fake news del divieto di portare l’hijab

La bufala è stata impacchettata partendo da una vera notizia, cioè la proposta di legge presentata da Fratelli d’Italia per vietare il velo integrale nei posti pubblici. Tuttavia, il video amplia e distorce questa informazione, aggiungendo la data del primo gennaio 2026 come momento di entrata in vigore del divieto ed estendendo questo anche all’uso dell’hijab. La vera notizia è uscita a inizio ottobre, il deepfake è stato pubblicato circa venti giorni dopo, veicolato come “video divertente”. Tra gli hashtag solo “hijab”, non è indicato tra gli hashtag l’uso dell’AI. Forse, dando per scontato che gli utenti avrebbero capito che si trattava di un video sintetico. Non è stato così.

I commenti

“Buon viaggio”, “ciao”, “Che bello finalmente”, “Sarà vero speriamo”, commenta uno dei pochi dubbiosi. “Bisogna adeguarsi”, “Penso non andrà via nessuno, qui stanno meglio dei loro paesi…”, “Finalmente, si devono adeguare”, “Qui fanno ciò che vogliono loro, italiani ai loro paesi no”.

Noi, loro, distinzioni nette, polarizzazioni.

Interviste deepfake, l’allarme dell’Ordine dei giornalisti

Già a maggio, l’Ordine nazionale dei giornalisti aveva messo in guardia dalla diffusione di video realizzati con intelligenza artificiale generativa che clonano visi e voci dei giornalisti reali, copiando anche sottopancia e loghi delle testate televisive nazionali.

In un comunicato, il presidente dell’Ordine Carlo Bartoli aveva dichiarato: “L’uso illecito e con fini illegali e fraudolenti dell’intelligenza artificiale per realizzare video che simulano giornalisti, rappresenta una minaccia seria al diritto dei cittadini ad essere informati, alla libertà di stampa, alla stabilità della democrazia”, aggiungendo che “sicuramente c’è anche un problema di educazione digitale perchè non si può credere a tutto ciò che circola in rete: il web e i social sono diventati un territorio ancora più a rischio con la IA generativa in grado di riprodurre volti, voci e immagini. Se si vuole buona informazione è bene che le persone si rivolgano direttamente ai canali delle testate giornalistiche”.

I motivi delle finte interviste con deepfake

Perché usare, come contesto di questi video, le finte interviste? Perché si sfrutta l’immagine di autorevolezza del giornalismo per veicolare con maggiore forza un messaggio falso, spesso puntando al ragebait immediato ma con fini più sottili che vanno dalla manipolazion dell’informazione, alla propaganda fino alla creazione di disordine sociale. Come spiega Giovanni Boccia Artieri, professore di Sociologia dei Media digitali all’Università di Urbino, “le fake interviste minano la fiducia nell’informazione e producono post-affidabilità, cioè una carenza generalizzata di fiducia: quando ogni immagine o voce può essere manipolata, diventa difficile distinguere il vero dal verosimile e la fiducia viene minata”.

Il giornalismo vero ha una responsabilità maggiore di fronte a questi casi, sia nel contrasto alla disinformazione attraverso attività di debunking e fact checking, sia nel diffondere notizie vere in modo corretto. Altrimenti, si rischia il caos mediatico e, come diretta conseguenza, quello sociale: “Il giornalismo deve passare da una logica di verifica a posteriori a una di trasparenza preventiva: dichiarare l’origine dei materiali, usare strumenti di tracciabilità e collaborazione tra redazioni e piattaforme – aggiunge il professore -. Il fact checking diventa AI literacy: capacità di leggere, testare e spiegare i contenuti sintetici. La responsabilità dei media è duplice: evitare la diffusione inconsapevole di deepfake e formare il pubblico alla consapevolezza critica”.

Video deepfake e target dei discorsi online: cosa dicono i dati

Un video deepfake buttato sui social è un ottimo innesco per sollevare temi di attualità con toni populisti e scatenare la folla contro un obiettivo desiderato. I target sono solitamente le donne, i neri, i musulmani, gli ebrei, la comunità LGBTQ+, rom e sinti. Secondo l’European Observatory of Online Hate, che realizza report mensili sui tassi di tossicità dei contenuti online europei, a novembre 2025 la categoria maggiormente individuata è stata quella dell’antisemitismo, seguita dalle narrative anti LGBTQ+ , dalle categorie anti-musulmani e anti-rifugiati oltre che dall’antiziganismo.

Durante il terzo trimestre 2025, i livelli di tossicità online sono stati più alti nell’Europea Occidentale e nell’Europa meridionale.

Tra le piattaforme, nello stesso periodo di tempo risultano esserci più alte percentuali di contenuti tossici sulle fringe platform come 4Chan, in assoluto definito dal report l’ambiente online più tossico di tutti, mentre tra le VLOPs (Very large online platforms), X risulta essere il canale con più alti livelli di tossicità, mentre TikTok quello con il tasso minore.

Video e interviste deepfake, alcuni esempi

Un esempio dagli Stati Uniti è quello dell’intervista deepfake che a inizio dicembre 2025 è circolata su TikTok, su cui il New York Times ha svolto fact checking dopo che online il video aveva scatenato un’ondata di odio razziale. Il video porta avanti un filone narrativo razzista comune sui social negli USA in cui persone nere, soprattutto donne, vengono rappresentate con l’AI mentre dichiarano di vendere buoni pasto SNAP – Supplemental Nutrition Assistance Program traendone quindi un indebito profitto alle spalle dei contribuenti americani. Non serve un’analisi mediologica per capirne la portata propagandistica.

In Italia, racconta Boccia Artieri, “è probabile che il fenomeno emerga in vista delle prossime campagne elettorali, dove l’uso sperimentale di GenAI per contenuti politici è già in crescita”.

Le finte interviste AI con il logo TG5

Facendo una ricognizione su TikTok si notano, per il pubblico di lingua italiana, numerosi profili dedicati ai video generati con AI. In questi, approfondendo, emergono anche interviste fake come quella descritta all’inizio del nostro articolo. Ma non solo: vengono create interviste su finti casi di cronaca, che magari si concludono con una battuta esprimendo apertamente, in questo caso, che si tratta di un prodotto finto e sintetico.

Hate speech, che cos’è

Secondo il DSA – Digital Services Act, si definisce hate speech l’incitamento all’odio online, cioè “ogni comportamento che inciti pubblicamente alla violenza o all’odio nei confronti di un gruppo di persone o di un membro di tale gruppo definito in riferimento alla razza, al colore della pelle, alla religione, alla discendenza o all’origine nazionale o etnica”.

Categorie semantiche dell’incitamento all’odio online

Come si spiega l’European Observatory on Online Hate, l’odio online viene veicolato con una comunicazione basata sulle seguenti categorie semantiche:

- Disumanizzazione (un esempio è definire “non persona” le donne, come fanno gli Incel)

- Sessismo

- Politica

- Razzismo

- Religione

- Cospirazionismo, falsità

- Violenza, categoria semantica che include anche i nomi delle armi.

NP

I rischi delle interviste deepfake

Non sono semplici scherzi. Le conseguenze della diffusione di queste false interviste realizzate con AI hanno impatti in ambito politico e sociale, oltre che sul lavoro dei professionisti dell’informazione. Come spiega Boccia Artieri, “sul piano politico, amplificano la polarizzazione e la delegittimazione delle fonti giornalistiche. Sul piano economico, danneggiano la reputazione di media e soggetti coinvolti, oltre a creare un mercato dell’attenzione basato sulla disinformazione virale“.

Quando poi i social media rilanciano e i media tradizionali riprendono questi contenuti, “il rischio si moltiplica: la legittimazione secondaria, cioè il passaggio dai feed all’agenda mediatica, consolida la falsa percezione di autenticità”, aggiunge.

Perché si creano false interviste con AI

Il contesto in cui emergono questi video è ampio, complesso e variegato: “Possono essere armi discorsive: strumenti di influence operations a basso costo, che sfruttano la viralità emotiva più che la credibilità. Gli effetti principali sono la distorsione del dibattito pubblico e la creazione di false memory: narrazioni manipolate che, una volta interiorizzate, restano anche dopo la smentita”, spiega Boccia Artieri.

Scoprire i deepfake: come non farsi ingannare

I consigli, secondo Boccia Artieri, per non cadere nella trappola dei deepfake, sono:

- diffidare da video con micro-espressioni innaturali o audio leggermente desincronizzato;

- verificare la fonte primaria e se l’intervista è pubblicata anche su canali ufficiali;

- usare strumenti di reverse video/image search;

- controllare timestamp, contesto e commenti: spesso le manipolazioni vengono segnalate dalla community.

Per prevenire una deriva distopica, tuttavia, “serve un’azione congiunta tra cultura e regolazione: educazione mediale e alfabetizzazione all’IA nelle scuole e nei media; obblighi di watermarking o disclosure per i contenuti sintetici; standard etici condivisi tra piattaforme, giornali e istituzioni. Non si tratta solo di controllare la tecnologia, ma di costruire una cultura della fiducia verificata nella comunicazione pubblica”, conclude.