Nel dibattito attuale sull’intelligenza artificiale, le professioni giuridiche e in particolare la professione notarile non possono non interrogarsi davanti al crocevia tra innovazione tecnologica e responsabilità pubblica, tra l’evoluzione dei modelli di analisi e l’esigenza di tutelare la volontà autentica dei cittadini.

Chi opera quotidianamente in ambito professionale, non solo nel notariato, e in materia di protezione dei dati personali osserva da vicino un fenomeno cruciale: la crescente integrazione di sistemi algoritmici nelle attività professionali che ormai richiede competenze tecniche e soprattutto consapevolezza dei limiti giuridici ed etici necessari al governo della tecnologia.

Indice degli argomenti

Intelligenza artificiale e notariato, lo scenario

L’esperienza maturata nell’analisi dei processi digitali e nell’applicazione dei quadri regolatori europei e nazionali mostra un’evidenza costante: l’IA può diventare uno strumento straordinario per migliorare l’efficienza e la qualità del lavoro, ma solo se governata da figure in grado di interpretare il diritto, comprenderne la funzione sociale e mantenere il controllo umano su ogni passaggio sostanziale.

Dunque, da persone o, meglio, da professionisti dotati di caratteristiche di cui l’AI non potrà mai dotarsi per definizione: umanità e intelligenza (umana, non probabilistica).

Ed è proprio in questa prospettiva che si inserisce la riflessione che segue: un approfondimento sul ruolo del Notaio nell’ecosistema digitale, sui limiti intrinseci dell’IA applicata al diritto e sulle responsabilità che la nuova normativa europea e italiana assegna ai professionisti che decidono di adottarla.

Questa analisi intende offrire al lettore una chiave di lettura chiara, concreta e aggiornata sul rapporto tra tecnologia e funzione notarile, muovendo da un presupposto semplice ma essenziale: nel diritto, l’innovazione non sostituisce la persona, ma ne amplifica la responsabilità.

Oltre a suggerire qualche elemento al lettore e al professionista che si orienta. La normativa tutela il cittadino attraverso la previsione di adempimenti costruiti per limitare le carenze fisiologiche ed ineliminabili di questa tecnologia tanto discussa. Informarsi e studiare, mai come oggi, fa e farà la differenza in ogni questione sull’AI.

Perché partire in questa indagine dalla figura del Notaio? Perché è figura che condensa professionista e pubblico ufficiale permettendo così di passare in rassegna i diversi aspetti di una questione – quella dell’impiego dell’IA – trasversale e multisfaccettata, con l’intento di illuminare così la maggior parte delle zone d’ombra che ancora ci sono.

Il notariato nell’era dell’intelligenza artificiale: tutela della volontà e della persona

La funzione notarile rappresenta uno dei cardini del sistema giuridico italiano: un punto d’incontro tra volontà privata e interesse pubblico, tra libertà negoziale e certezza del diritto. Il notaio è mediatore del diritto, garante della volontà delle parti e custode della sua genuina formazione.

A differenza di qualunque sistema algoritmico, il notaio:

- valuta l’identità, la capacità e la legittimazione delle parti;

- rileva segnali di coercizione, condizionamento o eterodirezione della volontà;

- integra norme, principi, prassi amministrative e contesto umano;

- assicura che l’atto sia comprensibile e coincida con ciò che realmente è voluto dalle parti.

Le sentenze della Cassazione sulla genuinità della volontà negoziale — tra cui quelle che hanno approfondito fenomeni di influenza indebita, abuso di dipendenza e condizionamento emotivo — ribadiscono che la formazione della volontà giuridica richiede valutazioni umane non delegabili.

Un algoritmo può generare una bozza; un notaio accerta se quell’atto sia davvero “giusto” per quelle parti e le loro effettive volontà, in quel momento, in quel contesto e secondo lo spirito della norma che appartiene alle persone nel loro tempo.

Per citare la Presidentessa di un importante Consiglio Notarile, solo il Notaio (aggiungo io il giurista) può salvare il diritto dalla sua “pietrificazione”, ossia dalla sua riduzione a materia immobile e non viva e dinamica, ancorata al sentire sociale che la caratterizza.

Dicevano i latini <Tempora mutantur, nos et mutamur in illis>, ed è vero: con il tempo noi tutti e il sentire sociale mutano e il giurista in ogni sua attività è interprete di questo continuo cambiamento. Il suo lavoro è proprio quello di adattare al caso, al tempo e alle volontà la norma (generale e astratta) calandola nella realtà specifica della fattispecie a lui sottoposta.

Intelligenza artificiale nel notariato e diritto vivente: il ruolo dei valori sociali

L’IA ha accesso a giurisprudenza, testi normativi e materiali regolatori: ma tutto ciò appartiene, giuridicamente parlando, a un tempo passato, trascorso. Il Notaio opera nel diritto vivente, in una dimensione in cui:

- il valore sociale di un istituto cambia;

- il significato della norma si aggiorna attraverso la coscienza collettiva;

- l’atto deve riflettere la realtà giuridica attuale, non solo quella storica.

L’attualità interpretativa è un fenomeno dinamico, processuale, culturale.

Una macchina non può percepire il mutamento del contesto. Le persone e, in particolare, i professionisti, fra cui appunto il Notaio, lo vivono, lo comprendono, lo interpretano.

Dalla probabilità al diritto: come funziona davvero l’IA generativa

Non possiamo dimenticare che gli algoritmi generativi lavorano su correlazioni statistiche, ossia predicono la sequenza di parole con maggiore probabilità, non individuando il percorso / ragionamento giuridico più corretto (peraltro il significato di corretto andrebbe ogni volta valutato rispetto al momento storico, coscienza sociale, percezione del professionista).

I sistemi di Intelligenza Artificiale non distinguono tra regola ed eccezione; non percepiscono (se non indirizzati con competenza) la gerarchia delle fonti; non sono in grado di applicare principi di equità, proporzionalità o ragionevolezza (ad esempio in un caso specifico e complesso).

Questi i motivi per i quali sono generate nella maggior parte dei casi informazioni inesatte e/o non esistenti (le c.d. allucinazioni). Si capisce che, anche per tale ragione, la tecnologia, in via generale e dunque anche l’IA, non può svolgere funzioni certificative o decisionali (ad oggi nel mondo notarile).

Il perché è semplice: il diritto richiede – e sempre richiederà – razionalità, non probabilità, e competenza, senza poter abdicare a quella tipica capacità umana che è l’apprendimento e la comunicazione intergenerazionale del sapere che appartiene solo e soltanto all’uomo.

Chi non possiede competenze non ha possibilità di formulare correttamente il quesito all’IA e dunque manca del presupposto essenziale all’ottenimento della risposta corretta, ottenendo una mera risposta probabilistica circa un quesito impregnato di soggettività e non professionale.

A domande non professionali conseguono risposte dello stesso tipo e a domande mal formulate risposte probabilistiche (dunque approssimative per definizione) che utilizzano i criteri impostati – più o meno consapevolmente – dall’utilizzatore.

IA antropomorfa e rischi cognitivi

Gli studi più recenti evidenziano che, quando l’IA assume uno stile linguistico vicino a quello umano, l’utente (umanamente) tende a proiettare capacità che il sistema non possiede.

Questo fenomeno — oggi confermato anche nelle ricerche di psicologia cognitiva — può produrre pericolose asimmetrie informative.

Questa “sovrastima” genera un rischio specifico: l’utente può ritenere corretta, neutrale o addirittura autorevole una risposta che, in realtà, è solo il risultato di un’elaborazione probabilistica su dati pregressi, priva di qualsiasi responsabilità, coscienza o valutazione etica.

Vigilanza notarile sull’uso dell’IA

Nel contesto notarile ciò impone una vigilanza ancora più rigorosa:

- il cittadino deve comprendere che l’IA è uno strumento, non un decisore;

- il Notaio deve garantire trasparenza e controllo umano;

- ogni output dell’IA deve essere rivisto, integrato e valutato criticamente.

Perché trattasi di un supporto alla funzione e non della sostituzione della stessa.

Regole per intelligenza artificiale e notariato: AI Act e legge 132/2025

Scendendo più nel tecnico e facendo una breve e rapida disamina della normativa si evidenzia che l’attuale regolamentazione disciplina le responsabilità tecnologiche come segue:

- il provider risponde del modello;

- il deployer del contesto d’uso (il soggetto che rende operativo il modello);

- l’utilizzatore professionale — in questo caso il professionista (notaio, avvocato, commercialista, etc.) — delle decisioni adottate sulla base dell’output.

Il Notaio, quindi, non è responsabile della tecnologia, ma dell’uso che ne fa o, meglio, che saprà farne rispetto al caso specifico e allo stato dell’arte, il che equivale per il professionista ad avere conoscenza e competenza della tecnologia in questione in modo professionale.

Non a caso si legge nel sistema europeo (AI Act) e nella normativa nazionale (legge 23 settembre 2025, n. 132, Legge italiana sull’IA) che l’attività svolta con AI necessita di supervisione umana qualificata, tracciabilità dei processi, gestione dei rischi tecnologici e informativa trasparente all’utente (anche ex art. 13 GDPR).

Legge 132/2025 e la prevalenza del lavoro intellettuale

La L.132/2025 rappresenta una tappa significativa nel percorso di integrazione dell’IA nelle professioni intellettuali. Il legislatore, consapevole della crescente diffusione di strumenti automatizzati nei processi lavorativi, ha scelto un approccio equilibrato: riconoscere l’utilità della tecnologia senza scalfire la natura personale, qualificata e insostituibile dell’attività professionale.

La legge introduce una distinzione netta tra:

- attività intellettuale prevalente, che implica valutazioni, interpretazioni, decisioni e responsabilità umane;

- attività automatizzata accessoria, che può supportare il lavoro ma non determinarne gli esiti.

È una distinzione che non ha solo valore teorico, ma impatto pratico immediato. L’art. 13 afferma espressamente che la responsabilità rimane “integralmente personale”: nessun output algoritmico può sostituire il discernimento, la prudenza professionale e la capacità valutativa che caratterizzano il sapere giuridico di un professionista e, nel caso di oggi, del Notaio.

La legge delega (132/25) introduce anche un obbligo di trasparenza e informazione, dal professionista al cittadino: quando un professionista utilizza l’IA nel corso della propria attività, deve informarne l’utente/cliente (art. 13, artt. 3–4 della stessa legge 132/25 e art. 50 AI Act) in modo chiaro, comprensibile e non meramente formale.

Non basta dichiarare che un sistema è stato impiegato: occorre spiegare come, per quali funzioni e con quali limiti, affinché il cliente possa valutare consapevolmente la natura della prestazione ricevuta.

L’applicazione delle norme nel notariato

Nel contesto notarile, queste norme assumono un’evidenza ancora maggiore.

La funzione pubblica esercitata dal notaio impone che nessuna fase essenziale dell’atto — dalla verifica della volontà delle parti fino alla certificazione finale — possa essere delegata a un sistema automatizzato. L’IA può intervenire soltanto nelle attività preparatorie, come la predisposizione di bozze o il recupero di informazioni, ma ad esempio non può in alcun modo incidere sulla formazione e sull’accertamento della volontà negoziale.

Ogni utilizzo dell’IA dovrebbe inoltre essere tracciabile e documentato, in coerenza con l’AI Act e con i principi della L. 132/2025 (in particolare art. 13 per le professioni intellettuali e art. 14 per la PA): non solo per ragioni di trasparenza, ma anche per consentire controlli successivi, audit e verifiche interne, ad esempio con registrazione dei log, prompt e output.

In altre parole, la legge attribuisce alla tecnologia un ruolo di supporto, mentre riafferma con forza che la responsabilità della decisione, della valutazione e dell’atto rimane nelle mani del professionista.

Trasparenza e responsabilità nell’uso dell’intelligenza artificiale nel notariato

Nel nuovo ecosistema digitale, la trasparenza diventa appunto una componente essenziale della relazione tra professionista e cittadino. L’uso dell’intelligenza artificiale non può rimanere un elemento “nascosto” nei processi di studio: il cliente ha diritto a sapere non solo se un algoritmo è stato utilizzato, ma anche come e in quale misura esso ha inciso sull’attività professionale.

Questo obbligo di chiarezza, già previsto dal GDPR e ulteriormente rafforzato dall’AI Act e dalla legge 23 settembre 2025, n. 132 (Legge italiana sull’IA), si traduce in quattro domande fondamentali a cui il professionista deve poter rispondere:

- È stato utilizzato un sistema di IA?

- Per quali attività specifiche?

- Con quali limiti e margini di affidabilità?

- Sotto quale forma di supervisione umana?

Non si tratta di un adempimento meramente formale, ma di un elemento sostanziale di tutela dell’utente e del professionista (indirettamente). Spiegare la funzione dell’IA consente al cittadino di comprendere la natura della prestazione che riceve e di valutare l’effettivo ruolo della tecnologia nel processo di formazione dell’atto.

In molti ordinamenti europei, questo principio è già parte integrante della prassi professionale.

In Francia, Germania e Spagna, gli studi notarili e le relative istituzioni hanno introdotto informative che distinguono chiaramente tra:

- attività automatizzate di supporto — come l’analisi preliminare di documenti o la generazione di bozze;

- attività valutative, decisionali e certificative — che restano di esclusiva competenza del notaio.

La distinzione è semplice, intuitiva e facilmente spiegabile al cliente: ciò che riguarda la volontà, la valutazione, il controllo di legalità e la responsabilità finale è sempre umano; e ciò che è meramente esecutivo o ripetitivo può essere assistito dalla tecnologia.

Pubblici ufficiali, PA e limiti strutturali dell’IA nelle funzioni di garanzia

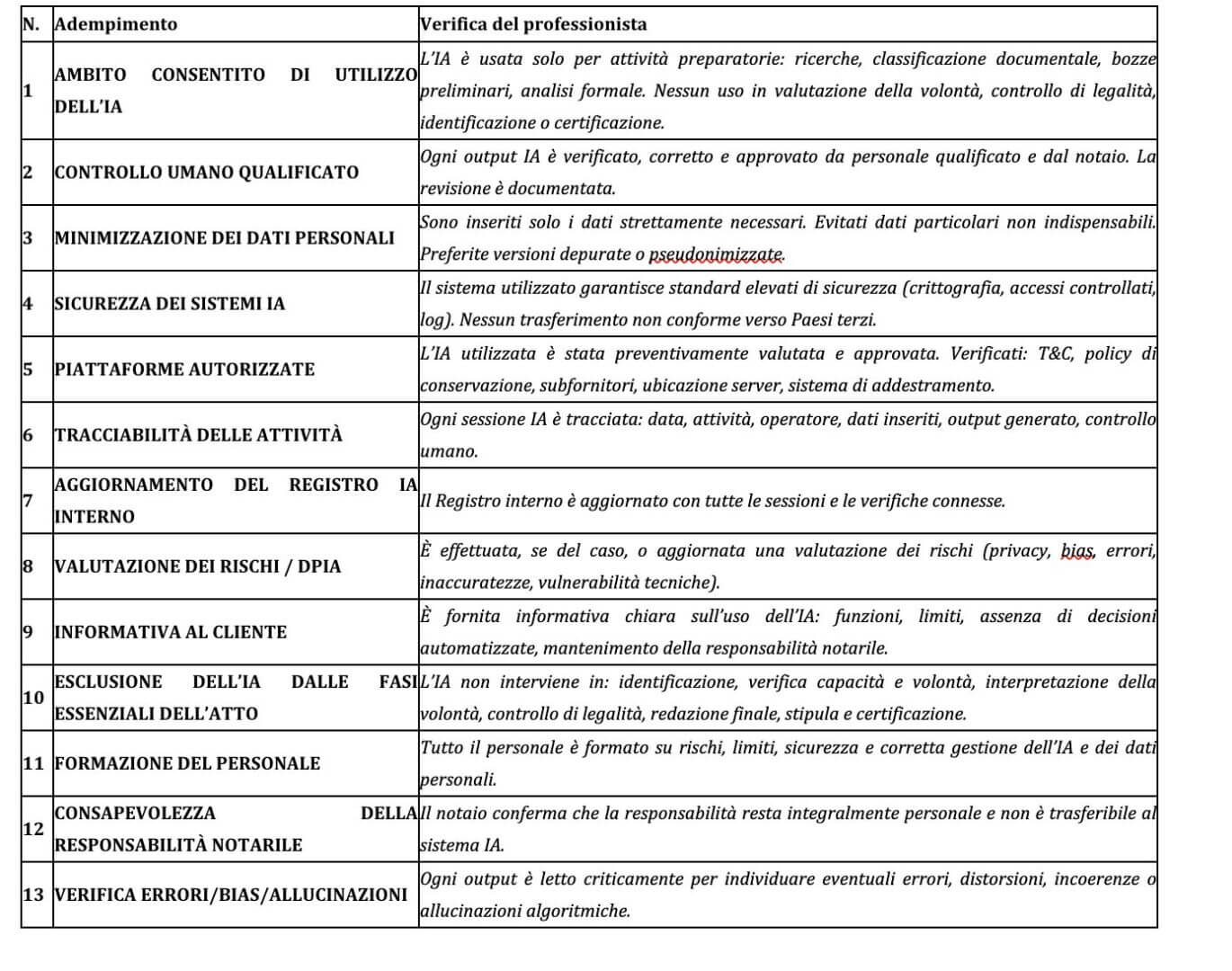

Gli adempimenti del Notaio dunque quali sono? Se dovessimo riassumere in una checklist gli adempimenti per lo studio che vuole avvalersi, nei termini sopraesposti, nel rispetto della normativa di riferimento e privacy, dei sistemi di AI, ecco un sintetico elenco (senza pretesa di esaustività, infatti ogni realtà organizzativa dovrà riadattare alla propria realtà in concreto la verifica di compliance normativa).

Si precisa inoltre che l’obbligo di tracciabilità non è un adempimento formale, ma un vero e proprio metodo di lavoro. Significa conservare i log delle attività svolte con il supporto dell’intelligenza artificiale, definire procedure interne che descrivano in modo chiaro quando e come tali strumenti possono essere utilizzati, e programmare audit periodici per verificare che le regole siano effettivamente rispettate.

In questo modo si crea una “catena di tracciabilità” completa e verificabile, perfettamente coerente con l’impostazione dell’AI Act e con i principi di responsabilità e trasparenza che caratterizzano la funzione notarile.

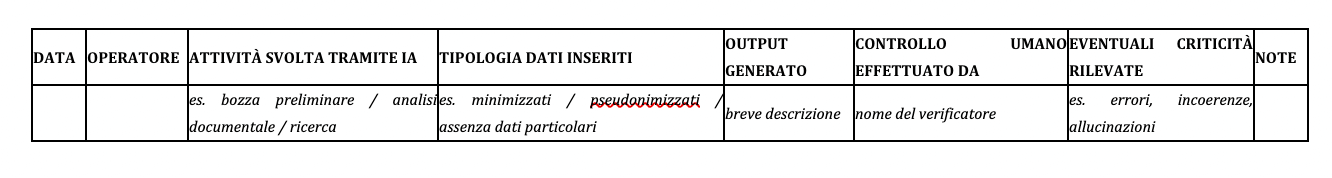

Per questo un registro di attività è indicato anche nella checklist <di partenza> suggerita e potrebbe articolarsi come il modello che segue.

Ora vediamo come la questione relativa alla funzione pubblica del Notaio assuma rilevanza in questo approfondimento. Le funzioni pubbliche che presuppongono discrezionalità tecnica, valutazione etica, tutela della volontà e certificazione giuridica si collocano in una dimensione incompatibile con il funzionamento dei sistemi di intelligenza artificiale attuali.

Queste attività non richiedono soltanto conoscenze normative, ma anche capacità di ascolto, interpretazione del comportamento umano, percezione delle dinamiche relazionali e valutazioni fondate su esperienza e prudenza professionale: elementi che nessun modello statistico è in grado di replicare, come già accennato in premessa.

Per comprendere il motivo di questa incompatibilità, è utile chiarire come viene addestrata l’IA oggi disponibile. I modelli generativi (LLM) vengono formati attraverso l’elaborazione di enormi quantità di testi, raccolti da fonti pubbliche, dataset autorizzati o materiali appositamente selezionati dai fornitori.

L’AI Act (Reg. UE 2024/1689) impone, agli artt. 9 e 10, requisiti molto stringenti sulla qualità, rappresentatività e documentazione dei dataset di addestramento: devono essere controllati, protetti da bias e tracciabili.

In questo processo è bene chiarire che l’utilizzatore finale non “addestra” il modello: le sue interazioni non modificano la struttura del sistema, né costituiscono parte del training originario. Alcune piattaforme possono usare i dati di utilizzo per miglioramenti statistici o analisi di performance, ma solo previo consenso e sempre nel rispetto del GDPR.

Cosa dicono gli studi

Questo limite strutturale spiega perché l’IA, pur essendo un ottimo strumento di supporto, rimane un sistema probabilistico: elabora correlazioni, non giudizi; produce testi plausibili, non decisioni giuridiche.

Studi condotti hanno evidenziato che i modelli generativi tendono a confermare le premesse contenute nei prompt (“confirmatory prompting”), mostrando una suscettibilità alla formulazione delle domande e modifica del modello di risposta.

In ambito giuridico questo fenomeno è particolarmente critico: articoli sul tema hanno segnalato come una domanda formulata da un avvocato o da un giudice in modo assertivo o suggerito possa orientare la risposta dell’IA verso interpretazioni distorte o ipotesi fattuali non aderenti ai principi giuridici consolidati.

Non si tratta, ovviamente, di una “decisione influenzata”, ma di un contenuto che può risultare potenzialmente fuorviante se assunto acriticamente nella fase preparatoria di una decisione o di un atto.

La situazione in Italia

In Italia il tema è stato affrontato anche dalle istituzioni. Il Consiglio Superiore della Magistratura ha stabilito che i sistemi di IA possono essere impiegati solo per attività di supporto, come la ricerca documentale o l’analisi di grandi volumi di atti, mentre ogni valutazione giuridica deve restare esclusiva prerogativa del magistrato. Nella stessa direzione il Ministero della Giustizia.

Se ne deduce che laddove il diritto richiede discernimento, interpretazione della volontà e responsabilità certificativa, la tecnologia può affiancare, ma non sostituire. Il notaio, come pubblico ufficiale, esercita una funzione che si fonda su elementi non replicabili dall’IA: la capacità di valutare se una volontà sia autentica, se una parte sia pienamente consapevole degli effetti dell’atto, se esistano condizioni di vulnerabilità o pressioni esterne, se il contenuto complessivo dell’atto sia conforme alla legge e agli interessi reali delle parti.

Si tratta di attività che si collocano ben al di là della generazione testuale o dell’analisi statistica: sono funzioni di garanzia, responsabilità e tutela che appartengono alla persona del notaio e che nessun sistema probabilistico potrà mai assumere. È proprio questa dimensione, profondamente umana, a mantenere oggi la figura del notaio come insostituibile anche nell’ecosistema digitale contemporaneo.

Il futuro di intelligenza artificiale e professione notarile

L’IA non riduce l’importanza del notaio o del professionista in genere, semmai la amplifica. Richiede più metodo, più trasparenza, più responsabilità per governare uno strumento per definizione approssimativo in quanto probabilistico.

Il notariato, in molti convegni ed eventi formativi, ha affermato la volontà di voler governare l’innovazione, non subirla. Il futuro degli atti pubblici non sarà automatizzato, ma collaborativo:

- la tecnologia sarà un supporto;

- il notaio e il notariato saranno garanti della funzione pubblica anche negli ambiti in cui può essere delegata alla tecnologia;

- il cittadino e i suoi diritti saranno il centro del sistema dal quale partire per aggiornare gli adempimenti e le tutele necessarie nell’impiego dell’IA.

È questa la traiettoria dell’evoluzione: un diritto più efficiente, grazie alla tecnologia, ma sempre e irrimediabilmente umano. L’umanità, che non può fare a meno di sé stessa, è chiamata a governare con professionalità la tecnologia di cui, con tanta intelligenza (umana), si è dotata.