Cattura del presidente del Venezuela Maduro è un evento storico anche per le dinamiche mediatiche digitali.

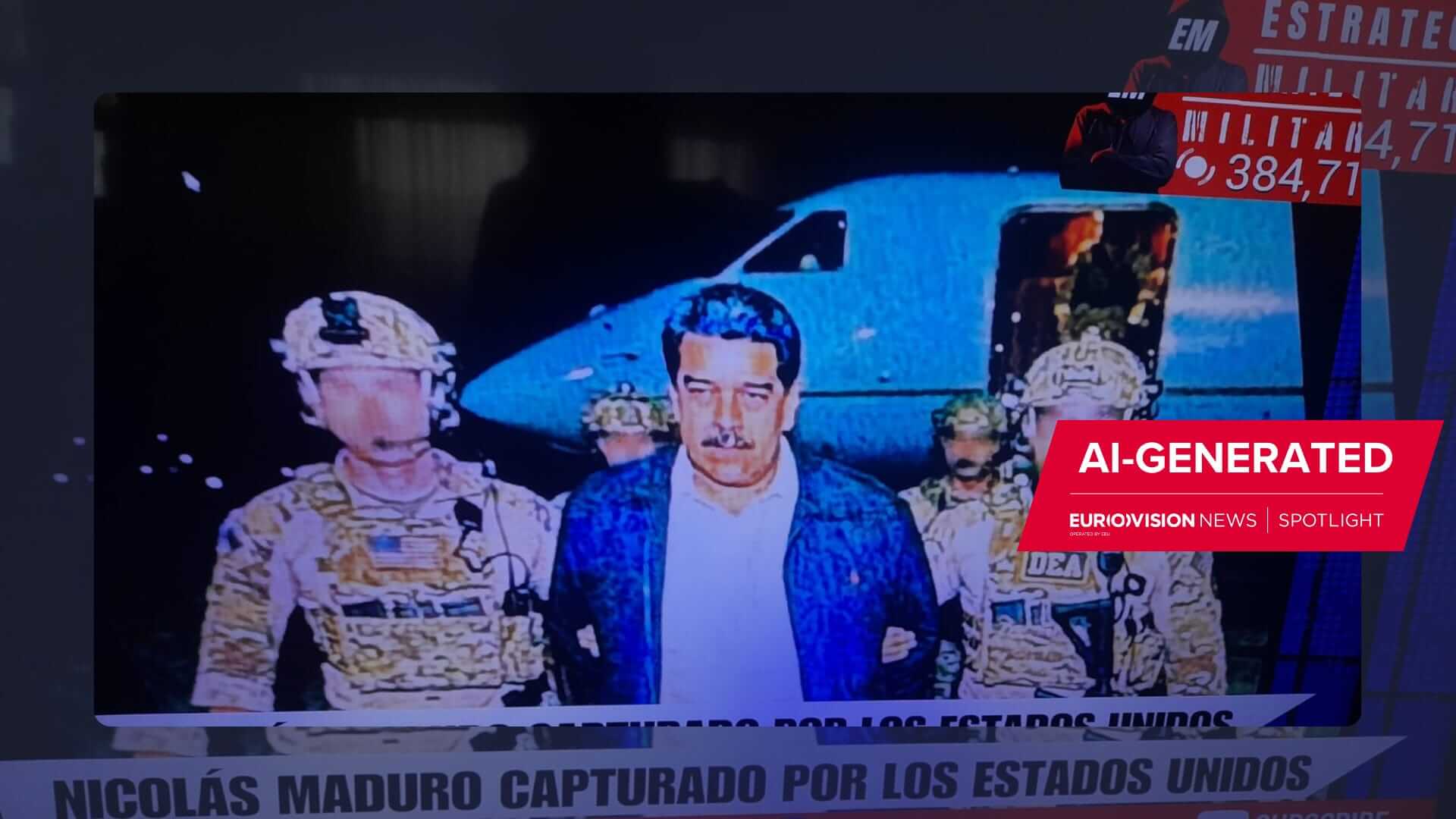

Mentre le istituzioni internazionali faticavano a confermare i fatti e contestualizzarli, sui social media prendeva forma una narrazione parallela. In poche ore, account anonimi e strumenti di intelligenza artificiale generativa hanno prodotto e diffuso immagini e video falsi della cattura di Maduro, sovrapponendosi alla realtà e alimentando un caos informativo senza precedenti.

Questo caso venezuelano rappresenta una svolta allarmante nel rapporto tra informazione e tecnologia: per la prima volta, la disinformazione generata dall’AI ha viaggiato in tempo reale a fianco di un grande evento storico, alterandone la percezione collettiva mentre l’evento era ancora in corso. Le conseguenze vanno oltre i confini locali: l’episodio offre spunti di riflessione per l’Europa e l’Italia sulla tenuta dei nostri ecosistemi informativi, sulle strategie regolatorie da adottare e sulle sfide di governance globale poste dalle nuove tecnologie.

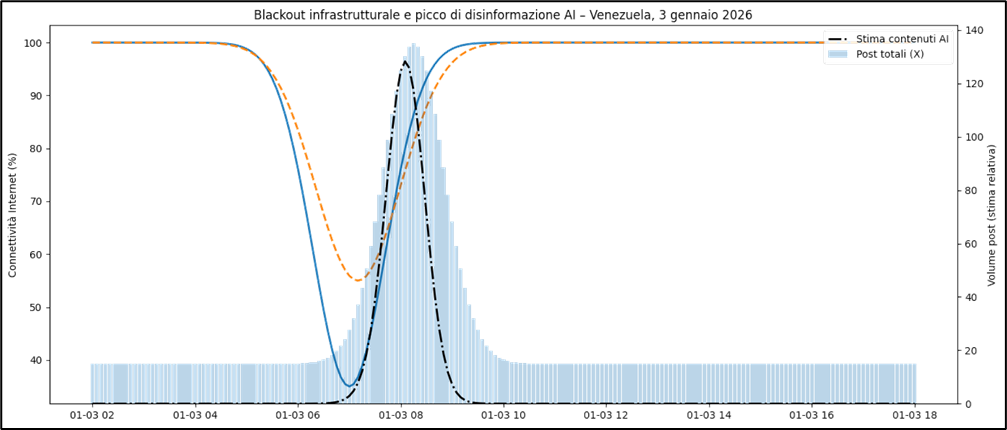

Rielaborazione realizzata con l’utilizzo di dati pubblici di monitoraggio della connettività – NetBlocks, Cloudflare Radar – e su stime di volume informativo derivate da analisi di pattern di diffusione sui social. I contenuti AI-generated sono identificati su base probabilistica

Indice degli argomenti

AI generativa e disinformazione: perché il caso Venezuela segna una svolta

Le ore successive al blitz del 3 gennaio 2026 hanno visto dipanarsi due realtà parallele. Da un lato, la cronaca fattuale dell’operazione militare (nome in codice “Absolute Resolve”) con cui le forze speciali USA hanno neutralizzato le difese di Caracas e catturato Maduro. Sul terreno, l’operazione ha avuto un impatto immediato sulle comunicazioni e sull’ecosistema informativo venezuelano. Gli USA hanno infatti impiegato capacità cibernetiche per neutralizzare le difese: secondo fonti ufficiali, “le luci di Caracas sono state spente grazie a una certa nostra expertise”, ha affermato Trump, alludendo a cyber-attacchi contro la rete elettrica. I dati di monitoraggio indipendenti confermano significative interruzioni di energia e Internet durante il raid.

Come leggere la finestra informativa durante il blackout

Asse X (tempo): 3 gennaio 2026, 02:00–18:00 UTC, risoluzione 5 minuti.

Asse Y sinistro: Connettività Internet (%).

– Linea BLU continua: connettività a Caracas

– Linea tratteggiata ARANCIONE: connettività nell’area metropolitana

Asse Y destro: Volume informativo su X (stima relativa).

– Barre verticali celesti: post totali

– Linea tratto-punto NERA: stima contenuti AI-generated

(Rielaborazione realizzata con l’utilizzo di dati pubblici di monitoraggio della connettività – NetBlocks, Cloudflare Radar – e su stime di volume informativo derivate da analisi di pattern di diffusione sui social. I contenuti AI-generated sono identificati su base probabilistica)

Il blackout apre la “finestra”: quando i deepfake occupano il silenzio

Le linee ondulate mostrano la relazione temporale tra il collasso della connettività a Caracas e il picco di contenuti generati dall’AI: il blackout infrastrutturale apre una finestra informativa che viene immediatamente occupata dalla disinformazione. Questo scenario di “oscuramento informativo” ha creato terreno fertile per confusione e voci incontrollate proprio nel momento più critico della crisi, come la “realtà sintetica” costruita online da immagini e video deepfake: foto apparentemente autentiche che mostravano Maduro in pigiama bianco su un aereo militare, scortato da soldati statunitensi (mentre in realtà il trasferimento avveniva in elicottero), oppure ritratto in pose umilianti e grottesche: contenuti generati dall’AI e diffusi viralmente sui social.

Queste false immagini, viste da oltre 14 milioni di persone solo su X secondo NewsGuard, hanno sopravanzato la capacità dei media tradizionali di verificare e contestualizzare. Solo in seguito, i fact-checker (tramite tool come SynthID) hanno rilevato watermark e artefatti tipici della generazione artificiale, confermando che le foto più virali erano fake: ma a quel punto la percezione pubblica dell’evento era già compromessa.

Perché sembravano “reportage” e non meme

Non si trattava di meme parodistici: al contrario, quei contenuti mimavano il linguaggio visivo del reportage giornalistico, senza indizi di ironia o manipolazione evidente, risultando estremamente credibili. La loro efficacia derivava anche dall’aderenza alle aspettative collettive: un leader autoritario arrestato e umiliato era uno scenario ritenuto plausibile. Questa verosimiglianza ha abbassato la soglia di diffidenza degli utenti, portandoli ad accettare emotivamente le immagini senza troppe domande.

AI generativa e disinformazione in tempo reale: la corsa della “prima ondata”

Un elemento chiave è la tempistica. A differenza di episodi passati, in cui i falsi digitali seguivano (di poco) gli eventi reali, nel caso venezuelano i deepfake sono comparsi in simultanea — o addirittura in anticipo rispetto all’evolversi dei fatti, capovolgendo la sequenza informativa tradizionale. In altri termini, l’AI è stata in grado di generare “prove” visive prima ancora che il fatto fosse stabilito, influenzando immediatamente l’interpretazione pubblica: chi controlla la prima ondata informativa controlla anche la cornice narrativa dell’evento.

Di conseguenza, la cronaca ufficiale si è trovata a inseguire una versione alternativa dei fatti già sedimentata nell’opinione pubblica. In definitiva, il presente stesso diventa contendibile: la prima versione di un fatto che si fissa nell’opinione pubblica potrebbe essere quella fittizia anziché quella reale, con un danno potenzialmente irreversibile alla memoria collettiva.

Quando i leader amplificano i falsi: l’effetto legittimazione

Non a caso, i deepfake di Maduro sono stati rilanciati anche da figure di primo piano — dallo stesso Donald Trump ad altri politici e influencer — conferendo loro un’aura di legittimità e amplificandone ulteriormente la diffusione. Il diretto coinvolgimento di leader e personaggi pubblici nel condividere media sintetici ha reso ancora più arduo il lavoro di smentita da parte delle fonti istituzionali.

Un ulteriore fattore aggravante è stato il vuoto informativo creatosi durante l’operazione militare. Trump stesso ha accennato che durante il raid le luci di Caracas sono state “spente” grazie a certe capacità statunitensi. In effetti, il monitoraggio indipendente ha registrato un crollo della connettività Internet in varie zone della capitale in coincidenza con l’attacco. Il blackout programmato ha paralizzato il comando e controllo del regime, interrotto le comunicazioni civili e seminato confusione, facilitando il raid USA.

AI generativa e disinformazione: i limiti del DSA e la sfida delle piattaforme globali

Quanto accaduto in Venezuela — pur geograficamente lontano — obbliga l’Europa e l’Italia a valutare la propria resilienza di fronte a scenari simili. L’Unione Europea ha adottato il Digital Services Act (DSA) per imporre nuove responsabilità alle piattaforme online, ma il caso Maduro ne evidenzia i limiti: il DSA interviene ex post (segnalando e rimuovendo contenuti illeciti o falsi), mentre i deepfake in tempo reale bruciano le tappe della verifica, consumando il danno prima che scattino i meccanismi di controllo.

Inoltre, la natura globale delle piattaforme rende difficile l’applicazione territoriale delle regole: contenuti generati fuori dall’Europa raggiungono comunque gli utenti UE in tempo reale, eludendo di fatto i confini giuridici. La disinformazione alimentata dall’AI, insomma, non si risolve solo con sanzioni o rimozioni postume: è un problema sistemico, legato all’architettura dell’ecosistema informativo.

Dal “trovare il falso” al “certificare il vero”

Diventa quindi necessario affiancare all’approccio regolatorio tradizionale strategie innovative. Molti esperti propongono di spostare il focus dall’identificazione del falso alla certificazione del vero. Invece di inseguire ogni bufala (impresa ardua, dato il ritmo con cui evolvono i generatori di deepfake), occorre attestare l’autenticità di contenuti e fonti attraverso strumenti tecnologici.

Un esempio è lo standard aperto C2PA (Coalition for Content Provenance and Authenticity), nato dalla collaborazione tra big tech, media e istituzioni: esso punta a includere metadati crittografici di provenienza in immagini e video, consentendo di verificarne l’origine e l’integrità lungo la filiera digitale. Permangono interrogativi su come implementare su larga scala questi meccanismi, ma la direzione è tracciata: watermark invisibili, firme digitali e altre soluzioni potranno in futuro aiutare a distinguere i media autentici dalle simulazioni AI.

Dall’AI Act al reato di deepfake: cosa cambia per l’Italia

Anche l’AI Act europeo — regolamento sull’intelligenza artificiale attualmente in via di approvazione — dovrebbe rafforzare questo quadro, prevedendo ad esempio l’obbligo per i sistemi generativi di dichiarare i contenuti sintetici e vietando pratiche di manipolazione cognitiva altamente invasive. In Italia, l’Autorità di vigilanza sulle comunicazioni (Agcom) ha già messo in guardia sugli effetti destabilizzanti di deepfake e propaganda automatizzata sul dibattito civico e sui processi democratici, operando all’intersezione tra il DSA e il futuro AI Act per fronteggiare questi rischi.

Sul piano legislativo nazionale, l’Italia ha anticipato molti partner introducendo una misura pionieristica: il nuovo reato di deepfake nel Codice penale. Dal fine 2025 è infatti in vigore l’art. 612-quater c.p., che punisce con la reclusione fino a 5 anni chi diffonde, senza consenso, immagini, video o audio falsificati con AI idonei a ingannare e a causare un danno alla persona rappresentata. Questa norma mira, in primo luogo, a tutelare i cittadini da abusi (come i fotomontaggi o video fake a sfondo diffamatorio o pornografico), ma testimonia anche la crescente attenzione delle istituzioni italiane verso il problema più ampio della disinformazione sintetica.

AI generativa e disinformazione: alfabetizzazione digitale e “etica dell’attesa”

Oltre alle leggi, c’è la dimensione culturale ed educativa. In un’era in cui i contenuti artefatti possono apparire perfettamente plausibili, occorre promuovere un’alfabetizzazione digitale rinnovata. Agli utenti va insegnato a riconoscere i segnali di rischio — ad esempio diffidare delle immagini troppo sensazionali comparse “dal nulla” in tempo reale — e a recuperare un’“etica dell’attesa” prima di credere e condividere notizie virali.

Questo cambio di mentalità, per quanto difficile (perché va contro la frenesia del web contemporaneo), è probabilmente l’unico antidoto strutturale nel lungo periodo.

Standard globali e cooperazione: la risposta oltre i confini

La crisi venezuelana del 2026 mette in luce tendenze che richiedono soluzioni globali. In un mondo interconnesso, la guerra dell’informazione non conosce confini: un evento locale può essere manipolato da attori remoti e avere ripercussioni ovunque. Nessun Paese, da solo, può arginare fenomeni di disinformazione lampo che sfruttano piattaforme planetarie e AI avanzate.

Segnali incoraggianti vanno in questa direzione. Nel luglio 2025, ad esempio, una coalizione guidata dagli enti di standardizzazione ISO, IEC e ITU ha lanciato all’AI for Good Global Summit di Ginevra una serie di raccomandazioni per promuovere standard internazionali sull’autenticità dei media digitali e combattere la disinformazione. L’iniziativa — nota come AMAS (AI and Multimedia Authenticity Standards) — ha sottolineato l’urgenza di dotarsi di strumenti tecnici interoperabili a livello globale che permettano di verificare la provenienza dei contenuti generati da AI.

Parallelamente, anche le istituzioni politiche internazionali stanno affrontando il tema: manipolazioni di questo tipo figurano ormai nelle agende di ONU, G7 e altri consessi, con proposte che vanno da codici di condotta volontari a possibili accordi globali sull’uso responsabile dell’AI (c’è chi auspica una sorta di “Convenzione di Ginevra digitale” per il cyberspazio).

In definitiva, servono regole e alleanze globali. La posta in gioco, evidenziata dal caso Venezuela, è la fiducia stessa nella realtà: se i falsi generati dall’AI possono alterare la comprensione degli eventi nel momento in cui accadono, diventa urgente che la comunità internazionale definisca principi comuni e azioni coordinate per arginare questa minaccia. L’Europa e l’Italia, dal canto loro, dovranno continuare a potenziare normative, tecnologie e cultura critica, sapendo che nessuna soluzione agisce in isolamento.

La sfida è planetaria e richiede uno sforzo congiunto: solo integrando politiche condivise, innovazioni tecniche e alfabetizzazione diffusa potremo sperare di preservare un ecosistema informativo in cui la verità fattuale continui a prevalere sulla finzione orchestrata.