L’impatto ambientale dell’intelligenza artificiale è spesso raccontato solo nella sua versione “salvifica”: algoritmi che ottimizzano le reti elettriche, riducono gli sprechi e abilitano la transizione ecologica. Ma dietro questa narrativa verde esiste una infrastruttura fisica fatta di energia, acqua, silicio e metalli rari.

Due immagini – come vedremo – mostrano con chiarezza il paradosso: la stessa tecnologia che promette di ridurre le emissioni rischia, se non governata, di alimentarle.

Indice degli argomenti

La doppia faccia dell’Intelligenza artificiale

Immaginiamo, dunque, due scene. Nella prima, un’intelligenza artificiale (IA) analizza in tempo reale i dati provenienti da migliaia di sensori su una rete elettrica, ottimizzando la distribuzione di energia da fonti rinnovabili e riducendo le emissioni di gas serra con una precisione sovrumana [1].

Nella seconda, un gigantesco data center, cuore pulsante di quella stessa IA, consuma milioni di litri d’acqua al giorno, prelevati da una falda acquifera in una regione afflitta dalla siccità, solo per raffreddare le migliaia di processori che ne consentono il funzionamento [3].

Queste due immagini, apparentemente in contraddizione, rappresentano la doppia faccia dell’IA e il paradosso centrale della nostra era digitale. Da un lato, l’IA viene celebrata come una tecnologia quasi immateriale, una leva strategica per la sostenibilità e la transizione ecologica [1]. Dall’altro, la sua infrastruttura fisica è una delle più energivore e idrovore mai sviluppate dall’uomo, con un’impronta ambientale in crescita esponenziale [5]. L’efficienza digitale, a lungo considerata sinonimo di progresso pulito, si sta rivelando un’arma a doppio taglio.

Questo articolo intende andare oltre la semplice narrazione, analizzando con dati concreti e casi di studio il costo nascosto dell’intelligenza artificiale. Si argomenterà che, per rendere l’IA realmente sostenibile, è necessario un cambio di paradigma: superare il mito dell’efficienza digitale fine a se stessa per abbracciare un modello olistico di “responsabilità computazionale“. Un modello che non si limita a misurare i benefici applicativi, ma che rende conto dell’intero impatto del ciclo di vita dell’IA, dalla produzione dell’hardware al suo smaltimento, riconoscendo che ogni calcolo ha un costo fisico e planetario.

Impatto ambientale dell’intelligenza artificiale: il paradosso di partenza

Prima di analizzare i costi, è fondamentale riconoscere l’enorme potenziale dell’IA come strumento per la sostenibilità. Lungi dall’essere solo una promessa, l’intelligenza artificiale sta già fornendo risultati misurabili in settori chiave, agendo come un “abilitatore critico della sostenibilità“. Ignorare questi successi significherebbe dipingere un quadro incompleto e ingiusto.

Un esempio emblematico è l’ottimizzazione energetica. Google ha dimostrato che l’applicazione degli algoritmi di DeepMind ai sistemi di raffreddamento dei propri data center può ridurre il consumo energetico per questa funzione fino al 40% [1]. Questi sistemi analizzano in tempo reale una moltitudine di variabili operative – carico dei server, temperatura esterna, umidità – per regolare in modo dinamico i sistemi di raffreddamento, minimizzando gli sprechi con una precisione irraggiungibile per un operatore umano [7].

Questo caso dimostra come l’IA possa essere utilizzata per ottimizzare se stessa, creando un circolo virtuoso di efficienza. Nel campo delle catene di approvvigionamento globali, l’IA sta diventando uno strumento indispensabile per la trasparenza e la sostenibilità. Aziende come Unilever la utilizzano per monitorare le proprie supply chain e garantire che materie prime critiche, come l’olio di palma, provengano da fonti responsabili che non contribuiscono alla deforestazione.

Integrando immagini satellitari, dati IoT e registri blockchain, gli algoritmi possono tracciare l’origine dei prodotti, identificare inefficienze, ridurre gli sprechi e assicurare la conformità a standard etici e ambientali [1].

Forse l’applicazione più promettente riguarda la gestione delle reti energetiche e la transizione verso le rinnovabili. La natura intermittente di fonti come il solare ed eolico rappresenta una delle maggiori sfide per la stabilità delle reti elettriche. L’IA offre soluzioni concrete.

La società energetica AES, ad esempio, ha impiegato l’IA per la manutenzione predittiva delle sue turbine eoliche. Analizzando i dati operativi, i modelli sono in grado di prevedere i guasti dei componenti con un’accuratezza del 90%, consentendo interventi mirati che hanno ridotto i costi di riparazione da 100.000 a 30.000 dollari per intervento ed eliminato 3.000 viaggi di manutenzione non necessari [8].

Su scala più ampia, l’IA può ottimizzare la distribuzione del carico sulla rete, prevedere la produzione energetica e la domanda, e facilitare l’integrazione di milioni di piccoli produttori di energia (come i pannelli solari domestici), accelerando così la decarbonizzazione [2]. Questi successi, tuttavia, rappresentano solo una faccia della medaglia.

Dal mito verde all’impatto ambientale dell’intelligenza artificiale nella transizione digitale

Dietro le promesse di un futuro verde si cela una realtà fisica ingombrante. Il cosiddetto “paradosso della sostenibilità” dell’IA risiede nel fatto che la crescita esponenziale della sua domanda computazionale supera di gran lunga i miglioramenti di efficienza dell’hardware sottostante [6].

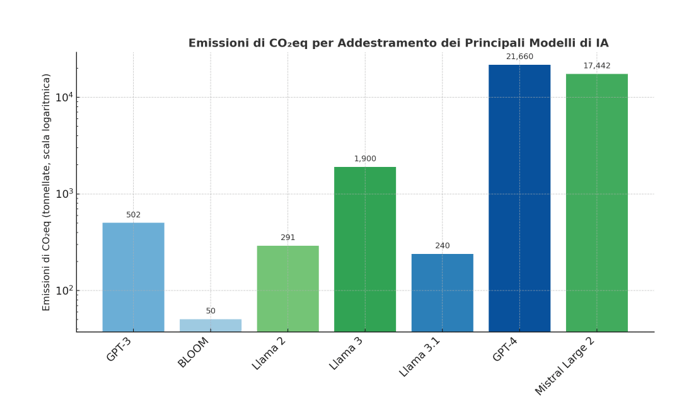

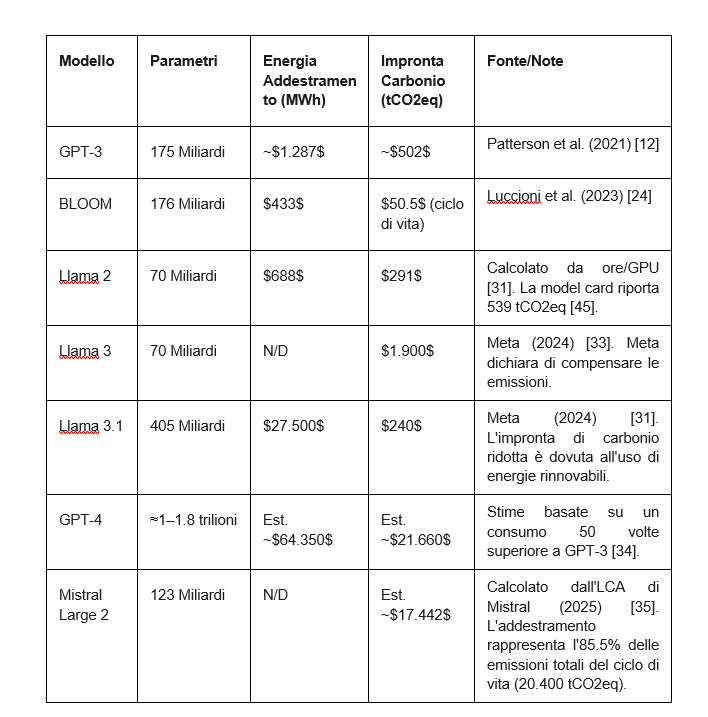

L’idea di una tecnologia “cloud” immateriale è un’illusione: il cloud ha una sua fisicità, fatta di cavi sottomarini, silicio, metalli rari e, soprattutto, giganteschi data center che consumano energia e acqua su scala industriale. Come mostra la Figura 1, l’impronta di carbonio associata all’addestramento dei modelli di intelligenza artificiale cresce in modo esponenziale con la loro dimensione e complessità.

Dalle centinaia di tonnellate di CO₂ emesse per addestrare modelli come GPT-3 o Llama 2, si passa alle oltre 20 mila tonnellate stimate per GPT-4, a testimonianza di quanto la corsa alla potenza computazionale possa avere un costo ambientale ormai non trascurabile.

Figura 1 – Emissioni di CO2eq per Addestramento dei Principali Modelli di IA

La corsa ai modelli giganti e l’impatto ambientale dell’intelligenza artificiale

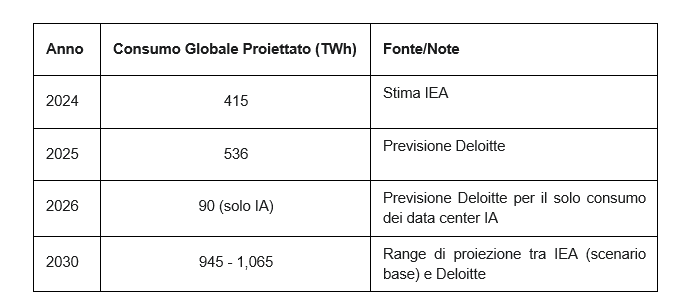

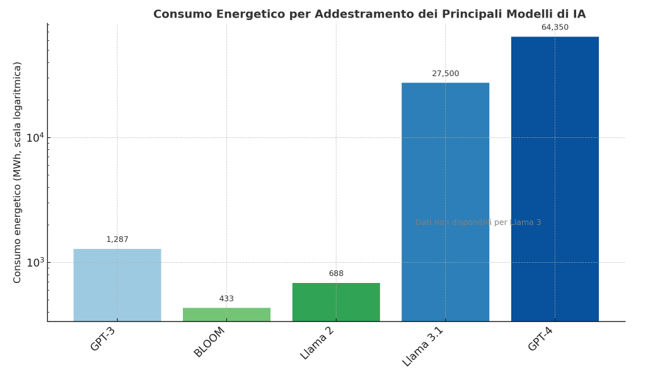

La fame di elettricità dell’IA è il suo costo più evidente. Secondo l’Agenzia Internazionale dell’Energia (IEA), il consumo energetico globale dei data center, che oggi si attesta tra l’1% e il 2% della domanda elettrica mondiale, potrebbe aumentare dell’80% tra il 2022 e il 2026 [9].

Le proiezioni più recenti, aggiornate al 2025, dipingono un quadro ancora più netto della traiettoria di crescita [10,11]:

Questa esplosione è guidata principalmente dall’avvento dell’IA generativa (GenAI). Una singola richiesta a un modello come ChatGPT può consumare fino a dieci volte l’elettricità di una ricerca su Google [5]. Ciò è dovuto alla straordinaria intensità computazionale richiesta sia per l’addestramento che per l’inferenza (l’uso) di questi modelli.

La potenza dei chip grafici (GPU), i cavalli di battaglia dell’IA, è passata dai 400 watt dei modelli del 2022 ai 1.200 watt previsti per le nuove generazioni del 2025 [9].

La crescita del fabbisogno energetico è ancora più evidente se si osservano i dati di consumo complessivo per l’addestramento dei principali modelli di intelligenza artificiale. Come illustrato nella Figura 2, l’energia necessaria per addestrare i modelli di nuova generazione, come GPT-4 o Llama 3.1, è aumentata di oltre due ordini di grandezza rispetto alle generazioni precedenti, raggiungendo decine di migliaia di megawattora per singolo ciclo di training.

Figura 2 – Consumo energetico per l’addestramento dei principali modelli di IA, espresso in MWh, scala logaritmica.

L’addestramento di un singolo modello di grandi dimensioni (Large Language Model, LLM) è un’impresa titanica. Si stima che possa consumare tanta elettricità quanto 100 abitazioni statunitensi in un intero anno [7]. Per quantificare questo impatto, è utile analizzare alcuni modelli specifici, includendo dati aggiornati al 2025.

La tabella evidenzia una crescita esponenziale dei consumi, ma anche l’impatto cruciale del mix energetico. L’addestramento di Llama 3.1, ad esempio, ha consumato un’enorme quantità di energia (27.500 MWh), ma ha generato un’impronta di carbonio relativamente bassa (240 tCO2eq) grazie all’uso intensivo di fonti rinnovabili.

Al contrario, modelli come Llama 3 (70B) e GPT-4 mostrano impronte di carbonio immense, sottolineando come la corsa verso modelli sempre più grandi, se non accompagnata da una strategia energetica sostenibile, abbia costi ambientali proibitivi.

Un deserto digitale: impatto ambientale dell’intelligenza artificiale sulle risorse idriche

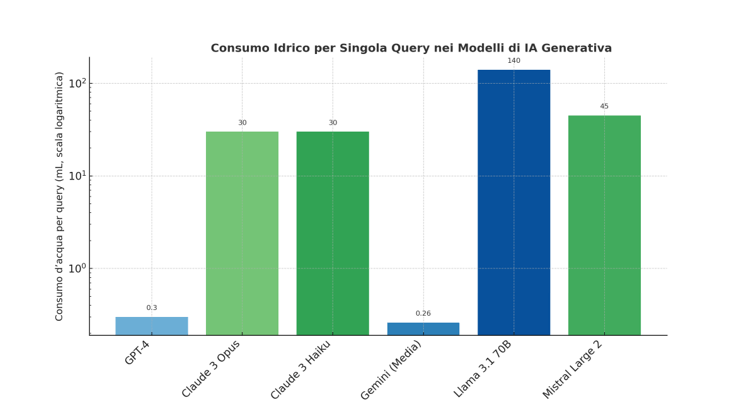

Se la fame di energia è allarmante, la sete d’acqua dell’IA è forse ancora più insidiosa, perché il suo impatto è intensamente locale. Anche a livello di singola interazione, l’impatto idrico dell’IA è tutt’altro che trascurabile.

Come mostra la Figura 3, la quantità d’acqua necessaria per generare una sola risposta può variare di centinaia di volte tra i diversi modelli: da meno di 0,3 mL per una query su GPT-4 o Gemini, fino a oltre 100 mL per modelli di grandi dimensioni come Llama 3 70B o Mistral Large 2. Una differenza che, moltiplicata per milioni di richieste giornaliere, rende evidente quanto la sostenibilità dell’IA dipenda anche dall’efficienza delle infrastrutture di raffreddamento.

Figura 3 – Consumo idrico per singola query nei principali modelli di IA generativa, scala logaritmica.

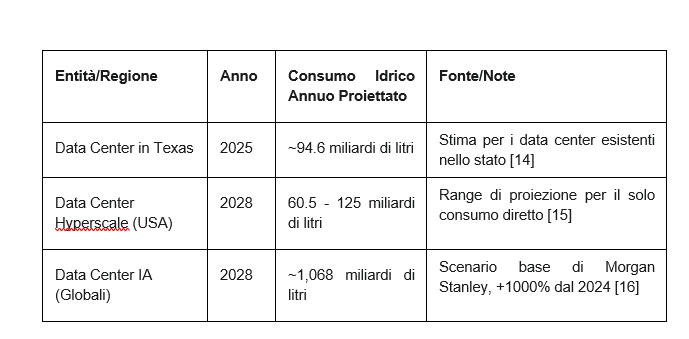

I data center utilizzano enormi quantità d’acqua, spesso potabile, principalmente per il raffreddamento evaporativo: l’acqua assorbe il calore prodotto dai server e viene poi espulsa sotto forma di vapore [3]. Il consumo è sia diretto (per il raffreddamento) sia indiretto (per la produzione dell’elettricità che alimenta l’impianto, specialmente se da fonti fossili o nucleari) [13].

L’ascesa dell’IA ha già portato a un aumento del consumo idrico del 20% per Google e del 34% per Microsoft [5]. Questo consumo si scontra drammaticamente con la realtà della crisi climatica in regioni già afflitte da stress idrico.

Caso concreto 1: Arizona, USA

Nel cuore del deserto del Sonora, una regione che affronta una storica siccità a causa del prosciugamento del fiume Colorado, i giganti della tecnologia stanno costruendo enormi data center. Un impianto di Microsoft a Goodyear, Arizona, è stato progettato per consumare fino a 212 milioni di litri di acqua potabile all’anno, l’equivalente del fabbisogno di 670 famiglie locali.

A Mesa, Google ha ottenuto un permesso per un data center che può utilizzare fino a 5.5 milioni di metri cubi d’acqua all’anno, pari al consumo di 23.000 abitanti dell’Arizona.3 Il paradosso è evidente: mentre lo stato revoca i permessi di costruzione per nuove abitazioni a causa della scarsità d’acqua, approva progetti che consumano risorse idriche su scala industriale per alimentare il cloud [3,4].

Caso Concreto 2: Aragona, Spagna

In Spagna, dove il 75% del territorio è a rischio desertificazione, la regione agricola dell’Aragona è diventata un hub per i data center. I nuovi impianti proposti da Amazon sono autorizzati a utilizzare 755.720 metri cubi d’acqua all’anno, una quantità sufficiente a irrigare 233 ettari di mais, una delle principali colture locali.

Inoltre, Amazon ha richiesto un aumento del 48% del consumo idrico per i suoi centri già esistenti, citando come motivazione l’aumento delle temperature globali dovuto al cambiamento climatico. La reazione delle comunità locali è stata forte. Gli agricoltori temono per le loro coltivazioni, mentre gruppi di attivisti come “Tu Nube Seca Mi Río” (“La tua nuvola prosciuga il mio fiume”) chiedono una moratoria sulla costruzione di nuovi data center, evidenziando il conflitto diretto tra le necessità del mondo digitale e quelle del mondo reale.

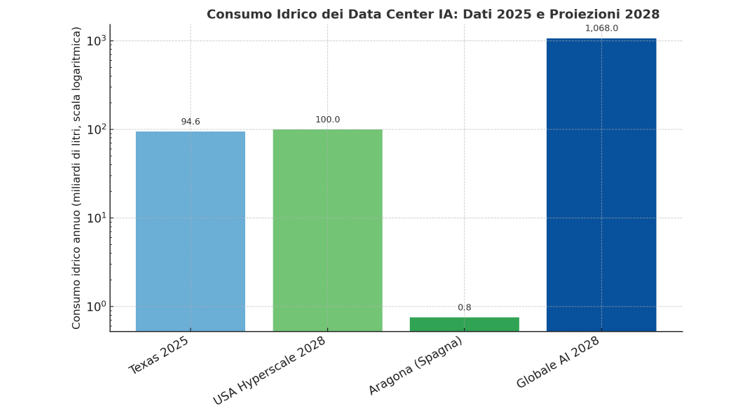

I due casi citati non sono episodi isolati, ma la manifestazione locale di una tendenza globale. Le proiezioni aggiornate al 2028 mostrano infatti un aumento vertiginoso del consumo idrico complessivo dei data center dedicati all’IA. Come sintetizzato nella Figura 4, il fabbisogno d’acqua mondiale per mantenere operative queste infrastrutture potrebbe superare 1 trilione di litri l’anno, con una crescita stimata di oltre +1000% rispetto al 2024.

Un impatto che, se non governato, rischia di compromettere l’equilibrio tra innovazione tecnologica e risorse naturali.

Figura 4 – Consumo idrico dei data center IA: dati 2025 e proiezioni 2028 per Texas, Aragona, USA hyperscale e livello globale. Scala logaritmica.

Questi casi dimostrano che l’impatto dell’IA non è un problema globale astratto, ma una questione di risorse locali e tangibili. Lo sviluppo dell’infrastruttura digitale sta creando nuove arene di conflitto per le risorse e solleva profonde questioni di giustizia ambientale.

I benefici globali dell’IA sono spesso pagati con costi ambientali e sociali locali, a carico di comunità già vulnerabili [17,14,15].

L’impatto ambientale dell’intelligenza artificiale a livello di singola query

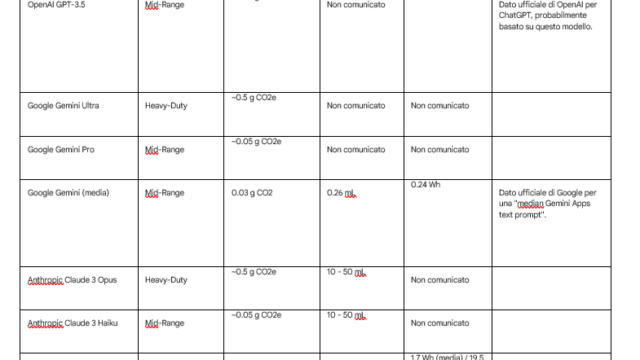

Oltre all’impatto macroscopico di addestramento e infrastruttura, i dati più recenti del 2025, resi pubblici da aziende come Mistral AI e Google, permettono di quantificare anche il costo ambientale di una singola interazione con i modelli di IA generativa.

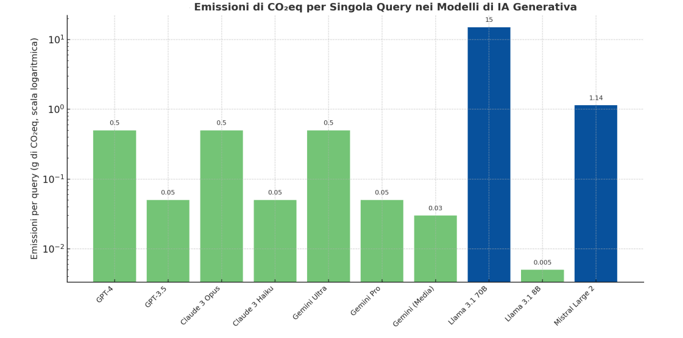

Questi dati rivelano differenze significative tra i diversi sistemi e sottolineano come ogni prompt abbia un costo misurabile. Come evidenziato nella Figura 5, anche una singola interazione con un modello di intelligenza artificiale genera un’impronta ambientale misurabile.

Le differenze tra modelli heavy-duty (come GPT-4 o Claude 3 Opus) e mid-range (come GPT-3.5 o Gemini Pro) possono superare un ordine di grandezza: da circa 0,5 grammi di CO₂eq per query nei modelli più potenti, a 0,05 grammi o meno per quelli più leggeri.

Figura 5 – Emissioni di CO₂eq per singola query nei principali modelli di IA generativa, scala logaritmica.

Hardware, ciclo di vita e impatto ambientale dell’intelligenza artificiale

L’impatto ambientale dell’IA non si esaurisce con il consumo operativo di energia e acqua. Una valutazione completa richiede un’analisi del ciclo di vita (Life Cycle Assessment, LCA), una metodologia che considera l’impatto di un prodotto “dalla culla alla tomba”, dall’estrazione delle materie prime alla produzione, all’uso e allo smaltimento finale [23].

Lo studio sul modello BLOOM ha rivelato che le “emissioni incarnate” (embodied emissions), ovvero quelle associate alla produzione dell’hardware (server e GPU) necessario per l’addestramento, ammontano a 11.2 tonnellate di CO2eq, rappresentando oltre il 20% dell’impronta di carbonio totale del ciclo di vita del modello [24].

Questo dato svela un costo spesso ignorato: la rapida obsolescenza dell’hardware per l’IA, che genera enormi quantità di rifiuti elettronici (e-waste), e l’impatto sociale e ambientale legato all’estrazione di metalli rari e minerali necessari per la produzione dei chip [5].

Questo quadro complesso porta a una considerazione cruciale. L’industria tecnologica si concentra spesso sui guadagni di efficienza, come l’aumento delle operazioni per watt (FLOPS/watt) [25].

Sebbene questi miglioramenti siano reali e importanti, essi vengono vanificati da un fenomeno noto come “effetto rimbalzo” (o paradosso di Jevons). I guadagni di efficienza rendono la tecnologia più potente e meno costosa, incentivandone un uso su scala sempre più vasta. Di conseguenza, il consumo energetico assoluto non diminuisce, ma esplode.

Focalizzarsi solo sull’efficienza relativa è fuorviante; la vera metrica di sostenibilità deve essere il consumo assoluto di risorse.

Greenwashing, trasparenza e giustizia ambientale nell’era dell’IA

La crescente consapevolezza dell’impronta ambientale dell’IA ha dato origine a un fenomeno preoccupante: l’AI greenwashing. Questo termine descrive la pratica di enfatizzare le applicazioni “verdi” dell’IA (come quelle descritte nella prima sezione) per distogliere l’attenzione e nascondere l’enorme impatto della sua stessa infrastruttura.

Il parallelo con lo scandalo “Dieselgate” di Volkswagen è calzante. La casa automobilistica promuoveva veicoli “clean diesel” dotati di software progettato per barare sui test delle emissioni.

Allo stesso modo, un’azienda tecnologica può lanciare una campagna mediatica su un progetto di riforestazione basato sull’IA mentre i suoi data center contribuiscono alla desertificazione di una regione agricola. È una forma di marketing ingannevole che sfrutta la percezione positiva della tecnologia per mascherare costi ambientali insostenibili.

La mancanza di trasparenza è il terreno fertile per il greenwashing. Molte delle più grandi aziende tecnologiche non divulgano dati granulari e verificabili sul consumo di energia e acqua dei loro singoli data center, spesso trincerandosi dietro la “natura proprietaria” di tali informazioni.

Questa opacità rende quasi impossibile per le comunità locali, i ricercatori e i regolatori valutare il vero impatto di queste infrastrutture.

La responsabilità etica, quindi, inizia con la trasparenza. È necessario un impegno radicale per misurare e comunicare onestamente l’impatto completo del ciclo di vita dei sistemi di IA. Paradossalmente, la stessa intelligenza artificiale può diventare uno strumento per combattere il greenwashing, analizzando automaticamente i report di sostenibilità aziendali, incrociando dati da fonti diverse (notizie, report di ONG, dati satellitari) e identificando le incongruenze tra le dichiarazioni di un’azienda e le sue reali performance ambientali [26].

Verso una responsabilità computazionale per ridurre l’impatto ambientale dell’intelligenza artificiale

La traiettoria attuale, guidata dalla sola massimizzazione delle performance, non è sostenibile. È necessario un nuovo paradigma: la responsabilità computazionale. Questo concetto va oltre la semplice efficienza (fare di più con meno).

Implica un approccio olistico che considera l’impatto ambientale, sociale ed etico come vincoli di progettazione fondamentali, non come optional da considerare a posteriori [6]. Significa chiedersi non solo “quanto è accurato il modello?”, ma anche “qual è il costo ambientale per ogni punto percentuale di accuratezza guadagnato?”.

Questo cambiamento culturale richiede strumenti pratici. Il campo della Green AI offre una “cassetta degli attrezzi” tecnica per costruire un’intelligenza artificiale più sostenibile, integrando l’efficienza ecologica in ogni fase del suo ciclo di vita [25].

Le tecniche chiave includono:

- Efficienza Algoritmica: Invece di costruire modelli sempre più grandi, si possono usare tecniche per renderli più snelli ed efficienti. Il pruning (potatura) rimuove le connessioni neurali superflue, riducendo le dimensioni e il carico computazionale del modello. La quantization (quantizzazione) utilizza calcoli a precisione numerica ridotta, che richiedono meno energia. La knowledge distillation (distillazione della conoscenza) trasferisce le capacità di un modello grande e ingombrante a un modello “studente” più piccolo e agile, senza una perdita significativa di performance [27].

- Hardware Ottimizzato e Data Center Sostenibili: Lo sviluppo di hardware specializzato come le Tensor Processing Units (TPU) e le innovazioni nella progettazione dei data center, come il raffreddamento a liquido a circuito chiuso (che riduce drasticamente il consumo d’acqua) e il riutilizzo del calore di scarto per riscaldare edifici vicini, sono fondamentali per ridurre l’impronta fisica dell’IA [25].

- Approccio Data-Centric: La qualità dei dati è cruciale. Utilizzare dataset più piccoli ma di altissima qualità può permettere di raggiungere performance elevate con modelli più compatti e meno tempo di addestramento, riducendo drasticamente il consumo energetico [28].

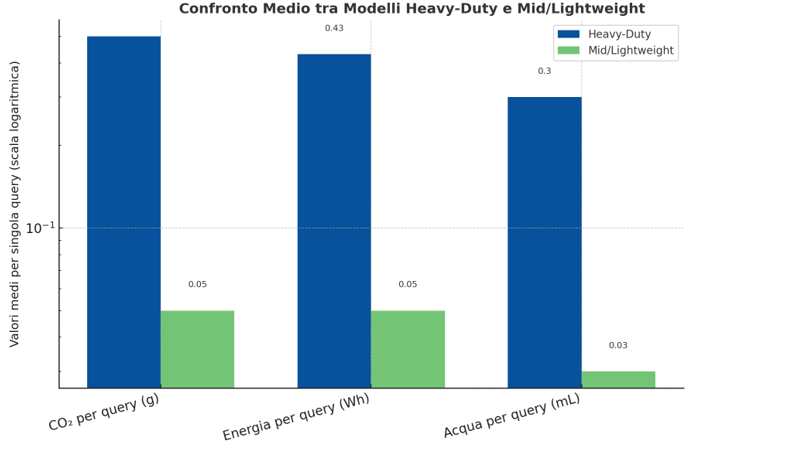

La differenza tra modelli heavy-duty e lightweight non è solo teorica, ma misurabile in termini di consumo di risorse. Come mostra la Figura 6, i modelli di dimensioni più contenute riducono in media di un ordine di grandezza le emissioni di CO₂, l’energia e l’acqua necessarie per ogni singola operazione.

Questi dati dimostrano che l’efficienza ecologica può coesistere con l’innovazione tecnologica, se la sostenibilità viene considerata come parametro di progetto sin dalle prime fasi di sviluppo.

Figura 6 – Confronto medio tra modelli Heavy-Duty e Mid/Lightweight: emissioni di CO₂, energia e acqua per singola query, scala logaritmica.

Tuttavia, la soluzione non è solo tecnica. È necessaria una prospettiva di design più ampia, come quella offerta dalla Sustainable Human-Computer Interaction (SHCI). Questo campo di ricerca si concentra sulla progettazione di tecnologie interattive che considerino il loro intero impatto ambientale e sociale. I suoi principi sono direttamente applicabili all’IA:

- Energy-Aware Design: Progettare sistemi che non solo siano efficienti, ma che rendano gli utenti consapevoli del consumo energetico delle loro azioni e li incentivino a comportamenti più sostenibili. Ad esempio, un’interfaccia potrebbe visualizzare il “costo” di una query complessa o suggerire alternative meno energivore [29].

- Resource-Conscious Design: Progettare hardware per la durabilità, la riparabilità e la modularità, combattendo attivamente l’obsolescenza programmata e promuovendo un’economia circolare per i dispositivi elettronici [29].

L’implicazione di questi approcci è profonda: la sostenibilità non può essere un’ottimizzazione a posteriori. Deve diventare un vincolo di progettazione primario, al pari dell’accuratezza e della velocità. La vera innovazione non consisterà nel creare il modello più grande, ma quello più efficiente dal punto di vista ecologico per un dato livello di performance.

Conclusioni: quale futuro per l’IA e il pianeta?

Il paradosso dell’intelligenza artificiale è lo specchio delle contraddizioni della nostra epoca. Abbiamo creato uno strumento con il potenziale per risolvere alcune delle sfide più grandi dell’umanità, inclusa la crisi climatica, ma lo abbiamo costruito su fondamenta che consumano voracemente le risorse del pianeta.

Il mito dell’efficienza digitale, che prometteva una crescita smaterializzata e pulita, si è scontrato con la dura realtà fisica dell’energia, dell’acqua e del silicio.

La traiettoria attuale, guidata da una corsa sfrenata verso modelli sempre più grandi e potenti, non è sostenibile. Continuare su questa strada significa rischiare che l’impronta ambientale dell’IA annulli i benefici che essa stessa potrebbe portare.

Ma l’obiettivo non è fermare l’innovazione; è reindirizzarla.

Per farlo, è necessario un impegno collettivo basato sul principio della responsabilità computazionale.

● Gli sviluppatori e i ricercatori devono adottare i principi di Green AI e SHCI, iniziando a riportare sistematicamente l’impronta ambientale dei loro modelli accanto alle metriche di performance. La trasparenza deve diventare la norma, non l’eccezione.

- Le aziende devono andare oltre il greenwashing e abbracciare una trasparenza radicale, pubblicando dati verificabili sui consumi delle loro infrastrutture e investendo in soluzioni realmente sostenibili, non solo in campagne di marketing.

- I policy maker hanno il compito di creare quadri normativi, sulla scia dell’AI Act europeo [43], che incentivino la responsabilità computazionale, richiedano valutazioni di impatto ambientale per i sistemi di IA su larga scala e proteggano le risorse vitali delle comunità locali.

L’intelligenza artificiale non è intrinsecamente “buona” o “cattiva” per il pianeta. È uno strumento la cui direzione dipende dalle scelte che facciamo oggi. La sfida è trasformarla da un motore di pura efficienza, indifferente ai costi, a un partner intelligente e responsabile nella costruzione di un futuro che sia, finalmente, sostenibile in ogni suo aspetto.

Ringraziamenti

Si ringraziano i membri, collaboratori ed amici del gruppo di ricerca M.O.D.A.L. (Mathematical MOdelling and Data AnaLisys) del Dipartimento di Matematica e Applicazioni “Renato Caccioppoli” – Università degli Studi di Napoli Federico II per le stimolanti discussioni sull’argomento trattato.

Bibliografia

- Artificial Intelligence and Sustainability: – Innovations in Business and Managerial Practices – Research Highlights & Events, https://research.sbs.edu/sbsrm/SBSRM01_Research%20Monography_01.pdf

- 22 AI Use Cases in Sustainability, Green Energy & Renewables – Scry AI, https://scryai.com/blog/use-cases/sustainability-green-energy-and-renewable-industries/

- The Cloud is Drying our Rivers: Water Usage of AI Data Centers | EthicalGEO, https://ethicalgeo.org/the-cloud-is-drying-our-rivers-water-usage-of-ai-data-centers/

- Microsoft Is Draining Arizona’s Water for its AI – Futurism, https://futurism.com/the-byte/microsoft-arizona-water-ai

- Environmental impact of artificial intelligence – Wikipedia, https://en.wikipedia.org/wiki/Environmental_impact_of_artificial_intelligence

- Sustainable AI – ML Systems Textbook, https://www.mlsysbook.ai/contents/core/sustainable_ai/sustainable_ai.html

- Green AI Application Use Cases & Development | SapientPro, https://sapient.pro/blog/green-ai-use-cases

- 5 AI Case Studies in Energy | VKTR, https://www.vktr.com/ai-disruption/5-ai-case-studies-in-energy/

- The increasing energy demand of artificial intelligence and its impact on commodity prices, https://www.ecb.europa.eu/press/economic-bulletin/focus/2025/html/ecb.ebbox202502_03~8eba688e29.en.html

- Energy demand from AI – IEA, https://www.iea.org/reports/energy-and-ai/energy-demand-from-ai

- Data center sustainability | Deloitte insights, https://www.deloitte.com/us/en/insights/industry/technology/technology-media-and-telecom-predictions/2025/genai-power-consumption-creates-need-for-more-sustainable-data-centers.html

- AI’s Growing Carbon Footprint – State of the Planet – Columbia University, https://news.climate.columbia.edu/2023/06/09/ais-growing-carbon-footprint/

- Tips for Researching Massive Water Consumption by Data Centers, https://gijn.org/stories/researching-water-consumption-data-centers/

- Data centers are thirsty for Texas’ water, but state planners don’t know how much they will need, https://www.texastribune.org/2025/09/25/texas-data-center-water-use/

- What we know about energy use at U.S. data centers amid the AI boom, https://www.pewresearch.org/short-reads/2025/10/24/what-we-know-about-energy-use-at-us-data-centers-amid-the-ai-boom/

- AI data centers to drive 11-fold rise in water consumption by 2028: Morgan Stanley, https://m.economictimes.com/tech/artificial-intelligence/ai-data-centers-to-drive-11-fold-rise-in-water-consumption-by-2028-morgan-stanley/articleshow/123755912.cms

- Amazon, Google, & Microsoft allegedly operating and expanding water-intensive data centres in some of the world’s driest regions, https://www.business-humanrights.org/en/latest-news/amazon-google-microsoft-allegedly-operating-and-expanding-water-intensive-datacentres-in-some-of-the-worlds-driest-region/

- How Big Tech’s Data Centers Are Draining Water-Stressed Regions, https://impakter.com/how-big-techs-data-centers-are-draining-water-stressed-regions/

- The ESG Cost of Meta, Google & Microsoft’s AI Investments | Sustainability Magazine, https://sustainabilitymag.com/articles/the-real-cost-of-meta-google-microsofts-ai-investments

- Our contribution to a global environmental standard for AI | Mistral AI, https://mistral.ai/news/our-contribution-to-a-global-environmental-standard-for-ai

- Google new Research Paper : Measuring the environmental impact of delivering AI – Reddit, https://www.reddit.com/r/LocalLLaMA/comments/1mymak3/google_new_research_paper_measuring_the/

- Measuring the environmental impact of delivering AI at Google Scale, https://services.google.com/fh/files/misc/measuring_the_environmental_impact_of_delivering_ai_at_google_scale.pdf

- Lifecycle Assessment of AI Models: Measuring and Mitigating Energy Consumption, https://www.researchgate.net/publication/389100406_Lifecycle_Assessment_of_AI_Models_Measuring_and_Mitigating_Energy_Consumption

- Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model, https://www.jmlr.org/papers/volume24/23-0069/23-0069.pdf29

- Green AI Explained: Fueling Innovation with a Smaller Carbon Footprint, https://carboncredits.com/green-ai-explained-fueling-innovation-with-a-smaller-carbon-footprint/

- How AI is exposing greenwashing and false ESG claims – The …, https://escp.eu/thechoice/tomorrow-choices/greenwashing-in-corporate-sustainability-how-ai-is-exposing-false-esg-claims/

- Green Federated Learning: A new era of Green Aware AI, D Thakur, A Guzzo, G Fortino, F Piccialli, ACM Computing Surveys 57 (8), 2025

- Chapter 10 How to apply green AI in practice? in – Brill, https://brill.com/edcollchap-oa/book/9789004730779/BP000017.xml

- Sustainable Human-Computer Interaction → Term, https://prism.sustainability-directory.com/term/sustainable-human-computer-interaction/

- Governare l’AI prima che ci governi: chi paga il prezzo degli errori algoritmici – TuttoTech, https://www.tuttotech.net/intelligenza-artificiale/intelligenza-artificiale-errori.html

- The environmental cost of model training | by BONDS | Medium, https://medium.com/@sbondale/the-environmental-cost-of-model-training-9c1b66c32b2e

- The Real Carbon Cost of an AI Token – DitchCarbon Blog, https://ditchcarbon.com/blog/llm-carbon-emissions

- The Carbon Emissions of Training AI Models – Voronoi, https://www.voronoiapp.com/technology/The-Carbon-Emissions-of-Training-AI-Models-1447

- AI and energy: Will AI reduce emissions or increase power demand ?, https://www.weforum.org/stories/2024/07/generative-ai-energy-emissions/

- Mistral AI publishes the first comprehensive life cycle assessment of a large language model, https://the-decoder.com/mistral-ai-publishes-the-first-comprehensive-life-cycle-assessment-of-a-large-language-model/