L’annuncio di Google VaultGemma segna una svolta epocale nel campo dell’intelligenza artificiale: per la prima volta, una delle principali Big Tech rilascia un modello linguistico di grandi dimensioni costruito “privacy by design”.

VaultGemma promette di risolvere uno dei più grandi ostacoli all’adozione su larga scala dell’Intelligenza Artificiale, soprattutto in settori regolamentati come sanità, finanza e pubblica amministrazione: la tutela dei dati sensibili durante la fase di addestramento del modello.

Indice degli argomenti

Il problema della privacy nei modelli di AI

I modelli di Intelligenza Artificiale che conversano con noi, suggeriscono testi, traducono e scrivono email sono straordinari strumenti di produttività. Eppure, dietro la magia di una risposta automatica si nasconde un rischio reale per la privacy: durante l’addestramento, i modelli di Intelligenza Artificiale assorbono dati di ogni tipo, anche contenuti riservati, personali, medici o confidenziali.

Finora non era raro che, se sollecitati in un certo modo, i modelli LLM (Large Language Models, come ChatGPT o Gemini) restituissero persino parti di testi originali, mettendo a rischio segreti aziendali, diagnosi mediche e identità degli utenti. VaultGemma nasce proprio per affrontare questo problema: come possiamo fidarci di un assistente virtuale se può “ricordare” e svelare quello che gli abbiamo “dato in pasto”?

Cos’è Vault Gemma, l’AI con la privacy incorporata

VaultGemma non è semplicemente una nuova versione: rappresenta una “ripartenza” nella progettazione dei modelli di Intelligenza Artificiale. Grazie all’applicazione nativa di tecniche di privacy differenziale (“differential privacy”), Google ha costruito un LLM con un miliardo di parametri nel quale la protezione dei dati è parte integrante della fase di apprendimento, non applicata in seguito. Ciò significa che sin dall’inizio l’algoritmo è stato istruito per non “memorizzare” mai dati personali, nemmeno se lo si stimola ad estrarre frammenti precisi dell’addestramento.

La privacy differenziale è un metodo matematico: in fase di addestramento, ad ogni passo viene aggiunto del rumore statistico appositamente calibrato, rendendo impossibile a posteriori dedurre se un dato specifico era presente o meno nel dataset usato dall’Intelligenza Artificiale. Questi meccanismi garantiscono che nemmeno chi progetta il modello possa mai sapere con certezza se una testimonianza medica, un elemento finanziario, una mail privata abbia inficiato il comportamento del modello finale.

VaultGemma offre una soluzione che può cambiare radicalmente le regole del gioco per tutti coloro che vorrebbero sfruttare il potenziale dell’Intelligenza Artificiale ma sono costretti a rispettare normative stringenti, come il nostro GDPR, ossia il Regolamento Europeo in materia di protezione dei dati personali.

I vantaggi di VaultGemma

Tra i vantaggi pratici, vi sono gli esempi che seguono:

- gli ospedali possono addestrare modelli su dati clinici senza il rischio di re-identificazione dei pazienti;

- le banche, le assicurazioni e le finanziarie possono automatizzare processi sfruttando dati privati senza temere fughe di informazioni;

- la pubblica amministrazione può digitalizzare archivi e comunicazione, mantenendo il rispetto della privacy dei cittadini.

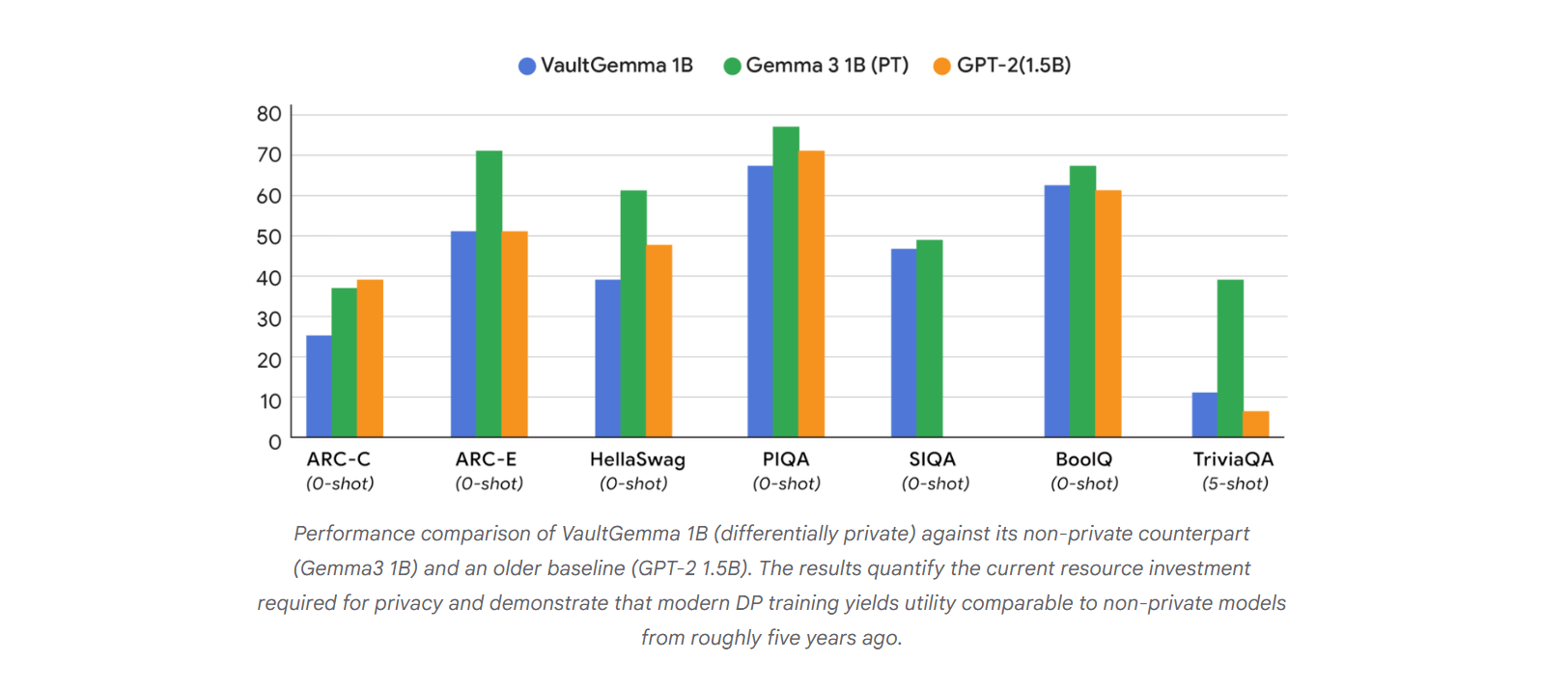

Come spesso accade in tecnologia, il paradigma “privacy by design” (presente anche nel GDPR) comporta alcune rinunce. Google ha reso trasparente che VaultGemma, allenato interamente con privacy differenziale, ha prestazioni comparabili a modelli di generazione testuale di qualche anno fa, anziché all’avanguardia di oggi. L’aggiunta di rumore nella fase di addestramento riduce inevitabilmente la precisione: gli output possono essere meno sofisticati e precisi rispetto a quelli di modelli simili ma privi di protezione privacy.

Aumenta il costo computazionale con VaultGemma

Ma ecco il punto cruciale: più protezione si vuole garantire, più occorre “pagare” in termini di dati, tempo e risorse computazionali. È una vera legge di scala che Google dimostra nel suo studio: privacy, costi e qualità devono essere bilanciati.

Tra le varie applicazioni pratiche dove VaultGemma può fare la differenza vi sono alcuni scenari concreti in cui VaultGemma può diventare la soluzione ideale:

- redazione automatizzata di cartelle cliniche, senza rischio di diffusione dei dati del paziente;

- gestione intelligente della corrispondenza finanziaria e dei documenti strategici di una banca;

- supporto alle ricerche scientifiche basate su dati personali o medicali “reali”.

Un esempio particolarmente significativo riguarda la formazione di modelli per il triage medico, l’assistenza a distanza e la telemedicina: VaultGemma può ricevere dati di casi clinici veri, apprendendo schemi generali senza “fissarsi mai” su informazioni individuali.

Gli impatti di Google VaultGemma

La nascita di VaultGemma facilita il lavoro dei giuristi, dei DPO (Data Protection Officer) e degli enti regolatori. Spesso, la mancanza di trasparenza su come i dati vengono “digeriti” dai modelli di Intelligenza Artificiale è la principale ragione di divieti e limitazioni nell’adozione dell’intelligenza artificiale. VaultGemma promette di superare questo ostacolo, adottando metodologie validate anche da esperti esterni. La trasparenza dell’intero processo poi, a partire dai dataset artificiali e arrivando all’algoritmo di training pubblicato e revisionato, costituisce una base solida su cui costruire applicazioni dell’Intelligenza Artificiale più sicure dal punto di vista normativo.

Per la prima volta, uno dei più avanzati modelli privacy-first viene rilasciato in modo open, invitando la comunità dei ricercatori mondiale a sottoporlo a stress test, confronti e analisi. VaultGemma diventa così un laboratorio per tutti coloro che vogliono capire davvero come funziona la privacy differenziale applicata alla linguistica computazionale.

L’arrivo di VaultGemma rappresenta l’inizio di una nuova era, dove il rispetto della privacy non è più un “optional” posticcio ma un elemento fondante dell’intero processo di sviluppo dell’Intelligenza Artificiale.

Significa dare fiducia agli utenti, alle aziende e agli enti pubblici. Significa, in altre parole, potersi affidare all’innovazione “senza paura”. E se i modelli futuri adotteranno la strada aperta da VaultGemma, sarà possibile una vera integrazione dell’Intelligenza Artificiale nei processi vitali della società: dalla sanità pubblica al servizio clienti, dalla ricerca accademica all’automazione del settore legale e di quello finanziario.

La presentazione di VaultGemma da parte di Google insomma non è una semplice “release” tecnica, ma un segnale di cambiamento che riguarda tutta la società digitale.

In un mondo dominato da domande sulla sicurezza, sulla riservatezza e sull’etica delle macchine, VaultGemma è il primo passo concreto verso una Intelligenza Artificiale in grado di collaborare davvero con noi senza rischiare di tradire la nostra fiducia. La sfida ora è nelle mani della comunità: testare, migliorare, diffondere e adottare modelli dove la privacy non è un lusso, ma una precondizione. Google VaultGemma apre la strada a un’Intelligenza Artificiale finalmente “umana”, in grado di proteggere ciò che ci rende unici: la nostra riservatezza.[1]

[1] Google releases VaultGemma, its first privacy-preserving LLM. Ars Technica. https://arstechnica.com/ai/2025/09/google-releases-vaultgemma-its-first-privacy-preserving-llm/?utm_brand=arstechnica&utm_social-type=owned&utm_source=mastodon&utm_medium=social