L’avvento delle tecnologie basate sull’Intelligenza Artificiale, in particolare dei modelli linguistici di grandi dimensioni (LLM) come ChatGPT, ha inaugurato una nuova era nel rapporto tra l’uomo e la conoscenza, ma anche profonde modificazioni nei processi di produzione e gestione della conoscenza stessa, con un’enorme influenza sui processi cognitivi e di apprendimento delle informazioni da parte degli individui.

Indice degli argomenti

Delegare alla macchina: il paradosso cognitivo

Tali sistemi, capaci di generare testi, analizzare dati e fornire risposte complesse con una rapidità senza precedenti, sono stati presentati come catalizzatori di produttività e strumenti di potenziamento cognitivo. Eppure, questa rivoluzione tecnologica solleva un interrogativo profondo e, per certi versi, paradossale: la delega di compiti cognitivi a una macchina, concepita per amplificare le nostre capacità intellettive, potrebbe in realtà condurre a un progressivo indebolimento dell’intelligenza umana?

Definizione di ignoranza artificiale e carico cognitivo

Questo interrogativo non riguarda una semplice mancanza di conoscenza, ma un fenomeno più sottile e insidioso che è possibile definire “ignoranza artificiale”, ovvero la delega della conoscenza alla macchina da parte dell’uomo. A differenza della tradizionale ignoranza, che si basa su una lacuna informativa, l’ignoranza artificiale descrive una condizione di dipendenza acritica dai sistemi di intelligenza artificiale.

La tesi: non più stupidi, ma a rischio debito cognitivo

Tale si manifesta come una “non-conoscenza” consapevole o inconscia, una progressiva riduzione della capacità di affrontare l’incertezza, il rischio e la complessità attraverso il pensiero autonomo: acquisire conoscenza, infatti, impone all’uomo uno sforzo cognitivo (cognitive load) che può essere facilmente aggirato, delegando alla macchina il processo di ricerca, gestione e memorizzazione delle informazioni, inibendo il lavoro intellettuale dell’uomo. L’etimologia stessa del termine “intelligenza”, derivante dal latino intus legere (leggere dentro), evoca l’atto di penetrare la realtà oggettiva per coglierne il significato profondo, una funzione volitiva individuale che si contrappone radicalmente all’atto superficiale di “leggere fuori”, delegando il processo conoscitivo a un algoritmo.

La tesi centrale di questo breve articolo (supportato da una sostanziosa bibliografia) è che l’IA non ci rende intrinsecamente “stupidi”, ma che il suo utilizzo passivo e sostitutivo, anziché attivo e complementare, possa determinare un rischio di “debito cognitivo”. Tale condizione, se non adeguatamente gestita, ha conseguenze misurabili sul funzionamento del cervello a livello individuale e sulla coesione intellettuale della società stessa.

Perimetro dell’analisi e metodo

La seguente analisi si allontana dalla semplicistica dicotomia tra un progresso inesorabile e una catastrofe imminente, per addentrarsi nei complessi meccanismi neurobiologici, nelle implicazioni psicologiche e nelle dinamiche sociali che definiscono la linea sottile tra potenziamento e atrofia intellettiva.

Per esplorare ciò che sta accadendo al nostro cervello a causa dell’avvento dell’intelligenza artificiale, ci si concentrerà sull’impatto neurobiologico di tale tecnologia, esplorando il concetto di “debito cognitivo” attraverso le più recenti evidenze scientifiche, esaminando le conseguenze dirette di questa delega mentale sulla memoria, la creatività e il senso di paternità dei contenuti prodotti.

Infine, si analizzeranno le dinamiche collettive di polarizzazione, omogeneizzazione, atrofizzazione e appiattimento del pensiero umano, che possono emergere dall’uso su vasta scala degli strumenti di intelligenza artificiale, determinando una modificazione dei processi di cognitivi e delle dinamiche di produzione di nuova conoscenza.

Il “debito cognitivo”: evidenze neurobiologiche e psicologiche dell’atrofia mentale indotta dall’IA

Il concetto di “debito cognitivo” emerge come una delle principali preoccupazioni nell’attuale dibattito relativo all’impatto dell’IA sulla conoscenza umana. Tale nozione, coniata per descrivere un fenomeno di “atrofia mentale” indotto dall’eccessiva delega di compiti intellettivi a sistemi esterni d’intelligenza artificiale, è stata paragonata all’atrofia muscolare che si verifica quando un arto non viene più utilizzato: con il tempo, il cervello perde forza, elasticità e reattività se non viene costantemente stimolato da sfide intellettuali. Si tratta di una conoscenza “a gravità zero” che non impegna più il cervello nello sforzo cognitivo di acquisizione, gestione ed immagazzinamento dell’informazione, ovvero il lavoro necessario all’apprendimento e alla produzione di conoscenza, determinandone di conseguenza l’atrofizzazione.

Lo studio del MIT

Uno studio condotto al Media Lab del Massachusetts Institute of Technology (MIT), rilasciato in versione pre-print sulla piattaforma arXiv della Cornell University e non ancora revisionato, ha fornito le prime prove neurofisiologiche di questo fenomeno. La ricerca, condotta da un team di scienziati coordinato da Nataliya Kosmyna, ha utilizzato un approccio multi-metodo che ha combinato dati neurofisiologici, test comportamentali e valutazioni qualitative per studiare gli effetti dell’uso di chatbot di IA generativa sull’attività cognitiva (Kosmyna et al., 2025). Il team di ricerca ha reclutato 54 studenti universitari, di età compresa tra 18 e 39 anni, residenti nell’area di Boston. I partecipanti sono stati suddivisi in tre gruppi sperimentali, ognuno con un diverso strumento a disposizione per la stesura di un saggio su temi specifici: un gruppo ha utilizzato ChatGPT (LLM), un secondo gruppo ha avuto a disposizione un motore di ricerca tradizionale come Google (Search Engine), e un terzo gruppo ha dovuto affidarsi esclusivamente alle proprie capacità cognitive (Brain-only).

Ogni gruppo ha completato tre sessioni nelle stesse condizioni. In una quarta sessione, gli utenti LLM sono stati riassegnati al gruppo Brain-only (LLM-to-Brain), e gli utenti Brain-only sono stati riassegnati alla condizione LLM (Brain-to-LLM).

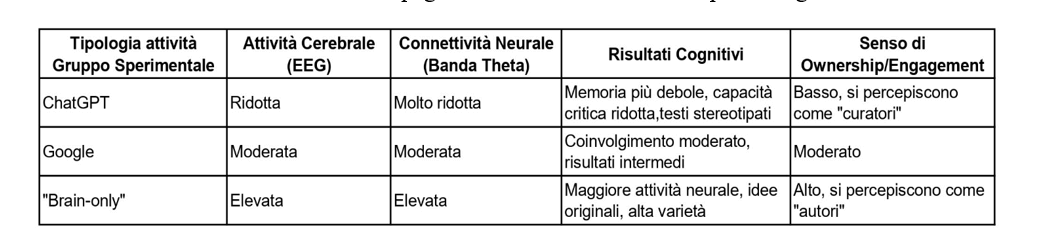

Durante le sessioni di scrittura, i ricercatori hanno misurato l’attività elettrica del cervello dei partecipanti utilizzando un dispositivo elettroencefalografico (EEG). Hanno analizzato la connettività neurale attraverso la funzione di trasferimento dinamica diretta (dDTF) e hanno confrontato i risultati tra i gruppi. I risultati hanno rivelato differenze marcate e “preoccupanti” tra i gruppi. La connettività cerebrale si riduceva sistematicamente all’aumentare del supporto esterno: dopo il task, il gruppo Brain-only, ossia quello che ha utilizzato unicamente le proprie capacità cognitive, ha mostrato reti neurali più forti e più estese, il gruppo del motore di ricerca un coinvolgimento intermedio, e l’assistenza dell’IA ha suscitato l’accoppiamento neurale più debole in assoluto. In particolare, il gruppo che ha utilizzato ChatGPT ha mostrato una significativa e progressiva riduzione della connettività neurale.

Questo disimpegno cerebrale è stato descritto come un fenomeno di “pilotaggio automatico” cognitivo. Gli studenti, anziché affrontare attivamente il processo di elaborazione delle idee e strutturazione del testo, si sono limitati a un ruolo di “curatori” delle risposte generate dall’IA, delegando ad essa il lavoro concettuale, riducendo drasticamente l’impegno mentale richiesto dal compito. Un risultato particolarmente allarmante dello studio è che la riduzione dell’attività cerebrale non era un effetto transitorio. Quando ai partecipanti del gruppo ChatGPT è stato successivamente chiesto di svolgere un compito autonomamente in modalità Brain-only (nella sessione 4), hanno continuato a mostrare una minore attività cerebrale, faticando a generare idee originali e a strutturare il pensiero senza l’assistenza dell’IA. Questo suggerisce che l’abitudine alla delega all’IA non solo influisce sulla performance mentale attuale, ma può instaurare una dinamica duratura di disimpegno neurale, riducendo le capacità cognitive. Al contrario, i partecipanti che per la prima volta hanno utilizzato l’IA dopo aver scritto autonomamente hanno mostrato un “picco a livello di rete” nella connettività neurale in tutte le bande di frequenza, suggerendo che l’integrazione di uno strumento esterno in un flusso di lavoro endogeno richieda un maggiore sforzo cognitivo e integrazione, mantenendo un range di prestazione mentale normale.

La tabella dimostra che, sebbene gli strumenti di IA generativa offrano una scorciatoia per la produttività, il costo a lungo termine è una progressiva atrofizzazione delle funzioni mentali fondamentali: nei compiti che richiedono attività cognitiva, il soggetto preferisce la strada del “risparmio energetico”, riducendo il proprio impegno mentale nell’esecuzione di un compito intellettivo e determinando una riduzione delle connessioni neurali.

Meccanismi psicologici di supporto: il Cognitive Offloading e la Teoria del Carico Cognitivo

Le evidenze neurobiologiche si allineano a meccanismi psicologici già noti. Uno di questi è il Cognitive offloading (scaricamento cognitivo), descritto da Risko e Gilbert (2016). Questo fenomeno si riferisce alla tendenza umana a delegare compiti mentali complessi a supporti esterni. L’avvento di Internet ha già manifestato un’incarnazione di questo meccanismo: il cosiddetto Google Effect (o “amnesia digitale”) ha dimostrato che la disponibilità di informazioni a portata di mano riduce la necessità di conservarle nella memoria a lungo termine, inducendo un’abitudine alla ricerca anziché alla memorizzazione. L’IA porta questo fenomeno a un livello superiore, poiché non si limita a fornire un link a un’informazione, ma un’intera risposta già elaborata, senza che l’utente debba impegnarsi in una più approfondita attività cognitiva.

Per comprendere il perché di questa atrofia, è utile fare riferimento alla Teoria del Carico Cognitivo (Cognitive Load Theory) dello psicologo australiano John Sweller (1988). La teoria distingue tra tre tipi di carico cognitivo:

- Carico interno (o intrinseco): lo sforzo mentale richiesto dalla complessità intrinseca del compito intellettivo (es. risolvere un’equazione complessa).

- Carico estraneo (o estrinseco): lo sforzo mentale superfluo, causato da una cattiva progettazione del materiale informativo o da informazioni non rilevanti o ridondanti (es. immagini superflue o ripetitive in un manuale).

- Carico essenziale (o germano): lo sforzo cognitivo richiesto per l’apprendimento effettivo, ovvero la costruzione di schemi mentali a lungo termine.

L’IA promette di ridurre il carico estrinseco, rendendo il processo più efficiente. Tuttavia, il rischio più grande è che, fornendo risposte già pronte e complete, riduca anche il carico essenziale. Quando un algoritmo svolge al posto umano il lavoro di sintesi, analisi e strutturazione del pensiero, lo studente o l’individuo non è più costretto a impegnarsi in quei processi mentali che sono cruciali per l’apprendimento, ovvero l’acquisizione di schemi di conoscenza profondi. Si verifica quindi un’illusione di efficienza che, a lungo andare, compromette la capacità stessa di imparare e di elaborare il pensiero in modo autonomo, esponendo all’inattività i circuiti cerebrali.

La crisi dell’autonomia: memoria, creatività e identità dell’autore

Le implicazioni del “debito cognitivo” non si limitano all’attività neurale, ma si estendono a funzioni cognitive superiori e persino al senso di identità individuale.

IA come “Mente estesa” vs. “Mente sostituita”

Una prospettiva ottimistica vede le tecnologie digitali come una “Mente estesa”, una teoria proposta da Clark e Chalmers (1998). Secondo questa visione, gli strumenti tecnologici possono diventare parte integrante del nostro sistema cognitivo, in una relazione fluida e bidirezionale. Per esempio, usare il GPS per orientarsi o il calendario digitale per gestire gli impegni non significherebbe delegare il pensiero, ma estenderlo, integrandolo in un sistema più ampio. I sostenitori della mente estesa sostengono che i processi cognitivi non sono confinati al cervello, ma possono estendersi all’ambiente circostante e agli artefatti tecnologici con cui interagiamo, inglobandoli nel pensiero.

Tuttavia, questa teoria ha ricevuto critiche che mettono in guardia contro una visione troppo semplicistica dell’integrazione tra uomo e macchina. Il punto cruciale non è tanto l’uso dello strumento, quanto la modalità con cui avviene l’interazione. La differenza fondamentale tra un’estensione positiva e una sostituzione dannosa risiede nell’intenzionalità e nel grado di controllo che l’utente mantiene sul processo. Quando si utilizza un’IA come un “amplificatore” per un brainstorming, per generare idee iniziali o per sbloccare un blocco creativo, l’individuo rimane il protagonista del processo, mantenendo il controllo sulla fase di progettazione e sulla verifica finale del prodotto. Al contrario, quando l’IA viene usata come una “scorciatoia”, delegando completamente la generazione di un testo o la soluzione di un problema fin dalle prime fasi, si verifica una vera e propria sostituzione della mente umana. In questo scenario, l’utente perde il controllo del processo creativo e decisionale, trasformando l’IA da alleato in un sostituto del pensiero, come sta accadendo a un numero sempre più altro di studenti.

L’impatto sulla creatività e sull’originalità

La creatività, una delle capacità più unicamente umane, è anch’essa oggetto di questo dibattito. L’IA generativa è indubbiamente un potente strumento creativo. È capace di simulare stili artistici, generare mondi virtuali, comporre musica, generare video dal semplice testo, offrendo ai creatori (creators o makers) la possibilità di superare i propri limiti. L’IA può fungere da acceleratore del processo creativo, rimuovendo i “punti di attrito”, fornendo nuove ispirazioni e automatizzando i compiti ripetitivi e meccanici. Questa collaborazione tra uomo e macchina può portare allo sviluppo di nuovi prodotti e metodi di lavoro, come dimostrato nel settore del design o della sanità.

Tuttavia, l’altra faccia della medaglia è il rischio di omologazione e appiattimento. Le evidenze dello studio del MIT indicano che i testi generati con l’assistenza dell’IA tendono a essere più stereotipati, uniformi, ripetitivi e privi di quella “firma personale” che contraddistingue il pensiero umano. Poiché i modelli linguistici si addestrano su vasti corpus di dati preesistenti, essi replicano prevalentemente stili e schemi di pensiero già ampiamente accettati, trascurando le forme d’arte meno convenzionali o non mainstream. Questo processo può portare a un’omogeneizzazione dei risultati creativi, riducendo la diversità di stili ed espressioni, omologando il lavoro intellettuale. Se, come affermato da alcuni studiosi, il pensiero umano è intrinsecamente imperfetto, ma anche ricco di emozione, intuizione ed esperienza, l’IA può replicare la forma, ma non la sostanza di questa complessità.

La crisi dell’ownership e dell’engagement

L’impatto psicologico e cognitivo della delega della conoscenza indotta dall’utilizzo di sistemi di IA si manifesta anche in una riduzione del senso di ownership e di engagement della conoscenza stessa. Nello studio del MIT, gli studenti che avevano utilizzato ChatGPT hanno dichiarato di provare un minore senso di paternità e un ridotto coinvolgimento soggettivo nel loro lavoro, percependosi come semplici “curatori” anziché come “autori”. Al contrario, coloro che avevano scritto autonomamente producevano testi più originali e mantenevano una memoria chiara del loro elaborato. Inoltre, il gruppo che aveva usato l’IA ha mostrato una capacità significativamente ridotta di citare correttamente le frasi dei propri saggi, un deficit che è persistito anche dopo aver smesso di usare l’IA, confermando una “codifica superficiale” (skimming) del contenuto nella memoria.

Questa diminuzione del senso di paternità è direttamente collegata a un concetto più ampio: la “pigrizia metacognitiva”. La metacognizione è la capacità di riflettere sul proprio processo di pensiero. Quando l’IA fornisce una risposta immediata e già pronta, l’utente non è più costretto a compiere lo sforzo di ragionamento, di analisi e di sintesi che porta alla “soddisfazione della scoperta personale”. La fatica del pensiero, pur essendo impegnativa, è un elemento fondamentale per l’apprendimento profondo, e la sua eliminazione rischia di portare a una progressiva perdita di iniziativa personale, che si manifesta come pigrizia mentale e disinteresse.

Il confine tra un uso sano e una delega dannosa si definisce proprio nella capacità di resistere alla tentazione della risposta immediata e di accettare la lentezza del pensiero umano. La delega della conoscenza causata dall’utilizzo dell’IA può inoltre determinare un altro rischio: quello di riporre eccessiva fiducia nelle capacità della macchina, affidandosi ciecamente alle risposte dell’IA. Com’è noto, il fenomeno delle “allucinazioni” determinato dal “bias dell’infallibilità della macchina” può generare conseguenze serie nel processo di acquisizione e gestione della conoscenza, specie se questo è applicato ai processi decisionali. Quando ci si basa sulle informazioni fornite dall’IA per prendere decisioni, è necessario controllare attentamente che le risposte fornite dalla macchina siano affidabili e basate su dati verificati. La perdita di “controllo umano significativo” sulle risposte dell’IA può comportare enormi conseguenze, specie se tali informazioni sono utilizzate per prendere decisioni che mettono in gioco la vita degli individui, come nel caso dei sistemi d’arma autonomi (AWS).

Dalle “camere d’eco” algoritmiche alla “ignoranza collettiva”

L’analisi sull’impatto dell’IA non può limitarsi al singolo individuo, ma deve estendersi alle dinamiche sociali e al modo in cui la tecnologia plasma la diversità delle idee, il sapere collettivo e la coesione intellettuale della società.

Tra Filter Bubble ed Echo Chamber

Per comprendere appieno le nuove sfide poste dall’IA, è fondamentale distinguere due concetti chiave della sociologia digitale: la Filter Bubble e la Echo Chamber. La Filter Bubble (bolla di filtraggio) è un fenomeno passivo e algoritmico, in cui i risultati di ricerca e i feed di notizie vengono personalizzati in base al comportamento passato dell’utente, alle sue preferenze (like), alle sue condivisioni (share), alla sua posizione geografica e alla sua storia di navigazione, creando una “bolla informativa”. Questo meccanismo crea un ambiente di “isolamento intellettuale” in cui l’utente è esposto quasi esclusivamente a informazioni che confermano le sue convinzioni preesistenti, escludendo visioni contrastanti e alimentando pregiudizi selettivi (bias di conferma).

La Echo Chamber (camera di risonanza), al contrario, è un fenomeno più attivo e sociale. Qui, le persone si auto-selezionano in gruppi omogenei, rafforzando e amplificando le proprie credenze attraverso la comunicazione e la ripetizione all’interno di un sistema chiuso. In una Echo Chamber, le persone scelgono attivamente di interagire con individui che la pensano allo stesso modo, contribuendo a una crescente polarizzazione sociale e politica (che può determinare distorsioni e radicalizzazioni), nonché ad un “isolamento sociale”.

La “Generative Echo Chamber”

Con l’avvento dei chatbot di IA, creati per simulare conversazioni umane in linguaggio naturale tramite testo o voce, emerge un fenomeno più insidioso e complesso, quello della “Generative Echo Chamber”. Questa nuova dinamica unisce il bias di conferma umano con la natura persuasiva e apparentemente autorevole dei sistemi LLM artificiali.

La ricerca di Leung e Urminsky sul cosiddetto “narrow search effect” offre una spiegazione causale di questo fenomeno (Leung & Urminsky, 2025). Gli esseri umani hanno una tendenza psicologica, spesso inconscia, a formulare query di ricerca che presumono e confermano le loro credenze preesistenti. Per esempio, una persona che crede che la caffeina sia sana tenderà a cercare i “benefici della caffeina”, mentre una persona scettica cercherà i suoi “pericoli”. Questo comportamento è una manifestazione moderna e “digitale” del bias di conferma, la tendenza a favorire le informazioni che riaffermano le proprie convinzioni, portando a profezie che si autoavverano (self-fulfilling prophecy).

A differenza dei motori di ricerca tradizionali, che presentano una lista di link (spesso con una certa diversità di fonti, anche se influenzata da algoritmi di ranking), i chatbot di IA sono progettati per fornire una singola risposta sintetica e apparentemente autorevole. Questa risposta, essendo ottimizzata per la “rilevanza” rispetto alla query ristretta dell’utente, si allinea perfettamente con il suo bias di conferma. Il risultato è una nuova forma di echo chamber, generata non da una comunità di pari, ma dall’interazione diretta con un sistema che, con la sua efficienza e la sua natura conversazionale, amplifica le convinzioni preesistenti dell’utente senza mai sfidarle. La ricerca ha dimostrato che persino una versione di un chatbot che forniva risposte più ampie e bilanciate, includendo pro e contro, portava a un maggiore rafforzamento delle convinzioni rispetto a una versione che forniva risposte ristrette e mirate. Questo suggerisce che il problema non è solo il bias di conferma, ma un prodotto delle nostre tendenze naturali e del modo in cui le piattaforme digitali rispondono ad esse.

Omogeneizzazione del pensiero e AI Autophagy

Un’ulteriore preoccupazione è che l’uso diffuso dell’IA possa portare a un’omogeneizzazione del pensiero, degli stili creativi e della diversità culturale. La natura stessa dei grandi modelli linguistici (LLM), che apprendono e replicano prevalentemente stili popolari e ampiamente accettati, rischia di sopprimere le voci meno mainstream e le espressioni non convenzionali. Questa dinamica è particolarmente visibile nel mondo della letteratura e dell’arte, dove i sistemi di IA, allineandosi alle preferenze consolidate, potrebbero escludere generi e voci diverse, limitando l’esposizione dei lettori e degli artisti a uno spettro più ampio di possibilità creative.

Il rischio più profondo di questa omogeneizzazione è il fenomeno della cosiddetta AI Autophagy o “malattia del riciclo”. Questo termine si riferisce al potenziale rischio che i futuri modelli di IA, venendo addestrati su dati prodotti da modelli di IA attuali, finiscano per degradare la propria base di conoscenza. In un processo ricorsivo, ogni nuova generazione di modelli riprodurrebbe e amplificherebbe i bias e le imprecisioni dei suoi predecessori, riducendo progressivamente la ricchezza, la varietà e l’originalità dei dati di addestramento. Se il pensiero umano si affida sempre più a una fonte di conoscenza che si sta impoverendo per auto-riproduzione, il rischio di un’ignoranza collettiva a lungo termine diventa una possibilità concreta e pericolosa.

Conclusioni: per un’etica cognitiva dell’intelligenza aumentata

L’analisi condotta in questo breve articolo ha cercato di rispondere al quesito fondamentale: l’IA ci renderà davvero tutti più stupidi? La risposta più razionale, come si evince dalle evidenze scientifiche e dalle dinamiche sociali esaminate, è che l’intelligenza artificiale non ci renda intrinsecamente “più stupidi”, ma che il rischio di un declino cognitivo è reale e misurabile. Questo rischio non è una caratteristica propria della tecnologia, ma la conseguenza del suo uso passivo e acritico da parte dell’uomo. Il “debito cognitivo” non è una semplice metafora, ma un fenomeno con conseguenze neurobiologiche, psicologiche e sociali che possono minare l’autonomia, la creatività e l’originalità del pensiero umano.

L’IA può essere una “stampella” o un “amplificatore”: la scelta spetta all’utente. Per navigare questa nuova era della conoscenza senza soccombere alla “ignoranza artificiale”, è essenziale adottare opportune strategie di mitigazione, sia a livello sia individuale che sistemico.

Strategie di mitigazione a livello individuale

- Uso consapevole e deliberato: l’IA deve essere considerata uno strumento secondario e complementare al pensiero, non il suo sostituto. Un approccio pratico potrebbe essere il “metodo 80/20”: non si tratta, ovviamente, del Principio di Pareto, ma di una strategia cognitiva che prevede di mantenere l’80% dello sforzo intellettuale autonomo (brain-only), utilizzando l’IA solo per il restante 20%.

- Rieducazione al pensiero lento: in un mondo che premia la velocità e la risposta immediata, è necessario riappropriarsi del valore della fatica del ragionamento e della pazienza. La soddisfazione della scoperta personale, che si raggiunge attraverso il pensiero critico e profondo, è un potente stimolo che la delega all’IA tende purtroppo ad inibire.

- Verifica e critica: è fondamentale non accettare mai le risposte dell’IA come verità assolute. La tendenza dei modelli LLM ad “allucinare” (ossia inventare risposte), o a produrre inesattezze, richiede una costante verifica da parte dell’utente, che deve esercitare il proprio pensiero critico e analitico per valutare l’affidabilità delle informazioni al fine di non assecondare il “bias dell’infallibilità della macchina”, cedendo alla tentazione di un pensiero “facilitato” e acritico.

Strategie di mitigazione a livello sistemico

- Educazione all’intelligenza artificiale: Le istituzioni educative hanno il compito cruciale di integrare l’alfabetizzazione digitale e la formazione all’uso critico dell’IA nei programmi scolastici e universitari (AI literacy). L’obiettivo non è vietare l’IA, ma insegnare a usarla in modo responsabile, critico ed intenzionale.

- Policy e regolamentazione: sono necessarie linee guida e normative chiare che distinguano tra l’uso dell’IA come supporto (scaffolding) e la sua sostituzione completa del lavoro intellettuale. Le politiche dovrebbero anche affrontare i rischi di bias algoritmico e di omogeneizzazione del pensiero, promuovendo sistemi che valorizzino la diversità delle fonti e delle prospettive.

In definitiva, l’era dell’IA non rappresenta una battaglia tra l’intelligenza artificiale e quella umana, ma una sfida per preservare ciò che ci rende unicamente umani, ossia l’acquisizione e la gestione della conoscenza. La vera innovazione non risiede nel delegare ad una macchina il lavoro intellettivo umano, ma nel trovare nuove modalità per potenziarlo, trasformando l’IA da potenziale fonte di “ignoranza” (intesa come delega della conoscenza umana agli algoritmi) ad un alleato per lo sviluppo di una nuova forma di intelligenza “aumentata”, in cui l’uomo mantenga le sue prerogative di artefice e gestore della conoscenza.

Bibliografia

Zhou, J., Muller, H., Holzinger, A., & Chen, F. (2024). Ethical ChatGPT: Concerns, Challenges, and Commandments. Electronics (Basel), 13(17), 3417. https://doi.org/10.3390/electronics131703417

Azevedo, R. (2005). Using hypermedia as a metacognitive tool for enhancing student learning? The role of self-regulated learning. Educational Psychologist, 40(4), 199-209. https://doi.org/10.1207/s15326985ep4004_2

Ahmad, S. F., Han, H., Alam, M. M., Rehmat, M. K., Irshad, M., Arraño-Muñoz, M., & Ariza-Montes, A. (2023). Impact of artificial intelligence on human loss in decision making, laziness and safety in education. Humanities and Social Sciences Communications, 10, Article 311. https://doi.org/10.1057/s41599-023-01787-8

Al-Samarraie, H., & Al-Hatem, A. I. (2018). The Effect of Web Search Result Display on Users’ Perceptual Experience and Information Seeking Performance. The Reference Librarian, 59(1), 10-18. https://doi.org/10.1080/02763877.2017.1399849

Annamalai, M. S. M. S., Bilogrevic, I., & De Cristofaro, E. (2025). Beyond the Crawl: Unmasking Browser Fingerprinting in Real User Interactions. arXiv:2502.01608. https://arxiv.org/abs/2502.01608

Anwar, M. S., Schoenebeck, G., & Dhillon, P. S. (2024). Filter bubble or homogenization? Disentangling the long-term effects of recommendations on user consumption patterns. In Proceedings of the ACM Web Conference 2024 (WWW ’24) (pp. 123-134). New York, NY: ACM Association for Computer Machinery. https://doi.org/10.1145/3589334.3645497

Bai, L., Liu, X., & Su, J. (2023). ChatGPT: The cognitive effects on learning and memory. Brain-X, 1, e30. https://doi.org/10.1002/brx2.30

Benchenane, K., Tiesinga, P., & Battaglia, F. (2011). Oscillations in the prefrontal cortex: A gateway to memory and attention. Current Opinion in Neurobiology, 21(3), 475-485. https://doi.org/10.1016/j.conb.2011.01.004

Bhattacharya, J., & Petsche, H. (2005). Drawing on mind’s canvas: Differences in cortical integration patterns between artists and non-artists. Human Brain Mapping, 26(1), 1-14. https://doi.org/10.1002/hbm.20104

Boot, N., Baas, M., Mühlfeld, E., de Dreu, C. K., & van Gaal, S. (2017). Widespread neural oscillations in the delta band dissociate rule convergence from rule divergence during creative idea generation. Neuropsychologia, 104, 8-17. https://doi.org/10.1016/j.neuropsychologia.2017.07.033

Botvinick, M. M., Braver, T. S., Barch, D. M., Carter, C. S., & Cohen, J. D. (2001). Conflict monitoring and cognitive control. Psychological Review, 108(3), 624-652. https://doi.org/10.1037/0033-295X.108.3.624

Bröhl, F., & Kayser, C. (2021). Delta/theta band EEG differentially tracks low and high frequency speech-derived envelopes. NeuroImage, 233, 117958. https://doi.org/10.1016/j.neuroimage.2021.117958

Bromberg-Martin, E. S., & Monosov, I. E. (2020). Neural circuitry of information seeking. Current Opinion in Behavioral Sciences, 35, 62-70. https://doi.org/10.1016/j.cobeha.2020.07.006

Budiyono, H. (2025). Exploring long-term impact of AI writing tools on independent writing skills: A case study of Indonesian language education students. International Journal of Information and Education Technology, 15(5), 1003-1013. https://doi.org/10.18178/ijjet.2025.15.5.2306

Cacicio, S., & Riggs, R. (2023). ChatGPT: Leveraging AI to Support Personalized Teaching and Learning. Adult Literacy Education: The International Journal of Literacy, Language, and Numeracy, 5(2), 70-74. https://doi.org/10.35847/SCacicio.RRiggs.5.2.70

Cao, C. C., Ding, Z., Lin, J., & Hopfgartner, F. (2023). AI Chatbots as Multi-Role Pedagogical Agents: Transforming Engagement in CS Education. arXiv: 2308.03992. https://doi.org/10.48550/arxiv.2308.03992

Clark, A., & Chalmers, D. J. (1998). The extended mind. Analysis, 58(1), 7-19. https://doi.org/10.1093/analys/58.1.7

Deng, X., & Yu, Z. (2023). A Meta-Analysis and Systematic Review of the Effect of Chatbot Technology Use in Sustainable Education. Sustainability, 15(4), 2940. https://doi.org/10.3390/su15042940

Dong, G., Potenza, M. N., Michel, C. M., & Michel, C. M. (2015). Behavioural and brain responses related to Internet search and memory. The European Journal of Neuroscience, 42(8), 2546-2554. https://doi.org/10.1111/ejn.13039

Dong, G., & Potenza, M. N. (2016). Short-term internet-search practicing modulates brain activity during recollection. Neuroscience, 335, 82-90. https://doi.org/10.1016/j.neuroscience.2016.08.028

Fan, Y., Tang, L., Le, H., Shen, K., Tan, S., Zhao, Y., Shen, Y., Li, X. and Gašević, D. (2024). Beware of metacognitive laziness: Effects of generative artificial intelligence on learning motivation, processes, and performance. ArXiv: 2412.09315. https://arxiv.org/abs/2412.09315

Fink, A., & Benedek, M. (2014). EEG alpha power and creative ideation. Neuroscience and Biobehavioral Reviews, 44(100), 111-123. https://doi.org/10.1016/j.neubiorev.2012.12.002

Gerlich, M. (2025). AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking. Societies, 15(1), 6. https://doi.org/10.3390/soc15010006

Gong, C., & Yang, Y. (2024). Google effects on memory: A meta-analytical review of the media effects of intensive Internet search behavior. Frontiers in Public Health, 12, Article 1332030. https://doi.org/10.3389/fpubh.2024.1332030

Gwizdka, J. (2009). Individual differences in cognitive load during web search: Impacts on task efficiency and strategy. The Ergonomics Open Journal, 2(1), 114-121.

Gwizdka, J. (2010). Distribution of cognitive load in Web search. Journal of the Association for Information Science and Technology, 61(11), 2167-2187. https://doi.org/10.1002/asi.21385

Harmony, T., Hinojosa, G., Marosi, E., Becker, J., Rodriguez, M., Reyes, A., & Fernández, T. (1990). Correlation between EEG spectral parameters and an educational evaluation. International Journal of Neuroscience, 54(1-2), 147-155. https://doi.org/10.3109/00207459008986630

Herbold, S., Hautli-Janisz, A., Heuer, U., Vogel, L., Müller, R., & Brandt, M. (2023). A large-scale comparison of human-written versus ChatGPT-generated essays. Scientific Reports, 13, 18617. https://doi.org/10.1038/s41598-023-45644-9

Jelson, A., Manesh, D., Jang, A., Dunlap, D., & Lee, S. W. (2025). An Empirical Study to Understand How Students Use ChatGPT for Writing Essays. arXiv:2501.10551. https://arxiv.org/abs/2501.10551

Kasneci, E., Seßler, K., Küchemann, S., Bannert, M., Dementieva, D., Fischer, F., Gasser, U., Groh, G., Günnemann, S., Hüllermeier, E., Krusche, S., Kutyniok, G., Michaeli, T., Nerdel, C., Pfeffer, J., Poquet, O., Sailer, M., Schmidt, A., Seidel, T., & Kasneci, G. (2023). ChatGPT for Good? On Opportunities and Challenges of Large Language Models for Education. Learning and Individual Differences, 103, 102274. https://doi.org/10.1016/j.lindif.2023.102274

King, M. R. (2023). A Conversation on Artificial Intelligence, Chatbots, and Plagiarism in Higher Education. Cellular and Molecular Bioengineering, 16(1), 1-2. https://doi.org/10.1007/s12195-022-00754-8

Kleinberg, J., Ludwig, J., Mullainathan, S., & Sunstein, C. R. (2019). Discrimination in the age of algorithms. SSRN. https://doi.org/10.2139/ssrn.3329669

Klepsch, M., Schmitz, F., & Seufert, T. (2017). Development and validation of two instruments measuring intrinsic, extraneous, and germane cognitive load. Frontiers in Psychology, 8, 1997. https://doi.org/10.3389/fpsyg.2017.01997

Kong, W., Hombaiah, S. A., Zhang, M., Mei, Q., & Bendersky, M. (2024). PRewrite: Prompt rewriting with reinforcement learning. arXiv:2401.08189. https://arxiv.org/abs/2401.08189

Kosmyna, N., Hauptmann, E., Yuan, Y. T., Situ, J., Liao, X. -H., Beresnitzky, A. V., Braunstein, I., & Maes, P. (2025). Your brain on ChatGPT: Accumulation of cognitive debt when using an AI assistant for essay writing task. arXiv: 2506.08872, 4. https://doi.org/10.48550/arXiv.2506.08872.

Lee, H.-P., Sarkar, A., Tankelevitch, L., Drosos, I., Rintel, S., Banks, R., & Wilson, N. (2025, April). The impact of generative AI on critical thinking: Self-reported reductions in cognitive effort and confidence effects from a survey of knowledge workers. In Proceedings of the ACM CHI Conference on Human Factors in Computing Systems. New York, NY: ACM Association for Computer Machinery. https://doi.org/10.1145/3706598.3713778

Lee, S., Cai, Y., Meng, D., Wang, Z., & Wu, Y. (2024). Unleashing Large Language Models’ Proficiency in Zero-shot Essay Scoring. arXiv: 2404.04941. https://doi.org/10.48550/arxiv.2404.04941

Leung, E., & Urminsky, O. (2025). The narrow search effect and how broadening search promotes belief updating. Proceedings of the National Academy of Sciences of the United States of America, 122(13), e2408175122. https://doi.org/10.1073/pnas.2408175122

Manyika, J., Silberg, J., & Presten, B. (2019). What do we do about the biases in AI? Harvard Business Review, 25 October (online). https://hbr.org/2019/10/what-do-we-do-about-the-biases-in-ai

Milana, M., Brandi, U., Hodge, S., & Hoggan-Kloubert, T. (2024). Artificial intelligence (AI), conversational agents, and generative AI: implications for adult education practice and research. International Journal of Lifelong Education, 43(1), 1-7. https://doi.org/10.1080/02601370.2024.2310448

Moos, D. C., & Azevedo, R. (2008). Self-regulated learning with hypermedia: The role of prior domain knowledge. Contemporary Educational Psychology, 33(2), 270-298. https://doi.org/10.1016/j.cedpsych.2007.03.001

Mutlu-Bayraktar, D., Cosgun, V., & Altan, T. (2019). Cognitive load in multimedia learning environments: A systematic review. Computers & Education, 141, Article 103618. https://doi.org/10.1016/j.compedu.2019.103618

Niloy, A. C., Akter, S., Sultana, N., Sultana, J., & Rahman, S. I. U. (2024). Is Chatgpt a menace for creative writing ability? An experiment. Journal of Computer Assisted Learning, 40(2), 919-930. https://doi.org/10.1111/jcal.12929

O’Brien, H. L., & Toms, E. G. (2008). What is user engagement? A conceptual framework for defining user engagement with technology. Journal of the American Society for Information Science and Technology, 59(6), 938-955. https://doi.org/10.1002/asi.20801

O’Brien, H. L., Cairns, P., & Hall, M. (2018). A practical approach to measuring user engagement with the refined user engagement scale (UES) and new UES short form. International Journal of Human-Computer Studies, 112, 28-39. https://doi.org/10.1016/j.ijhcs.2018.01.004

Opfermann, M., Azevedo, R., & Leutner, D. (2012). Metacognition and hypermedia learning: How do they relate?. In N. M. Seel (Ed.), Encyclopedia of the sciences of learning (pp. 2224-2228). New York, NY: Springer US. https://doi.org/10.1007/978-1-4419-1428-6_709

Ouyang, Z., Jiang, Y., & Liu, H. (2024). The Effects of Duolingo, an AI-Integrated Technology, on EFL Learners’ Willingness to Communicate and Engagement in Online Classes. International Review of Research in Open and Distance Learning, 25(3), 97-115. https://doi.org/10.19173/irrodl.v25i3.7677

Paas, F., & van Gog, T. (2006). Optimising worked example instruction: Different ways to increase germane cognitive load. Learning and Instruction, 16(2), 87-91. https://doi.org/10.1016/j.learninstruc.2006.02.004

Pedró, F., Subosa, M., Rivas, A., & Valverde, P. (2019). Artificial intelligence in education: Challenges and opportunities for sustainable development. Paris-Bonn: UNESCO Publications. https://unesdoc.unesco.org/ark:/48223/pf0000366994

Peláez-Sánchez, I. C., Velarde-Camaqui, D., & Glasserman-Morales, L. D. (2024). The impact of large language models on higher education: Exploring the connection between AI and Education 4.0. Frontiers in Education, 9, 1392091. https://doi.org/10.3389/feduc.2024.1392091

Risko, E. F., & Gilbert, S. J. (2016). Cognitive offloading. Trends in Cognitive Sciences, 20(9), 676-688. https://www.sciencedirect.com/science/article/abs/pii/S1364661316300985

Safari, M., Shalbaf, R., Bagherzadeh, S., & Mohammadi, A. (2024). Classification of mental workload using brain connectivity and machine learning on electroencephalogram data. Scientific Reports, 14, 9153. https://doi.org/10.1038/s41598-024-59652-w

Sajja, R., Sermet, Y., Cikmaz, M., Cwiertny, D., & Demir, I. (2024). Artificial Intelligence-Enabled Intelligent Assistant for Personalized and Adaptive Learning in Higher Education. Information (Basel), 15(10), 596. https://doi.org/10.3390/info15100596

Schmidhuber, J., Schlogl, S., Ploder, C., Kaber, D., Fortino, G., Guerrieri, A., Nurnberger, A., Mendonca, D., Yu, Z., & Schilling, M. (2021). Cognitive Load and Productivity Implications in Human-Chatbot Interaction. 2021 IEEE 2nd International Conference on Human-Machine Systems (ICHMS), 1-6. Piscataway, NJ: IEEE. https://doi.org/10.1109/ICHMS53169.2021.9582445

Shah, C., Erhard, K., Ortheil, H. J., Kaza, E., Kessler, C., & Lotze, M. (2013). Neural correlates of creative writing: an fMRI study. Human Brain Mapping, 34(5), 1088-1101. https://doi.org/10.1002/hbm.21493

Shanmugasundaram, M., & Tamilarasu, A. (2023). The impact of digital technology, social media, and artificial intelligence on cognitive functions: A review. Frontiers in Cognition, 2, 1203077. https://doi.org/10.3389/fcogn.2023.1203077

Shao, Y., Jiang, Y., Kanell, T. A., Xu, P., Khattab, O., & Lam, M. S. (2024). Assisting in Writing Wikipedia-like Articles From Scratch with Large Language Models. arXiv:2402.14207. https://doi.org/10.48550/arxiv.2402.14207

Sharma, N., Liao, Q. V., & Xiao, Z. (2024). Generative echo chamber? Effect of LLM-powered search systems on diverse information seeking. In Proceedings of the CHI Conference on Human Factors in Computing Systems (CHI ’24) (pp. 1-17). New York, NY: ACM Association for Computer Machinery. https://doi.org/10.1145/3613904.3642459

Shen, Y., Heacock, L., Elias, J., Hentel, K. D., Reig, B., Shih, G., & Moy, L. (2023). ChatGPT and Other Large Language Models Are Double-edged Swords. Radiology, 307(2), e230163-e230163. https://doi.org/10.1148/radiol.230163

Shojaee, P., Mirzadeh, I., Alizadeh, K., Horton, M., Bengio, S., & Farajtabar, M. (2025). The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity. Cupertino, CA: Apple. https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf

Shumailov, I., Shumaylov, Z., Zhao, Y., Gal, Y., Papernot, N., & Anderson, R. (2023). The curse of recursion: Training on generated data makes models forget. arXiv:2305.17493. https://arxiv.org/abs/2305.17493

Small, G. W., Moody, T. D., Siddarth, P., & Bookheimer, S. Y. (2009). Your brain on Google: Patterns of cerebral activation during Internet searching. The American Journal of Geriatric Psychiatry, 17(2), 116-126. https://doi.org/10.1097/JGP.0b013e3181953a02

Sparrow, B., Liu, J., & Wegner, D. M. (2011). Google effects on memory: Cognitive consequences of having information at our fingertips. Science, 333(6043), 776-778. https://doi.org/10.1126/science.1207745

Stadler, M., Bannert, M., & Sailer, M. (2024). Cognitive ease at a cost: LLMs reduce mental effort but compromise depth in student scientific inquiry. Computers in Human Behavior, 160, 108386. https://doi.org/10.1016/j.chb.2024.108386

Stahl, M., Biermann, L., Nehring, A., & Wachsmuth, H. (2024). Exploring LLM prompting strategies for joint essay scoring and feedback generation. In Proceedings of the 19th Workshop on Innovative Use of NLP for Building Educational Applications (pp. 283-298). Kerrville, TX: ACL Association for Computational Linguistics. https://aclanthology.org/2024.bea-1.23/

Su, J., & Yang, W. (2023). Unlocking the Power of ChatGPT: A Framework for Applying Generative AI in Education. ECNU Review of Education, 6(3), 355-366. https://doi.org/10.1177/20965311231168423

Sullivan, M., Kelly, A., & McLaughlan, P. (2023). ChatGPT in higher education: Considerations for academic integrity and student learning. Journal of Applied Learning and Teaching, 6(1), 31-40. https://doi.org/10.37074/jalt.2023.6.1.17

Sundararajan, N., & Adesope, O. (2020). Keep it coherent: A meta-analysis of the seductive details effect. Educational Psychology Review, 32(3), 707-734. https://doi.org/10.1007/s10648-020-09522-4

Sweller, J. (1988). Cognitive load during problem solving: effects on learning. Cognitive Science, 12, 275-285. https://onlinelibrary.wiley.com/doi/abs/10.1207/s15516709cog1202_4

Turner, E., & Rainie, L. (2020). Most Americans rely on their own research to make big decisions, and that often means online searches. Washington, DC: Pew Research Center. https://www.pewresearch.org/short-reads/2020/03/05/most-americans-rely-on-their-own-research-to-make-big-decisions-and-that-often-means-online-searches/

Varela, F., Lachaux, J., Rodriguez, E., & Martinerie, J. (2001). The brainweb: Phase synchronization and large-scale integration. Nature Reviews Neuroscience, 2(4), 229-239. https://doi.org/10.1038/35067550

von Hoyer, J., Hoppe, A., Kammerer, Y., Otto, C., Pardi, G., Rokicki, M., Yu, R., Dietze, S., Ewerth, R., & Holtz, P. (2022). The Search as Learning Spaceship: Toward a comprehensive model of psychological and technological facets of Search as Learning. Frontiers in Psychology, 13, 827748. https://doi.org/10.3389/fpsyq.2022.827748

Wang, J., & Fan, W. (2025). The effect of ChatGPT on students’ learning performance, learning perception, and higher-order thinking: Insights from a meta-analysis. Humanities and Social Sciences Communications, 12, 621. https://doi.org/10.1057/s41599-025-04787-v

Webster, J., & Ho, H. (1997). Audience engagement in multimedia presentations. The DATA BASE for Advances in Information Systems, 28(2), 63-77. https://dl.acm.org/doi/10.1145/264701.264706

Whipp, J. L., & Chiarelli, S. (2004). Self-regulation in a web-based course: A case study. Educational Technology Research & Development, 52(4), 5-21. https://doi.org/10.1007/BF02504714

Willoughby, T., Anderson, S. A., Wood, E., Mueller, J., & Ross, C. (2009). Fast searching for information on the Internet to use in a learning context: The impact of domain knowledge. Computers and Education, 52(3), 640-648. https://doi.org/10.1016/j.compedu.2008.11.009

Xing, X., Shi, F., Huang, J., Zhang, X., & Wu, Y. (2025). On the caveats of AI autophagy. Nature Machine Intelligence, 7, 172-180. https://doi.org/10.1038/s42256-025-00984-1

Yang, T. C., Hsu, Y. C., & Wu, J. Y. (2025). The effectiveness of ChatGPT in assisting high school students in programming learning: evidence from a quasi-experimental research. Interactive Learning Environments, 1-18. https://doi.org/10.1080/10494820.2025.2450659

Yang, Y., Shin, A., Kang, M., Kang, J., & Song, J. Y. (2024). Can We Delegate Learning to Automation?: A Comparative Study of LLM Chatbots, Search Engines, and Books. arXiv: 2410.01396. https://doi.org/10.48550/arxiv.2410.01396

Zhang, S., Zhao, X., Zhou, T., & Kim, J. H. (2024). Do you have AI dependency? The roles of academic self-efficacy, academic stress, and performance expectations on problematic AI usage behavior. International Journal of Educational Technology in Higher Education, 21(1), 34-14. https://doi.org/10.1186/s41239-024-00467-0