Come ogni anno, il mese di novembre porta la nuova edizione di Supercomputing, la conferenza mondiale dedicata al supercalcolo a St.Louis (Stati Uniti).

Per decenni si trattava di una conferenza per addetti ai lavori, ma negli ultimi anni la crescita dei datacenter e soprattutto l’arrivo dell’AI rendono questo appuntamento di interesse più generale ed un interessante osservatorio sulle tecnologie che sono alla base dell’era digitale e consentono di intuire le traiettorie dello sviluppo delle nuove tecnologie.

Vediamo le novità che abbiamo visto di persona alla conferenza e soprattutto di capire quali siano le implicazioni per il nostro paese, in un panorama in cui il “gigawatt” non è più solo l’unità di misura per alimentare il flusso canalizzatore in Ritorno al futuro ma la nuova unità di misura per l’alimentazione dell’intelligenza artificiale.

Indice degli argomenti

SC2025 senza rivoluzioni

La prima cosa che salta all’occhio della nuova edizione della conferenza è l’assenza di annunci su nuove tecnologie. Viviamo un momento in cui i componenti di base dei nostri sistemi sembrano essersi assestate e invece di assistere a nuove tipologie di acceleratori o a nuove architetture di processori si vedono solo nuovi sistemi che richiedono semplicemente più energia e, di conseguenza, una maggiore generazione di calore.

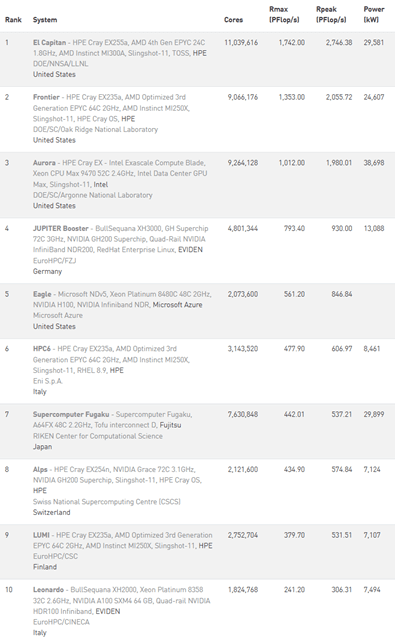

Il primo specchio di questa situazione è rappresentato dalla Top500, la classifica dei 500 sistemi di supercalcolo più potenti al mondo. La classifica viene aggiornata due volte l’anno ed è annunciata a Supercomputing e alla sua versione europea International Supercomputing che si tiene tra maggio e giugno in Germania.

Se confrontiamo le classifiche del 2025 (a sinistra la più recente) si osserva come non vi siano cambiamenti nella classifica (che vede i primi tre sistemi statunitensi, e cinque sistemi europei). L’unico cambiamento degno di nota è rappresentato da Jupiter Boost, il sistema tedesco, che è il primo sistema europeo a superare la barriera dell’exaflop (un milione di miliardi di operazioni in virgola mobile al secondo).

La colonna a cui prestare attenzione della tabella è però l’ultima: i sistemi richiedono almeno 7 mega Watt di potenza per operare con un picco del numero 3 che ha impiegato 38MW. Per mettere le cose in prospettiva stiamo parlando della potenza massima di quasi quarantamila abitazioni italiane nell’ultimo caso. Si tratta evidentemente di sistemi molto grandi ma la tendenza è quella di crescita degli assorbimenti (Jupiter ha richiesto ulteriori 2MW per superare la barriera psicologica dell’exascale), e poiché molte delle tecnologie in versione ridotta sono quelle che poi si impiegano in datacenter aziendali è normale attendersi una crescita anche dei conti dei datacenter nazionali.

Supercomputing 2025: AI uguale super caldo

Una dei pezzi forti di SC è l’exhibition, un’enorme area espositiva con centinaia di stand in cui grandi aziende e piccole startup mostrano le proprie innovazioni. Non stupisce che il patron di nVidia, Jensen Huang, fosse in persona allo stand per raccontare le novità del gigante produttore delle GPU i componenti essenziali dell’AI.

L’intelligenza artificiale ha dominato buona parte delle conversazioni, sia nel suo impiego all’interno di tecnologie come, ad esempio, lo storage VAST che supporta l’indicizzazione di dati con il supporto ai vettori, sia per implementare sistemi di intelligenza artificiale on-premises, tema sempre caldo al maturare della qualità dei modelli open weight.

Per chi, come me, è cresciuto nel mondo dell’elettronica non è abituato ad associare l’acqua e i tubi ai computer.

Raffreddamento ad acqua

Eppure ormai una parte significativa dell’esibizione è dedicata a tubi, valvole e circuiti idraulici necessari a portare acqua sui componenti dei server per consentire una maggiore densità di calcolo. Dell technologies ad esempio ha annunciato i nuovi rack secondo lo standard OCP (più larghi dei rack tradizionali) con un sistema di raffreddamento capace di raffreddare 160KW in un singolo armadio (per mettere le cose in giusta prospettiva dieci anni fa la potenza per rack in un design innovativo di datacenter era di 15KW, stiamo parlando di un fattore 10 di differenza). In questi rack il liquido viene usato per raffreddare l’aria nel rack (pur mantenendola a oltre 40 gradi per ridurre i consumi di raffreddamento) da una porta/radiatore sul retro. I nuovi rack inoltre non usano più i tradizionali cavi per l’alimentazione, si sta infatti affermando una barra capace di trasportare 1400A al centro del rack dove si innestano i server: la potenza necessaria renderebbe i cavi troppo rigidi e spessi per funzionare.

I server hanno ormai tutti circuiti interni di raffreddamento a liquido, con circuiti sempre più sofisticati che portano liquidi (a volte a base di glicole ma più spesso semplicemente acqua) direttamente sulla componentistica interna.

Ci si può chiedere la ragione di questa improvvisa impennata dei consumi dovuti ad una sempre maggiore densità della componentistica. L’AI è largamente responsabile per questa nuova tendenza: le grandi dimensioni dei modelli non riescono a stare interamente all’interno delle memorie dei singoli componenti e quindi la migliore soluzione che abbiamo è quello di tenere i componenti il più vicino possibile per assicurare la giusta velocità nell’accesso ai dati.

L’Italia può restare competitiva? Che si apprende dal Supercomputing 2025

Fa sicuramente piacere che l’Italia sia presente nella Top 500 con due sistemi (HPC6 di ENI e Leonardo di Cineca), ma la tendenza di crescita della densità energetica è preoccupante per assicurare un ruolo del nostro paese nella corsa al digitale. Se pochi anni fa 1MW era sufficiente ad alimentare un datacenter medio-grande (con oltre 50 rack) oggi in linea teorica solo sei rack possono esaurirlo (e ci si aspetta che in due anni ne possa bastare uno solo).

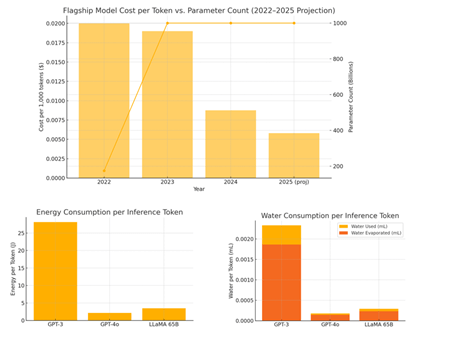

La rete di distribuzione nazionale non è in generale pronta per fornire densità di potenza adeguate se non con grandi investimenti che ridurranno (o comunque rallenteranno) la capacità di realizzare grandi infrastrutture se non in un numero limitato di casi. C’è quindi il rischio di esternalizzare un altro pezzo importante della nostra sovranità digitale ai grandi cloud. Va anche sottolineato che il raffreddamento di grandi datacenter è spesso fatto mediante raffreddamento evaporativo (che porta ad un’evaporazione di circa l’80% dell’acqua utilizzata per raffreddare) che richiede la realizzazione di interi laghi artificiali per sostenere la sua realizzazione.

L’ottimizzazione energetica nell’esecuzione dei modelli potrebbe riequilibrare l’equazione riportando i consumi in ambiti più accessibili per il nostro paese, e i il costo stimato sia in termini di acqua che di energia per token generato da un’AI è calato drasticamente negli ultimi tre anni, ma è bastato a malapena a compensare la crescita nell’uso della tecnologia.

Alcuni paesi fanno uso di energia nucleare per sostenere la crescita, una politica che è in discussione al governo ma che per il momento non è realisticamente impiegabile sul suolo nazionale.

Cosa abbiamo imparato al Supercomputing 2025

I nuovi annunci di Supercomputing lasciano intravedere un futuro in cui i datacenter richiederanno sempre più risorse energetiche ed idriche, e questo costringerà a rivedere le infrastrutture nazionali.

In Italia ci sarà una spinta a federarsi per assicurare le risorse necessarie, ma è cruciale muoversi come Europa in modo coordinato, solo in questo modo si può pensare di disporre delle risorse necessarie per la realizzazione di queste infrastrutture cruciali per il futuro industriale. A testimonianza del ruolo chiave che l’Europa può giocare va sottolineato come tre dei cinque supercomputer europei sono stati possibili grazie ai finanziamenti di EuroHPC, iniziativa europea.

L’Italia dovrà rivedere le proprie politiche in termini di collocazione di queste grandi infrastrutture, sono finiti i tempi degli scaffali con i PC e un condizionatore a parete. Per fortuna le politiche di AgID hanno spinto il paese nella giusta direzione, ma forse è arrivato il momento di fare un check alle nostre strategie.