Per capire quali scenari economici che l’AI ci aprirà nel 2026 sono indicative le dichiarazioni di Andrej Karpathy, uno degli informatici più noti nel mondo dell’IA, strappato da Musk a peso d’oro a OpenAI dopo la rottura con Sam Altman e messo a capo dell’IA di Tesla.

Indice degli argomenti

La programmazione rivoluzionata dall’AI

A fine dicembre, sul suo profilo su X, Karpathy, quasi a chiosare un bilancio personale del 2025, ha affidato le seguenti parole: “non mi sono mai sentito così indietro come programmatore. La professione sta subendo una radicale ristrutturazione, poiché i contributi dei programmatori sono sempre più scarsi e disomogenei”.

Parole che danno il senso della rivoluzione in arrivo, a partire dalla programmazione e a finire chissà dove, verso uno scenario a cui le nostre economie non sembrano ancora preparate fino in fondo; nelle aziende e per i lavoratori coinvolti.

Ancora Karpathy: “Ho la sensazione che potrei essere 10 volte più potente se solo mettessi insieme correttamente ciò che è diventato disponibile nell’ultimo anno, e non riuscire a rivendicare il potenziamento sembra decisamente una questione di competenze”.

“C’è un nuovo livello di astrazione programmabile da padroneggiare (oltre ai soliti livelli sottostanti) che coinvolge agenti, subagenti, i loro prompt, contesti, memoria, modalità, permessi, strumenti, plugin, competenze, hook, MCP, LSP, comandi slash, flussi di lavoro, integrazioni IDE e la necessità di costruire un modello mentale onnicomprensivo per i punti di forza e le insidie di entità fondamentalmente stocastiche, fallibili, incomprensibili e mutevoli, improvvisamente mescolate a quella che una volta era la buona vecchia ingegneria”.

“È chiaro che è stato distribuito un qualche potente strumento alieno, solo che non è accompagnato da un manuale e tutti devono imparare a impugnarlo e a usarlo, mentre il terremoto di magnitudo 9 che ne è derivato sta scuotendo la professione. Rimboccatevi le maniche per non restare indietro.”

Queste affermazioni fanno il paio con quanto ha dichiarato più o meno negli stessi giorni Geoffrey Hinton, uno dei padri fondatori del deep learning e Premio Nobel per la fisica del 2024, secondo il quale la tecnologia sta avanzando più velocemente di quanto avesse previsto soltanto due anni prima.

E in generale con i tanti programmatori informatici che nelle ultime settimane hanno dichiarato che ormai alcuni modelli IA, in particolare Claude Code, non sono più soltanto dei buoni assistenti ma possono scrivere codice al 100%. Permettendo quel processo noto come “vibe coding”, secondo il quale i programmatori forniscono in linguaggio naturale istruzioni tramite prompt ai modelli IA e questi ultimi generano e modificano il codice sulla base delle richieste ricevute.

Un processo iterativo nel quale il programmatore interviene per supervisionare e correggere, ma in teoria può non dover scrivere neppure una riga di codice. Come per l’appunto hanno pubblicamente ammesso numerosi informatici da qualche settimana a questa parte.

Robotica e IA fisica: gli economics dell’intelligenza artificiale nel mondo reale

Tuffandoci verso le novità tecnologiche del futuro prossimo, in attesa di una futuribile e ancora incerta AGI, non possiamo non citare gli importanti sviluppi nella robotica e più in generale nella cosiddetta IA fisica, ben rappresentata nell’appuntamento annuale di inizio gennaio a Las Vegas con il CES, la principale manifestazione mondiale sull’elettronica di consumo.

In coincidenza con il suo attesissimo intervento, Jensen Huang ha perfino parlato di un ChatGPT moment per la robotica che sperimenteremo per la prima volta nel 2026. Naturalmente il CEO di Nvidia lo riferiva soprattutto ai suoi prodotti, a partire da Alpamayo, modello open source per la guida autonoma che è già in produzione e sarà installato già nei prossimi mesi sui nuovi modelli Mercedes Benz CLA (attesi in Europa entro il secondo trimestre).

Al di là degli inevitabili hype sulle capacità di Alpamayo di “pensare e ragionare”, gli aspetti interessanti e innovativi sono principalmente due.

Innanzitutto, l’IA fisica non si basa sui Large Language Model (LLM), al contrario dell’IA generativa che siamo stati abituati a conoscere, alla base di tool come ChatGPT, Gemini o Claude, ma deve sviluppare una comprensione delle leggi della fisica per poter guidare su strada in sicurezza.

Si tratta di una direzione verso la quale stanno andando sempre di più altre aziende e alcuni dei principali scienziati, come Fei-Fei Li, anche lei presente al CES, e Yann LeCun, con le loro rispettive startup (quella di LeCun, che si chiamerà Advanced Machine Intelligence Labs, è ancora in fase di decollo, in attesa che lo scienziato di origine francese e uno dei padri fondatori del deep learning lasci Meta).

In realtà, probabilmente ci vorrà ancora un buon numero di anni per arrivare a un modello generalista di base del mondo fisico, paragonabile a quello che un LLM è per il linguaggio, ma intanto ne vedremo sempre di più delle applicazioni verticali sempre più sofisticate.

Anche sulla base di queste premesse, il 2026 potrebbe rappresentare un anno di svolta sia per le auto a guida autonoma, con i servizi di robotaxi che dovrebbero sbarcare per la prima volta grazie a Uber e Baidu in Europa (ma non nell’Unione Europea bensì a Londra per il momento), che per i robot umanoidi (nei quali insieme a tanti altri player c’è anche la startup italiana Generative Bionics, spinoff dell’Istituto Italiano di Tecnologia anch’esso sul palco del CES e reduce da un round di finanziamento di 70 milioni di dollari).

Un “piano B” contro le allucinazioni: l’architettura a due livelli

Il secondo aspetto di interesse è l’architettura immaginata da Nvidia per Alpamayo per aumentarne il livello di sicurezza e che potrebbe suggerire la strada anche per prevenire le allucinazioni dell’IA e renderla pienamente affidabile.

A questo fine, Alpamayo si basa su un’architettura di controllo a due livelli. Il sistema IA più avanzato opera continuamente, affiancato da un secondo software di guida autonoma basato su regole e modelli più tradizionali, progettato per essere prevedibile e stabile.

Questo secondo sistema svolge il ruolo di supervisore: osserva le decisioni dell’IA e ne valuta l’affidabilità in tempo reale. Quando individua una situazione ambigua o un margine di incertezza nel comportamento dell’IA, Alpamayo passa immediatamente al sistema tradizionale, che applica procedure di sicurezza consolidate.

In questo modo, il veicolo dispone di un piano B nel caso di possibili problemi. Si tratta di una frontiera architettonica dei sistemi IA che, applicata anche ad altre tipologie di problemi, può consentire di abilitare finalmente un’implementazione massiva dell’IA agentica dalla quale ci si aspettano i guadagni principali di produttività e che al momento ha un’applicazione ancora limitata (secondo stime di Gartner, nel 2026 si dovrebbe passare dal 5% al 40% delle soluzioni IA per le imprese che la integrano).

Competizione tra modelli e chip: gli economics dell’intelligenza artificiale

Se Nvidia ha dimostrato a Las Vegas di essere in grado di innovare non solo nel suo core business, presentando i nuovi chip Vera Rubin, molto più efficienti sia in fase di addestramento che di inferenza dei migliori modelli oggi sul mercato, ma anche in segmenti adiacenti, come per l’appunto modelli IA applicati alla guida autonoma, d’altro canto altri chipmaker si stanno muovendo con dinamismo e buone prospettive di crescita.

Da AMD a soggetti verticalmente integrati come AWS e Google, ai player cinesi che stanno avanzando rapidamente, ma anche alle tante startup nate nel frattempo, alcune delle quali cresciute rapidamente. Come nel caso di Groq, fondata nel 2016 da Jonathan Ross (proveniente da Google dove aveva sviluppato il progetto TPU, che oggi consente al colosso di Mountain View di poter fare concorrenza alle GPU di Nvidia, grazie ai minori costi).

Proprio nei giorni precedenti il Natale è stato reso noto l’accordo di licenza sottoscritto da Nvidia per i processori di Groq, particolarmente efficaci nella fase d’inferenza (e potenziali competitor della stessa azienda guidata da Huang).

Al di là dei chip, il vero banco di prova del 2026 sul fronte aziendale sarà quello dei modelli di IA, mercato nel quale l’app più diffusa, ChatGPT, sta perdendo quote di mercato, a favore soprattutto di Gemini, specie dopo il rilascio a fine novembre della versione 3 di quest’ultimo da parte di Google (addestrata proprio con i TPU in house).

Secondo i dati di traffico monitorati da Similarweb, a un mese circa dall’uscita di Gemini, ChatGPT aveva circa il 22% degli utenti giornalieri. In termini di quote di mercato, se l’anno era iniziato con ChatGPT che deteneva l’87,2% del traffico contro il 5,4% di Gemini, nelle ultime settimane quest’ultimo è arrivato fino al 40% di utenti giornalieri del primo.

Non sappiamo ancora se questo trend continuerà (tra le sue previsioni del 2026 il sito di news specializzato sulle cose della Silicon Valley, The Information, scommetteva sul fatto che Gemini avrebbe raggiunto nel corso dell’anno ChatGPT come numero di utenti), ma quel che appare certo è che il prodotto di punta di OpenAI non potrà più godere dello status quasi monopolistico (almeno rispetto al pubblico più generale) di cui ha goduto fin qui.

Anche perché la competizione non si gioca solo con Google. Innanzitutto, nel terzetto attualmente in testa come performance medie dei modelli occorre considerare stabilmente anche il già citato Claude, che ha una quota di mercato inferiore rispetto al pubblico generalista ma si posiziona in maniera molto autorevole nelle applicazioni business (abbiamo d’altronde già parlato delle virtù di Claude Code per chi sviluppa software).

Come abbiamo già avuto modo di scrivere qui in una recente analisi, Anthropic, a differenza di OpenAI che immagina di raggiungere il primo bilancio in nero solo nel 2030, prevede di diventare profittevole più a breve, a partire dal 2027, generando ben 17 miliardi di utile nel 2028 (a fronte di 70 miliardi di ricavi).

Grazie proprio alla maggiore efficacia sul fronte B2B, cioè del business destinato alle imprese. Mentre finora OpenAI non è riuscita a monetizzare sul fronte enterprise il clamoroso successo delle proprie app, a differenza allora di Amazon e oggi di Anthropic, la quale ritiene che la sua API, cioè l’interfaccia per far parlare tra loro software diversi, e le applicazioni collegate, genereranno nel 2025 circa il doppio dei ricavi rispetto a OpenAI e all’incirca l’80% dei propri ricavi fino al 2028.

Questa attenzione ai clienti business ha fatto sì che Claude Code sia prossimo a produrre 1 miliardo di dollari di ricavi annualizzati.

Oltre a puntare di più sul mercato business e a mantenere la leadership di ChatGPT, OpenAI sta provando ad esplorare nuove fonti di introito. In particolare, entro il 2026 dovrebbe essere lanciato il primo device nato dalla collaborazione con Jony Ive, dal 1997 al 2019 Chief Designer Officer di Apple e dunque dietro a tutti i principali trionfi dell’azienda di Cupertino, primo tra tutti l’iPhone.

Collaborazione fin qui costata ad OpenAI almeno 6,5 miliardi di dollari, ovvero il costo d’acquisto di Io Products, startup fondata da Ive nel 2024 e comprata dall’azienda guidata da Altman nel corso del 2025.

Non si sa ancora molto del device che OpenAI porterà sul mercato né se uscirà davvero nell’anno in corso o nel prossimo. In ogni caso, appare questa la nuova scommessa di OpenAI alla quale è affidata una parte importante del suo futuro più immediato, insieme al suo ingresso nel mercato pubblicitario e agli accordi con le aziende perché vendano direttamente i loro servizi su ChatGPT, bypassando gli app store di Apple e Google.

Tutti fronti sui quali si presume questi ultimi non rimarranno certo inerti. Sarà dunque interessante monitorare gli effetti a catena che potrebbero innestarsi in generale sul mercato digitale. Anche se occorre dire che al momento i tentativi di OpenAI di diversificare il proprio business e di creare un proprio ecosistema, sul modello proprio di Apple e soprattutto Google, da ultimo con il lancio di un nuovo motore di ricerca, Atlas, hanno fatto solo il solletico alle principali piattaforme.

Peraltro, per OpenAI non ci sono solo Apple e Google da un lato e quest’ultima e Anthropic dall’altro con i quali vedersela. Dopo gli enormi investimenti del 2025 in una vera e propria campagna acquisti per la nuova divisione Superintelligence, culminata nell’acquisto di Scale AI, Meta ha annunciato una nuova operazione a fine dicembre, l’acquisizione di Manus AI, interessante per due motivi.

Del primo, l’aspetto geopolitico, è quello di cui si è più parlato. Manus AI era una delle startup cinesi più promettenti finché si è trasferita a Singapore. Con l’acquisto da parte di Meta si completerebbe un passaggio dal campo cinese a quello americano, che è già stato salutato dagli osservatori statunitensi come una conseguenza delle restrizioni all’export americane (Manus AI sviluppa le sue app su modelli fondazionali di altri, tra i quali i più performanti sono ancora per il momento quelli americani), oltre a un’ammissione di superiorità dell’ecosistema IA statunitense in generale.

Data la sensibilità della questione non sorprende che la stessa Cina abbia aperto un’indagine per capire se la stessa Manus AI abbia a sua volta violato le restrizioni cinesi. Certamente, a seconda di come andrà la vicenda e dei suoi possibili strascichi giudiziari, potrebbero esserci ulteriori impulsi o meno per ulteriori startup cinesi a passare su un terreno neutro o addirittura a farsi comprare da fondi o aziende USA (o di altri Paesi).

L’altro aspetto dell’acquisizione di Manus AI, di cui si è meno parlato, è il posizionamento di quest’ultima nel mercato IA e che potrebbe segnalare anche un nuovo sviluppo per Meta, anch’essa alla ricerca di ritorni sugli enormi investimenti effettuati sull’IA (anche se, a differenza di OpenAI, ha ovviamente una base di ricavi e profitti enormi derivanti in particolare dalla pubblicità online sui propri social).

Infatti Manus AI ha puntato tutto sull’IA agentica, prospettando dunque un possibile ingresso di Meta nel mercato B2B dell’IA dalla porta principale, con conseguenze sullo sviluppo di applicazioni che potrebbero dare la spinta decisiva per possibili aumenti di produttività a livello aziendale e, forse, anche aggregato.

Produttività e lavoro: il paradosso di Jevons negli economics dell’intelligenza artificiale

Il tema della produttività, principale fonte di crescita economica, si intreccia da sempre con quello del lavoro. Anche se questa relazione è meno scontata di quanto appaia a molti. Proprio in conseguenza dei veloci progressi dell’IA, Hinton ad esempio si attende che nel 2026 potrebbero esserci massicce riduzioni dei posti di lavoro.

Già nel 2016 lo scienziato britannico aveva dichiarato che la radiologia non avrebbe dovuto essere più insegnata perché nel giro di pochi anni i radiologi sarebbero stati sostituiti dalle macchine. Una previsione che si è rilevata al momento del tutto infondata, visto che non solo i radiologi non sono spariti ma nel frattempo sono diventati negli USA la seconda specializzazione medica più pagata e le scuole di medicina pullulano come non mai di giovani che vorrebbero ingrossarne le fila.

E tutto questo non è avvenuto a dispetto bensì grazie all’IA, che ha permesso di aumentare la produttività dei radiologi più di quanto sia avvenuto per altre professioni mediche (ed ecco perché i salari sono aumentati proporzionalmente di più).

In un recente post su X, visualizzato da oltre 4 milioni di utenti, Aaron Levie, imprenditore ed esperto di tecnologia tra i più seguiti nella Silicon Valley, ha parlato di paradosso di Jevons per il lavoro della conoscenza, pronosticandone per il nuovo anno una vera e propria esplosione.

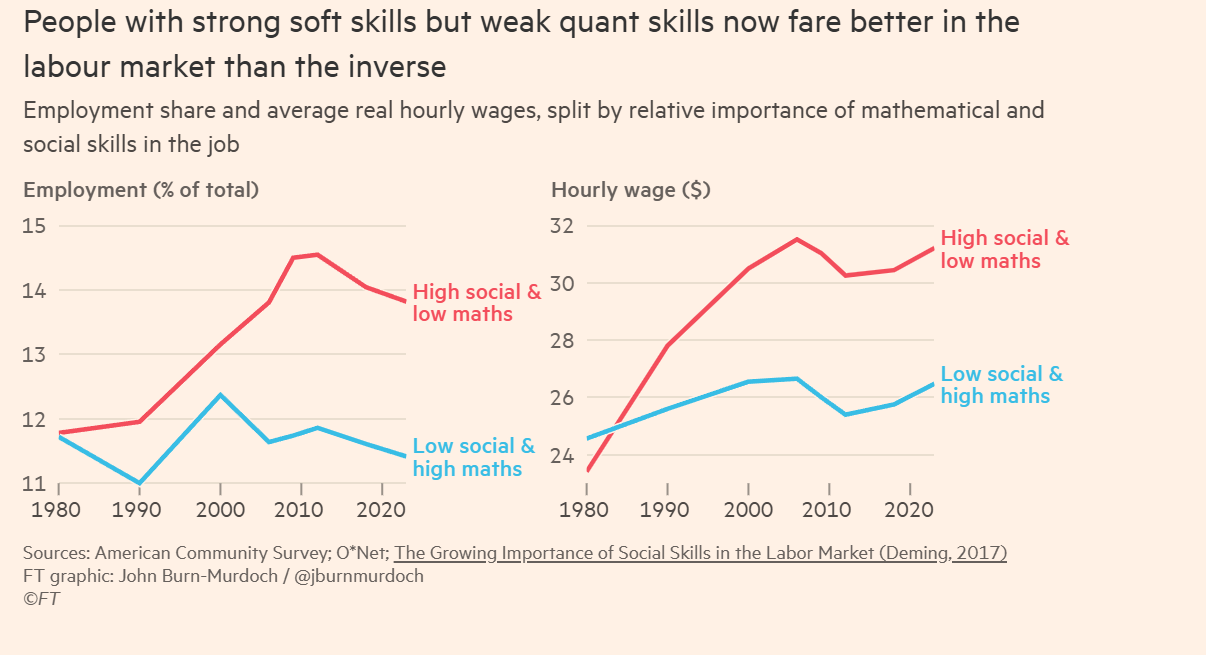

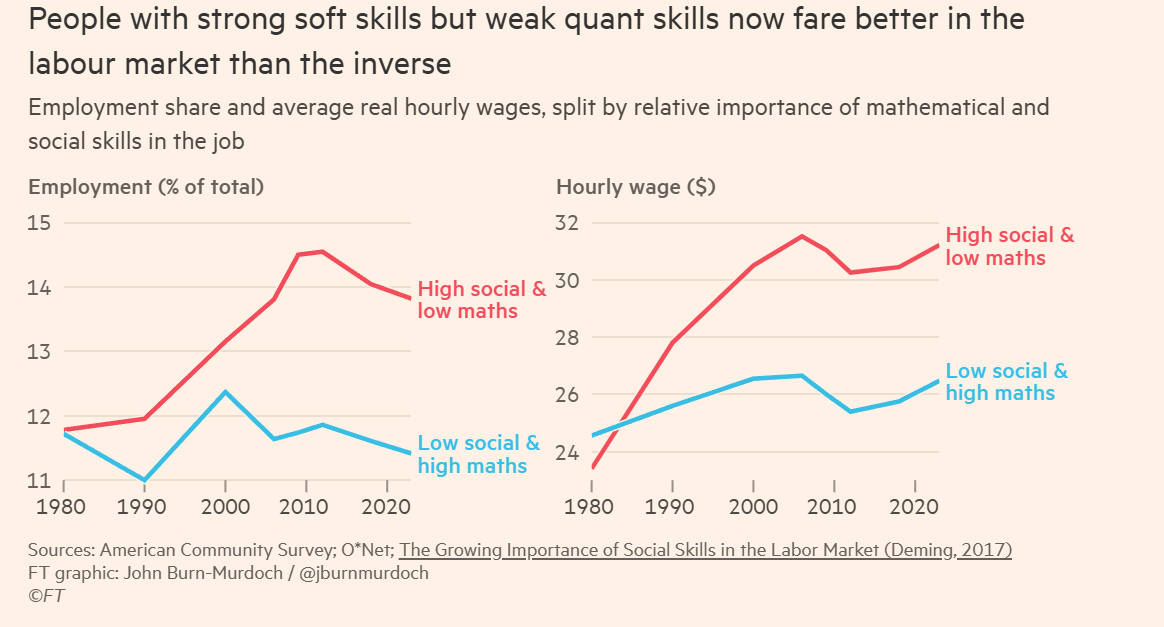

Le soft skill già pagano meglio sul mercato del lavoro

William Stanley Jevons, economista inglese dell’Ottocento tra gli antesignani della scuola marginalista, fu il primo ad accorgersi poco dopo la metà dell’Ottocento che la maggiore efficienza nell’uso del carbone non portava a una riduzione della domanda ma paradossalmente a un incremento, in quanto aumentava la convenienza d’impiego per una serie di applicazioni a valle che prima non potevano essere contemplate.

A distanza di un secolo e mezzo, il paradosso è ampiamente noto nella letteratura ambientale in una chiave purtroppo negativa. Maggiore efficienza nell’uso dell’energia può infatti portare a un rimbalzo dei consumi, vanificando almeno in parte i benefici per l’ambiente (e le bollette).

Nel caso dell’IA, tuttavia, il paradosso di Jevons sarebbe la migliore e più immediata assicurazione contro il catastrofismo di chi immagina che per essere produttiva la tecnologia debba portare a licenziamenti di massa (o quantomeno consolidare le mancate nuove assunzioni osservate negli USA da diversi studi pubblicati nel corso dell’ultimo anno).

Per costoro, il Sacro Graal della produttività, a lungo cercato e sfuggito ai sistemi economici in seguito alle varie rivoluzioni informatiche dal primo Dopoguerra ad oggi (con un’unica parziale eccezione per quella di Internet a cavallo tra vecchio e nuovo secolo), potrebbe essere conseguito solo al prezzo di una variazione inversamente proporzionale dell’occupazione.

In realtà, non necessariamente deve essere così e il paradosso di Jevons, accoppiato a una tecnologia nonostante tutto ancora imperfetta, è lì a dimostrarlo.

Nell’esempio concreto di Levie, “quando si è un team piccolo, si prendono decisioni tra avere una buona pagina web di marketing, costruire una nuova esperienza di prodotto, gestire le richieste di assistenza clienti, occuparsi di qualcosa di importante in ambito finanziario, trovare nuovi canali di distribuzione e così via.

Ognuna di queste aree di investimento e di tempo entra in competizione con le altre, e tutte insieme finiscono per rallentare la crescita. Oggi, però, abbiamo la possibilità di far saltare il vincolo principale che guida molti di questi compromessi: il costo di svolgere queste attività.

La domanda aumenterà di 10 o 100 volte in molti ambiti di lavoro, perché abbiamo abbassato molte delle altre barriere all’ingresso che impedivano di sperimentare tanti tipi di attività che la maggior parte delle aziende non avrebbe nemmeno preso in considerazione prima.

Naturalmente, molti si chiedono che cosa accadrà a tutti i posti di lavoro in questo nuovo mondo. La realtà è che, nonostante tutte le attività che l’IA ci consente di automatizzare, servono ancora persone per mettere insieme l’intero flusso di lavoro e produrre valore reale.

Gli agenti di IA richiedono gestione, supervisione e un contesto significativo per ottenere tutti i benefici. Tutti gli aumenti delle prestazioni dei modelli di IA degli ultimi anni hanno portato a output di qualità più elevata, ma siamo ancora molto lontani da un’IA completamente autonoma che implementi e mantenga perfettamente ciò che stiamo cercando.”

Dunque, in questa prospettiva, la produttività aumenterà ma non talmente tanto da rendere superfluo il lavoro umano. Man mano che l’IA agentica troverà applicazione nelle imprese e in generale nelle varie organizzazioni, il ruolo delle persone occupate si trasformerà sempre di più nella capacità di assegnare compiti agli agenti e di verificarne i risultati, almeno nelle funzioni sufficientemente esposte agli impatti della tecnologia (già oggi la gran parte).

Il 2026 come banco di prova macroeconomico

Secondo alcuni, gli ultimi dati sul PIL americano, relativi al terzo trimestre del 2025, confrontati con l’andamento del mercato del lavoro, potrebbero confermare una tendenza a un aumento della produttività che finalmente potrebbe essere rinvenuto a livello macroeconomico.

Mettendo insieme, da un lato, una crescita del PIL a un ritmo annualizzato nettamente superiore alle attese, pari al 4,3%, con una (quasi) contemporanea frenata della crescita dell’occupazione e un (lieve) aumento della disoccupazione e con la doverosa premessa che le rilevazioni statistiche di grandezze macroeconomiche sono spesso imperfette e per questo soggette a frequenti revisioni ex post, si possono avanzare tre interpretazioni plausibili.

La prima è che i dati sul mercato del lavoro siano corretti e che la crescita del PIL sia sovrastimata, come già accaduto in passato in molte occasioni. Secondo quella opposta, il PIL sarebbe corretto mentre a dover essere aggiustati al rialzo sono semmai i dati sul mercato del lavoro.

Ma c’è una terza spiegazione, che è quella per noi più interessante. Qualora entrambe le rilevazioni fossero più o meno giuste, vorrebbe dire che il PIL si è espanso di molto con poco o nessun lavoro aggiuntivo.

Se così fosse, la crescita della produttività nel terzo trimestre dovrebbe essere stata nettamente più elevata del normale (nella media degli ultimi decenni di poco superiore all’1% del PIL negli USA, meno in Europa), grosso modo in linea con il tasso di crescita del PIL, dato che le ore di lavoro complessive sono rimaste stabili.

In un commento sul New York Times proprio alla vigilia di Natale, Jason Furman, principale consigliere economico di Obama nel suo secondo mandato, pur avendo ventilato queste tre possibili interpretazioni e dando buon credito alla terza, è giustamente scettico sull’abbandonarsi a facili ottimismi, di fronte a dati pur sempre trimestrali.

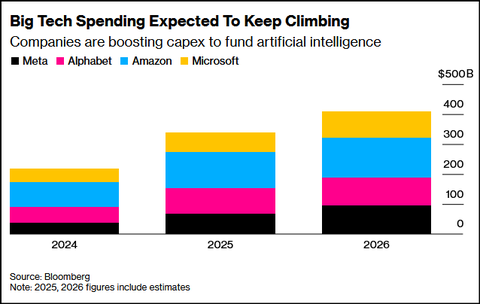

E, inoltre, se anche la terza interpretazione si rilevasse quella giusta, esisterebbe “una spiegazione più prosaica” di una maggiore produttività trainata dall’IA, cioè quella che “la crescita sia concentrata in settori ad alta intensità di produttività, come i data center, che generano un output significativo con relativamente pochi lavoratori.”

Dunque, nessun ritrovamento ancora del Sacro Graal ma semmai più investimenti nella fase propedeutica alle operazioni di ricerca.

Come afferma Furman, potrebbero volerci anni prima di sapere quale di queste spiegazioni sia corretta — ammesso che lo si scopra mai. E in ogni caso “servirebbero anche alcuni anni per convincermi che stessimo già godendo di un boom di produttività alimentato dall’IA e non semplicemente di un episodio volatile e temporaneo.”

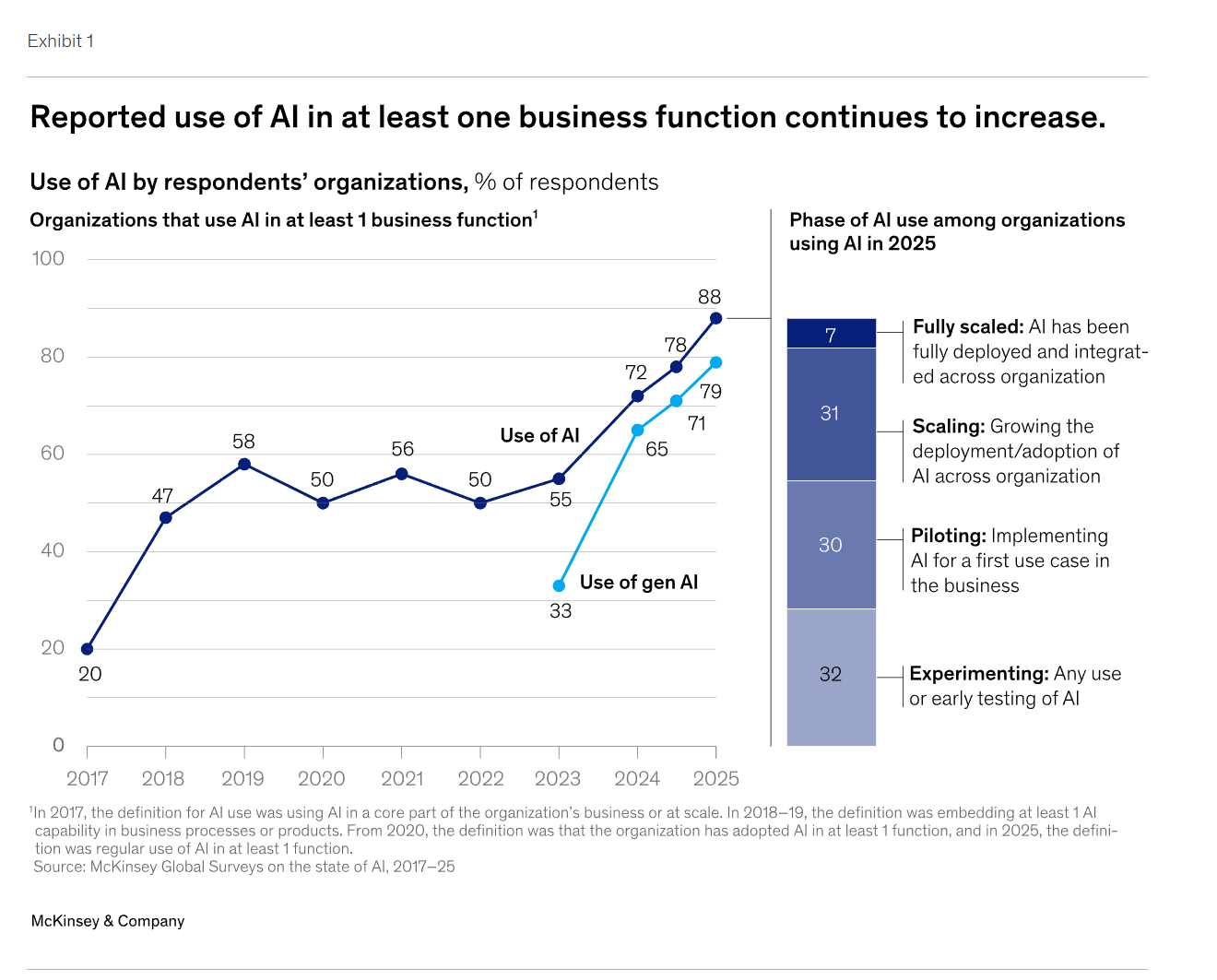

Ma è pur vero che, all’aumentare più veloce del previsto nel grado di adozione dell’IA, proporzionale anche a un rapido incremento del livello di complessità delle funzioni svolte e all’impiego su larga scala di agenti IA, il 2026 sarà il primo serio banco di prova per testare incrementi di produttività sia a livelli micro che macro.

Formazione e organizzazione: gli economics dell’intelligenza artificiale

Piuttosto a mancare ancora tra tutti gli investimenti in atto, o quantomeno ad essere in ritardo rispetto a quello che servirebbe per far decollare l’IA nelle aziende e in generale nell’economia, appaiono le spese in formazione e nei cambiamenti organizzativi necessari ad adottare l’IA con successo.

Secondo un recente studio della London School of Economics, i professionisti formati usano l’IA con un guadagno di produttività più di due volte superiore a chi lo fa senza aver ricevuto alcuna formazione.

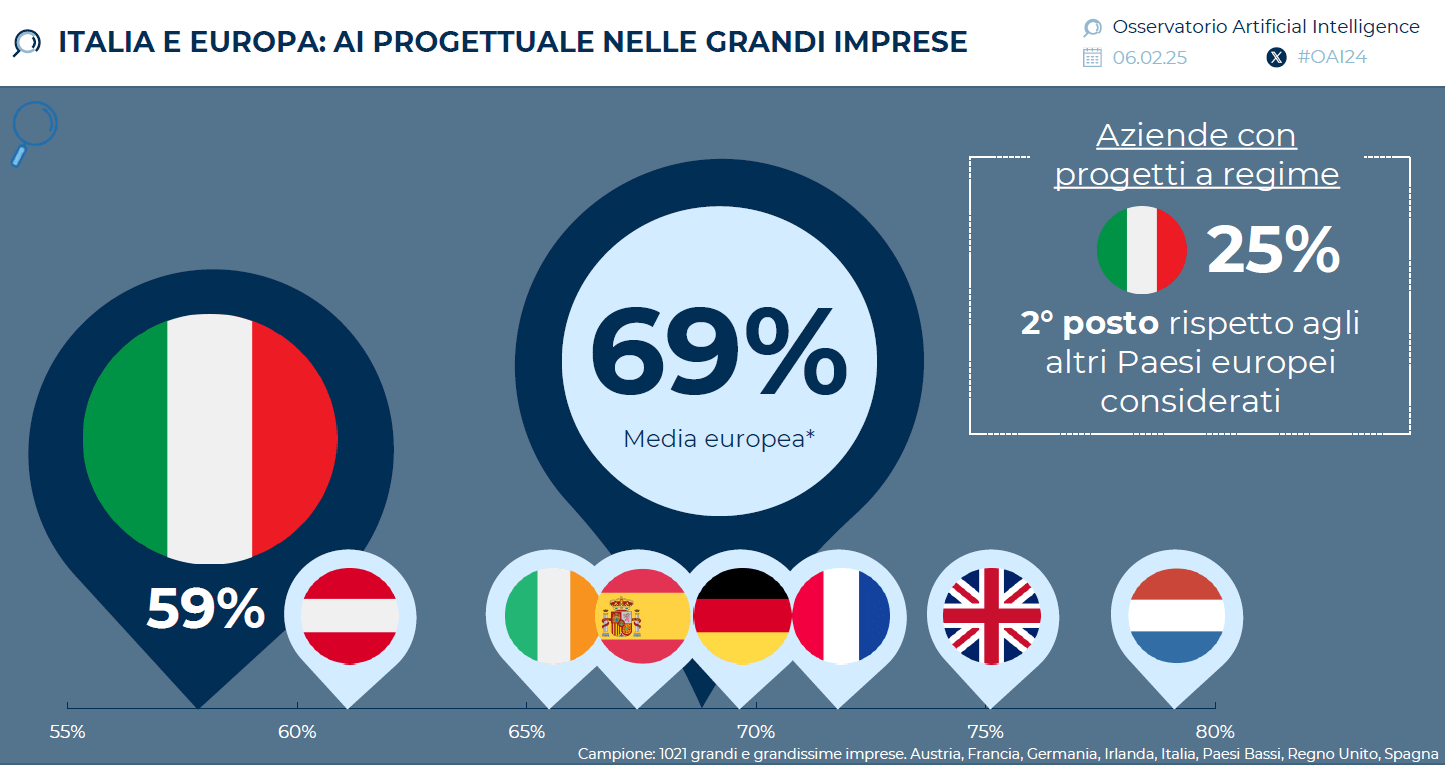

E un altro studio recente ci dice che solo il 15% delle aziende in Europa ha messo in campo interventi formativi, a fronte del 20% che, secondo gli ultimi dati Eurostat, in media ha adottato la tecnologia.

Se questo è l’approccio, facile immaginare che l’uso prevalente di strumenti di IA rimanga inadeguato, alla stregua di motori di ricerca potenziati o, peggio ancora, di companion di supporto psicologico. Magari utili e piacevoli, sia pure con tutti i rischi del caso, ma certamente non decisivi per portare a quel cambio di passo economico che ci si aspetterebbe da una tecnologia potenzialmente così trasformativa.

Dati anche gli enormi investimenti infrastrutturali e nello sviluppo dei modelli, capaci di spingere all’insù i conti di alcune delle principali imprese del mondo e il PIL americano, ma che presto o tardi si affacceranno alla nostra vista come pericolosi boomerang in assenza di rendimenti adeguati.