L’AI Literacy non è nata con ChatGPT. Esisteva una riflessione articolata già quarant’anni fa, in contesti sorprendentemente diversi: laboratori universitari, ambienti militari, grandi aziende, scuole.

Questa “archeologia” riporta alla luce visioni dimenticate che anticipano i dilemmi odierni: l’intelligenza artificiale come strumento di pensiero anziché come intelligenza autonoma, la necessità di alfabetizzazione organizzativa oltre quella individuale, il rischio di perdere conoscenza invece di preservarla.

Le domande fondamentali sono rimaste invariate attraverso i cicli tecnologici: come sviluppare pensiero critico, come trasferire sapere, come amplificare l’intelligenza umana senza sostituirla. Riscoprire queste radici significa costruire un futuro in cui l’IA sia mezzo e non fine.

Indice degli argomenti

Il punto di svolta: quando ChatGPT ha cambiato tutto

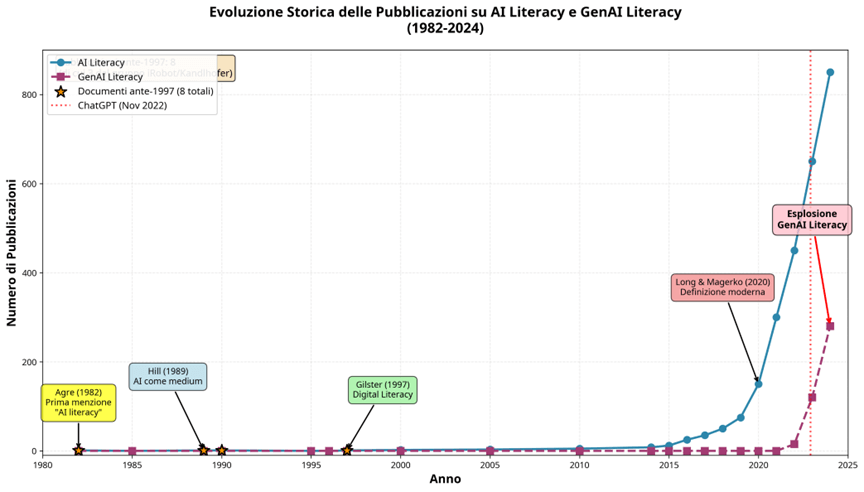

Il 30 novembre 2022 rappresenta uno spartiacque nella storia della tecnologia e della cultura digitale. Il rilascio pubblico di ChatGPT da parte di OpenAI ha innescato un “inevitabile salto di paradigma” (Bozkurt, 2023) che ha investito la società, l’economia e, in modo particolare, l’educazione. In questo nuovo contesto, il concetto dell’AI Literacy (alfabetizzazione all’intelligenza artificiale) ha acquisito un’urgenza e una centralità senza precedenti. Se prima dell’era generativa l’AI Literacy era definita da Long e Magerko (2020) come “un insieme di competenze che consentono agli individui di valutare criticamente le tecnologie di IA, comunicare e collaborare efficacemente con l’IA e utilizzare l’IA come strumento online, a casa e sul posto di lavoro” (p. 2), oggi il dibattito si è evoluto per includere le specificità dei modelli linguistici di grandi dimensioni, dando vita al concetto di GenAI Literacy (Gao et al., 2024).

Ma cosa accadeva nella “preistoria” dell’IA, prima che il mondo conoscesse l’interfaccia conversazionale di ChatGPT? Una ricerca bibliografica sistematica rivela che prima del 2016 (compreso) esistono 8 pubblicazioni che utilizzano esplicitamente il termine “AI literacy“. Di queste, tre provengono dal gruppo di ricerca austriaco guidato da Gerald Steinbauer-Wagner, che ha condotto esperimenti pionieristici sull’insegnamento dell’IA nelle scuole attraverso progetti di AI Literacy ante litteram. Gli altri cinque documenti rappresentano vere e proprie “gemme” concettuali emerse in contesti eterogenei: un laboratorio di ricerca del MIT, il mondo militare statunitense, una grande azienda brasiliana e un istituto di ricerca economica giapponese.

Figura 1: Andamento storico delle pubblicazioni su AI Literacy (1982-2024) e GenAI Literacy (2022-2024). Si noti la presenza di 8 pubblicazioni ante-2016, di cui 3 dal gruppo di Gerald Steinbauer-Wagner

La prima definizione di AI Literacy nel contesto economico giapponese

Prima di intraprendere il nostro “viaggio archeologico”, è necessario stabilire cosa si intenda per AI Literacy. La prima definizione sistematica e operativa del concetto è attribuibile a Yoko Konishi (2016), economista e Senior Fellow del Research Institute of Economy, Trade and Industry (RIETI) giapponese. Nel suo articolo “What is Needed for AI Literacy?“, pubblicato nel gennaio 2016 — significativamente prima della rivoluzione dell’IA generativa — Konishi delinea l’AI Literacy non come una competenza tecnica, ma come una disposizione cognitiva e strategica:

“AI literacy refers to being conscious about whether there are any standardized/formatted tasks that have not been applied for AI due to large data volume, and whether excessive labor, money or time is spent for ‘categorization, repetition, exploration, organization and optimization.’ We should make it a habit to think about what can and cannot be applied to AI” (Konishi, 2016, p. 3).

Questa definizione, radicata nel contesto economico-organizzativo, anticipa di quattro anni la più celebre formulazione di Long e Magerko (2020), che invece si concentra su competenze individuali di valutazione critica, comunicazione e collaborazione con sistemi di IA. La concettualizzazione di Konishi è particolarmente rilevante perché colloca l’AI Literacy non nel dominio della programmazione o della comprensione algoritmica, ma in quello della consapevolezza strategica e del pensiero critico applicato ai processi. È un’alfabetizzazione che riguarda il riconoscimento delle opportunità e dei limiti, la capacità di identificare dove l’IA può creare valore e dove, invece, l’intervento umano rimane insostituibile.

La letteratura contemporanea ha progressivamente arricchito e articolato questa definizione. Ng, Leung, Chu e Qiao (2021), in una revisione esplorativa che ha analizzato l’andamento crescente delle pubblicazioni sull’AI literacy dal 2014 al 2021, identificano cinque dimensioni fondamentali: (1) conoscenza e comprensione dell’IA, (2) uso e applicazione dell’IA, (3) valutazione e creazione di sistemi di IA, (4) etica e impatto sociale dell’IA, e (5) consapevolezza critica. Casal-Otero et al. (2023), in una revisione sistematica focalizzata sull’educazione K-12, sottolineano come l’AI literacy rappresenti una “sfida pedagogica e cognitiva” che richiede approcci didattici innovativi e contestualizzati. Con l’avvento dell’IA generativa, il concetto si è ulteriormente evoluto: Gao et al. (2024) propongono il framework della GenAI Literacy, che include competenze specifiche legate al prompting, alla co-creazione con modelli linguistici e alla valutazione critica di output generati.

Ciò che emerge da questa rassegna è che l’AI Literacy non è mai stata una competenza monolitica, ma un costrutto multidimensionale che si adatta ai contesti tecnologici, sociali ed educativi. E, come vedremo più avanti, le radici di questa complessità affondano molto più indietro nel tempo di quanto la letteratura scientifica abbia riconosciuto.

Otto documenti pionieristici: una mappa per esplorare il passato

Prima di procedere all’analisi approfondita, presentiamo brevemente i cinque documenti che costituiscono il cuore del nostro “viaggio archeologico” nella AI literacy:

- Agre, P. E. (1982). What to read: A biased guide to AI literacy for the beginner. Questo documento detiene il primato storico: è la prima attestazione conosciuta del termine “AI literacy“. Si tratta di una guida bibliografica ragionata, scritta da un giovane dottorando per orientare i neofiti nel campo dell’intelligenza artificiale.

- Hill, W. C. (1989). The mind at AI: Horseless carriage to clock. Un saggio epistemologico di sorprendente modernità che propone di concepire l’intelligenza artificiale non come un’intelligenza, ma come un nuovo medium rappresentazionale basato sulla computazione.

- U.S. Army Electronic Proving Ground (1990). Methodology investigation of AI test officer support tool III. Un rapporto tecnico “unclassified” che affronta il problema della perdita di conoscenza esperta nelle organizzazioni militari e propone l’IA come memoria organizzativa interattiva con finalità pedagogiche.

- Tenorio, M. F. d. M., Maia, A. C. P., & Grant-Tenorio, A. E. (1997). A model for advanced in-house industrial training: A case study on intelligent system technology transfer using a project-oriented approach. Un modello sistematico di formazione aziendale implementato da PETROBRAS, che rappresenta il primo approccio scientifico aziendale sull’AI literacy.

- Gruppo di Gerald Steinbauer-Wagner (2016). Tre contributi fondamentali del gruppo di ricerca austriaco della Graz University of Technology che hanno pionieristicamente portato l’insegnamento dell’IA nelle scuole di ogni ordine e grado, dal progetto iRobot al curriculum completo K-12, fino all’iniziativa europea EDLRIS.

- Konishi, Y. (2016). What is Needed for AI Literacy? RIETI Column. La prima definizione sistematica e operativa di AI Literacy, formulata da un’economista giapponese nel contesto dell’analisi dei big data e dell’impatto economico dell’IA. Di cui ho già parlato in precedenza.

Questi otto documenti costituiscono un corpus di pensiero anticipatore che merita di essere riscoperto e valorizzato.

Philip Agre e la nascita dell’AI Literacy al MIT nel 1982

Il punto di partenza di ogni indagine archeologica sull’AI Literacy non può che essere il Working Paper 239 del MIT AI Lab, intitolato “What to read: A biased guide to AI literacy for the beginner” (“Cosa leggere: una guida parziale all’alfabetizzazione IA per il principiante”), scritto da Philip E. Agre nel novembre del 1982.

Nel novembre 1982, Philip E. Agre non era un professore affermato, ma un giovane dottorando al MIT AI Lab, probabilmente al secondo o terzo anno del suo programma di PhD in Electrical Engineering and Computer Science. Cresciuto nel Maryland e ammesso al college in giovane età, Agre aveva iniziato il suo dottorato sotto la supervisione di Michael Brady. Quando Brady lasciò il MIT per Oxford, Agre e il suo collaboratore David Chapman passarono sotto la guida di Rodney Brooks, un ricercatore appena arrivato al laboratorio che avrebbe rivoluzionato il campo dell’IA con l’approccio della Nouvelle AI.

Il MIT AI Lab degli anni ’80 era l’epicentro mondiale della ricerca sull’intelligenza artificiale, un luogo di fervore intellettuale in cui si respirava l’ottimismo del primo boom dell’IA, l’era dei sistemi esperti. In questo contesto, Agre e Chapman stavano sviluppando un approccio radicalmente nuovo all’IA, che enfatizzava il comportamento come emergente dall’interazione con l’ambiente piuttosto che dalla codificazione completa del comportamento. Questo lavoro culminerà nel 1989 con la pubblicazione dell’articolo seminale “What are plans for?“, considerato fondamentale per il reactive planning.

Ma nel 1982, Agre era ancora uno studente, immerso in un ambiente collaborativo e stimolante, circondato da menti brillanti. Ed è in questo contesto che nasce l’idea di una “guida all’AI literacy“. Non si tratta di un’imposizione dall’alto, ma di un atto di generosità intellettuale tra pari, un tentativo di condividere un percorso di lettura ragionato per chi, come lui poco tempo prima, si affacciava al mondo dell’intelligenza artificiale. Il Working Paper 239 si apre con una dichiarazione di modestia e onestà intellettuale che ne definisce il tono:

“This note tries to provide a quick guide to AI literacy for the beginning AI hacker and for the experienced AI hacker or two whose scholarship isn’t what it should be. Most will recognize it as the same old list of classic papers, give or take a few that I feel to be under- or over-rated. It is not guaranteed to be thorough or balanced or anything like that” (Agre, 1982, p. 1).

L’uso del termine “hacker” non è casuale: negli anni ’80 al MIT, “hacker” non aveva la connotazione negativa odierna, ma designava un programmatore appassionato, curioso, tecnicamente competente e intellettualmente libero. La guida è dichiaratamente “biased” (parziale), ma il suo valore risiede proprio in questa scelta curatoriale. Agre non pretende di offrire un canone neutro e oggettivo, ma un percorso di lettura ragionato, filtrato attraverso la sua esperienza e le sue sensibilità intellettuali. Il documento si articola in diverse sezioni tematiche, coprendo i principali ambiti della ricerca IA dell’epoca, dalla Filosofia alla Fantascienza In totale, la guida di Agre raccomanda oltre 150 riferimenti bibliografici, tra articoli, libri e working papers. Non è un semplice elenco, ma un percorso strutturato, con annotazioni e giudizi critici. Per esempio, Agre non esita a definire alcuni lavori “sopravvalutati” o a segnalare testi che ritiene ingiustamente trascurati.

Per Agre, l’AI literacy non è una competenza astratta o una serie di abilità tecniche. È, innanzitutto, la padronanza di un canone di testi fondamentali che permettono di comprendere i concetti, le tecniche, le sfide e i dibattiti del campo. È un’alfabetizzazione che si costruisce attraverso lo studio, la lettura critica e l’inserimento in una comunità di pratica. L’AI literacy, in questa prospettiva, è una forma di literacy accademica: saper leggere, interpretare, contestualizzare e criticare la letteratura scientifica. Ma è anche qualcosa di più: è la capacità di orientarsi in un campo in rapida evoluzione, di distinguere le mode passeggere dalle intuizioni durature, di riconoscere i problemi aperti e le direzioni promettenti. È, in definitiva, la capacità di pensare l’intelligenza artificiale, non solo di programmarla.

Pensare l’IA come medium e non come intelligenza

Questa concezione è straordinariamente moderna. Oggi, di fronte all’esplosione dell’IA generativa, ci troviamo nuovamente di fronte alla necessità di “alfabetizzare” masse di persone che devono orientarsi in un panorama tecnologico complesso e in rapida evoluzione. E, come nel 1982, questa alfabetizzazione non può ridursi alla padronanza di strumenti o alla memorizzazione di procedure, ma richiede la costruzione di un quadro concettuale che permetta di comprendere, valutare e utilizzare criticamente la tecnologia.

Se il contributo di Agre delinea la necessità di un’alfabetizzazione per “entrare” nel mondo dell’IA, il saggio di William C. Hill, “The Mind at AI: Horseless Carriage to Clock“, pubblicato su AI Magazine nel 1989, compie un balzo epistemologico di sorprendente modernità, proponendo una radicale riconcettualizzazione della natura stessa dell’intelligenza artificiale. Scrivendo al culmine del boom dei sistemi esperti e poco prima del collasso del mercato che avrebbe dato inizio al secondo “inverno” dell’IA, Hill si distacca dalle due narrazioni dominanti del suo tempo: l’IA come tentativo di replicare la mente umana e l’IA come strumento per costruire artefatti intelligenti. Egli propone una terza via, un “terzo obiettivo nascosto e più fondamentale” (a third, hidden and more fundamental goal): concepire l’intelligenza artificiale non come un’intelligenza, ma come un nuovo medium rappresentazionale basato sulla computazione.

“A more fundamental human urge is playing out, that of seeking new expressive power through new expressive means” (Hill, 1989, p. 29).

In questa prospettiva, l’IA diventa un’estensione dell’umana facoltà di rappresentazione, un nuovo linguaggio attraverso cui l’intelletto può esprimersi con inedita chiarezza e forza. Hill, attingendo implicitamente alla teoria dei media di autori come McLuhan (1964) e Ong (1982), sposta il focus dalla macchina “pensante” al medium “espressivo”. La domanda cruciale non è più “le macchine possono pensare?”, ma “in che modo la computazione, come medium, modella e amplifica il nostro pensiero?”.

Per Hill, la vera sostanza tecnica dell’IA risiede nello sfruttamento delle proprietà rappresentazionali uniche della computazione, che egli identifica in quattro categorie:

- Dinamica (Dynamics): la capacità di rappresentare processi temporali e cambiamenti di stato.

- Profondità (Depth): la capacità di creare livelli di astrazione, nascondendo o rivelando la complessità interna.

- Facilitazione (Facilitation): l’adattamento tra le operazioni mentali e quelle offerte dal sistema.

- Interattività (Interactivity): la capacità del contesto di influenzare il processo computazionale.

La vera rivoluzione, secondo Hill, sta nel fatto che “i mezzi attraverso cui la computazione facilita la rappresentazione sono essi stessi estensibili” (the means by which computation facilitates representation are themselves extensible, p. 31), rendendola un medium senza precedenti, un meta-medium.

Questa intuizione è straordinariamente profetica. Oggi, di fronte all’IA generativa, la visione di Hill appare non solo attuale, ma essenziale: usiamo ChatGPT o Midjourney non come intelligenze autonome, ma come potentissimi media rappresentazionali per scrivere, argomentare, visualizzare e creare. L’AI Literacy, in questa prospettiva, non è solo la capacità di usare uno strumento, ma la competenza semiotica di padroneggiare un nuovo linguaggio, di comprenderne la grammatica (i prompt), la sintassi (i modelli sottostanti) e la pragmatica (gli usi efficaci e critici). Hill ci invita a guardare l’IA non con il timore reverenziale verso una mente aliena, ma con la curiosità critica verso un nuovo medium che, come la scrittura o la stampa prima di esso, sta ridefinendo le fondamenta della nostra cultura e del nostro intelletto.

Il pristechnolocution: quando le parole ingannano la comprensione

Hill utilizza un termine: “pristechnolocution” per definire un fenomeno linguistico e concettuale ricorrente nell’innovazione tecnologica. Il concetto esprime come le nuove tecnologie vengano inizialmente descritte e concepite attraverso metafore di tecnologie precedenti e familiari, in modo fuorviante. Esempi classici includono “carrozza senza cavalli” per l’automobile, “telegrafo senza fili” per la radio, o “scrittura artificiale” per la stampa.

Secondo Hill, il termine “intelligenza artificiale” è proprio un pristechnolocution: descrive erroneamente la tecnologia computazionale come imitazione dell’intelletto umano, quando in realtà l’IA rappresenta fondamentalmente un nuovo mezzo rappresentazionale attraverso cui l’intelletto umano può esprimersi con chiarezza e forza diverse.

Questo tipo di denominazione è problematico perché:

- Dirige l’attenzione verso somiglianze superficiali e non importanti

- Oscura le vere potenzialità e limiti della nuova tecnologia

- Suona anacronisticamente ingenuo decenni dopo

Il pristechnolocution riflette la tendenza umana a comprendere l’innovazione attraverso categorie familiari, ritardando la comprensione delle proprietà uniche e rivoluzionarie della nuova tecnologia. In altre parole, questa etichetta dirige l’attenzione verso somiglianze superficiali con l’intelligenza umana, distogliendo dalla sostanza tecnica reale: la creazione di nuovi mezzi per rappresentare la conoscenza.

L’esercito americano e l’IA come memoria organizzativa pedagogica

Spostandoci dal contesto accademico e filosofico a quello eminentemente pragmatico delle applicazioni militari, incontriamo il terzo reperto della nostra indagine archeologica: il report tecnico AD-A247 360 dello U.S. Army Electronic Proving Ground, datato settembre 1990. Intitolato “Methodology investigation of AI test officer support tool III” (“Indagine metodologica sullo strumento di supporto per ufficiali di test IA III”), questo documento rappresenta un caso di studio affascinante e largamente sconosciuto. Si tratta di un rapporto tecnico declassificato (unclassified), reso pubblicamente accessibile attraverso il Defense Technical Information Center (DTIC). Il documento è stato prodotto dall’Electronic Proving Ground di Fort Huachuca, Arizona, un centro di eccellenza dell’esercito statunitense per il testing e la valutazione di sistemi di comando, controllo, comunicazioni e intelligence (C3I). Il rapporto fa parte di una serie di studi metodologici condotti tra il 1988 e il 1990 per esplorare l’applicazione di tecnologie di intelligenza artificiale al supporto delle operazioni di testing.

Il report identifica con lucidità una criticità che ancora oggi affligge innumerevoli settori: la crescente complessità dei sistemi tecnologici e la fragilità della conoscenza esperta necessaria per gestirli. Il documento si apre con una diagnosi chiara:

“This hard-earned expertise is frequently lost to the organization because of personnel reassignment or attrition” (U.S. Army, 1990, p. 3).

Il problema è particolarmente acuto nel contesto militare, dove il personale è soggetto a rotazioni frequenti e dove la complessità dei sistemi C3I richiede anni di esperienza per essere padroneggiata. Ma la diagnosi ha una portata universale: in ogni organizzazione complessa, la conoscenza critica è spesso incarnata in pochi individui esperti, e la loro partenza rappresenta una perdita irreparabile di capitale intellettuale.

La soluzione proposta dal rapporto è l’inserimento di tecnologie di intelligenza artificiale, in particolare sistemi esperti sviluppati su microcomputer. La scelta del microcomputer (anziché dei costosi hardware specializzati come le macchine LISP che dominavano l’IA commerciale dell’epoca) è dettata da criteri di accessibilità e costo-efficacia, e rappresenta una scelta lungimirante che anticipa il collasso del mercato dei sistemi esperti proprietari.

Ciò che rende questo documento un precursore fondamentale del pensiero sull’AI Literacy è il suo duplice obiettivo. Gli strumenti di IA non sono concepiti solo per fornire soluzioni e migliorare l’efficienza, ma anche, e soprattutto, per una finalità pedagogica. Uno degli obiettivi espliciti del progetto era infatti:

“Education of the user (test officer); in addition to merely providing a solution, provide a means for the user to train new personnel by exposure to how a process is accomplished” (U.S. Army, 1990, p. 4).

In questa visione, l’apprendimento è organizzativo, iterativo e basato sulla pratica. Ad esempio, nel report, vengono illustrate le modalità con le quali sono costruiti i materiali di lavoro. Una metodologia basata su workshop collaborativi che affiancavano esperti di dominio (test officers con anni di esperienza) e ingegneri della conoscenza (knowledge engineers). Il rapporto descrive anche un apprenticeship program per formare personale di altri uffici, trasferendo non solo l’uso degli strumenti, ma anche la metodologia di sviluppo.

L’approccio dello U.S. Army del 1990 sposta l’asse dell’AI Literacy dall’individuo all’organizzazione, vedendola come una capacità strategica per garantire la continuità operativa e la gestione della conoscenza in ambienti complessi. L’alfabetizzazione all’IA, in questo contesto, assume una connotazione eminentemente pratica e organizzativa. Non si tratta di comprendere l’IA come concetto astratto, ma di sviluppare un ecosistema in cui:

- La conoscenza viene codificata in sistemi intelligenti.

- Il personale viene formato per utilizzare questi sistemi.

- Gli utenti contribuiscono al miglioramento continuo dei sistemi attraverso il feedback.

- La metodologia di sviluppo viene trasferita ad altri gruppi dell’organizzazione.

Questo modello, concepito in un contesto militare tre decenni fa, è di una rilevanza sconcertante per le sfide che le imprese e le istituzioni affrontano oggi nell’era dell’IA generativa. La domanda che il rapporto pone è ancora attualissima: come possiamo utilizzare l’IA non solo per automatizzare, ma per preservare, trasferire e amplificare la conoscenza umana?

Petrobas e il modello industriale di formazione all’IA

Il nostro viaggio archeologico si sposta sulla fine degli anni ’80 anche se il documento è stato pubblicato solo nel 1997 — lo stesso anno del fondamentale testo di Gilster (1997) sulla digital literacy — l’articolo “A model for advanced in-house industrial training: a case study on intelligent system technology transfer using a project-oriented approach” (“Un modello per la formazione industriale avanzata interna: un caso di studio sul trasferimento di tecnologia di sistemi intelligenti utilizzando un approccio orientato ai progetti”) di Tenorio, Maia e Grant-Tenorio, descrive un’iniziativa su larga scala implementata dal colosso energetico brasiliano Petrobas.

Il contesto è post-“inverno dell’IA“, e la lezione del decennio precedente è stata assimilata: l’adozione dell’IA in ambito industriale deve essere pragmatica, sostenibile e, soprattutto, orientata al valore. Il collasso del mercato dei sistemi esperti alla fine degli anni ’80 aveva lasciato un’eredità di scetticismo e diffidenza. Le aziende che avevano investito milioni in costosi hardware proprietari e consulenze si erano trovate con sistemi difficili da mantenere, impossibili da scalare e spesso incapaci di mantenere le promesse iniziali.

Petrobas, una delle maggiori compagnie petrolifere al mondo, decise di adottare un approccio radicalmente diverso: invece di acquistare soluzioni chiavi in mano da fornitori esterni, investì nella formazione interna del proprio personale, creando competenze endogene e sostenibili.

L’articolo illustra un programma educativo completo di livello graduate, sviluppato in collaborazione con Synergetics Science and Technology Inc., con l’obiettivo di formare i propri professionisti all’applicazione di tecniche di IA e reti neurali per la risoluzione di problemi manageriali e tecnologici, in un modo che fosse al contempo: “time- and cost-effective” (Tenorio et al., 1997, p. 144).

Il programma era articolato in due percorsi di specializzazione, coprendo i principali paradigmi dell’epoca:

- CAVIAR (Computer-Aided VIsion and Artificial Reasoning): Un corso focalizzato sull’IA simbolica, i sistemi esperti e il ragionamento basato su regole.

- CERN (Computational Emulation of Reasoning with Neural networks): Un corso dedicato all’approccio connessionista delle reti neurali.

Ma l’elemento più innovativo del modello Petrobas è l’adozione di un approccio eminentemente project-oriented (orientato ai progetti). La formazione non era un esercizio teorico, ma un processo di trasferimento tecnologico calato nella realtà aziendale. Gli autori spiegano che “L’obiettivo principale del programma era fornire ai professionisti PETROBRAS le competenze necessarie per applicare tecniche di IA e reti neurali per risolvere problemi manageriali e tecnologici in modo efficiente in termini di tempo e costi” (ibidem, p. 144).

I dipendenti-studenti non si limitavano a seguire lezioni e svolgere esercizi accademici, ma lavoravano su progetti reali, di diretto interesse per Petrobas. Questi progetti spaziavano dall’ottimizzazione dei processi di raffinazione alla manutenzione predittiva delle piattaforme offshore, dalla gestione delle scorte all’analisi dei dati geologici. In questo modo, l’apprendimento era contestualizzato, motivato e immediatamente applicabile.

Anche in questo approccio, si trasforma l’AI Literacy da competenza individuale a capacità organizzativa. L’obiettivo non è solo creare singoli esperti, ma diffondere una cultura dell’IA all’interno dell’impresa, costruendo un ecosistema interno in grado di:

- Identificare opportunità: Riconoscere dove l’IA può creare valore.

- Sviluppare soluzioni: Progettare e implementare sistemi di IA adatti ai problemi specifici.

- Gestire l’innovazione: Mantenere, aggiornare e far evolvere i sistemi nel tempo.

- Trasferire conoscenza: Formare nuove generazioni di professionisti.

Il caso Petrobas è un interessante “reperto”: un modello sistematico e scalabile di corporate AI literacy che anticipa di oltre due decenni le attuali strategie di upskilling e reskilling che le aziende stanno faticosamente cercando di implementare per fronteggiare la rivoluzione dell’IA generativa. Esso dimostra che già alla fine degli anni ’90 era chiaro che, per avere successo, l’adozione dell’IA non poteva essere delegata a pochi tecnici, ma richiedeva un investimento corale sulla formazione e sulla cultura dell’intera organizzazione.

Il progetto iRobot: l’AI Literacy entra nelle scuole austriache

Completano il nostro corpus di documenti tre contributi fondamentali provenienti da un gruppo di ricerca austriaco che ha pionieristicamente portato l’insegnamento dell’intelligenza artificiale nelle scuole di ogni ordine e grado. Martin Kandlhofer e Gerald Steinbauer, dell’Istituto di Software Technology della Graz University of Technology, insieme a Harald Burgsteiner della Fachhochschule Joanneum, hanno condotto nel 2016 una serie di esperimenti educativi che rappresentano i primi tentativi sistematici di sviluppare un’AI literacy scolastica (Burgsteiner, Kandlhofer e Steinbauer, 2016; Kandlhofer, Hirschmugl-Gaisch e Huber, 2016; Kandlhofer, Steinbauer, Hirschmugl-Gaisch, e Huber, 2016).

Il progetto iRobot (da non confondere con l’azienda produttrice di robot domestici) nasce dall’osservazione che, mentre la robotica educativa aveva già fatto il suo ingresso nelle scuole attraverso piattaforme come LEGO Mindstorms, l’insegnamento dei concetti fondamentali dell’intelligenza artificiale rimaneva confinato all’università. Kandlhofer e colleghi si posero una domanda provocatoria: è possibile insegnare l’IA — ricerca euristica, rappresentazione della conoscenza, apprendimento automatico — a studenti delle scuole superiori?

La risposta, documentata nel primo articolo del 2016, fu un clamoroso sì. Il gruppo sviluppò un modulo didattico innovativo della durata di 16 ore, articolato in lezioni teoriche, esercitazioni pratiche e un progetto finale. Gli studenti, utilizzando robot Lego Mindstorms e un ambiente di programmazione appositamente adattato, affrontavano problemi classici dell’IA come la navigazione autonoma, il riconoscimento di pattern e l’apprendimento per rinforzo.

Il secondo contributo, presentato alla IEEE Frontiers in Education Conference del 2016, amplia radicalmente la visione. Kandlhofer e Gerald Steinbauer-Wagner propongono un curriculum completo di AI e computer science che copre l’intero arco educativo, dall’asilo all’università. L’articolo introduce esplicitamente il termine “AI literacy” e lo definisce come: l’insieme di competenze che consente agli individui di valutare criticamente le tecnologie di IA, comunicare e collaborare efficacemente con l’IA e utilizzare l’IA come strumento” (Ibidem, p. 2).

Questa definizione anticipa di quattro anni quella di Long e Magerko (2020), dimostrando che il concetto di AI literacy era già maturo nella comunità dell’educational robotics prima di diventare mainstream.

Il curriculum proposto è articolato in quattro livelli:

- Kindergarten/Primary School: Introduzione al pensiero computazionale e ai concetti base di algoritmo e automazione attraverso il gioco.

- Middle School: Primi concetti di IA attraverso la programmazione di robot e l’esplorazione di comportamenti intelligenti.

- High School: Modulo iRobot completo, con introduzione formale ai concetti di ricerca, rappresentazione della conoscenza e apprendimento.

- University: Approfondimento tecnico e specializzazione.

Il gruppo austriaco ha dimostrato, con rigore empirico, che l’insegnamento dell’AI è non solo possibile, ma anche efficace e motivante a tutti i livelli scolastici. I loro esperimenti hanno coinvolto oltre 1000 studenti e 100 insegnanti tra il 2014 e il 2016, con risultati documentati in termini di apprendimento, motivazione e atteggiamento verso l’AI.

Questi tre contributi rappresentano un ponte fondamentale tra la “preistoria” dell’AI literacy e l’era contemporanea. Essi dimostrano che, già prima dell’esplosione dell’IA generativa, esisteva una consapevolezza matura della necessità di alfabetizzare le nuove generazioni all’intelligenza artificiale, non come utenti passivi, ma come cittadini critici e creatori informati.

Lezioni dal passato per costruire il futuro dell’IA

Il nostro viaggio archeologico nella “preistoria” dell’AI Literacy, attraverso l’analisi di otto documenti antecedenti al 2020, non è un mero esercizio di retrospettiva storica. Al contrario, esso svela una genealogia di pensiero di sorprendente attualità, capace di illuminare con una luce nuova le sfide che oggi affrontiamo nell’era dell’intelligenza artificiale generativa.

La prima considerazione è legata alla modernità del pensiero di William C. Hill e la sua visione dell’IA come medium. Questa intuizione, formulata nel 1989, si rivela oggi non solo profetica, ma essenziale per una corretta alfabetizzazione all’IA generativa. Hill ci ha insegnato a spostare lo sguardo dall’utopia (o distopia) di una macchina cosciente alla realtà di un nuovo, potentissimo strumento di rappresentazione. L’IA non è una mente, ma un’estensione della nostra mente; non è un autore, ma uno strumento di scrittura e di pensiero. Comprendere questo significa demistificare la tecnologia e riappropriarsi della nostra centralità. Le competenze che oggi identifichiamo come cruciali per la GenAI Literacy — la capacità di formulare prompt efficaci, di valutare criticamente gli output, di riconoscere i bias, di utilizzare l’IA come partner in un processo creativo — non sono altro che le declinazioni contemporanee di quella “padronanza dei mezzi espressivi” di cui parlava Hill. L’AI Literacy, in questa prospettiva, diventa una forma di semiotica applicata, la capacità di comprendere e utilizzare un nuovo linguaggio che sta rimodellando il modo in cui produciamo conoscenza, comunichiamo e persino pensiamo. Questa visione ci libera dall’ansia di essere “sostituiti” e ci restituisce la responsabilità di essere “autori” che si avvalgono di un nuovo, straordinario strumento. Come la stampa non ha eliminato gli scrittori ma ha trasformato radicalmente la pratica della scrittura, così l’IA generativa non elimina i lavoratori della conoscenza, ma ridefinisce profondamente le modalità del lavoro intellettuale.

La seconda considerazione è che, anche in questa fase embrionale, era già chiara la natura triadica di ogni reale processo di adozione dell’IA. Le tre leve fondamentali — persone, tecnologie e processi — dovevano essere concepite e sviluppate in modo integrato. Separarle, o privilegiarne una a discapito delle altre, significava votarsi al fallimento. I documenti analizzati, nel loro insieme, compongono un quadro olistico che dimostra questa consapevolezza. La lezione di questo approccio integrato, maturata a ridosso del secondo “inverno dell’IA“, risuona oggi con forza: l’implementazione dell’IA generativa nelle organizzazioni non può ridursi all’adozione di una nuova tecnologia, ma richiede un ripensamento sinergico dei modelli di business, dei flussi di lavoro e, soprattutto, un massiccio investimento nella cultura e nelle competenze delle persone.

La terza considerazione è che le domande più importanti non sono mai state puramente tecniche. Già decenni fa, in contesti molto diversi, emergeva la consapevolezza che l’adozione dell’intelligenza artificiale fosse una sfida culturale, pedagogica e organizzativa.

I pionieri di cui abbiamo riscoperto le tracce non erano ossessionati dalla corsa verso la super-intelligenza, ma erano concentrati su problemi concreti: come si impara, come si trasferisce conoscenza, come si lavora meglio insieme. La loro saggezza, pragmatica e umanistica, costituisce un antidoto prezioso contro le narrazioni iperboliche e spesso fuorvianti che dominano il dibattito odierno.

Agre ci ha mostrato che l’alfabetizzazione è innanzitutto immersione in una comunità di pratica e padronanza di un canone culturale. Lo U.S. Army ci ha insegnato che l’IA può essere uno strumento di memoria organizzativa che non solo conserva ma trasmette conoscenza. PETROBRAS ci ha dimostrato che l’adozione dell’IA richiede investimenti coraggiosi nella formazione. Konishi ci ha ricordato che l’AI literacy è innanzitutto consapevolezza strategica delle opportunità e dei limiti. Il gruppo di ricerca austriaco ci ha provato empiricamente che l’insegnamento dell’IA è possibile e fruttuoso a tutti i livelli educativi.

In definitiva, la preistoria dell’AI Literacy ci insegna che le domande fondamentali rimangono costanti attraverso i cicli tecnologici: Come possiamo sviluppare competenze critiche e non solo operative? Come possiamo preservare e trasferire la conoscenza in ambienti complessi? Come possiamo utilizzare la tecnologia per amplificare, e non sostituire, l’intelligenza umana? Come possiamo formare cittadini e lavoratori capaci di navigare un mondo in cui l’IA è pervasiva?

Ripartire da questa eredità significa costruire un futuro in cui l’intelligenza artificiale non sia un fine in sé, ma un potente mezzo al servizio dell’intelligenza umana. Significa resistere alla tentazione del determinismo tecnologico e riaffermare la centralità delle scelte umane, dei valori, della cultura. Significa, in ultima analisi, riconoscere che l’AI Literacy non è una competenza tecnica da acquisire, ma una postura intellettuale da coltivare: quella della curiosità critica, della consapevolezza riflessiva e della responsabilità creativa di fronte a uno strumento che, come la scrittura, la stampa e il computer prima di esso, sta ridefinendo le fondamenta della nostra civiltà.