Grokipedia, la nuova proposta di Musk che prende il nome dall’AI gen proprietaria Grok, in una versione preliminare, è online. Un progetto che nasce esplicitamente in seno alla politica, in un solco ideologico partitico, di destra, dichiarato dal principio.

Il 30 settembre, sul suo social X, Musk annunciava l’uscita della sua enciclopedia AI, scrivendo quanto segue: “We are building Grokipedia @xAI Will be a massive improvement over Wikipedia. Frankly, it is a necessary step towards the xAI goal of understanding the Universe”.

Questo messaggio in realtà è la ricondivisione commentata di un tweet di David Sacks[1], in cui affermava, traduciamo, che “Wikipedia è irrimediabilmente di parte. Un esercito di attivisti di sinistra gestisce le biografie e contrasta le correzioni ragionevoli. Ad aggravare il problema, Wikipedia appare spesso al primo posto nei risultati di ricerca di Google ed è ormai una fonte affidabile per l’addestramento dei modelli di intelligenza artificiale. Si tratta di un problema enorme”.

Innegabile che qualunque voce dizionaristica, qualunque libro, qualunque sguardo, compreso quello della scienza, dipendano da chi osserva, ma se l’osservazione non ha contraddittorio o processo di verifica collettivi, l’enciclopedia, da strumento educativo, tramite diffusione del sapere in senso lato diventa strumento di propaganda dittatoriale (che, come ci ricorda Popper, è l’assenza dell’opposizione).

Indice degli argomenti

Come funziona Grokipedia

Procediamo per gradi e capiamo come funziona il progetto di Musk, incominciando dalle definizioni, secondo Wiki e secondo Groki:

Grokipedia (dice wikipedia) è un’enciclopedia online generata dall’intelligenza artificiale sviluppata da xAI. Le voci di Grokipedia sono create e modificate dal modello linguistico Grok, anche se il processo esatto alla base della generazione dei contenuti non è noto. Grok, sempre secondo il sito wiki, cliccando ipertestualmente sulla parola in blu, è il chatbot generativo di Musk: un modello conversazionale che ha fatto parlare di sé per risposte assai controverse — filonazismo, teorie della cospirazione e antisemitismo.

Le copiature da Wikipedia

Molti articoli derivano da Wikipedia, alcuni dei quali sono stati copiati quasi alla lettera al momento del lancio. Gli articoli non possono essere modificati direttamente, anche se i visitatori che hanno effettuato l’accesso all’enciclopedia possono suggerire modifiche tramite un modulo pop-up per segnalare informazioni errate. Al 28 ottobre 2025, il sito dichiara di avere oltre 800.000 articoli.

Il fondatore di xAI, Elon Musk, ha posizionato Grokipedia come alternativa a Wikipedia, con l’obiettivo di “eliminare la propaganda” presente in quest’ultima. L’accoglienza iniziale riservata a Grokipedia si è concentrata sulla sua accuratezza e sui suoi pregiudizi dovuti ad allucinazioni e potenziali distorsioni algoritmiche, con diverse fonti che hanno descritto gli articoli come promotori di prospettive di destra, teorie cospirative e opinioni personali di Elon Musk.

L’esperimento: gli esiti di ricerca su Grokipedia

Su Grokipedia non troviamo una voce Grokipedia a sé, ma la vediamo inserita nel contesto di altre pagine.

Search for “grokipedia” yielded 8 results: Online encyclopedia; Criticism of Wikipedia for racial bias; Predictions of the end of Wikipedia; Allegations of ideological bias on Wikipedia; Wikimedia movement; Wikipedia and fact-checking; Portuguese Wikipedia; Wikipedia content moderation controversies dellle “enciclopedie online”.

Già questa selezione fa comprendere lo spostamento ideologico del sapere. Ma proseguiamo oltre. Scegliendo la prima definizione, troviamo un paragrafo in cui si parla come segue della Grokipedia: Grokipedia è una piattaforma emergente sviluppata da xAI e annunciata il primo ottobre 2025 come alternativa open-source a Wikipedia. Essa dichiara un approccio di massima ricerca della verità, generando e curando le voci tramite il modello Grok AI, che sfrutta grandi dataset e ragionamento sui principi primi.

L’obiettivo dichiarato è produrre contenuti neutrali e trasparenti, integrando feedback degli utenti senza ricorrere all’editing anonimo di massa. A ottobre 2025 Grokipedia è ancora in fase beta, con un ritardo rispetto alle tempistiche iniziali, per migliorare la precisione di fronte alle critiche secondo cui i sistemi di IA ereditano pregiudizi dai dati di addestramento (e qui si cita ad esempio the coversation) — anche se xAI afferma di contrastare il problema con un controllo dei fatti in tempo reale basato su fonti verificabili.

La campagna ideologica dietro a Grokipedia

I sostenitori, tra cui il fondatore di xAI Elon Musk, posizionano Grokipedia come una risposta agli squilibri ideologici percepiti nelle enciclopedie collaborative, sfruttando l’intelligenza artificiale per la scalabilità e gli aggiornamenti rapidi su argomenti come economia, fisica ed eventi attuali. La sua architettura integra le capacità di query-risposta di Grok per generare voci su richiesta, potenzialmente integrate dalla supervisione umana dei ricercatori di xAI, sebbene i dettagli completi sulla governance rimangano in arrivo a partire dalla fine di ottobre 2025.

Vantaggi e rischi di Grokipedia

I primi test suggeriscono vantaggi in termini di velocità e copertura di prospettive sottorappresentate, ma gli scettici notano rischi di allucinazione o eccessivo affidamento su dati proprietari, sottolineando la necessità di una convalida continua rispetto alle prove empiriche primarie. Questa piattaforma esemplifica il passaggio verso la specializzazione algoritmica nelle enciclopedie online, dove l’intelligenza artificiale gestisce la sintesi aspirando al realismo causale rispetto alle narrazioni guidate dal consenso.

Nel paragrafo si mette poi a confronto con la SEP, Stanphord Enchyclopedia of Philosophy, la quale privilegia autorità accademica, revisione esperta e aggiornamento continuo, mentre Grokpedia propone sintesi algoritmica, rapidità e filtraggio personalizzato delle informazioni.

Insomma, quello che appare evidente, per entrambe, è che, più che voci enciclopediche, sembrano il discorso di un politico o comunque un articolo da cui traspare l’inclinazione del giornale che lo ospita: apertamente in polemica con Wikipedia, e viceversa. Wiki polemizza contro l’avversario e Groki si autocelebra e si propone come verità a differenza della parzialità dell’enciclopedia collaborativa. In breve, troviamo un tono accusatorio reciproco, più che la neutralità – tanto per una quanto per l’altra.

Le differenze tra Grokipedia e Wikipedia

Ciò che comunque resta concreto, al di là di tutto, è che Grokipedia sembra l’ennesimo sfondone del miliardario. Come per SpaceX e Tesla, anche qui vediamo un racconto fantascientifico, la distopia di un’enciclopedia alternativa alla “massoneria di sinistra”, alle industrie del caffè e ad altre idee balzane, mentre di fatto le pagine proposte sono proprio quelle di Wikipedia – certo, a parte i temi trigger del miliardario, tra cui il riscaldamento globale, come evidenzia anche Wired, e una certa indulgenza e autocompiacimento narcisistico.

In fondo, le scelte narrative di entrambe le enciclopedie risultano comprensibili. Grokipedia nasce come progetto privato e commerciale, guidato da un CEO noto per le sue provocazioni; Wikipedia, dal canto suo, tende a sospendere l’ideale di neutralità nei confronti dell’azienda che da tempo la accusa. In questo scontro di narrazioni è naturale che prevalgano le critiche più che il riconoscimento di eventuali meriti o potenzialità delle tecnologie Grok e Grokipedia. Resta però la differenza sostanziale: Wikipedia rimane una piattaforma no-profit, fondata sulla collaborazione volontaria e sulla costruzione collettiva della conoscenza basata su fonti verificabili.

Enciclopedia online, cosa cambia con l’AI

Rispetto a qualche anno fa le nostre abitudini digitali di recepimento delle informazioni sono mutate radicalmente. Aranzulla (mastro di chiavi della nostra generazione) in un’intervista a Fanpage lamenta una perdita di flusso del 25 percento sul suo sito. Questo volo in picchiata, dice, è accaduto da quando Google avrebbe inserito AI Overview nel suo browser: uno strumento che riassume già la risposta per l’utente, quella che quest’ultimo, un tempo, avrebbe dovuto trovare, leggere e dedurre tra i vari link, ma che ora riceve bell’e pronta in alto. “Prima Google portava gli utenti sui nostri siti, ora mostra risposte create rielaborando i nostri contenuti — senza bisogno di cliccare”, afferma esplicitamente Salvatore Aranzulla.

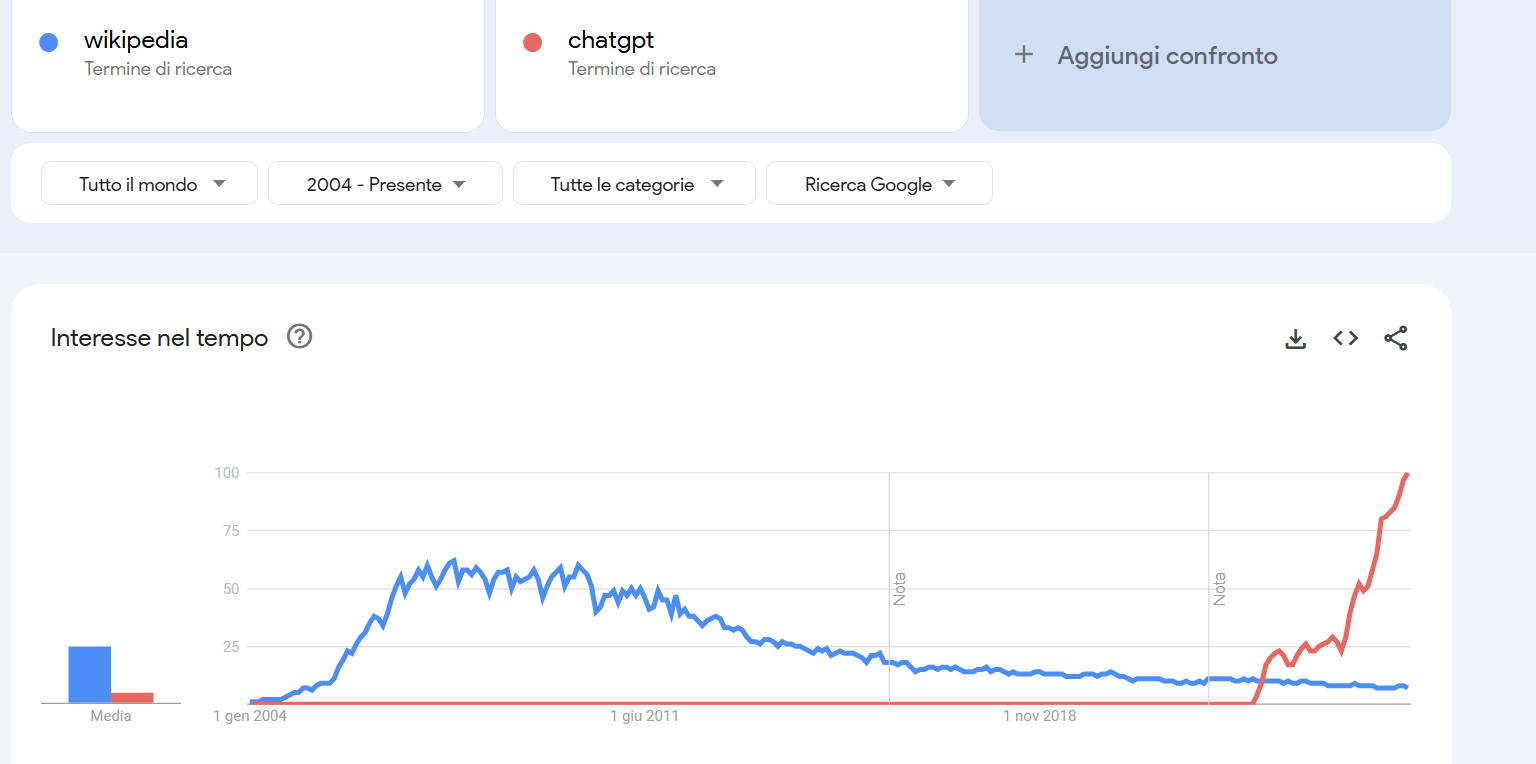

La stessa tendenza la si può intuire rispetto alle ricerche su Wikipedia. Se andiamo su Google trends e cerchiamo wikipedia, aggiungendo poi una generica chiave chatgpt a confronto, si vede nettamente il cambiamento inesorabile delle abitudini digitali degli utenti del web dal 2004 a oggi (Fig.1).

Le trasformazioni di Seo e browser e la conoscienza passiva

Questa trasformazione, che sta già modificando le logiche della SEO e la struttura della ricerca online, comporta il rischio di un approccio passivo alla conoscenza, in cui l’utente delega completamente il proprio ruolo critico alla macchina. L’errore più grave è confondere l’intelligenza artificiale con un vero educatore: l’IA non è Socrate, non guida al sapere attraverso il dialogo, ma restituisce la risposta più probabile secondo modelli statistici.

Il browser, al contrario, implicava un atto di selezione soggettivo, pure in un palinsesto di pertinenza proposto dal motore – un ordo rerum algoritmico. Insomma, l’atto di libertà, di responsabilità e di movimento ipertestuale era ben preservato del web 2.0. Con l’assistente conversazionale questo processo si riduce (addirittura annulla), e con esso la libertà. La conoscenza, per sua natura, richiede confronto, scelta e responsabilità; quando queste vengono sostituite dalla voce unica dei LLM, il sapere si trasforma in consumo, secondo gli imperativi della velocità e della probabilità, con l’impossibile o arduo verificarsi del clinamen e di qualunque serendipità, se la selezione avviene secondo un algoritmo calcolato sulla massa e su ciò che essa si aspetta.

La trasparenza dei motori di ricerca vs le reti neurali

Google e gli altri motori offrivano una selezione più trasparente e spiegabile rispetto alle reti neurali, che sappiamo mancare di spiegabilità. Inoltre, l’ergonomia facilitava l’ipertesto, il clic, e lo presentava come uno spazio esperienziale di prove ed errori, cioè di scoperta – una metodologia perfetta per l’apprendimento. Un ulteriore elemento educativo interessante era dato dalla modalità di ricerca: la chiave inserita nel browser costituiva già un principio di condensazione e sintesi tramite le keywords essenziali.

Scegliere le parole chiave significava definire il proprio pensiero, sintetizzarlo e orientarlo verso uno scopo. Il chatbot, invece, è più indulgente: comprende dove vogliamo andare a parare e restituisce comunque una risposta, compensando la nostra pigrizia, la nostra incapacità di fare prompt engineering, e ignorando gli errori. In breve ci sa offrire sempre e comunque ciò che un utente medio potrebbe voler ottenere.

Il nodo della varietà delle fonti

Il problema sorge per chi non è un utente medio, e per le fonti non “trovabili” da GPT, non aggiornate a un SEO moderno. La dispersione nel mare magnum dei dati era già un problema serio, ma almeno era preservata ancora la scelta e la lettura di varie fonti, la rivoluzione copernicana; qui, invece, il soggetto torna a essere uno specchio passivo – e distorcente, tipico dei parchi a tema.

Figure 1 Qui un grafico da Google trends che mostra l’interesse progressivamente calante per Wikipedia dal 2004 a oggi e come negli ultimi anni, da quando chat gpt è stato rilasciato, siano invece esplose le ricerche per il modello di generazione AI.

Storia del cambiamento dell’enciclopedia

L’Enciclopedia dell’Età dei Lumi è ovviamente nata come obiettivo sociale e quindi politico, ma vedremo qui in che modo tale idea sociale è diversa da quella proposta da Sacks e da Musk.

Nel XVIII secolo è l’intellettualismo etico per cui il male sembra derivare dalla non conoscenza, sfruttata ad hoc da Stato e Chiesa. L’Illuminismo parte dal presupposto che non vi sia alcuna autorità al di sopra della ragione. Qualunque altra causa o principio — Dio, finalità, Stato o Chiesa — rappresenta una falsa autorità, poiché si fonda sull’uso strumentale dell’ignoranza del popolo. Il compito della nuova cultura e degli esperti è dunque quello di diradare, con i lumi della ragione e con la diffusione del sapere, le superstizioni, per condurre l’umanità a uno stato di sviluppo superiore.

L’obiettivo dell’Enciclopedia non è soltanto descrittivo o testimoniale: è profondamente politico. Si colloca in un momento di sovvertimento dell’ordine medievale, con l’intento di liberare l’essere umano dalle vecchie autorità del passato — un riscatto dalla tradizione dei poteri costituiti. In questa visione, la conoscenza è strumento di emancipazione e di progresso collettivo: a ogni soggetto viene restituita l’autorità e la responsabilità di ragionare autonomamente, perché tutti, possedendo la ragione, sono potenzialmente in grado di farlo.

È un principio di uguaglianza garantito dal Logos, contro la divisione per ceti. Il sapere, raccontato dagli esperti nelle scienze e nelle tecniche, viene organizzato in un tutto ordinato e coerente, ma sempre accessibile. In questo senso, l’Enciclopedia rappresenta un progetto etico e democratico: educare alla libertà attraverso la conoscenza. Con Grokipedia e le altre aziende di AI, invece, sembra profilarsi il ritorno a una forma di centralità autoritaria del sapere: qualcuno che decide cosa è vero e cosa è falso, sottraendo al soggetto la possibilità di confrontare molte fonti e costruire una propria media razionale.

Il caso della Stanford Encyclopedia of Philosophy

In linea con la tradizione illuministica vi è, per molti aspetti, la Stanford Encyclopedia of Philosophy (come anche la Storia della filosofia curata da Riccardo Fedriga e Umberto Eco), in cui sono i filosofi e gli studiosi specialisti di una determinata area a redigere e aggiornare le voci. Si tratta di un sapere esperto, fondato sull’autorevolezza accademica e sulla accountability — chi scrive una voce ne risponde, in quanto esperto e in quanto autore identificabile.

Wikipedia nasce invece come un progetto radicalmente diverso, quasi in polemica con questa impostazione: una piattaforma aperta, in cui chiunque può intervenire, correggere, ampliare o discutere una voce – senza firma. Non si tratta di democratizzare il sapere nel senso illuministico del termine, ma di socializzarlo, cioè di renderlo il prodotto di una rete di contributi distribuiti e anonimi.

Il sapere come trend

È, come si potrebbe dire, la reificazione dell’oralità: la conoscenza non più trasmessa da un’autorità, ma continuamente rinegoziata, scritta e riscritta da una comunità viva, pur senza la laurea e la qualifica da esperto. Un’oralità, insomma, di cui ciascuno è trasmettitore della fonte. Come ai tempi della Grecia antica l’attore ripeteva una formula codificata dalla tradizione, che restava la vera esperta (e poi la memoria ogni tanto facendo cilecca riformulava), anche con Wikipedia chiunque, sulla scorta del riferimento, può contribuire a tramandare il verbo –con il passaggio inevitabile del filtro e della reinterpretazione.

Con Wikipedia qualunque anonimo può intervenire, non sulla scorta della Ragione stoica e illuministica che ci rende uguali in potenza, ma secondo la filosofia americana di stampo positivista, che sostiene che tutti possiamo già farlo. Nel Settecento l’uguaglianza restava elitaria e marcatamente borghese, formale e non sostanziale: infatti l’Encyclopédie era una sorta di Stanford Encyclopedia of Philosophy, non certo un sito wiki. Inoltre, la scrittura e la stampa cartacea richiedevano tempi lunghi per ogni cambiamento. Oggi sembra un vantaggio poter aggiornare tutto rapidamente, ma in realtà il sapere stesso sembra aver assunto l’andamento di un trend, di una moda, di una stagionalità.

Su Wikipedia, infatti, può intervenire qualunque volontario, a prescindere da expertise e curriculum — ma non senza autorità: l’autorità è quella della fonte. Resta tuttavia la domanda: siamo sicuri che l’anonimo utente abbia la competenza necessaria per saperla leggere e interpretare correttamente? Si sostiene che spetti agli accademici la responsabilità di controllare il proprio bacino di conoscenza, segnalando eventuali interpretazioni errate prodotte da altri.

Questa verificabilità e apertura alla correzione da parte di tutti dovrebbero garantire un certo principio di neutralità. In sintesi, Wikipedia si fonda su norme di affidabilità e di neutralità di punto di vista, garantite da un sistema di controllo condiviso, costituito da volontari (non guidati da un’ideologia o da un comitato centrale) e da bot che segnalano o annullano modifiche sospette.

Trasparenza e tracciabilità di correzioni e fonti

Insomma, a differenza dell’Enciclopedia illuministica o della Stanford Encyclopedia of Philosophy, Wikipedia non si basa su un sistema redazionale chiuso né su voci curate da esperti riconosciuti in una disciplina. Il suo principio fondativo è quello della partecipazione aperta: chiunque, anche senza registrarsi, può modificare o creare una voce, purché rispetti le regole fondamentali di verificabilità delle informazioni (ogni affermazione deve essere accompagnata da una fonte attendibile) e di neutralità del punto di vista. Ogni voce dispone inoltre di una pagina di discussione pubblica, in cui gli utenti confrontano le fonti, discutono le interpretazioni e decidono, in modo collaborativo, la forma finale del testo.

L’affidabilità di Wikipedia

Questo sistema non elimina del tutto il rischio di errore, ma lo rende trasparente e tracciabile: tutte le versioni precedenti di una voce sono conservate e consultabili, insieme alla cronologia delle modifiche e ai nomi degli utenti che le hanno effettuate. Sulla sua affidabilità, uno studio pubblicato proprio su Nature nel 2005 ha confrontato 42 voci di scienze tra Wikipedia e l’Encyclopaedia Britannica. I risultati mostrarono che, in media, le voci di Wikipedia contenevano circa 3,86 errori per voce, contro i 2,92 di Britannica, una differenza considerata minima rispetto alla vastità del progetto. Questo portò la rivista a concludere che Wikipedia fosse “sorprendentemente accurata” per un’enciclopedia scritta da volontari. Studi successivi hanno confermato che la qualità delle voci varia a seconda dell’argomento e della lingua, ma che nei settori più frequentati e monitorati (come scienze, storia e filosofia) l’affidabilità si mantiene su livelli comparabili a quelli delle enciclopedie tradizionali.

Il concetto di sapere collettivo e lo scontro con l’AI

Wikipedia rappresentava ancora l’idea di un sapere collettivo, tipico della prima era digitale, in cui il confronto tra fonti restava parte del processo di apprendimento e in cui gli utenti del Web 2 non erano più passivi, venendo tradizionalmente definiti “comment-autori” e “spett-autori”. Tuttavia, quest’attività sembra star venendo via via meno con LLM e con i motori di ricerca integrati nei chatbot generativi, come ChatGPT connesso a Internet, e viceversa, Ai Overview in Google. Si è inaugurata una nuova modalità di produzione, accesso e ricezione del sapere — di nuovo asimmetrica e passiva, ma con un ipse dixit basato sulla statistica e sui dati del web (da università della strada a università dei social è un attimo): non si cercano più le informazioni, è l’assistente a trovarle, valutarle e restituirle al posto nostro.

A partire da ChatGPT e dai modelli generativi integrati nei browser (Gemini per Google, Bing per Microsoft e simili) si è verificato un passaggio verso sistemi artificiali enciclopedici, che, basandosi sulla statistica, creano un ordine probabilistico dei saperi, diverso dall’ordine conferito dagli esperti, fondato sulla cronologia e sull’evoluzione diacronica delle conoscenze. In questi sistemi, la gerarchia dei contenuti dipende dalla probabilità, dalla frequenza e da altre dinamiche statistiche, senza derivare necessariamente dalle sistematizzazioni precedenti: ciò che in un vero percorso educativo guidava verso un confronto attivo e neutrale, qui viene sostituito da un percorso più diretto e semplificato, spesso concentrato sul “giungere al sodo” senza stimolare la scoperta. Il tutto dei modelli linguistici non è enciclopedico, non è qualitativo, è un tiro di dado, per giunta truccato.

Come gli LLM cambiano le enciclopedie

L’uso di modelli generativi come GPT per creare enciclopedie digitali segna un cambiamento radicale, non solo non si legge più l’enciclopedia cartacea (antica come le caramelle Rossana nelle case dei nonni e come il corredo alle figlie), ma non si consultano più gli esperti (umani) nel settore, non si attuano più confronti, accettando, acriticamente l’informazione dal “maestro digitale”, quello che sembra corrisponderci di più: il sapere non è più la laurea, derisa dal mondo memico dei social, e non è nemmeno più costruito collettivamente tramite sito wiki. Il sapere non è una summa, ma un sunto, risultato di una scelta demandata al robot generativo secondo logiche statistiche e predittive.

Ciò comporta, come abbiamo anticipato, criticità educative e civiche, con un rischio concreto di passivizzazione del sapere e di concentrazione ideologica: il possesso di quel sapere da parte di gruppi chiusi di potere, aziende private, tanto OpenAI quanto Google, tanto xAI quanto Meta, che si fanno veicolo della verità per il popolo: insomma siamo al polo contrario rispetto ai principi illuministici di ragione, confronto, saggezza distribuita e “sapere aude!” kantiano. Non c’è più coraggio nell’uso della propria ragione, la rivoluzione copernicana è tornata specchio passivo. Uno specchio che però è orientato al profitto.

L’interpretazione del fenomeno attraverso Popper e Habermas

Possiamo aggiungere un’altra riflessione, collegandoci all’idea di ingegneria gradualistica di Popper, per cui non esiste una verità assoluta, né una persona che la possieda, al contrario è più razionale lavorare collettivamente sui problemi e sui “mali” della società, in un’ottica scientifica, fatta di falsificazioni, verifiche aperte, condivisone dei risultati perché ci sia un reciproco controllo, questo al fine di costruire una sorta di saggezza distribuita, una diffusione del sapere— attraverso diversi articoli, voci enciclopediche, siti, video e altre testimonianze condivise online — a cui tutti possano prendere parte mediante forme di partecipazione democratica, confronto e discussione, in un tentativo di arrivare a compromessi condivisi.

Questo ricorda anche l’etica della conversazione di Habermas: partire da posizioni diverse, senza alcuna pretesa di possedere la verità, per trovare un terreno comune tramite il dialogo.

Questa dinamica sembra ormai interrotta in una situazione in cui il compromesso teorico è trovato e confezionato dagli LLM, con un utente passivo che si trova a ricevere ciò che già cerca, secondo un modello che segue l’etica della pubblicità: conferme per l’audience, zero rischio per chi comunica, e quindi un appiattimento verso il basso. La democrazia, seguendo il ragionamento di Popper, dovrebbe mirare a elevare il popolo, non a dargli ciò che vuole, ma a spingerlo ad attualizzare il meglio di sé: il pungiglione socratico. Si assiste così a una recrudescenza delle posizioni estreme, fenomeno già osservato con gli algoritmi dei social media, che propongono contenuti calibrati sui gusti del destinatario, in modo da non sconquassarlo, ma di lasciarlo a dormire pacificamente.

Passività 3.0 e distopia

In buona sostanza alla passività 3.0, già di per sé allarmante, si aggiunge l’obiettivo distopico (anagramma di dipotico) di Grokipedia: esplicitamente politico e di destra, riflesso di Musk. Le conseguenze sono potenzialmente gravi per la diffusione di disinformazione e per la conferma di posizioni autoritarie.

Già gli algoritmi dei social impediscono il confronto e il contraddittorio, mostrando sempre ciò che l’utente vuole vedere, confermando le sue convinzioni e creando l’illusione di un mondo costruito su misura. In questo caso si aggiunge un’enciclopedia che parla una sola lingua, rinforzando la polarizzazione e limitando drasticamente l’esperienza critica, che sappiamo essere fondamentale nell’apprendimento libero e autentico.

Ciò che viene offerto dall’azienda xAI è un sofista artificiale, un piccolo Ippia digitale di estrema destra e complottista, privo di guardrail, se non “dall’altra parte”, l’esilio dell’opposizione. Il guardrail in AI è quel sistema di blocchi programmati per evitare che i bot, imparando tutto lo scibile — specialmente dal web, fonte primaria di dati e di conoscenza per questi LLM — generino contenuti inappropriati, come fake news, misoginia, violenza o nudità. Immaginate Reddit come letture d’infanzia e pensate al tipo di “fanciullo” che ne uscirebbe: certamente non quello della Montessori, ma più simile ai bambini abituati a tablet e giochi digitali.

Per evitare che il “bambino” metta le “Nike” di Trallallero Trallallà, ci sono due strade: intervenire a monte, impedendo che acquisisca certi contenuti nocivi, oppure intervenire dopo, cercando di rieducarlo. Per il deep learning la via è simile: si cerca di fornire un dataset il più pulito possibile, ma, siccome un LLM può generare qualunque cosa abbia appreso, potrebbe comunque produrre contenuti problematici. Un dataset totalmente privo di riferimenti aberranti è impossibile: nella mole gigantesca di dati qualche scena “da cui prendere spunto” passerà inevitabilmente. Ecco perché servono i guardrail: blocchi ad hoc per impedire che il sistema diffonda ciò che ha imparato e che non è considerato appropriato.

Una definizione di inappropriatezza

Ovviamente, il concetto di “non appropriato” dipende da una scelta culturale e da uno sguardo specifico. Ma esiste una differenza fondamentale: un conto è una scelta basata su principi etici il più possibile condivisi, frutto di un compromesso ragionato sul rischio e fondato sul discernimento tra verità e falsità, sostenuto da fonti, metodi e comunità scientifiche; un altro conto è una selezione imposta da un potere ideologico o economico, come nel caso di xAI.

Senza scomodare il post-strutturalismo, la post-verità o i filosofi della scienza come Feyerabend — i quali sostengono che non esista una verità unica e che il dubbio estremo può diventare paralizzante, lasciando spazio a derive politiche — a volte funziona meglio il buon senso della filosofia analitica o un criterio pragmatico legato alla democrazia. Per spiegarmi con un esempio: quando disegno una parabola sul quaderno, uso la geometria euclidea.

Etica dell’audience e confronto democratico

In conclusione, un’enciclopedia generativa basata sulla probabilità e sulla maggioranza incarna l’etica dell’audience e, di conseguenza, sostituisce la dinamica democratica: non c’è contraddittorio, non c’è opposizione e non esiste un reale dibattito pubblico. Il risultato è una trasmissione del sapere anti-democratica, in cui la conoscenza non è distribuita né critica, ma centralizzata, economica e senza metacoscienzza, con il rischio di diffondere superstizione e confermare pregiudizi. È l’approccio opposto a quello illuministico: mentre l’Illuminismo mirava a liberare l’uomo dalle false autorità e a promuovere un sapere ragionato e condiviso, l’IA priva l’utente della possibilità di confrontare fonti, riflettere e partecipare alla costruzione collettiva della conoscenza.

Bibliografia

Saettone, Lorenza (12 maggio 2022). “La chatbot di Google sostituirà i motori di ricerca? Male, ecco perché”. Agenda Digitale. Disponibile online: https://www.agendadigitale.eu/mercati-digitali/la-chatbot-di-google-sostituira-i-motori-di-ricerca-perche-non‑e‑una‑bella‑prospettiva/ .

Sacks è coinvolto dai tempi di PayPal negli affari di Musk e dal 2024 è diventato “zar” (letteralmente) dell’AI e delle criptovalute per Trump e per la Casa Bianca. ↑