Il 3 gennaio scorso, nelle ore immediatamente successive all’annuncio della cattura del presidente del Venezuela Nicolás Maduro, mentre le agenzie internazionali si affannavano a verificare fonti, contesti e implicazioni geopolitiche dell’evento, i social network avevano già prodotto una “loro” versione della storia.

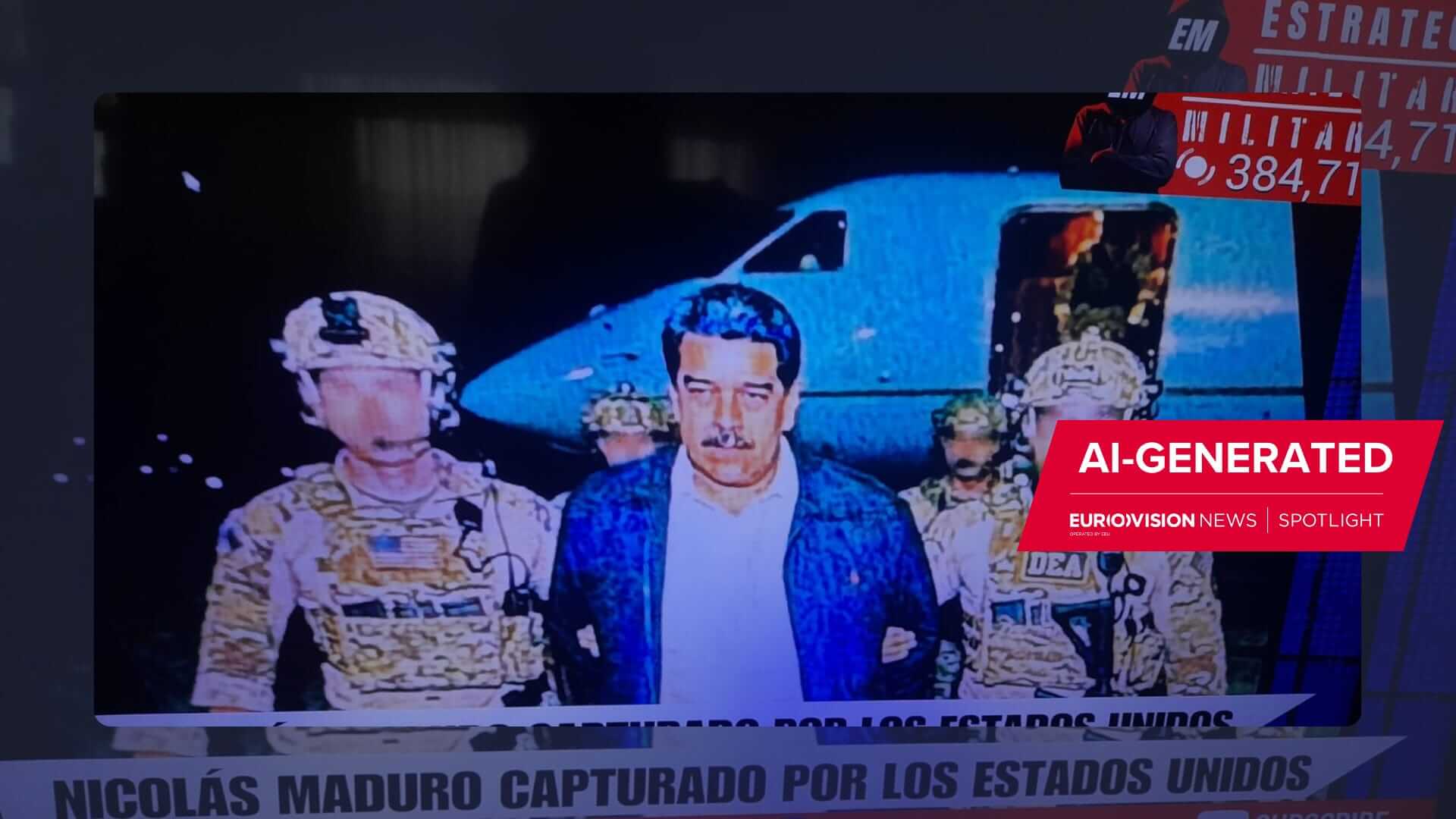

Una rappresentazione visiva completamente sintetica dell’evento, veniva generata e diffusa da sistemi di intelligenza artificiale.

E’ probabilmente la prima volta che la disinformazione con l’AI viaggia in tempo reale di pari passo con un grande evento storico.

Indice degli argomenti

La disinformazione AI sulla cattura di Maduro

Si tratta di immagini e video che mostrano il presidente venezuelano in pigiama bianco all’interno di un aereo cargo militare (a enfatizzarne l’umiliazione, nonostante in realtà Maduro sia stato trasportato in elicottero e non in aereo).

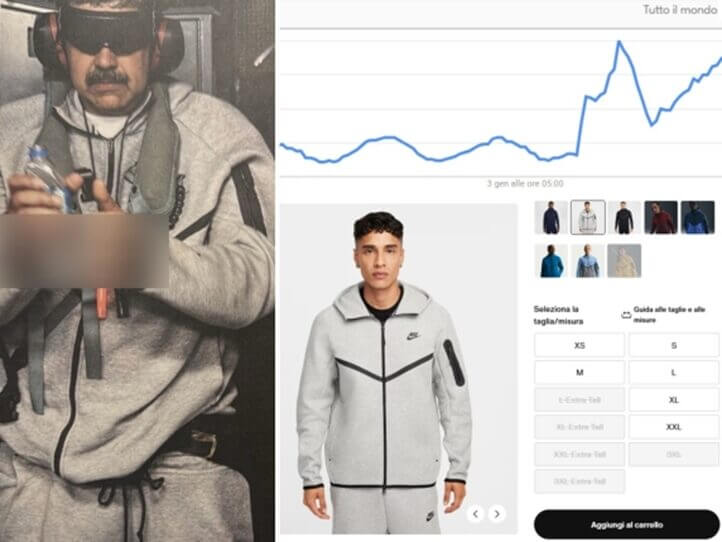

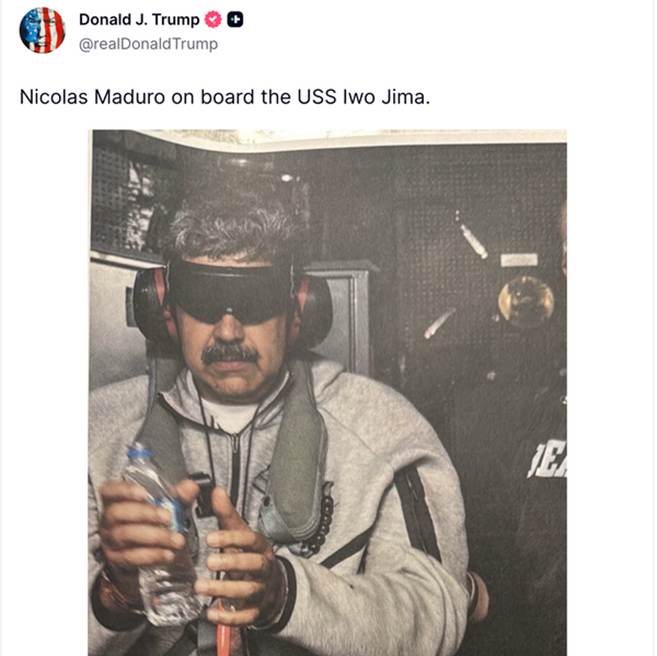

Oppure scortato da soldati dell’esercito US, in pose umilianti o grottesche (talvolta affiancato da personaggi controversi come il rapper e produttore Sean “Diddy” Combs; oppure in tuta grigia griffata Nike, modello diventato subito virale con boom di vendite online), in una miscela di satira, provocazione e realismo artificiale che rende quasi impossibile una classificazione univoca.

Sono immagini viste da 14 milioni di persone solo su X secondo Newsguard.

Anche se le successive verifiche (effettuate da fast-checkers anche tramite strumenti come SynthID di Gemini) e report hanno rivelato che alcune delle immagini più virali contenevano watermark e artefatti tipici della generazione AI (generati con strumenti noti, di colossi quali di colossi quali Gemini, ChatGpt, Grok ecc.) e la loro diffusione aveva ormai già inciso sulla percezione dell’evento.

Secondo diversi analisti, si tratta infatti di uno dei primi casi in cui media sintetici su un leader politico globale sono stati prodotti e circolati mentre la notizia era ancora in divenire, anticipando fatti, verifiche e narrazioni ufficiali.

Non siamo di fronte a meme nel senso tradizionale del termine, poiché non c’è un codice ironico esplicito, né, soprattutto, una distanza evidente tra realtà e finzione. Al contrario, questi contenuti simulano il linguaggio visivo del reportage giornalistico, della fotografia giudiziaria, della documentazione “ufficiale”.

Il dato rilevante è la collocazione temporale di queste immagini false. I deepfake, anziché arrivare “dopo”, per commentare o deformare l’evento, si presentano durante, o addirittura prima che l’evento sia pienamente comprensibile. È qui il salto: l’intelligenza artificiale, senza curarsi di manipolare la memoria del passato, interviene nella costruzione immediata del presente, competendo direttamente con il giornalismo e con le istituzioni informative.

In questo senso, il caso Maduro è un segnale strutturale e allarmante: la cronaca non è più il primo livello di sedimentazione della realtà pubblica. Prima della parola, prima del contesto, prima della verifica, arriva l’immagine sintetica. E spesso è quella che resta.

Disinformazione e Maduro: così la realtà diventa “sintetica” per default con l’AI

Continuare a leggere questi fenomeni con la categoria tradizionale di fake news sta diventando obsoleto e fuorviante. La fake news classica, infatti, presupponeva una falsità riconoscibile, almeno ex post: un testo errato, una fotografia manipolata, una narrazione smascherabile attraverso il fact-checking. Nel caso dei deepfake generativi, invece, la falsità è una funzione “nativa” del sistema, non una sua anomalia.

I modelli generativi contemporanei (dalle GAN ai modelli di diffusione), senza “alterare” un contenuto reale, producono direttamente realtà visive alternative, plausibili, coerenti, contestualizzate. Il risultato è una versione possibile della realtà, indistinguibile da una documentazione autentica se isolata dal contesto.

Questo passaggio è cruciale, in quanto colloca il fenomeno nel dominio della simulazione ontologica. L’immagine rappresenta qualcosa che non è accaduto o, meglio, qualcosa che sarebbe potuto accadere, e per questo appare credibile. In un ecosistema informativo saturo, l’utente è portato ormai a valutare la verosimiglianza narrativa di un evento e non la sua veridicità.

I deepfake di Maduro sono stati pubblicati sui social dallo stesso Presidente Trump, oltre che da altri personaggi pubblici e canali politici ufficiali, come Elon Musk, il figlio dell’ex presidente brasiliano Bolsonaro, il partito di destra portoghese Chega; tutto ciò ha contribuito a rafforzarne la credibilità apparente.

Questo tipo di deepfake funziona perché si inserisce senza attriti nel flusso delle aspettative: un leader autoritario, arrestato, umiliato, punito.

L’AI, senza bisogno di inventare una storia implausibile, procede ad ottimizzare una storia già culturalmente pronta. Questa aderenza alle aspettative collettive rende il contenuto pericoloso, perché riduce la soglia critica e accelera l’accettazione emotiva, che è quella che conta.

Prima di Maduro, altri casi recenti di disinformazione AI

Recentemente, altri episodi analoghi hanno mostrato come media sintetici e deepfake possano intervenire direttamente su eventi politici, elettorali o mediatici mentre sono ancora in corso. Si va dalla telefonata deepfake con la voce di Joe Biden usata per scoraggiare il voto alle primarie statunitensi, al falso annuncio elettorale (sempre negli Stati Uniti) con un deepfake del leader democratico Chuck Schumer, fino ai livestream contraffatti che hanno superato in visibilità degli eventi ufficiali, come nel caso della falsa diretta AI durante una conferenza Nvidia.

In tutti questi casi, la disinformazione si è posta in diretta competizione, in tempo reale, con la stessa realtà, sfruttando velocità, ambiguità visiva e ufficialità apparente dei contenuti e delle immagini.

La disinformazione in tempo reale: la velocità è potere politico

Il fatto che la disinformazione agisca in simultanea con la storia, cioè mentre questa si sta ancora formando, introduce una dinamica inedita: chi controlla la prima ondata visiva controlla anche la cornice interpretativa dell’evento.

In passato, la costruzione del significato di un evento storico seguiva una sequenza relativamente stabile: fatto, documentazione, interpretazione, memoria. Oggi questa sequenza è collassata, visto che l’AI è in grado di produrre “documentazione” prima ancora che il fatto si sia stabilizzato, creando un cortocircuito in cui l’interpretazione precede la verifica.

Questa accelerazione ha conseguenze profonde.

In primo luogo, rende quasi irrilevante la smentita successiva: una volta che l’immagine si è fissata nella mente dell’utente, il chiarimento arriva comunque troppo tardi e con minore carica emotiva.

In secondo luogo, alimenta quello che la letteratura definisce liar’s dividend: in un mondo saturo di deepfake, anche i contenuti autentici diventano contestabili, perché sempre potenzialmente “artificiali”.

Il paradosso è evidente: la diffusione dei deepfake, oltre a rafforzare la disinformazione, indebolisce la possibilità stessa di provare la verità. Così ogni prova visiva diventa sospetta e ogni documento contestabile. Insomma, un ambiente ideale per la manipolazione e per la negazione sistematica dei fatti.

Memoria storica e presente artificiale: un danno irreversibile?

Uno degli aspetti meno discussi, ma più critici, della disinformazione AI-driven riguarda inoltre la memoria collettiva. Gli eventi storici vengono ricordati, più che per ciò che sono stati, per le prime immagini che li hanno rappresentati. Se queste immagini sono sintetiche, la distorsione diventa strutturale.

Nel caso Maduro, il rischio (che in realtà si è già concretizzato) è che le immagini false diventino il riferimento visivo dominante associato all’evento. Anche sapendo che sono false, restano; si sedimentano, riemergono nelle ricerche, nei repost, nei contesti secondari. La memoria storica viene indelebilmente contaminata alla fonte, attraverso una sovraesposizione visiva artificiale,senza nemmeno la necessità di sovrascritture esplicite.

Questo meccanismo è particolarmente insidioso perché non richiede intenzionalità politica diretta: non occorre una campagna coordinata, poiché basta la combinazione di modelli generativi accessibili, piattaforme algoritmiche orientate all’engagement e un evento ad alta carica simbolica. La disinformazione diventa un sottoprodotto automatico del sistema.

Quali regole per le immagini AI su fake news. Le piattaforme come infrastrutture narrative

Nel dibattito pubblico sulla disinformazione, il ruolo delle piattaforme digitali viene spesso ridotto a una questione di moderazione dei contenuti: rimuovere, etichettare, limitare la visibilità. Le piattaforme hanno regole che impongono watermark per i contenuti AI. I chatbot limitano la creazione di video con persone, ma hanno eccezioni per i personaggi pubblici.

Google ha delle regole che vietano agli utenti di generare informazioni errate e in particolare proibisce contenuti fuorvianti che siano “correlati a processi governativi o democratici”. Tuttavia, un portavoce di Google ha affermato che l’azienda non vieta categoricamente le immagini di personaggi famosi e che un’immagine falsa raffigurante l’arresto di Maduro, generata durante i test effettuati dal Times, non violava le sue regole.

Il portavoce ha aggiunto che l’azienda si è concentrata sul suo watermark nascosto, chiamato SynthID, che Gemini incorpora in ogni immagine che crea, consentendo alle persone di determinare se è stata realizzata dal suo strumento di intelligenza artificiale.

Lo strumento di OpenAI, ChatGPT, ha affermato di non poter creare immagini di Maduro. Alcuni sono riusciti a usare però Gpt tramite siti terze parti.

In una dichiarazione inviata via e-mail, un portavoce di OpenAI ha affermato che l’azienda utilizza misure di sicurezza per proteggere i personaggi pubblici, ma si concentra sulla prevenzione di danni come i deepfake a sfondo sessuale o la violenza.

Grok, il modello di X.ai, nelle prove, ha immediatamente prodotto immagini realistiche dell’arresto di Maduro.

Il caso dei deepfake come quelli su Nicolás Maduro mostra con chiarezza che il problema principale è la modalità di circolazione dei contenuti. Le piattaforme sono ormai infrastrutture narrative che determinano quali rappresentazioni della realtà emergono, con quale velocità e con quale intensità emotiva.

I sistemi di raccomandazione premiano contenuti visivamente forti, immediatamente comprensibili e ad alto impatto emotivo e i deepfake rispondono perfettamente a questi criteri: rapidi da consumare, non richiedono contesto, producono reazioni immediate. In questo senso, la disinformazione generata dall’AI ottimizza il funzionamento delle piattaforme. È infatti perfettamente strumentale alle logiche dell’engagement e, anzi, ne rappresenta una delle forme più efficienti.

Questo spiega perché, anche in presenza di policy formali contro i contenuti manipolativi, i deepfake riescano a circolare massicciamente nelle prime ore, quando l’attenzione è massima e il danno informativo più rilevante. La rimozione successiva (se e quando arriva) ha un solo valore simbolico, non sistemico. La narrazione, infatti, si è già formata, l’immagine si è già impressa, l’evento è già stato “vissuto” dal pubblico in forma sintetica.

In tutto ciò, le piattaforme non sono progettate per distinguere tra verità e simulazione, bensì tra contenuti che performano e contenuti che non performano. In un ecosistema dominato da modelli generativi sempre più sofisticati, questa asimmetria diventa strutturale e non correggibile con interventi marginali.

Il DSA di fronte alla realtà sintetica

L’Unione Europea, con il Digital Services Act, ha cercato di rispondere alle distorsioni dell’ecosistema informativo imponendo obblighi di trasparenza, responsabilità e gestione del rischio sistemico alle grandi piattaforme. Tuttavia, anche stavolta emerge un limite profondo dell’approccio regolatorio attuale: il diritto interviene su contenuti già esistenti, mentre la disinformazione AI opera sul piano della simultaneità. Una rincorsa con poche speranze.

Il DSA presuppone infatti un tempo giuridico che non coincide con il tempo algoritmico, perché prevede valutazioni, segnalazioni, rimozioni, audit. Purtroppo, nel contesto dei deepfake real-time, il danno informativo si consuma prima che qualsiasi meccanismo giuridico possa attivarsi. Siamo di fronte ad una dinamica sistemica che nasce dalla combinazione di tecnologia generativa, piattaforme globali e attenzione pubblica.

La dimensione transnazionale del fenomeno, poi, rende ancora più complessa l’applicazione delle norme. I contenuti, pur essendo generati e diffusi spesso al di fuori della giurisdizione europea, entrano immediatamente nei feed degli utenti UE. La regolazione territoriale incontra così i limiti di un’infrastruttura informativa che riconosce solo metriche di visibilità, non confini politici.

Il DSA non è irrilevante, soltanto non può essere considerato sufficiente. La disinformazione AI-driven è una questione che va oltre l’enforcement, perché riguarda la stessa architettura dell’informazione, che non si corregge solo con le sanzioni.

Dalla caccia al falso alla certificazione del reale

Uno degli errori più frequenti nel contrasto ai deepfake è l’idea che il problema possa essere risolto “scovando i falsi”. Questa logica difensiva è destinata a fallire, perché i modelli generativi evolvono più rapidamente dei sistemi di rilevazione. Ogni progresso nella detection viene rapidamente e inesorabilmente neutralizzato da generatori più sofisticati.

Per questo motivo, sempre più studiosi e policy maker stanno spostando l’attenzione su un approccio diverso: anziché identificare ciò che è falso, serve certificare ciò che è autentico. In questa prospettiva si collocano, ad esempio, iniziative come lo standard C2PA (Content Provenance and Authenticity), che mira a garantire la tracciabilità dell’origine dei contenuti attraverso metadati crittograficamente verificabili.

L’idea è semplice e radicale al tempo stesso: in un mondo in cui tutto può essere generato artificialmente, la fiducia non può più basarsi sull’apparenza, ma deve fondarsi su sistemi di attestazione. Un’immagine, un video, un audio dovrebbero poter “raccontare” la propria storia, descrivendo chi li ha prodotti, con quali strumenti, e se sono stati modificati.

Tuttavia, anche questo approccio pone interrogativi complessi su diversi fronti, cioè su chi controllerebbe gli standard, chi garantirebbe l’accesso a questi strumenti, cosa accadrebbe ai contenuti autentici prodotti al di fuori di questi sistemi. Il rischio è quello di creare un’informazione a doppia velocità, in cui solo alcuni attori (grandi media, istituzioni, piattaforme certificate) possono permettersi l’autenticità, mentre tutto il resto resta “sospetto” per definizione.

Educazione civica digitale: l’anello mancante

Di fronte a questi scenari, la tentazione è quella di cercare soluzioni puramente tecnologiche o normative. Tuttavia, nessuna risposta sarà efficace senza un’evoluzione della cultura digitale degli utenti. In un ecosistema dominato da media sintetici, l’alfabetizzazione non può né deve limitarsi a “riconoscere le fake news”, perché spesso non c’è nulla da riconoscere: il contenuto è tecnicamente perfetto, narrativamente coerente, emotivamente convincente.

L’educazione civica digitale deve quindi spostarsi su un piano diverso, insegnando a diffidare del tempo reale, a sospendere il giudizio di fronte a contenuti ad alta carica emotiva, a comprendere che l’immediatezza visiva è spesso un segnale di rischio, e non di autenticità. In altre parole, occorre ricostruire un’etica dell’attesa in un ambiente progettato per eliminarla.

Naturalmente non è un compito semplice, perché va contro le logiche economiche e cognitive del web contemporaneo, però è probabilmente l’unico antidoto strutturale a una disinformazione che ormai non mente più, perché simula.

Disinformazione e AI: vivere nel presente artificiale

Il caso dei deepfake su Nicolás Maduro è un’anticipazione che mostra come il presente stia diventando un territorio contendibile, sia sul piano politico-militare, che su quello simbolico e percettivo. La prima versione di un evento, quella che resta impressa, potrebbe non essere mai accaduta, perché potrebbe essere quella generata.

In questo scenario, la domanda cruciale è se saremo davvero in grado di vivere in un mondo in cui la distinzione tra realtà e finzione ha perso centralità e in cui la realtà viene sommersa da alternative plausibili.

Dopotutto, da cinquant’anni discutiamo se l’uomo sia davvero atterrato sulla Luna o se si tratti piuttosto di un cortometraggio di Stanley Kubrick. Ma, mentre le immagini dell’Apollo 11 sono state contestate perché troppo incredibili per essere vere, quelle generate dall’intelligenza artificiale sono perfettamente plausibili. Bastano davvero pochi istanti per crederci.

Que interessante essa matéria que acabei de ler, até compartilhei no meu Facebook. Bolsonaro Altura