Ci sono delle idee che nascono come pura invenzione letteraria ad opera di uno scrittore visionario, ma che con il passare degli anni iniziano a insinuarsi nel dibattito scientifico, come se attendessero il momento giusto per reclamare un posto nel mondo reale. Un destino come quello seguito da certi film visionari, come “Star Trek”, o “2001 Odissea nello spazio” che hanno anticipato molti degli sviluppi entrati oggi nella nostra quotidianità. Altre invenzioni letterarie, a distanza di anni, hanno conquistato uno spazio concreto nel mondo reale.

La psicostoria, concepita da Isaac Asimov nella saga della Fondazione, nel 1951, quando ancora i primi computer erano all’inizio del loro cammino, è forse l’esempio più interessante di questo fenomeno, alla luce degli attuali sviluppi dei modelli di Intelligenza Artificiale [1]. Chi ha letto quei romanzi ricorderà il protagonista indiscusso dell’opera, Hari Seldon, il matematico capace di combinare statistica, sociologia e storia per prevedere, con grande precisione, il destino dell’intera civiltà umana. Una civiltà immaginata nel racconto come diffusa ormai nell’intera Galassia, con un unico Impero Galattico governato dalla dinastia genetica degli imperatori Clion. Asimov mise in scena un’idea originale e molto attrattiva: la “Psicostoria”, una scienza capace di prevedere il destino di intere civiltà.

Hari Seldon non era un profeta, era un matematico che scommetteva sulla potenza dei grandi numeri: se una popolazione è abbastanza vasta, le azioni dei singoli si compensano, e restano soltanto le leggi statistiche. La sua è una costruzione elegante, resa possibile, nel racconto, da un universo che si comporta come un sistema chiuso, l’impero galattico, senza interferenze esterne. Nel nostro mondo reale, però, le società sono sistemi aperti, attraversati da crisi e retroazioni.

Eppure, nella stagione dei big data e del calcolo ad alte prestazioni, quell’idea non è più solo una suggestione narrativa, frutto della fantasia di uno scrittore visionario, ma ci pone delle domande pratiche: fino a che punto si può progettare un’infrastruttura di conoscenza e di previsione in grado di anticipare linee di sviluppo collettive, per ridurne l’incertezza? E’ possibile trasformare quel sogno letterario in un progetto scientifico vero e proprio?

Indice degli argomenti

Dalla narrativa alla scienza dei sistemi complessi

È qui che la psicostoria cessa di essere un mito e diventa una questione concreta: che cosa servirebbe davvero per progettare un’infrastruttura in grado di anticipare le evoluzioni sociali collettive, senza confondere correlazioni statistiche con un fantomatico “destino”? E quali sono i limiti che dovremmo rispettare per non trasformare la previsione in condizionamento?

La versione “scientifica” della psicostoria, il modo in cui potrebbe essere effettivamente approcciata, riguarda la scienza dei sistemi complessi. La nostra società può essere vista come un intreccio di reti su diversi livelli, reti di individui, organizzazioni e istituzioni, che interagiscono tra loro continuamente, generando comportamenti emergenti non sempre lineari, a volte anche controintuitivi [2].

Questo sguardo sul futuro non promette l’onniscienza: suggerisce piuttosto che, se si mappano bene le connessioni, compito tutt’altro che banale che richiede strumenti molto sofisticati, e se si raccolgono abbastanza dati di qualità, si possono delineare linee di tendenza plausibili. Si possono individuare dei fattori su cui un intervento politico, economico o sociale può avere la massima efficacia. È un passaggio che ci porta dal “destino” alle probabilità, dalla profezia alla diagnosi, e quindi alla pianificazione.

Per fare questo, per passare dalle speculazioni letterarie a una pratica attuazione, occorre utilizzare strumenti complessi, mettendo insieme dati, modelli predittivi e algoritmi in grado di effettuare correlazioni e di delineare futuri scenari operativi.

Entra così in gioco una “psicostoria contemporanea”, figlia dei big data e dei modelli di Intelligenza Artificiale generativa, in grado di tracciare dei percorsi concreti e analizzabili, verificare ipotesi e simularne gli effetti.

I tre pilastri metodologici da costrure

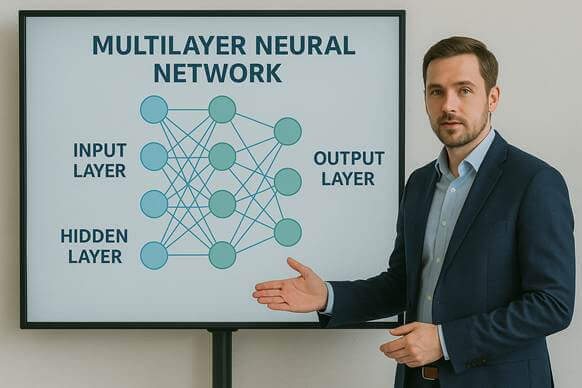

Un tentativo serio di elaborare questa psicostoria attuale dovrebbe fare affidamento su tre pilastri fondamentali. Il primo è l’intelligenza artificiale, intesa come capacità di addestrare modelli predittivi su dati eterogenei, spesso rumorosi, riconoscendo dei pattern che sfuggono all’occhio umano. E’ quello che si fa nei sistemi progettati per la “clusterizzazione”, in cui vengono individuati raggruppamenti e correlazioni che altrimenti resterebbero inosservati. E’ un lavoro che oggi si può fare.

Il secondo è la sociologia computazionale, che traduce le ipotesi su norme, incentivi, spinte sociali e coordinamento, in modelli matematici applicabili e verificabili. In questo modo diventa possibile collegare i comportamenti dei singoli con i più ampi fenomeni collettivi, facendo emergere delle linee evolutive che a prima vista sembrerebbero inspiegabili.

Il terzo pilastro è l’inferenza causale, l’elemento che consente di passare dalla mera correlazione alla risposta operativa alla domanda “cosa succede se interveniamo su questo aspetto?”, “quali effetti produrrà questa decisione sui comportamenti generali?”

Senza una nozione rigorosa di causalità, e una previsione dei possibili effetti, le elaborazioni delle tendenze restano unicamente descrizioni di modelli del passato, ma non possono essere considerate delle guide attendibili per il futuro [3].

Se i modelli sono indispensabili, lo sono ancora di più i dati su cui vengono addestrati, e che guideranno le previsioni future, su dati nuovi e inediti. Perché è sulla qualità di questi dati, e sulla loro coerenza, che si baseranno le predizioni di questi nuovi sistemi, e le conseguenze di bias e di errori potrebbero facilmente compromettere l’affidabilità delle previsioni.

Il lavoro di engineering sui dati non è quindi un aspetto meramente tecnico, ma è la fase preliminare che determinerà l’affidabilità dell’intero sistema durante il suo funzionamento.

I dati: dalla raccolta alla governance

Nella psicostoria romanzesca di Asimov i dati sono impliciti, si davano semplicemente per scontati, non se ne parlava affatto. Nella realtà, invece, costituiscono il punto di partenza per qualunque sistema predittivo, senza dati nessuna “Psicostoria” è possibile.

I dati vanno cercati, ripuliti da rumore e bias, documentati e protetti. Servono serie storiche economiche e demografiche, tracciati di mobilità, indicatori sanitari, misure climatiche e ambientali, cronologie di eventi politici e sociali, fino all’acquisizione di flussi generati da media, ricercatori, social networks e piattaforme digitali.

La vera sfida non è sulla quantità, oggi ampiamente disponibile da una molteplicità di fonti, ma la qualità e la compatibilità rispetto ai contesti che si vogliono prevedere. Ci troviamo di fronte a formati difformi, granularità non allineate, bias di selezione, periodi storici mancanti, inattendibilità di certe fonti.

È qui che una psicostoria, a livello di paese o di Unione Europea, dovrebbe ereditare le metodologie della statistica ufficiale e dell’open government data, con le pipeline di normalizzazione, i cataloghi di metadati, la tracciabilità delle trasformazioni e con controlli e supervisioni sulla qualità.

L’esperienza in Italia dell’ISTAT, in grado di fare dialogare fonti amministrative, censuarie e campionarie diverse, fornisce un modello concreto di armonizzazione, a livello nazionale, da confrontare e mettere a fattor comune con gli omologhi istituti statistici europei allargandone l’ambito, e comprendendo lo scenario più ampio dell’Unione Europea [4].

Allo stesso tempo, la Strategia Italiana sull’IA, pubblicata nel luglio 2024, indica un percorso di governance che non deve rimanere sulla carta se vogliamo ridurre la distanza tra conoscenza pubblica e decisione [5].

Il quadro normativo di riferimento è sicuramente quello dell’ AI Act (UE 2024/1689) [6], e la nuova legge italiana sull’Intelligenza Artificiale approvata il 17 settembre 2025, che ne attualizza l’uso in Italia e chiarisce i compiti di vigilanza e guida, affidati all’ ACN e all’ AGID, portando quindi la regolamentazione su un terreno di attuazione quotidiana.

A partire dai dati occorre poi sviluppare dei modelli capaci di generare previsioni affidabili e concretamente utilizzabili.

Modelli predittivi in profondità: i modelli neurali

Sul piano algoritmico non esiste nessuna “Formula di Seldon”. Esistono diverse famiglie di modelli, ciascuna con propri punti di forza e limiti.

Le reti LSTM (Long Short-Term Memory), nate per superare la perdita d’informazione nelle sequenze lunghe, sono adatte a modellare le serie storiche economiche, energetiche o epidemiologiche, perché hanno la caratteristica di memorizzare e dimenticare in modo controllato, grazie ai loro meccanismi di controllo a “gates”, riuscendo a catturare le stagionalità e i cicli nascosti, anche su ampi orizzonti temporali [7].

I Temporal Fusion Transformers (TFT) hanno portato l’uso dell’ “Attention” a maturità anche nel campo delle serie temporali multivariate. Sono in grado di selezionare, tra centinaia di variabili, quelle più rilevanti in ogni finestra di contesto, e forniscono previsioni simultanee basate su orizzonti temporali diversi: a breve, medio e lungo termine.

Questi modelli combinano reti ricorrenti (RNN, ma in particolare LSTM o GRU) con i meccanismi di Attention, così da catturare sia le dipendenze sequenziali sia le relazioni tra variabili eterogenee su “finestre” molto ampie di contesto.

A differenza di un LLM come GPT, che predice il prossimo token in una sequenza di testo, i TFT generano intere traiettorie temporali. Lo fanno corredando le stime con intervalli di probabilità espliciti, una caratteristica di trasparenza indispensabile quando le previsioni devono supportare decisioni pubbliche che possono incidere direttamente sulla vita delle persone [8].

Quando invece il fenomeno da esaminare è intrinsecamente reticolare, basti pensare alla diffusione di informazioni sui media, ai post sui social, a catene logistiche integrate o a interdipendenze energetiche, anche transnazionali, allora la modellazione più naturale passa per le rappresentazioni a grafo, e ai modelli neurali specializzati, come le Graph Convolutional Networks (GCN). Queste reti neurali basate su grafi apprendono non solo dai nodi, ma anche dalla struttura delle connessioni che intercorrono tra di loro, mettendo in luce relazioni che altrimenti rimarrebbero non visibili.

In un’architettura psicostorica i diversi modelli non competono ma convivono: si confrontano e si integrano, validandosi a vicenda, andando a comporre i diversi aspetti dell’analisi psicostorica. Questi modelli devono essere gestiti come componenti critiche, con versionamento, monitoraggio del ciclo di vita, con accountability e audit indipendenti da parte di organismi terzi.

Simulare le società: scenari di “what-if” con agenti intelligenti

Là dove la statistica si ferma, iniziano le simulazioni sugli scenari. I modelli basati su agenti e su reti neurali (Agent-Based Models) costruiscono popolazioni artificiali di cittadini, imprese, istituzioni, ne definiscono regole credibili di decisione e di interazione.

Il sistema viene poi lasciato evolvere e si osservano i risultati: sono dei “digital twins”, gemelli digitali di interi ecosistemi sociali in evoluzione controllata, che esplorano diversi scenari evolutivi, anche i più improbabili. E ne possono emergere delle sorprese: soglie di coordinamento inaspettate, disordini, innovazioni che si diffondono o si esauriscono, condizionamenti prima ignoti che si palesano nelle simulazioni.

L’utilità è duplice: si possono testare politiche simulate, e si può capire se un risultato dipende da un presupposto debole, del tutto errato, oppure dalla mancanza di ulteriori dati.

L’approccio è già in uso in molti ambiti: dalle Smart Cities alla pianificazione urbana, dalla risposta alle crisi alle dinamiche energetiche, fino ai processi legati all’adozione di nuove tecnologie [9].

In Italia, l’ENEA lo applica alla transizione energetica e ambientale, integrando input fisici, economici e sociali per misurare cambiamenti e tempi di attuazione: rappresenta un esempio concreto di laboratorio nazionale di simulazione, che potrebbe essere esteso a molti altri settori oltre all’energia e all’ambiente [10].

Dalla correlazione all’azione: l’inferenza causale

Ogni volta che osserviamo due fenomeni che si evolvono insieme, la tentazione è sempre la stessa: pensare che uno dei due influenzi o determini l’altro. È una scorciatoia mentale classica, usata inconsciamente per semplificare la realtà, che può portare a intuizioni geniali, ma anche a errori colossali. L’inferenza causale nasce proprio per evitare queste trappole, mettendo ordine in un territorio dove le apparenze spesso ingannano.

In una psicostoria, la differenza tra correlazione e causalità non è un dettaglio tecnico: è la linea che separa una previsione utile da una possibile illusione. Sapere che due variabili si muovono insieme è interessante: sapere perché lo fanno, e cosa succederebbe se intervenissimo, sull’una piuttosto che sull’altra, è tutt’altra cosa. La moderna inferenza causale ci offre strumenti rigorosi per fare questo salto concettuale. In sostanza, significa disegnare mappe delle possibili relazioni e applicare regole che ci dicono se un legame è davvero causale o se è solo un’illusione statistica, dovuta cioè al caso.

Può sembrare linguaggio tecnico, da specialisti, ma la sostanza è molto semplice: si tratta di capire non solo “cosa è successo finora”, ma “cosa succederebbe se cambiassimo qualcosa”. In altre parole, non limitarsi a descrivere un modello del mondo, ma metterlo alla prova, almeno nella simulazione, ovviamente.

E qui il legame con la psicostoria diventa evidente: se vogliamo usare i modelli per guidare decisioni pubbliche, dobbiamo poter rispondere a domande come “Se aumentiamo un certo incentivo, che effetto avrà sulla coesione sociale?” oppure “Se introduciamo una nuova tecnologia, quali settori economici ne saranno più colpiti?”, o ancora “Se imponiamo dei nuovi dazi, come varierà la geopolitica mondiale?”. Senza questo passaggio, il rischio è quello di produrre dei modelli bellissimi e affascinanti, che però sanno solo raccontarci scenari passati, riformulare esperienze già vissute, ripetendo quindi schemi già noti.

C’è poi il tema dei “counterfactuals”, i famosi “what-if”, “cosa sarebbe successo se…”. Sono degli scenari ipotetici, che non possiamo osservare nella realtà, ma che possiamo esplorare, con modelli causali ben progettati e realizzati. Immaginiamo di poter valutare l’effetto di una politica sanitaria, confrontando uno scenario in cui è stata introdotta una certa misura antiepidemica, con un altro scenario in cui non lo è stata, e esaminare le differenze in modo misurabile, confrontando diversi livelli di parametri: questo è il cuore dell’ inferenza causale. E’ un approccio reso sistematico dal lavoro di Judea Pearl, che ha introdotto il “do-calculus”, un linguaggio matematico che trasforma le correlazioni osservate in ipotesi causali da verificare, insieme a una teoria rigorosa dei controfattuali [11] .

In sintesi, senza causalità, la psicostoria sarebbe poco più di una cronaca statistica del mondo. Con la causalità, invece, diventa uno strumento operativo, capace di suggerire azioni concrete e di stimarne gli effetti, con la consapevolezza dei limiti e delle incertezze che ogni previsione inevitabilmente comporta.

Architettura e flussi di una piattaforma psicostorica

La struttura operativa della psicostoria può essere immaginata come composta da più strati, una architettura digitale fatta di componenti interconnesse.

Alla base è presente un’infrastruttura di acquisizione di enormi moli di dati, che elabora flussi eterogenei di informazioni come archivi storici, stream dai media, osservazioni da sensori e satelliti, dati amministrativi, e molto altro ancora, garantendo conformità legale e aderenza ai principi etici e di sicurezza.

Il livello successivo è costituito da un sistema di gestione dei dati ad alte prestazioni, che custodisce i dataset già pre-elaborati in formati efficienti, con i loro cataloghi e metadati, e con una completa tracciabilità e auditabilità. Le pipeline di trasformazione adottate in fase di acquisizione normalizzano, anonimizzano e documentano gli archivi. Un catalogo di variabili pre-elaborate e coerenti permette poi di riutilizzare dati già “puliti”, sia per fasi successive di addestramento sia per le inferenze sulle verifiche di ipotesi.

Un motore predittivo raccoglie e utilizza diversi modelli, che vengono gestiti e aggiornati in modo controllato, così da garantirne affidabilità, robustezza ed equità. Per evitare errori, il sistema deve prevedere delle soglie di allarme, che segnalano quando le condizioni reali cambiano e i modelli rischiano di perdere accuratezza, un fenomeno noto come “drift” (deriva del modello). Questo richiede un monitoraggio costante del livello di aggiornamento dei flussi di dati che vengono trattati.

Accanto a questo, un simulatore ad agenti permette di costruire gli scenari “what-if” : cosa succederebbe se introducessimo una nuova politica economica, o introducessimo una nuova legge sull’ordine pubblico. Il simulatore utilizza i risultati dei modelli, integrandoli con i vincoli di dominio, ma anche con la supervisione degli esperti, per restituire scenari realistici e confrontabili, anche su percorsi evolutivi diversi.

Infine, una console interattiva di analisi rende trasparenti e facilmente leggibili i risultati: mostra le previsioni, i margini di incertezza, i presupposti utilizzati, e mantiene traccia di tutte le operazioni fatte (auditabilità), rendendo i risultati accessibili e verificabili dai decisori pubblici, dalle autorità di controllo e anche dai cittadini.

Per reggere questa architettura servono naturalmente sistemi di calcolo ad alte prestazioni (HPC) e, idealmente, occorrerebbe mantenere la sovranità tecnologica, proteggere i dati sensibili.

In Europa il programma Destination Earth, che costruisce gemelli digitali del pianeta per simulazioni climatiche e ambientali, è un precedente tecnico e istituzionale importante, anche per le sue scelte di armonizzazione e di governance [12].

In Italia, il supercomputer Leonardo del CINECA, nodo Euro-HPC, offre la potenza di calcolo necessaria per addestrare questo tipo di modelli su vasta scala, per simulazioni molto impegnative, e potrebbe diventare uno dei pilastri computazionali di un progetto psicostorico a livello europeo [13].

Casi già operativi in Italia ed Europa

Chi pensa che tutto questo appartenga ancora alla fantascienza, o a un lontanissimo futuro, dovrebbe guardare a ciò che già esiste nella realtà. L’IPCC (Intergovernmental Panel on Climate Change) integra da anni osservazioni e modelli fisici con ipotesi socioeconomiche, producendo scenari che si sviluppano nell’arco di decenni. Questi rapporti sono diventati un punto di riferimento per i governi e i mercati: non è psicostoria, ma rappresenta comunque il più solido esperimento di previsione integrata su scala planetaria [14].

Un altro esempio è il Global Burden of Disease, coordinato dall’Institute for Health Metrics and Evaluation, che integra dati epidemiologici e demografici, producendo scenari diversi sulla salute globale, usati sia dall’OMS che dai governi, come riferimento per le politiche sanitarie [15].

Allo stesso modo, il World Climate Research Programme coordina centinaia di modelli climatici globali (CMIP), costituendo la base scientifica dei rapporti IPCC.

Anche iniziative come Our World in Data, che raccoglie e rende comparabili dati su economia, salute e società, insieme agli scenari economici e sociali elaborati da OECD e World Bank, mostrano come la modellistica predittiva sia già parte integrante della governance globale [16].

Persino esperimenti ormai storici, come Google Flu Trends, hanno dimostrato i punti di forza e i rischi dell’uso dei big data nel fare previsioni su fenomeni sociali complessi.

Il progetto GDELT (Global Database of Events, Language, and Tone) raccoglie e analizza notizie da tutto il mondo in oltre cento lingue, trasformandole in un archivio strutturato di eventi, attori e narrazioni. Ogni evento è tradotto in un grafo interrogabile, che descrive chi sono gli attori coinvolti, quale azione è avvenuta, contro chi, in quale luogo e con quale tono narrativo. Questo consente di monitorare in tempo quasi reale conflitti, disinformazione, migrazioni o crisi umanitarie, permettendo di sviluppare sistemi di allerta precoce e di individuare nuove tendenze. Un tassello fondamentale verso una possibile futura “storia computabile” [17].

In Europa, Destination Earth sta realizzando un “gemello digitale” del pianeta, combinando i dati del programma Copernicus (il programma europeo di osservazione della Terra, promosso dalla Commissione Europea in collaborazione con l’Agenzia Spaziale Europea) con modelli numerici avanzati: una possibile componente, tecnica e istituzionale, per le future piattaforme predittive multilivello.

In Italia, oltre alla potenza computazionale di Leonardo, operano quotidianamente istituzioni come ISTAT, che integra basi dati diverse con metodologie di qualità a supporto delle politiche pubbliche, ed ENEA, che utilizza scenari e simulazioni per misurare costi, benefici e tempi della transizione energetica.

Sia in Italia che in Europa, riviste e osservatori come Agenda Digitale [18], Forum PA o gli Osservatori del Politecnico di Milano, insieme a istituzioni come il Centro Europeo per la Trasparenza Algoritmica (ECAT), hanno contribuito a costituire uno spazio stabile di confronto tra comunità tecnica, giuridica e politica sui temi dell’intelligenza artificiale, dei dati e della governance.

Costi, capacità e potenziali protagonisti

Immaginare una piattaforma psicostorica significa confrontarsi con una scala di investimenti che va ben oltre i progetti di digitalizzazione tradizionali. Non si tratta di un software da sviluppare e distribuire, ma di una vera e propria infrastruttura scientifica strategica, paragonabile a progetti come i grandi acceleratori di particelle, il CERN di Ginevra, o ai programmi spaziali come la Stazione Spaziale Internazionale (ISS). L’ordine di grandezza è quello dei miliardi di euro, distribuiti su più anni e su più centri di competenza internazionali.

Costi diretti e infrastrutturali

I costi diretti riguardano innanzitutto l’hardware ad alte prestazioni: supercluster di GPU e TPU, sistemi di archiviazione ad alta velocità in grado di gestire petabyte di dati, reti a bassissima latenza e sistemi di raffreddamento e alimentazione ridondanti. Per dare un riferimento, l’addestramento di un modello LLM di fascia alta come GPT-4 ha richiesto migliaia di GPU Nvidia-A100 per settimane, con un costo stimato in decine di milioni di dollari, solo per calcolo ed energia [19].

Una psicostoria, che combinasse modelli linguistici, predittivi temporali, analisi di rete e simulazioni neurali, richiederebbe capacità di calcolo di gran lunga superiori, probabilmente comparabili a quelle dei supercomputer più potenti al mondo [20].

Costi indiretti e operativi

A questi costi infrastrutturali si sommano le spese di manutenzione, licenze, sicurezza informatica, aggiornamento periodico dei modelli e governance dei dati.

Ogni modifica normativa, ad esempio in materie di privacy o di interoperabilità, può imporre modifiche onerose, sia all’architettura sia alle procedure operative. Il mantenimento della qualità predittiva richiede un monitoraggio continuo, per individuare i fenomeni di cambiamento nei dati (drift) e intercettare bias emergenti.

Capitale umano e competenze rare

Non meno rilevante è il capitale umano: servono data scientist, esperti di dominio, ingegneri dedicati alla manutenzione e all’aggiornamento dei modelli, sociologi computazionali, esperti di sicurezza e giuristi specializzati in AI Act e data governance. Figure professionali rare, difficili da attrarre e da trattenere, in un mercato del lavoro altamente competitivo dove le big tech offrono condizioni difficilmente eguagliabili.

Ruolo dei privati

Sul piano tecnico, colossi come OpenAI, Google DeepMind, Meta o Microsoft dispongono già della potenza di calcolo, dei gruppi interdisciplinari e delle infrastrutture necessarie per avviare un progetto psicostorico. Ma la questione non è solo tecnica: l’accesso a dati socioeconomici, sanitari e demografici su larga scala, può realizzarsi solo tramite accordi con governi e organismi internazionali [21].

A causa degli investimenti necessari, il ruolo dei governi e i sostegni pubblici sono fondamentali, vista l’entità dei valori in gioco, anche in considerazione del rischio di concentrazione del potere predittivo in mani private, che renderebbe il progetto politicamente e socialmente a rischio, o addirittura inaccettabile senza una governance trasparente e una forte supervisione pubblica.

Confronto internazionale

Progetti di scala paragonabile alla “Psicostoria” già esistono: il programma europeo Destination Earth ha un budget di circa 1,2 miliardi di euro, mentre il supercomputer statunitense Frontier ha richiesto investimenti per centinaia di milioni di dollari.

Una psicostoria operativa, per essere competitiva e autonoma, avrebbe bisogno di cifre simili, soprattutto se l’obiettivo è quello di mantenere la sovranità tecnologica ed evitare dipendenza da infrastrutture estere.

In sintesi, il vero costo di una psicostoria non si misura solo in termini economici, ma implica la capacità di creare e mantenere un’infrastruttura di previsione affidabile, eticamente controllata e sostenibile nell’arco di decenni.

E’ un impegno che nessuna entità, pubblica o privata, può affrontare isolatamente senza rischiare squilibri di potere o fragilità di tipo strategico.

Per questi motivi, e a fronte di tali impegni, un progetto di psicostoria potrebbe nascere solo nell’ambito di una partnership pubblico-privata, che coinvolga dei governi rappresentati in seno ad un’organizzazione internazionale, come le Nazioni Unite o l’Unione Europea, e alcuni tra i principali attori industriali e tecnologici del settore.

Regole, rischi e potere: la governance

Ogni volta che concentriamo capacità predittive in poche mani, stiamo concentrando anche del potere. E il potere, da che mondo è mondo, non è mai neutrale. Può essere usato per proteggere e migliorare la vita delle persone ma può anche diventare uno strumento di controllo o di manipolazione.

È per questo che, quando si parla di “Psicostoria”, la questione della governance non è un dettaglio burocratico: è la sostanza stessa del progetto.

Il Regolamento europeo sull’Intelligenza Artificiale (AI Act UE 2024/1689) ha sancito un principio fondamentale: non tutta l’AI è uguale ma ci sono livelli di rischio diversificati da gestire, che prevedono obblighi di trasparenza e meccanismi di verifica.

In un contesto psicostorico, questo significa che ogni modulo, ogni dataset, ogni algoritmo dovrebbe essere messo sotto esame costantemente, durante tutta la vita del progetto. Non solo per ragioni tecniche e normative, ma per garantire legittimità e fiducia pubblica rispetto alle previsioni e alle analisi che il sistema produce.

Sul piano nazionale, la Strategia Italiana per l’IA ha indicato strumenti concreti per assicurare trasparenza, come i registri dei dataset e dei modelli, il riuso e l’auditabilità delle soluzioni, l’obbligo di documentare le scelte tecniche. Sono linee guida molto importanti, ma da sole non bastano di certo.

Servono procedure concrete e poteri reali, come la possibilità di sospendere l’uso di un modello se supera soglie di rischio definite, o se mostra comportamenti distorti, o presenta gravi bias nell’uso.

Il punto è che le regole non devono restare sulla carta. Devono diventare verificabili sul piano tecnico, con strumenti come privacy by design e security by design e con la pubblicazione periodica di impact assessment. In fase di addestramento deve essere adottato il “federated learning”, una tecnica che permette di addestrare modelli condivisi senza spostare i dati dal loro luogo d’origine, condividendo solo i parametri del modello risultanti dall’addestramento.

E devono, inoltre, esserci degli spazi di denuncia protetta, perché se in un sistema complesso gli allarmi spesso arrivano da chi ci lavora dentro, ma arrivano a volte anche da ricercatori esterni, o anche da chi rileva vulnerabilità non note nel sistema.

C’è poi un aspetto particolarmente delicato: una psicostoria, per essere utile, ha bisogno di dati sensibili, magari anche di informazioni in tempo quasi reale su economia, salute, mobilità, opinione pubblica. Gestire questi dati senza mettere a rischio diritti fondamentali delle persone richiede una governance trasparente e a più livelli, dove cittadini, autorità indipendenti e comunità scientifica possano controllare, o anche contestare, le scelte.

Il complesso delle normative da rispettare e gli strumenti di controllo da sviluppare devono essere efficaci, per garantire la tutela della privacy e dei principi etici. Ma occorre anche assicurare la sicurezza e la protezione delle informazioni, con una politica di difesa in profondità (defence in depth) dei vari sistemi: infrastrutture, reti di comunicazione, dati, personale [22].

In altre parole: la governance di una psicostoria non può essere un aspetto secondario rispetto alle problematiche tecnologiche, pur rilevanti. È il telaio che tiene insieme la macchina. Senza un sistema di regole chiaro, verificabile e capace di fermare l’intero meccanismo in caso di abuso o errore, il rischio è che uno strumento nato per orientare le società verso il bene comune possa trasformarsi in un apparato di sorveglianza o manipolazione.

I limiti intrinseci: il “cigno nero” e il caso

Per quanto possiamo pensare di poter prevedere tutto, esiste sempre qualcosa che ci sfugge. È la natura stessa della realtà: complessa, dinamica, attraversata da forze che spesso non conosciamo, o che sottovalutiamo. E inoltre, c’è un aspetto che siamo portati a sottovalutare, perché non ci piace, e non riusciamo a controllarlo: il caso.

Un sistema predittivo, anche il più sofisticato, può stimare tendenze e calcolare delle probabilità, ma non potrà mai annullare l’imprevisto.

Gli eventi rari e ad alto impatto, quelli che Nassim Nicholas Taleb ha chiamato “Cigni Neri” [23] sono, per definizione, fuori dalla portata di ogni previsione. Una guerra scoppiata in un paese periferico, una pandemia causata da un nuovo virus, un’invenzione tecnologica che cambia improvvisamente le regole del gioco, come successo in passato: tutto questo può ribaltare scenari calcolati con cura e con grande impiego di risorse.

La psicostoria di Asimov aveva un trucco narrativo per aggirare il problema: le “Crisi di Seldon” erano già previste, integrate nel modello, come se il futuro fosse un percorso inevitabile, punteggiato da tappe obbligate. Eppure, anche nella psicostoria di Hari Seldon, venne fuori una figura inaspettata, un Cigno Nero, “Il Mulo”. Asimov introdusse questo protagonista negativo per dare un senso di veridicità alla storia, altrimenti troppo fantasiosa secondo i punti di vista del 1951.

Nel mondo reale, però, non abbiamo copioni prestabiliti. Possiamo solo definire il campo in cui i nostri modelli funzionano bene e riconoscere quando stiamo uscendo da quei confini, per entrare quindi in “terra incognita”. Questo richiede una grande onestà intellettuale. Significa dichiarare apertamente: “oltre questo punto le nostre previsioni diventano fragili” oppure “questo evento non era previsto, e cambia le condizioni di partenza”. Non è un’ammissione di fallimento, ma un atto di responsabilità, per rivedere e aggiornare i modelli.

C’è poi un altro limite, meno evidente ma altrettanto importante: i modelli non vivono in un mondo neutro. Le loro previsioni possono influenzare il comportamento delle persone, e quel cambiamento può a sua volta alterare il futuro che si voleva stimare. È il paradosso dell’osservatore applicato alle società umane: quando sai che qualcuno ti sta “prevedendo”, potresti agire diversamente. Sarebbe un po’, metaforicamente, come avviene in Meccanica Quantistica con il famoso “paradosso di Schrödinger”, che ci indica come l’osservatore non sia neutrale, e influisca sullo stato del sistema osservato, modificandolo. Naturalmente si tratta solo di una metafora, da non prendersi alla lettera, ma che rende bene l’idea: anche nelle società l’atto di osservare e prevedere le tendenze può modificare i comportamenti.

Una psicostoria realistica deve essere progettata come uno strumento flessibile, capace di aggiornarsi continuamente, di incorporare nuove informazioni e di ricalibrare le ipotesi formulate. Deve accettare che l’incertezza non scomparirà mai del tutto, e che proprio in questa incertezza si nasconde la libertà delle società di reinventarsi, in bene o anche nel male.

In fondo, la vera forza di un sistema predittivo non sta nel dire esattamente cosa succederà, ma nell’aiutare a riconoscere quando le condizioni degli assunti stanno cambiando. E a quel punto, permetterci di reagire prima che sia troppo tardi per intervenire. Un sistema di previsione, insomma, per monitorare il cammino e introdurre per tempo degli elementi correttivi.

Per inciso, il fascino del racconto di Asimov, che ha poi dato origine al titolo della sua saga, è stato quello di prevedere la creazione di una “Fondazione” con fini di controllo e monitoraggio del progetto (anzi, addirittura due “fondazioni”, una che controllava l’altra). Ma questa è letteratura.

Un’opportunità culturale, non solo tecnica

Un progetto di questa portata non sarebbe allora solo una sfida tecnologica, ma un’occasione per ripensare il nostro rapporto con la conoscenza e con il futuro. Significherebbe introdurre nel dibattito pubblico un’abitudine alla valutazione probabilistica, all’analisi dei dati in prospettiva storica, e alla comprensione delle dinamiche di lungo periodo. In altre parole, un antidoto contro il “presentismo” che spesso condiziona sia la politica che l’economia, dove le decisioni vengono prese spesso sull’onda dell’emergenza, senza una visione d’insieme, e senza prospettive di lungo termine.

Pensiamo alla recente pandemia da Covid-19: la diffusione di dati epidemiologici assume un significato diverso se interpretata alla luce di scenari simulati: non più un semplice bollettino giornaliero, ma un racconto coerente che spiega le possibili traiettorie, le soglie critiche, le conseguenze delle scelte [24].

O anche a come, di fronte a una crisi energetica, un modello predittivo possa mostrare non solo il prezzo previsto del gas, ma anche gli effetti a catena sulle filiere industriali, sui consumi domestici, sulla stabilità sociale, e sugli equilibri geopolitici.

Per arrivare a questo, serve però una popolazione in grado di interpretare queste informazioni. E, soprattutto, occorrerebbe anche avere dei decisori pubblici che imparino a lavorare sui dati, non guardando solo al presente, o alle prossime elezioni, ma in una prospettiva di lungo periodo, per il bene delle comunità da loro amministrate.

La “Psicostoria” moderna richiederebbe perciò anche dei programmi educativi mirati, dalla scuola all’università, fino alla formazione continua dei decisori politici e degli amministratori pubblici.

Non certo per trasformare tutti in data scientist, ma per fornire strumenti di lettura critica, di comprensione delle incertezze, di analisi approfondita dei dati e delle tendenze, ed anche, alla fine, il riconoscimento dei limiti intrinseci dei modelli. Se è vero che i dati sono “il petrolio” delle società moderne, bisogna allora abituarsi a valutarli nella loro giusta dimensione e utilità.

Infine, c’è un aspetto di responsabilità collettiva: bisogna comprendere che le previsioni non sono sentenze, ma ipotesi, e che vivono della qualità dei dati che si raccolgono e della correttezza delle ipotesi di partenza.

Questa consapevolezza può diventare una forma di maturità democratica, in cui i cittadini partecipano, non solo come destinatari delle decisioni, ma come interlocutori informati, capaci di interrogare e mettere in discussione le basi delle politiche pubbliche e i comportamenti collettivi. Non si tratta di una semplice “democrazia dal basso” ma della consapevolezza che la conoscenza e i dati, se ben usati, possono mettere tutti in condizioni di incidere realmente sulle scelte.

Conclusione: costruire strumenti, non oracoli

Non avremo mai la psicostoria di Hari Seldon, e questo, molto probabilmente, è un bene. Una previsione perfetta congelerebbe infatti la nostra libertà, trasformando la politica e la società in un esercizio di esecuzione di un copione già scritto, ammesso che ciò fosse davvero possibile. La vera sfida non è quella di eliminare l’incertezza, ma imparare a conviverci, riducendola quando possibile, e rendendola comprensibile quando non lo è, per dotarci di strumenti di intervento e di controllo.

La psicostoria che possiamo realisticamente pensare di progettare oggi non è un insieme di equazioni o un oracolo da consultare, ma un ecosistema fatto di varie componenti: modelli predittivi che stimano le tendenze, simulazioni che esplorano scenari alternativi, sistemi di monitoraggio capaci di captare i segnali deboli di cambiamento, altrimenti non percepibili. È una conoscenza che non impone un futuro, ma cerca di interpretarlo alla luce delle tendenze in atto e dei dati disponibili, mettendo a fuoco fragilità e possibilità di intervento, offrendo ai decisori politici, economici e sociali, oltre che alle popolazioni civili, l’opportunità di agire prima che certi eventi diventino inevitabili. Questa psicostoria è per sua natura collettiva: non può essere costruita da un singolo laboratorio o da una singola nazione, ma richiede la convergenza di competenze, dati e visioni politiche. Richiede una governance che protegga il bene comune, eviti concentrazioni di potere poco chiare e renda trasparenti metodi, limiti e presupposti. Senza questo presidio democratico, qualunque infrastruttura predittiva rischia di diventare un meccanismo di sorveglianza o manipolazione.

Un punto decisivo è proprio questo: dall’istituzione di organismi di controllo internazionale dipenderà la possibilità di realizzare concretamente un progetto del genere. C’è poi un elemento che spesso sfugge nel dibattito: la “Psicostoria”, se ben progettata, è anche un esercizio di responsabilità etica e politica. Ogni previsione è una scelta su cosa misurare, su quali dati includere o escludere, su quali modelli privilegiare. Dietro a ogni parametro c’è un’ipotesi di mondo e di sviluppo. Dichiarare queste ipotesi, metterle alla prova e permettere a chiunque di conoscerle, o anche di contestarle, è ciò che separa la scienza dalla propaganda, la democrazia dal controllo. Se pensaste che questo progetto possa apparire come un’utopia, in particolare nelle condizioni geopolitiche del nostro tempo, avreste qualche motivo. Tuttavia, il fatto stesso che oggi un progetto del genere risulti possibile, introduce un elemento di riflessione che va oltre le difficoltà attuali, e guarda al futuro di tutti noi.

In ultima analisi, la lezione di Asimov non è tanto che il futuro sia prevedibile, ma che la conoscenza, se ben usata, può guidare le società attraverso le inevitabili crisi: climatiche, economiche, politiche e sociali. Non possiamo pensare di prevedere la “rotta esatta” per i prossimi anni, o i prossimi secoli, ma possiamo progettare una strumentazione composta da modelli evolutivi complessi, analizzando i quali potremmo rendere il nostro cammino meno incerto. Non per tracciare il nostro destino, ma per moltiplicare le nostre possibilità di orientarlo.

Bibliografia

[1] Asimov, I. (1951-1993). Fondazione, il ciclo completo. Mondadori 2020 – Fondazione (romanzo) – Wikipedia

[2] Mitchell, M. (2009). Complexity: A Guided Tour. Oxford University Press – Complexity A Guided Tour | Oxford Academic

[3] Pearl, J., & Mackenzie, D. (2018). The Book of Why: The New Science of Cause and Effect. Basic Books – Pearl, Judea and Mackenzie, Dana: The book of why: the new science of cause and effect (2018) | AI & SOCIETY

[4] ISTAT. Rapporto annuale. Istituto Nazionale di Statistica – Rapporto annuale 2024 – La situazione del Paese – Istat

[5] AgID. Agenzia per l’Italia Digitale & Dipartimento per la Trasformazione Digitale (2024). Strategia italiana per l’Intelligenza Artificiale 2024–2026 – Strategia_italiana_per_l_Intelligenza_artificiale_2024-2026.pdf

[6] Parlamento Europeo e Consiglio dell’Unione Europea. (2024). AI Act. – L_202401689IT.000101.fmx.xml

[7] Hochreiter, S., & Schmidhuber, J. (1997). “Long Short-Term Memory”. Neural Computation, 9(8), 1735-1780 – Long short-term memory.

[8] Lim, B., et al. (2021). “Temporal Fusion Transformers for Interpretable Multi-horizon Time Series Forecasting”. International Journal of Forecasting – [1912.09363] Temporal Fusion Transformers for Interpretable Multi-horizon Time Series Forecasting

[9] Macal, C., & North, M. (2010). “Tutorial on Agent-Based Modelling and Simulation”. Journal of Simulation, 4(3), 151–162 – (PDF) Tutorial on agent-based modelling and simulation

[10] ENEA (2023). Rapporto Annuale sull’Efficienza Energetica 2023 (RAEE) – Rapporto Annuale sull’Efficienza Energetica 2023 – ENEA – Dipartimento Unità per l’efficienza energetica

[11] Judea Pearl (2009). Casuality. Cambridge University Press – CAUSALITY, 2nd Edition, 2009

[12] European Commission. (2023). Destination Earth Programme – Destinazione Terra (DestinE) – modello digitale della terra | Plasmare il futuro digitale dell’Europa

[13] CINECA / EuroHPC (2023). Pagina ufficiale sul supercomputer Leonardo (EuroHPC node) – About | Leonardo Pre-exascale Supercomputer

[14] IPCC. (2023). Sixth Assessment Report. Intergovernmental Panel on Climate Change – Sixth Assessment Report — IPCC

[15] Global Burden of Disease (GBD) – Global Burden of Disease (GBD)

[16] Our World in Data – Our World in Data

[17] Leetaru, K. (2013). The GDELT Project – The GDELT Project

[18] Agenda Digitale. (2023). “AI, cloud e sovranità dei dati nella PA” – Dalla carta al cloud: come l’AI può salvare la PA italiana – Agenda Digitale

[19] OpenAI (2023). GPT‑4 Technical Report – gpt-4.pdf

[20] Top500.org. (2024). “Top 500 Supercomputer Rankings” – Home – | TOP500

[21] Gama, J. et al. (2014). A Survey on Concept Drift Adaptation. ACM Computing Surveys 46(4) – Bournemouth University Research Online [BURO] – A Survey on Concept Drift Adaptation.

[22] NIST (2023). AI Risk Management Framework 1.0. – Artificial Intelligence Risk Management Framework (AI RMF 1.0)

[23] Taleb, N. N. (2007). The Black Swan. Random House – The Black Swan: The Impact of the Highly Improbable : Nassim Nicholas Taleb : Free Download, Borrow, and Streaming : Internet Archive

[24] Evaluation of the US COVID-19 Scenario Modeling Hub (2023) – Evaluation of the US COVID-19 Scenario Modeling Hub for informing pandemic response under uncertainty | Nature Communications