Negli ultimi anni il settore delle telecomunicazioni in Italia e in Europa sta attraversando una fase di difficoltà strutturale che non può più essere interpretata come una semplice congiuntura negativa.

Indice degli argomenti

Perché la connettività non basta più: crisi e commoditizzazione

La pressione competitiva esercitata dalle grandi piattaforme digitali globali, la progressiva commoditizzazione dei servizi di connettività fissa e mobile e un impianto regolatorio che ha privilegiato per lungo tempo la tutela del consumatore finale rispetto alla sostenibilità industriale degli operatori hanno eroso in modo significativo margini, capacità di investimento e prospettive di crescita. In questo contesto, continuare a fondare il modello di business esclusivamente sulla fornitura di connettività non appare più sufficiente né sostenibile nel medio-lungo periodo.

Per tornare a crescere, gli operatori di telecomunicazioni sono chiamati a compiere un salto di paradigma, estendendo il proprio perimetro di attività verso i servizi ICT avanzati, il cloud, l’edge computing e l’intelligenza artificiale. Questo percorso non può essere interpretato come una semplice diversificazione dell’offerta, ma come una trasformazione profonda del ruolo delle Telco all’interno dell’ecosistema digitale. Da fornitori di infrastrutture di accesso e trasporto, gli operatori possono e devono evolvere verso piattaforme abilitanti per la digitalizzazione di imprese e Pubblica Amministrazione, mettendo a valore prossimità territoriale, affidabilità, competenze operative e conoscenza dei contesti regolati.

La crisi delle telecomunicazioni italiane e lo spostamento del valore

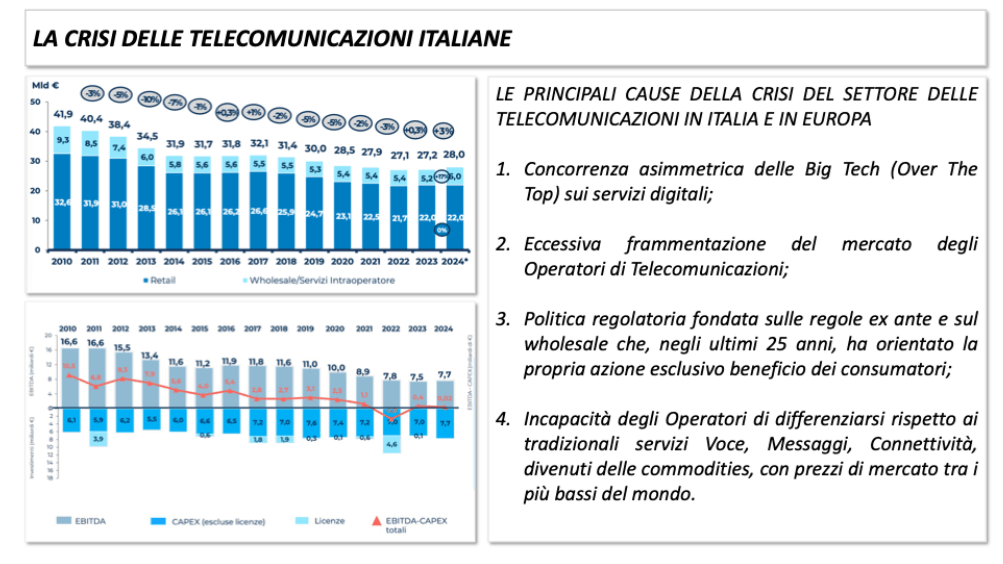

Negli ultimi quindici anni il settore delle telecomunicazioni italiane ha attraversato una crisi profonda e persistente, che non può più essere interpretata come una semplice fase ciclica. I ricavi complessivi del settore hanno seguito una traiettoria di progressiva contrazione, passando da valori superiori ai quaranta miliardi di euro all’inizio del decennio scorso a poco meno di trenta miliardi negli anni più recenti. Si tratta di una riduzione molto significativa, che assume un peso ancora maggiore se letta in termini reali e che colloca l’Italia tra i pochi grandi Paesi europei in cui il valore del mercato delle telecomunicazioni si è ridotto in modo così marcato nel tempo.

Figura 1: I numeri della crisi delle telecomunicazioni italiane

Parallelamente alla contrazione dei ricavi, si è assistito a un progressivo deterioramento della redditività. I margini operativi si sono assottigliati anno dopo anno, mentre l’intensità degli investimenti è rimasta strutturalmente elevata.

Ricavi, margini e CAPEX: il nodo della sostenibilità industriale

La distanza tra la capacità di generare cassa e il livello di CAPEX necessario per sostenere l’evoluzione tecnologica delle reti si è ridotta fino a diventare, in diversi periodi, estremamente contenuta. Questo fenomeno segnala una difficoltà crescente nel mantenere un equilibrio economico sostenibile, in cui una quota sempre maggiore del valore prodotto viene assorbita dagli investimenti infrastrutturali, lasciando spazi limitati per l’innovazione, la crescita e la remunerazione del capitale.

Un elemento centrale di questa crisi è la progressiva commoditizzazione dei servizi tradizionali di telecomunicazione. Voce, messaggistica e connettività, sia nel fisso sia nel mobile, hanno perso nel tempo la capacità di generare differenziazione e valore, trasformandosi in servizi standardizzati, caratterizzati da una competizione prevalentemente basata sul prezzo. I livelli tariffari, tra i più bassi a livello internazionale, riflettono un mercato fortemente competitivo ma al tempo stesso incapace di sostenere modelli industriali solidi e orientati al lungo periodo.

A questa dinamica si è aggiunta una forte frammentazione del mercato, che ha moltiplicato gli operatori e intensificato la pressione competitiva senza favorire un reale rafforzamento industriale del settore. In un contesto di domanda sostanzialmente matura per i servizi di connettività, l’eccesso di competizione ha contribuito a comprimere ulteriormente i ricavi, rendendo più difficile per gli operatori recuperare gli ingenti investimenti effettuati nelle reti di nuova generazione.

Asimmetria con le piattaforme digitali e frammentazione del mercato

Un ulteriore fattore di squilibrio è rappresentato dallo spostamento del valore lungo la catena digitale. Mentre le telecomunicazioni continuavano a sostenere il peso degli investimenti infrastrutturali, una parte crescente della creazione di valore si è concentrata nei servizi digitali e nelle piattaforme globali, che utilizzano le reti come abilitatori fondamentali senza essere soggette agli stessi vincoli economici e regolatori degli operatori di rete. Questo ha accentuato la percezione di una asimmetria strutturale, in cui le Telco svolgono un ruolo essenziale per il funzionamento dell’economia digitale, ma con margini e prospettive di crescita sempre più limitati.

Nel loro insieme, questi elementi delineano una crisi che è al tempo stesso economica, industriale e strategica. Le telecomunicazioni italiane restano un’infrastruttura critica per il Paese, ma il modello su cui si sono basate negli ultimi decenni mostra evidenti segni di esaurimento. Da questa consapevolezza nasce l’esigenza di ripensare profondamente il ruolo delle Telco, il perimetro dei servizi offerti e le condizioni di contesto necessarie per avviare una nuova fase di sviluppo e di sostenibilità economica.

Cloud sovrano delle Telco: definizione, vantaggi e confini

La crescita nei servizi richiede però un presupposto fondamentale: la capacità di adottare, personalizzare e gestire piattaforme software complesse, superando una logica puramente infrastrutturale. In questo scenario il cloud assume un ruolo centrale, ma non come mera estensione del modello degli hyperscaler globali. Per le Telco europee si apre invece lo spazio di un cloud sovrano, di prossimità, tecnologicamente indipendente, capace di garantire controllo dei dati, conformità normativa e integrazione con le reti e i sistemi edge. La sovranità non va intesa come chiusura, ma come capacità di scelta, di governo tecnologico e di riduzione delle dipendenze strutturali.

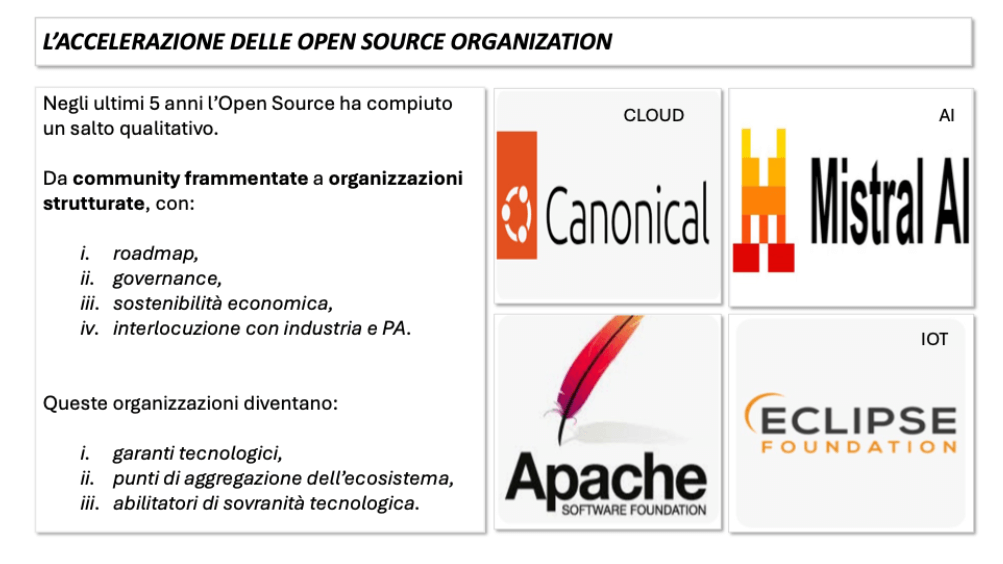

In questo percorso di trasformazione, la maturità raggiunta dal software open source rappresenta un asset strategico di primaria importanza. Negli ultimi anni l’open source ha superato la fase delle community frammentate e sperimentali per strutturarsi in vere e proprie organizzazioni industriali, dotate di roadmap chiare, modelli di governance, sostenibilità economica e capacità di dialogo con grandi imprese e istituzioni. Queste open source organization non sono più semplici fornitori di componenti tecnologiche, ma diventano garanti di stabilità, catalizzatori di ecosistemi e abilitatori di sovranità tecnologica.

Alcuni esempi risultano particolarmente significativi per il settore delle telecomunicazioni. Canonical rappresenta oggi uno dei riferimenti principali per la costruzione di infrastrutture cloud open, ibride e sovrane, grazie a un controllo coerente dello stack che va dal sistema operativo alla gestione dei container e del private cloud. La Apache Software Foundation costituisce l’ossatura tecnologica per l’osservabilità, l’automazione e la gestione dei dati e degli eventi in ambienti distribuiti, elementi essenziali per reti complesse, servizi cloud e piattaforme AI.

Mistral, nel campo dell’intelligenza artificiale generativa, propone un modello europeo basato su open weight e su un forte orientamento all’uso industriale e sovrano dei modelli, particolarmente adatto allo sviluppo di language model specifici di dominio. Eclipse Foundation, infine, rappresenta il punto di riferimento per l’industrial IoT e l’integrazione tra mondo IT e OT, un ambito cruciale per l’evoluzione dei servizi verticali e dell’edge computing.

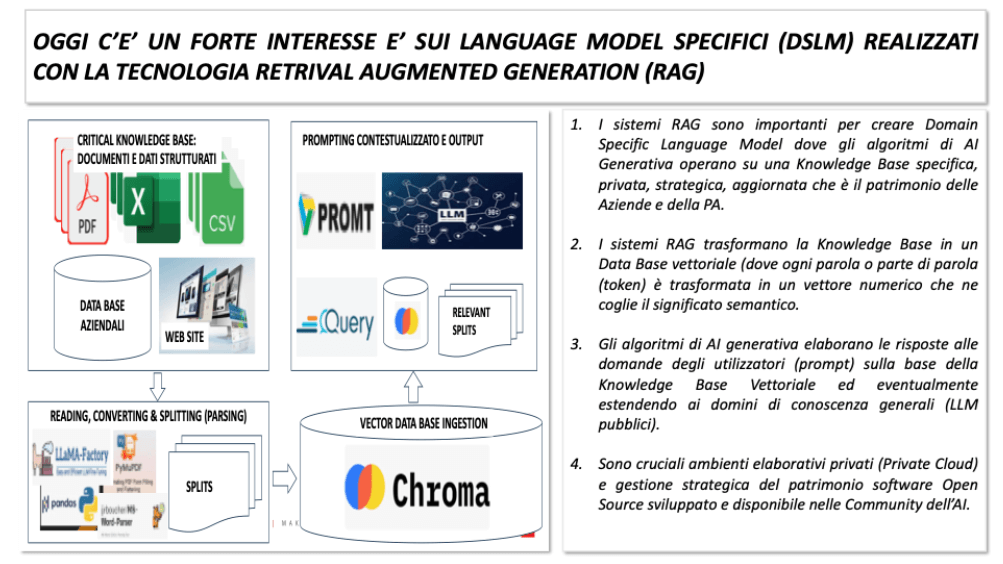

In particolare, l’adozione dell’AI generativa e lo sviluppo di domain specific language model aprono per gli operatori Telco opportunità concrete di valorizzazione del cloud sovrano di prossimità. I modelli linguistici specifici, basati su tecniche di retrieval augmented generation e alimentati da basi di conoscenza proprietarie, consentono di offrire servizi ad alto valore aggiunto a grandi imprese, PMI e Pubblica Amministrazione, mantenendo il controllo sui dati e garantendo livelli elevati di sicurezza, compliance e personalizzazione. In questo contesto, la prossimità geografica e infrastrutturale delle Telco diventa un vantaggio competitivo reale rispetto ai modelli centralizzati.

Open source come leva industriale per nuovi servizi ICT

Negli ultimi anni l’open source ha progressivamente assunto un ruolo molto più ampio rispetto a quello tradizionale di strumento per sviluppatori. Oggi l’open source è al centro di molte delle principali tecnologie di infrastruttura, applicazione e dati che abilitano i nuovi servizi digitali e definiscono l’architettura della trasformazione digitale. Questa evoluzione supera la storica visione dell’open source come alternativa economica al software proprietario e lo pone come motore strategico di innovazione, interoperabilità e sovranità tecnologica per imprese e infrastrutture critiche.

Questa maturazione dell’open source si riflette nella crescente adozione di tecnologie open in ambiti come il cloud computing, l’intelligenza artificiale, l’Internet of Things e l’edge computing. La diffusione di piattaforme come Kubernetes per l’orchestrazione dei container, tecnologie di virtualizzazione e distribuzione dei carichi di lavoro, e framework open per la gestione dei dati e dei servizi applicativi testimonia come l’open source sia ormai parte integrante delle architetture enterprise e cloud native contemporanee. Questo fenomeno è accompagnato da una progressiva attenzione alla governance, alla sicurezza e alla gestione strategica dell’open source all’interno delle organizzazioni, anche se la piena maturità di questi aspetti è ancora in corso di sviluppo.

Figura 2: Alcune importanti community open source oggi strategiche per lo sviluppo di nuovi servizi.

In questo contesto, l’open source diventa una leva fondamentale per creare nuovi servizi ICT di valore per i clienti delle telecomunicazioni. Il paradigma dell’open source facilita infatti l’integrazione di componenti modulari, la sperimentazione di nuovi modelli di servizio, la personalizzazione di piattaforme su scala e l’adozione di tecnologie avanzate senza vincoli di lock-in tecnologico. Queste caratteristiche sono particolarmente rilevanti per gli operatori di telecomunicazioni che intendono spostare il proprio baricentro dal mero trasporto di bit verso l’erogazione di servizi digitali innovativi e verticalizzati, capaci di generare nuove fonti di ricavo.

La capacità dell’open source di abilitare nuovi servizi si fonda su alcuni elementi chiave. Innanzitutto, adottare tecnologie open significa poter costruire ecosistemi collaborativi in cui imprese, fornitori di software, integratori e comunità globali lavorano insieme per evolvere le piattaforme di base e sviluppare soluzioni specifiche. Questo approccio accelera il time-to-market, riduce i costi di sviluppo e permette alle imprese di partecipare attivamente alla definizione degli standard tecnologici.

In secondo luogo, l’open source promuove trasparenza e auditabilità, aspetti che si allineano con requisiti di compliance, sicurezza e governance sempre più stringenti nelle applicazioni corporate e nei servizi regolamentati. Inoltre, l’adozione di tecnologie open permette di evitare dipendenze dai fornitori proprietari, favorendo al contrario la portabilità, la scalabilità e la capacità di combinare componenti software diversi in modo coerente e interoperabile.

Questa strategia di estensione dei servizi basati su open source si riflette in diversi ambiti tecnologici. Nel cloud computing, l’utilizzo di piattaforme open consente di costruire stack infrastrutturali in grado di supportare servizi gestiti, orchestrazione di ambienti ibridi e multi-cloud, e integrazione semplificata con soluzioni di edge computing e servizi containerizzati. Nel campo dell’intelligenza artificiale, l’adozione di modelli, librerie e tool open consente alle imprese di sviluppare soluzioni AI personalizzate, basate su specifiche esigenze di dominio, e di mantenerne il controllo sui dati e sugli algoritmi, riducendo il rischio di dipendenza da modelli chiusi.

Anche nell’Internet of Things e nei servizi di edge computing l’open source gioca un ruolo sempre più centrale nel creare piattaforme interoperabili e scalabili. Le tecnologie open consentono di collegare dispositivi eterogenei, gestire il ciclo di vita dei dati generati ai margini della rete, e orchestrare servizi distribuiti in modo efficiente, riducendo la complessità di integrazione e favorendo l’adozione su larga scala di soluzioni IoT verticali.

In questo nuovo scenario, le open source organization rappresentano non solo fornitori di software, ma punti di aggregazione di ecosistemi tecnologici e catalizzatori di innovazione. Queste organizzazioni, dotate di governance strutturata, roadmap condivise e sostenibilità operativa, facilitano la creazione di servizi avanzati basati su piattaforme aperte e collaborazioni estese. La maturità raggiunta dall’open source permette così agli operatori di telecomunicazioni di costruire offerte di servizi ICT differenziate, integrate e competitive, fondando la propria proposta su tecnologie di infrastruttura, dati e intelligenza artificiale che sono già adottate su scala globale.

Le organizzazioni open source che contano per il cloud e l’AI

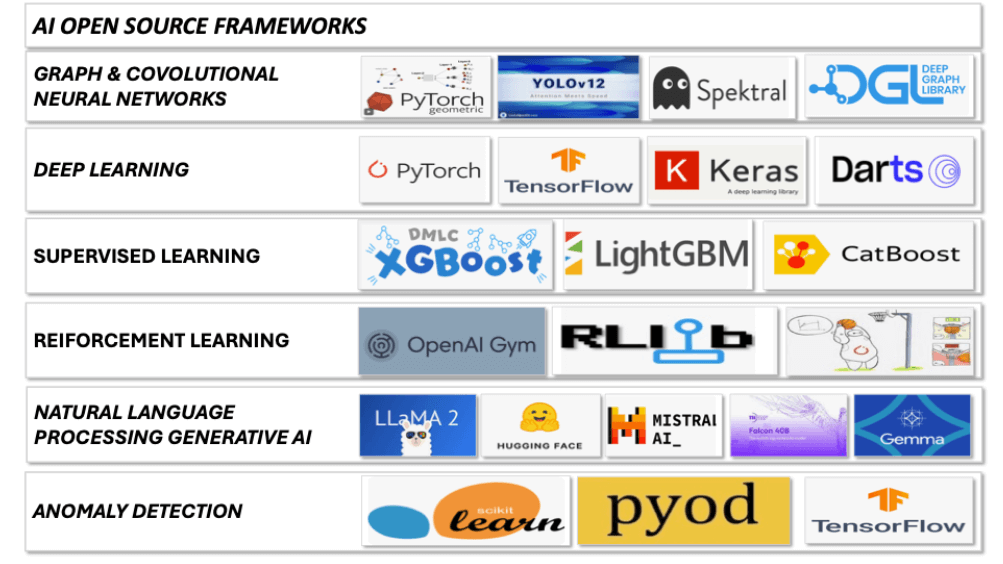

L’adozione dell’intelligenza artificiale nelle telecomunicazioni e nei servizi ICT sta entrando in una fase di maturità industriale, e un elemento decisivo di questa maturità è la disponibilità di un ecosistema open source ormai completo. La slide propone una lettura “a famiglie” dei principali framework e delle principali community che oggi costituiscono la base tecnologica con cui si costruiscono soluzioni AI reali, scalabili e manutenibili. Il punto di fondo è che l’AI non è una singola tecnologia, ma un insieme di paradigmi e strumenti diversi, ciascuno adatto a specifiche classi di problemi.

Figura 3: Alcuni importanti moduli open source per l’intelligenza artificiale.

Il primo blocco, dedicato a graph e modelli convoluzionali, richiama una dimensione particolarmente rilevante per le telecomunicazioni. Le reti sono per natura grafi: nodi, link, topologie, dipendenze logiche e fisiche. Le tecniche di graph neural networks consentono di rappresentare e apprendere queste strutture in modo più efficace rispetto ai metodi tradizionali, con benefici potenziali in ambiti come ottimizzazione di routing e capacità, analisi di impatto dei guasti, correlazione di allarmi, identificazione di colli di bottiglia e, più in generale, supporto a decisioni operative basate su struttura e contesto della rete.

Accanto ai grafi, la presenza di modelli per computer vision evidenzia un’altra traiettoria che sta crescendo: ispezione automatica di infrastrutture, sicurezza fisica, monitoraggio ambientale nei siti, controllo qualità in contesti industriali e smart building. Anche qui il messaggio è operativo: esistono strumenti maturi e disponibili che trasformano casi d’uso prima sperimentali in soluzioni implementabili.

Il secondo blocco, dedicato al deep learning, rappresenta la base comune su cui si costruiscono molti degli altri domini. Framework come PyTorch e TensorFlow, e librerie di alto livello, hanno standardizzato sviluppo, training, validazione e deployment. Per un operatore, questo significa poter industrializzare l’AI secondo cicli di vita comparabili a quelli del software: versioning, testing, monitoraggio, aggiornamento, gestione del debito tecnico. È un passaggio critico perché sposta l’AI da laboratorio a produzione, dove contano affidabilità, ripetibilità e capacità di operare nel tempo.

Il terzo blocco, relativo al supervised learning con strumenti come XGBoost, LightGBM e CatBoost, è un richiamo importante a una realtà spesso sottovalutata nel dibattito pubblico dominato dalla generative AI. Molti problemi aziendali ad alto impatto restano dominati da modelli supervisionati e, in particolare, da tecniche molto efficaci su dati tabellari: churn, propensity, credit risk, frodi, forecasting, capacity planning, performance prediction, classificazioni e scoring di qualunque tipo.

In un contesto Telco questi modelli sono spesso più semplici da mettere in produzione, più interpretabili, più economici e più robusti su dataset strutturati. La loro presenza in una mappa dell’AI open source serve a ricordare che l’evoluzione verso i servizi non passa solo dai grandi modelli generativi, ma da un portafoglio di tecniche che vanno applicate con pragmatismo ai dati disponibili.

Il blocco sul reinforcement learning segnala un’altra area di potenziale impatto, soprattutto quando l’obiettivo non è classificare o prevedere, ma ottimizzare decisioni sequenziali in un sistema dinamico. È un paradigma naturale per orchestrazione di risorse, ottimizzazione di politiche, tuning di parametri, gestione adattativa in presenza di vincoli e trade-off. In ambito Telco può essere rilevante per policy di controllo in ambienti complessi, per automazione avanzata e per alcune forme di closed-loop automation.

È anche, però, un dominio che richiede disciplina ingegneristica: simulazione accurata, definizione delle reward, gestione dei rischi operativi. La slide, includendolo, fa emergere la completezza dello stack open source, ma implicitamente invita a distinguere tra aree immediatamente produttive e aree che richiedono maggiore maturità di processo.

Il blocco su natural language processing e generative AI rappresenta il punto più attuale e strategico. La presenza di Hugging Face e di modelli open evidenzia che l’ecosistema della generative AI non è solo dominato da modelli chiusi: esiste una filiera open che permette ad aziende e operatori di costruire soluzioni controllate, personalizzate e coerenti con requisiti di sicurezza e sovranità.

Per le Telco, questo si traduce in due direttrici. La prima è interna: automazione della produzione e gestione della conoscenza, supporto alle operations, copiloti per ingegneri e tecnici, assistenza agli operatori di NOC e service desk, generazione e validazione di documentazione tecnica e procedure. La seconda è esterna: servizi alle imprese basati su modelli specializzati, dove il valore nasce dalla capacità di far lavorare l’AI sulla conoscenza specifica del cliente, sui suoi documenti, sulle sue policy, sui suoi dati e processi.

In entrambi i casi, la disponibilità di modelli e tool open consente di disegnare architetture dove il dato resta governato, la personalizzazione è possibile e il deployment può avvenire su cloud privato o edge, a seconda delle necessità.

Infine, il blocco sull’anomaly detection richiama un pilastro della gestione operativa, particolarmente rilevante per infrastrutture critiche. La rilevazione di anomalie è un tema trasversale: rete, cybersecurity, sistemi, applicazioni, IoT, impianti industriali, building, energia. La presenza di strumenti open consolidati mostra che questa area è già industrializzabile e può rappresentare una via rapida per dimostrare valore, perché riduce downtime, migliora la qualità del servizio e abilita manutenzione predittiva e proactive assurance.

Nel loro insieme, questi blocchi descrivono un messaggio chiaro: l’AI open source non è un insieme disordinato di librerie, ma un ecosistema maturo che copre tutti i principali paradigmi necessari per costruire servizi. La conseguenza pratica è che una strategia industriale per le Telco può essere fondata su una piattaforma AI componibile, dove ogni famiglia tecnologica viene selezionata in funzione del caso d’uso e integrata in un ciclo di vita governato.

Domain specific language model nel cloud sovrano delle Telco di prossimità

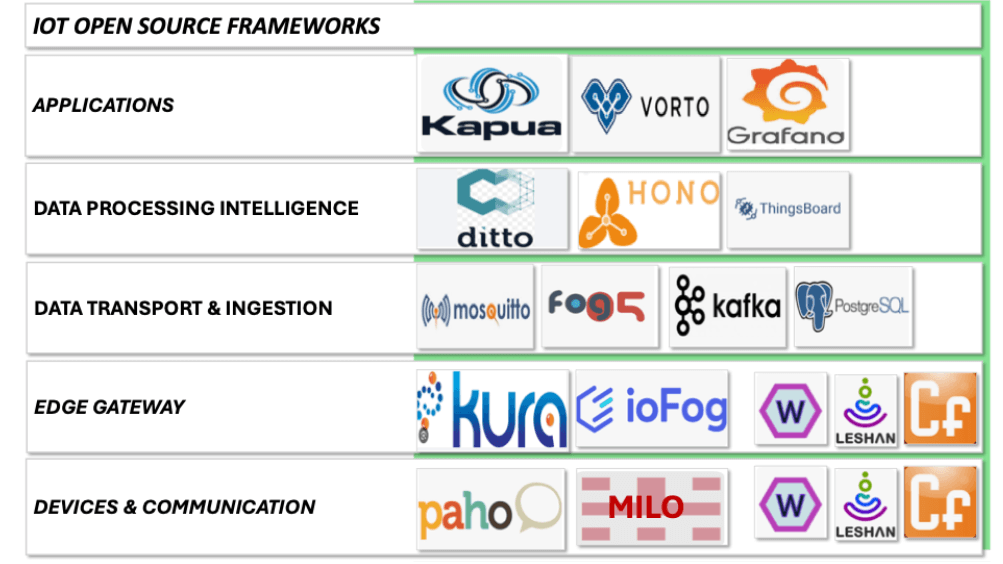

L’Internet of Things rappresenta una delle principali direttrici di crescita dell’utilizzo delle reti di telecomunicazione e, al tempo stesso, uno degli ambiti in cui l’open source ha raggiunto un livello di maturità tale da consentire implementazioni industriali su larga scala. L’aumento esponenziale del numero di dispositivi connessi, la varietà dei casi d’uso e la pervasività dei sensori stanno trasformando le reti da semplici canali di trasporto a infrastrutture abilitanti per servizi digitali verticali.

Automotive, smart metering, smart building, smart city, industrial IoT e smart grids sono solo alcuni dei contesti in cui l’IoT sta generando nuova domanda di connettività, di elaborazione distribuita e di piattaforme software capaci di gestire complessità, eterogeneità e scala.

In questi verticali, l’IoT non si limita ad aumentare il volume del traffico, ma modifica profondamente il profilo di utilizzo delle reti. I flussi di dati sono spesso continui, distribuiti, sensibili alla latenza e, in molti casi, critici dal punto di vista operativo e di sicurezza. Questo richiede architetture che integrino rete, edge computing e piattaforme applicative in modo coerente. L’open source si inserisce in questo scenario come fattore abilitante, perché fornisce componenti interoperabili e standardizzati lungo l’intera catena del valore, dal dispositivo fino alle applicazioni di business.

La figura 4 evidenzia una struttura a livelli che riflette bene questa complessità. Alla base vi sono i dispositivi e i protocolli di comunicazione, che costituiscono il punto di contatto tra il mondo fisico e quello digitale. In ambiti come l’automotive connesso, lo smart metering energetico o le reti di sensori industriali, la capacità di supportare protocolli leggeri, affidabili e standardizzati è essenziale per garantire interoperabilità tra vendor diversi e per assicurare una lunga vita operativa delle soluzioni.

Figura 4: Alcuni importanti moduli open source per l’IoT.

Salendo di livello, il ruolo dei gateway edge diventa centrale. È in prossimità dei dispositivi che si concentrano funzioni sempre più sofisticate di raccolta, normalizzazione, filtraggio e pre-elaborazione dei dati. Questo è particolarmente evidente negli scenari industriali, nelle smart grid e negli edifici intelligenti, dove non tutti i dati devono o possono essere inviati a un cloud centrale. L’edge computing consente di ridurre la latenza, ottimizzare l’uso della banda e aumentare la resilienza dei sistemi.

Le piattaforme open source per edge gateway permettono di implementare queste funzioni in modo flessibile, adattandole ai diversi contesti verticali e integrandole nativamente con le reti di telecomunicazione.

Il livello del data transport e dell’ingestion rappresenta il cuore della relazione tra IoT e rete. Qui si concentrano i meccanismi di raccolta affidabile dei flussi di dati, la gestione degli eventi e la loro distribuzione verso i sistemi di elaborazione e storage. Nei casi d’uso come smart city e smart mobility, dove milioni di eventi possono essere generati in tempo reale, la capacità di gestire stream continui e di scalare orizzontalmente è un requisito imprescindibile.

Il livello della data processing intelligence segna il passaggio dall’IoT come semplice generatore di dati all’IoT come abilitatore di servizi intelligenti. È qui che i dati vengono contestualizzati, arricchiti, correlati e resi disponibili per l’analisi e per l’integrazione con altri sistemi aziendali. Nei contesti di smart building e industrial IoT, ad esempio, questo livello consente di passare dal monitoraggio alla manutenzione predittiva, dall’automazione semplice all’ottimizzazione dei processi.

Infine, il livello applicativo rappresenta il punto in cui l’IoT diventa visibile per il cliente finale e per il business. Dashboard, sistemi di controllo, piattaforme verticali e servizi a valore aggiunto si appoggiano su tutta la catena sottostante. In ambiti come smart city e smart grids, le applicazioni IoT sono spesso multi-attore, coinvolgono enti pubblici, utility, operatori e cittadini, e richiedono quindi un elevato grado di interoperabilità e trasparenza.

Nel loro insieme, questi livelli mostrano come l’IoT open source costituisca una piattaforma naturale di crescita per le telecomunicazioni. Da un lato aumenta l’utilizzo delle reti in termini quantitativi e qualitativi, dall’altro abilita nuovi servizi ICT verticali che possono essere progettati, gestiti ed erogati dagli operatori. In questo scenario, le Telco non sono semplici fornitori di connettività, ma diventano integratori di ecosistemi IoT, operatori di piattaforme edge e cloud distribuite e partner tecnologici per settori industriali e pubblici.

Cloud repatriation: perché la selettività rafforza il cloud sovrano delle Telco

L’evoluzione più rilevante dell’intelligenza artificiale negli ultimi anni non riguarda soltanto la crescita delle capacità dei modelli generici, ma soprattutto lo spostamento dell’attenzione verso modelli linguistici specifici di dominio. In questo contesto si inserisce l’interesse crescente per i Domain Specific Language Model sviluppati attraverso architetture basate su retrieval augmented generation. Questo approccio consente di superare i limiti dei modelli generalisti, mettendo al centro il patrimonio informativo specifico di ciascuna organizzazione e trasformando l’AI in uno strumento realmente utile per i processi aziendali e pubblici.

La logica dei sistemi RAG è chiara e profondamente coerente con le esigenze di imprese e Pubblica Amministrazione. I modelli di AI generativa non operano più soltanto sulla conoscenza generica appresa durante la fase di training, ma vengono alimentati dinamicamente da una base di conoscenza privata, aggiornata e strategica. Documenti, database aziendali, archivi tecnici, procedure operative, manuali, dati strutturati e semi-strutturati diventano la fonte primaria su cui l’AI costruisce le risposte.

In questo modo il valore non risiede tanto nel modello linguistico in sé, quanto nella qualità, nella completezza e nella governance della knowledge base sottostante. Dal punto di vista architetturale, i sistemi RAG introducono una catena di elaborazione che si presta particolarmente bene a essere implementata con tecnologie open source. I contenuti vengono acquisiti, letti, convertiti e suddivisi in porzioni semanticamente significative.

Queste informazioni vengono poi trasformate in rappresentazioni vettoriali che catturano il significato dei testi e consentono ricerche semantiche efficienti. Al momento dell’interazione con l’utente, il sistema seleziona le parti più rilevanti della knowledge base e le utilizza per contestualizzare il prompt e guidare la generazione della risposta. Il risultato è un output che riflette il linguaggio, i concetti e le regole del dominio specifico, riducendo drasticamente allucinazioni, ambiguità e risposte generiche.

Figura 5: Soluzioni e servizi per i Domain Specific Language Model.

Per gli operatori di telecomunicazioni, questo scenario apre un’opportunità strategica particolarmente rilevante. Da alcuni anni le Telco hanno avviato offerte cloud, spesso inizialmente orientate a servizi infrastrutturali di base. L’evoluzione verso piattaforme per lo sviluppo di DSLM consente di compiere un salto di valore, spostando l’offerta dal semplice hosting di risorse computazionali alla fornitura di servizi AI avanzati, fortemente personalizzati e ad alto contenuto professionale.

In questo modello, il cloud non è più solo un ambiente di esecuzione, ma diventa la piattaforma su cui si costruisce, governa e protegge la conoscenza digitale dei clienti. Un elemento chiave di questa proposta è la valorizzazione dei data center locali. I DSLM basati su RAG richiedono ambienti elaborativi affidabili, sicuri e vicini ai dati.

La possibilità di sviluppare e far operare questi modelli in cloud privati o ibridi, localizzati sul territorio, risponde a esigenze sempre più sentite in termini di sovranità del dato, compliance normativa, controllo degli accessi e protezione delle informazioni sensibili. In questo senso, le infrastrutture delle Telco rappresentano un vantaggio competitivo naturale, perché combinano prossimità geografica, affidabilità operativa e integrazione nativa con le reti.

L’adozione di tecnologie open source per la realizzazione delle piattaforme RAG rafforza ulteriormente questo modello. L’open source consente di costruire architetture flessibili, componibili e adattabili ai diversi contesti settoriali, evitando dipendenze rigide da soluzioni proprietarie e permettendo una gestione evolutiva nel tempo. Inoltre, l’utilizzo di componenti open facilita l’integrazione con i sistemi informativi esistenti dei clienti e con altri servizi cloud, edge e AI, creando un ecosistema coerente e interoperabile.

In questo scenario, gli operatori di telecomunicazioni possono posizionarsi come abilitatori di intelligenza artificiale di dominio, offrendo alle aziende e alla Pubblica Amministrazione non solo infrastrutture, ma piattaforme complete per la valorizzazione della conoscenza. I DSLM diventano così uno strumento concreto per migliorare l’efficienza operativa, supportare decisioni complesse, automatizzare processi e aumentare la qualità dei servizi, mentre il cloud di prossimità delle Telco si afferma come l’ambiente naturale in cui queste soluzioni possono essere sviluppate e gestite in modo sicuro, controllato e sostenibile nel tempo.

Data center ed edge computing: la base del cloud sovrano delle Telco

Tutti gli elementi analizzati nei capitoli precedenti convergono verso un punto chiave: la crescente centralità dei dati, degli algoritmi e della conoscenza digitale rende inevitabile una riflessione profonda sul luogo in cui questi asset vengono elaborati e governati. L’intelligenza artificiale, l’IoT, i modelli linguistici specifici di dominio e le piattaforme digitali avanzate non sono semplicemente carichi computazionali, ma rappresentano il cuore informativo e decisionale delle organizzazioni.

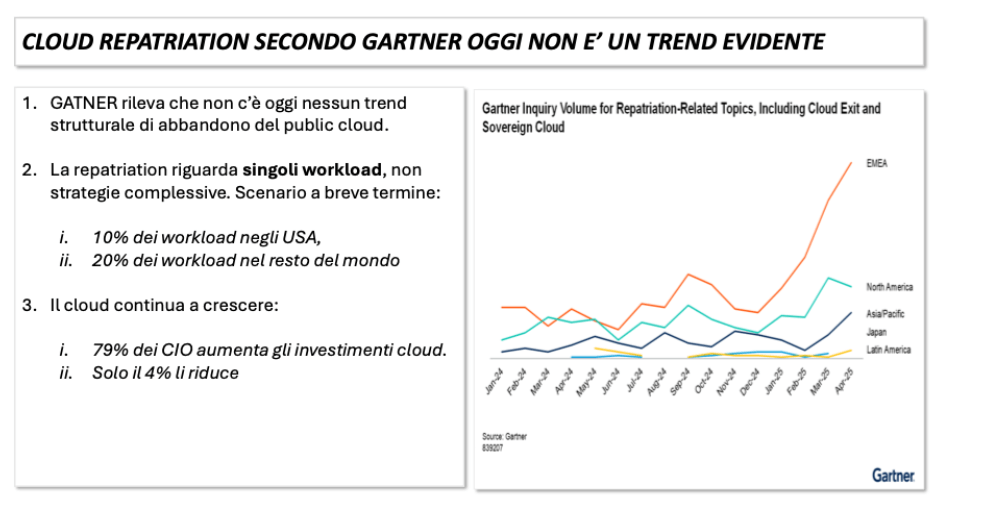

La loro delicatezza, in termini di valore economico, criticità operativa e rilevanza strategica, modifica radicalmente il modo in cui le imprese e la Pubblica Amministrazione guardano alle architetture cloud. Ad oggi, il fenomeno della cloud repatriation non si manifesta in forma generalizzata. Non si osserva un abbandono strutturale del public cloud, né una inversione di tendenza rispetto alla crescita complessiva dei servizi cloud.

Le scelte architetturali rimangono prevalentemente ibride e pragmatiche, con una forte attenzione a costi, scalabilità e velocità di adozione. Tuttavia, sotto questa apparente stabilità, si sta affermando una dinamica più sottile ma significativa: la selezione sempre più attenta dei workload da collocare nel cloud pubblico rispetto a quelli da mantenere o riportare in ambienti privati o di prossimità.

Questa dinamica è strettamente legata alla natura dei nuovi servizi digitali. I sistemi di AI generativa e i DSLM basati su RAG operano su basi di conoscenza che costituiscono il patrimonio informativo più sensibile delle organizzazioni. Documenti tecnici, dati operativi, informazioni su clienti, processi e infrastrutture diventano parte integrante del funzionamento degli algoritmi.

In questi casi, il tema non è solo la sicurezza in senso tradizionale, ma il controllo complessivo del ciclo di vita del dato e dell’algoritmo: dove risiedono, chi vi accede, come vengono aggiornati, come vengono tracciate le interazioni e come si garantisce la conformità a normative sempre più articolate.

Analogamente, l’IoT e l’edge computing generano flussi di dati continui, spesso legati a infrastrutture fisiche, impianti industriali, reti energetiche, sistemi di mobilità e servizi pubblici. In questi contesti, la latenza, l’affidabilità e la resilienza diventano fattori critici, e l’elaborazione distribuita in prossimità della fonte del dato assume un valore superiore rispetto alla centralizzazione estrema.

Figura 6: Cloud repatriation oggi e i futuri trend (Fonte: GARTNER).

È in questo scenario che il concetto di cloud repatriation assume un significato più evoluto. Non si tratta di un ritorno generalizzato ai data center tradizionali, né di una contrapposizione tra cloud pubblico e infrastrutture private. Si tratta piuttosto di un processo selettivo, guidato dalla crescente consapevolezza che non tutti i carichi applicativi hanno le stesse esigenze e lo stesso profilo di rischio.

I workload più strategici, quelli che incorporano conoscenza critica, algoritmi proprietari e funzioni decisionali avanzate, tendono progressivamente a essere collocati in ambienti più controllati, spesso ibridi, dove il cloud pubblico convive con cloud privati e edge cloud. In questo senso, l’accelerazione dell’AI e dei servizi digitali avanzati agisce come fattore abilitante e, allo stesso tempo, come catalizzatore di una nuova fase del cloud.

Strategie di ripresa e quadro regolatorio per le Telco

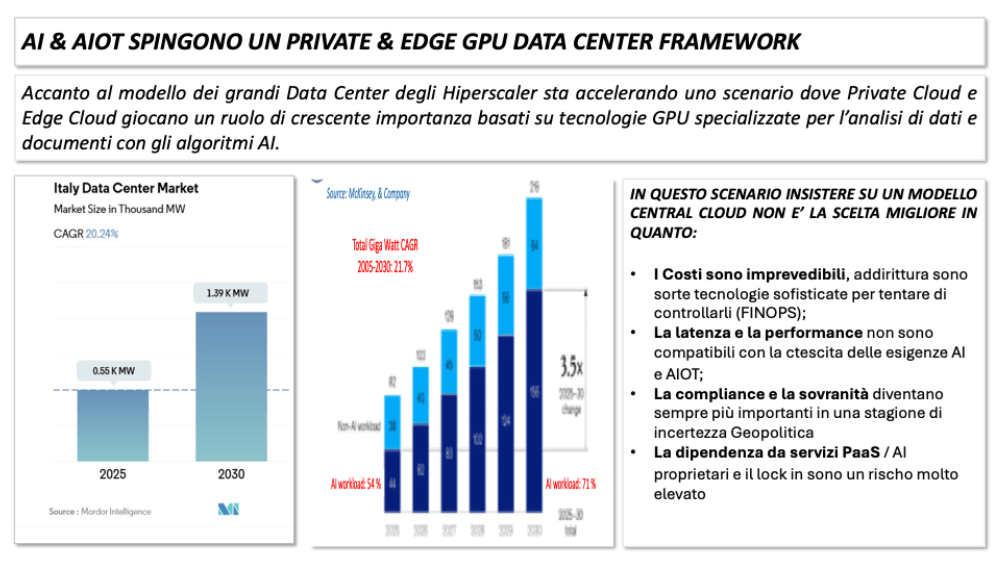

La crescita dei data center rappresenta uno dei fenomeni più rilevanti della trasformazione digitale in corso e riguarda in modo diretto anche il contesto italiano. L’aumento della domanda di capacità computazionale, trainato in particolare dall’intelligenza artificiale e dall’AIoT, sta determinando un’espansione rapida delle infrastrutture di elaborazione, con tassi di crescita che non hanno precedenti nelle precedenti fasi di digitalizzazione.

Questa dinamica non è legata esclusivamente allo sviluppo dei grandi campus degli hyperscaler, ma interessa in modo sempre più marcato l’intero territorio, con modelli infrastrutturali differenziati e complementari. Accanto alle grandi gigafactory del dato, che concentrano enormi capacità di calcolo e storage, si sta infatti affermando un’esigenza crescente di data center distribuiti, di dimensioni medio-piccole, collocati in prossimità degli utenti, delle imprese e delle infrastrutture critiche.

L’evoluzione dei carichi di lavoro AI, in particolare quelli legati all’inferenza, all’elaborazione in tempo reale e all’integrazione con sistemi fisici, rende sempre meno efficiente un modello basato esclusivamente sulla centralizzazione estrema. L’elaborazione di dati sensibili, l’esigenza di bassa latenza e la necessità di garantire continuità operativa spingono verso architetture distribuite, dove il calcolo si avvicina al punto di generazione del dato.

In questo scenario, l’edge computing assume un ruolo strutturale e non più sperimentale. I data center edge, dotati di acceleratori hardware come le GPU e integrati con le reti di telecomunicazione, diventano il luogo naturale per supportare applicazioni di AI e AIoT in settori come l’industria manifatturiera, l’energia, la mobilità, le smart city e le infrastrutture pubbliche.

Figura 7: Evoluzione dei data center in Italia.

Nel complesso, la crescita impetuosa dei data center in Italia va interpretata come l’avvio di una nuova fase infrastrutturale, in cui la capacità di calcolo diventa un elemento diffuso sul territorio e strettamente integrato con le reti. Gli operatori di telecomunicazioni, grazie alla loro presenza capillare e alla loro esperienza nella gestione di infrastrutture critiche, sono nella posizione ideale per guidare questo sviluppo. La combinazione di data center locali, edge computing e cloud sovrano rappresenta non solo una risposta alle esigenze emergenti dell’AI e dell’IoT, ma anche una concreta opportunità di rilancio industriale e di creazione di nuovo valore per il settore delle telecomunicazioni.

Figura 8: Le strategie per la ripresa.

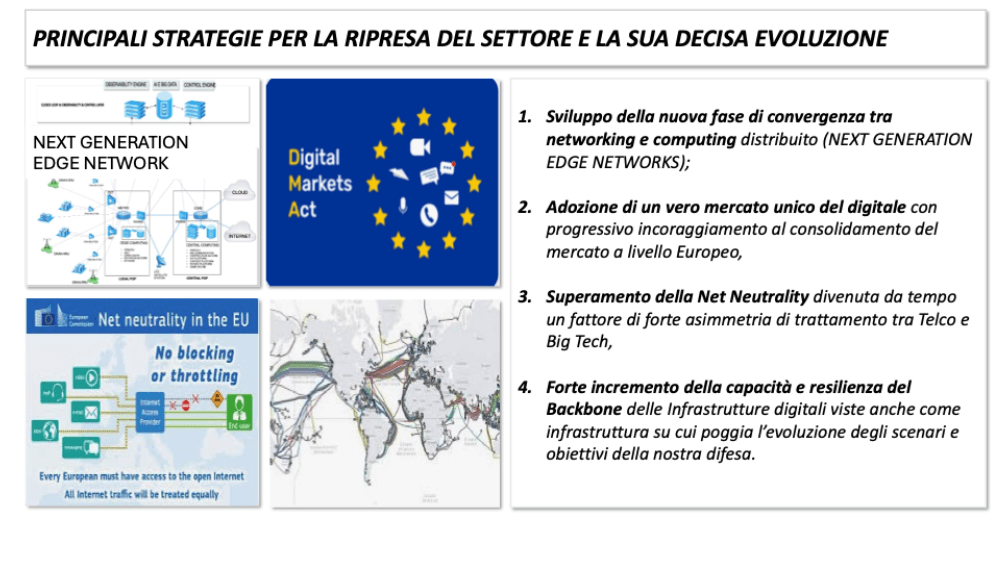

La combinazione dei fattori analizzati nei capitoli precedenti apre una prospettiva concreta di rilancio del settore delle telecomunicazioni, fondata non su un semplice recupero della connettività, ma sull’evoluzione verso una nuova famiglia di servizi digitali avanzati basati sull’intelligenza artificiale. Le Telco dispongono oggi di asset distintivi che, se opportunamente valorizzati, consentono di sviluppare e offrire servizi AI based rivolti alle imprese e alla Pubblica Amministrazione, superando il modello tradizionale centrato esclusivamente sul trasporto dei dati.

Accanto all’evoluzione tecnologica e di servizio, restano tuttavia decisive alcune azioni di carattere regolatorio. La capacità del settore di intraprendere una nuova stagione di crescita dipende anche dalla creazione di un contesto normativo più equilibrato, che riconosca il ruolo sistemico delle telecomunicazioni nella trasformazione digitale. La costruzione di un vero mercato unico europeo del digitale, accompagnata da un progressivo consolidamento del settore, rappresenta una condizione necessaria per recuperare scala, capacità di investimento e competitività a livello globale.

Verso un nuovo operatore: next generation edge networks e cloud sovrano delle Telco

Verso un nuovo modello di Operatore di Telecomunicazioni

Questo capitolo conclusivo sintetizza e ricompone in una visione unitaria le azioni necessarie per la ripresa strutturale del settore delle telecomunicazioni, alla luce delle trasformazioni tecnologiche, industriali e geopolitiche analizzate nei capitoli precedenti. Il filo conduttore è chiaro: la crisi delle Telco non può essere risolta con interventi marginali o tattici, ma richiede un ripensamento profondo del modello infrastrutturale, del perimetro dei servizi e dell’impianto regolatorio, coerente con la nuova centralità delle reti digitali nell’economia e nella sicurezza del continente.

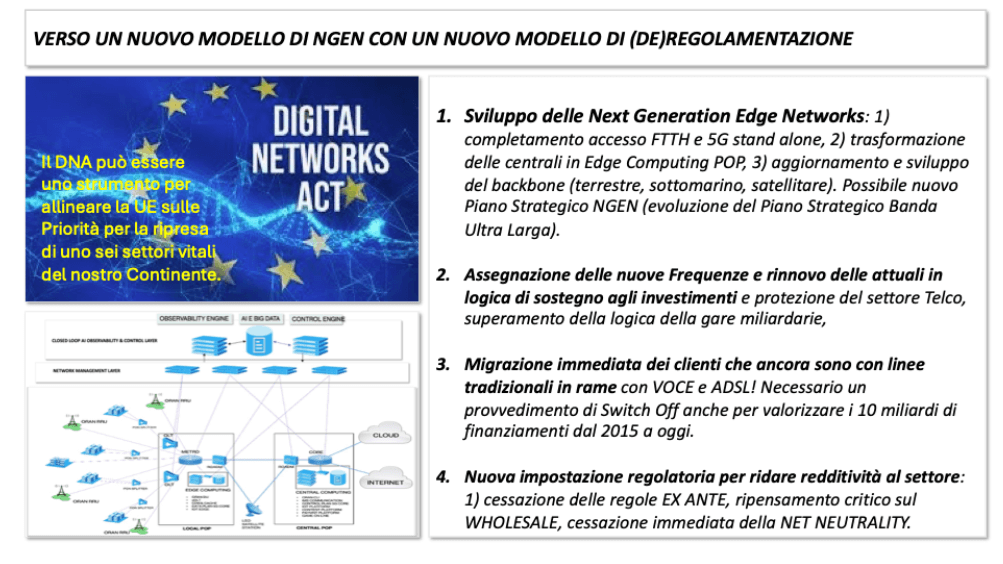

Il primo asse di intervento riguarda lo sviluppo delle Next Generation Edge Networks come naturale evoluzione delle reti di accesso di nuova generazione. Dopo la fase di diffusione della fibra ottica fino alle abitazioni e del 5G, diventa necessario completare la trasformazione delle infrastrutture rendendo le centrali e i punti di presenza veri e propri nodi di edge computing. In questo modello, la rete non è più soltanto un mezzo di trasporto, ma una piattaforma distribuita capace di ospitare funzioni computazionali, algoritmi di intelligenza artificiale e servizi digitali avanzati.

Figura 9: La via verso la Next Generation Edge Network e (de)regolamentazione del settore Telco.

In questo quadro, strumenti di policy a livello europeo, come il Digital Networks Act, possono rappresentare un’occasione per riallineare le priorità strategiche del continente su uno dei suoi settori vitali. Le reti digitali non sono più solo un’infrastruttura economica, ma un elemento abilitante per la competitività industriale, la transizione digitale, la sicurezza e la difesa. Riconoscere questo ruolo implica accettare che la regolamentazione debba evolvere di pari passo con la tecnologia e con i modelli di servizio.

Conclusioni

L’analisi sviluppata mostra con chiarezza come il settore delle telecomunicazioni si trovi oggi in un passaggio storico. La crisi che ha caratterizzato gli ultimi quindici anni non è stata il risultato di un singolo errore o di una congiuntura sfavorevole, ma l’esito di una trasformazione profonda del contesto tecnologico, economico e regolatorio, a cui il modello tradizionale delle Telco non è riuscito a rispondere in modo adeguato. La progressiva commoditizzazione della connettività, la pressione competitiva delle piattaforme digitali globali e un impianto regolatorio pensato per un’altra fase storica hanno eroso valore, margini e capacità di investimento, mettendo in discussione la sostenibilità industriale del settore.

Allo stesso tempo, però, questa crisi coincide con una fase di straordinaria accelerazione tecnologica che restituisce alle telecomunicazioni una centralità strategica senza precedenti. L’intelligenza artificiale, l’IoT, il cloud distribuito e l’edge computing stanno ridefinendo il modo in cui dati, algoritmi e servizi digitali vengono prodotti, elaborati e utilizzati. In questo nuovo scenario, le reti non sono più semplici infrastrutture di trasporto, ma diventano piattaforme intelligenti, distribuite e integrate con capacità computazionali avanzate.