OpenAI al fianco del Governo Usa nello scontro con la Cina sui modelli di intelligenza artificiale, ormai diventati anche strumenti geopolitici di soft power.

Si può leggere così il lancio dei primi modelli linguistici di grandi dimensioni (LLM) OpenAI a “peso aperto” (open-weight).

Indice degli argomenti

OpenAI gpt-oss-120b e gpt-oss-20b

Sono in effetti i primi della nuova era dell’AI; l’ultimo aperto è stato GPT-2 del 2019. Questa mossa, che introduce i modelli gpt-oss-120b e gpt-oss-20b, segna un’importante inversione di rotta strategica dopo anni in cui l’azienda aveva prevalentemente adottato un approccio a codice chiuso, guadagnandosi persino il soprannome dispregiativo di “ClosedAI”.

Questi nuovi modelli sono stati concepiti per garantire accessibilità e flessibilità di implementazione, essendo in grado di operare localmente su hardware di consumo, come laptop e telefoni cellulari di fascia alta (nel caso del gpt-oss-20b), o su singole GPU di livello enterprise (per il gpt-oss-120b), pur mantenendo prestazioni paragonabili ai modelli proprietari o3-mini e o4-mini di OpenAI.

Licenza Apache 2.0

Un aspetto fondamentale di questa iniziativa è il rilascio dei modelli sotto la licenza permissiva Apache 2.0, che ne consente l’ampio utilizzo commerciale, la modifica e la ridistribuzione. Questa scelta si discosta notevolmente dalle licenze più restrittive adottate da altri attori di primo piano nel settore, come Meta con i suoi modelli Llama, e indica una chiara intenzione di favorire una più ampia adozione e collaborazione all’interno della comunità dell’IA aperta.

Nathan Lambert, responsabile del post-training presso l’Allen Institute for AI, afferma che questa scelta è lodevole: “Tali licenze sono tipiche dei modelli aperti cinesi, ma Meta ha rilasciato i suoi modelli Llama con una licenza personalizzata e più restrittiva. È un’ottima cosa per la comunità aperta”.

La portata di questo riavvicinamento strategico da parte di OpenAI trascende la mera introduzione di un prodotto tecnico; essa rappresenta una risposta calcolata a un panorama globale dell’IA in rapida evoluzione e intensamente competitivo, profondamente influenzato da considerazioni geopolitiche.

La Cina sta diventando leader dell’AI grazie all’open

Il lungo intervallo senza nuove release di LLM aperti da parte di OpenAI aveva creato un vuoto, alimentando la frustrazione degli utenti e favorendo l’emergere di potenti modelli aperti sviluppati da altre entità, in particolare dalla Cina.

In un’esplicita dichiarazione sul blog, OpenAI ha inquadrato questo rilascio come un contributo all’espansione dei “binari democratici dell’IA” e come un allineamento con le priorità politiche degli Stati Uniti, sottolineando la dimensione strategica nazionale dello sviluppo dell’IA.

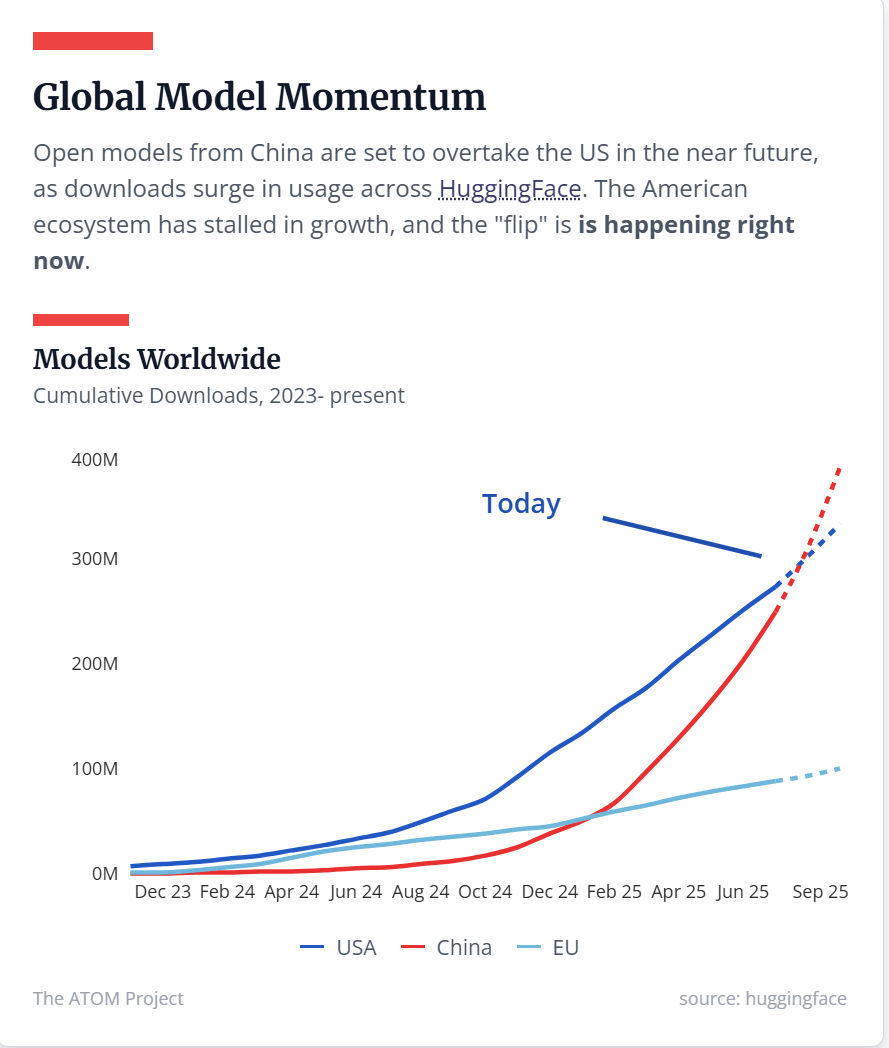

Negli ultimi anni, si è assistito a un fenomeno di “ribaltamento” (flippening) nel dominio dei modelli aperti, con le offerte cinesi, tra cui quelle di DeepSeek, Kimi K2 e la serie Qwen di Alibaba, che hanno guadagnato una popolarità e una quota di mercato significative. Questi modelli hanno spesso superato le controparti americane, come Llama di Meta, in termini di adozione e, in alcuni benchmark, di prestazioni pure. Questo “ribaltamento”, particolarmente evidente nelle tendenze di download cumulativo su piattaforme come Hugging Face, costituisce una sfida diretta alla leadership americana nella ricerca e applicazione dell’IA, sollevando notevoli preoccupazioni riguardo all’influenza tecnologica globale e alla definizione dei futuri standard dell’IA.

Un aspetto critico di questa ascesa cinese è la documentata integrazione di allineamenti ideologici e censura politica in alcuni modelli cinesi, il che pone una profonda sfida etica e geopolitica per le nazioni democratiche in relazione all’accesso alle informazioni e al pregiudizio algoritmico.

Il riavvicinamento di OpenAI ai modelli aperti mira a riaffermare il suo status di riferimento nell’ecosistema dell’IA, a fornire un’offerta di prodotti completa agli utenti, ad accelerare la ricerca e l’innovazione nell’IA su più ampia scala e ad allinearsi strategicamente con l’emergente strategia nazionale statunitense sull’IA. Il governo degli Stati Uniti, attraverso iniziative come l’AI Action Plan del 2025 dell’amministrazione Trump, sta attivamente promuovendo lo sviluppo interno dell’IA aperta.

In questa logica si colloca anche il Project ATOM dell’esperto Nathan Lambert che ha come scopo dichiarato quello di “Rinvigorire la ricerca sull’intelligenza artificiale negli Stati Uniti attraverso la creazione di modelli aperti e all’avanguardia”.

L’obiettivo di queste iniziative è salvaguardare la leadership americana, proteggere la propria pila tecnologica dell’IA e proiettare i “valori americani” a livello globale, inquadrando la corsa all’IA come una componente cruciale della sicurezza nazionale.

Questa complessa interazione tra l’innovazione del settore privato e la politica nazionale sottolinea il ruolo innegabile dell’IA come strumento critico di soft power e di competizione tecnologica, destinato a plasmare i futuri standard globali, la prosperità economica e l’influenza internazionale.

Il nexus geopolitico: l’IA come nuova dimensione del soft power e dell’influenza globale

Durante gli anni in cui OpenAI ha adottato prevalentemente un approccio a codice chiuso, si è verificato un significativo cambiamento nel panorama globale dell’IA aperta. I modelli aperti cinesi, in particolare quelli di DeepSeek, Kimi K2 e la serie Qwen di Alibaba, hanno rapidamente guadagnato popolarità e, in molti casi, hanno superato le loro controparti americane in termini di adozione e, in alcuni benchmark, di prestazioni pure. DeepSeek, con il suo ingresso di impatto all’inizio del 2025, è diventato rapidamente un attore di spicco. Una caratteristica chiave osservata in molti modelli cinesi, incluso DeepSeek, è la loro tendenza a rifiutarsi di discutere argomenti ritenuti politicamente sensibili o proibiti dal Partito Comunista Cinese (PCC), come il massacro di Piazza Tienanmen.

Già a luglio 2023, modelli cinesi come Kimi-K2, Qwen3, GLM-4, HunyuanWorld di Tencent e Wan 2.2 di Alibaba hanno mostrato un notevole aumento di popolarità su Hugging Face, una piattaforma leader per la condivisione di modelli di machine learning, occupando frequentemente le prime posizioni di tendenza. Ciò ha indicato un significativo cambiamento nell’impegno della comunità globale dell’IA.

A metà del 2025, i modelli di IA open-source cinesi dominavano le classifiche globali su piattaforme di benchmarking, con aziende come DeepSeek e Alibaba che offrivano prestazioni di livello mondiale che rivaleggiavano, e talvolta superavano, le offerte della Silicon Valley. Esempi specifici includono Kimi K2, MiniMax M1, Qwen 3 e varie varianti di DeepSeek R1 che si sono classificate davanti ai modelli di Google e Meta su una piattaforma di benchmarking dell’Università della California, Berkeley.

In termini di penetrazione del mercato, i modelli di DeepSeek detenevano una quota del 24% in OpenRouter, un mercato globale di modelli di IA, a metà luglio, rendendolo il secondo sviluppatore di modelli più popolare a livello globale, appena dietro Google. La famiglia di modelli Qwen di Alibaba si è affermata come il più grande ecosistema di IA open-source al mondo, vantando oltre 100.000 modelli derivati costruiti su di essa, superando la comunità Llama di Meta Platforms, secondo Hugging Face.

Il rapporto Project ATOM di Nathan Lambert documenta esplicitamente questo fenomeno, illustrando come i modelli cinesi stiano “ribaltando” le offerte americane come Llama in termini di adozione e slancio delle prestazioni.

L’analisi del rapporto sulle tendenze di download cumulativo su Hugging Face indica che questo “ribaltamento” – in cui i modelli cinesi sono destinati a superare i modelli statunitensi nell’uso complessivo e nell’influenza – è in atto. Questa tendenza non è accidentale ma riflette un’iniziativa strategica deliberata e più ampia da parte delle aziende tecnologiche cinesi per sfruttare le metodologie open-source come mezzo per accelerare l’innovazione, favorire la collaborazione ed espandere la loro impronta globale nel settore dell’IA.

L’adozione aggressiva da parte della Cina di modelli open-source e open-weight è una strategia deliberata e multifaccettata per conquistare una quota di mercato globale significativa e stabilire i propri modelli come standard de facto del settore. Offrendo modelli ad alte prestazioni e gratuiti, le aziende cinesi stanno di fatto democratizzando l’accesso all’IA avanzata, attraendo in particolare sviluppatori e organizzazioni nei mercati emergenti e nelle regioni con risorse limitate.

Questa strategia mira a incorporare il loro stack tecnologico e, implicitamente, i loro valori e le loro norme sottostanti nel panorama globale dello sviluppo dell’IA, creando una dipendenza e un’influenza a lungo termine. Se uno sviluppatore o una startup in un paese in via di sviluppo può accedere a un modello cinese ad alte prestazioni gratuitamente o a un costo significativamente inferiore rispetto alle alternative proprietarie, si orienterà naturalmente verso di esso.

Questa adozione diffusa crea un potente effetto di rete: più utenti portano a più feedback, più modelli derivati e una comunità più ampia familiarizzata con l’ecosistema cinese. Non si tratta solo di superiorità tecnica; si tratta di costruire una base di utenti globale e una rete di influenza, in modo simile a come i sistemi operativi o le piattaforme di social media hanno raggiunto il dominio globale. Oppure come accaduto con il 5G cinese. Questa penetrazione economica ha implicazioni geopolitiche dirette, poiché la dipendenza tecnologica si traduce spesso in leva diplomatica e soft power.

L'”apertura” di molti modelli cinesi presenta un profondo paradosso: sebbene i pesi del modello siano spesso accessibili per l’ispezione e l’uso, i dati di addestramento sottostanti e i processi di allineamento incorporano frequentemente la censura sanzionata dallo stato e specifici pregiudizi ideologici.

Ciò significa che l’adozione di questi modelli apparentemente “aperti” può inavvertitamente portare alla sottile propagazione di valori politici specifici, narrazioni e meccanismi di controllo delle informazioni, rappresentando una forma sofisticata e insidiosa di soft power. Gli utenti potrebbero inizialmente adottare un modello cinese puramente per le sue prestazioni tecniche, la sua economicità o la sua accessibilità, senza comprendere appieno o preoccuparsi dei suoi pregiudizi intrinseci. Tuttavia, nel tempo, l’interazione costante con modelli progettati per filtrare o modellare le informazioni secondo le narrazioni statali potrebbe influenzare sottilmente le percezioni degli utenti, l’accesso alle informazioni e persino i quadri cognitivi, in particolare su argomenti geopolitici sensibili. Ciò trasforma i modelli di IA da strumenti neutrali a strumenti di influenza ideologica, operando ben oltre la loro immediata utilità tecnica. Ciò solleva questioni critiche sulla trasparenza algoritmica e sul potenziale di uno spazio informativo globale frammentato.

L’IA come vettore di soft power e influenza geopolitica

L’intelligenza artificiale è sempre più riconosciuta come uno strumento critico di potere nazionale, paragonabile al nuovo “arsenale nucleare” del soft power. Essa rimodella fondamentalmente il modo in cui le nazioni proiettano la loro influenza a livello globale e come percepiscono il proprio potenziale di leadership sulla scena internazionale. La corsa contemporanea alla supremazia nell’IA si estende ben oltre la mera potenza computazionale o l’efficienza algoritmica.

Essa comprende le dimensioni cruciali del controllo narrativo, della leadership etica e della capacità di plasmare il quadro stesso attraverso il quale l’umanità affronta i suoi prossimi balzi tecnologici e sociali. Ogni significativo progresso nell’IA, sia nell’elaborazione del linguaggio naturale che nella visione artificiale, diventa immediatamente un asset di soft power. Serve come dimostrazione tangibile non solo della destrezza tecnologica di una nazione, ma anche della sua leadership culturale e intellettuale su scala globale.

Le nazioni che possiedono o controllano grandi set di dati di alta qualità ottengono un vantaggio intrinseco e significativo nello sviluppo dell’IA, poiché i dati sono il carburante per questi sistemi. Il modo in cui i paesi scelgono di gestire, condividere o limitare l’accesso alle proprie risorse di dati diventa una profonda dichiarazione dei loro valori e un potente strumento di influenza. I dati non sono più solo “il nuovo petrolio”; sono sempre più visti come “il nuovo patrimonio culturale”, che plasma il modo in cui le generazioni future comprenderanno e interagiranno con il mondo.

L’intensa competizione globale per attrarre e trattenere i migliori talenti dell’IA è emersa come una dimensione cruciale della proiezione del soft power. Università, laboratori di ricerca di spicco e le principali aziende tecnologiche sono ora considerate le “nuove ambasciate culturali”, con la loro capacità di attrarre e trattenere i principali ricercatori di IA che funge da metrica diretta dell’influenza nazionale e del prestigio scientifico.

Mentre le piattaforme digitali e le tecnologie AI hanno apparentemente democratizzato la capacità di proiettare influenza culturale e diffondere informazioni a livello globale, hanno contemporaneamente creato nuove forme di concentrazione del potere. Questa concentrazione si manifesta attraverso il gatekeeping algoritmico (dove l’AI determina quali contenuti vengono visualizzati) e la supremazia tecnologica (dove pochi attori dominanti controllano l’infrastruttura AI fondamentale), portando a un paradosso in cui l’influenza è sia distribuita che altamente centralizzata.

I modelli linguistici di grandi dimensioni, in particolare, non sono strumenti tecnologici neutrali; sono intrinsecamente intrisi dei valori, dei quadri etici e persino delle norme politiche dei loro creatori, dei loro dati di addestramento e delle società in cui vengono sviluppati. Quando questi modelli raggiungono un’ampia adozione globale, funzionano come “moltiplicatori di valori“, propagando sottilmente ma potentemente quei principi incorporati oltre i confini. Ciò eleva la “corsa all’IA” oltre la mera competizione tecnica a un confronto su quale IA plasmerà in definitiva il pensiero globale, il comportamento e le norme sociali.

Se un modello di IA, attraverso le sue risposte o la generazione di contenuti, promuove costantemente determinate narrazioni, dà priorità a specifiche considerazioni etiche o evita particolari argomenti (come si vede con i modelli cinesi), plasma l’ambiente informativo per i suoi utenti in tutto il mondo. Questa influenza è più pervasiva e potenzialmente più insidiosa della propaganda tradizionale perché è incorporata in uno strumento tecnologico apparentemente obiettivo. Di conseguenza, la scelta di un modello di IA da parte di un governo, di un’azienda o di un individuo diventa un’approvazione implicita dei suoi valori sottostanti e un contributo alla propagazione globale di tali valori. Ciò rende lo sviluppo dell’IA una componente fondamentale della politica estera e della diplomazia culturale di una nazione.

Il dominio nello sviluppo e nella diffusione di massa di modelli di IA crea un ciclo di feedback geoeconomico-geopolitico. Il successo tecnologico si traduce in vantaggi economici (ad esempio, quote di mercato, entrate, creazione di posti di lavoro), che a loro volta rafforzano la capacità di una nazione di investire ulteriormente nella ricerca e nello sviluppo dell’IA, consolidando il suo vantaggio competitivo.

Questa spirale ascendente non solo rafforza la posizione economica di una nazione, ma proietta anche un’immagine di leadership e innovazione, rafforzando il suo soft power e la sua influenza diplomatica. In questo contesto, l’IA diventa un catalizzatore per la prosperità nazionale e un potente strumento per plasmare l’ordine internazionale. La nazione che vince la “corsa all’IA” non solo controlla una tecnologia chiave, ma definisce anche le regole del gioco per il futuro digitale globale, influenzando gli standard tecnici, i quadri etici e le norme di governance.

Ciò ha implicazioni significative per l’allineamento delle alleanze, le relazioni commerciali e la capacità di una nazione di proiettare i propri valori e interessi a livello globale.

La strategia Usa per rispondere alla minaccia

Per rispondere al problema, il Progetto ATOM raccomanda che, per riconquistare la leadership globale nell’IA open-source, gli Stati Uniti debbano mantenere più laboratori dedicati all’addestramento di modelli aperti con oltre 10.000 GPU all’avanguardia. Attualmente, la Repubblica Popolare Cinese dispone di almeno cinque laboratori che producono e rilasciano modelli aperti con capacità pari o superiori a quelle del miglior modello aperto statunitense.

Il piano Trump

L’amministrazione Trump ha anch’essa enfatizzato lo sviluppo di modelli aperti nel suo “AI Action Plan” del 2025, intitolato “Winning the Race: America’s AI Action Plan”. Questo piano delinea oltre 90 posizioni politiche federali su tre pilastri chiave: accelerare l’innovazione, costruire l’infrastruttura AI americana e guidare la diplomazia e la sicurezza internazionale dell’IA.

Il piano mira a garantire che gli USA abbiano modelli aperti leader fondati sui valori americani. Riconosce esplicitamente che “i modelli open-source e open-weight potrebbero diventare standard globali in alcune aree di business e nella ricerca accademica in tutto il mondo. Per questo motivo, hanno anche un valore geostrategico”. Il piano propone inoltre di rafforzare l’applicazione dei controlli sulle esportazioni per proteggere l’innovazione americana nell’IA e promuovere l’adozione degli stack di IA americani all’interno di un’alleanza globale.

Tra le azioni specifiche figurano l’accelerazione della maturazione di un “sano mercato finanziario per il calcolo” per fornire un migliore accesso alla potenza di calcolo su larga scala per accademici e startup, l’aumento dell’accesso della comunità di ricerca al calcolo, ai modelli e ai dati del settore privato, e la promozione dell’adozione di modelli open-source e open-weight da parte delle piccole e medie imprese.

Il ruolo OpenAI

OpenAI ora si allinea esplicitamente con questa posizione, come indicato nei documenti relativi al piano d’azione, dove ha chiaramente espresso di considerare il rapporto Stati Uniti-Cina una questione chiave e di volersi posizionare come un attore di grande importanza per il sistema statunitense. OpenAI ha dichiarato che i suoi modelli open-weight sono progettati per allinearsi alle priorità politiche statunitensi che godono di ampio sostegno nello spettro politico. L’azienda vede i modelli open-weight come un modo per “espandere i binari democratici dell’IA” e per aiutare gli alleati e i partner degli Stati Uniti a costruire infrastrutture AI radicate nei valori democratici. Questo è particolarmente rilevante per gli “swing states”, per i quali la disponibilità di potenti modelli open-weight sarà un incentivo a costruire su un’IA democratica piuttosto che su un’IA autocratica.

La strategia statunitense, esemplificata dal Progetto ATOM e dal Piano d’Azione AI dell’amministrazione Trump, riflette una profonda comprensione del fatto che la competizione per l’IA è una guerra tecnologica con implicazioni che vanno ben oltre il dominio tecnico. Si tratta di una competizione per definire gli standard globali, proiettare i valori e garantire la sicurezza nazionale in un’era in cui l’IA è fondamentale per la prosperità economica e l’influenza geopolitica. L’investimento nei modelli aperti nazionali è visto come essenziale per mantenere la leadership nella ricerca fondamentale sull’IA, massimizzare la quota di mercato dell’IA negli Stati Uniti e proteggere lo stack di IA statunitense.

Insomma: la decisione di OpenAI di rilasciare i modelli gpt-oss è un passo strategico che si inserisce in questo contesto geopolitico più ampio. Non è solo una risposta tecnologica e imprenditoriale alle azioni intraprese da altre aziende di IA, ma una mossa calcolata per riaffermare la posizione di OpenAI come punto di riferimento per gli utenti di modelli aperti e per allinearsi con le priorità politiche statunitensi.

Man mano che OpenAI continua a sviluppare la sua vasta infrastruttura computazionale, avrà bisogno di supporto e approvazioni politiche, e una leadership comprensiva potrebbe fare molto in tal senso.

La competizione per il dominio dell’IA aperta è una manifestazione di una più ampia rivalità sistemica tra Stati Uniti e Cina. Entrambe le nazioni riconoscono che il controllo sui modelli fondamentali dell’IA e sugli ecosistemi associati conferisce un vantaggio strategico a lungo termine, non solo in termini economici e militari, ma anche nella capacità di plasmare l’ordine internazionale. La strategia statunitense di promuovere l’IA aperta nazionale e di allineare le aziende private con le priorità governative è un tentativo di contrastare la crescente influenza cinese e di garantire che il futuro dell’IA sia plasmato da principi democratici. Ciò implica un’integrazione più stretta tra il settore privato e le politiche governative, riconoscendo che la sicurezza nazionale nell’era dell’IA richiede un approccio olistico che abbracci la ricerca, lo sviluppo, l’infrastruttura e la proiezione internazionale.

Sicurezza e considerazioni etiche nell’era dell’IA aperta

Il rilascio di modelli di IA open-weight, pur offrendo notevoli vantaggi in termini di accessibilità e innovazione, introduce anche un profilo di rischio unico e complesse considerazioni etiche, in particolare nel contesto della competizione geopolitica.

I modelli di IA open-source, se utilizzati da attori malevoli, possono rappresentare gravi minacce alla pace internazionale, alla sicurezza e ai diritti umani. Modelli open-source altamente capaci potrebbero essere riproposti da attori con intenti malevoli per perpetrare crimini, causare danni o persino disturbare e minare i processi democratici. La natura stessa dell’open-source, progettata per promuovere trasparenza, condivisione della conoscenza, sviluppo guidato dalla comunità e collaborazione, rende questi modelli intrinsecamente accessibili.

Questa accessibilità, tuttavia, comporta rischi significativi. Tali modelli e strumenti potrebbero essere sfruttati da attori statali e non statali per spionaggio, sorveglianza, guerra cibernetica, disinformazione e propaganda, e sviluppo di armi.

Ciò solleva rischi geopolitici e ha implicazioni per la sicurezza nazionale, poiché le infrastrutture critiche potrebbero essere attaccate e i gruppi terroristici potrebbero guidare il reclutamento e personalizzare le campagne di propaganda, aggirando o sovvertendo i sistemi di rilevamento e moderazione. La disinformazione sistematica da parte di attori non statali o sostenuti dallo stato potrebbe fomentare disordini civili e violare la pace pubblica. Ci sono state segnalazioni confermate di attori estremisti e terroristici che utilizzano strumenti e modelli di IA pubblicamente disponibili per migliorare la portata delle loro operazioni.

L’FBI ha avvertito che i modelli open-source hanno attratto criminali informatici e attori in malafede che li utilizzano per sviluppare malware e attacchi di phishing.

La risposta OpenAI

OpenAI ha cercato di affrontare queste preoccupazioni di sicurezza attraverso un approccio multifaccettato nello sviluppo di gpt-oss. I modelli sono stati sottoposti a un rigoroso addestramento di sicurezza e a valutazioni basate sugli standard di sicurezza interni di OpenAI. Ciò include il filtraggio di dati dannosi specifici relativi a fattori chimici, biologici, radiologici e nucleari (CBRN) durante la fase di pre-addestramento. Durante il post-addestramento, sono state utilizzate tecniche di allineamento e gerarchia delle istruzioni per insegnare ai modelli a rifiutare prompt non sicuri e a proteggersi dagli attacchi di iniezione di prompt.

Inoltre, OpenAI ha condotto un fine-tuning avversariale, perfezionando i modelli su dati specifici di sicurezza biologica e informatica per imitare i metodi degli attaccanti. I test hanno dimostrato che, anche dopo il fine-tuning utilizzando lo stack di addestramento leader del settore di OpenAI, questi modelli perfezionati in modo dannoso non sono riusciti a raggiungere prestazioni elevate. OpenAI ha dichiarato che questi processi segnano un significativo passo avanti nella sicurezza dei modelli open-source, con la speranza che contribuiscano a promuovere la formazione sicura e la ricerca sull’allineamento in tutto il settore.

Per creare un ecosistema open-source più sicuro, OpenAI ha lanciato una “Red Team Challenge” con un premio di 500.000 dollari per incoraggiare ricercatori, sviluppatori e appassionati di tutto il mondo a contribuire all’identificazione di nuovi problemi di sicurezza. Questa iniziativa riconosce che la sicurezza dei modelli open-source è una responsabilità condivisa e richiede un approccio collaborativo.

Il tema etico

Le considerazioni etiche si estendono anche alla questione della censura e del bias ideologico, in particolare per quanto riguarda i modelli di IA cinesi. Osservatori hanno notato che i modelli cinesi spesso si rifiutano di parlare di argomenti che il Partito Comunista Cinese ha ritenuto proibiti, come Piazza Tienanmen. Questa censura è incorporata direttamente nell’architettura dei sistemi di IA cinesi attraverso l’addestramento su set di dati che istruiscono l’IA su come classificare e classificare i contenuti sensibili, garantendo che i modelli si muovano nella “corretta direzione politica”. Ciò solleva serie preoccupazioni tra gli esperti di IA riguardo alla crescente adozione di modelli cinesi, in quanto possono propagare sottilmente narrazioni statali e limitare l’accesso a informazioni non allineate.

Open è trasparente

Da un altro punto di vista, la trasparenza e la responsabilità sono fondamentali per la sicurezza dell’IA. Mentre i modelli di IA open-source operano già sotto protocolli open-source, rendendo il loro codice o i loro pesi verificabili e aperti ai contributori, è importante che gli sviluppatori mettano in atto meccanismi che prevengano gli abusi, come il controllo delle versioni e gli strumenti di registrazione per tracciare le modifiche. La mancanza di metodi e pratiche comuni nella gestione dei difetti del modello segnalati dagli utenti è una sfida attuale nel settore.

La natura intrinseca dei modelli open-weight, una volta rilasciati, implica che il controllo sulla loro implementazione e modifica si sposta dall’entità sviluppatrice alla comunità globale. Questo comporta una distribuzione del rischio e della responsabilità di sicurezza. Sebbene OpenAI abbia compiuto sforzi significativi per integrare salvaguardie e promuovere la “red teaming”, la possibilità che attori malevoli riadattino i modelli per scopi dannosi rimane una preoccupazione fondamentale.

Questa situazione sottolinea la necessità di un quadro di governance globale che vada oltre le singole aziende, per affrontare le sfide di sicurezza e di uso improprio che trascendono i confini nazionali. La corsa all’IA non è solo una competizione per la superiorità tecnica, ma anche una gara per definire le norme di sicurezza e le pratiche etiche che regoleranno questa tecnologia trasformativa.

Il dibattito tra modelli aperti e chiusi è persistente, e le aziende stanno adattando le loro strategie. A differenza di OpenAI, che ha riabbracciato l’open-source, Meta potrebbe orientarsi verso una strategia software più conservativa e a codice chiuso, in seguito alla recente creazione del suo Superintelligence Lab. Questo dibattito sottolinea la complessità intrinseca della sicurezza nell’IA, dove l’apertura può favorire l’innovazione e la trasparenza, ma anche esporre a nuovi vettori di attacco e a rischi di uso improprio. La sfida consiste nel trovare un equilibrio che massimizzi i benefici dell’IA democratizzata minimizzando i suoi potenziali pericoli.

Approfondimento tecnico: capacità di gpt-oss-120b e gpt-oss-20b

Sia gpt-oss-120b che gpt-oss-20b sono fondamentalmente costruiti sull’architettura Transformer, che è diventata lo standard de facto per gli LLM moderni. Un’innovazione chiave è l’utilizzo della tecnologia Mixture-of-Experts (MoE). MoE consente a questi modelli di essere molto grandi in termini di parametri totali, attivando al contempo un sottoinsieme più piccolo di parametri (esperti) per ogni token di input. Ciò riduce significativamente il costo computazionale durante l’inferenza, rendendoli più efficienti rispetto ai modelli densi con un numero totale di parametri comparabile. Nello specifico, gpt-oss-120b ha un totale di 117 miliardi di parametri ma ne attiva solo 5,1 miliardi per token, mentre gpt-oss-20b ha 21 miliardi di parametri totali attivando 3,6 miliardi per token.

Ulteriori scelte architettoniche includono le attivazioni SwiGLU e i “sink” di attenzione appresi. Essi alternano anche meccanismi di attenzione densi e sparsi a banda locale, contribuendo alla loro efficienza. L’implementazione dell’Embedding Posizionale Rotazionale (RoPE) consente a questi modelli di supportare lunghezze di contesto eccezionalmente lunghe, fino a 128.000 token. Questo è cruciale per compiti che richiedono la comprensione e il ragionamento su documenti o conversazioni estese.

Il modello gpt-oss-120b, più grande, è progettato per casi d’uso di produzione, per scopi generali e per ragionamenti complessi. La sua efficienza gli consente di funzionare efficacemente su una singola GPU da 80 GB, come una NVIDIA H100, rendendolo accessibile a molti ambienti aziendali e di ricerca. Il modello gpt-oss-20b, più piccolo, è ottimizzato per una latenza inferiore e per applicazioni locali o specializzate.

Può funzionare comodamente su hardware di consumo, in particolare un laptop con soli 16 GB di RAM, o persino un telefono cellulare di fascia alta. OpenAI ha collaborato con Microsoft per garantire che le versioni ottimizzate di questi modelli funzionino in modo efficiente sui dispositivi Windows, ampliandone la portata.

Prestazioni

Per quanto riguarda le prestazioni, il gpt-oss-120b dimostra una quasi parità con il modello proprietario o4-mini di OpenAI nei benchmark di ragionamento di base.7 Supera significativamente l’o3-mini di OpenAI e raggiunge o supera l’o4-mini in aree critiche come la programmazione competitiva (Codeforces), la risoluzione di problemi generali (MMLU, HLE) e l’uso di strumenti (TauBench). In particolare, supera persino l’o4-mini in domini specializzati come le query relative alla salute (HealthBench) e la matematica competitiva (AIME). Nonostante le sue dimensioni ridotte, il modello gpt-oss-20b raggiunge prestazioni paragonabili all’o3-mini di OpenAI nei benchmark comuni. Supera anche l’o3-mini nella matematica competitiva e nei compiti relativi alla salute. Entrambi i modelli offrono una caratteristica unica che consente agli sviluppatori di configurare lo “sforzo di ragionamento” (basso, medio, alto) tramite un semplice messaggio di sistema, consentendo un equilibrio tra latenza e prestazioni in base alle esigenze specifiche del caso d’uso.

I modelli gpt-oss sono esplicitamente progettati per flussi di lavoro agentici, dimostrando una robusta capacità di seguire le istruzioni, un efficace utilizzo degli strumenti (come la ricerca web e l’esecuzione di codice Python) e un sofisticato ragionamento a catena di pensiero. Questo li posiziona bene per la creazione di agenti AI autonomi. Sono anche in grado di integrarsi perfettamente con i servizi cloud di OpenAI, che possono fornire funzionalità aggiuntive, come l’elaborazione multimodale, quando richiesto.

L’implicazione tecnica più profonda di questa release è la democratizzazione delle capacità avanzate dell’IA. La possibilità di eseguire modelli con prestazioni quasi pari a quelle di o4-mini su hardware di consumo facilmente reperibile (ad esempio, 16 GB di RAM per gpt-oss-20b) rappresenta un significativo balzo in avanti nel rendere l’IA potente accessibile oltre le grandi aziende o le istituzioni di ricerca. Questo abbassa drasticamente la barriera all’ingresso per i singoli sviluppatori, le piccole startup e persino gli utenti in ambienti con risorse limitate, favorendo una diffusa sperimentazione, innovazione e sviluppo locale dell’IA.

Storicamente, l’accesso alle capacità degli LLM di frontiera richiedeva investimenti sostanziali in risorse di cloud computing o hardware specializzato e costoso. Rendendo questi modelli eseguibili su dispositivi comuni, OpenAI rimuove un importante ostacolo economico e logistico.

Effetto rete

Ciò significa che un pool di talenti molto più ampio e diversificato può ora interagire direttamente con l’architettura di OpenAI, eseguirne il fine-tuning e costruire applicazioni su di essa.

Questa adozione diffusa potrebbe portare a una maggiore familiarità con l’ecosistema di OpenAI, creando potenzialmente un “effetto di rete” che a lungo termine gioverebbe a OpenAI, poiché un numero maggiore di sviluppatori acquisirebbe competenza con i suoi strumenti e modelli, portando a una maggiore adozione complessiva delle sue tecnologie, inclusi i suoi servizi ospitati.

Affronta inoltre direttamente le crescenti preoccupazioni sulla privacy e la sovranità dei dati, consentendo l’elaborazione locale di dati sensibili, dietro il firewall di un’organizzazione.

Le prestazioni di gpt-oss-20b su un laptop standard o persino su un telefono di fascia alta ridefiniscono fondamentalmente l’aspettativa di ciò che l’IA “utile” può realizzare su dispositivi locali.

Questa nuova base accelererà probabilmente lo sviluppo di applicazioni AI edge e ridurrà la dipendenza da un’infrastruttura cloud continua per molte attività comuni di IA, influenzando così i modelli di business esistenti e intensificando le discussioni sulla sovranità dei dati e sull’IA decentralizzata.

Se un modello capace di svolgere compiti a livello o3-mini può funzionare in modo efficiente su un telefono cellulare, si sposta il paradigma per l’IA su dispositivo. Ciò apre categorie completamente nuove di applicazioni per l’uso offline, una maggiore privacy personale (poiché i dati non lasciano il dispositivo) e costi operativi significativamente ridotti per alcuni casi d’uso.

Questa capacità sfida direttamente le strategie di IA incentrate sul cloud adottate da molte aziende, dimostrando un’alternativa locale valida e performante. Implica anche un futuro in cui l’IA sarà profondamente integrata nei dispositivi personali, offrendo un’assistenza ubiqua e sempre attiva senza una connettività di rete costante.

Riavvicinarsi alla community open

La release di gpt-oss è anche uno sforzo diretto e deliberato per riavvicinarsi alla più ampia comunità dell’IA aperta, migliorare la propria immagine pubblica e riaffermare la leadership e l’influenza di OpenAI nell’ecosistema globale di ricerca e sviluppo dell’IA.

La quota di mercato di OpenAI nel settore dell’IA aziendale ha subito un calo significativo, passando dal 50% nel 2024 al 25% nel 2025. Questa perdita sostanziale è attribuita alla feroce concorrenza sia da parte di fornitori a codice chiuso consolidati come Anthropic e Google, sia alla rapida crescita della popolarità e dell’adozione di alternative open-source, in particolare la serie Llama di Meta.

Questo rilascio open-weight è progettato per colmare il divario strategico tra i modelli puramente a codice chiuso (che offrono facilità d’uso e supporto del fornitore) e i modelli completamente open-source (che offrono un’ampia personalizzazione e risparmi sui costi), mirando a conquistare quote di mercato da entrambi i segmenti. Inoltre, l’hosting dei modelli gpt-oss su piattaforme ampiamente utilizzate come Hugging Face, Databricks, Azure e AWS garantisce che OpenAI mantenga una presenza cruciale nei diversi ambienti in cui operano già aziende e sviluppatori, facilitando l’integrazione e l’adozione.

Un imperativo fondamentale è abbassare le barriere all’ingresso per la tecnologia AI avanzata, rendendola più accessibile ai mercati emergenti, ai settori con risorse limitate e alle organizzazioni più piccole che potrebbero non avere l’infrastruttura o il budget per implementazioni cloud su larga scala. Il co-fondatore di OpenAI, Greg Brockman, ha sottolineato che i modelli aperti consentono in modo unico agli utenti di eseguirli localmente, dietro i propri firewall e sulla propria infrastruttura, affrontando preoccupazioni critiche relative alla sovranità e al controllo dei dati. Sam Altman ha espresso un forte ottimismo sul fatto che questo rilascio catalizzerà “nuovi tipi di ricerca e la creazione di nuovi tipi di prodotti”, prevedendo un “aumento significativo del tasso di innovazione” nel campo dell’IA. La leadership di OpenAI ritiene che, rendendo la propria tecnologia ampiamente disponibile, gli utenti si affideranno ai loro progressi per future scoperte, fornendo feedback, dati e intuizioni inestimabili necessari per il miglioramento continuo del modello.

Per settori altamente regolamentati e sensibili come ospedali, studi legali e amministrazioni pubbliche, la capacità di eseguire modelli AI localmente è fondamentale per garantire la sicurezza dei dati e la conformità a rigorose normative sulla privacy. I modelli open-weight offrono una soluzione sicura e flessibile per sfruttare le capacità AI avanzate mantenendo le informazioni sensibili sotto stretto controllo locale, in particolare nelle giurisdizioni in cui i dati non possono legalmente lasciare il paese o dove i servizi cloud di terze parti non sono consentiti.

Il cambiamento strategico di OpenAI verso i modelli open-weight è un tentativo sofisticato e calcolato di recuperare la narrativa “aperta” che è stata sempre più dominata da concorrenti come Meta e varie aziende cinesi.

Questi concorrenti hanno guadagnato una significativa trazione di mercato e buona volontà della comunità abbracciando strategie di rilascio di modelli più aperti. Offrendo modelli open-weight competitivi, OpenAI cerca di ristabilirsi non solo come fornitore leader di servizi proprietari basati su API, ma come un attore centrale e influente nel più ampio ecosistema AI più decentralizzato. Questa mossa riguarda fondamentalmente l’influenza sulla mentalità e la promozione del blocco dell’ecosistema attraverso una maggiore accessibilità e collaborazione. Il soprannome “ClosedAI” non era solo un problema di pubbliche relazioni; rappresentava una perdita tangibile di influenza all’interno della comunità di ricerca e tra gli sviluppatori che sempre più favorivano alternative aperte. Rilasciando gpt-oss, OpenAI sta affrontando direttamente questa percezione. È una manovra strategica per garantire che la prossima ondata di innovazione AI, gran parte della quale avverrà probabilmente su piattaforme aperte, continui a essere costruita su o attorno alle tecnologie fondamentali di OpenAI. Se ricercatori e sviluppatori adottano gpt-oss come modello “cavallo di battaglia” per i loro progetti, OpenAI ne trarrà un immenso beneficio dalle loro scoperte, feedback e contributi, che potranno poi essere integrati nel loro più ampio ecosistema di modelli, creando un potente circolo virtuoso di innovazione, adozione e leadership continua.

Il cambiamento strategico di OpenAI segnala implicitamente un futuro in cui un modello di business ibrido – che offre sia servizi proprietari ad alte prestazioni basati su cloud sia modelli open-weight scaricabili e flessibili – diventerà un approccio standard e forse necessario per le aziende di IA di frontiera. Ciò consente a OpenAI di soddisfare efficacemente una vasta gamma di esigenze e preferenze dei clienti, da coloro che danno priorità alla convenienza e alla potenza pura (tramite API) a coloro che richiedono un maggiore controllo, personalizzazione e privacy dei dati (tramite implementazioni locali).

Questo approccio completo posiziona OpenAI per catturare un segmento significativamente più ampio del mercato dell’IA in evoluzione, offrendo uno spettro completo di soluzioni. Il mercato dell’IA si sta rapidamente segmentando. Alcuni utenti e aziende danno priorità alla facilità d’uso, alla scalabilità e alle prestazioni all’avanguardia, che sono meglio fornite tramite servizi API ospitati. Altri, in particolare in settori regolamentati o con specifiche preoccupazioni sulla privacy, richiedono la possibilità di eseguire modelli localmente, dietro i propri firewall, e di ottimizzarli con dati proprietari. Offrendo entrambi, OpenAI massimizza il suo mercato indirizzabile e riduce il rischio di essere emarginata da concorrenti puramente a codice chiuso o puramente open-source. Ciò aumenta anche la loro resilienza contro potenziali futuri cambiamenti negli ambienti normativi, nei requisiti di residenza dei dati o nelle preferenze degli utenti, diversificando efficacemente il loro portafoglio strategico.

–

Conclusioni

Il rilascio dei modelli gpt-oss da parte di OpenAI segna un momento cruciale nel panorama globale dell’intelligenza artificiale, riflettendo una complessa interazione di motivazioni tecniche, strategiche e, in particolare, geopolitiche. Questa mossa non è una semplice inversione di rotta, ma una ricalibrazione strategica mirata a riaffermare la posizione di OpenAI in un ecosistema dell’IA sempre più affollato e competitivo.

In sintesi, la mossa di OpenAI è un’audace dichiarazione di intenti che riconosce il ruolo ineludibile dell’IA aperta nel plasmare il futuro tecnologico e geopolitico. Il successo di questa strategia dipenderà non solo dalla capacità tecnica di OpenAI, ma anche dalla sua abilità di navigare in un complesso scacchiere globale, dove l’innovazione tecnologica è inestricabilmente legata alla proiezione del potere e dei valori.