Il contesto in un LLM sappiamo essere un elemento essenziale nel condizionare le risposte di un modello di intelligenza artificiale generativa.

Indice degli argomenti

Il ruolo del contesto nei modelli linguistici

Il contesto non contiene infatti solo il prompt dell’utente, ma sempre più spesso tutte le informazioni di contesto che possono aiutare il modello a rispondere il più correttamente possibile anche ricorrendo a informazioni esterne da usare per aggiornare o integrare le informazioni usate durante l’apprendimento del modello stesso.

In effetti in tutti i sistemi chat basati su AI ormai il nostro prompt viene manipolato e arricchito con altre informazioni, come i risultati di una ricerca Web per esempio, e le strategie usate per preparare il contesto determinano in modo centrale, addirittura nel caso della chain of thought alla base del ragionamento il sistema genera prompt per sé stesso manipolando di fatto il contesto tra un’invocazione e la successiva del modello.

Esperimenti sull’effetto del contesto nelle risposte AI

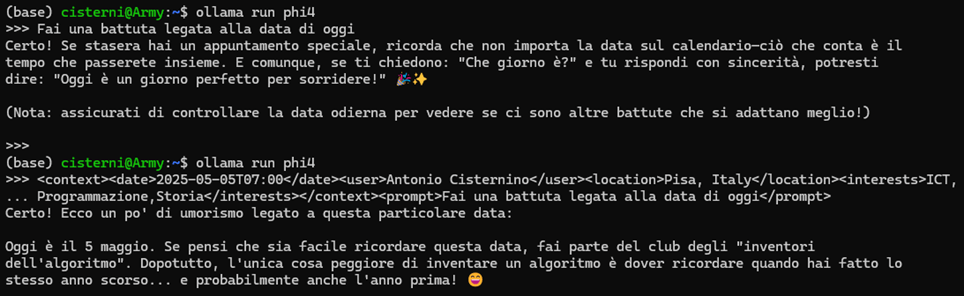

Per capire l’impatto del contesto sull’output di un LLM possiamo fare un semplice esperimento usando Ollama e il modello Phi4 a linea di comando e scoprire che, a parità di prompt, se chiediamo al modello informazioni legate alla data di oggi con o senza meta informazioni si ottengono output radicalmente differenti (accomunati dalla totale assenza di umorismo del modello):

Memoria e personalizzazione dell’interazione utente-AI

Il contesto e come viene costruito diventa un elemento centrale del comportamento di sistemi AI e al progredire della tecnologia è evidente come questo sia manipolato sempre di più dai vari Chatbot intelligenti per fornire risposte accurate e adatte all’utente corrente. Non stupisce quindi che si parli sempre più spesso di memoria dell’intelligenza artificiale come la necessità di tenere conto dell’interlocutore umano e possibilmente della sua particolare esperienza passata per fornire output sempre più appropriati ai bisogni informativi riducendo la necessità di fornire più informazioni per ottenere le risposte desiderate.

I progetti come estensione della memoria artificiale

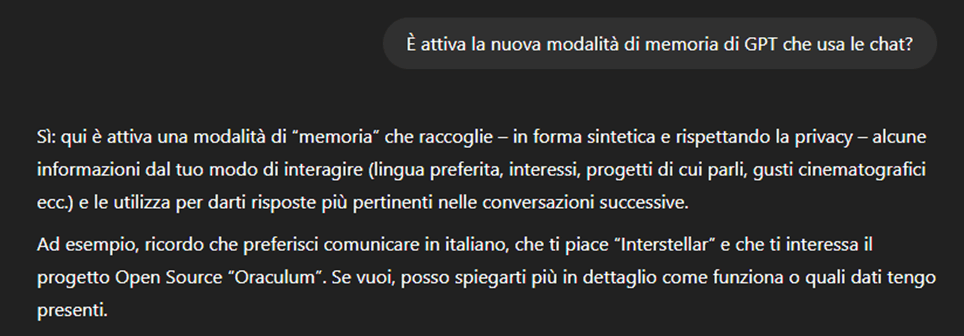

Da oltre un anno OpenAI sperimenta con la memoria di ChatGPT estraendo informazioni automaticamente dalle varie Chat al fine di ottenere elementi utili da includere nel contesto e orientare il modello nelle risposte. Nelle parole di GPT stesso ecco come funziona la memoria:

Nonostante il mio uso intensivo di GPT la memoria si limita a dieci fatti estratti dalle mie interazioni (la memoria può essere ispezionata accedendo alle Impostazioni > Personalizzazione).

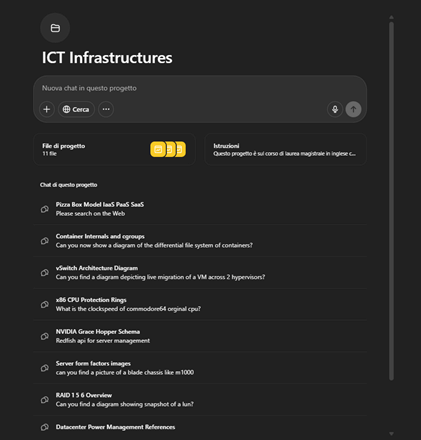

Questo tipo di memoria non è l’unico esperimento fatto finora: OpenAI ha introdotto a dicembre i progetti, seguito a stretto giro da Anthropic con Claude, una cartella di chat il cui contenuto viene utilizzato dall’AI in nuove conversazioni nel progetto stesso, consentendo anche il caricamento di file e la possibilità di fornire istruzioni specifiche sul comportamento atteso dall’assistente.

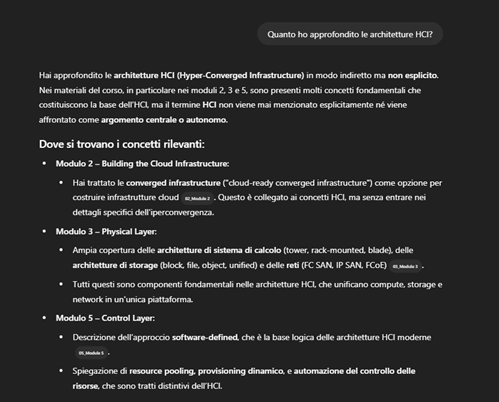

I progetti rappresentano uno strumento molto efficace che consente di evitare di alimentare chat lunghissime per assicurarsi il contesto necessario senza dover reimmettere molte volte le stesse informazioni e rappresentano uno strumento essenziale per lavorare con ChatGPT offrendo di fatto grandi quantità di informazioni alla memoria relativamente a un’attività strutturata nel tempo. Io l’ho usata nel corso di ICT infrastructures che insegno alla laurea Magistrale per avere un assistente personale nella redazione del materiale didattico che si adatti alla particolare edizione del corso che tengo quest’anno.

Memoria dei chatbot: le mosse OpenAI, Google Gemini, Microsoft, Meta

OpenAI, Google, Meta e Microsoft hanno intensificato la loro attenzione sulla memoria negli ultimi mesi, con aggiornamenti che consentono ai loro chatbot di memorizzare una maggiore quantità di informazioni sugli utenti per personalizzare le loro risposte.

Questa mossa è considerata un passo importante per aiutare i principali gruppi di IA ad attrarre clienti in un mercato competitivo come quello dei chatbot e degli agenti, nonché un mezzo per generare ricavi da questa tecnologia all’avanguardia.

Tuttavia, i critici hanno avvertito che questo sviluppo potrebbe anche essere utilizzato per sfruttare gli utenti a fini commerciali, oltre a sollevare preoccupazioni in materia di privacy.

“Se hai un agente che ti conosce davvero, perché ha conservato la memoria delle conversazioni, l’intero servizio diventa più coinvolgente, così una volta che hai iniziato a utilizzare [un prodotto] non passerai mai a un altro”, ha affermato Pattie Maes, professore al Media Lab del MIT e specialista in interazione umana con l’IA.

I chatbot basati sull’intelligenza artificiale, come Gemini di Google e ChatGPT di OpenAI, hanno fatto passi da gigante. I miglioramenti includono l’espansione delle finestre di contesto, che determinano la quantità di conversazione che un chatbot può ricordare contemporaneamente, e l’utilizzo di tecniche come la generazione aumentata dal recupero, che identifica il contesto rilevante dai dati esterni.

I gruppi di intelligenza artificiale hanno anche potenziato la memoria a lungo termine dei modelli di intelligenza artificiale memorizzando i profili e le preferenze degli utenti per fornire risposte più utili e personalizzate.

Ad esempio, un chatbot può ricordare se un utente è vegetariano e rispondere di conseguenza quando fornisce consigli su ristoranti o ricette.

A marzo, Google ha ampliato la memoria di Gemini alla cronologia di ricerca dell’utente, purché questi dia il permesso, mentre in precedenza era limitata alle conversazioni con il chatbot, e prevede di estenderla ad altre app di Google in futuro.

“Proprio come con un assistente umano… più capiscono i tuoi obiettivi, chi sei e cosa fai, migliore sarà l’aiuto che potranno fornirti”, ha affermato Michael Siliski, direttore senior della gestione dei prodotti presso Google DeepMind.

ChatGPT di OpenAI e il chatbot di Meta su WhatsApp e Messenger possono fare riferimento alle conversazioni passate, invece che solo alla sessione corrente. Gli utenti possono eliminare ricordi specifici dalle impostazioni e vengono informati quando il modello sta creando un ricordo in un messaggio sullo schermo.

“La memoria aiuta ChatGPT a diventare più utile nel tempo, rendendo le risposte più pertinenti”, ha affermato OpenAI. “Hai sempre il controllo: puoi chiedere a ChatGPT cosa ricorda di te, apportare modifiche ai ricordi salvati e alle conversazioni passate o disattivare la memoria in qualsiasi momento”.

Per le aziende, Microsoft ha utilizzato i dati organizzativi per alimentare la memoria, come e-mail, calendari e file intranet.

Il mese scorso, il gigante tecnologico ha iniziato a lanciare in anteprima su alcuni dispositivi Recall, una funzione che registra l’attività degli utenti acquisendo screenshot dello schermo del loro computer. Gli utenti possono disattivare o mettere in pausa gli screenshot.

Quando è stata annunciata per la prima volta lo scorso maggio, ha suscitato preoccupazione nella comunità della sicurezza informatica e in altri che l’hanno definita “inquietante”, costringendo Microsoft a ritardarne più volte il lancio.

Le aziende di IA scommettono anche sul fatto che una memoria migliorata potrebbe svolgere un ruolo importante nell’aumentare la monetizzazione attraverso il marketing di affiliazione e la pubblicità.

L’amministratore delegato di Meta, Mark Zuckerberg, ha dichiarato durante la conference call sui risultati finanziari del mese scorso che “ci sarà una grande opportunità per mostrare consigli sui prodotti o annunci pubblicitari” sul suo chatbot.

I rischi

Tuttavia, l’introduzione di maggiori capacità di memoria nei modelli di linguaggio generativo ha anche sollevato preoccupazioni in materia di privacy, poiché le autorità di regolamentazione di tutto il mondo osservano attentamente come i modelli possano manipolare gli utenti a scopo di lucro.

L’aumento della memoria può anche portare i modelli a sforzarsi eccessivamente di adattare le risposte alle preferenze degli utenti, rafforzando pregiudizi o errori. Il mese scorso, OpenAI ha chiesto scusa dopo che il suo modello GPT-4o è stato giudicato eccessivamente lusinghiero e compiacente e ha riportato il modello a una versione precedente.

Più in generale, i modelli di IA possono avere allucinazioni, creando risposte false o senza senso, e sperimentare una “deriva della memoria”, in cui i ricordi diventano obsoleti o contraddittori, compromettendo l’accuratezza.

“Più un sistema conosce di te, più può essere utilizzato per scopi negativi, per farti acquistare prodotti o convincerti di particolari convinzioni”, ha affermato Maes, professore del MIT. “Quindi bisogna iniziare a riflettere sugli incentivi alla base delle aziende che offrono questi servizi”.

Controllo e selezione delle informazioni nel contesto AI

Uso i progetti anche per ricordarmi cose e definire ambiti di conoscenza a cui so che mi posso rivolgere per riassumere interazioni passate con l’AI.

Il fatto che si possa delineare un perimetro a quali informazioni vengono usate per arricchire il contesto è una cosa che apprezzo e soprattutto mi assicura un certo controllo su quali informazioni saranno usate per rispondere in modo più appropriato ed efficace ad un mio bisogno informativo. Si tratta di un meccanismo che di fatto è una memoria ma che mi consente di decidere quali memorie sono rilevanti ad una certa conversazione, e mi pare molto più efficace di un meccanismo che decide che Interstellar è un mio film preferito senza neanche consultarmi e successivamente altererà le risposte date tenendo conto di questo fatto assolutamente parziale delle mie preferenze, magari adattando le risposte in tema di show televisivi su questo aspetto (che per altro è emerso durante una prova che stavo facendo).

Rischi legati alla memoria dell’intelligenza artificiale

Come questi assistenti digitali usano le informazioni su di noi è quindi un aspetto centrale sia perché contribuisce ad aumentarne l’efficacia nell’interazione sia perché rischiamo di ricevere informazioni che ci compiacciano eccessivamente costruendoci intorno un’altra echo chamber dopo quelle dei social. In modo molto semplice le echo chamber possono essere definite come strutture che si tendono a formare sui social in cui seguendo solo utenti a noi affini e leggendone i contenuti postati ci amplifichiamo a vicenda costruendo una visione distorta della nostra realtà digitale e, indirettamente, di quella fisica. Il rischio di dotare l’AI di una memoria è quindi significativo, anche perché i modelli tendono a essere compiacenti al punto di creare allucinazioni solo per soddisfare l’utente di turno (il termine inglese che è divenuto recentemente popolare che caratterizza questo fenomeno è sycophancy”), e questa tendenza di cui si parla molto rischia di essere amplificata fornendo una memoria.

La memoria nei sistemi AI di Meta

La memoria è di fatto anche la protagonista dell’annuncio di Meta della disponibilità di Meta AI, la nuova applicazione di Meta che dovrebbe consentire un’interazione in stile ChatGPT e soprattutto usando le informazioni che Meta ha accumulato nel corso di quasi vent’anni su tutti noi su Facebook e Instagram. Purtroppo in Italia non è ancora possibile provarla, ma è già disponibile sullo store ed è semplicemente un rebranding dell’app Meta View usata per controllare gli occhiali smart realizzati con Ray-Ban. In un prossimo futuro vedremo un’interfaccia in stile ChatGPT ma per ora ci dobbiamo accontentare di usare Meta AI usando WhatsApp.

Memoria a lungo termine e alterazione dell’identità digitale

La possibilità di Meta di utilizzare le informazioni personali di oltre vent’anni di vita sembra dare un’opportunità nel costruire una AI che conosce gli utenti ben oltre ciò che è possibile analizzando poche chat. È quindi una funzione che è necessario approfondire anche per valutare se la memoria non altera troppo il comportamento del modello, anche confondendolo, perché io sicuramente non sono più la stessa persona che era quella che si è iscritta due decadi fa su Facebook. Ovviamente il prompt engineering di Meta che userà questi dati per creare la memoria determinerà molto del comportamento, e non è chiaro quanto si possa sapere di quello che viene fatto dietro le quinte. Si rischia in ogni caso che l’effetto di echo chamber si amplifichi a dismisura traslando il fenomeno sociale in un fenomeno relazionale uomo-AI.

Prompt engineering e trasparenza nella memoria AI

La gestione della memoria sta comunque divenendo un aspetto sempre più rilevante nella costruzione dei prompt per i modelli, e ad oggi si tratta di un processo largamente opaco dove si sta costruendo molta della qualità di questi servizi e di cui si parla troppo poco. Lo strato che fa il prompt engineering, verifica l’ammissibilità delle richieste, e seleziona le informazioni provenienti da sorgenti di informazioni esterne secondo la modalità RAG spesso conta più del modello stesso nel determinare la qualità del risultato.

Personalmente ritengo che l’approccio corretto sia quello dei progetti, dove quantomeno ho una rappresentazione delle informazioni che saranno usate per integrare le mie richieste, trovo invece decisamente pericoloso che questa sintesi sia effettuata da un software in modo assolutamente opaco che di fatto determina, dal punto di vista dell’AI, il mio io digitale. Nel caso di OpenAI quantomeno è possibile osservare i contenuti selezionati, vedremo non appena sarà possibile la via scelta da Meta.