L’intelligenza artificiale è entrata nelle organizzazioni con la promessa di maggiore efficienza e trasformazione dei processi. Molte organizzazioni investono nella formazione del personale, un passo necessario e, peraltro, un obbligo specifico stabilito dall’AI Act per garantire un “livello sufficiente di alfabetizzazione in materia di IA”. Eppure spesso l’adozione stenta a decollare.

Indice degli argomenti

Perché l’AI in azienda non decolla

I motivi possono essere diversi e vanno da una scarsità di competenze tecniche a una mancanza di un sistema di regole condivise all’interno dell’organizzazione. L’insieme che provoca effetti distorsivi perché ci può esser freno interno all’organizzazione mentre, al tempo stesso, molti lavoratori provano e utilizzano l’IA generativa in modo del tutto autonomo dando vita al fenomeno della “IA nascosta”. Si tratta di una prospettiva altrettanto negativa per le organizzazioni che, se non dettano regole chiare, alcuni dipendenti se le creano da soli.

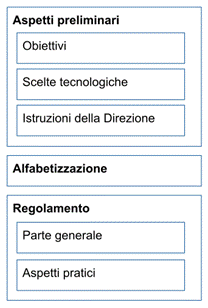

In un precedente articolo si era ipotizzato un percorso per l’adozione di un regolamento all’interno di un’organizzazione in tre passaggi: definizione degli aspetti preliminari, alfabetizzazione, stesura del regolamento per dipendenti e collaboratori.

Fig.1 – Processo di adozione di un regolamento in tre passaggi: preliminari, alfabetizzazione, adozione.

Secondo questo schema, immaginiamo un’ipotetica organizzazione che abbia già definito la propria strategia di trasformazione basata sull’intelligenza artificiale o – più semplicemente – almeno deciso di introdurre l’intelligenza artificiale generativa tra i dipendenti in modo chiaro con regole condivise. Ipotizziamo inoltre che abbia già vagliato e selezionato i sistemi – cioè le piattaforme – di cui avvalersi, e lo stesso organo direttivo abbia già comunicato la direzione intrapresa. Questa ipotetica organizzazione ha già valutato, oltre i vantaggi, anche lo schema dei rischi di cui tenere presente e, al tempo stesso, ha già cominciato un percorso di alfabetizzazione basato sulle Faq della Commissione Europea.

In questa ipotetica organizzazione viene introdotto un regolamento in tre parti: introduzione, rischi e responsabilità, indicazioni pratiche.

Ai in azienda: introduzione tecnica, normativa e contrattuale

Il regolamento normalmente esordisce con un’introduzione tecnica, normativa e contrattuale. In questa parte è opportuno ricordare che l’intelligenza artificiale, pur utilizzando gli strumenti dell’informatica, quando adottata dalle organizzazioni non è informatica classica. Non c’è un programma che esegue operazioni su dati per ottenere altri dati. Nella sua forma più diffusa, l’IA deduce le regole da dati e risposte, successivamente queste regole possono essere applicate su altri dati. Si tratta di uno stravolgimento delle regole del gioco e del pensiero algoritmico, inoltre l’IA generativa, quella che tutti conoscono, permette l’interazione con linguaggio naturale, molto diverso dei linguaggi normalmente utilizzati per programmare i computer.

In questa parte introduttiva vanno chiariti perlomeno aspetti base quali: differenza tra modello e sistema, cosa si intende per intelligenza artificiale generativa, chiarire il concetto di rischio in generale, sapere cos’è un agente e in cosa differisce da un “normale” prompting. Si tratta di avere un linguaggio condiviso all’interno dell’organizzazione per poter successivamente crescere verso altre direzioni quali, per esempio i RAG, il machine learning su dati e processi strutturati, l’intelligenza artificiale degli agenti.

Quanto al quadro normativo, per quando in fase di definizione, la buona notizia è che le norme finalmente ci sono e sono sufficientemente coerenti tra di loro. Vanno citate almeno le norme principali a partire dall’AI Act (Regolamento Ue 2024/1689) che non è un documento di indirizzo ma il quadro giuridico a protezione dei diritti e delle libertà delle persone. Quanto agli indirizzi, in Italia va citata la recente Legge sull’IA (L.132/2025) che indica varie direzioni su cui il Governo è delegato a intervenire mentre, per gli Enti Pubblici, deve essere indicato il Piano Triennale (Piano Triennale per l’informatica nella PA nella sua ultima incarnazione, quella del triennio 2024-2026).

In questa parte si può stabilire in modo chiaro che vanno evitati gli account “gratuiti” dei singoli dipendenti. Deve essere chiaro che è l’organizzazione che adotta uno o più piattaforme, stipula i contratti a livello aziendale e distribuisce gli accessi ai propri dipendenti e collaboratori.

Rischi e responsabilità

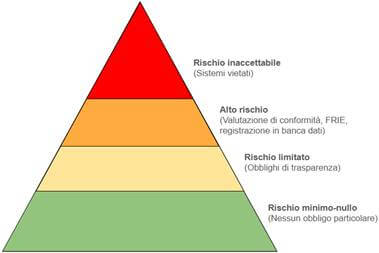

Nessuna tecnologia è neutra, tantomeno lo è l’IA generativa basata con NLP ed LLM. I rischi ci sono e vanno compresi. In questa parte è utile ricordare la ripartizione dei rischi secondo l’IA Act

Fig. 2 – Classi di rischio per l’IA Act

Vanno poi individuati e spiegati i rischi specifici per la singola organizzazione. Al primo posto ovviamente ci sono i rischi legati alla riservatezza dei dati personali, alle allucinazioni e ai bias. In base all’attività della singola organizzazione, vanno individuali le classi di rischio relative al diritto all’immagine immagine e al diritto d’autore, alla riservatezza dei dati non personali, alla proprietà intellettuale etc.

Per quanto riguarda le Pubbliche Amministrazioni, il quadro è definito da specifiche norme e sentenze del Consiglio di Stato pertanto il regolamento dovrebbe accennare:

– alla responsabilità del procedimento amministrativo (essenzialmente la L.241/1990);

– alla distinzione tra “algoritmo di mero supporto” e “decisione algoritmica” (CDS 4875/2025);

– e, nel caso di decisione algoritmica, chiarire che vanno chiariti i principi base di conoscibilità, di non esclusività e di non discriminazione della decisione algoritmica nei confronti dei destinatari (la sentenza seminale è la CDS 2270/2019).

Indicazioni pratiche

Segue la parte del regolamento dedicato alle indicazioni pratiche da dare ai dipendenti. Si tratta di indicare quali sono gli strumenti permessi, quali quelli vietati e vanno forniti esempi. La prima scelta di indicazione pratica riguarda il grado di dettaglio cioè se enunciare solo i principi generali di cura del prompting e di verifica dei risultati oppure definire chiaramente gli strumenti oppure, ancora, spiegare dove sono e come lanciare questi strumenti.

Se l’organizzazione ha scelto determinate piattaforme, ha stipulato il relativo contratto che – per motivi di privacy e security – è protettivo sui dati e sui diritti, quelle sono le uniche che i dipendenti dovrebbero essere autorizzati ad utilizzare. In questa parte emerge l’importanza delle precedenti scelte tecnologiche che non sono neutre, obbligano l’organizzazione alla coerenza con gli obiettivi, con la formazione e l’alfabetizzazione e gli aspetti contrattuali.

Se, per esempio l’organizzazione ha selezionato la suite Workflow di Google, la prima indicazione pratica potrà spiegare come lanciare il client Gemini, le Gemme e – se adottato – anche altri strumenti come NotebookLM.

In un’organizzazione, gli strumenti vietati dovrebbero essere tutti quelli non permessi. Nella pratica è opportuno applicare una certa flessibilità e semmai indicare quali sono gli strumenti che non si dovrebbero usare con l’indicazione che, in caso di necessità, l’organizzazione stessa potrà farsi carico di acquisirli con un contratto aziendale.

Per finire, le indicazioni pratiche dovrebbero contenere qualche esempio di prompting efficace e, contemporaneamente, esempi di prompt non adeguati. In questa parte può essere utile esordire con le caratteristiche di un buon prompt. Le regole sono quelle note, un buon prompt è un “progetto” lungo anche 10 o venti righe, in cui l’utilizzatore è invitato a definire le quattro regole base: persona, compito, contesto, formato e vincoli.

Infine, va chiarito che il regolamento riguarda esclusivamente l’utilizzo dell’IA generativa da parte dei dipendenti per il loro lavoro quotidiano. Non riguarda altre scelte in capo all’organizzazione tra cui selezione e gestione dei dipendenti che comporta specifici oneri informativi (L 152/1997), l’acquisizione di sistemi o l’utilizzo della IA nei processi di acquisto (Dlgs.36/2023 art.30), le verticalizzazioni su sistemi già esistenti o il machine learning su dati e processi strutturati.

10 punti per un’IA antropocentrica in azienda

L’adozione di un regolamento per i dipendenti è parte del rispetto “antropocentrico” della IA di per le persone, dei diritti e delle libertà. Non deve essere semplice compliance normativa e neppure accountability in senso meramente autodifensivo, non è qualcosa da fare formalmente unicamente dimostrare di essere stati “a posto” se ci saranno problemi.

Con queste considerazioni e con la successione delineata degli argomenti, un regolamento aziendale può avere indicativamente questa sequenza di paragrafi:

01. Prefazione

02. Breve introduzione tecnica

03. Breve introduzione normativa e di indirizzo

04. Termini e concetti

05. Rischi

06. Responsabilità

07. Cenni ad aspetti particolari non oggetto di questo regolamento

08. Indicazioni pratiche – Strumenti permessi

09. Indicazioni pratiche – Strumenti vietati

10. Indicazioni pratiche – Esempi di prompting

Il regolamento deve essere capace di mostrare gli strumenti di intelligenza responsabile e, al tempo stesso, spingere per un uso responsabile degli stessi. Va inserito in un percorso di stimolo e, al tempo stesso, di contenimento della l’IA nascosta. Deve essere uno strumento a supporto della trasformazione digitale. Un compito non semplice ma sfidante.