E’ un buon momento per fare il punto e capire quali traiettorie seguiranno le tecnologie dell’intelligenza artificiale nei prossimi mesi. Sembra ieri, ma è già passato un anno da quando non si parlava d’altro che di agentic AI, con grandi aspettative legate al miglioramento dei modelli.

Per il 2026 il panorama sembra però meno stabile e, soprattutto, meno legato alle tecnologie “pure” e più alle tensioni create dagli enormi investimenti dei grandi player nelle cosiddette gigafactories (da gigawatt) o AI factories. Per prendere decisioni consapevoli su adozione e sviluppo, serve quindi fare il punto non solo sullo stato dell’arte, ma anche sulle frizioni che ne condizionano l’evoluzione, con possibili mutamenti radicali di scenario e dei rapporti di forza.

Indice degli argomenti

Le tendenze AI 2026: modelli LLM verso la maturità

L’evoluzione dei modelli LLM ha caratterizzato lo sviluppo e la diffusione dell’AI generativa dal rilascio di ChatGPT 3.5 a fine 2022. Oggi è lecito chiedersi come gli sviluppi delle tecnologie LLM possano influenzare il 2026: da quello che si osserva, la tecnologia ha raggiunto un livello di maturità tale per cui diventa spesso difficile apprezzare la novità tra un modello e il precedente, o tra modelli differenti.

Non significa che non vi sia evoluzione: i continui miglioramenti riducono le allucinazioni, aumentano la capacità di seguire istruzioni, ampliano il contesto e la capacità di elaborarlo. Sono però modifiche incrementali, sempre più difficili da “vedere” senza esperienza. E, per sostenere un mercato in cui i miliardi di dollari sembrano spiccioli, servirebbe un mercato globale con centinaia di milioni di utenti paganti in grado di coprire i costi.

Generalisti vs specializzati

Accanto ai modelli generalistici che inseguono la visione dell’AGI, crescono modelli specializzati. È il caso dei modelli ottimizzati per la generazione di codice, su cui Google, OpenAI e Anthropic stanno investendo in modo significativo (oltre ad attori storici come GitHub e Microsoft). È un approccio diverso: punta a segmenti specifici con valore aggiunto più evidente, tale da giustificare investimenti importanti.

Open weight ed esecuzione locale

Se dai mega-modelli non è quindi realistico attendersi “colpi di scena” tecnologici (se non su ambiti verticali), conviene guardare ai modelli open weight eseguibili localmente. Anche grazie ai contributi dei big (ad esempio con il rilascio dei modelli GPT-OSS da parte di OpenAI, con prestazioni paragonabili a GPT-3.5 e ad alcune varianti di GPT-4o), questi modelli potrebbero giocare un ruolo nella costruzione di infrastrutture aziendali.

Immagini e video: dove le tendenze AI 2026 possono spostare il mercato

Se gli LLM sembrano avvicinarsi a una stabilizzazione funzionale, i modelli che generano immagini e video hanno ancora ampi margini di miglioramento. Ne sono prova i recenti rilasci di modelli per immagini come Nano Banana Pro (Google) e GPT Images 1.5 (OpenAI), e, pochi mesi prima, i modelli video Veo 3.1 (Google) e Sora 2 (OpenAI).

Già oggi le capacità di questi modelli stanno cambiando il mondo della comunicazione, consentendo la generazione di veri e propri personaggi digitali (si veda, ad esempio, il post di Eugenio Fierro su LinkedIn che mostra una influencer generata interamente in digitale).

Limiti tecnici ancora aperti

I modelli di immagini presentano ancora problemi in diverse aree, ad esempio nella generazione del testo dentro le immagini, anche se i progressi sono significativi a ogni aggiornamento. Nei modelli video, le limitazioni restano importanti sia in termini di durata sia di coerenza, soprattutto tra sequenze generate indipendentemente: un occhio attento nota incoerenze anche quando si riesce ad assicurare lo stesso protagonista, per esempio usando il cameo di Sora 2 in sequenze differenti (si veda anche il post su LinkedIn che mostra un cortometraggio composto da otto video generati con Sora 2).

Alcuni problemi tecnici che limitano gli impieghi saranno probabilmente risolti nel corso dell’anno, migliorando l’applicabilità a scenari di comunicazione e produzione. È evidente, però, che già nello scorso anno queste tecnologie sono passate da curiosità a strumenti realmente utili.

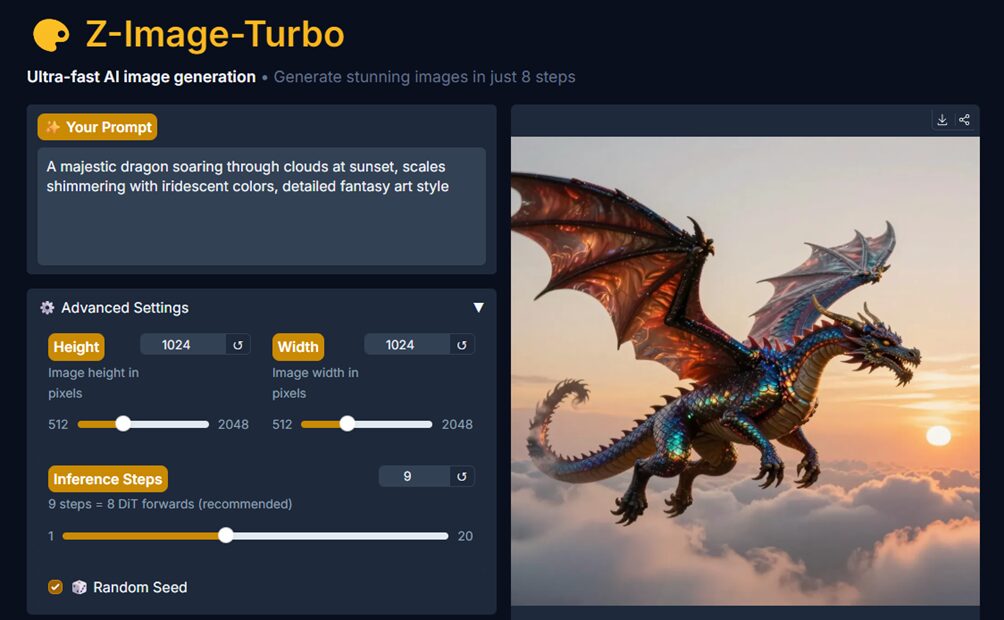

Open model per contenuti multimediali

Anche nella generazione multimediale i modelli open rappresentano un’alternativa ai mega-modelli erogati nel cloud. Tra quelli degni di nota troviamo la classe di modelli Z-Image (una demo di esempio è disponibile “qui”) e numerose iniziative che, come già avviene per gli LLM, iniziano a rendere interessante l’esecuzione anche locale di sistemi di generazione multimediale.

In ogni caso, la generazione di elementi multimediali sembra l’unico settore in cui potrebbero verificarsi miglioramenti tecnologici capaci di spostare scenari di mercato. Non è un caso che Google e OpenAI si siano mossi di recente in questo spazio, soprattutto OpenAI con il rilascio dell’app Sora e della sezione Images nell’interfaccia di GPT.

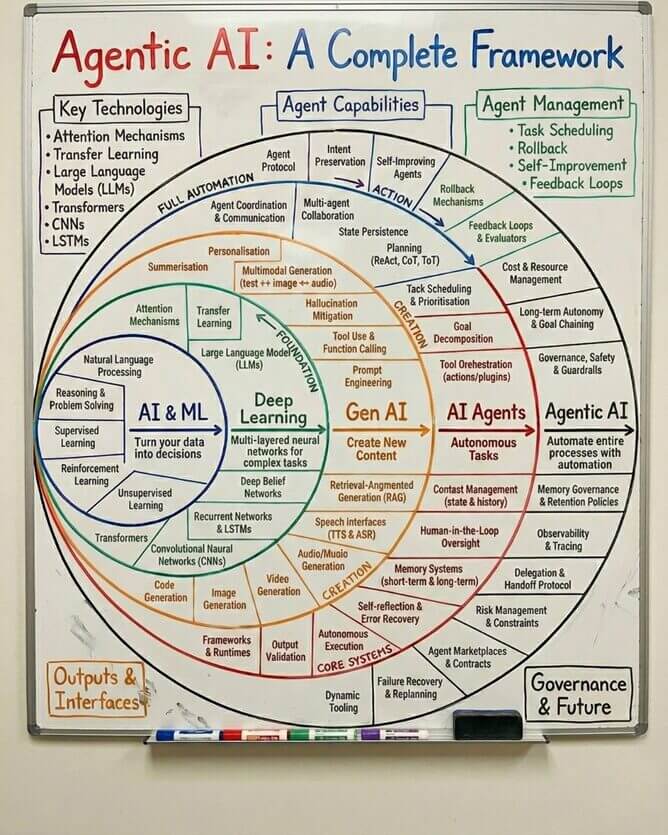

Agenti e agentic AI: automazione sì, ma con limiti di affidabilità

Gli agenti erano la vera promessa di un anno fa: il passaggio dall’AI “reattiva”, in cui si pongono domande, a quella “proattiva”, in cui l’AI svolge autonomamente compiti non banali su richiesta dell’utente, approfondendo un problema in modo indipendente.

Nel corso dell’anno si è iniziato a usare due termini distinti: gli agenti AI svolgono compiti specifici posti dall’utente (ad esempio la ricerca approfondita, l’Agent e il Codex di OpenAI); se invece si automatizza un intero processo, si parla di agentic AI. In parallelo sono nati framework per gestire questa nuova automazione (degno di nota il framework di Cohere o l’impiego nel low code fatto da Jitterbit).

Sebbene l’automazione sia spesso vista come panacea aziendale, la piena applicazione si scontra con un’affidabilità ancora inadeguata per molti compiti. Si apre quindi un tema centrale: come assicurare un processo di accountability dell’AI, senza il quale sembra difficile delegare davvero funzioni in modo automatico.

In questo senso, la compagnia “Macrohard” lanciata da Elon Musk per lo sviluppo di codice interamente basato su AI (presentata nelle news come un Microsoft killer) appare, per ora, soprattutto un’iniziativa di marketing. Nel 2026 è comunque lecito aspettarsi un consolidamento delle tecnologie di automazione, con più attenzione alla qualità e alla verificabilità dei risultati che a rivoluzioni immediate.

UX e integrazioni: come si userà l’AI nel 2026

Se le tecnologie core dell’AI sembrano stabilizzarsi, resta aperto il tema della user experience (UX), cioè dell’interfaccia con cui gli utenti fruiscono dell’AI. La chat si sta evolvendo, includendo strumenti per il lavoro collaborativo e per “capitalizzare” il manufatto chat, che ha un valore in sé.

Il tema più caldo per il 2026 è rendere più efficace l’AI attraverso l’accesso a strumenti esterni, così da assicurare un uso continuo della tecnologia e, di conseguenza, la sua monetizzazione. Un fenomeno in crescita riguarda il valore dei dati che si accumulano nelle chat: man mano che deleghiamo memoria a queste strutture, cresce la necessità di strumenti per mantenerle, cercarle ed elaborarle.

L’importanza della UX è evidenziata dai continui cambiamenti nelle interfacce: non è un caso che anche Google abbia introdotto, nel solco tracciato da OpenAI, un’interfaccia dedicata alle immagini e ai video generati con Gemini.

Per migliorare la UX si ricorre anche a integrazioni: l’accesso ad applicazioni esterne, anche grazie a protocolli come MCP (Model Context Protocol), emerge come elemento chiave per la “personal AI”, consentendo ai modelli di manipolare applicazioni e accelerare automazione e produzione di contenuti senza che l’utente debba fungere da intermediario.

OpenAI è stata pioniera di questa apertura, prima con i plugin, poi con i GPTs e ora consentendo la manipolazione di dati attraverso applicazioni. L’abilitazione all’uso di applicazioni è stata inclusa anche da Anthropic (sviluppatore del protocollo MCP) con Claude, ma con un supporto meno maturo rispetto a quello di OpenAI.

È lecito aspettarsi che nel 2026 la UX veda nuove aggiunte, con strumenti sempre più specializzati per un uso più efficace. Per certi versi il modello conversazionale sarà “diluito” in strutture più complesse, pensate per un uso più produttivo delle informazioni generate dagli utenti.

IoT e robotica: promesse e tempi lunghi per l’AI nel 2026

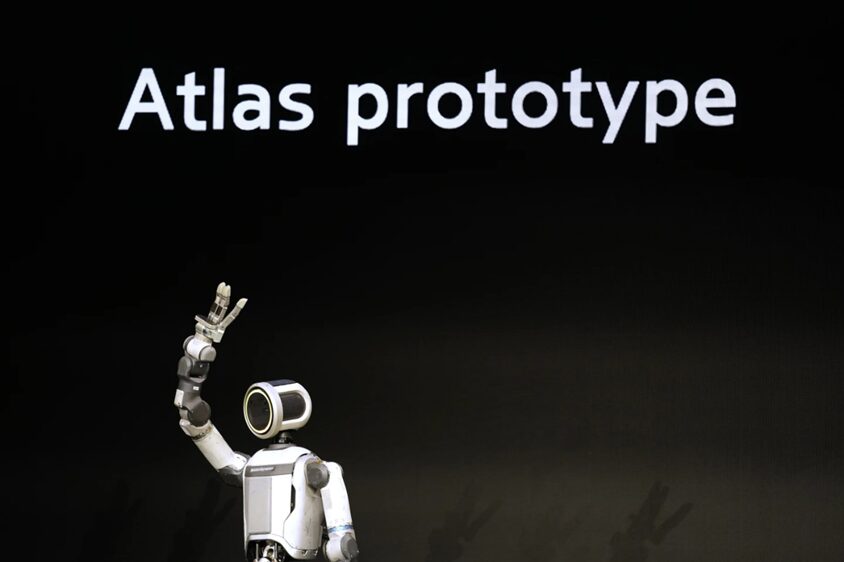

Un impatto significativo dell’AI riguarda controlli sempre più sofisticati per l’automazione di dispositivi IoT e robot, in particolare robot umanoidi. La flessibilità dei nuovi modelli consente maggiore versatilità nel controllo di robot capaci di esibire comportamenti multifunzionali.

Ne è testimonianza l’annuncio del robot umanoide Atlas, risultato di un progetto congiunto tra Google e Boston Dynamics che prevede l’impiego di Gemini per il controllo di robot prodotti da Hyundai per operare all’interno di fabbriche.

Va però detto che il prototipo mostrato al CES 2026 era telecontrollato da una persona e non dall’AI: serviva a dimostrare i 56 gradi di libertà del nuovo robot. Prima del 2030 non si prevede un reale uso della tecnologia, e, a parte il prototipo, Atlas è rimasto immobile sul palco: sembra quindi necessario ancora tempo perché il breakthrough promesso dall’accoppiata AI e robotica si traduca in applicazioni concrete.

Nel 2026 vedremo probabilmente moltiplicarsi annunci di robot controllati da modelli generativi, continuando un percorso inaugurato nella prima metà del 2025 da nVidia con l’introduzione del framework Cosmos per l’addestramento di modelli per la robotica. Restano però problemi aperti: far sì che i modelli seguano istruzioni ed evitino azioni guidate da allucinazioni rende il mercato ancora “in potenza”, più che reale.

GPU, CUDA e alternative: le tendenze AI 2026 nell’accelerazione

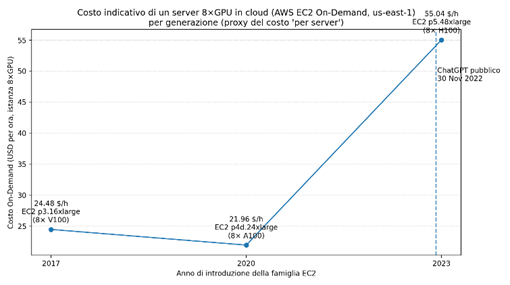

Un elemento essenziale per l’esecuzione delle deep neural networks è la GPU, acceleratore hardware che ottimizza i calcoli necessari per generare nuovi token a partire dal contesto fornito al modello. Il leader di mercato è Nvidia, e il successo degli LLM ha spinto non solo il valore del titolo, ma soprattutto i prezzi degli acceleratori (come mostra il costo orario di nodi con 8 GPU nel cloud di Amazon AWS).

Una GPU accelera operazioni di algebra lineare svolgendo calcoli in virgola mobile su vettori di numeri. Ma Nvidia non è l’unico player: oltre a competitor storici come AMD e Intel, si sono affiancati i big del cloud, Google con le TPU e Amazon AWS con Trainium (addestramento) e Inferentia (inferenza). Più di recente sono stati sviluppati chip dedicati agli LLM come le LPU (Language Processing Unit) della startup Groq, recentemente oggetto di un accordo da venti miliardi di dollari per acquisire la tecnologia delle LPU e figure chiave della società.

Il peso dello stack software (oltre l’hardware)

Il quasi monopolio di Nvidia non è legato solo all’hardware: conta l’interconnessione NVLink e la tecnologia di Mellanox per comunicazione a bassa latenza nel calcolo ad alte prestazioni. Ma il motivo principale sembra essere il software CUDA, il framework che ha permesso di usare il modello SIMD delle GPU per computazioni oltre la grafica 3D.

Molto software scritto in due decenni usa CUDA e ha supportato la ricerca che ha portato allo stato attuale. Non è un caso che Nvidia abbia rilasciato DGX Spark, una piattaforma a costo relativamente basso (circa tremila euro) che consente di sviluppare e testare software capace di girare su tutte le GPU Nvidia, incluse quelle datacenter che da sole costano oltre dieci volte tanto e che difficilmente possono essere allocate allo sviluppo.

Nel 2026 la tensione tra lock-in (CUDA e Nvidia) e la necessità di alternative per calmierare il mercato porterà probabilmente a investimenti significativi sugli stack software per l’AI. Il mantra “comprare GPU Nvidia” non sarà quindi l’unica strada per chi vuole realizzare servizi di AI.

AI factories, energia e investimenti: le tendenze AI 2026 che cambiano l’IT

La crescita dell’AI e la previsione di servire porzioni significative della popolazione mondiale con servizi basati su questi modelli hanno avviato la creazione di enormi datacenter, battezzati AI factories, capaci di offrire potenza di calcolo su scala. È una partita globale in cui molti vedono riflessi geopolitici.

Non è un caso che, sin dal discorso inaugurale, il Presidente Trump abbia parlato di infrastrutture strategiche lanciando il progetto da 500 miliardi di dollari Stargate, che vede coinvolti Oracle e OpenAI e che ha contribuito a generare fratture politiche nei mesi successivi.

Dalle AI factories alle gigafactory (energia e acqua)

Più recentemente si è iniziato a parlare di gigafactories, perché questi datacenter richiedono potenze di qualche gigawatt e quantità ingenti di acqua. In questo quadro si inserisce l’acquisizione (avviata a fine 2025) di Intersect Power da parte di Google per circa 4,75 miliardi di dollari, letta come un modo per controllare almeno in parte i costi dell’energia a supporto delle proprie AI factories.

Questi investimenti sembrano distanti, ma stanno distorcendo l’intero mercato IT e quello energetico. Si riconsiderano infrastrutture nazionali per individuare siti che possano ricevere risorse necessarie, spesso oltre la capacità delle reti di distribuzione esistenti. Le richieste influenzano anche mercati adiacenti, con aumenti di costo che impattano servizi non direttamente legati all’AI.

Un esempio citato è la divisione Samsung Semiconductor, che avrebbe negato memorie alla divisione mobile di Samsung per via di margini superiori vendendo memorie alle AI factories. I prezzi delle memorie sono esplosi come conseguenza diretta della realizzazione di queste infrastrutture, alimentando una competizione che coinvolge anche la disponibilità delle GPU e i relativi costi.

Il CEO di IBM, Arvind Krishna, è arrivato a dichiarare pubblicamente che i costi pianificati per la realizzazione di queste infrastrutture potrebbero raggiungere l’ordine di otto trilioni di dollari, con profitti annui enormi necessari solo per pagare gli interessi. In questo contesto si citano anche misure di taglio dei costi, come la riduzione di circa quattordicimila ingegneri, e l’ipotesi di un possibile collasso del settore IT globale se le stime dovessero confermarsi.

Open weight, cloud e strategie: come scegliere il modello nelle tendenze AI 2026

Il rilascio di modelli open weight eseguibili localmente, con prestazioni paragonabili ai modelli cloud di un paio di anni fa, apre nuovi scenari. L’esecuzione locale è attraente per molte ragioni, non ultima un maggiore controllo dei dati passati al modello.

Finora i modelli open erano utili per compiti specifici ma non lasciavano intravedere un uso paragonabile ai modelli più complessi dei big. Gli ultimi rilasci (in particolare i modelli GPT-OSS) hanno cambiato lo scenario, consentendo di valutare infrastrutture AI aziendali con modelli meno capaci ma adeguati a compiti specifici, e soprattutto con pieno controllo dell’elaborazione e della disponibilità in automazione.

In questo senso, è importante considerare come anche la giustizia americana stia iniziando a occuparsi del contenuto delle chat con l’AI: viene citata una recente sentenza di un giudice distrettuale che obbliga OpenAI a rilasciare i log di venti milioni di conversazioni anonimizzate, che OpenAI cercava di non dischiudere per tutelare privacy (e il controllo su dati preziosi per l’addestramento).

Un altro fattore che potrebbe contribuire alla diffusione dei modelli locali (e anche all’uso di acceleratori diversi dalle GPU Nvidia) sono gli AI PC. Numerose funzioni possono essere assolte localmente da modelli low power e, dai primi annunci, si osserva un miglioramento del supporto software per eseguire modelli sul PC, sia su x86 sia su ARM. L’ottimizzazione su hardware meno costoso aumenterà le tensioni per chi deve scegliere un approccio aziendale, aprendo opzioni il cui futuro potrebbe non essere quello atteso.

La disponibilità di più modelli rende importante anche l’adozione di API e protocolli standard, per ridurre lock-in e aumentare la portabilità del codice. Nel 2026 sarà quindi necessario osservare l’evoluzione dei modelli open weight (monitorando in primis il sito Hugging Face) e sviluppare competenze interne per gestione e integrazione, affiancandole all’uso delle API dei modelli cloud.

L’anno che inizia non sembra un anno di scelte di lungo periodo: è però necessario, per chi non lo avesse già fatto, considerare l’integrazione dell’AI via API, e non solo tramite interfacce come ChatGPT, Claude e Gemini (o le loro controparti open).

Leadership, lavoro e strategie per un anno instabile

Negli ultimi tre anni l’impressione era che il leader fosse OpenAI, inseguita da Google e Anthropic. I progressi di Google nel 2025 mettono in dubbio la leadership e spingono OpenAI a valutare nuove strade per monetizzare gli utenti gratuiti (inclusa la valutazione di introdurre pubblicità nella versione free di ChatGPT). Google lavora per abbassare il costo per token, anche grazie alle TPU e all’investimento nel settore energetico; Anthropic, con Amazon, apre scenari competitivi.

Gli investimenti nelle gigafactory richiedono flussi di cassa adeguati e spingono i big a conquistare quote di mercato, ma la pressione competitiva può abbassare i prezzi e ridurre la marginalità. OpenAI ha dichiarato, oltre 800 milioni di utenti attivi settimanalmente, ma molti non pagano e dovranno essere monetizzati senza provocare migrazioni di piattaforma. Il 2026 si annuncia quindi come un anno di competizione intensa, con annunci su più fronti nella speranza di attrarre nuovi utenti.

Nel frattempo, è impensabile che il mondo del lavoro non venga condizionato: dalla generazione di contenuti multimediali (con impatti sui lavori creativi) fino alla maturazione dell’automazione di processo basata su agentic AI. Se l’impatto fosse significativo, potrebbe portare a conflitti sociali, come previsto da vari esperti. Un modo per prepararsi è investire nella formazione: AI + uomo può essere meglio dei singoli addendi, come teorizzato da Ethan Mollick in Co-Intelligence.

In un panorama instabile è consigliabile evitare investimenti troppo “monolitici”, differenziare sia la collocazione dei modelli (locale vs cloud) sia i fornitori, per non “puntare sul cavallo sbagliato”. L’instabilità può creare valore con nuove tecnologie, ma può anche bastare un trimestre in borsa sotto le attese per far scoppiare una bolla AI, con conseguente terremoto che brucerebbe investimenti e razionalizzerebbe gli attori.

In ogni caso, il 2026 appare come un anno in cui le aziende devono portare a terra qualche forma di valore con l’AI, evitando di restare indietro. Potrebbe essere l’anno in cui si investe soprattutto sul capitale umano, con formazione mirata e automazione su piccola scala per chi non è incline a correre rischi.

Il calendario è cambiato: ora non resta che vedere come l’anno si svilupperà e come le varie tensioni troveranno risoluzione, o si acuiranno.