È convinzione generale che a dipendenti e collaboratori di un’organizzazione vanno date linee guida sull’utilizzo dell’intelligenza artificiale ma cosa è opportuno oppure obbligatorio che contengano queste linee guida? Soprattutto, come arrivare alla loro redazione? Non è un quesito da poco perché, prima dei rischi, prima ancora della scelta della piattaforma, va compreso cosa vuole l’organizzazione tenendo conto del contesto esterno e interno e di cosa possono/devono offrire i propri collaboratori.

Indice degli argomenti

IA in azienda: un processo in 3 step

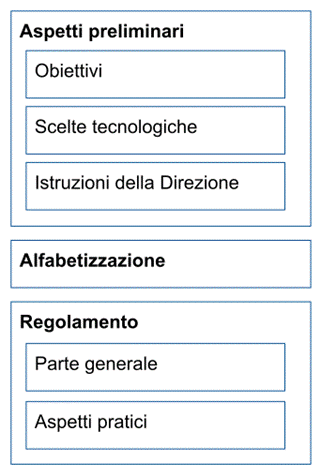

L’adozione di un regolamento interno è solo l’ultimo step di un processo che deve essere preceduto da altri passaggi preparatori.

Il primo passo comprende aspetti preliminari quali la definizione degli obiettivi, l’effettuazione di scelte tecnologiche e la comunicazione ufficiale da parte della direzione.

Il secondo step riguarda l’alfabetizzazione del personale e solo l’ultimo passaggio potrà essere la redazione di un regolamento. Il regolamento a sua volta potrà essere diviso in due parti, una generale su principi e obiettivi e una più pratica sugli strumenti e le cautele.

Si tratta di un approccio incrementale sufficientemente flessibile per l’adozione di strumenti che – oggi e per chissà quanto tempo ancora – non sono stabili. L’IA avanza, gli annunci dei grandi fornitori si susseguono con frequenza, le promesse sono molte, le minacce sono presenti ma nebulose e – in questa situazione – le organizzazioni devono essere capaci di darsi regole efficaci. Non è detto che sia un compito semplice.

Figura 1 – processo di adozione di un regolamento

Le basi strategiche per l’adozione dell’IA

Definire gli obiettivi connessi all’adozione dell’intelligenza artificiale in un’organizzazione è il primo passo obbligatorio. Forse è la parte più difficile e non solo perché un generico indicare strumenti e invitare a cominciare ad usarli sembra tanto un’esortazione stile “armiamoci e partite”, ovviamente destinata a non produrre effetti. Soprattutto perché alla gran parte delle organizzazioni non è ancora chiaro cosa si possa non si possa fare con l’IA e concentrarsi solo sull’offerta di piattaforme rischia di creare confusione e nessun risultato tangibile e misurabile.

L’IA nelle organizzazioni è sicuramente un caso, forse il più dirompente, di trasformazione digitale, pertanto non si tratta di introdurre tecnologia per produrre meglio ma, piuttosto, di trasformare l’organizzazione con l’introduzione della tecnologia.

Siamo in pieno nell’alveo delle metodologie Agile con un approccio più ingegneristico, Lean che è più orientata alla gestione del business oppure al Design Thinking che focalizza sull’approccio mentale nell’ambito delle organizzazioni. Tutte metodologie che prevedono forme iterative di attuazione che partono dalla misura di dove ci si trova, compreso la mappatura degli strumenti già attivi cioè eventuali chatbot o strumenti di scrittura facilitata delle mail. Vanno poi definiti gli obiettivi a cui segue l’attuazione e la verifica dell’avanzamento tramite KPI, per finire con modifica e ridefinizione di metodi e obiettivi e ricominciare il ciclo.

Quanto alle Pubbliche Amministrazioni, sono le stesse linee guida dell’Agid (a citare il Ciclo di Deming come modello di miglioramento continuo.

Chiaramente, prima l’organizzazione ha chiarezza di dove andare, meglio è anche perché le scelte tecnologiche rischiano di essere vincolanti.

Panorama delle piattaforme IA disponibili

Tutte le organizzazioni devono cominciare con il dotarsi accessi professionali per i propri collaboratori a uno o più sistemi di intelligenza artificiale generativa. I sistemi sul mercato a disposizione delle organizzazioni sono moltissimi ma, salvo esigenze particolari, in Italia i principali si riducono a cinque: ChatGpt, Gemini, Copilot, Claude, potenzialmente Minerva.

a. OpenAi ChatGpt. Nelle sue varie declinazioni, nel 2022 era stata la prima famiglia di sistemi ad uscire sul mercato e per questo gode di una certa aura di primogenitura. Il lancio delle API l’anno successivo ne aveva dato un’ulteriore spinta competitiva.

b. Google Gemini. Per le organizzazioni, questa famiglia di sistemi è integrata in Workspace e pertanto ne condivide le forme di accesso e le idiosincrasie lato contrattuale. Un’integrazione che favorisce l’adozione di più prodotti appartenenti a un unico sviluppatore in una sorta di vendor lock-in “gentile”.

c. Microsoft Copilot. Valgono le considerazioni del caso precedente ma con la famiglia Microsoft 365.

d. Anthropic Claude. Non offre integrazioni con applicazioni d’ufficio ma una qualche attenzione etica alla sicurezza. Vale la pena sottolineare che nessun modello e nessuna piattaforma offre forme di sicurezza riconducibili a quelle dell’informatica classica.

e. Minerva. Si tratta di una famiglia di modelli linguistici sviluppati da La Sapienza su sistemi Cineca. I modelli sono istruiti sull’italiano e pertanto capaci di fornire risposte più coerenti nella nostra lingua. I modelli sono completamente aperti quindi potenzialmente interessanti soprattutto per le Pubbliche Amministrazioni. Il progetto è ancora in fase sperimentale, è stato finanziato inizialmente dal PNRR e al momento Babelscape, spin-off de La Sapienza, ne sta sviluppando un’offerta commerciale solida e completa di RAG.

Strumenti avanzati oltre i modelli generativi di base

Anche limitando (come in questo articolo) ai modelli generativi testuali, l’offerta di sistemi è ampia e variegata. Inoltre, alcuni sistemi, come il cinese DeepSeek R1, sono semplicemente vietati nel nostro Paese per problemi di affidabilità e sicurezza.

Sempre in un’ottica incrementale, successivamente le organizzazioni sono invitate a scegliere altre componenti di intelligenza artificiale. Normalmente le scelte sono tre in ordine crescente di complessità organizzativa: altri strumenti per gli utenti finali, agenti AI, machine learning. Vediamole separatamente.

Strumenti per il lavoro condiviso

L’organizzazione può incoraggiare l’uso di altri strumenti di intelligenza artificiale generativa. Nella maggior parte dei casi si tratta di strumenti per il lavoro condiviso o altri per la selezione delle fonti. Nel primo caso ci sono gli strumenti accessibili dal normale ambiente di lavoro e sono le Gems di Google Gemini, Pages di Microsoft Copilot o le Gpt di OpenAi ChatGpt.

Selezione delle fonti

Per la selezione delle fonti, Google mette a disposizione Notebook LM mentre il corrispondente di Microsoft è accessibile direttamente dall’ambiente Copilot. Più complesso è il caso degli strumenti RAG (Retrieval-Augmented Generation). Si tratta di sistemi per recuperare informazioni su basi di conoscenza esterna forniti preventivamente. Le risposte tramite modello linguistico sono più accurate, aggiornate e – soprattutto – basate su dati specifici. In ambito Google, Vertex AI RAG engine è parte dell’offerta cloud, la stessa forma di offerta di Microsoft tramite Azure. Ovviamente entrambi da contrattare espressamente.

Agenti AI

Agenti AI. Si tratta di sistemi autonomi utilizzabili con linguaggio naturale e progettati per percepire l’ambiente, elaborare informazioni e – questo è il punto – prendere decisioni e agire per raggiungere obiettivi specifici. Sono diversi dai chatbot per modo di “ragionare”, per forme e fasi di trattamento dei dati (multistep) e per forme concrete di attuazione tramite API. Richiedono competenze tecniche specifiche e possibilmente la conoscenza di MCP (Model Context Protocol), protocollo per modellazione e connessione tra agenti diversi. Anche qui il panorama delle offerte è diversificato. Limitando agli ecosistemi più diffusi tra le organizzazioni, le offerte si riducono a Microsoft Copilot Studio (https://www.microsoft.com/en-us/microsoft-copilot/organizations) e Google Vertex AI (https://console.cloud.google.com). Entrambe vanno contrattate espressamente secondo determinata struttura di prezzi e garanzie.

Machine Learning

ML (Machine Learning). Si tratta di piattaforme che non necessariamente prevedono interazione tramite linguaggio naturale ma che sicuramente necessitano di un controllo stretto sui dati e relazioni. Decisamente fuori portata delle organizzazioni se non con studi e applicazioni strutturali con data scientist ma pur sempre una scelta possibile se non altro da parte delle organizzazioni più strutturate.

Comunicazione dirigenziale e contrasto all’IA nascosta

Definiti obiettivi e scelte tecnologiche, il primo importante step nell’organizzazione riguarda una comunicazione ufficiale da parte della direzione per chiarire che l’organizzazione ha adottato l’IA indicando direzione e strumenti. Questa comunicazione deve incoraggiare e stimolare anche per contrastare il fenomeno della “IA nascosta” cioè le piattaforme IA usate dai collaboratori senza un preventivo assenso, deve indicare brevemente quali strumenti sono possibili, quali obbligatori e quali quelli vietati. È opportuno anche un breve richiamo a principi e diritti fondamentali.

Formazione obbligatoria secondo l’AI Act

L’adozione di un regolamento interno deve andare di pari passo con le competenze dei collaboratori, la loro capacità di comprendere il contesto, le possibilità e gli svantaggi. L’acquisizione di competenze di base è uno specifico obbligo dell’AI Act che spinge verso pratiche di formazione di base. Se ne occupa espressamente l’art.4 che spinge per “un livello sufficiente di alfabetizzazione”. Per il Considerando 20 le nozioni “possono variare in relazione al contesto” e dovrebbero riguardare elementi tecnici, misure nell’utilizzo, modalità di interpretazione degli output e la conformità, il tutto seguito da follow-up” mentre per l’art. 3.56 l’obiettivo deve essere quello di “procedere a una diffusione informata dei sistemi di IA” con consapevolezza su opportunità, rischi e danni”.

Quanto al contenuto dell’alfabetizzazione finora non c’era molto. Finalmente a maggio è intervenuta la Commissione Europea con FAQ ufficiali che esorta le organizzazioni ad adottare un “approccio responsabilizzato simile a quello previsto per la privacy” e flessibile tenendo conto la classificazione dei rischi previsti dalla norma stessa, sulle allucinazioni dell’IA generativa e sulle responsabilità. Nella pratica gli utilizzatori dovrebbero apprendere quali sono gli obblighi di trasparenza e sorveglianza per i primi tre livelli di rischio posto che, ovviamente, il quarto livello di rischio (intollerabile) è vietato nell’Unione da febbraio scorso.

Accanto a questi argomenti, è opportuno che le organizzazioni integrino la formazione con aspetti legati alle opportunità concrete e all’utilizzo pratico degli strumenti messi a disposizione.

Struttura della sezione generale del regolamento

Definiti obiettivi e piattaforme, dopo indicazioni della direzione e un’adeguata formazione di base, l’organizzazione può finalmente predisporre un regolamento per i propri collaboratori. Il regolamento può essere diviso in una parte generale e in una più pratica. Nulla vieta che le due parti vengano preparate e socializzate in tempi diversi.

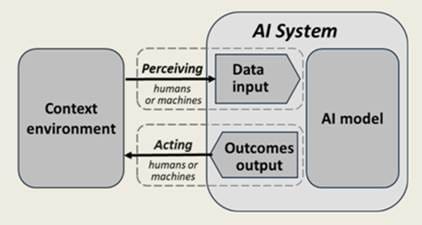

La parte generale dovrebbe chiarire il contesto accogliendo le indicazioni della direzione. Potrebbe essere utile puntualizzare su alcuni concetti di base: differenza tra modelli e sistemi, intelligenza generativa, mappatura degli strumenti già in uso compreso chatbot o help contestuali basati sul comportamento. Vanno equilibrate le esigenze di dare indicazioni chiare ma non troppo specifiche visto il veloce susseguirsi delle novità che costringerebbero ad aggiornare frequentemente le linee guida. È opportuno che chiarisca che i fornitori di intelligenza artificiale devono rispettare determinati standard in fatto di sicurezza, trasparenza e così via.

Figura 2 – Le componenti dell’intelligenza artificiale definite dall’OECD-OCSE nel 2019 specificano che un “sistema” incorpora un “modello” e interagisce con l’esterno. Si tratta di concetti base che andrebbero inseriti nella parte generale di un regolamento.

Classificazione e gestione dei rischi IA

Una parte importante della parte generale potrebbe riguardare i rischi che sono molteplici. La buona notizia è che i rischi sono noti e variamente classificati. L’AI Act (Regolamento Ue 2024/1689) prevede quattro livelli di rischio: inaccettabile e pertanto vietato (art.5), alto rischio (art.6 e all.III), rischio limitato, rischio minimo. Il Regolamento definisce inoltre il rischio sistemico (art.3.62) collegato perlopiù ai modelli di IA per finalità generali (art.3.63). Ci sono almeno altre due classificazioni: AIRO e AI Risk Repository.

a. AIRO (Ai Risk Ontology) dell’OCSE/OECD. Basato sull’AI Act e utilizzabile con gli strumenti del web semantico (OWL 2) classifica i rischi per bias, privacy, trasparenza e spiegabilità, supervisione umana, responsabilizzazione etc.

b. AI Risk Repository del MIT. Raccoglie più di 1600 rischi estratti da decine di altre classificazioni.

Esistono inoltre framework per definire autonomamente i rischi all’interno delle organizzazioni. Interessante è quello dell’allegato C della norma tecnica ISO/IEC 42001:2023 sui Sistemi di gestione dell’Intelligenza Artificiale che fornisce un quadro concettualmente riconducibile a quello della ISO 27001 sulla sicurezza delle informazioni affinché siano le organizzazioni a definire i rischi in base ai loro obiettivi e al loro contesto operativo. Nello specifico, questa norma è legata alla ISO/IEC 23894 che è dedicata alla gestione del rischio nei sistemi di intelligenza artificiale. Consolidato da più tempo è il framework AI RMF (AI Risk Management Framework) del NIST per definire i rischi (persone, organizzazione, ecosistema) e la loro gestione (governance, mappatura, gestione e misurazione).

Linee guida operative per l’uso quotidiano

Segue una parte più pratica e didattica su quali strumenti i collaboratori possono o devono usare, per farci cosa, quali gli strumenti da evitare.

Quanto ai rischi, vanno selezionati e spiegati solo rischi collegati alla prestazione lavorativa. Per esempio, è chiaro che la disinformazione è un rischio per la collettività ma in un’organizzazione interessano (o dovrebbero) interessare più quelli connessi alla privacy e alla riservatezza, all’affidabilità dei risultati e ai metodi per mitigare le allucinazioni.

Vanno date indicazioni sull’etica e la responsabilità, la trasparenza e fornire indicazioni per raggiungere un grado sufficiente di consapevolezza delle grandi potenzialità unite ai limiti dell’IA. Il tutto corredato da esempi pratici sia sulle piattaforme, per esempio sulle forme di formulazione dei prompt, sia sulle componenti già a disposizione come la compilazione di elenchi e riassunti a partire da documenti o lo smistamento delle mail.

Il regolamento dovrebbe anche favorire forme di collaborazione per socializzare metodi e risultati.

Conclusioni

L’adozione di un regolamento può seguire strade diverse per organizzazioni diverse ma vi sono alcuni punti fermi.

- il regolamento interno va inserito in un contesto che comprende definizione degli obiettivi, scelte tecnologiche e adozione della direzione.

- Il ruolo dell’alfabetizzazione è centrale, paradossalmente superiore a quello delle competenze specialistiche che – a costo di perdere il polso del processo di trasformazione – almeno al principio posso essere acquisite all’esterno.

- È preferibile un approccio incrementale per piccoli passi. Poi misurare l’effetto tenendo conto dell’orientamento dell’organizzazione e poi semmai approfondire una o più direzioni.

- Il regolamento può essere redatto a livelli, diviso in una parte pratica con esempi a cui far seguire una più generale.