Quando si parla di Intelligenza Artificiale il problema più importante e da tutti riconosciuto, analisti, scienziati e filosofi, è quello del “controllo” di questi Modelli. In questa parola sono racchiuse una serie di preoccupazioni, ma anche una consapevolezza, ormai molto diffusa, che ci troviamo di fronte, per la prima volta nella storia, a dei sistemi di grande potenza, in grado di auto-apprendere e di arrivare a delle decisioni autonome. Questo sulla base dell’addestramento, utilizzando gli algoritmi con cui sono stati progettati, e con un continuo incremento delle prestazioni.

Porsi il problema del “controllo” è quindi una questione fondamentale per affrontare gli sviluppi di questi modelli, vedendoli come un miglioramento complessivo della nostra civiltà, e non come un potenziale pericolo, addirittura esistenziale, per la specie umana. Questa forte consapevolezza è derivata anche dalle tante voci che si sono levate nei tempi recenti, dal campo della ricerca, dell’accademia, degli esperti di tecnologia, e persino da parte di chi ha contribuito allo sviluppo stesso di questi sistemi. Scienziati, ricercatori, premi Nobel e tanti altri, hanno messo in guardia dai rischi che corriamo, hanno firmato appelli alla prudenza, e hanno portato tutti noi alla logica conclusione che il problema del “Controllo” è il problema fondamentale da gestire, per continuare a sviluppare questi sistemi in sicurezza, lasciando all’uomo le capacità decisionali ultime.

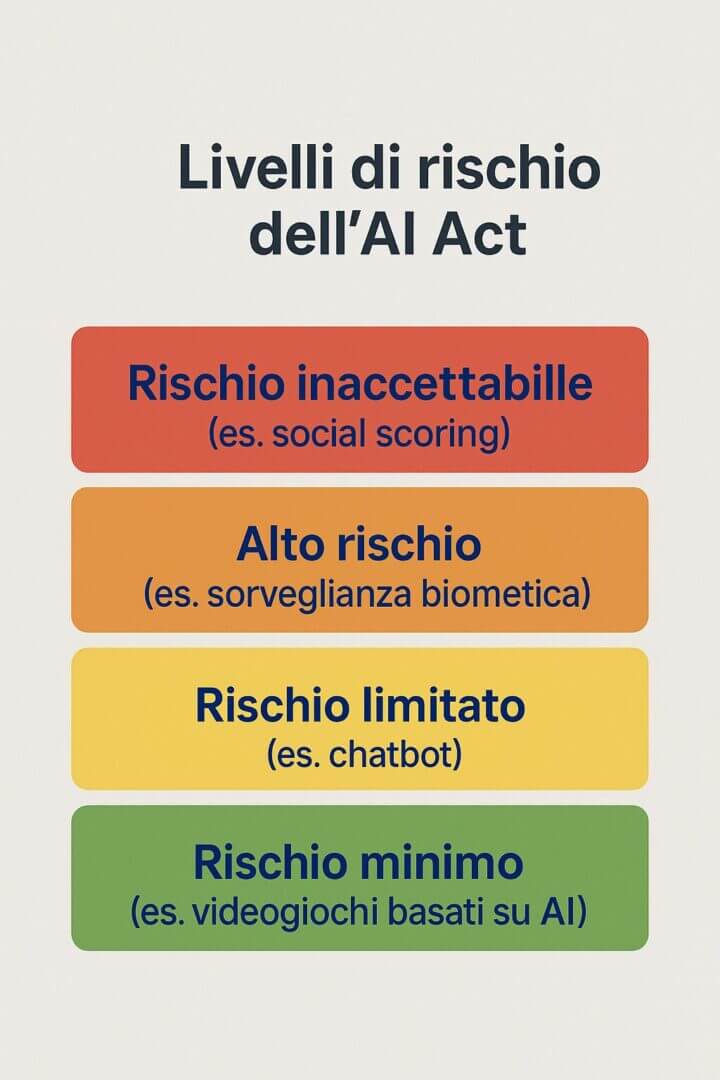

Il punto più alto che è stato raggiunto, come conseguenza di questa consapevolezza diffusa, è stata l’approvazione dell’ “AI Act” da parte dell’Unione Europea. Una regolamentazione che basa tutto il suo impianto sulla difesa dei diritti e della dignità delle persone, e che ha portato ad una classificazione dei Sistemi di AI sulla base del loro “Livello di Rischio” [1]. Su questa base, il Regolamento ha introdotto delle limitazioni, e impone delle regole da rispettare per la progettazione e la messa in esercizio di questi sistemi. Molte altre legislazioni, a livello internazionale, hanno ricalcato successivamente le orme dell’ AI Act, e oggi molti paesi si sono dotati di regole che fissano dei principi di base per il controllo dei Sistemi di AI. Vedremo poi anche le critiche che sono state sollevate su questo insieme di regole, da parte di chi vorrebbe più libertà nella ricerca e nella produzione di questi sistemi, in nome del progresso e della libera iniziativa, secondo il loro punto di vista.

Vogliamo affrontare, in questa sede, il tema dei “Controlli” seguendo un approccio complessivo, e prenderemo come punto di partenza proprio l’attuale AI Act per analizzare più a fondo questo tema. Partiremo dai punti della regolamentazione che ne fissano i principi, le regole e le modalità di attuazione, e vedremo che passare dai principi generali alla loro pratica attuazione non è così semplice in molti casi. Una serie di domande, che legittimamente ci poniamo, è ancora senza risposta, e hanno bisogno di ulteriori passi in avanti delle regolamentazioni.

Indice degli argomenti

AI Act e i meccanismi di controllo previsti

Facciamo una rapida panoramica dei punti del Regolamento in cui è affrontato il tema del Controllo, soffermandoci sugli articoli più importanti che riguardano questo specifico aspetto:

Articolo 5: “Sono vietate le pratiche di AI seguenti: …. ”

L’articolo fa un elenco delle pratiche di AI ritenuto a rischio inaccettabile, e quindi vietate. Rientrano in questa categoria l’utilizzo di tecniche subliminali o che sfruttano le vulnerabilità delle persone, i Modelli per la valutazione e la classificazione di persone fisiche o gruppi, quelli che effettuano una valutazione di rischio per l’eventuale commissione di reati, di riconoscimento facciale mediante scraping non mirato e per il riconoscimento di emozioni nei luoghi di lavoro o di istruzione (a meno di uso per fini medici). Sono vietati anche i sistemi per la classificazione delle persone in base ai loro dati biometrici e per l’uso dell’identificazione biometrica remota in tempo reale, se non autorizzate. Un articolo molto importante, e dirimente per una serie di applicazioni. Sono limiti ben precisi, che il Regolamento impone di non superare.

Articolo 20: “I fornitori di sistemi di IA ad alto rischio che ritengono o hanno motivo di ritenere che un sistema di IA ad alto rischio da essi immesso sul mercato o messo in servizio non sia conforme al presente regolamento adottano immediatamente le misure correttive necessarie per rendere conforme tale dispositivo, ritirarlo, disabilitarlo o richiamarlo, a seconda dei casi.”

Un importante articolo che obbliga i fornitori dei sistemi di AI ad assicurare che il sistema sia conforme alle disposizioni dell’AI Act, e a verificarne la rispondenza se già sul mercato. Questo articolo vincola ogni fornitore al controllo puntuale dell’applicazione del Regolamento, ritirando dal mercato, per gli opportuni adeguamenti, quei sistemi già in circolazione che fossero eventualmente difformi.

Articolo 27: “Prima di utilizzare un sistema di IA ad alto rischio di cui all’articolo 6, paragrafo 2, ad eccezione dei sistemi di IA ad alto rischio destinati a essere usati nel settore elencati nell’allegato III, punto 2, i deployer che sono organismi di diritto pubblico o sono enti privati che forniscono servizi pubblici e i deployer di sistemi di IA ad alto rischio di cui all’allegato III, punto 5, lettere b) e c), effettuano una valutazione dell’impatto sui diritti fondamentali che l’uso di tale sistema può produrre.”

Obbligo di una valutazione preliminare degli impatti che il sistema può produrre, prima di renderlo disponibile agli utenti, in caso di servizi di pubblica utilità.

Articolo 70: “Ciascuno Stato membro istituisce o designa come autorità nazionali competenti ai fini del presente regolamento almeno un’autorità di notifica e almeno un’autorità di vigilanza del mercato. Tali autorità nazionali competenti esercitano i loro poteri in modo indipendente, imparziale e senza pregiudizi, in modo da salvaguardare i principi di obiettività delle loro attività e dei loro compiti e garantire l’applicazione e l’attuazione del presente regolamento.”

E’ l’articolo in cui vengono indicati ruoli e responsabilità delle “Autorità Nazionali Competenti”, per ogni stato, che dovranno vigilare sulla corretta applicazione della normativa. Sono le entità addette alla sorveglianza ed al controllo, secondo il Regolamento.

Articolo 74.13: “Alle autorità di vigilanza del mercato è concesso l’accesso al codice sorgente del sistema di IA ad alto rischio su richiesta motivata e solo qualora siano soddisfatte entrambe le condizioni seguenti: a) l’accesso al codice sorgente è necessario per valutare la conformità di un sistema di IA ad alto rischio ai requisiti di cui al capo III, sezione 2; e b) le procedure di prova o di audit e le verifiche basate sui dati e sulla documentazione presentati dal fornitore sono state esaurite o si sono dimostrate insufficienti.

Un articolo che mette in risalto il ruolo delle autorità di vigilanza nel far rispettare il Regolamento, in particolare per i sistemi ad alto rischio. Le autorità possono anche richiedere l’accesso al codice sorgente per effettuare le verifiche di conformità.

E’ un tipo di controllo che per un modello di AI può però essere insufficiente, perché tali sistemi si basano su reti neurali complesse e non solo su algoritmi realizzati con codice software.

Ad esempio, può essere necessario valutare i parametri del modello e la qualità dei dati di addestramento, verificare la presenza di fattori inibitori, valutarne gli effetti sulle persone.

Articolo 85: “Fatti salvi altri ricorsi amministrativi o giurisdizionali, qualsiasi persona fisica o giuridica che abbia motivo di ritenere che vi sia stata una violazione delle disposizioni del presente regolamento può presentare un reclamo alla pertinente autorità di vigilanza del mercato.”

Sancisce il diritto di presentare opposizione all’autorità di sorveglianza per eventuali violazioni al Regolamento. E’ una forma di controllo “a posteriori”, che consente la segnalazione di eventuali violazioni del Regolamento. Può essere visto come una forma di controllo “diffuso”, da parte di qualsiasi soggetto.

Articolo 86: “Qualsiasi persona interessata oggetto di una decisione adottata dal deployer sulla base dell’output di un sistema di IA ad alto rischio elencato nell’allegato III, ad eccezione dei sistemi elencati al punto 2 dello stesso, e che produca effetti giuridici o in modo analogo incida significativamente su tale persona in un modo che essa ritenga avere un impatto negativo sulla sua salute, sulla sua sicurezza o sui suoi diritti fondamentali ha il diritto di ottenere dal deployer spiegazioni chiare e significative sul ruolo del sistema di IA nella procedura decisionale e sui principali elementi della decisione adottata.”

E’ un articolo fondamentale che riguarda la cosiddetta “spiegabilità” dei sistemi di AI, la necessità, cioè di fornire corrette informazioni sulle modalità con cui sono arrivati a delle determinate conclusioni.

E’ un articolo che in certi casi può risultare difficile da applicare, poiché, mentre è possibile fornire sempre le fonti a cui il sistema ha attinto, o su cui è stato addestrato, è molto più difficile spiegare i processi logici che sono stati seguiti dalla sua Rete Neurale per arrivare alle conclusioni fornite, almeno all’attuale livello tecnologico di progettazione.

Spesso un Modello risulta una Black Box per i suoi stessi progettisti e sviluppatori. Basti pensare che il LLM GPT-4o della Open-AI si basa su miliardi di parametri, e su più di 100 “Layer” che compongono le sue Reti Neurali (i dati precisi non sono resi disponibili dall’azienda) [2].

Articolo 91.1: “La Commissione può chiedere al fornitore del modello di IA per finalità generali in questione di fornire la documentazione redatta dal fornitore in conformità degli articoli 53 e 55 o qualsiasi altra informazione supplementare necessaria al fine di valutare la conformità del fornitore al presente regolamento.”

Il controllo può essere effettuato anche chiedendo al fornitore di fornire tutta la documentazione necessaria per effettuare le verifiche di conformità al Regolamento.

Anche questo è un controllo “a posteriori” che consente di richiedere la documentazione tecnica del modello, come indicato nell’ “Articolo 53 – Obblighi dei fornitori di AI per finalità generali”, e anche l’evidenza delle valutazioni dei modelli, come da “Articolo 55 – Obblighi dei fornitori di modelli di AI per finalità generali con rischio sistemico”.

Articolo 92.1: “L’ufficio per l’IA, previa consultazione del comitato, può effettuare valutazioni del modello di IA per finalità generali in questione:

a) per valutare la conformità del fornitore agli obblighi previsti dal presente regolamento, qualora le informazioni raccolte a norma dell’articolo 91 siano insufficienti; o

b) per indagare sui rischi sistemici a livello dell’Unione dei modelli di IA per finalità generali con rischio sistemico, in particolare a seguito di una segnalazione qualificata del gruppo di esperti scientifici conformemente all’articolo 90, paragrafo 1, lettera a).”

Il controllo esercitato dall’Ufficio per l’AI della EU riguarda anche la valutazione dei ”rischi sistemici” di tipo generale, a livello dell’intera Unione Europea. Sono quei rischi connessi all’uso di modelli di AI che possono avere impatti ben oltre l’area di applicazione specifica, arrecando potenzialmente danni di carattere molto esteso e difficili da controllare.

Articolo 93.1: “Se necessario e opportuno, la Commissione può chiedere ai fornitori di: a) adottare misure adeguate per adempiere gli obblighi di cui agli articoli 53 e 54; b) attuare misure di attenuazione se la valutazione effettuata conformemente all’articolo 92 ha suscitato un timore serio e comprovato di un rischio sistemico a livello dell’Unione; c) limitare la messa a disposizione sul mercato, ritirare o richiamare il modello.”

Il controllo esercitato dalla commissione può portare a richiedere ai fornitori di adottare tutte le misure adeguate ad assicurare la conformità del sistema al Regolamento, così come i fornitori stessi sono tenuti a fare anche in osservanza dell’Articolo 20.

L’insieme di tutto l’impianto regolatorio definito dall’AI Act mette in evidenza le responsabilità dei fornitori ed i poteri di controllo che le autorità di vigilanza dei singoli stati, e della Commissione, possono esercitare per assicurare il rispetto del Regolamento. Vengono indicate le misure da prendere per i sistemi ad Alto Rischio, e vengono vietati espressamente alcuni utilizzi ritenuti lesivi della dignità e dei diritti delle persone.

La strategia italiana e i punti critici del controllo

Naturalmente sono anche previste delle sanzioni, di non lieve entità, per l’inosservanza del Regolamento e la mancata applicazione dei controlli previsti. Il tema dei Controlli, quindi, è affrontato da una molteplicità di punti di vista, e vengono definiti dei limiti invalicabili, di cui occorrerà tener conto anche in tutte le evoluzioni future di questo Regolamento.

Pochi giorni dopo l’approvazione dell’AI Act da parte del Parlamento Europeo, l’”Agenzia per l’Italia Digitale” ha pubblicato un documento sulla “Strategia Italiana per l’Intelligenza Artificiale” [3]. Tra le strategie abilitanti il documento pone l’accento sulla disponibilità e sul controllo dei Data Set e dei Modelli di AI, uno dei punti fondamentali di controllo da attivare, nell’ambito della strategia italiana:

“Per mettere a sistema la conoscenza acquisita in specifiche progettualità e consentire il riuso di artefatti di IA, si realizzerà un programma mirato alla definizione di un registro di dataset e modelli, che siano costruiti secondo principi di trasparenza e fairness, che siano eticamente affidabili by design e che siano riusabili per accelerare le soluzioni delle aziende italiane.”

I limiti e le evoluzioni del modello normativo attuale

Molte sono state le critiche sollevate da più parti nei confronti dell’AI Act, prima ancora che questo entri pienamente a regime, nell’agosto del 2026. In particolare, il Regolamento è visto da alcuni come un possibile ostacolo all’innovazione e alla ricerca in questo settore, e all’espansione del mercato che si sta sviluppando.

E’ evidente che imporre delle regole implica delle limitazioni, ma questo è esattamente lo scopo di questa Regolamentazione: porre dei limiti all’uso improprio dei sistemi di AI, mettere sempre al centro di questi sviluppi i diritti e la dignità delle persone, il rispetto delle loro prerogative, e la protezione dei loro dati personali, come già previsto dal “General Data Protection Regulation (GDPR)” del 2016.

Alcuni punti tuttavia potrebbero essere migliorati, e sicuramente lo saranno, nell’ottica di introdurre delle semplificazioni per i piccoli operatori, ad esempio, come le PMI e le Startup. Si tratterebbe di introdurre un’applicazione differenziata di alcuni adempimenti, a seconda della tipologia di operatori, distinguendoli cioè tra piccoli operatori, grandi piattaforme o aziende, e Pubbliche Amministrazioni. Anche la classificazione del “Rischio” potrebbe essere più articolata, facilitando l’individuazione delle categorie di appartenenza per i diversi sistemi, e diversificando i Controlli da introdurre nelle diverse fasi della progettazione e poi della diffusione di questi prodotti sul mercato.

Essendo poi questi sistemi in continua evoluzione, occorrerà definire meglio il meccanismo delle revisioni programmate, in modo che portino a delle revisioni periodiche per tener conto di queste evoluzioni. E occorrerà prevedere un adattamento continuo delle tecniche di controllo, sia in termini di garanzie che in termini di semplificazione, definendo quei punti da monitorare costantemente durante le revisioni previste, sia in quelle annuali che quadriennali.

E potrebbero essere stabiliti dei ”Marchi di Qualità” specifici di garanzia per i prodotti immessi sul mercato, sulla base delle certificazione di conformità già previste, da gestire e da adeguare periodicamente, seguendo i cambiamenti e l’introduzione sul mercato dei nuovi modelli. In particolare, poi, la qualità dei dati utilizzati per l’addestramento sarà un fattore determinante di successo per questi modelli, e i controlli di conformità sui dati utilizzati saranno un elemento di valutazione importante, per ogni tipo di certificazione. L’AI Act, insomma, andrebbe visto come un processo in progressivo miglioramento, in cui i criteri di controllo e di gestione delle conformità dovrebbero adeguarsi ad un mercato in rapidissima trasformazione.

La gestione delle filiere produttive, già articolata nell’AI Act, dovrebbe portare ad un raccordo tra la gestione del rischio per i Modelli di AI e quelli previsti della NIS2, ad esempio, in modo da mettere a fattor comune le segnalazione per le violazioni gravi, e anche per fornire dei “Framework”, e delle best practice di riferimento per l’intero settore.

E va sempre ricordato che, oltre l’AI Act, tutte le regolamentazioni in vigore nella EU, dal GDPR, alla NIS2, già citata, alla DORA, e al Data Governance Act, devono essere applicate anche alle piattaforme di Intelligenza Artificiale, creando in tal modo un quadro normativo complessivo, anche per affrontare i rischi specifici connessi alla Cybersecurity e alla Protezione dei dati personali.

L’introduzione dell’AI Act in EU è stata seguita da altre regolamentazioni internazionali, come in USA, con un “Executive Order” presidenziale da parte del nuovo presidente D.J.Trump, che ha revocato il precedente del presidente J.Biden in ottica più liberista, in Canada, dove è stata approvata l’”Artificial Intelligence and Data Act”, in Australia, con il “Voluntary AI Safety Standard”, in Giappone, dove sono state approvate delle “Linee Guida” e ultimamente anche la legge quadro “AI Bill”, ed anche in Cina dove è stato adottato un “Basic security requirement for generative intelligence service”.

L’insieme di queste normative e di linee guida ha voluto mettere dei limiti allo sviluppo “selvaggio” di questi sistemi. Ma siamo solo all’inizio, perché sono tanti i fattori di rischio che occorre considerare, e occorrerà procedere ulteriormente su questa strada, per aggiornamenti continui e adeguamenti, man mano che vengono proposte nuove e più avanzate realizzazioni.

Armi autonome e necessità di accordi internazionali

Tra i fattori di rischio più urgenti, e che richiedono particolare attenzione, ce ne sono però due che richiederebbero delle azioni urgenti, e riguardano i sistemi d’arma autonomi e le implicazioni emotive, dovute all’interazione con sistemi di AI, che stiamo già usando e che verranno progressivamente introdotti nelle nostre case nella forma di Robot antropomorfi. Vediamo questi due aspetti più da vicino, per meglio inquadrarne i rischi.

Un problema ormai improcrastinabile da affrontare è quello relativo all’utilizzo di sistemi d’arma autonomi gestiti da AI, che, una volta addestrati ad individuare e colpire determinati target, possono essere difficilmente controllabili durante il loro utilizzo. E questo perché potrebbero trovarsi in condizioni di difficile controllo da remoto, o perché i tempi di reazione risulterebbero troppo ridotti per essere controllati completamente.

Abbiamo avuto due esempi recenti di questi impieghi di armi autonome, da cui dovremmo trarre molti insegnamenti, per definirne i limiti e le modalità di impiego.

Il primo esempio è stato l’attacco che il primo giugno 2025 l’ Ucraina ha condotto, con l’operazione “Tela di Ragno” alle basi militari russe in cui stazionavano bombardieri strategici. Ad Olenya, Belaya, e probabilmente anche ad altre basi.

E’ stato dichiarato dall’Ucraina, ma non ci sono conferme terze, tantomeno da parte russa, che 40 bombardieri strategici, addetti al trasporto di armamento missilistico e nucleare, sono stati colpiti, e almeno 13 di questi sono stati distrutti. L’attacco è stato condotto da droni intelligenti, immagazzinati in dei camion parcheggiati in precedenza nelle vicinanze delle basi, e attivati successivamente da remoto.

Questi droni erano guidati da sistemi di AI in grado di prendere decisioni autonome, per modificare l’altitudine, evitare i jammer di disturbo, sfuggire agli apparati di intercettazione russi, e identificare i bersagli su cui erano stati addestrati. Un’operazione preparata per mesi, ma la cui esecuzione ha richiesto l’impiego di sistemi di AI autonomi per gestire l’operazione una volta avviata [4].

Il secondo esempio è stato quello della notte del 12 giugno 2025, quando Israele ha lanciato un attacco di sorpresa denominato “Rising Lion”, verso i sistemi di difesa aerea e missilistica dell’Iran, e verso delle infrastrutture chiave del programma di sviluppo nucleare iraniano.

Gli attacchi, anche in questo caso, sono stati condotti con l’utilizzo di droni infiltrati sul territorio nemico, e gestiti da sistemi a guida autonoma per aggirare le difese iraniane [5].

Molte altre operazioni sono state condotte in passato utilizzando dei sistemi di AI per la guida di armi intelligenti. I “Controlli” su questi sistemi possono risultare impossibili da gestire una volta che le armi siano state attivate.

Si pone quindi urgentemente il tema della elaborazione di accordi internazionali per la non proliferazione di questi sistemi d’arma intelligenti, che possono rendersi in certi casi autonomi dal controllo umano, i cosiddetti “LAWS – Letal Autonomous Weapon System”, come droni, robot e veicoli armati autonomi.

Un accordo del genere non è semplice da realizzare oggi, per la presenza predominante di alcuni attori che detengono un quasi monopolio di queste tecnologie. Ma è importante iniziare a lavorarci, anche per creare in prospettiva delle agenzie sovranazionali, sul modello dell’ AIEA, istituita per il controllo delle armi nucleari [6]. Sarebbe importante che alcuni paesi cominciassero a coordinarsi per realizzare, in tempi abbastanza brevi, un primo embrione di “Trattato di non proliferazione di armamenti autonomi”.

Anche su questo terreno l’Europa potrebbe giocare un ruolo trainante, insieme a paesi come il Canada, il Giappone, l’Australia, la Nuova Zelanda, l’India e il Brasile. Molto più difficile coinvolgere fin dall’inizio gli Usa, la Cina e la Russia, per motivi strettamente legati all’attuale situazione geopolitica e ai conflitti in corso. Il futuro trattato dovrebbe introdurre vincoli severi alla produzione di armi autonome, e la proibizione dell’uso di questi sistemi nei casi in cui il controllo e la decisione finale non possano essere eseguiti da operatori umani.

Il concetto dello “Human in the Loop” dovrebbe essere reso imprescindibile nell’uso di questi sistemi, ed essere il fondamento del futuro trattato internazionale.

Questo non vieterebbe, in generale, l’uso di questi sistemi intelligenti, ma vieterebbe di renderli autonomi dal controllo umano, definendone così anche i limiti e le responsabilità, sia giuridiche che morali. L’agenzia di verifica sovranazionale, appositamente creata, potrebbe sovraintendere all’applicazione del trattato.

E’ in corso una campagna internazionale per sensibilizzare l’opinione pubblica su questo tema, denominata “Stop Killer Robot” [7].

Interazioni emotive e rischi cognitivi degli AI Companion

La storia delle interazioni tra esseri umani e agenti di AI risale ad alcuni decenni fa, con le prime sperimentazioni messe in atto al MIT da Joseph Weizenbaum nel 1966, con ELIZA, un sistema che forniva delle risposte basate prevalentemente sulle parole inserite dal richiedente. Successivamente altri modelli furono sviluppati, come PARRY, realizzato da Kenneth Colby a Stanford nel 1972, e poi ALICE, creato come progetto Open Source da Richard Wallace nel 1995.

Si arriva nel 2011 al SIRI di Apple e al CORTANA di Microsoft, e poi ad ALEXA di Amazon, nel 2014. Nel 2014 Microsoft lanciò anche un Chat-Bot su Twitter, TAY, che si rivelò un completo fallimento, e fu ritirato nel giro di 24 ore per risposte inappropriate, dovute ad un addestramento non controllato fatto online.

E finalmente si arriva alla serie dei Chat-GPT della OpenAI, che, a partire dal 2018, ha rilasciato via via diversi prodotti, e nel 2020 quello che è diventato ormai un fenomeno di massa, la versione Chat-GPT3. Da quel momento il modello di OpenAI è diventato quello prevalente nelle interazioni umane con i sistemi di Chat-Bot, ed è oggi utilizzato da chiunque, e per una molteplicità di scopi: studio, lavoro, divertimento e tante altre applicazioni.

Successivamente, anche Google, con BARD, e poi con GEMINI, e Microsoft con COPILOT sono seguiti a ruota, nel 2023. Si sono poi diffusi tutta una serie di prodotti di AI per la generazione di contenuti visuali, sonori, o video, come MIDJOURNEY, per la creazione di immagini, messo sul mercato nel 2022.

Oggi l’uso di questi Chat-Bot è diffusissimo, e consente una interazione molto semplice ed in linguaggio umano. Questo consente un dialogo molto naturale con questi Modelli, ed è molto facile perdere di vista il fatto di trovarsi a dialogare con un prodotto software, e non con una persona in carne ed ossa. E questo soprattutto per le persone più fragili, come anziani o minori, o anche poco attente a distinguere in modo netto le caratteristiche dell’interlocutore.

E’ possibile che si possano sviluppare delle interazioni emotive, ed anche affettive, molto personali, con questi sistemi, perché le recenti evoluzioni hanno reso questa tecnologia alla portata di tutti, e il livello di comprensione del linguaggio, e di interazione con le persone, è ormai eccellente. La possibilità che si vengano a creare delle dipendenze psicologiche o affettive è già molto concreta.

Ed esistono anche dei rischi legati ad una “dipendenza cognitiva” dovuta all’uso dei Chat-Bot. Un recentissimo studio del MIT Media Lab ha messo in evidenza i limiti dell’apprendimento, nei casi in cui vengono utilizzati questi Bot. Il rischio è che i concetti, non elaborati compiutamente, non entrino a far parte del bagaglio culturale delle persone, ma vengano utilizzati per comporre asetticamente dei lavori, senza capacità di assimilazione. [8].

E’ questo un campo in cui i controlli da attuare possono esser solo quelli dati dalla formazione, dall’addestramento al corretto utilizzo. Sarebbe quindi altamente auspicabile che anche la didattica nelle scuole e nelle Università si evolvesse rapidamente, per dare una corretta preparazione su come utilizzare al meglio questi strumenti, e su come evitare le situazioni di rischio più comuni.

La creazione di “cloni digitali” apre poi una serie infinita di possibilità. E’ possibile, ad esempio, dialogare con un clone creato dall’AI di un personaggio storico del passato, ottenendo una interazione molto efficace.

Questi sviluppi hanno portato a sperimentare cloni digitali di qualsiasi tipo, anche di parenti o genitori ormai scomparsi. E qui si apre un ventaglio di considerazioni, etiche e morali, di cui occorrerà tener conto, sviluppando specifici “indicatori di allarme”, e sarà necessario porre anche dei limiti nella comunicazione empatica e nel controllo emozionale delle persone.

Occorre, in sostanza, affrontare un dilemma di fondo: lasciar creare dei cloni il più possibile realistici, o mettere sempre, e chiaramente, sull’avviso che si sta dialogando con un software, e non con una persona. Sono questioni nuove da affrontare, ma che stanno diventando sempre più attuali.

Credo che controlli di questo genere debbano entrare a far parte della futura evoluzione delle regolamentazioni, perché i rischi di una trasformazione dei rapporti sociali, in termini di isolamento e di dipendenza, sono più che evidenti, in particolare per i soggetti più fragili.

Robot antropomorfi e nuove sfide etiche

Infine, ci sono ulteriori sviluppi da affrontare con la creazione di Robot antropomorfi dotati di AI, che è ormai arrivata quasi a un livello di produzione commerciale. Non è lontano il momento in cui avremo a che fare con dei Robot intelligenti che frequenteranno le nostre case ed i luoghi di lavoro. Si aprono quindi scenari completamente nuovi per quanto riguarda le possibilità di controllo di questi sistemi, con cui interagiremo sia fisicamente che emotivamente. Problemi etici e di sicurezza, fisica ed emozionale.

Un recente lavoro di Massimo Canducci espone dettagliatamente le problematiche relative alla “empatia artificiale”, e ci pone di fronte a degli interrogativi inquietanti, nel momento in cui si va a prevedere una società in cui la presenza di questi Modelli “empatici” farà parte della nostra vita quotidiana in maniera generalizzata. Tuttavia, anche se possibili, non è detto che le applicazioni più pervasive verranno realizzate, perché proprio la definizione di sistemi di controllo, etici e responsabili, potrebbe prevenire degli sviluppi troppo impattanti [9].

La questione da dirimere è anche qui quella di trovare il giusto equilibrio tra compagni digitali e capacità di controllo, un filo sottilissimo su cui c’è ancora molto da lavorare, in termini di regolamentazione e di modalità di utilizzo, certamente, ma soprattutto di consapevolezza delle persone.

E’ necessario che i limiti tra uomo e macchina siano resi molto evidenti, che gli utenti vengano costantemente informati, e persino allertati durante l’utilizzo, per evitare che ci siano assuefazioni o si instaurino dei legami, anche sentimentali, con tali prodotti della tecnologia.

Educazione, informazione e salvaguardia psicologica

Il principio non può che essere quello di dare la possibilità di scelta alle persone, ma occorre anche tener conto delle fragilità personali e dei rischi enormi che si corrono in termini di impatto sociale e sulla psicologia degli individui, specialmente i più fragili.

Sono temi su cui dovranno dare il loro contributo non solo gli esperti di tecnologia e i giuristi, ma anche medici e psicologi, perché certe applicazioni di questi sistemi possono anche essere utilizzate per specifiche terapie, così come nel settore della formazione e dell’apprendimento.

E occorre porsi naturalmente degli obiettivi di trasparenza, ma anche di efficacia di questi impieghi, cercando di contemperare i due estremi del controllo e dell’ utilità.

E’ una strada da esplorare con urgenza, perché i tempi sono già scaduti, e fenomeni di involuzione sociale, e di dipendenza cognitiva, si stanno già sperimentando.

Molti sono anche i rischi da gestire collegati a diverse altre applicazioni dei sistemi di AI, come il contrasto ai “deepfake”, che inquinano l’informazione e possono essere utilizzati per influenzare il dibattito politico, o per la manipolazione a fini politici o commerciali.

Il tema dei Controlli, in questi casi, è molto complesso da affrontare, e non può che essere basato su un monitoraggio diffuso, e con livelli di controllo diversificati, a partire dalle piattaforme, dagli enti di ricerca e di informazione.

Una nuova formulazione della “Intelligenza Artificiale”

Come abbiamo visto a proposito dell’AI Act, questo è un campo in cui gli sviluppi si succedono ad un ritmo impressionante, e la tecnologia è molto più veloce di quanto noi riusciamo a stargli dietro in termini di normative e di strumenti di controllo.

Occorre però fare un salto di qualità nella definizione stessa del concetto di “Controllo” delle applicazioni di AI. Ed occorre chiarirsi sulle diverse interpretazioni che si danno dell’Intelligenza Artificiale, un termine che, di per sé, rappresenta, in un certo senso, un ossimoro.

L’intelligenza è una caratteristica dell’uomo, legata alla sua cultura, alla storia, ai comportamenti, alle emozioni. Nulla di tutto ciò è rappresentato in un software, per quanto complesso e realizzato con Reti Neurali profonde, e che vengono addestrate su data set di enormi dimensioni.

L’intelligenza nasce anche dalla reazione dell’uomo agli errori, alle conseguenti reazioni di paura, di rimorso, o di repulsione che questi provocano. Una macchina sbaglia, invece, perché ci sono errori negli algoritmi, oppure perché è stata addestrata su dati di scarsa qualità, manifestando questi errori come “allucinazioni” o come conclusioni inesatte. Ma si tratta di errori riconducibili alla progettazione e alla realizzazione di questi modelli, non certo ad un comportamento dettato da emozioni.

Forse è proprio la capacità di commettere errori la caratteristica fondamentale dell’intelligenza umana. Sulle emozioni si costruiscono legami, reti di socializzazione, interessi comuni, società organizzate, intere civiltà. Non vorrei addentrarmi oltre in queste considerazioni, che appartengono a discipline diverse, ma sono questi i razionali che ci devono portare a vedere chiaramente la differenza tra gli esseri umani e le macchine, per quanto empatiche queste possano risultare oggi ed anche in futuro.

Molti fissano il “passaggio di consegne”, per così dire, tra l’intelligenza umana e quella delle macchine, nel momento in cui Garry Kasparov (campione del mondo di scacchi dal 1985 al 2000) venne sconfitto dal computer Deep Blue dell’IBM nel suo secondo match, giocato nel 1997.

Per la verità Deep Blue non era un modello di AI per come lo intendiamo oggi, basato su Reti Neurali e Machine Learning, ma utilizzava schemi di ricerca prestabiliti, con un’enorme potenza computazionale. Questo gli consentiva analisi esaustive su milioni di mosse al secondo, e di effettuare la scelta delle mosse basandosi su una funzione di valutazione della posizione sviluppata da IBM. Un sistema del tipo “AI Classica”, basata su pattern deterministici, e non predittivi. Garry Kasparov ha continuato ad occuparsi del rapporto tra uomo e macchine seguendone l’evoluzione, ed ha scritto un libro in cui esprime le sue idee in proposito, raccontando anche di quell’esperienza con Deep Blue [10]. Kasparov è oggi uno dei maggiori oppositori, in esilio, all’attuale direzione politica in Russia.

Ho incrociato Garry il 5 ottobre del 2019 a Milano, ad un evento dal titolo: “Onlife – Il futuro visto da vicino”, e gli ho chiesto il suo giudizio su quel match, a distanza di qualche anno. Garry mi ha risposto che non si era trattato di partite a scacchi, ma di un confronto tra un uomo e degli algoritmi. E in questa risposta di Kasparov va interpretato il senso vero di quell’evento mediatico, altro che “passaggio di consegne”. Era un confronto tra due entità diverse, una umana e l’altra digitale, e non erano certo delle partite a scacchi quelle che si erano giocate, ma una specie di test sul grado di evoluzione di quegli algoritmi [11].

E’ questa l’interpretazione che dovremmo dare dei sistemi di AI, a mio parere, non certo quella di “intelligenze” aliene, in grado persino di mettere in pericolo la specie umana. E’ un riallineamento di paradigma che dovremmo tutti compiere, anche psicologicamente.

La nascita degli Agenti AI di controllo “antagonisti”

Il tema dei Controlli, come abbiamo visto, è molto complesso, e dobbiamo sempre tener presente che una caratteristica importante dei Modelli di AI è la loro continua evoluzione. Man mano che l’addestramento prosegue, nell’utilizzo continuo e generalizzato, questi sistemi apprendono dei nuovi pattern, e adattano il loro comportamento all’utilizzo che ne facciamo. Questa caratteristica pone un problema enorme relativamente ai rischi, perché risulta evidente che non basta introdurre degli elementi di autocontrollo in fase di progettazione, ma occorre mantenere un elevato livello di verifica durante tutto il ciclo di vita di questi sistemi, dalla fase di progettazione, al deploy, e al loro utilizzo, durante tutto l’arco temporale della loro esistenza.

Un notevole incremento delle capacità di controllo potrebbe essere ottenuto dallo sviluppo di Sistemi di AI “paralleli”, che siano dedicati specificamente all’esecuzione dei controlli sui sistemi principali, seguendo il loro apprendimento continuo. Un sistema parallelo che si evolva insieme al sistema principale, e che venga utilizzato contestualmente ad esso.

E’ un nuovo modo di concepire l’intero scenario dei controlli, che esce da un concetto prevalentemente normativo, ed acquista una caratterizzazione a se stante, di “Modello di AI di controllo”. Il nuovo paradigma con cui progettare questi sistemi darebbe delle migliori garanzie, perché vedrebbe una evoluzione parallela, nel corso della loro vita, degli Agenti di AI operativi e degli Agenti di AI di controllo, a loro antagonisti, in un utilizzo congiunto e complementare, che lavorino in simbiosi tra loro.

Il “Modello di Controllo” dovrebbe basarsi su una propria rete neurale autonoma, che rielabori costantemente le metriche di rischio, alimentando in tal modo un modello previsionale indipendente, basato su parametri di tipo diverso da quelli operativi. Si avrebbe così una valutazione costante degli effetti prodotti dall’evoluzione, monitorando una serie di parametri ben identificati, e con un controllo sui loro risultati, prevenendo così possibili effetti indesiderati. Identificare i fattori di rischio su cui operare, e stabilire quali parametri monitorare, e in che misura, sarebbe compito dei progettisti e degli esperti, in relazione alle diverse tipologie di rischio, di valutazione degli impatti, e in base ai contesti di applicazione.

Si tratta, in sintesi, di utilizzare l’Intelligenza Artificiale non solo come fattore di sviluppo e di progresso, ma anche come strumento di controllo di se stessa, così come si sta facendo nel campo della Cybersecurity, dove nuovi prodotti che utilizzano l’AI aiutano a combattere le nuove minacce, sviluppate utilizzando altri Modelli di AI [12].

E’ uno scenario tutto da esplorare, e da sviluppare nel prossimo futuro, che potrebbe dare un contributo molto importante al controllo di questo mercato. Perché la preoccupazione, inutile nascondercelo, è che l’evoluzione normativa, dei regolamenti e dei trattati, possa procedere ad un ritmo troppo lento rispetto a quello, infinitamente più rapido, a cui stiamo assistendo per la tecnologia. E in questo periodo di tempo, in cui questi controlli non saranno ancora applicati appieno, o tarderanno ad essere introdotti, correremo dei rischi le cui conseguenze sono difficilmente immaginabili.

Il controllo come chiave del futuro tecnologico umano

Se sapremo sgombrare il campo dall’equivoco provocato dal termine “Intelligenza Artificiale”, così come coniato da John McCarthy nel 1955 [13], potremo allora concentrarci sui metodi migliori per affrontare i nuovi rischi che ne derivano. In particolare, nel momento in cui interagiremo emotivamente con questi sistemi, per salvaguardare le debolezze e la personalità degli individui più esposti.

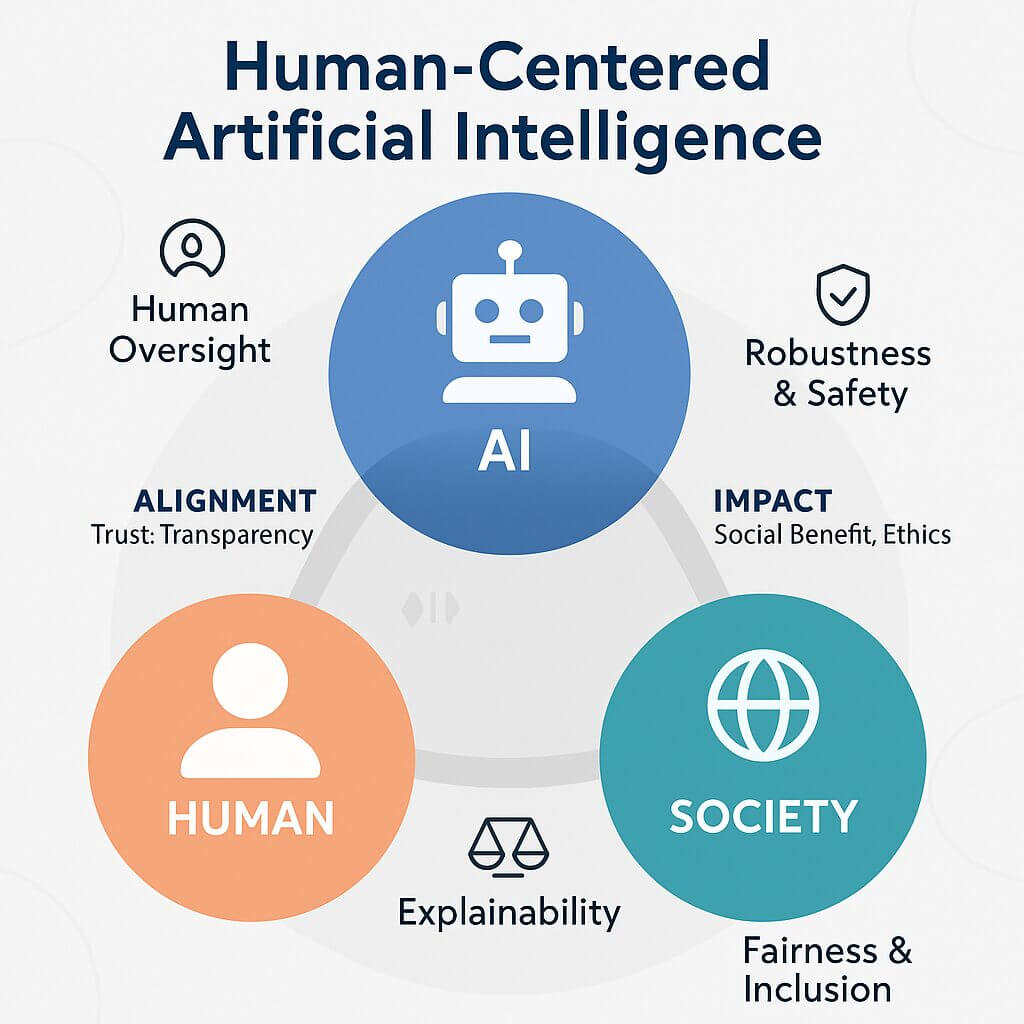

L’altro tema urgente, come abbiamo visto, è quello del controllo dei sistemi d’arma “intelligenti”. Sarà necessario seguire dei framework di Human Centered AI che guidino la progettazione e lo sviluppo, e poi l’impiego di questi sistemi in fase operativa, così come ha iniziato a fare l’AI Act [14].

Insieme alle normative, e nell’ottica di includere i Controlli fin dalla fase di progettazione di questi sistemi, sono state sviluppate delle linee guida da parte dei maggiori organismi internazionali, che danno dei riferimenti concreti a questo mercato. Un importante contributo è stata la definizione di un ”AI Risk Management Framework” del NIST, il “National Institute of Standards and Technology” degli Stati Uniti, pubblicato nel 2023, che fornisce una guida per l’intero ciclo di vita dei sistemi di AI, nel conciliare fiducia e gestione dei rischi [15]. Anche la ISO, l’ “International Organization for Standardization”, ha pubblicato uno standard di riferimento per la gestione di questi sistemi, lo “ISO/IEC 42001 – IT – AI – Management System”, sempre nel 2023 [16].

Abbiamo visto che il tema dei “Controlli” riguarda diversi aspetti, e non consiste in un metaforico “interruttore” da spegnere se le cose vanno male, perché purtroppo non è così semplice. I sistemi di intelligenza Artificiale sovraintendono ormai ad una serie notevolissima di compiti, dalla produzione industriale, alla guida autonoma di auto e di aerei, al controllo di infrastrutture critiche. Sistemi di AI vengono usati anche come assistenti personali, e nel prossimo futuro assisteremo all’entrata in campo di Robot antropomorfi domestici, per ogni tipo di supporto quotidiano.

Dovranno essere progettati e inseriti nei sistemi degli elementi di autocontrollo, che dovranno far parte integrante dei modelli di AI fin dalla fase di progettazione, che siano in grado di riconoscere i possibili rischi a cui si va incontro, ed anche i rapporti di dipendenza e i legami affettivi che si possano instaurare per gli interlocutori umani.

Le nuove regolamentazioni, evoluzioni dell’AI Act e delle normative affini, dovrebbero includere quindi degli elenchi specifici di autocontrolli, da inserire nei sistemi come standard, e di conseguenza anche delle regole efficaci per verificarne l’attuazione. Sono elementi di controllo che richiederanno ulteriori approfondimenti, e potranno portare anche a dei trattati internazionali, come dovrà essere possibile nel caso dei sistemi d’arma intelligenti.

E occorrerà introdurre dei controlli sui livelli di empatia, per indicare chiaramente all’interlocutore umano che sta rischiando una dipendenza emotiva da un sistema di AI, che ha a che fare con un software, e non con una persona. Una sorta di “Avvisi di salvaguardia psicologica”, che potrebbero far parte dei nuovi sistemi di controllo, da adottare nelle future regolamentazioni.

E c’è un’altra questione da considerare, per completare questa panoramica relativa ai Controlli, ed è l’interoperabilità tra i sistemi di AI: oggi per ottenere una comunicazione tra più sistemi di AI occorre gestirla esternamente, con un software di connessione, e ogni sistema tratta l’input come un input generico, non proveniente da altri modelli di AI. In futuro non è esclusa la possibilità di poter ottenere una comunicazione diretta tra sistemi di AI, e si aprirà, in questa eventualità, uno scenario da gestire con molta prudenza, e con opportuni controlli inibitori.

In particolare, come molti studiosi prevedono, se i Modelli di AI attuali si evolveranno assumendo la caratteristica di Modelli “AGI – Artificial General Intelligence”, dei sistemi cioè in grado di replicare e superare le prestazioni umane, aventi la capacità di comprendere i problemi senza avere un addestramento preventivo, ma imparando continuamente [17].

Non dovrebbe essere possibile alcuna comunicazione diretta, su iniziativa del singolo Sistema di AI, sia per risolvere un problema che per acquisire informazioni. Dovrebbe esserci un controllo inibente, non superabile dall’utente comune ma gestito a livello centralizzato. Non dovremmo insomma consentire la creazione di “Network di AI” cooperanti tra loro. Non si tratta di fantascienza, ma di adeguamento ad una nuova fonte di rischio che potrebbe presentarsi, a detta di molti, in un futuro non troppo lontano.

Se impareremo a utilizzare i “Modelli di AI di Controllo” potremo ricevere grandi benefici dall’ autocontrollo dell’AI, facendoci supportare dei sistemi stessi per individuare e monitorare costantemente i fattori di rischio, lasciando sempre nelle mani dell’uomo le decisioni finali, e la supervisione di ogni framework di utilizzo.

Passare dai principi all’applicazione concreta di tutte queste modalità di controllo non sarà un processo semplice, anche per la diversità di interessi economici e politici globali. E’ auspicabile che si cominci a pensare in termini di “umanità”, e non di singoli paesi. Sarà un cammino lungo e difficile, ma che risulta essenziale percorrere, perché è proprio sulla questione dei ”Controlli” che la fantascienza potrebbe incrociare gli sviluppi reali di queste tecnologie, portando a degli scenari fuori controllo, con dei pericoli effettivi per la specie umana.

E’ la prima volta nella storia in cui è stato creato un sistema tecnologico in grado di auto alimentarsi, di arrivare a prendere delle decisioni autonome, e di agire direttamente sulla vita e sulla esistenza stessa delle persone. Senza immaginare fantascientifiche superintelligenze aliene, dobbiamo però renderci conto della potenza di questa tecnologia, e sviluppare gli opportuni anticorpi in grado di salvaguardare le nostre vite, come persone e come specie vivente.

Il tema dei “Controlli” dei sistemi di AI, quelli esistenti, quelli in via di applicazione, e quelli che ancora non sono stati concepiti, è quello che sta acquisendo una importanza decisiva per il nostro futuro.

Note

[1]_ Livelli di rischio secondo l’AI Act – https://nessunsegnale.it/classificazione-rischi-dellai-act-tutto-quello-che-devi-sapere/

[2]: Open AI – Chat GPT 40 – https://openai.com/index/hello-gpt-4o/

[3]: Strategia Italiana per l’AI – https://innovazione.gov.it/notizie/articoli/strategia-italiana-per-l-intelligenza-artificiale-2024-2026/

[4]: Operazione “Tela di Ragno” – https://it.euronews.com/2025/06/02/operazione-tela-di-ragno-come-lucraina-ha-distrutto-oltre-un-terzo-dei-bombardieri-russi

[5]: Operazione “Rising Lion” – https://it.euronews.com/2025/06/13/israele-contro-iran-cosi-il-mossad-ha-avviato-unoperazione-segreta-e-attivato-droni-a-dist

[6]: Agenzia Internazionale per l’Energia Atomica – https://www.iaea.org/

[7]: Campagna Stop Killer Robot –

https://www.wired.it/article/robot-killer-battaglia-stop-onu

[8]: «Il tuo cervello e ChatGPT: accumulazione di debito cognitivo nell’usare un assistente di intelligenza artificiale per compiti di scrittura» – https://www.media.mit.edu/publications/your-brain-on-chatgpt

[9]: Massimo Canducci – Empatia Artificiale – Egea 2025

[10]: Garry Kasparov – Deep Thinking – Fandango 2019

[11]: Intervista a Garry Kasparov – https://video.repubblica.it/dossier/onlife/onlife-intervista-a-garry-kasparov-le-macchine-non-ci-sostituiranno/345210/345792

[12]: AI per la Cybersecurity – https://www.fortinet.com/it/resources/cyberglossary/artificial-intelligence-in-cybersecurity

[13]: Dartmouth Summer Research Project on Artificial Intelligence – https://www.cs.swarthmore.edu/~meeden/cs63/f11/AIproposal.pdf?

[14]: Human Centered AI – https://itdigest.com/artificial-intelligence/human-centered-ai-the-future-kind-of-humans-bestfriend/

https://hai.stanford.edu/?utm_source=SCPD&utm_medium=Website&utm_campaign=SCPD

[15]: NIST – AI Risk Management Framework – https://www.nist.gov/itl/ai-risk-management-framework

[16]: ISO/IEC 42001:2023 – ISO/IEC 42001:2023 – AI management systems

[17]: Artificial General Intelligence: https://www.ibm.com/think/topics/artificial-general-intelligence