Il digital divide cognitivo rappresenta l’evoluzione più insidiosa della disuguaglianza digitale: non riguarda più chi ha o non ha accesso alla tecnologia, ma chi possiede le competenze per comprendere, utilizzare e contestare i sistemi di intelligenza artificiale che plasmano la nostra realtà quotidiana.

Indice degli argomenti

La bolla algoritmica e l’inversione dei ruoli tra uomo e tecnologia

Ricordate “The Truman Show“? Truman vive in una bolla perfetta, e già qui dovrebbe suonare un campanello d’allarme, dove tutto sembra costruito apposta per lui: la città perfetta, il tempo perfetto, le coincidenze perfette e lui ci crede, perché vive una realtà “normale”, finché non inizia a notare delle crepe, quelle che altrove avrebbero definito “glitch“: un gatto che appare due volte, la pioggia che cade solo su di lui, i riflettori che cadono dal cielo…

Film visionario, classico caso di fantascienza che anticipa il futuro o parallelo inquietante con quello che stiamo vivendo oggi? Guardando la nostra realtà da una prospettiva esterna, ci rendiamo conto di come essa sia sempre più plasmata dagli algoritmi e similmente a Truman, ignaro delle telecamere, noi non percepiamo i sistemi che ci profilano, ci categorizzano e che prendono decisioni al nostro posto. Anticipando con quest’ultima affermazione una fra le possibili consapevolezze a cui questo viaggio potrebbe condurre, credo si possa tuttavia convergere sull’idea che non sia l’intelligenza artificiale ad adattarsi a noi: siamo noi, sempre più, a piegare il nostro pensiero, il nostro linguaggio e i nostri comportamenti alle esigenze delle macchine.

Storicamente, il progresso tecnologico ha sempre avuto un impatto trasformativo, democratizzando l’accesso a strumenti e conoscenze che un tempo erano appannaggio di pochi eletti: laboratori di ricerca all’avanguardia, accademie esclusive o circoli ristretti di intellettuali e benestanti detenevano il monopolio del sapere. Tuttavia, l’avvento di tecnologie come i personal computer, l’espansione di Internet, la diffusione capillare degli smartphone e i progressi nelle biotecnologie ha ridefinito radicalmente il nostro modo di vivere, lavorare e interagire.

Eppure, proprio in questo momento di massima onnipresenza tecnologica, emerge un rischio concreto forse non più sotto il nostro controllo: la possibilità che quanto ci circonda, la struttura stessa della società e persino la nostra percezione del mondo non siano più plasmati per l’essere umano, ma per soddisfare le logiche intrinseche della tecnologia e degli algoritmi sottostanti. La tecnologia, nata come strumento al nostro servizio, rischia di trasformarsi nel metro di misura della nostra stessa esistenza, dettando le condizioni e le modalità del nostro vivere. Naturalmente il fulcro del problema non risiede nella tecnologia in sé, benché superata una “massa critica” la tecnologia stessa non è più da definirsi “neutra”, ma nell’inversione dei ruoli che essa potrebbe innescare. Le esigenze di efficienza, ottimizzazione e connessione proprie dei sistemi tecnologici iniziano a dettare le nostre priorità, anziché il contrario. Questa dinamica si manifesta in molteplici modi nella vita quotidiana: dalla crescente dipendenza dagli algoritmi che modellano i nostri gusti, influenzano le nostre decisioni e prefigurano le nostre esperienze, all’adattamento delle nostre abitudini e persino degli spazi fisici alle interfacce digitali.

Un altro sintomo è la crescente difficoltà a disconnettersi da un flusso di informazioni continuo, spesso sovraccarico e frammentato, che può generare ansia e una sensazione di costante urgenza. Senza un’etica con principi fondativi comuni e una continua riflessione critica, la democratizzazione tecnologica si sta trasformando in una nuova forma di condizionamento dove questa ‘ampia accessibilità e diffusione universale della tecnologia sta portando ad una conformità dettata dalle logiche implicite, e spesso invisibili, intrinseche alle macchine.

E’ un presente scritto, non un futuro da scrivere.

Possibile che tutto ciò sia accaduto sotto gli occhi di tutti, anche degli “esperti”?

Pensateci un attimo, quando abbiamo accettato di trasformare le nostre domande in “prompt“? O quando di strutturare il nostro pensiero secondo delle logiche algoritmiche? Di cercare di comprendere e allinearci / conformarci ai requisiti delle interfacce invece di pretendere che fossero queste ultime ad adattarsi a noi? La tecnologia dovrebbe essere come un abito di sartoria, cucita su di noi, per le nostre esigenze e necessità proprio in virtù di principi etici e morali nei quali è il benessere dell’uomo, come singolo individuo e come parte della società, il motore trainante eppure basta parlare di “prompt engineering“, ed è solo la punta di un iceberg, per realizzare quanto fallace e utopistica sia questa prospettiva.

Il digital divide 3.0 e l’assistenza AI always-on

Si tratta di una inversione di tendenza silenziosa e latente, che sta creando una nuova forma di disuguaglianza, un digital divide cognitivo, una frattura che non riguarda più chi ha o non ha accesso alla tecnologia, ma chi possiede o meno le competenze per sopravvivere in un mondo plasmato a misura di quest’ultima. Un caso recente, l’annuncio dei nuovi occhiali di Meta, Ray-Ban Meta, integranti Meta AI per un dispositivo always-on che vede e sente ciò che vediamo e sentiamo. Naturalmente il punto di rottura non sono gli occhiali in sé ma l’AI che li alimenta a partire dal modo in cui sono stati presentati, dei “co-pilota cognitivi” perché se la conoscenza è potere, come definiamo quindi l’accesso istantaneo e contestuale alla conoscenza universale? Un superpotere? Il “digital divide” classico era basato sull’accesso, il Divide 2.0, sulla competenza, chi sa usare gli strumenti digitali vs. chi non sa usarli e ora? Stiamo entrando in un Divide 3.0 (Cognitivo / Aumento) fra chi ha un’assistenza AI always-on che aumenta le proprie capacità vs. chi si affida solo alla propria cognizione biologica.

E chi rimane escluso da questo mondo, cosa diventa?

La retorica della salute mentale e il controllo degli utenti

Un altro esempio illuminante di quanto il controllo non sia nelle nostre mani arriva direttamente dal CEO di OpenAI: Sam Altman ha recentemente annunciato sul suo canale X che ChatGPT diventerà “meno restrittivo” perché ora avrebbero “mitigato i seri problemi di salute mentale”. Fermiamoci un attimo. Come si “mitiga” la salute mentale? Con del codice migliore? Con qualche controllo sull’età? Davvero? Tutti sappiamo che ChatGPT è stato insopportabilmente prudente, rifiutando qualsiasi cosa minimamente controversa, scusandosi per esistere, trattando ogni utente come se fosse fatto di porcellana. Ci hanno detto che era per la “salute mentale”. E ora, improvvisamente, l’hanno “risolta”? Con cosa, esattamente? Quali erano questi “seri problemi di salute mentale”? Perché nessuno li ha mai spiegati nel dettaglio? “Trattare gli utenti adulti come adulti” scrive Altman. Grazie. Ma perché ci è voluto così tanto? Perché non è stato questo l’approccio dal primo giorno? Gli adulti sono adulti… o no? E l’accesso a contenuti per “adulti verificati” annunciato a dicembre? Privacy? Paesi con leggi rigide sull’identificazione? Aspetti etici e guardrail per un’AI senza vera “intelligenza”? La salute mentale non si “aggiusta” con un aggiornamento software, non stiamo parlando di bug: le persone vulnerabili rimangono vulnerabili. I rischi non sono magicamente scomparsi, non possono scomparire e sappiamo benissimo per la letteratura accademica i modelli attuali basati su architettura “transformer“, senza scendere del tecnico-tecnicismo fine a sé stesso in questo nostro viaggio, allucinano non appena ricevono dati. I messaggi sono importanti, soprattutto quando si ha una base utenti di oltre 700 milioni di utenti attivi settimanalmente, “Se vuoi che agisca come un amico”: ma vogliamo davvero che l’AI agisca come amici? È sano? Altman si preoccupa della salute mentale mentre costruisce “simulatori di relazioni“? Il suo intervento offre una speranza: “speriamo che sarà migliore”. In che senso “speriamo”? Quali inoltre le ricadute di queste dichiarazioni agli occhi dei competitors? Legittimare altro?

Chi decide quando un sistema è “abbastanza sicuro”? Chi decide i limiti? Chi controlla i controller? Non noi utenti, questo è certo. Forse il vero problema di salute mentale è costruire prodotti che rendono le persone emotivamente dipendenti da “amici” AI mentre si afferma di fare attenzione alla salute mentale.

Chi decide i confini dell’intelligenza artificiale

Il paradosso è evidente: da una parte si celebra l'”AI al servizio dell’umanità“, dall’altra la realtà quotidiana rivela che sono gli esseri umani a doversi conformare ai requisiti di questi sistemi, imparando a “parlare la loro lingua”, a sottostare ai loro bisogni, come la necessità di una connessione ad Internet, a rispettare i loro tempi di “ragionamento” o delle risposte fuorvianti incuranti dei potenziali effetti collaterali.

Ma chi ha deciso che dovremmo essere noi ad imparare il linguaggio delle macchine e non viceversa?

E perché accettiamo questo destino, come fosse già scritto ed inevitabile?

Questo adattamento forzato non è neutrale: genera esclusioni sistematiche, erode l’autonomia cognitiva e standardizza il pensiero. Come osservano i ricercatori Jan van Dijk e Alexander van Deursen, siamo di fronte a un “second-level digital divide“: anche con accesso universale alla tecnologia, il divario nelle competenze continua ad ampliarsi, determinando chi prospera e chi viene lasciato indietro nell’era dell’AI.

È davvero questo il futuro che vogliamo?

Quando le competenze diventano barriere: la nuova esclusione

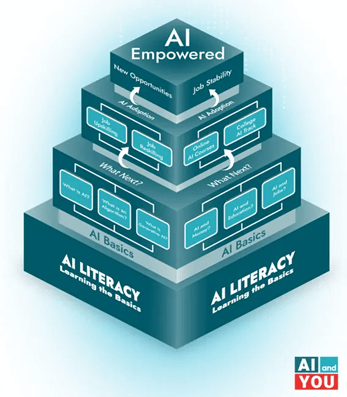

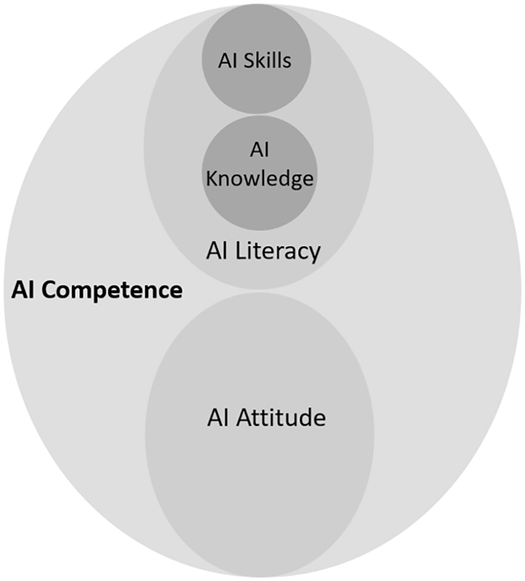

Il tradizionale digital divide, incentrato sull’accesso materiale (possesso di un computer, connessione internet), è stato in gran parte superato, sebbene permangano regioni in cui rappresenta ancora un problema significativo, ma ne è emersa una forma più insidiosa, o forse quella originaria si è semplicemente trasfigurata perché questo nuovo concetto, il cognitive digital divide, identifica una disparità basata sulle abilità: la capacità di comprendere come funzionano gli algoritmi, di interagire efficacemente con sistemi AI, di valutare criticamente i loro output. Non basta più saper usare un dispositivo, occorre padroneggiare quella che l’UNESCO definisce “AI literacy“, un insieme di competenze che includono comprensione dei principi del machine learning, capacità di prompt engineering, alfabetizzazione algoritmica, pensiero critico applicato agli output AI. Ma quanti di noi possiedono davvero queste competenze? E chi decide quali competenze sono “necessarie” oggi? Oggi, sì, perché un altro aspetto caratterizzate l’era che stiamo vivendo è la contingenza, un presente in continuo divenire, senza che si abbia il tempo di comprendere e padroneggiare queste tecnologie.

Fonte: AI literacy and the new Digital Divide – A Global Call for Action

La distribuzione diseguale delle competenze AI

Nella ricerca accademica “The artificial intelligence divide: Who is the most vulnerable?“, pubblicata nel 2024 su SageJournals, si è dimostrato, limitatamente al campione del test, che queste competenze sono distribuite in modo profondamente diseguale: la popolazione censita è quella olandese, quindi non riflette assolutamente la diversità potenziale di altre regioni europee ma soprattutto extra-europee, tuttavia è utile benchmark perché ha portato ad identificare cinque categorie di utenti: esperti favorevoli, esperti scettici, utenti medi, scettici privi di competenze e utenti neutrali senza competenze.

Fonte: The artificial intelligence divide: Who is the most vulnerable?

I gruppi più vulnerabili principalmente anziani con bassa scolarizzazione mostrano i livelli più bassi di competenza AI e sono sistematicamente esclusi dai benefici della tecnologia. Estendendo l’analisi fuori da questo studio, altre ricerche prese in esame nella nostra riflessione (UNESCO, Monitoring 2023 GEM Report) seppur non afferenti la medesima finestra temporale, evidenziano come solo una limitata parte di adulti sia in grado di scrivere un programma informatico, ma qui non è tanto la finalità dello scrivere quanto la coscienza e consapevolezza di come farlo da evidenziare, mentre nell’Africa subsahariana il 90% dei bambini lascia la scuola senza competenze digitali di base. Sono numeri che dovrebbero farci riflettere: stiamo davvero costruendo un futuro inclusivo? Il divario di genere è altrettanto marcato: le donne hanno 1,6 volte più probabilità degli uomini di citare la mancanza di competenze come barriera all’uso di Internet e sono quattro volte meno rappresentate nelle professioni legate all’AI. Lo studio condotto da randstad nel 2024 evidenzia anche questa scarsità di talenti, segno che per quanto si senta la necessità di figure con competenze verticali in questo settore, le aziende stesse manchino di formarle e farle crescere quando assunte (“upskilling” e / o “reskilling“?). In realtà, l’attenzione non è da porsi unicamente sull’assenza di skills e competenze, quanto sul fatto che il mondo digitale richiede sempre più adattamento umano alle logiche delle macchine: imparare a usare l’AI significa ristrutturare il proprio modo di comunicare, significa passare dal linguaggio naturale a istruzioni strutturate, fornire contesto esaustivo perché l’algoritmo non può dedurlo (ed al momento è un bene…), iterare continuamente per ottenere risultati accettabili. Vi è mai capitato di riformulare tre, quattro, cinque volte la stessa domanda a ChatGPT, Gemini o Deepseek per ottenere una risposta sensata? E non vi siete chiesti perché dovrebbe essere normale? Non possiamo adottare una tecnologia che cambia così rapidamente.

Non è compatibile con le nostre vite, i nostri impegni, il tempo da dedicare ai nostri affetti, a noi stessi.

L’opacità algoritmica e il danno ermeneutico

Esiste una forma di violenza epistemica ancora più sottile: l’impossibilità di comprendere le decisioni che ci riguardano. La filosofa britannica Miranda Fricker nel suo libro “Epistemic Injustice: Power and the Ethics of Knowing” (2007), sostiene che, oltre alle ingiustizie sociali più note (come la disuguaglianza economica o legale), esiste una forma distinta di ingiustizia che colpisce le persone specificamente nella loro capacità di “soggetti conoscenti” (cioè, come esseri umani che capiscono, sanno e comunicano la conoscenza). Una ingiustizia che si delinea su due piani: una ingiustizia testimoniale, quando un ascoltatore sminuisce ingiustamente la credibilità di chi parla a causa di un pregiudizio identitario (legato a genere, razza, classe sociale, accento, ecc.) ed una ingiustizia ermeneutica, quando una società manca degli strumenti concettuali condivisi (le “risorse ermeneutiche collettive“) per comprendere, o persino articolare, un’esperienza sociale vissuta da un gruppo.

Le ricerche della Fricker sono state alla base di numerosi studi recenti tra i quali indubbiamente quello portato a termine da Silvia Milano e Carina Prunkl è fra i più noti: “Algorithmic profiling as a source of hermeneutical injustice” (2024), ad oltre 17 anni dall’opera della filosofa britannica, si concentra proprio sull’opacità dell’Intelligenza Artificiale, sostenendo che i sistemi algoritmici complessi, in particolare quelli usati per la profilazione algoritmica (algorithmic profiling), creano una nuova forma di ingiustizia ermeneutica.

E’ noto che molti sistemi di AI (specialmente quelli legati al “reasoning“) sono “scatole nere“: prendono decisioni cruciali sulla vita delle persone ma il loro funzionamento interno è così complesso da essere incomprensibile, talvolta agli occhi dei loro stessi creatori. Nel concreto, come si manifesterebbe o come potremmo riconoscere questa nuova forma di ingiustizia? Sicuramente il primo aspetto è quello della non comprensione di una decisione, seguita dalla successiva mancanza di una spiegazione, il banale “perché” (a causa dell’opacità del sistema, la risposta è “l’algoritmo ha deciso così” oppure è una spiegazione tecnica incomprensibile che non rivela la vera logica…), la lacuna ermeneutica, nella quale l’individuo non ha le risorse concettuali per capire cosa gli è successo, non sa se la decisione è stata giusta, ingiusta, basata su dati errati o su un pregiudizio, un bias, nascosto nell’algoritmo. Questa lacuna interpretativa non è solo frustrante, è un danno perché impedisce all’individuo di formulare il problema in modo coerente e, di conseguenza, di rendere impossibile contestare la decisione o rivendicare i propri diritti.

Non puoi combattere contro una logica che non puoi nemmeno nominare.

Qualche mese fa, Mustafa Suleyman, una delle menti più brillanti del panorama moderno dell’intelligenza artificiale, ha scritto un articolo sul suo blog personale, terminando con una frase che suona come un monito “we must build AI for people; not to be a person“: intelligenze artificiali al servizio dell’uomo, non suoi cloni per sostituirli.

Jackie Kay, Atoosa Kasirzadeh e Shakir Mohamed, nella loro ricerca del 2024 sull’AI generativa “Epistemic Injustice in Generative AI“, identificano quattro dimensioni di questa ingiustizia epistemica: l’AI amplifica pregiudizi sociali dai dati di addestramento, viene manipolata intenzionalmente per produrre falsità (i deepfake ad esempio), manca di comprensione socioculturale delle esperienze delle minoranze, genera accesso diseguale alla conoscenza a seconda della lingua o del gruppo identitario. Coloro i quali hanno un basso livello di alfabetizzazione tecnologica si trovano in una duplice difficoltà: sono soggetti a decisioni basate su algoritmi e non possiedono gli strumenti necessari per comprenderle o opporsi ad esse. Come possiamo, dunque, definire questo fenomeno? Ma soprattutto: lo definiamo con la finalità di comprenderne impatti e possibili mitigazioni oppure banalmente, per continuiamo ad ignorarlo? Sistemi di scoring creditizio, algoritmi di selezione del personale, piattaforme di giustizia predittiva decidono su prestiti, assunzioni, pene detentive… chi non comprende come funzionano questi sistemi non può difendersi anzitutto perché non ne ha consapevolezza, non ha gli strumenti e le conoscenze per identificarli, si ritrova inerme, incapace perfino di articolare il disagio che prova.

Libertà e capacità di comprendere i meccanismi che ci governano

Questa “frammentazione epistemica” isola gli individui, rendendo difficile sviluppare e applicare nuove risorse interpretative condivise. Il risultato è una popolazione subalterna nella società algoritmica, priva degli strumenti cognitivi per esercitare il proprio diritto all’agire in modo consapevole.

Siamo davvero liberi se non possiamo comprendere i meccanismi che ci governano e come definire l’incapacità stessa di non poter esprimere questo disagio?

Erosione dell’autonomia e standardizzazione del pensiero

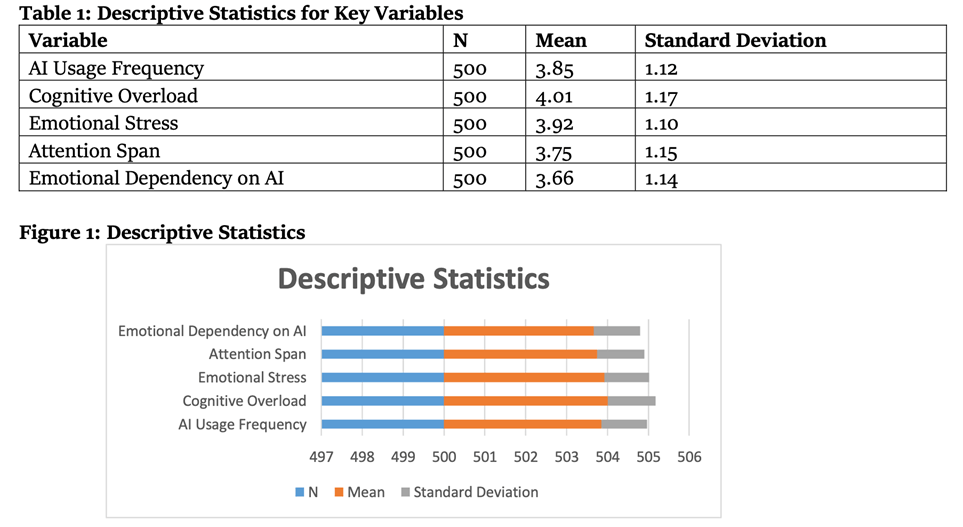

Le conseguenze psicologiche dell’adattamento forzato all’AI sono misurabili e preoccupanti. Gerlich, in uno studio del 2025, “AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking“, su 666 partecipanti, ha dimostrato una correlazione negativa importante tra uso frequente di strumenti AI e capacità di pensiero critico, mediata dall’aumento del “cognitive offloading“, la delega di compiti cognitivi a strumenti esterni. Ma cosa perdiamo esattamente quando deleghiamo il nostro pensare? I partecipanti più giovani (17 –-> 25 anni) mostrano dipendenza più alta e punteggi inferiori nel pensiero critico. Stiamo crescendo una generazione che sa interrogare le macchine ma non sa più interrogare se stessa? Una meta-analisi condotta da ricercatori della Purdue University (West Lafayette, Indiana) su AI e design evidenzia il fenomeno del “deskilling“: quando la dipendenza da sistemi tecnologici riduce competenze esistenti o impedisce lo sviluppo di nuove, creando l’ironia che operatori umani devono supervisionare sistemi che non possiedono più le capacità di gestire autonomamente. Nel settore medico, una revisione sistematica del 2025 documenta come i clinici vengano sempre più relegati a ruoli di supervisione piuttosto che di decisione attiva, con erosione delle capacità di esame fisico, diagnosi differenziale e comunicazione medico-paziente. Affidare compiti all’intelligenza artificiale, pur consentendo in alcuni contesti di focalizzarsi su aspetti a più alto valore, comporta, a lungo termine, un’inevitabile perdita di familiarità con le modalità di esecuzione di tali attività. Vogliamo davvero che i nostri medici dimentichino come visitare un paziente perché l’algoritmo lo fa al posto loro? In Pakistan, lo studio “Psychological Impacts of AI Dependence: Assessing the Cognitive and Emotional Costs of Intelligent Systems in Daily Life” condotto su 500 professionisti sanitari ed educativi ha rilevato che l’uso prolungato di AI porta a sovraccarico cognitivo, stress emotivo amplificato, ansia nelle decisioni critiche e riduzione dell’autonomia decisionale.

Fonte: Psychological Impacts of AI Dependence: Assessing the Cognitive and Emotional Costs of Intelligent Systems in Daily Life

Lo studio naturalmente riflette una fotografia ben definita il che impedisce di stabilire nessi di causalità (cosa causa cosa), impedisce di comprendere gli impatti psicologici a lungo termine e gli effetti della dipendenza dall’IA sul benessere professionale tuttavia, per quanto limitato, offre un quadro chiaro di una realtà in essere.

Dipendenza emotiva e monocultura algoritmica

La dipendenza non è solo funzionale, ma emotiva. Siamo sicuri che questo sia progresso?

Altrettanto inquietante è la standardizzazione del pensiero: uno studio di Stanford del 2022, “Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization?” documenta come la “monocultura algoritmica“, l’uso degli stessi sistemi da parte di molteplici decisori crei omogeneizzazione dei risultati, istituzionalizzando l’esclusione sistematica e riscrivendo gerarchie sociali. Studi recenti sulla scrittura assistita dall’intelligenza artificiale rivelano che i saggi generati da strumenti di AI mostrano una notevole uniformità, non solo a livello linguistico ma anche nel loro contenuto concettuale. Cosa rimane della nostra individualità quando pensiamo tutti allo stesso modo? Gabriel Giani Moreno in un articolo su Medium evidenzia questa “cultura monoalgoritmica” per la quale “ciò che inizia come assistenza diventa un processo di cessione di controllo, dove il confine tra creatività umana e conformità generata da macchine sfuma”.

Le voci che plasmano la nostra società riflettono sempre più le sfumature dell’algoritmo, piuttosto che le prospettive uniche delle loro origini umane”. Siamo ancora autori dei nostri pensieri o semplici ripetitori di schemi algoritmici? Nei sistemi di raccomandazione, gli utenti che subiscono perdite di utilità sperimentano maggiore omogeneizzazione, intrappolati in loop di feedback che amplificano i bias sociali. E noi, siamo forse prigionieri delle stesse bolle? Molto interessante in merito anche il concetto di “distant writing” del prof.Luciano Floridi una nuova pratica letteraria in cui gli autori agiscono come “designer“, utilizzando assistenti di Intelligenza Artificiale (basati su LLM) per generare narrazioni.

Mantenendo il controllo creativo attraverso prompt precisi e revisioni, l’autore sfrutta l’IA per creare nuove opere. A differenza del “distant reading” (lettura a distanza) di Moretti, che analizza testi esistenti, il “distant writing” (o “wrAIting“) produce nuovi testi, espandendo la creatività umana e aprendo possibilità narrative prima inaccessibili.

Le geografie della disuguaglianza artificiale

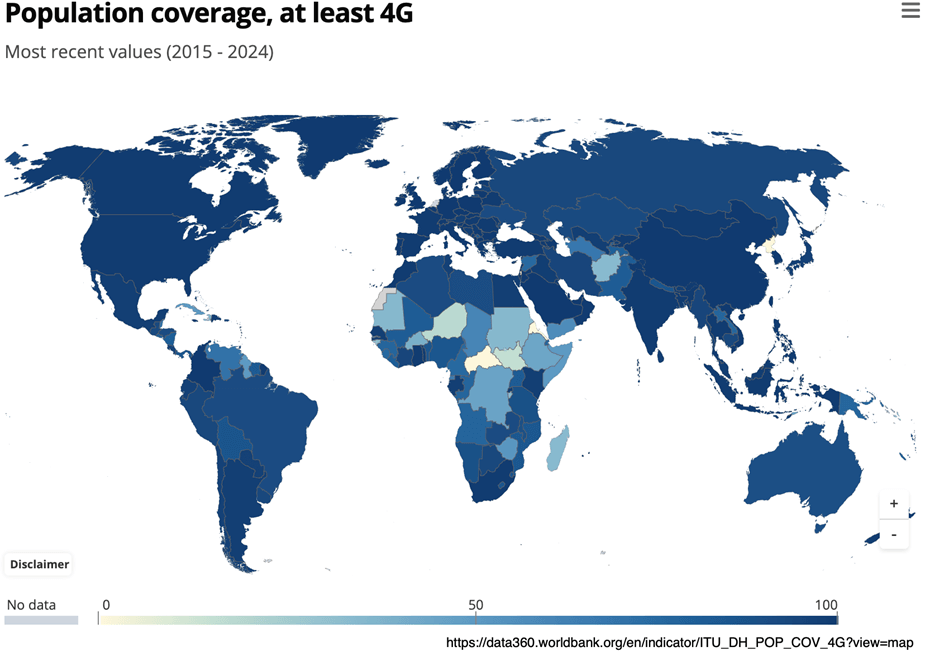

Ma questo divario cognitivo non si distribuisce uniformemente nello spazio, ha una geografia precisa, una mappa che ricalca e amplifica le disuguaglianze che già conosciamo. Quando parliamo di intelligenza artificiale, tendiamo a immaginare un futuro in cui la tecnologia si diffonderà naturalmente, come è accaduto con i telefoni cellulari tuttavia dati raccontano una storia completamente diversa: stiamo assistendo alla formazione di una nuova cartografia globale in cui alcune regioni accumulano capacità cognitive potenziate mentre altre rimangono ai margini, condannate a un’esclusione che non è più solo economica ma diventa epistemica, cognitiva, esistenziale.

Prendendo ad esempio i numeri dell’analisi condotta dall’International Telecommunication Union (2024), i paesi ad alto reddito mostrano una copertura 5G dell’84% mentre quelli a basso reddito si fermano al 4%. Non è un rapporto di 2 a 1 o di 5 a 1. È un rapporto di 21 a 1. E il 5G non è un lusso tecnologico: è l’infrastruttura che permette applicazioni AI avanzate, quelle definiranno chi può competere nell’economia globale e chi no. Questa fotografia però rappresenta un divario che non andrà ad assottigliarsi, come ci aspetteremmo con la diffusione tecnologica, ma tenderà ad ampliarsi.

L’OCSE (2024) ha misurato che il gap di velocità tra aree metropolitane e rurali è triplicato in cinque anni, passando da 22 Mbps a 58 Mbps.

Triplicato, in cinque anni, nonostante investimenti miliardari in infrastrutture.

La concentrazione geografica dell’AI non è casuale: Madeleine, Daepp e Counts (2024), analizzando i pattern di ricerca di ChatGPT nei primi sei mesi dal lancio attraverso database su larga scala, hanno mappato l’emergere di veri e propri “hotspot” nelle aree metropolitane costiere degli Stati Uniti e “coldspot” nel Sud, negli Appalachi, nel Midwest. Sorprende? Non sorprende? Il punto non è che esistano disparità, il punto è che questo meccanismo non fa altro che amplificarle: l’analisi identifica nell’istruzione il più forte predittore della consapevolezza AI.

Le contee con i tassi più alti di ricerca sono quelle con popolazioni proporzionalmente più istruite ed economicamente avvantaggiate ma non è tutto: chi ha più risorse cognitive ed economiche adotta prima l’AI, l’AI amplifica le sue capacità, questo lo rende ancora più competitivo, attrarre più risorse, consolida il vantaggio. E gli altri? Gli altri rimangono indietro, sempre di più, sempre più velocemente. Quello che questi dati rivelano non è semplicemente un “ritardo” temporaneo destinato a essere colmato dalla normale diffusione tecnologica. La natura auto-rinforzante dell’innovazione AI crea quelle che Walker e Winders (2024) chiamano “economie di agglomerazione“, sempre più intense: dati, talenti, capitali e infrastrutture si attraggono reciprocamente. Silicon Valley attrae i migliori ricercatori perché ha le migliori aziende; ha le migliori aziende perché attrae capitali; attrae capitali perché ha l’ecosistema più avanzato; ha l’ecosistema più avanzato perché attrae i migliori ricercatori. È un loop che si auto-alimenta e auto-accelera. E ogni ciclo aumenta la distanza tra il centro e le periferie.

Il divario colpisce anche all’interno dei paesi sviluppati: negli Stati Uniti, solo il 58% dei residenti rurali ha banda larga domestica contro il 70% dei suburbani. Il divario generazionale è altrettanto netto: solo il 22% dei Baby Boomers riceve formazione AI contro il 45% della Generazione Z, i cui skill AI sono cresciuti del 292% rispetto alla media del 110%.

La biforcazione evolutiva della specie umana

Ma cosa accade ai nostri genitori, ai nostri nonni, lasciati indietro da questa corsa? Le donne affrontano barriere multiple: sono 2 volte più a rischio di sostituzione lavorativa AI rispetto agli uomini, hanno il 5% in meno di probabilità di ricevere formazione AI, e sono sottorappresentate dell’86% nei ruoli di data science e AI nella Silicon Valley. È davvero accettabile? Non stiamo parlando di una disuguaglianza che può essere risolta con più investimenti in infrastrutture. Stiamo parlando di una biforcazione evolutiva nella specie umana, dove alcune popolazioni sviluppano capacità cognitive potenziate dall’AI mentre altre rimangono ancorate alla cognizione biologica di base.

E quando questa biforcazione sarà completa, quando le architetture cognitive saranno così divergenti da non poter più comunicare efficacemente, avremo creato quello che Alonso, Kothari e Rehman (2024) chiamano un “terms of trade” globale completamente squilibrato dove il Nord globale produce materie prime e lavoro a basso costo, mentre il Nord globale produce intelligenza, innovazione, valore ad altissimo contenuto cognitivo.

E se un giorno fossimo poi la figura che non avrà un posto di lavoro perché come suggerito dal CEO di Perplexity, forse uno strumento è in grado di svolgere il nostro compito?

Queste disparità non sono accidentali.

Le scelte che determinano chi conta nello sviluppo AI

Portano a riflettere alcune scelte precise su dove investire risorse educative, quali popolazioni includere nello sviluppo tecnologico, quali voci contano nella definizione degli standard AI. Chi sta decidendo per tutti noi? Le comunità più marginalizzate donne, persone di colore, persone con disabilità, comunità LGBTQ+ sopportano il peso maggiore del divario AI. In 31 paesi con dati disponibili, chi ha istruzione terziaria ha quasi il doppio delle probabilità di possedere competenze digitali di base rispetto a chi ha minore scolarizzazione. L’AI literacy sta diventando un marcatore di classe, determinando chi può prosperare e chi sarà escluso dall’economia e dalla società del futuro.

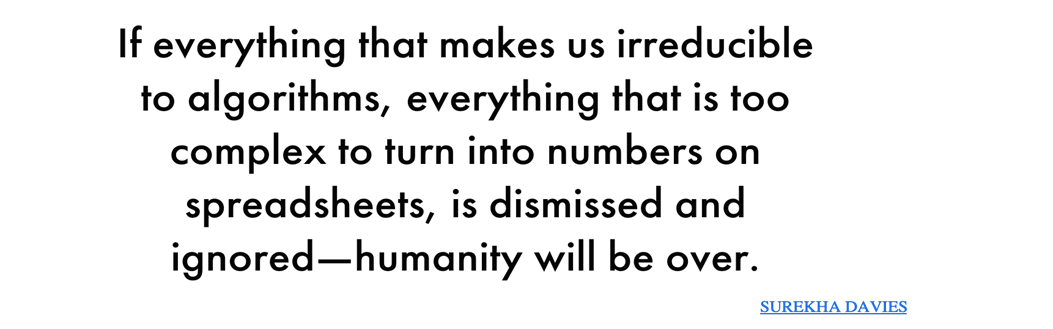

Verso un’ecologia digitale della giustizia

Di fronte a questa deriva, emergono voci critiche che smascherano la retorica dell'”AI al servizio dell’umanità”. La storica Surekha Davies denuncia una “disumanizzazione economica” con il suo appello “We’re Already at Risk of Ceding Our Humanity to AI” in cui “le persone non sono altro che i prodotti del loro lavoro” e “se tutto ciò che ci rende irriducibili agli algoritmi, tutto ciò che è troppo complesso per essere trasformato in numeri su fogli di calcolo, viene respinto e ignorato l’umanità sarà finita”. Possiamo permetterci di ignorare questo avvertimento? Uno studio del 2025 della Elon University su 300+ esperti tecnologici globali rivela che oltre il 61% prevede cambiamenti “profondi” o “rivoluzionari” alle capacità umane entro il 2035, con effetti “prevalentemente negativi” su 9 dei 12 tratti essenziali: intelligenza sociale ed emotiva, capacità di pensiero profondo, fiducia in norme condivise, empatia, benessere mentale, senso di agentività. Gli esperti avvertono: “stiamo camminando nel sonno verso un futuro AI che non abbiamo mai inteso e non vogliamo”.

Quando ci sveglieremo?

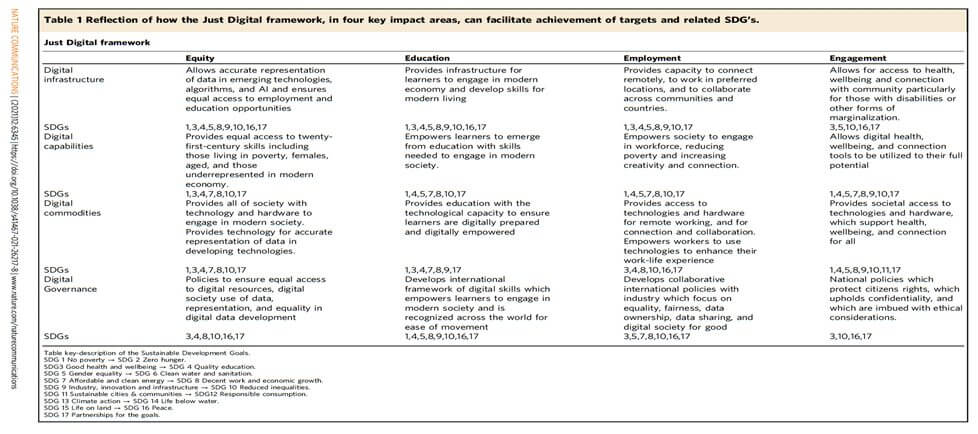

Costruire un’ecologia digitale più equa richiede ribaltare il paradigma dominante, non più “adattare gli umani all’AI” ma progettare sistemi che rispettino e amplificano la diversità cognitiva umana. Ma chi ha il potere di operare questo ribaltamento? L’UNESCO propone un framework etico AI basato su diritti umani, inclusività e preservazione della diversità culturale. Il concetto di “giustizia epistemica” richiede che i sistemi AI riconoscano forme multiple di conoscenza, non solo quella quantificabile e automatizzabile. Il framework “Just Digital” proposto nel 2021 articola quattro pilastri: infrastruttura digitale equa, capacità digitali attraverso educazione, accesso ai dispositivi, e governance digitale etica con partecipazione pubblica.

Fonte: nature, articolo: A Just Digital framework to ensure equitable achievement of the Sustainable Development Goals (2021)

Sono belle parole ma servono azioni concrete, movimenti di attivismo digitale contro la sorveglianza di massa, che sfida i monopoli informativi, iniziative comunitarie per alfabetizzazione AI radicata nei territori. Come propongono i ricercatori di Stanford, dobbiamo scegliere “augmentation over automation” AI che completa le persone permettendo loro di fare cose nuove, non che le sostituisce. Significa investire nell’educazione critica alla tecnologia, garantire che comunità marginalizzate partecipino alla progettazione AI, sviluppare interfacce che rispettino l’autonomia cognitiva umana piuttosto che estrarla. Il digital divide cognitivo non è un effetto collaterale inevitabile del progresso, ma il risultato di scelte politiche ed economiche precise. Possiamo ancora decidere se vogliamo un futuro in cui l’intelligenza umana con tutta la sua meravigliosa imperfezione, diversità, e complessità sia celebrata e supportata, o un mondo in cui solo chi sa piegare il proprio pensiero ai requisiti delle macchine merita di partecipare pienamente alla società. La domanda non è se l’AI cambierà il mondo, lo sta già facendo, ma chi avrà il potere di decidere come e quando, chi potrà decidere al nostro posto.

Ma che mondo vogliamo?

Glossario dei termini

AI Literacy: L’insieme di competenze necessarie per comprendere, utilizzare e valutare criticamente i sistemi di intelligenza artificiale, inclusi principi di machine learning, prompt engineering e alfabetizzazione algoritmica. Definito dall’UNESCO come essenziale per ridurre il nuovo digital divide.

Allucinazione (in AI): Fenomeno in cui modelli basati su architetture transformer generano informazioni false o incoerenti, spesso a causa di input ambigui o dati di addestramento limitati.

Augmentation over Automation: Principio che privilegia l’uso dell’AI per amplificare le capacità umane (augmentation) anziché sostituirle completamente (automation), promosso da istituzioni come Stanford HAI per un approccio etico.

Bias Algoritmico: Pregiudizi sistematici incorporati negli algoritmi, derivanti da dati di addestramento distorti, che possono amplificare discriminazioni sociali basate su genere, razza o altre categorie.

Cognitive Digital Divide: Una forma avanzata di digital divide basata non sull’accesso alla tecnologia, ma sulle competenze cognitive per interagire con l’AI, creando disparità tra chi padroneggia questi sistemi e chi no.

Cognitive offloading: La delega di compiti cognitivi (come ragionamento o memoria) a strumenti esterni come l’AI, che può ridurre le capacità di pensiero critico a lungo termine.

Deepfake: Contenuti multimediali falsi generati dall’AI, come video o audio manipolati, che amplificano ingiustizie epistemiche diffondendo disinformazione.

Deskilling: Il processo di erosione o perdita di competenze umane dovuto alla dipendenza da sistemi tecnologici, come nel settore medico dove i clinici diventano supervisori anziché decisori attivi.

Digital Divide: Tradizionalmente, la disparità nell’accesso a tecnologie digitali; evolve in forme come il “second-level” (basato su competenze) o “Divide 3.0” (cognitivo/aumento, tra chi ha AI always-on e chi no).

Distant Writing (wrAIting): Pratica letteraria in cui autori usano AI come assistenti per generare testi, agendo come “designer” attraverso prompt e revisioni, contrapposta al distant reading (analisi computazionale di testi esistenti).

Economia di agglomerazione: Meccanismo auto-rinforzante in cui risorse (dati, talenti, capitali) si concentrano in aree specifiche (es. Silicon Valley), amplificando disuguaglianze geografiche nell’innovazione AI.

Giustizia epistemica: Concetto che richiede ai sistemi AI di riconoscere e integrare forme multiple di conoscenza umana, non solo quella quantificabile, per evitare esclusioni basate su opacità o bias.

Ingiustizia ermeneutica: Forma di ingiustizia epistemica in cui manca un framework condiviso per interpretare esperienze (es. decisioni algoritmiche opache), impedendo alle persone di articolare o contestare danni subiti.

Ingiustizia epistemica: Violazione del diritto a essere riconosciuti come “soggetti conoscenti”, inclusa l’ingiustizia testimoniale (sminuire credibilità per pregiudizi) e ermeneutica (mancanza di strumenti interpretativi).

Ingiustizia testimoniale: Aspetto dell’ingiustizia epistemica in cui la credibilità di una persona è ingiustamente sminuita a causa di pregiudizi identitari (es. genere, razza).

Machine Learning (ML): Sottocampo dell’AI in cui i sistemi imparano da dati per fare previsioni o decisioni, spesso attraverso modelli complessi come i transformer.

Monocultura algoritmica: L’uso diffuso degli stessi algoritmi che porta a omogeneizzazione di risultati, pensieri e decisioni, riducendo la diversità e istituzionalizzando esclusioni.

Opacità algoritmica: La natura “scatola nera” di molti sistemi AI, dove il funzionamento interno è incomprensibile, anche ai creatori, causando ingiustizie ermeneutiche.

Prompt engineering: Tecnica di ottimizzazione delle istruzioni (prompt) date a modelli AI per ottenere risposte accurate, che richiede all’utente di adattarsi alla logica della macchina.

Second-Level Digital Divide: Evoluzione del digital divide, focalizzata sulle disparità nelle competenze e nell’uso efficace della tecnologia, anziché sul mero accesso materiale.

Transformer (architettura): Modello di rete neurale usato in AI generativa (es. ChatGPT), noto per elaborare sequenze di dati ma soggetto ad allucinazioni e richiedente input strutturati.

Riferimenti

Policyreview.info. (2025). The intensified digital divide: Comprehending GenAI. https://policyreview.info/articles/news/intensified-digital-divide-comprehending-genai/1772

Van Deursen, A. J. A. M., & van Dijk, J. A. G. M. (2019). The first-level digital divide shifts from inequalities in physical access to inequalities in material access. New Media & Society, 21(2), 354-375. https://doi.org/10.1177/1461444818797082

UNESCO. (2024). AI literacy and the new Digital Divide A Global Call for Action. https://www.unesco.org/en/articles/ai-literacy-and-new-digital-divide-global-call-action

Wang, C., Boerman, S. C., Kroon, A. C., Möller, J., & de Vreese, C. H. (2025). The artificial intelligence divide: Who is the most vulnerable? New Media & Society. https://doi.org/10.1177/14614448241232345

UNESCO. (2023). Monitoring 2023 GEM Report. https://gem-report-2023.unesco.org/monitoring-7/

Randstad. (2024). AI skills gap widens. https://www.randstad.com/press/2024/ai-skills-gap-widens/

Watkins, M. (2024). Adapting To AI Is Not Adopting AI. Substack. https://marcwatkins.substack.com/p/adapting-to-ai-is-not-adopting-ai

Fricker, M. (2009). Epistemic injustice: Power and the ethics of knowing. Oxford University Press.

Kay, J., Kasirzadeh, A., & Mohamed, S. (2024). Epistemic Injustice in Generative AI. arXiv preprint. https://arxiv.org/html/2408.11441v1

Milano, S., Taddeo, M., & Floridi, L. (2024). Algorithmic profiling as a source of hermeneutical injustice. Philosophical Studies. https://doi.org/10.1007/s11098-023-02095-2

Gerlich, M. (2025). AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking. Societies, 15(1), 6. https://doi.org/10.3390/soc15010006

Prakash S., Phuong B., Sean S L., Max K., Ali B., Paul P., arXiv. (2025). De-skilling, Cognitive Offloading, and Misplaced Responsibilities: Potential Ironies of AI-Assisted Design. https://arxiv.org/html/2503.03924v1

Springer. (2025). AI-induced Deskilling in Medicine: A Mixed-Method Review and Research Agenda for Healthcare and Beyond. Artificial Intelligence Review. https://doi.org/10.1007/s10462-025-11352-1

Spcrd. (2024). Psychological Impacts of AI Dependence: Assessing the Cognitive and Emotional Costs of Intelligent Systems in Daily Life. Review of Applied Management and Social Sciences. https://ramss.spcrd.org/index.php/ramss/article/view/458

Liu, Y., Liu, X., Arora, N., & Goel, S. (2022). Picking on the Same Person: Does Algorithmic Monoculture lead to Outcome Homogenization? NeurIPS. https://arxiv.org/abs/2211.13972

OpenAI. (2022). InstructGPT: Training language models to follow instructions with human feedback.

Giani Moreno, G. (2024). The Algorithmic Monoculture: Are AI Writing Tools Leading Us to Surrender Our Intellectual Autonomy? Medium. https://gabriel-giani.medium.com/the-algorithmic-monoculture-are-ai-writing-tools-leading-us-to-surrender-our-intellectual-autonomy-b3f9bffa287d

Chaney, A., Stewart, B. M., & Engelhardt, B. E. (2017). How Algorithmic Confounding in Recommendation Systems Increases Homogeneity and Decreases Utility. arXiv preprint. https://arxiv.org/pdf/1710.11214

e-Estonia. (2025). AI Leap 2025: Estonia sets the standard for AI in education. https://e-estonia.com/ai-leap-2025-estonia-sets-ai-standard-in-education/

UNESCO. (2023). Global Education Monitoring Report 2023. https://gem-report-2023.unesco.org/

Brookings. (2020). Digital skills and the future of work in Africa. https://www.brookings.edu/blog/africa-in-focus/2020/07/22/figures-of-the-week-digital-skills-and-the-future-of-work-in-africa/

Oklahoma State University. (n.d.). The Digital Divide – Learning in the Digital Age. https://open.library.okstate.edu/learninginthedigitalage/chapter/the-digital-divide/

Randstad. (2024). AI skills gap widens. https://www.randstad.com/press/2024/ai-skills-gap-widens/

UNESCO. (2024). AI literacy and the new Digital Divide A Global Call for Action. https://www.unesco.org/ethics-ai/en/articles/ai-literacy-and-new-digital-divide-global-call-action

Van Deursen, A. J. A. M., & van Dijk, J. A. G. M. (2019). The first-level digital divide shifts from inequalities in physical access to inequalities in material access. New Media & Society, 21(2), 354-375. https://doi.org/10.1177/1461444818797082

Davies, S. (2024). We’re Already at Risk of Ceding Our Humanity to AI. Literary Hub. https://lithub.com/were-already-at-risk-of-ceding-our-humanity-to-ai/

Elon University. (2025). Report: Technology experts worry about the future of being human in the AI Age. https://www.elon.edu/u/news/2025/04/02/report-technology-experts-worry-about-the-future-of-being-human-in-the-ai-age/

UNESCO. (2021). Recommendation on the Ethics of Artificial Intelligence. https://unesdoc.unesco.org/ark:/48223/pf0000367823

Vinuesa, R., et al. (2021). A Just Digital framework to ensure equitable achievement of the Sustainable Development Goals. Nature Communications, 12, 6345. https://doi.org/10.1038/s41467-021-26217-8

Stanford HAI. (2019). A Human-Centered Approach to the AI Revolution. https://hai.stanford.edu/news/human-centered-approach-ai-revolution

Floridi, Luciano, Distant Writing: Literary Production in the Age of Artificial Intelligence Revised version 5 (April 26, 2025). Centre for Digital Ethics (CEDE) Research Paper , Available at SSRN: https://ssrn.com/abstract=5232088 or http://dx.doi.org/10.2139/ssrn.5232088

Moretti, Franco, Distant Reading, Verso, June 4, 2013 https://www.versobooks.com/products/2309-distant-reading