L’impiego dell’Intelligenza Artificiale (IA) nel terrorismo non è più solo un’ipotesi da fantascienza, ma un fenomeno emergente e multidimensionale con implicazioni concrete.

Indice degli argomenti

Come l’intelligenza artificiale cambia il terrorismo

I gruppi terroristici – dalle organizzazioni jihadiste ai movimenti estremisti – stanno esplorando come sfruttare l’IA per ampliare la propria capacità operativa, comunicativa e strategica, trasformando potenzialmente il modo in cui pianificano attacchi, diffondono propaganda e reclutano aderenti.

Questa tendenza rappresenta una nuova frontiera nella guerra asimmetrica tecnologica, in cui strumenti una volta appannaggio di stati e grandi aziende diventano disponibili anche a cellule terroristiche o singoli individui radicalizzati.

Di seguito analizziamo come l’IA stia influenzando il terrorismo su più livelli, quali rischi e scenari ne derivano e le sfide che tutto ciò pone per la sicurezza e la governance globale.

Dalla propaganda automatizzata ai droni autonomi

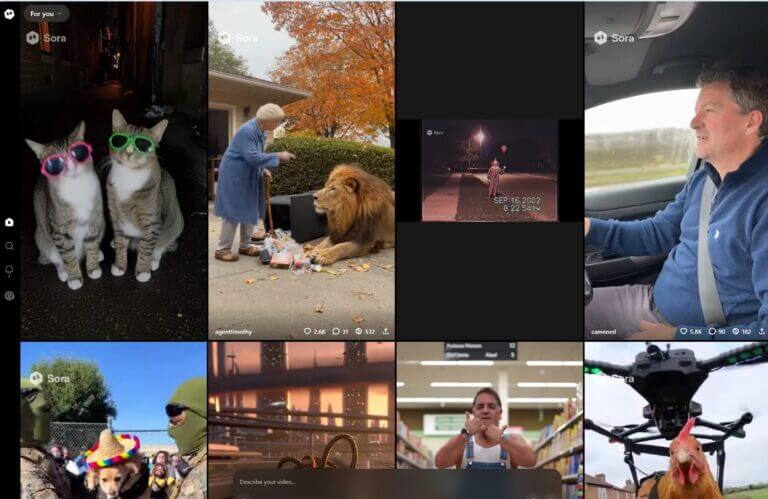

I terroristi hanno sempre mostrato grande adattabilità nell’adottare tecnologie emergenti. In passato hanno sfruttato Internet, i social media e la crittografia; oggi vedono nell’IA un nuovo potente alleato. Sul piano comunicativo e propagandistico, l’IA generativa (capace di produrre testi, immagini, audio o video realistici su richiesta) sta rivoluzionando la propaganda estremista. Attraverso chatbot avanzati e generatori di immagini/video, anche un piccolo gruppo può produrre quantità massicce di contenuti persuasivi e mirati, abbattendo costi e tempi tradizionali.

Ad esempio, è stato documentato che militanti dello Stato Islamico (ISIS) hanno pubblicato guide tecniche su come usare in sicurezza strumenti di IA generativa, mentre altri affiliati ad al-Qaeda hanno diffuso poster propagandistici le cui immagini appaiono create con IA. Ambienti dell’estremisti non sono da meno: figure neonaziste hanno persino redatto manuali di “guerra memetica” spiegando come generare meme e immagini estremiste tramite IA.

La capacità di automatizzare la produzione di disinformazione è inquietante: video o audio deepfake possono mettere in scena leader politici o religiosi mentre pronunciano discorsi incendiari mai avvenuti, con un realismo tale da ingannare il pubblico. Immagini false ma emotivamente potenti – ad esempio bambini feriti in un conflitto – possono essere create per suscitare odio e desiderio di vendetta. Questi materiali sintetici, diffusi viralmente sui social, amplificano la portata della propaganda terroristica, rendendola più credibile e difficile da smascherare.

Reclutamento automatizzato con IA e adescamento online

Un recente esempio si è visto nel conflitto israelo-palestinese del 2023, dove report hanno indicato che Hamas ha impiegato deepfake “emotivi” per manipolare la percezione degli eventi sul campo. Video artefatti e montati ad arte hanno potuto mostrare falsi attacchi o alterare l’impatto di eventi reali, confondendo l’opinione pubblica locale e internazionale.

Scenari di questo tipo evidenziano come la linea tra realtà e finzione diventi sempre più labile: immaginiamo un video in cui un leader dichiara guerra ad un Paese o un imam influente inciti. In sintesi, l’IA è anche un moltiplicatore di forza propagandistica: genera contenuti in quantità e qualità tali da erodere la fiducia nelle informazioni online e da potenziare le campagne di odio su scala globale.

Dalla propaganda al reclutamento interattivo

All’efficacia della propaganda si collega l’evoluzione del reclutamento e radicalizzazione online mediante IA. Tradizionalmente, gruppi come ISIS curavano forum e social network per agganciare potenziali simpatizzanti; ora possono automatizzare parte di questo processo. I chatbot potenziati da modelli linguistici (simili a ChatGPT) permettono di interagire one-to-one con aspiranti reclute, simulando conversazioni umane empatiche e personalizzate. Un bot può rispondere a dubbi ideologici, fornire materiali estremisti su misura degli interessi dell’utente e mantenerne vivo l’engagement, traghettandolo gradualmente verso posizioni radicali.

Minori e radicalizzazione: un target vulnerabile per l’IA

Questo reclutamento interattivo automatizzato rende possibile avvicinare contemporaneamente un numero enorme di individui, senza impiegare attivisti umani in ogni conversazione. In pratica, poche persone possono orchestrare un esercito di assistenti virtuali che sondano i social e le chat, adescando persone vulnerabili o curiose con una propaganda altamente mirata. Particolare preoccupazione desta l’adescamento di giovani e giovanissimi online: i bambini e adolescenti, abituati a dialogare con assistenti virtuali o a giocare in ambienti digitali, possono essere affascinati da chat anonime apparentemente amichevoli. L’ingenuità e la fiducia tipiche dell’età li rendono bersagli ideali: un chatbot ben congegnato potrebbe farsi passare per un coetaneo o un mentore comprensivo, guadagnando la loro fiducia prima di esporli gradualmente a idee estremiste. Si sono già registrati casi di minori coinvolti in conversazioni manipolative con bot online, prova che questa minaccia non è teorica. L’IA, dunque, può espandere la platea di potenziali terroristi, collegando i gruppi radicali a individui solitari (i cosiddetti lone wolves) che navigano in rete in cerca di un’identità o uno scopo.

Droni e armi intelligenti: la nuova offensiva tecnologica

Oltre alla sfera mediatica, l’Intelligenza Artificiale sta trasformando anche le capacità operative sul campo dei gruppi terroristici. Un caso già concreto è l’uso di droni commerciali modificati, equipaggiati con esplosivi o armi leggere. Già negli scorsi anni milizie come Hamas, Hezbollah e lo stesso ISIS hanno impiegato droni artigianali per attacchi mirati contro obiettivi militari e civili. Finora si è trattato perlopiù di piccoli velivoli telecomandati o programmati per seguire una rotta GPS, ma l’integrazione dell’IA ne moltiplica l’efficacia.

Algoritmi di visione artificiale e navigazione autonoma permettono a un drone di riconoscere obiettivi (volti umani, veicoli specifici) e dirigersi su di essi senza bisogno di un pilota remoto. In pratica, si avvicina la possibilità di “droni kamikaze” autonomi: piccoli aeromobili che sorvolano un’area identificando in autonomia il bersaglio (ad esempio un convoglio o una folla durante un evento pubblico) e lanciandosi contro di esso con letale precisione.

Le Nazioni Unite hanno definito i droni uno dei principali rischi terroristici contemporanei, proprio perché economici, relativamente facili da usare e ora potenzialmente resi più intelligenti dall’IA. La prospettiva di sciami di droni coordinati da algoritmi, capaci di saturare le difese tradizionali, rientra tra gli scenari più inquietanti per la sicurezza futura. Un singolo terrorista, acquistando decine di droni a basso costo e caricandoli con software di guida autonoma, potrebbe orchestrare attacchi simultanei su più punti, eludendo o sopraffacendo le forze dell’ordine.

Autobombe autonome: il futuro degli attentati suicidi

Parallelamente, si discute seriamente del rischio di autobombe a guida autonoma. Se oggi gli attentatori suicidi mettono a repentaglio la propria vita per condurre un veicolo carico di esplosivo a destinazione, in un futuro prossimo un’auto senza pilota potrebbe svolgere la stessa missione in maniera completamente automatizzata. Organismi internazionali come la NATO hanno espresso timore che gruppi terroristi possano sfruttare auto a guida autonoma come bombe mobili.

Una vettura dotata di IA potrebbe percorrere anche lunghe distanze ed evitare ostacoli o posti di blocco, per poi lanciarsi contro l’obiettivo e detonare. Ciò eliminerebbe la necessità di un attentatore suicida umano, riducendo il “costo” in vite per il gruppo terrorista e potenzialmente aumentando la frequenza di tali attacchi. Per ora questo scenario non si è materializzato, sebbene siano circolate voci su tentativi dello Stato Islamico di sviluppare tecnologie simili. Anche se nulla di concreto è emerso, il solo fatto che se ne parli indica l’attenzione dei terroristi a queste innovazioni.

Cyberterrorismo e IA: scenari digitali di sabotaggio

L’IA apre poi il fronte della guerra cibernetica in mano a terroristi e attori non statali. Strumenti basati su IA possono automatizzare attacchi hacker, scansionando in autonomia bersagli informatici alla ricerca di falle da sfruttare o generando ondate di phishing altamente credibili. Ad esempio, modelli linguistici avanzati possono produrre email di spear-phishing personalizzate (in ottimo stile nativo e con riferimenti specifici alla vittima) per rubare credenziali o diffondere malware, con un realismo difficile da individuare.

Allo stesso modo, algoritmi generativi di codice potrebbero aiutare anche criminali meno esperti a confezionare malware su misura, abbassando le barriere d’ingresso al cyber-terrorismo. In un panorama in cui infrastrutture vitali (reti elettriche, sistemi finanziari, trasporti) sono sempre più digitalizzati, la possibilità che gruppi ostili sfruttino l’IA per sabotaggi informatici è tutt’altro che remota. Va sottolineato come simili tecniche siano già impiegate da attori statali o parastatali – ad esempio unità di intelligence militare russe e iraniane hanno utilizzato IA per migliorare ricognizioni satellitari e ingannare difese cyber – e nel futuro potrebbero filtrare nell’arsenale di terroristi senza bandiera.

Rischi concreti e scenari potenziali

Alcuni rischi sono già realtà, come abbiamo visto: disinformazione virale tramite deepfake, droni armati sempre più sofisticati, reclutamento anonimo online e perfino suggerimenti operativi ottenuti da chatbot. Proprio quest’ultimo aspetto ha trovato conferma clamorosa in un episodio recente negli Stati Uniti: nel 2024 un estremista ha utilizzato ChatGPT per ottenere istruzioni su come fabbricare una potente bomba artigianale, poi usata in un attentato suicida a Las Vegas. In quel caso, l’uomo – un ex militare – ha interrogato il modello IA su quali esplosivi fossero più efficaci e come massimizzare i danni, ricevendo risposte con dettagli tecnici utili (nonostante il chatbot teoricamente avesse filtri di sicurezza). L’episodio ha messo in allerta le autorità, che hanno rivelato come già da tempo circolassero avvisi sull’uso di IA generativa da parte di terroristi fai-da-te.

Documenti interni di intelligence, emersi dopo l’attacco, parlano di militanti che condividono versioni piratate o “jailbreakate” di chatbot sui forum clandestini, proprio al fine di estrarre istruzioni su bombe e indicazioni tattiche senza i blocchi etici dei sistemi ufficiali. In pratica, se un normale utente di ChatGPT non riuscirebbe a farsi spiegare come sabotare una rete elettrica o costruire un ordigno, un terrorista motivato può procurarsi una copia alterata del modello (o rivolgersi a strumenti open-source meno filtrati) e ottenere le informazioni desiderate. Gli analisti sottolineano che l’IA sta “abbassando la soglia” per pianificare attacchi, fornendo idee e know-how pronti all’uso a persone che altrimenti avrebbero avuto bisogno di lunga preparazione o di contatti esperti. Per fare un parallelo, è come se manuali prima reperibili solo nei meandri del dark web o nelle accademie militari siano ora consultabili, in forma conversazionale, da chiunque sappia dove cercare.

Tra gli scenari più inquietanti ipotizzati dagli esperti vi è l’uso dell’IA per potenziare attacchi con armi di distruzione di massa, in particolare biologiche o chimiche. Modelli di apprendimento automatico applicati alla biologia sintetica potrebbero un giorno assistere terroristi nel progettare agenti patogeni o tossine letali, identificando mutazioni per aggirare vaccini o suggerendo metodi di sintesi prima sconosciuti. Si tratta di prospettive ancora teoriche ma prese sul serio dalla comunità internazionale: alcuni ricercatori hanno già dimostrato che un algoritmo generativo, concepito originariamente per scoprire nuovi farmaci, poteva essere riconvertito a produrre formule di possibili agenti chimici letali. Un simile abuso su larga scala dell’IA nel campo biochimico abbasserebbe drasticamente la barriera tecnologica del bioterrorismo, permettendo a piccoli gruppi di creare armi un tempo alla portata solo di laboratori statali avanzati. Benché al momento non risultino casi noti di terroristi che abbiano intrapreso questa via, il semplice avanzare della tecnologia rende questo rischio futuribile non trascurabile.

Sfide per la sicurezza e la governance globale

L’emergere dell’IA come strumento terrorista costringe governi e istituzioni a ripensare strategie di prevenzione, contrasto e regolamentazione. Da un lato, le forze di sicurezza devono dotarsi di contromisure tecniche altrettanto avanzate: ad esempio, algoritmi capaci di individuare contenuti deepfake (analizzando anomalie pixel o watermark digitali) per smascherare tempestivamente video falsificati prima che creino caos. Allo stesso modo, servono sistemi di difesa anti-drone potenziati, in grado di rilevare e neutralizzare UAV ostili – magari usando IA per distinguere un drone minaccioso da uno lecito – specialmente in occasione di eventi affollati o nei pressi di obiettivi sensibili.

Anche il monitoraggio delle comunicazioni online richiede upgrade: l’impiego di IA da parte di terroristi su Telegram, forum del dark web o piattaforme decentrate rende necessario impiegare strumenti di analisi automatizzata (ad esempio per scovare conversazioni anomale indicative di reclutamento o preparativi di attacchi). Tuttavia, queste contromisure sollevano problemi complessi: l’uso di IA di sorveglianza può confliggere con privacy e libertà civili, e i sistemi di riconoscimento deepfake non sono infallibili (rischiano sia falsi allarmi sia mancate individuazioni se i falsari aggiornano i metodi). Le istituzioni democratiche si trovano quindi a bilanciare l’esigenza di sicurezza con la tutela dei diritti, in un contesto dove l’innovazione corre più veloce della normativa.

Difficoltà nella governance e nella tracciabilità delle minacce IA

Regolare l’uso ostile dell’IA in un contesto globale significa innanzitutto riconoscere che l’IA è una dual-use technology: le stesse tecniche che curano malattie o automatizzano l’industria possono essere piegate a scopi distruttivi. Diversamente dalle armi convenzionali o dalle materie prime per bombe nucleari, qui non esistono componenti fisici da controllare o confinare con embarghi.

Il “proliferatore” è il codice, l’algoritmo – qualcosa di intangible e replicabile all’infinito, che viaggia in rete a costo zero. Governance tecnologica globale in questo ambito significa provare a mettere paletti all’accesso e all’uso di IA avanzate, ma con quali strumenti? Sono allo studio varie strategie: ad esempio, imporre marcatori digitali obbligatori nei contenuti generati da IA (per facilitarne il riconoscimento), oppure richiedere licenze e verifiche per addestrare modelli sopra una certa potenza di calcolo. Tuttavia, queste misure – ammesso vengano adottate dai principali Paesi – possono essere facilmente eluse da attori non statali. Un gruppo terrorista non si atterrà certo a regolamenti internazionali; potrà scaricare versioni open-source di algoritmi senza alcun controllo, oppure servirsi di infrastrutture in Stati compiacenti o incapaci di far rispettare i divieti. Un paradosso evidente è che mentre le grandi aziende e università sono soggette a normative e scrutiny pubblico, le cellule clandestine possono agire nell’ombra, sfruttando tecnologie che comunque filtrano nel dominio pubblico col passare del tempo.

Si pone inoltre un problema di tracciabilità e attribuzione. Quando un attacco terroristico avviene con metodi “tradizionali”, gli investigatori possono risalire a colpevoli e mandanti attraverso armi, esplosivi, finanziamenti.

Ma se il danno è causato da un’azione mediata dall’IA, come una campagna di disinformazione o un sabotaggio informatico automatizzato, identificare i responsabili diventa molto più complesso. Ad esempio, un video deepfake apparso dal nulla in rete potrebbe essere opera di chiunque disponga di un computer e di sufficiente abilità tecnica: può provenire da un appartamento anonimo in qualsiasi parte del mondo. La decentralizzazione propria dell’ecosistema digitale permette ai terroristi di mascherare le proprie tracce dietro reti anonime, server off-shore o identità virtuali fittizie (magari create esse stesse con AI, come volti e profili sintetici). Questo rende estremamente difficile per le autorità attribuire con certezza un attacco o una campagna mediatica a un determinato gruppo, rallentando la risposta e complicando l’azione giudiziaria. Anche quando l’attribuzione è possibile, spesso avviene ex post, quando il danno in termini di vite umane o stabilità sociale è già compiuto.

Strategie future per contrastare il terrorismo potenziato dall’IA

Il rapporto tra IA e terrorismo è ancora agli inizi, ma sta rapidamente guadagnando importanza. Quello che oggi vediamo in forma embrionale – il terrorista aumentato dalla tecnologia – potrebbe diventare nel prossimo futuro una costante delle minacce alla sicurezza globale. Il panorama descritto è volutamente ampio e multidimensionale: dalla guerra psicologica online alla robotica armata, passando per la formazione di nuove leve terroristiche tramite tutorial forniti dall’IA. Ogni dimensione aggiunge un livello di complessità alla sfida che società e governi devono affrontare. Non esiste una soluzione semplice né unica: sarà necessaria un’azione coordinata su più fronti. Da un lato, investire in contro-tecnologie e nella formazione di esperti capaci di fronteggiare l’abuso dell’IA (analisti, ingegneri della sicurezza, esperti di disinformazione); dall’altro, lavorare a quadri normativi internazionali che, pur difficili da negoziare, stabiliscano principi condivisi sull’uso responsabile dell’IA e sanzioni per il suo impiego a fini terroristici.

Importante sarà anche il ruolo degli attori privati e della società civile: le grandi piattaforme dovranno rafforzare le barriere contro contenuti manipolati e cooperare con le autorità, mentre le organizzazioni non governative potranno monitorare e denunciare abusi, e il pubblico dovrà essere educato a un consumo critico dei media nell’era dell’IA.

In definitiva, la convergenza tra terrorismo e Intelligenza Artificiale rappresenta una nuova fase dell’eterna gara tra attacco e difesa. Così come i terroristi esplorano strade innovative per seminare terrore, le forze della sicurezza e le istituzioni dovranno innovare nel prevenirlo. La posta in gioco è alta: farsi trovare impreparati significherebbe permettere a attori violenti di sfruttare a loro vantaggio strumenti che permeano ormai ogni aspetto del mondo moderno. Al contrario, affrontare con lucidità e anticipo questa minaccia emergente potrà contenere i rischi, preservando i benefici dell’IA per la collettività e negando ai terroristi la possibilità di trasformare le nostre stesse tecnologie in armi di distruzione e paura.