Il presente documento analizza il fenomeno emergente dei sistemi di intelligenza artificiale specializzati nella generazione di contenuti e conoscenza sulla base di documentazione e dati di natura commerciale, tecnica e procedurale, focalizzati su specifici contesti verticali denominati Domain Specific Language Model (DSLM).

Indice degli argomenti

Da DSLM a cloud privato: l’evoluzione dei sistemi AI

Tali sistemi adottano un’architettura Retrieval Augmented Generation (RAG), che consente di interrogare una knowledge base aziendale o istituzionale e di generare contenuti coerenti, contestualizzati e aggiornati, combinando le potenzialità dei modelli linguistici avanzati con la conoscenza interna dell’organizzazione.

Tali sistemi sono progettati per operare interamente in ambienti locali o su cloud privati, nel rispetto dei principi di sovranità digitale, sicurezza e riservatezza dei dati. Nella maggior parte dei casi non viene utilizzato alcun modello linguistico pubblico accessibile via internet, né è previsto il trasferimento di contenuti al di fuori dell’infrastruttura dell’ente. Solo quando e se le elaborazioni locali dovessero rivelarsi insufficienti sono previste richieste agli LLM pubblici. Questo approccio, che risponde pienamente alle esigenze di continuità operativa, indipendenza tecnologica e protezione del patrimonio informativo, così cruciali per le Aziende e le Pubbliche Amministrazioni, è destinato a rivalutare il concetto di cloud privato, con data center di nuova generazione di nuovo nelle Aziende o in mano a provider nazionali di prossimità come è il caso dei Telco Cloud.

Vantaggi nell’automazione della documentazione aziendale

La tecnologia dei Domain Specific Language Model consente di automatizzare la produzione di documenti ricorrenti e complessi (come specifiche tecniche, capitolati, piani di test, manuali, verbali), riducendo i tempi di redazione, aumentando l’uniformità e la qualità dei contenuti e minimizzando gli errori umani. La knowledge base può comprendere testi, dati strutturati, immagini, video e documenti specialistici, ed è progettata per essere mantenuta aggiornata e verificabile nel tempo. Pubbliche Amministrazioni e Aziende Private, che gestiscono elevati volumi di documentazione, in ambito sanitario, tecnico, normativo o contrattuale, sono importanti candidati a sviluppare e utilizzare queste piattaforme.

Componenti tecnologiche e Open Source

Le principali componenti tecnologie per l’implementazione dei sistemi sono costruite sulla base di sofisticate e complete suite di tecnologie open source consolidate, come ad esempio LlamaIndex, Chroma e modelli linguistici open source ospitabili localmente. Dunque, accanto alla rivalutazione dell’approccio di computing privato e di prossimità, c’è una profonda nuova consapevolezza del ruolo strategico dell’Open Source Software. Queste scelte garantiscono sostenibilità economica, trasparenza delle soluzioni e possibilità di riuso secondo i principi dell’open innovation nella Pubblica Amministrazione e nelle Aziende e infine è del tutto compatibile con le indicazioni dell’AI ACT della Unione Europea.

I Large language model (LLM)

I Large Language Models rappresentano oggi una delle frontiere più avanzate dell’intelligenza artificiale. Questi sistemi, caratterizzati da un numero molto elevato di parametri che può raggiungere numerosità pari a migliaia di miliardi, hanno rivoluzionato la capacità delle macchine di comprendere e generare linguaggio naturale. La loro denominazione “large” (grandi) non si riferisce solo alla dimensione computazionale, ma anche alla vastità della conoscenza che acquisiscono durante l’addestramento, che permette loro di affrontare compiti linguistici estremamente diversificati con un’efficacia senza precedenti. Alla base di questi modelli troviamo l’architettura Transformer, introdotta da Google nel 2017, che ha segnato un punto di svolta nell’elaborazione del linguaggio naturale.

Architettura transformer e self-attention

La vera forza di questa architettura risiede nel meccanismo di “self-attention”, che consente al modello di analizzare le relazioni tra le diverse parole nelle frasi, indipendentemente dalla loro posizione all’interno di frasi o paragrafi. Questa capacità ha superato una limitazione fondamentale dei precedenti modelli ricorrenti, che faticavano a mantenere il contesto su sequenze lunghe. Gli LLM moderni funzionano grazie a un’architettura di rete neurale profonda che elabora il testo attraverso vari strati specializzati, che considera simultaneamente tutte le parole di una sequenza e che determina quanto ciascuna di esse debba influenzare la rappresentazione di ogni altra parola. Questo processo consente di catturare sfumature contestuali, riferimenti a distanza e dipendenze complesse che caratterizzano il linguaggio umano.

Prima che un testo possa essere elaborato, viene suddiviso in segmenti e poi in unità ancora più elementari chiamate token attraverso l’omonimo processo di tokenizzazione. Questi token possono rappresentare parole intere, parti di parole o singoli caratteri, a seconda dell’approccio scelto. Ogni token viene poi trasformato in un vettore numerico ad alta dimensionalità (embedding) che ne cattura le proprietà semantiche. A differenza dei vecchi sistemi dove una parola aveva sempre la stessa rappresentazione, negli LLM gli embedding sono dinamici e contestuali: la rappresentazione della parola “banco” sarà diversa se si parla di un banco di scuola o di un istituto bancario.

L’elaborazione avviene attraverso decine o centinaia di strati di Transformer, dove ogni strato raffina ulteriormente la comprensione del testo. Gli LLM più diffusi utilizzano varianti “decoder-only” (come la famiglia GPT) focalizzate sulla generazione di testo, mentre altri modelli come BERT adottano architetture “encoder-only” ottimizzate per la comprensione del linguaggio. In entrambi i casi, il risultato è un sistema capace di manipolare rappresentazioni linguistiche incredibilmente sofisticate.

Fasi di addestramento degli LLM

La creazione di un Large Language Model è un processo complesso e dispendioso che richiede enormi risorse computazionali e una vasta quantità di dati. Tutto inizia con la raccolta di un corpus testuale massiccio che può includere libri, articoli, pagine web, discussioni online e documenti di vario genere. Questo corpus deve essere il più diversificato possibile per consentire al modello di acquisire una comprensione ampia del linguaggio umano e della conoscenza generale.

La prima fase di addestramento, chiamata pre-training, avviene in modo non supervisionato: il modello impara a predire parti mancanti o successive del testo, sviluppando così una comprensione generale della lingua e acquisendo una vasta conoscenza implicita. Questa fase richiede cluster di GPU (Graphic Processing Unit) o TPU (Tensor Processing Unit) di fascia alta e può durare settimane o mesi, con costi che possono raggiungere milioni di dollari per i modelli più grandi. Durante questo processo, il modello elabora migliaia di miliardi di parole, affinando gradualmente miliardi di parametri per catturare le strutture linguistiche e le relazioni semantiche.

Dopo il pre-training, il modello viene sottoposto a una fase di fine-tuning, dove viene ulteriormente addestrato su dataset più specifici e con tecniche supervisionate. Tra le metodologie più avanzate in questa fase troviamo l’Instruction Tuning, dove il modello impara a seguire istruzioni in linguaggio naturale, e il Reinforcement Learning from Human Feedback (RLHF), dove il feedback umano viene utilizzato per allineare il comportamento del modello alle aspettative e ai valori umani. Questa fase è cruciale per trasformare un modello con conoscenze linguistiche generali in uno strumento utile e sicuro per applicazioni specifiche.

L’ultima fase del processo riguarda l’ottimizzazione per l’implementazione pratica. Tecniche come la quantizzazione (riduzione della precisione numerica dei parametri), il pruning (eliminazione delle connessioni meno significative) e la knowledge distillation (trasferimento della conoscenza a modelli più piccoli) consentono di ridurre le dimensioni del modello e i requisiti computazionali, rendendo possibile l’utilizzo degli LLM su piattaforme con risorse limitate pur mantenendo gran parte delle loro capacità.

I sistemi retrieval augmented generation system (RAG)

I sistemi RAG (Retrieval-Augmented Generation) rappresentano una delle innovazioni più significative nel panorama dell’intelligenza artificiale moderna, emergendo come risposta elegante alle limitazioni intrinseche dei Large Language Models. Questa architettura ibrida è nata dalla consapevolezza che, nonostante la loro straordinaria capacità di elaborazione linguistica, i modelli linguistici puri soffrono di carenze fondamentali quando si tratta di accuratezza fattuale, aggiornamento delle informazioni e trasparenza delle fonti.

L’idea alla base dei sistemi RAG è tanto semplice quanto potente: anziché affidarsi esclusivamente alla conoscenza parametrica “memorizzata” nei pesi del modello durante l’addestramento, questi sistemi integrano dinamicamente informazioni recuperate da fonti esterne nel processo di generazione delle risposte. Questo approccio combina la flessibilità e naturalezza espressiva degli LLM con l’accuratezza e l’aggiornabilità di basi di conoscenza strutturate, creando un sistema di intelligenza artificiale più affidabile e versatile.

La storia dei RAG inizia formalmente nel 2020, quando ricercatori di Facebook AI Research (ora Meta AI) pubblicarono il paper seminale “Retrieval-Augmented Generation for Knowledge-Intensive NLP (Natural Language Processing) Tasks“, ma l’idea di combinare recupero e generazione ha radici più profonde nella ricerca sulla risposta a domande (question answering) e sui sistemi di ricerca. Ciò che ha reso possibile l’effettiva implementazione dei sistemi RAG moderni è stata la convergenza di tre fattori: l’emergere di potenti LLM, lo sviluppo di tecnologie efficienti per la ricerca semantica e la creazione di database vettoriali in grado di gestire enormi quantità di sequenze / vettori numerici ad alta dimensionalità.

Applicazione dei sistemi RAG in aziende e PA

Oggi stiamo osservando la forte accelerazione dell’adozione di Intelligenza Artificiale applicata ai processi delle Aziendali e delle Pubbliche Amministrazioni e si stanno moltiplicando le iniziative di sviluppo di Domain Specific Language Model (DSLM) basati appunto su un approccio avanzato di RAG per integrare conoscenze aziendali specifiche in modo efficiente, sicuro ed economico. Tali sistemi richiedono l’elaborazione di dati rilevanti e strategici delle Aziende e PA (Knowledge Base) preferibilmente con infrastrutture di calcolo con prestazioni molto elevate locali (private cloud), per mantenere riservata e sicura tale base di conoscenza e applicare gli strumenti di AI generativa su di essa. In altri termini i sistemi RAG stanno spingendo la rivalutazione del computing privato o locale, segnale questo che dovrebbe essere colto dai soggetti che oggi dispongono di infrastrutture fisiche e digitali molto distribuite come gli Operatori di Telecomunicazioni. Torneremo su questo punto nei prossimi paragrafi.

Obiettivi e vantaggi dei sistemi RAG

L’obiettivo dei sistemi RAG è quello di sviluppare un sistema intelligente per la produzione automatizzata informazioni per il supporto alle decisioni, per l’esecuzione di processi con il minimo effort di risorse umane e di generare documentazione specialistica di varia natura, a partire dal patrimonio informativo interno, combinato con le capacità generative di un modello linguistico avanzato. Gli obiettivi sono generalizzati per adattarsi a molteplici settori, inclusi ma non limitati a, ingegneria, industria, sanità, energia, pubblica amministrazione e servizi professionali:

- Automatizzare la redazione di documentazione complessa e ricorrente, riducendo i tempi e gli sforzi manuali;

- Migliorare la qualità, la coerenza e la standardizzazione dei documenti tecnici, procedurali o normativi;

- Abilitare una gestione evoluta del know-how aziendale, trasformando la documentazione interna in una vera knowledge base operativa;

- Potenziare l’efficienza operativa delle funzioni specialistiche (es. progettazione, manutenzione, compliance, formazione) grazie all’accesso intelligente alla conoscenza strutturata;

- Abilitare una risposta più rapida a esigenze progettuali, normative o di mercato, attraverso una produzione documentale più agile;

- Ridurre gli errori umani derivanti da copia/incolla, versioni obsolete o modelli incoerenti;

- Integrare le best practice aziendali nei processi di creazione documentale, garantendo maggiore conformità e riuso;

- Valorizzare le competenze interne, permettendo ai team di focalizzarsi su attività a più alto valore aggiunto.

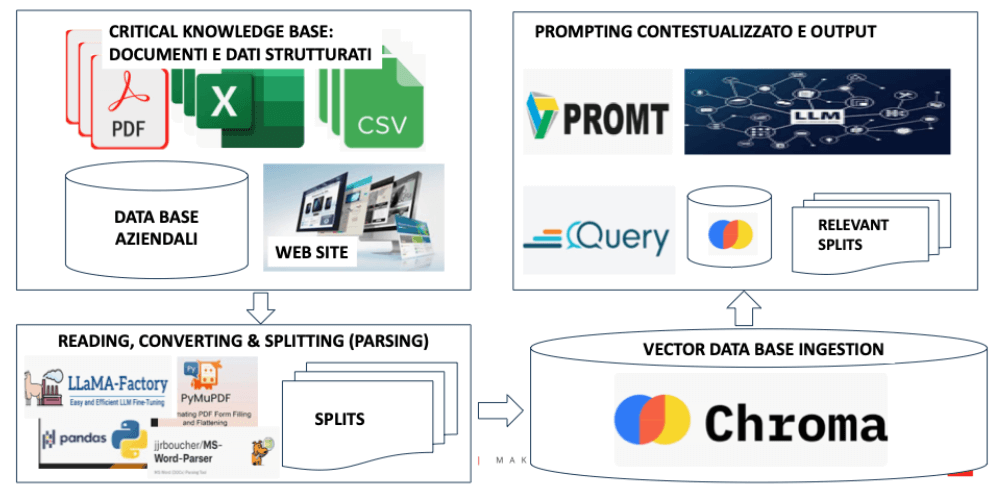

Framework RAG e componenti

Il Framework RAG è il cuore del sistema che consente al modello, come abbiamo visto, di interrogare una base documentale interna per arricchire la generazione con contenuti specifici. Questo consente di combinare la potenza linguistica del LLM con la precisione delle fonti aziendali. I documenti che costituiscono la Knowledge Base sono in formato PDF, DOCX, HTML e vengono convertiti in testo e suddivisi in unità informative elementari (paragrafi, sezioni, tabelle) tramite algoritmi di parsing intelligenti. Il sistema è progettato per integrare, oltre ai documenti testuali tradizionali suddetti, anche dati strutturati provenienti da file CSV e Excel. Tali fonti possono contenere configurazioni, tabelle di parametri, registri, log, piani di manutenzione o inventari, e vengono trattate con metodi specifici. I dati tabellari vengono importati tramite reader dedicati (ad esempio CSVReader o PandasCSVReader per LlamaIndex) e segmentati in righe o gruppi di righe, arricchiti con metadati descrittivi (nome colonna, riga, categoria, origine). Questo permette di includere nelle successive fasi di generazione opportune sezioni che derivano da dataset numerici o tabelle descrittive. In alternativa, per dataset voluminosi o con forte componente quantitativa, il sistema può adottare strategie ibride, combinando: Embedding semantico per colonne testuali o descrittive; Query strutturate (NL-to-SQL o NL-to-Pandas) per analisi dinamica dei dati. In questo modo, la knowledge base può includere non solo manuali e documentazione tecnica, ma anche contenuti di tipo analitico-operativo, mantenendo coerenza e arricchendo la capacità di risposta del modello.

Ogni segmento testuale viene trasformato prima in token, poi in vettori associati a ciascun token e successivamente, grazie all’uso di reti neurali profonde, in un vettore numerico multidimensionale che ne rappresenta il significato semantico. Questo embedding consente poi, nella fase di prompting, di eseguire una ricerca basata sul contenuto effettivo, non solo sulle parole chiave. Vengono utilizzati modelli di embedding compatibili con LlamaIndex, specificamente ottimizzati per ambienti RAG locali. Gli embedding e i relativi metadati (origine, categoria, data, versione) vengono archiviati in un database vettoriale performante come Chroma. Il sistema esegue query semantiche in tempo reale, restituendo i segmenti più pertinenti come contesto da fornire al modello linguistico. L’interrogazione della base DSLM viene realizzata tramite un Large Language Model (LLM) di nuova generazione. Il modello funge da motore generativo, in grado di redigere contenuti coerenti e pertinenti a partire da un contesto fornito dalla fase RAG. Grazie al prompting mirato, il modello può essere guidato a produrre output strutturati (es. sezioni di documenti tecnici) con aderenza agli standard aziendali. Il sistema costruisce i prompt in modo che le risposte siano basate prioritariamente sui documenti aziendali. Quando necessario, il modello può integrare anche conoscenze generali. Questa strategia consente una produzione documentale contestualizzata, ma non limitata (Prompting ibrido Hybrid Retrieval).

Fasi del processo RAG

Vediamo ora, con maggiore dettaglio le quattro fasi del processo RAG rappresentate in sintesi nella figura 1.

Creazione della Knowledge Base (KB)

La prima fase del processo RAG è la creazione della Knowledge Base (KB) ossia la documentazione rilevante dell’Azienda o della PA che sarà alla base delle risposte (o anche inferenze) degli algoritmi di Generative AI.

- Documenti di Normativa del settore (AZIENDALE, ISO, …);

- Documenti di Specifica dei processi di progettazione, di produzione, di manutenzione;

- Documenti relativi ai cataloghi prodotti e servizi, ai listini prezzi, alle offerte e statistiche di adoption da parte dei clienti;

- Repository delle competenze e dei curricula;

- Analisi delle offerte dei concorrenti e insight di mercato;

- Statistiche del comportamento dei prodotti / servizi in termini di uso, problemi, guasti,…

- Immagini, video, rilevanti da catalogare e utilizzare in parti, …

I documenti devono essere caratterizzati da qualità e aggiornamento rilevanti; infatti, è dalla qualità della KB che dipende l’efficacia del processo di apprendimento mirato degli algoritmi LLM secondo il processo RAG.

L’evoluzione delle tecnologie di Intelligenza Artificiale consente oggi di estendere l’ambito applicativo del DSLM anche a contenuti non testuali, quali immagini, video e file diagnostici in formato DICOM. Questa possibilità apre scenari particolarmente interessanti per settori come l’ingegneria, la formazione tecnica, la sanità e il controllo industriale, dove la documentazione specialistica si compone sempre più spesso di materiali eterogenei e ad alta densità informativa.

Nel caso delle immagini, è possibile integrare contenuti grafici come schemi, mappe, disegni tecnici o fotografie operative, convertendoli in informazioni semanticamente leggibili tramite tecniche di riconoscimento automatico. L’utilizzo di modelli OCR consente di estrarre testi da immagini annotate, mentre sistemi più avanzati di visual captioning generano descrizioni contestuali, utili per l’indicizzazione e il recupero semantico. Una volta estratta la parte informativa, essa può essere trasformata in embedding testuale e archiviata nella knowledge base esattamente come un normale documento.

Anche i contenuti video possono essere inclusi nel processo. Attraverso strumenti di trascrizione automatica, come i modelli speech-to-text, si può convertire il parlato tecnico in testo strutturato, mantenendo riferimenti temporali o contesti di scena. In alternativa, è possibile estrarre frame chiave dal video e sottoporli a processi di analisi visuale per ottenere informazioni aggiuntive. In entrambi i casi, il contenuto derivato viene associato al file originale e reso accessibile al motore di retrieval.

Per quanto riguarda le immagini mediche in formato DICOM, utilizzate prevalentemente in ambito sanitario ma sempre più diffuse anche in contesti industriali avanzati, è possibile elaborare sia i metadati strutturati che le immagini stesse. La conversione di immagini DICOM in formati standard (ad esempio JPEG o PNG) consente l’utilizzo di modelli visivi per generare descrizioni interpretative, che possono essere usate a fini documentali, formativi o diagnostici. I metadati clinici o tecnici contenuti nei file possono anch’essi essere estratti, descritti e indicizzati. In tutti questi scenari, il principio operativo rimane coerente con l’architettura del DSLM: qualsiasi contenuto non testuale viene trasformato in una forma linguistica che ne descrive il significato, viene arricchito da metadati di origine e viene successivamente trasformato in uno spazio vettoriale. Ciò consente di mantenere un approccio unificato alla gestione della conoscenza, pur trattando formati e canali diversi.

L’integrazione di questi contenuti multimodali rappresenta una naturale evoluzione del DSLM, estendendone la capacità di generare documenti tecnici, istruzioni operative, report interpretativi e supporti formativi anche a partire da materiali visivi e audiovisivi. In prospettiva, si apre la possibilità di costruire sistemi completamente multimodali, in cui il modello linguistico è in grado di rispondere a domande, generare contenuti o assistere gli utenti utilizzando testi, immagini, video e dati clinici come fonti integrate. Questo rafforza il valore strategico della soluzione e la sua adattabilità ai contesti più complessi e critici.

Parsing (Chunking)

La seconda fase del processo è quello del parsing (o anche chunking) ossia della segmentazione dei documenti e delle altre fonti informative in parti chiamate splits (o segmenti). Per ogni pagina in media si creano 5 split . La segmentazione migliore è di tipo semantico che divide i testi secondo logica e contenuto dei vari paragrafi. I documenti vengono elaborati tramite strumenti software, parser intelligenti, in modo automatico in grado di individuare sezioni, paragrafi, intestazioni, tabelle e altre strutture informative. Ogni elemento informativo viene trattato come un’unità autonoma, dotata di metadati (es. origine, data, sezione, titolo, tipo di documento). Questa granularità consente al sistema di eseguire retrieval più mirati e accurati durante la fase di generazione, come vedremo più avanti. I segmenti di testo e tabelle vengono poi ancora trasformati in parti ancora più elementati che prendono il nome di token. Essi possono essere una parola, una parte di parola, un carattere o una frase elementare. Una parola in italiano equivale a 1,4 token e quindi un paragrafo di 100 parole misura 140 token. I token sono anche una misura dell’informazione prodotta.

Trasformazione dei segmenti in vettori

La terza fase del processo RAG è la trasformazione dei segmenti di testo, o meglio i token, in numeri, o meglio in insiemi di numeri, ossia in vettori:

- I segmenti di testo (SPLIT) vendono ulteriormente scomposti in token, ricordiamo che da 100 parole ottengo 140 token circa;

- Il segmento, scomposto in token, viene elaborato dal software di embedding il quale trasforma i token in un insieme iniziale di numeri (vettore iniziale), ad esempio [0,0124; -0,9931; 0,0548);

- Questi vettori iniziali vengono messi in relazione con gli altri vettori iniziali tramite uso delle reti neurali profonde in modo da mantenere le relazioni semantiche tra testi. A questo punto abbiamo una serie di vettori iniziali e viene elaborato un vettore unico tramite aggregazione (vettore finale o vettore denso o semplicemente Vettore);

- Il vettore finale viene accoppiato al testo originale del segmento e ai metadati del segmento (titolo, fonte, numero token, tipo documento, …) e questa tripletta di informazioni diventa un elemento della knowledge base vettoriale o data base vettoriale. Due testi simili hanno vettori con una distanza piccola e viceversa. La trasformazione numerica dei testi ottimizza la ricerca e il confronto dei contenuti.

Figura 1: Architettura del sistema basato sul modello RAG (Retrival Augmented Generation).

Generazione delle risposte e degli elaborati finali

La quarta fase del processo RAG è, finalmente, la generazione delle risposte e degli elaborati finali:

- Si procede con una domanda di interesse;

- Il sistema RAG attiva un processo di identificazione (retrival) sul vector database (QUERY), in altri termini la domanda viene trasformata essa stessa in un vettore e vengono estratti, per minima distanza dalla domanda, i vettori ossia i segmenti di testo più pertinenti (RELEVANT SPLIT nella figura 1);

- I Segmenti identificati costituiscono un input per l’algoritmo di generazione (o modello linguistico) insieme alle istruzioni per la risposta e insieme alla domanda su cosa si vuole ottenere. Il modello linguistico può essere:

- LLM esterno via API (GPT-4, CLAUDE, MISTRAL, …);

- Un LLM locale di tipo open source

- Un LLM locale open source con integrazione di LLM pubblico attivato con API (Application Programming Interface). Questo è il processo migliore ossia IBRIDO.

Quindi la scelta è l’uso di un LLM locale open source che ricerca localmente nel database vettoriale e che completa gli elementi per le risposte e la generazione di contenuti con interrogazioni all’LLM pubblico.

Gli embedding e i relativi metadati sono salvati in un database vettoriale, che rappresenta la knowledge base dinamica del sistema. Chroma è il componente scelto per le sue performance, flessibilità e integrazione con pipeline locali. Il database supporta query semantiche, versionamento documentale, tagging per categoria e aggiornamenti incrementali. È possibile segmentare la knowledge base per dominio, area funzionale o progetto. Il ciclo di vita della knowledge base è dinamico. Il sistema prevede strumenti per: aggiornare documenti già presenti con nuove versioni; aggiungere nuove fonti e reindicizzare i contenuti; rigenerare automaticamente gli embedding modificati; validare i contenuti generati e segnalare anomalie; monitorare l’efficacia del retrieval e la qualità del prompt.

Quando l’utente pone una domanda o richiede un output documentale (es. HLD, Test Plan, SOP), il sistema attiva un retrieval semantico nella knowledge base e seleziona i segmenti più pertinenti. Questi segmenti vengono forniti al modello linguistico tramite un prompt strutturato, che ne guida la generazione. Il prompting può essere configurato per:

- privilegiare le fonti interne rispetto alla conoscenza generica;

- includere istruzioni di formattazione;

- indicare il tipo di documento da generare;

- gestire riferimenti multipli e coerenza tra sezioni.

Questa quarta fase, ossia Il prompting, è quella più critica e strategica di un sistema DSLM basato su RAG. Rappresenta l’interfaccia logica tra la conoscenza aziendale raccolta nei documenti e il modello linguistico che genera risposte o documentazione. In pratica, il prompt è il messaggio che guida l’intelligenza artificiale a produrre un output coerente con le aspettative dell’utente e con gli standard aziendali. Progettare un prompt efficace significa istruire il modello su cosa deve fare, quali fonti deve usare, come deve strutturare la risposta e con quale stile deve esprimersi. Un prompting ben costruito consente di generare documenti come High Level Design, Test Plan o procedure operative partendo da contenuti aziendali già esistenti, mantenendo uniformità, correttezza tecnica e aderenza alle linee guida interne.

Nel contesto di un’architettura RAG, il prompting si basa su due componenti principali: il contesto informativo recuperato dalla knowledge base e le istruzioni date al modello. È possibile scegliere se privilegiare esclusivamente la documentazione interna oppure permettere al modello di integrare, in modo controllato, la sua conoscenza generale. Questa scelta dipende dal tipo di dominio, dalla sensibilità dei dati e dal livello di maturità della documentazione aziendale. Nei casi in cui l’affidabilità e la coerenza con le fonti interne siano prioritari, il prompting dovrà vincolare l’intelligenza artificiale a utilizzare solo i contenuti della knowledge base. In scenari più flessibili, si può optare per un prompting ibrido che combina conoscenze aziendali e generiche, chiarendo nella risposta quali informazioni provengono da fonti certificate e quali da conoscenza pubblica.

Per quanto riguarda la scelta del modello linguistico da usare, il prompting può essere applicato sia su modelli esterni accessibili via API, come ChatGPT di OpenAI, Claude di Anthropic o Mistral API, sia su modelli open source ospitati localmente, come LLaMA, Mistral, Zephyr o Phi.

La scelta è sui migliori modelli open source che consentono maggiore controllo, personalizzazione e riservatezza, rendendoli ideali per ambienti sensibili o industriali. Il prompting rimane l’elemento chiave per ottenere risposte utili, affidabili e aderenti al contesto, indipendentemente dal modello sottostante. Un sistema DSLM efficace non è solo una collezione di documenti e un modello generativo, ma una pipeline intelligente di interrogazione e guida del modello, in cui il prompting agisce da regia invisibile ma determinante.

Sovereignty, sicurezza e governance

Uno degli elementi cardine del progetto DSLM è la totale aderenza ai principi di sovranità del dato, sicurezza operativa e controllo diretto della conoscenza aziendale. Per questo motivo, la soluzione proposta è progettata per essere implementata all’interno di ambienti locali o su cloud privati sotto il pieno controllo del cliente. Non viene utilizzato alcun modello linguistico pubblico accessibile via Internet, né viene trasferita documentazione aziendale all’esterno dell’infrastruttura. Questa scelta riflette la volontà di garantire la massima riservatezza delle informazioni strategiche, evitare dipendenze da fornitori esterni di AI e assicurare la continuità operativa anche in scenari di crisi geopolitica, indisponibilità di servizi cloud globali o cambiamenti normativi.

Architettura e controllo della conoscenza aziendale

L’architettura DSLM prevede che tutti i documenti, gli embedding vettoriali, i modelli linguistici e i database siano ospitati su sistemi ad alte prestazioni, dimensionati con cura in funzione del volume di dati e del numero di utenti previsti. Il sistema consente inoltre la piena tracciabilità delle fonti utilizzate per la generazione dei contenuti, grazie a un meccanismo di metadati persistenti e link alle sezioni originali dei documenti. È possibile attivare funzioni avanzate di tagging semantico, versioning documentale, gestione delle fonti autorevoli e audit delle risposte generate.

Questa configurazione garantisce che la conoscenza interna non solo sia protetta, ma anche gestita in modo strutturato, trasparente e adattabile nel tempo. Il cloud privato diventa quindi non una semplice alternativa tecnica, ma una componente strategica per la governance del sapere aziendale nell’era dell’intelligenza artificiale.

Il ruolo strategico del software open source

Il software Open Source (OSS[1]) viene utilizzato all’interno delle applicazioni IT mission – critical tutte le organizzazioni del mondo, spesso senza la loro esplicita consapevolezza. Le Imprese devono progressivamente sfruttare più intensamente l’OSS per soddisfare le loro esigenze aziendali, promuovendo l’innovazione, la flessibilità, lo sviluppo accelerato del software e risparmi sui costi rispetto a quelli alternativi commerciali di terze parti. Il software Open Source condivide gli stessi rischi principali di qualsiasi altra tecnologia software, come ad esempio qualità, sicurezza e redditività a lungo termine, e ancora di più delle altre tipologie di software richiede una gestione adeguata e una governance molto strutturata in quanto sono spesso non è disciplinato da contratti di assistenza sufficienti.

Innovazione e vantaggi dell’Open Source

Il software Open Source, da sempre e in particolare oggi, è la base di tutte le più importanti innovazioni che stanno orientando l’evoluzione dell’intelligenza artificiale, di internet of things, della cybersecurity, del cloud e di molte altre aree a forte crescita. Adottare l’Open Source è quindi investimento strategico che, se gestito correttamente, può promuovere l’innovazione, ridurre il Total Cost of Ownership (TCO) e aumentare la fidelizzazione dei talenti e il valore aziendale. Infine, in questo momento storico delle relazioni internazionali, accelerare la strategia Open Source, per l’Europa e per l’Italia in particolare, è un forte segnale verso il nuovo approccio di Sovereignty e accelerazione della Digitalizzazione come strumenti di competitività.

Adozione dell’Open Source nelle imprese

Un programma strutturato OSS è in linea con le nuove esigenze dei clienti non solo per i vantaggi economici legati all’assenza di costi di licenza, ma soprattutto per la sua capacità di accelerare lo sviluppo, favorire l’interoperabilità, migliorare la sicurezza (grazie alla trasparenza del codice) e attrarre competenze tecnologiche avanzate. Un programma OSS può anche migliorare la visibilità e la reputazione nel settore ICT, rafforzando l’immagine di un’azienda innovativa e aperta alla collaborazione con ecosistemi tecnologici globali.

Open Source nei progetti di Intelligenza Artificiale

Dal punto di vista operativo, queste tecnologie possono essere integrate nei progetti in vari contesti applicativi: dalla classificazione e analisi predittiva, all’elaborazione del linguaggio naturale per chatbot intelligenti e motori semantici di ricerca documentale, fino alla creazione di agenti autonomi in contesti industriali, sanitari o di pubblica sicurezza. Inoltre, grazie alle community open source, è possibile disporre di modelli preaddestrati per compiti complessi, riducendo drasticamente i tempi di sviluppo.

Partecipazione attiva nei progetti Open Source

Ma l’adozione non può essere passiva. La partecipazione attiva ai progetti Open Source di IA attraverso la segnalazione di bug, la proposta di nuove funzionalità o il rilascio di modelli proprietari addestrati su dati anonimi e conformi al GDPR – rappresenta una leva per migliorare la reputazione tecnica e attrarre talenti. I professionisti dell’AI più competenti cercano ambienti in cui possano lavorare con strumenti all’avanguardia e contribuire a progetti di valore pubblico.

Open Source e trasparenza nei modelli di Intelligenza Artificiale

Infine, l’approccio open consente una maggiore trasparenza e auditabilità dei modelli, elemento chiave nei contesti regolamentati o soggetti a responsabilità, come la pubblica amministrazione, il settore sanitario, le utility e il mondo bancario. In un futuro prossimo, con l’entrata in vigore dell’AI Act europeo, la tracciabilità, l’interoperabilità e la possibilità di auditing del software IA diventeranno requisiti imprescindibili: l’Open Source è oggi il modo più solido per prepararsi a questo scenario.

L’Open Source come strategia di posizionamento nell’AI

Nel panorama attuale dell’Intelligenza Artificiale, l’Open Source rappresenta non solo una scelta tecnologica, ma una vera e propria strategia di posizionamento. Le soluzioni AI più avanzate si basano oggi su framework e librerie open source sviluppati e mantenuti da community internazionali, università, grandi aziende e singoli sviluppatori. L’adozione, l’adattamento e – quando possibile – il contributo attivo a questi strumenti consentono di rimanere allineati con lo stato dell’arte, riducendo i costi di licenza e aumentando la capacità di innovazione.

Il ruolo dell’Open Source nel contesto aziendale

Nel contesto aziendale, l’adozione di tecnologie Open Source nel campo dell’AI può svolgere un ruolo decisivo su più fronti. I framework come TensorFlow e PyTorch costituiscono la base per lo sviluppo di modelli di machine learning e deep learning, sia supervisionati che non supervisionati. La libreria Transformers di Hugging Face è ormai lo standard de facto per l’implementazione di modelli di Natural Language Processing (NLP) di nuova generazione, come BERT, GPT, RoBERTa e T5. Inoltre, l’interoperabilità offerta da ONNX permette la portabilità tra ambienti eterogenei, elemento cruciale in scenari multi-cloud o edge.

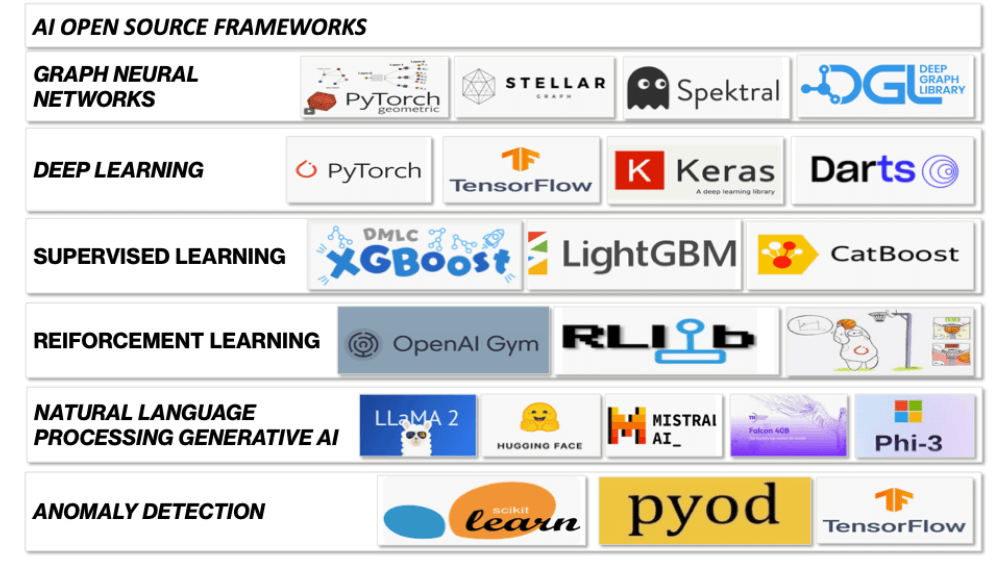

Framework Open Source per l’IA

Lo schema della figura 2 è una sintesi efficace dei principali framework Open Source organizzati per categoria di algoritmo o paradigma dell’Intelligenza Artificiale. Di seguito viene riportata una descrizione dettagliata e un commento per ciascun blocco.

Figura 2: I principali framework Open Source usati per lo sviluppo dell’Intelligenza Artificiale.

Reti neurali e intelligenza artificiale

La categoria delle Reti Neurali raccoglie strumenti fondamentali per l’elaborazione di dati strutturati come grafi, sempre più rilevanti nel networking, nella cybersecurity, nella bioinformatica e nelle raccomandazioni intelligenti.

- PyTorch Geometric: estensione di PyTorch per modelli GNN, molto usata nella ricerca.

- StellarGraph: sviluppata da CSIRO, è orientata a use case aziendali.

- Spektral: basata su Keras/TensorFlow, comoda per prototipazione.

- DGL (Deep Graph Library): supporta sia PyTorch che MXNet e si presta a modelli scalabili e performanti.

Le Reti Neurali Grafiche sono un campo in rapida crescita e rappresentano una frontiera importante, specie per chi lavora su relazioni complesse tra entità come utenti, dispositivi, nodi di rete.

Deep Learning e AI

Il Deep Learning è il cuore dell’AI moderna, alla base di modelli neurali profondi per visione artificiale, NLP, generative AI.

- PyTorch: uno degli standard più usati nella ricerca e industria, flessibile e potente.

- TensorFlow: sviluppato da Google, è robusto e adatto a deployment industriali.

- Keras: alto livello, semplice da usare, ora integrato in TensorFlow.

- Darts: ottimo per deep learning su serie temporali, utile in contesti IoT e industriali.

Apprendimento supervisionato e strumenti essenziali

I Modelli di apprendimento supervisionato sono particolarmente usati per classificazione e regressione.

- XGBoost: potente e veloce, molto usato nelle competizioni Kaggle.

- LightGBM: alternativo a XGBoost, più efficiente su dataset grandi.

- CatBoost: ottimizzato da Yandex per gestire variabili categoriche, utile in ambiti enterprise.

Sono tool insostituibili per pipeline ML tradizionali, perfetti per problemi strutturati su dati tabellari, ad esempio in ambito bancario, sanitario o PA.

Il Reinforcement Learning (RL)

Il Reinforcement Learning (RL) è molto usato per modellare agenti che imparano interagendo con l’ambiente.

- OpenAI Gym: ambiente di riferimento per RL, con molte simulazioni disponibili.

- RLlib: parte di Ray, pensato per scalabilità e parallelismo.

L’uso reale di RL è ancora limitato all’industria avanzata, ma può trovare impiego nel tuning automatico di sistemi complessi, ad esempio nel networking.

Tecnologie di Natural Language Processing (NLP)

Infine, le tecnologie per il Natural Language Processing, delle quali abbiamo detto in modo esteso trattando LLM e RAG, sono fondamentali per l’elaborazione del linguaggio, la sintesi automatica e la generazione di testo o codice.

- LLaMA 2: modello open di Meta, performante in ambiti generativi.

- Hugging Face: hub centrale per modelli NLP e LLM, include libreria Transformers.

- Mistral AI: modelli leggeri ma molto performanti, di recente sviluppo.

- Falcon 40B: open model ad alte prestazioni sviluppato da TII.

- Phi-3: modello di Microsoft ottimizzato per ambienti con risorse limitate.

Il Natural Language Processing è un’area dove l’Open Source ha portato una vera democratizzazione dell’accesso ai Large Language Models.

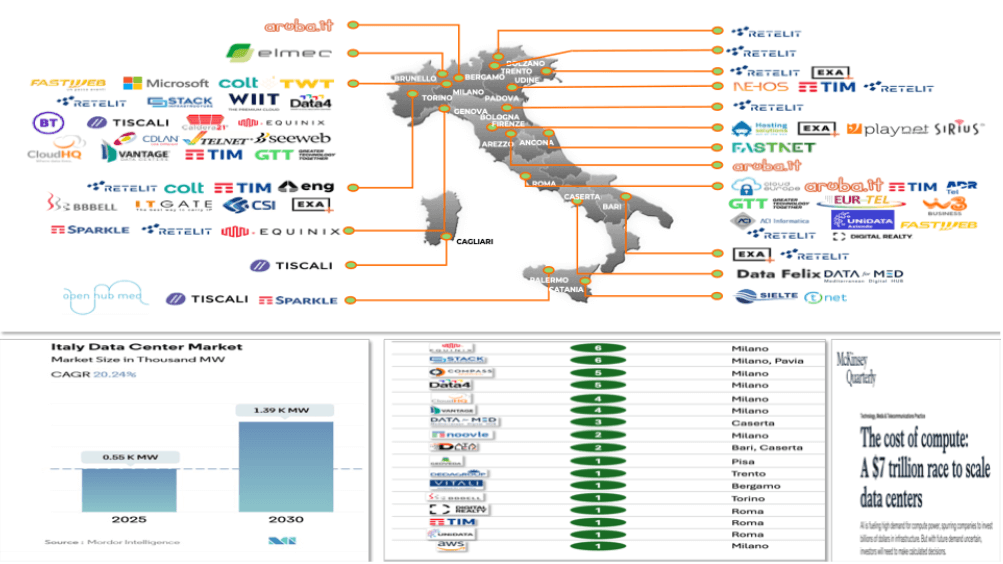

Data center e infrastrutture digitali per lo sviluppo dei sistemi AI

Come è noto l’accelerazione dell’Intelligenza Artificiale sta creando un’ulteriore fase di crescita nella creazione di Data Center in tutto il mondo. In Italia vi sono oggi 170 Data Center TIER 4, alcuni dei quali sono rappresentati nella figura 3. La capacità totale, misurata in gigawatt (GW) è oggi 0,55 GW che corrisponde a meno dell’1% della capacità totale istallata nel mondo che oggi è di 80 GW.

Figura 3: Lo sviluppo dei Data Center in Italia al 2030

Previsioni di sviluppo dei data center in Italia

Le previsioni di sviluppo sono molto importanti. Entro il 2030 si prevede la realizzazione di almeno 40 nuovi Data Center Tier 4 il che porterà a un incremento di capacità elaborativa, e dunque di potenza istallata, pari a + 0,85 GW per un totale si 1,4 GW. Si ritiene che a livello globale dagli 80 GW di oggi, nello stesso periodo entro il 2030, si raggiungano 220 GW con un incremento del 175% rispetto a oggi.

Crescita del mercato dei componenti elettronici nei data center

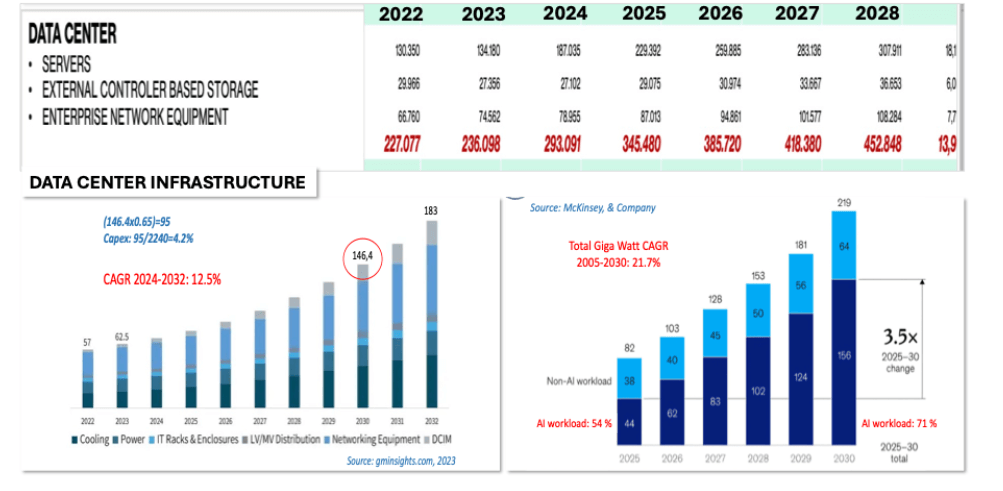

Il mercato totale dei componenti elettronici nei Data Center è ben descritto da Gartner e nel 2024 ha raggiunto una cifra di 300 miliardi di $ che crescerà del 50% per arrivare a 450 miliardi di $ nel 2028 con un tasso di crescita medio del 14% con la componente dei server che crescerà del 18% Tale dinamica è illustrata nella figura 4.

L’importanza delle GPU nei sistemi dei data center

Nell’ambito della crescita molto sostenuta che abbiamo appena descritto la parte più rilevante spetta ai sistemi basati sulle Graphical Processing Unit (GPU).

Sempre nella figura 4 è descritto l’andamento del mercato globale delle infrastrutture dei Data Center, nel periodo 2022–2032, espresso in miliardi di dollari. Secondo i dati di GMInsights, questo mercato passerà da circa 57 miliardi di dollari nel 2022 a 183 miliardi nel 2032, con un tasso annuo di crescita composto (CAGR, Compound Annual Growth Rate) pari al 12,5% per il periodo 2024–2032. Questo ritmo di crescita risulta coerente con l’espansione generale dei servizi digitali e, in particolare, con l’incremento continuo della domanda di elaborazione, archiviazione e trasmissione dati su scala globale.

Figura 4: Previsioni di crescita del mercato Data Center in miliardi di $ e Gigawatt (GW)

Tipologie di infrastrutture dei data center

Una parte importante della figura è dedicata alle tipologie di infrastrutture Dat Center. Notiamo l’infrastruttura costituita dai rack IT e dalle enclosure (“IT Racks & Enclosures”), che ospitano fisicamente i server e gli switch. La distribuzione elettrica a bassa e media tensione (“LV/MV Distribution”) rappresenta l’insieme dei componenti che portano l’energia dalla rete di alimentazione fino ai sistemi finali, garantendo efficienza e sicurezza. I dispositivi di rete (“Networking Equipment”), invece, sono cruciali per l’interconnessione tra i nodi del data center e verso l’esterno, abilitando l’accesso ai servizi cloud e agli ambienti virtualizzati. Infine, la parte superiore delle colonne rappresenta i sistemi di gestione dell’infrastruttura del data center, noti come DCIM (Data Center Infrastructure Management), che integrano sensori, software e dashboard per monitorare in tempo reale energia, spazio, raffreddamento, sicurezza e disponibilità.

In prospettiva, questo rafforza l’idea che i data center stiano diventando “centrali nervose” dell’economia digitale, non più semplici contenitori di server ma ambienti intelligenti, sostenibili, automatizzati, e sempre più strategici per la competitività dei sistemi produttivi e dei servizi pubblici.

L’evoluzione della potenza nei data center e il consumo energetico

Molto importante, anche perché legata alla trasformazione green nel nostro Pianeta, è l’evoluzione del consumo di potenza nei Data Center, espresso in gigawatt (GW). Oggi distinguiamo chiaramente tra workload legati all’intelligenza artificiale (AI) e workload tradizionali (non-AI). I dati della figura 7 sono tratti da una ricerca McKinsey & Company e illustrano in modo evidente la crescita impressionante del fabbisogno energetico nei prossimi anni, direttamente proporzionale all’esplosione dei carichi di lavoro legati all’AI.

Nel 2025 il consumo complessivo previsto per i data center è di 82 GW, suddivisi tra 38 GW per i carichi non-AI (come applicazioni business, database, posta elettronica, siti web, ecc.) e 44 GW per i workload AI, come l’addestramento e l’inferenza di modelli di machine learning e deep learning. Questo dato è già significativo perché mostra che i carichi AI superano quelli tradizionali, con una quota del 54% sul totale.

La crescita si fa ancora più marcata anno dopo anno. Già nel 2026 il consumo AI supera i 60 GW e continua a salire rapidamente fino a raggiungere i 156 GW nel 2030. In confronto, i workload non-AI crescono in modo più moderato, passando da 38 GW nel 2025 a 64 GW nel 2030. Questo significa che la percentuale dei carichi AI rispetto al totale aumenta in modo consistente: dal 54% iniziale al 71% nel 2030. È un chiaro segnale che la rivoluzione digitale guidata dall’intelligenza artificiale non è solo un fatto tecnologico, ma ha anche un impatto strutturale sull’infrastruttura energetica e sull’efficienza dei data center.

Efficienza energetica e sfide future per i data center

Nel complesso, il fabbisogno energetico totale per i data center crescerà di circa 3,5 volte in soli cinque anni, passando da 82 a 219 GW. Questo incremento comporta conseguenze importanti sia in termini ambientali sia economici. Da un lato, impone nuove strategie per migliorare l’efficienza energetica, come il raffreddamento avanzato, l’uso di chip specializzati (GPU, TPU, DPU) e l’alimentazione da fonti rinnovabili. Dall’altro, richiede un ripensamento del design stesso dei data center, che devono essere più intelligenti, distribuiti, e capaci di ottimizzare dinamicamente i consumi. Il dato sintetico sul CAGR (Compound Annual Growth Rate) del consumo totale di energia nei data center tra il 2005 e il 2030, pari al 21,7%, conferma una crescita strutturale di lungo periodo, ben oltre i cicli tecnologici tradizionali. L’AI non è più un “workload speciale”, ma si avvia a diventare il carico di default dei data center globali.

In sintesi, questa figura non mostra solo un aumento quantitativo, ma segnala un profondo cambiamento qualitativo nella natura stessa dei servizi digitali. Il futuro sarà dominato da modelli intelligenti che, per funzionare, richiederanno infrastrutture energetiche robuste, sostenibili e ottimizzate, pena il rischio di colli di bottiglia o impatti ambientali non trascurabili. La sfida dell’efficienza AI-ready è appena iniziata.

Evoluzione delle AI ethernet fabric

Accanto alla notevole evoluzione dei Data Center spinti dalle esigenze di AI (o AI Data Center) ci aspettiamo una analoga evoluzione delle AI Ethernet Fabric che rappresenta una revisione strutturale dell’architettura di rete Ethernet specificamente ottimizzata per i carichi di lavoro AI con le seguenti caratteristiche fondamentali:

- Topologie non-blocking tramite architetture Clos e Spine-Leaf avanzate, che eliminano i colli di bottiglia durante le comunicazioni intensive tra GPU;

- Traffic engineering AI-aware che ottimizza automaticamente i flussi di traffico basandosi sui pattern di comunicazione tipici dei framework AI come PyTorch e TensorFlow;

- Sincronizzazione distribuita con protocolli specializzati come RDMA over Converged Ethernet (RoCE) che riducono la latenza fino al 90% rispetto al TCP tradizionale;

- Scalabilità massiva tramite la possibilità di connettere migliaia di GPU con latenze nell’ordine dei microsecondi, cruciale per l’AI training distribuito;

- Telemetria avanzata che consente visibilità granulare sui pattern di comunicazione AI per identificare e risolvere colli di bottiglia di prestazioni

Caratteristiche e funzionalità delle AI ethernet fabric

La “AI Ethernet Fabric” è un sottoinsieme delle tecnologie “AI Network Fabric” appositamente progettata per gestire la comunicazione requisiti per i carichi di lavoro tipici dell’intelligenza artificiale. Questi requisiti includono una perdita di pacchetti bassa o nulla, un’elevata velocità, vicina ai Terabit/s, consegna dei pacchetti con un preciso in ordine all’interno o tra cluster di unità di elaborazione grafica (GPU). AI Ethernet Fabric consente una gestione unificata, visibilità e robustezza e una forte capacità di automazione. I fornitori oggi rilevanti tali tipi di reti sono: Arista, Broadcom, Cisco, H3C, Huawei, Reti Juniper, NVIDIA, Ruijie.

L’intervallo di tempo per la diffusione per AI Ethernet Fabric va da uno a tre anni perché è la rete ottimizzata per supportare la rapida adozione dell’AI generativa nei data center. Si prevede che entro il 2027 il 36% delle organizzazioni sarà in fase di sperimentazione fase di adozione di GenAI. Si prevede che la spesa per i server ottimizzati per l’intelligenza artificiale crescerà a un ritmo di cinque anni con un tasso di crescita annuo del 30 % fino al 2027, rispetto a solo l’1 % server di scopo. La spesa per le reti dei Data Center e dei grandi Campus seguirà un modello simile. Nel 2028, la spesa per AI Ethernet Fabric sarà di 4 miliardi di dollari e il suo tasso di crescita annuale composto dal 2024 al 2028 sarà del 70 %.

L’evoluzione dell’ethernet verso il terabit ethernet

Dal lato dell’offerta, non solo i principali fornitori di switching Ethernet hanno lanciato i prodotti AI Ethernet fabric, ma anche Ultra Ethernet Consortium, organizzazione di standardizzazione dell’Ethernet di nuova generazione, è stata formata e affiancata da molti fornitori influenti. L’approccio basato su standard per includere tutti i principali fornitori di tecnologia Ethernet può accelerare notevolmente il ritmo di sviluppo di tale tecnologia. Anche se l’Ethernet tradizionale non è progettato per garantire l’affidabilità e supportare prestazioni elevate di calcolo e di intelligenza artificiale, l’accesso diretto alla memoria remota (RDMA) su Ethernet (RoCE) ha fatto molta strada. L’intero ecosistema dei fornitori Ethernet, organizzazioni di standardizzazione, sta lavorando insieme per progettare la prossima generazione di Ethernet per questo miglioramento.

Si prevede che entro la fine del 2028 Ethernet supererà InfiniBand, precedentemente lanciato da NVIDIA, in quanto tecnologia di trasporto di rete per interconnettere l’infrastruttura di IA. Pertanto, AI Ethernet Fabric sarà implementato nei prossimi due anni nella maggior parte dei data center aziendali e/o data center del provider che dispongono di una formazione AI considerevole e influenzano i carichi di lavoro. Andando ancora più avanti emergerà la tecnologia Il Terabit Ethernet rappresenta una frontiera fondamentale per le reti ad altissima velocità:

- Velocità di connessione a 800 Gbps con roadmap verso 1.6 Tbps (1600 Gbps) e oltre;

- Utilizzo di tecniche di modulazione PAM8 e oltre per massimizzare l’efficienza spettrale;

- Impiego di tecnologie fotoniche avanzate come laser a cavità verticale (VCSEL) di nuova generazione;

- Essenziali per cluster con migliaia di GPU che richiedono interconnessioni ultra-rapide;

- Supporta casi d’uso come gemelli digitali in tempo reale, simulazioni climatiche e ricerca genomica su larga scala.

Il futuro dei data center e delle tecnologie di rete

Questa tecnologia, precedentemente considerata futuristica, sta diventando una necessità pratica per supportare l’esplosione dei carichi di lavoro AI, HPC e analisi dati in tempo reale.

L’evoluzione di queste tecnologie sta ridisegnando l’architettura dei data center moderni, con un focus crescente su prestazioni estreme, sostenibilità e flessibilità attraverso soluzioni aperte e disaggregate.

AI edge computing e telco cloud

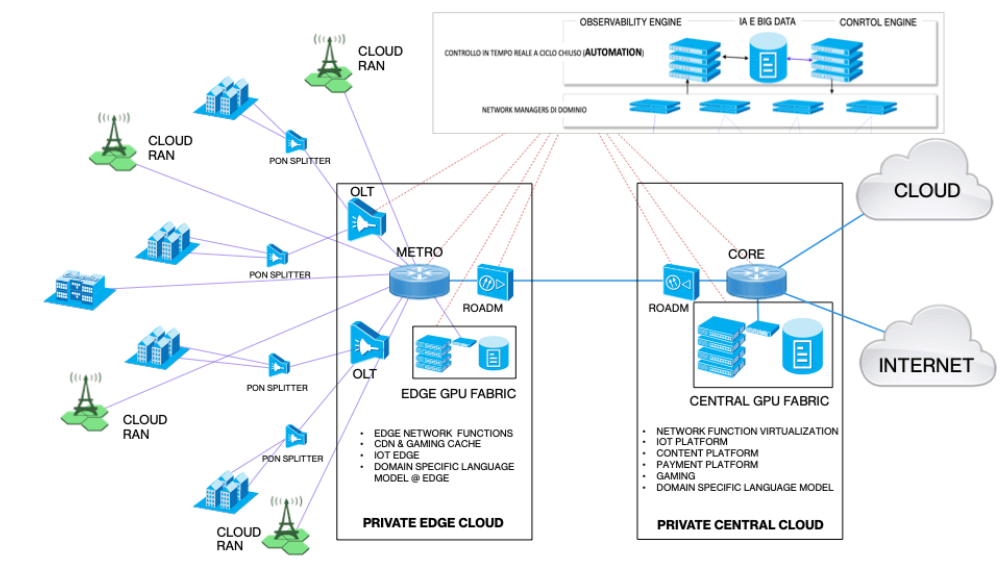

Oggi sta emergendo il concetto di “cloud continuum”, rappresentato in figura 5, con il quale si intende l’interconnessione tra Data Center centrali, reti metropolitane e risorse edge, al fine di garantire un’elaborazione flessibile, scalabile e distribuita dei carichi di lavoro. Questo modello sta affiancando la visione centralizzata dei cloud pubblici, consentendo una gestione più efficiente e personalizzata di servizi, dati e applicazioni.

Reti cognitive e autonome

Nel nuovo paradigma emergono le reti cognitive e autonome, in cui l’intelligenza artificiale è impiegata per l’ottimizzazione dinamica della rete: dalla gestione automatica della topologia e del traffico, fino alla autoriparazione e alla protezione proattiva dalle minacce. Si tratta di reti “self-aware”, capaci di configurarsi, adattarsi e ripararsi autonomamente, basate su modelli di machine learning e analisi predittiva. In questo contesto, i Digital Twin delle reti diventano strumenti fondamentali per simulare, monitorare e ottimizzare il comportamento delle infrastrutture in tempo reale. Le Telco stanno progressivamente adottando queste tecnologie per garantire qualità del servizio, flessibilità e riduzione dei costi operativi.

La combinazione di edge computing, AI, cloud e reti software-defined apre scenari innovativi per la sanità digitale, le smart city, l’automazione industriale e la gestione delle emergenze, abilitando servizi intelligenti a bassa latenza e ad alta resilienza.

L’edge computing e la sua evoluzione

L’edge computing rappresenta una rivoluzione nell’architettura delle reti moderne, segnando il passaggio da un modello centralizzato cloud-centrico a uno distribuito che sposta l’elaborazione più vicino alle fonti dei dati. Questa trasformazione risponde a esigenze sempre più pressanti di latenza, efficienza e scalabilità che caratterizzano i servizi digitali moderni. A differenza del cloud computing tradizionale, dove l’elaborazione avviene in pochi data center centralizzati, l’edge computing distribuisce le risorse computazionali attraverso una rete capillare di nodi periferici, creando un’infrastruttura più resiliente e reattiva.

Crescita del settore dell’edge computing

Il settore dell’edge computing sta vivendo una crescita esponenziale. Secondo le più recenti analisi di IDC, gli investimenti globali in questo settore raggiungeranno i 274 miliardi di dollari entro il 2025, partendo dai 176 miliardi del 2022, con un tasso di crescita annuale composto del 18,7%. Questa crescita significativa sarà principalmente guidata dalla crescente domanda di elaborazione con algoritmi di Intelligenza Artificiale, come i sistemi RAG discussi nei primi capitoli del presente lavoro, dalla proliferazione dei dispositivi IoT, dalla progressiva adozione delle tecnologie 5G advanced e Virtual GPON nelle reti di accesso che procederanno verso i framework di tipo Cloud RAN e di disaggregazione degli elementi di rete.

Accelerazione del telco cloud

Le reti di telecomunicazione accelereranno nello sviluppo del Telco Cloud (basato su edge computing) per cinque ragioni fondamentali che stanno ridefinendo l’architettura delle infrastrutture di rete.

In primo luogo, come già descritto in modo approfondito, la crescita dell’adozione da parte di Aziende e PA dell’Intelligenza Artificiale basata sui sistemi RAG e sulle proprie Knowledge Base strategiche e private, porta alla necessità di rilevante capacità elaborativa locale per motivi di performance, di esigenza di riservatezza e privacy dei dati e per le crescenti indicazioni relative agli aspetti di Sovereignty. In aggiunta a questo, le applicazioni mission-critical rappresentano un altro ambito dove l’edge computing sta dimostrando il suo valore strategico. I sistemi di controllo industriale ora possono operare con tempi di risposta inferiori al millisecondo, mentre i veicoli autonomi beneficiano dell’elaborazione in tempo reale dei dati dei sensori. Anche i sistemi di sicurezza pubblica hanno visto miglioramenti significativi, con la possibilità di effettuare analisi video in tempo reale direttamente ai bordi della rete.

La virtualizzazione delle reti software-defined

In secondo luogo, la trasformazione software-defined delle reti richiede una profonda evoluzione nell’architettura di elaborazione. La virtualizzazione delle funzioni di rete e il networking software-defined necessitano di capacità computazionali distribuite per gestire efficacemente le funzioni virtualizzate. L’implementazione dell’edge computing in questo contesto ha permesso di ridurre i tempi di latenza fino al 90% rispetto alle architetture tradizionali, con un miglioramento significativo nelle prestazioni delle applicazioni critiche.

Il supporto alle applicazioni 5G avanzate e IoT

Il terzo driver fondamentale è rappresentato dal supporto alle applicazioni 5G avanzate in particolare in ambito 5G PRIVATO e IOT. L’edge computing si rivela essenziale per realizzare le le applicazioni mission-critical che richiedono latenze inferiori al millisecondo. La capacità di gestire la massive Machine Type Communication con densità elevatissime di dispositivi e di supportare l’Enhanced Mobile Broadband con throughput dell’ordine dei gigabit per secondo è resa possibile proprio grazie all’elaborazione distribuita ai bordi della rete.

Sostenibilità e sicurezza nell’edge computing

Il quarto aspetto cruciale riguarda la sostenibilità e la sicurezza. L’elaborazione dei dati al bordo della rete sta dimostrando vantaggi significativi sul fronte energetico, con riduzioni del consumo che raggiungono il 30-40% rispetto alle architetture cloud centralizzate potendo contare anche su produzione locale da fonti alternative. Inoltre, la diminuzione del traffico di rete, che può arrivare al 40-50%, porta a un’ottimizzazione significativa delle risorse. La localizzazione dei dati sensibili contribuisce anche a un sostanziale miglioramento della sicurezza complessiva dell’infrastruttura.

Digital twin e edge computing

Infine, il quinto elemento strategico riguarda la strategia di gestire le reti tramite l’approccio Digital Twin che rappresenta uno dei casi d’uso più significativi dell’edge computing nelle reti moderne. Questi gemelli digitali richiedono un’elaborazione in tempo reale di enormi quantità di dati di telemetria che vengono raccolti da tutti gli elementi intelligenti della rete e delle reti dei clienti connessi, l’elaborazione di tali dati con algoritmi predittivi e la generazione di comandi che vengono continuamente impartiti al livello di controllo degli apparati per determinarne dinamicamente la configurazione ottimale. L’implementazione edge permette di mantenere latenze di aggiornamento inferiori ai 10 millisecondi, gestendo contemporaneamente fino a 100.000 aggiornamenti al secondo per ogni digital twin. Questo approccio distribuito ha permesso di ottimizzare significativamente il consumo di banda, riducendo del 60-70% il traffico verso il cloud centrale.

Evoluzione dell’edge computing nelle telecomunicazioni

L’evoluzione dell’edge computing nelle reti di telecomunicazione continuerà nei prossimi anni seguendo diverse direttrici innovative. L’integrazione con le tecnologie di intelligenza artificiale sta diventando sempre più profonda, permettendo elaborazioni complesse direttamente ai bordi della rete. Lo sviluppo di architetture edge native per il 6G rappresenta un’altra frontiera importante, così come la standardizzazione delle interfacce e dei protocolli edge. Un’evoluzione particolarmente promettente riguarda i modelli di edge computing federato, che permetteranno una collaborazione più stretta tra diverse infrastrutture edge.

Figura 5: Architettura delle future reti basate su edge computing (TELCO CLOUD) e AI self healing.

In sintesi, quanto detto fino a ora dimostra che la convergenza tra edge computing e reti di telecomunicazione sta creando un nuovo paradigma di elaborazione distribuita che promette di ridefinire radicalmente il modo in cui gestiamo e processiamo i dati nelle reti del futuro. Questa trasformazione sta abilitando servizi e applicazioni che richiedono prestazioni, affidabilità e sicurezza senza precedenti, aprendo la strada a innovazioni che fino a poco tempo fa sembravano impossibili da realizzare.

L’architettura telco cloud e l’edge computing

Un ulteriore scenario emergente riguarda la virtualizzazione e disaggregazione degli elementi delle Reti di Telecomunicazioni e l’analogo trend sta avvenendo per tutti gli elementi delle reti locali ed Enterprise con il paradigma SONiC (Software for Open Networking in the Cloud) che rappresenta una delle innovazioni più dirompenti nel mondo del networking moderno, specialmente in ambito data center e cloud-scale.

SONiC, progetto open source sotto l’ombrello della Linux Foundation, porta nel mondo del networking dei data center un approccio analogo a quello che abbiamo visto nelle Reti Telco con la virtualizzazione dei vari control plan degli apparati di accesso e di backbone, approccio basato sulla disaggregazione tra hardware e software negli switch e nei nodi di rete ad alte prestazioni. Il principio cardine è quello di separare il sistema operativo di rete dallo switch fisico, consentendo alle aziende di scegliere liberamente l’hardware di base, fornito da vendor come Edgecore, Dell, Celestica, o Accton, e di installarvi un sistema operativo software standardizzato, altamente modulare, indipendente dal fornitore e costantemente evoluto dalla community.

Il progetto Soníc e l’innovazione nelle reti

L’architettura di SONiC si fonda sull’utilizzo di container Docker per ogni funzione di rete (come BGP[2], LLDP, SNMP, DHCP relay, routing IPv4/IPv6, QoS, ACL, etc.), realizzando così un sistema operativo “a microservizi”, dove ogni funzione può essere aggiornata, riavviata o modificata in modo indipendente, senza impattare il funzionamento dell’intero nodo. Questo approccio aumenta enormemente la resilienza e la manutenibilità della rete. Il cuore dell’infrastruttura è basato su Linux Debian, e utilizza come stack di astrazione verso l’hardware il progetto Switch Abstraction Interface (SAI), sviluppato anch’esso da Microsoft e oggi mantenuto dalla community Open Compute Project. Grazie a SAI, SONiC può funzionare su ASIC di diversi produttori (Broadcom, Mellanox/NVIDIA, Intel, etc.) mantenendo lo stesso comportamento software.

L’adozione di Soníc nelle reti moderne

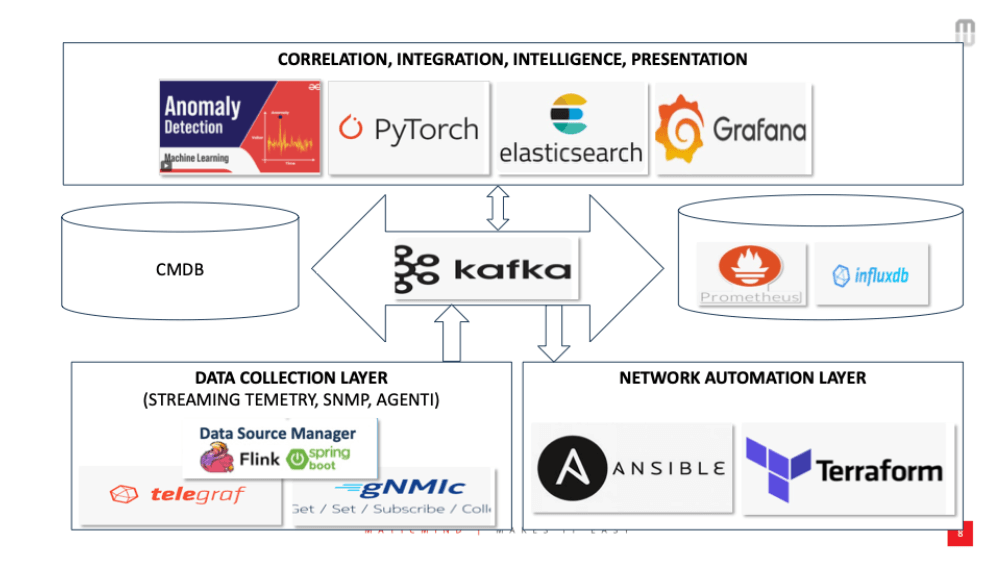

SONiC è pensato per integrarsi nativamente con strumenti di automazione e orchestrazione: Ansible eTerraform sono usati per il provisioning e la configurazione automatizzata, mentre per orchestrazioni complesse su larga scala SONiC si presta all’integrazione con Kubernetes e container networking, particolarmente in ambienti cloud-native o in data center basati su architetture spine-leaf. L’osservabilità è un altro punto di forza: SONiC supporta una telemetria avanzata tramite gNMI/gRPC, REST API, SNMP, e log in tempo reale, integrabili in stack open come Prometheus + Grafana, Telegraf + InfluxDB, oELK (Elasticsearch, Logstash, Kibana). Nella figura 6 vi è un modello di observability e automation per tali tipi di reti software defined.

In sintesi, SONiC è molto più di un sistema operativo per switch: è un ecosistema completo, sostenuto da una community in forte crescita (tra cui Microsoft, NVIDIA, Alibaba, Dell, Broadcom, Edgecore e molti altri), che mira a rendere il networking più aperto, programmabile, automatizzato e resiliente. L’adozione in larga scala da parte di hyperscaler è un segnale forte: la trasformazione delle reti in ambienti governati da codice, telemetria, orchestrazione e intelligenza artificiale è ormai realtà, e SONiC ne è uno degli abilitatori principali.

Disaggregazione hardware e software con Soníc

Notiamo bene che da un lato parliamo di disaggregazione software-hardware, con SONiC e SAI che puntano a piattaforme flessibili e modulari; dall’altro lato assistiamo alla nascita di tecnologie come AI Ethernet e Terabit Ethernet, che richiedono apparati altamente specializzati, ottimizzati a livello di ASIC, per garantire latenze nell’ordine dei microsecondi, throughput multi-terabit, zero packet loss e traffico congestion-aware. Tuttavia, queste due tendenze non sono in conflitto, ma rappresentano due piani complementari dello stack tecnologico, che stanno evolvendo in parallelo e con una crescente sinergia.

Osservabilità e automazione per le reti Soníc

La disaggregazione introdotta da SONiC agisce a livello di control plane e management, mentre le innovazioni di Terabit Ethernet e AI Networking si esprimono nel data plane, ovvero nel silicio (ASIC) degli switch. SONiC non rimpiazza il chip di switching né ne riduce le prestazioni: anzi, utilizza proprio i migliori ASIC del mercato (Broadcom Tomahawk, NVIDIA Spectrum, Intel Tofino, Marvell Prestera, etc.), accedendo alle loro funzionalità tramite l’interfaccia standardizzata SAI. Questo significa che l’hardware resta ad alte prestazioni, ma viene liberato dal vincolo di usare solo il sistema operativo del vendor. È lo stesso principio per cui i server x86 di fascia alta usano Linux o VMware, anche se hanno CPU potentissime: lo strato software è disaggregato e flessibile, ma l’hardware continua a evolversi al massimo livello.

Figura 6: Observability & Automation per le piattaforme di rete Virtualizzate e SONiC.

Le opportunità per gli operatori di telecomunicazioni con telco cloud

Quello della possibilità di ospitare i control e management plan degli apparati delle reti Enterprise è un altro contenuto importante per l’estensione del modello di business degli Operatori di Telecomunicazioni che, con l’approccio Telco Cloud, possono fare approcci e strategie commerciali a favore di un recupero di spazi e mercati in ambito Enterprise da molto tempo meno presidiati.

Implementazione di piattaforme cloud in ambito telco

In altre parole, con l’architettura Telco Cloud gli Operatori:

- Realizzano la Network Function Virtualization seguendo la strategia CUPS (Control and User Plan Separation) propria delle tecnologie di accesso ottiche di nuova generazione (virtual OLT) e delle tecnologie mobili di nuova generazione come le Cloud RAN (Distribution Unit, Central Unit, Radio Intelligent Controller realizzate come funzioni software);

- Implementano le Content Delivery Networks per abilitare repliche locali e dinamiche dei contenuti delle Piattaforme di Video Streaming e le funzioni locali a bassissima latenza pe supporto delle Game Console;Implementano le AI RAG (retrieval Augmented Generation) fabric consentendo ad Aziende e PA locali di implementare la trasformazione delle proprie Knowledge Base in senso vettoriale in modo da renderle utilizzabile per le ricerche e la generazione dei propri Domain Specific Language Model) tenendo ben saldi i dati strategici in prossimità e con la garanzia di un uso nel totale rispetto delle Compliance Nazionali;Realizzano le piattaforme IOT EDGE per consentire la preelaborazione dei dati raccolti da milioni di sensori e sistemi intelligenti (Programmable Logic Controllers) e il loro invio alle funzioni core implementate nella parte centralizzata del Telco Cloud o in ambito Private / Public Cloud.Ospitano le funzioni Control Plane dei nuovi apparati delle reti enterprise (vitual CPE Customer Premise Equipment) nella logica SONiC che abbiamo discusso approfonditamente nei precedenti paragrafi.

- Implementano piattaforme CLOUD preferibilmente Open Source, come nel caso di Open Stack, per offrire servizi IAAS (Infrastructure As A Service) semplici e molto performanti.

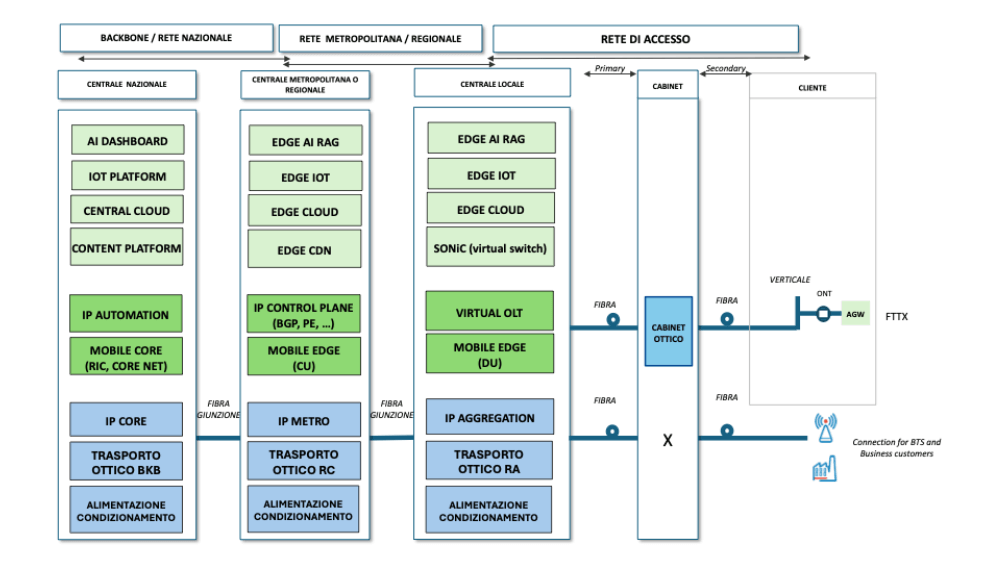

Questo approccio è illustrato nella figura 7 che illustra la distribuzione tra EDGE e CORE sia per le funzioni proprie delle telecomunicazioni (rappresentate in figura con il colore verde più scuro) e sia per le funzioni a supporto dell’offerta commerciale per Aziende e PA (rappresentate in figura con il colore verde più chiaro).

Figura 7: Distribuzione delle funzioni di rete e di business nel Telco Cloud.

Risultati attesi

In questo capitolo discutiamo i risultati attesi dalla strategia articolata che abbiamo presentato.

L’introduzione di un Domain Specific Language Model all’interno dell’organizzazione rappresenta un cambiamento profondo nella gestione della conoscenza e nei processi documentali. I benefici attesi sono significativi e trasversali rispetto al settore di appartenenza o alla funzione aziendale coinvolta. In un contesto ICT, i vantaggi sono evidenti nella drastica riduzione dei tempi necessari per redigere documentazione tecnica, configurazioni, runbook e piani di test. Il risparmio operativo supera facilmente il 60%, con una qualità più alta, una maggiore uniformità formale e una netta diminuzione degli errori dovuti a copiature o modelli incoerenti. Tuttavia, l’impatto positivo di questo approccio si estende anche ad altri settori e aree aziendali.

In ambito bancario e assicurativo è possibile standardizzare la produzione di policy, piani di conformità, documentazione normativa e processi interni, garantendo maggiore trasparenza, velocità e tracciabilità delle informazioni. Nel settore delle utility e dell’energia, può accelerare la redazione di specifiche tecniche, documenti di gara, documentazione di cantiere, report operativi e procedure di manutenzione. Nella produzione industriale, supporta la generazione automatizzata di manuali tecnici, schede di processo, documenti di qualità e reportistica tecnica, con beneficio tangibile sia in fabbrica sia negli uffici tecnici.

I benefici sono altrettanto rilevanti nelle aree commerciali e nei reparti di ingegneria d’offerta. In quanto è possibile preparare più velocemente offerte complesse, rispondere in modo strutturato a capitolati tecnici, personalizzare template di proposta e garantire coerenza tra il linguaggio commerciale e quello ingegneristico. I team di vendita e prevendita possono così risparmiare tempo prezioso, evitare duplicazioni e concentrarsi sulle strategie di posizionamento, lasciando all’intelligenza artificiale la generazione assistita dei contenuti ricorrenti o standard.

In sintesi, l’adozione di un DSLM porta con sé un salto di qualità nella produttività aziendale, migliora la qualità delle risposte, riduce i colli di bottiglia legati alla creazione manuale della documentazione e libera risorse tecniche e manageriali per attività a maggiore valore strategico. È un investimento che si ripaga rapidamente e che posiziona l’organizzazione su un piano superiore di maturità digitale e competitività. È possibile stimare un’ottimizzazione di almeno il 50% sulle attività ripetitive, ma anche su quelle concettuali che, pur richiedendo riflessione, seguono uno schema o modello riconoscibile e formalizzabile. Le attività ripetitive come la scrittura di sezioni standard di documenti (es. capitoli di HLD, checklist, descrizioni apparati, format Excel, dichiarazioni tecniche) sono perfettamente automatizzabili. Con un DSLM ben progettato, il guadagno supera spesso il 60-70%, soprattutto se la documentazione è costruita su template o stili ricorrenti.

Le attività concettuali strutturate, come la scrittura di piani di progetto, la definizione di architetture ricorrenti, la spiegazione tecnica di un sistema già noto, o la risposta a un requisito tecnico noto ma da adattare, possono anch’esse beneficiare di un’accelerazione sostanziale. In questi casi, l’IA non sostituisce la valutazione umana, ma fornisce una base ben articolata e strutturata su cui l’esperto può intervenire con modifiche mirate. Questo riduce drasticamente il tempo di “prima stesura”, che in molte organizzazioni è il collo di bottiglia principale.

In pratica, quando il contenuto è noto, ma da riformulare, adattare, aggiornare o contestualizzare, l’ottimizzazione si mantiene su un livello del 50% o superiore, grazie al fatto che il modello lavora su conoscenza formalizzata e contestualizzata. Questo vale non solo per i documenti tecnici, ma anche per quelli di offerta, compliance, onboarding clienti, formazione e gestione progetti. La riduzione del tempo necessario, unita a una maggiore omogeneità, genera un ritorno concreto su efficienza, velocità di esecuzione e riduzione degli errori.

Ora veniamo ai risultati attesi per le aziende ICT dal lato dell’offerta di sistemi AI con particolare riferimento alle aziende che realizzano i sistemi DSLM (System & Software Integrator) e le aziende che mettono a disposizione le infrastrutture e gli ambienti elaborativi necessari (Data Center Provider).

Per i Software e System Integrator i ritorni sono importanti in quanto le esigenze sono generalizzate a prescindere dalla dimensione dell’Azienda o PA sulle quali implementare i sistemi. Tutto il comparto AI cresce oltre il 30% l’anno in Italia, come recentemente indicato dai migliori analisti di mercato, e data la novità del contesto c’è richiesta di un forte supporto dal mercato.

Per i Data Center provider la prospettiva è ancora maggiore viste le stime di crescita del fabbisogno di queste strutture pari al 300% in 5 anni. Tra questi provider infrastrutturali un ruolo di primo piano possono giocare le Telco perché:

- sono Operatori infrastrutturati dotati di molti POP in edifici industriali molto distribuiti sul territorio;

- hanno prossimità e presenza nei clienti con processi molto strutturati di customer care e assistenza tecnica, non banali per un contesto così innovativo;

- hanno dato prova di una gestione attenta e responsabile delle varie delibere regolamentari e di compliance e dunque li troveremo in prima linea per il rispetto dell’AI ACT dell’EU oggi in fase di approvazione legge Italiana, dove privacy, security, sovereignty sono valori rilevanti.

Se si considera, come illustrato nel dettaglio nel precedente paragrafo, che le Telco devono comunque evolvere strutturalmente le tradizionali centrali in nuovi Edge Computing Data Center per implementare le funzioni virtuali delle nuove piattaforme ottiche e 5G advanced (in futuro 6G), si può concludere che essi possono e debbono procedere speditamente nella direzione indicata.

Conclusioni

La trasformazione digitale in corso, alimentata dalle nuove capacità dell’intelligenza artificiale generativa, impone un ripensamento profondo delle architetture informative, dei modelli di governance della conoscenza e delle infrastrutture che ne supportano l’elaborazione. In questo contesto, i Domain Specific Language Model (DSLM) emergono come strumenti chiave per affrontare la complessità informativa delle organizzazioni moderne, migliorare la produttività dei team tecnici e garantire maggiore qualità, coerenza e sicurezza nella produzione documentale.

Il cuore della proposta consiste nella costruzione di sistemi DSLM basati su architetture Retrieval-Augmented Generation (RAG), alimentati da una knowledge base aziendale o istituzionale progettata per essere aggiornata, verificabile e accessibile in modo semantico. L’approccio consente di automatizzare la produzione di documenti specialistici e di potenziare le funzioni di supporto alle decisioni, facilitando la valorizzazione del patrimonio informativo interno. Non si tratta solo di aumentare l’efficienza, ma di strutturare un nuovo ciclo del sapere aziendale, dove l’intelligenza artificiale lavora a fianco dei professionisti, generando contenuti contestualizzati, tracciabili e riutilizzabili.

A differenza dei modelli generalisti disponibili via cloud pubblico, i DSLM proposti sono progettati per funzionare in ambienti locali o su cloud privati, pienamente sotto il controllo dell’organizzazione. Questo aspetto è cruciale: le nuove normative europee, le esigenze di compliance e le tensioni geopolitiche impongono che i dati strategici non lascino il perimetro dell’ente. La sovranità digitale, la riservatezza e la continuità operativa non sono più opzioni, ma requisiti fondamentali. I DSLM sono, per loro natura, compatibili con questi obiettivi, e rappresentano una risposta matura e scalabile al bisogno di intelligenza artificiale sicura, auditabile e personalizzata.

All’interno di questa visione, si inserisce in modo particolarmente efficace il ruolo degli Operatori di Telecomunicazione. Le Telco italiane dispongono di una rete capillare di POP (Point of Presence) distribuiti sul territorio nazionale, spesso già collocati in edifici idonei all’installazione di infrastrutture di edge computing. Hanno inoltre esperienza consolidata nella gestione di ambienti critici, nei servizi di customer care, e nel rispetto della compliance normativa. In un contesto che richiede infrastrutture prossime all’utente, capaci di ospitare modelli AI locali, le Telco possono diventare gli attori principali di una nuova rete di Telco Cloud distribuito, dedicata all’esecuzione sicura ed efficiente dei DSLM.

Questa rete potrà ospitare e orchestrare non solo le componenti di rete virtualizzate (come nei progetti Cloud RAN e SONiC), ma anche le funzioni di intelligenza artificiale delle aziende e delle pubbliche amministrazioni, offrendo servizi a valore aggiunto per la generazione documentale, la compliance, la formazione, la manutenzione predittiva e il supporto alle decisioni. È una prospettiva che consente agli Operatori di riconquistare spazi strategici nel mercato ICT, offrendo piattaforme infrastrutturali per i servizi AI di nuova generazione.

La proposta qui delineata risponde inoltre a una chiara tendenza tecnologica: la convergenza tra AI, edge computing, cloud e reti software-defined. Le architetture distribuite che uniscono core, edge e ambienti locali (cloud continuum) permettono di ottimizzare le prestazioni, migliorare la resilienza e ridurre significativamente i consumi energetici, in linea con gli obiettivi di sostenibilità. I DSLM, progettati per essere eseguiti anche in ambienti decentralizzati, rappresentano l’applicazione concreta di questa visione: modelli intelligenti che operano vicino ai dati, rispettando i vincoli di privacy e garantendo bassa latenza e alte performance.

Infine, la scelta tecnologica di basarsi su stack Open Source rafforza ulteriormente la sostenibilità e l’indipendenza della proposta. Le piattaforme RAG come LlamaIndex, i database vettoriali come Chroma, e i modelli linguistici open source locali sono oggi in grado di offrire prestazioni elevate, ampia flessibilità e pieno controllo. L’open source è l’alleato naturale della sovranità digitale, ma anche un potente motore di innovazione, interoperabilità e attrazione di talenti.

In conclusione, la strategia proposta integra in modo coerente tre direttrici fondamentali:

- la trasformazione intelligente e sicura della conoscenza aziendale;

- la valorizzazione delle infrastrutture Telco come backbone per l’AI distribuita;

- l’adozione di tecnologie open, auditabili e sostenibili.

È una strategia industriale concreta, tecnologicamente solida e conforme alle priorità europee, che può contribuire in modo decisivo alla costruzione di un ecosistema AI nazionale realmente competitivo, etico e autonomo.

Note

[1] OSS sta per Open Source Software ed è l’acronimo utilizzato da Gartner.

[2] BGP è il Border Gateway Protocol ed è implementato nei router ai confini di differenti autonomous system di Internet, LLDP è il Link Layer Discovery Protocol, SNMP è il Simple Network Management Protocol con il quale gli elementi di rete comunicano allarmi ed eventi ai propri Element Manager, DHCP è il Dynamic Host Configuration Protocol